谈谈HPC可否掀起下一轮技术热潮

转载文章请注明作者和全文信息

需求的膨胀推动着技术变革,技术的革新进一步丰富着我们的生活,如今大数据、云计算技术已经自身疲惫了。然而跨界竞争和技术融合迫使我们不断换血和补充能量来适应一次次变革。那么在人工智能、虚拟现实、物联网等技术热潮过后,能预测到的下一个技术热点会是什么,高性能计算(HPC)?面对技术和行业融合现状,HPC应该再适合不过了,另外,我也倾向于把HPC看作是一种跟各个行业比较紧密结合的技术。

在这里谈到的HPC,已经不仅仅是简单的一堆计算、网络、存储、HPC软件等设备,而更多的是聚焦在HPC的发展、主流玩家、技术趋势和HPC未来出路。回顾历史,传统HPC还是主要聚焦在仿真、物理化学、生命科学、渲染、勘探和气象等六大场景,上层HPC集群化的特定应用环境也是比较固定。

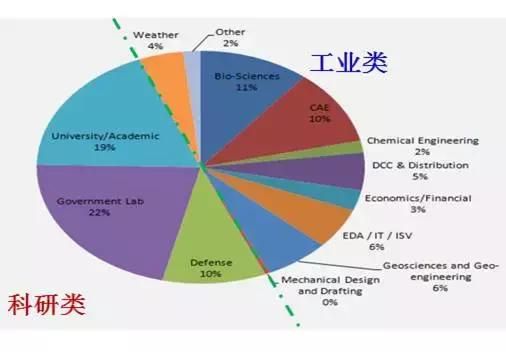

随着大数据、云计算和技术发展和行业融合,HPC在各个层面的分类也发生了一些变化,根据HPC应用的目标市场可分为HPC商业市场和HPC科研市场。

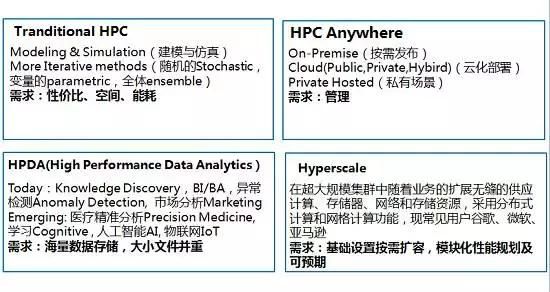

然而,我个人觉得这个划分相对来说太过于宽泛。行业采用比较多且容易理解的划分方法是按照传统HPC(以上述的六大场景为主),HPDA高性能数据分析、HPC Anywhere和HyperScale四大类。

HPC Anywhere也实现了HPC和云的结合,例如Panzura、Ctera、Avere和Nasumi等集群文件网关存储厂商,他们提供一个高速的本地分布式NAS系统,用于对接AWS、Azure等这样的公有云对象存储和一些低速的NAS产品,通过这些网关提供了一个缓冲层,可以设置策略让数据在网关和其它存储之间流动,实现NAS或Object存储直接与集群网关连接,甚至与公有云链接。

HPC系统涉及存储、计算节点、网络、HPC软件和L1层冷却、机房、供电等多种复杂设备,但是从技术角度讲,服务器、网络标准都比较统一,每家厂商设计出的产品除了在管理方面差异较大之外,其他方面基本保持在同等水平。然而标准不一、最容易提升方案竞争力的还是存储设备。

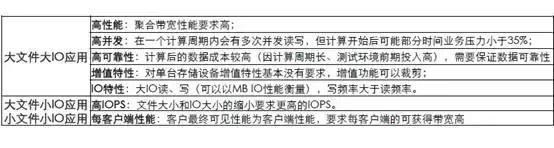

HPC存储是在HPC应用环境下,为解决传统串行存储性能瓶颈,所提出的专用存储。HPC存储侧的容量、性能、IOPS与HPC计算侧的规模、性能弱相关。HPC存储主要关注点性价比、低成本、占地空间等;在HPC典型应用场景下,常见的业务模型大致如下:

在IOR测试工具中,IOPS实际上就等同于OPS,IOR工具在HPC的BenchMark测试中采用的是比较多的,主要原因是IOR对带宽和OPS都比较适合,并提供丰富的参数来模拟不同的业务IO模型。

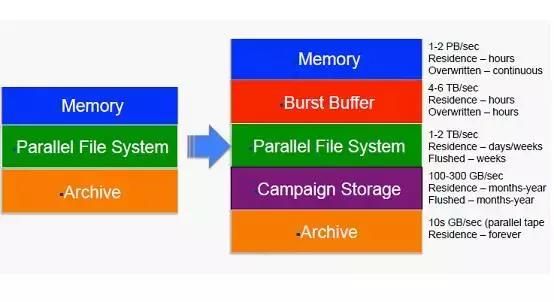

如果我们回顾一下HPC存储技术发展历史,不管采用怎样的分类,我们会看到几年前,HPC架构是典型的3层架构,即计算节点内存、并行文件系统和归档存储。平行文件系统对HPC性能影响是最大的,在某种意义上决定pFS乃至整个HPC存储性能,所以针对超大规模HPC集群,成千上万个计算节点需要同时Checking Point时,一般基于NL_SAS磁盘的并行文件系统就有点力不从心了,那就需要在pFS之上多加一层高速大容量(相对于Memory)的Cache。

Burst Buffer技术和产品的出现使得HPC计算架构发生了变化,Campaign 存储如同数据热备,它的出现给数据生命周期管理增加了更多选择。我个人认为Burst Buffer技术只是一个技术过度,如果改善系统性能的Hybird存储,不过,在目前SSD还相当贵的状况下,Burst Buffer却能够更好的匹配超大型HPC场景极致性能需求。在性能和容量空间比在20MB/TB至200MB/TB之间,Burst Buffer可以说是非常适合的,通过简单的配置调整,基本不会出现容量或性能超配,而且能发挥出SSD的价值。

如果没有Burst buffer,所有性能层需要pFS来承载,Checking Point时性能需要pFS来承载内存数据,Burst Buffer的另一个作用是在浪涌IO模型下,Burst Buffer可以作为高性能层和pFS一起提供性能,对小IO可以进行合并优化。目前DDN、Cray、EMC等都已经支持,并且IBM也会很快支持,DDN、Cray和EMC的Burst buffer方案可以参考我之前的文章Burst Buffer技术为何在HPC如此盛行。

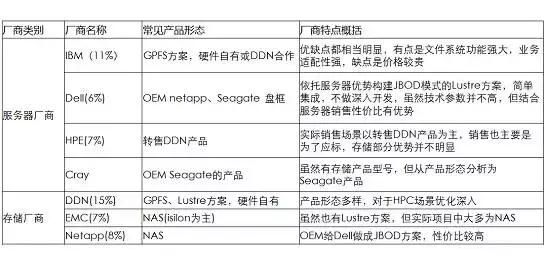

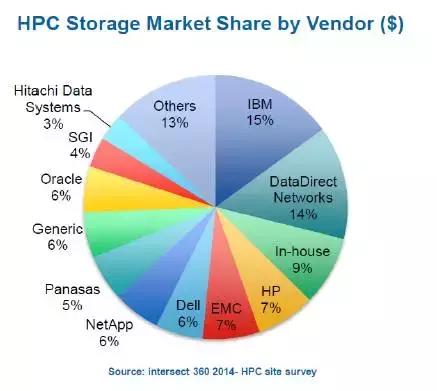

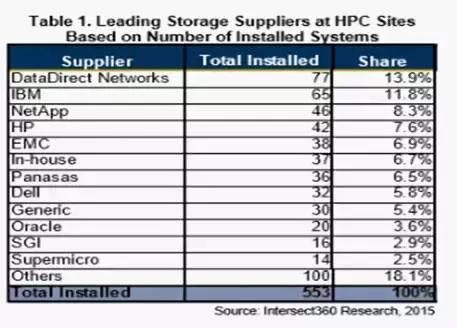

我们再来看看HPC行业的的主要玩家,主要看看服务器和存储。服务器厂商在HPC行业的的情况基本上和在整个服务器产品的市场份额保持一致。在技术上,服务器没什么好说的,加内存,加CPU,加接口卡性能一定会提升,通过高密节点也很容易提升密度。

HPC存储厂商实主要分了3类,服务器厂商、传统存储厂商和专注于HPC行业的存储厂商。从这些厂商我们看到,IBM虽然是服务器或者是传统存储厂商,但是借助于GPFS,其市场份额比较大的,随着Lustre放弃企业版给客户带来的不确定性,GPFS的市场份额还会上升。DDN目前实现了Burst Buffer IME,在很多场景下凭借高性能、NVMe SSD和高密度领军整个HPC行业。

既然说到这里了,我们简单看看DDN的Burst Buffer IME产品,IME产品支持三种形态。

IME240 采用2U商用服务器。 单个产品提供20GB带宽,提供48块NVMe SSD,支持800G和1.8TB。5个IME240,配置1.8TB磁盘满配,提供100GB带宽,300TB容量,容量使用率80%。

IME14KX基于专用的SFA14KX平台,基于4U设备,支持的灵活配置NVMe磁盘。最大也是支持48磁盘,性能是10GB/s到满配的50GB/s,扩展性和IME240一致,支持扩展到32个节点,性能达到1.6TB/s。

IME SOFTWARE-ONLY是纯软件产品。可以灵活部署在现有硬件。

实际上,我个人认为HPC系统在市场份额和项目上分布上,超大规模和中小型规模应该是一半一半的,但是在企业市场,中小型规模的客户一般是集成商或代理能够接触到的,而厂商能够直接接触或者说看的上眼的往往就是超大规模的HPC市场。所以对厂商来说跟进HPC技术步伐就显得尤为重要。我上面提到的已经具备和马上具备Burst Buffer的厂商,都是引领HPC行业和技术的厂商,如DDN、IBM等。

Panasas和Seagate是两家专注HPC行业的专业存储厂商,从目前来看,他们在Burst Buffer上没有发力,但是他们在NL_SAS磁盘和HPC专有存储上却一直不懈努力。Panasas的技术从我一开始借助HPC就吸引着我,ActiveStor 8、9、11、12采用数据控制分离,磁盘内置控制器可以把HDD磁盘性能发挥极致,遗憾的是不知为何,最近几年Panasas一直淡出在我们视野。

至于Seagate,更是把密度和HDD结合的非常完美的典范,ClusterStor可以在5U空间提供84个磁盘容量和16GB/s性能,从最新的宣传来看,性能已经翻番了。他们虽没有采用SSD,但成了完全可以玩转HPC的例子。

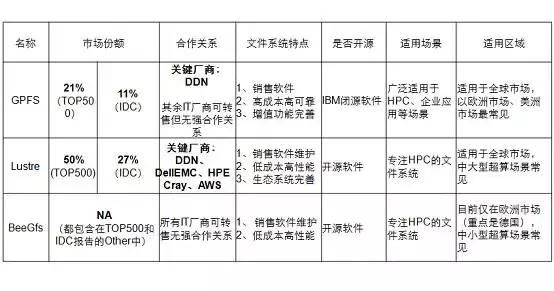

关于存储的发展,我们有个业界一直被推崇的做法可以借鉴,那就是开源的重要性。从Linux,OpenStack,Ceph到Lustre、BeeGFS等。他们的成功说明开放的魅力强大,参与者越多产品才会越稳定,客户才会认同。拥抱开源,基于自己的优势和理解定制化,走出一条自己的路。DDN、Seagate还有很多HPC方案供应商都是这样从中获利的。回首HPC并行文件系统,屈指可数,主流的有Lustre、GPFS、BeeGFS,当然Glustre、Ceph和企业NAS也会在HPC中出现。

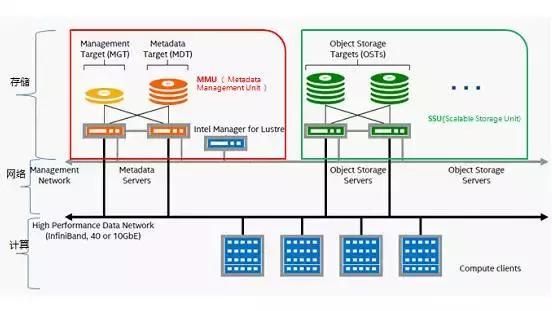

Lustre并行文件系统在超大规模(尤其是超算中心)和科教领等对成本敏感的领域,讲到这里,那我们简单谈谈Lustre的架构。

Lustre文件系统不管多大,元数据和管理节点(MMU)基本上是固定的,只需根据系统容量配置调整元数据存储(MGT&MDT)的容量即可,数据存储单元SSU是存储基本单元,按需扩展实现容量和性能扩展。

GPFS在工业等对成本不敏感应用,对系统稳定性要求较高的系统中份额巨大,个人认为IBM OEM out合作策略弥补了其在闭源上的不足。BeeGFS多采用服务器构建文件系统,主要在欧洲的科研、高校机构,中小型超算场景。

展望未来,HPC的出路到底在哪里?请参看前期文章HPC技术趋势HPDA、深度学习和软件定义等了解HPC趋势和发展。HPC结合大数据是一个方向;目前HPDA已经在大数据和HPC领域结合的比较好了,比如Lustre支持对接Hadoop、支持部署Hbase和Hive。大数据目前应用范围非常广泛,并且跨界融合也很明显,如智慧城市,海量视频分析,要求HPC对接Hadoop实现数据共享,计算资源共享;物联网传感数据分析;以及小文件场景如机器学习、深度学习、基因分析、金融分析和能源分析Scratch层等。

HPC Anywhere结合HPC和云计算,云上HPC实现HPC资源服务化,HPC在互联网分布式应用的HyperScale化都会给HPC带来无限商机。前面我们讨论到的Burst Buffer、专注HDD和专业HPC存储,以及拥抱开源趋势都计划想在HPC行业发展的厂商借鉴的,目前急需要做的就是做好HPC产品规划布局,才能迎接新时代。

温馨提示:

请搜索“ICT_Architect”或“扫一扫”下面二维码关注公众号,获取更多精彩内容。