NIPS2018深度学习(20)|亮点: 双向RNN时间序列;对抗自编码异常检测;脉冲神经网络(论文及代码)...

[1] BRITS: Bidirectional Recurrent Imputation for Time Series

Wei Cao, Dong Wang, Jian Li, Hao Zhou, Yitan Li, Lei Li

Tsinghua University, Duke University, Bytedance AI Lab

https://papers.nips.cc/paper/7911-brits-bidirectional-recurrent-imputation-for-time-series.pdf

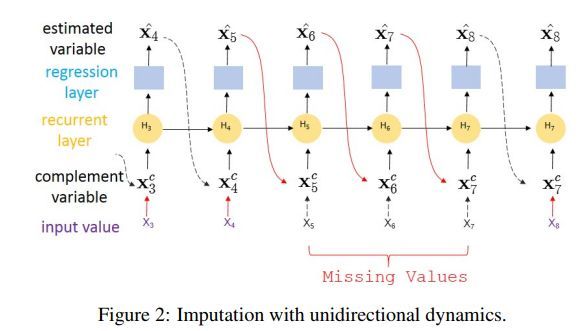

时间序列在很多分类或者回归中都会用到。但是,在实际应用中,时间序列可能会包含很多缺失值。给定多个可能有关联的时间序列,补充缺失值同时对类别标签进行预测非常重要。

现有的填补方法通常对潜在的数据生成过程加以较强的假设,比如状态空间中的线性动力学。这篇文章提出一种新的适用于时间序列的缺失值填补方法,简称BRITS,该方法基于循环神经网络。

这种方法利用双向循环动力系统直接学习缺失值,不需要任何特定的假设。填补值可以看做RNN图的变量,利用反向传播可以高效更新。

BRITS具有以下几个优势:

1 可以处理多个相关时间序列中的缺失值

2 可以泛化到带有潜在非线性动力学的时间序列中

3 填补过程是数据驱动的(难道还有不是数据驱动的?),可以用于一般的缺失数据的情形。

作者们在三个真实数据集上进行了实验,空气质量数据集,医疗健康数据集以及人口活动位置数据集。实验表明,该方法不仅在缺失值填补中效果最好,而且在分类或者回归任务中效果也是最好的。

这篇文章的贡献如下

带有缺失值的多变量时间序列示例如下

基于无向动力学的缺失值填补示例如下

几种方法的效果对比如下

其中KNN和MF对应的参考资料为

The elements of statistical learning

Multiple Imputation by Chained Equations (MICE)对应的论文为

Multiple imputation by chained equations:what is it and how does it work? 2011

ImputeTS对应的论文为

imputeTS: Time Series Missing Value Imputation in R, 2017

STMVL对应的论文为

St-mvl: filling missing values in geo-sensory time series data

GRU-D对应的论文为

Recurrent neural networks for multivariate time series with missing values, 2018

代码地址

https://github.com/zhiyongc/GRU-D

M-RNN对应的论文为

Multi-directional recurrent neural networks: A novel method for estimating missing data, 2017

在分类任务中,几种方法的效果对比如下

代码地址

https://github.com/caow13/BRITS

https://github.com/iskandr/fancyimpute

![]() 我是分割线

我是分割线![]()

[2] Generative Probabilistic Novelty Detection with Adversarial Autoencoders

Stanislav Pidhorskyi, Ranya Almohsen, Donald A. Adjeroh, Gianfranco Doretto

West Virginia University

https://papers.nips.cc/paper/7915-generative-probabilistic-novelty-detection-with-adversarial-autoencoders.pdf

异常检测即为判定一个新的样本点是正常点还是异常点。假设训练数据只能描述正常样本点的分布。最近有一些方法主要利用深层编码解码网络结构来计算重构误差,该误差可以用来计算新颖度得分或者训练一分类的分类器。

这篇文章也利用类似的网络结构,不过他们利用概率方法,并且能够高效的计算一个样本是否是由正常分布生成的。为此,他们首先对正常分布的潜在结构所暗含的参数流形结构线性化,进而使得新颖度概率可计算。并且给出了概率如何分解,然后关于流形正切空间的局部坐标来计算。此外,作者们还对自编码网络的训练进行了改善。

流形表示图示如下

网络结构图示如下

不同方法的效果对比如下

LOF对应的论文为

Lof: identifying density-based local outliers

DRAE对应的论文为

Learning discriminative reconstructions for unsupervised outlier removal,ICCV 2015

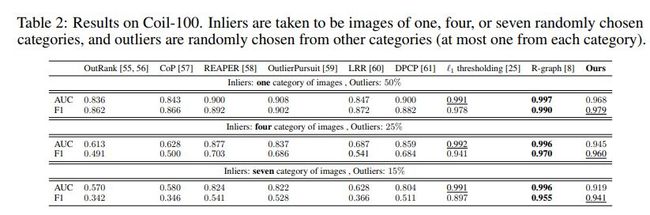

在数据集Coil-100上几种方法的效果对比如下

OutRank对应的论文为

Outlier detection using random walks,ICTAI 2006

Outrank: a graph-based outlier detection framework using random walk, 2008

CoP 对应的论文为

Coherence pursuit: Fast, simple, and robust principal component analysis,2016

REAPER对应的论文为

Robust computation of linear models by convex relaxation, 2015

OutlierPursuit对应的论文为

Robust pca via outlier pursuit,NIPS 2010

LRR对应的论文为

Robust subspace segmentation by low-rank representation, ICML 2010

DPCP对应的论文为

Dual principal component pursuit, ICCV 2015

R-graph对应的论文为

Provable self-representation based outlier detection in a union of subspaces, 2017

代码地址

https://github.com/podgorskiy/GPND

![]() 我是分割线

我是分割线![]()

[3] Hybrid Macro/Micro Level Backpropagation for Training Deep Spiking Neural Networks

Yingyezhe Jin, Wenrui Zhang, Peng Li

Texas A&M University

https://papers.nips.cc/paper/7932-hybrid-macromicro-level-backpropagation-for-training-deep-spiking-neural-networks.pdf

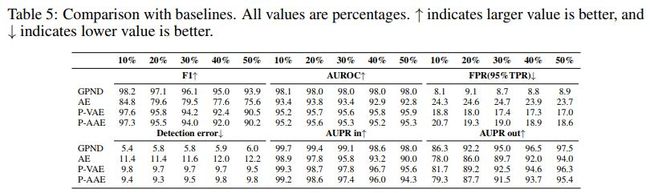

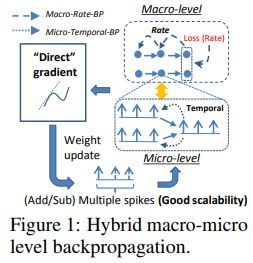

脉冲神经网络(SNNs, Spiking neural networks)能够处理时空信息,而且可以利用超低功率事件驱动的神经形态硬件来实现。但是,SNNs的性能只能达到跟传统的深层人工神经网络一样的效果,这是因为一种长期存在的挑战,即训练过程中复杂的动力学和非可微的脉冲事件。

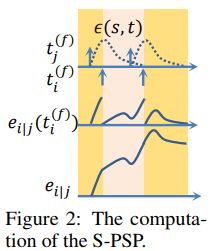

现有的SNN中的误差传播方法受限于它的可扩展性,不能合适的处理脉冲不连续性,编码率损失函数与梯度之间的与或不匹配。这篇文章为训练多层SNNs提出一种混合的宏微等级后向传播算法(HM2-BP)。时序效应能够由脉冲训练的细微突触后电位(S-PSP)精确捕捉。

率编码误差是在宏观层面定义的,计算和反向传播时既有宏观层面又有微观层面。跟现有BP方法不同,HM2-BP直接计算率编码损失函数关于可调参数的梯度。

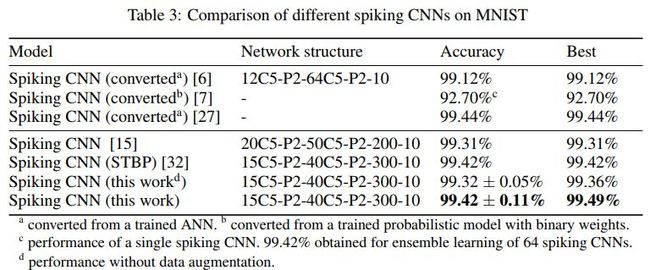

作者们利用训练深层全连接和卷积SNNs在静态MNIST和动态仿神经N-MNIST上对HM2-BP进行评估。HM2-BP在MNIST上达到99.49的准确率,在数据集N-MNIST上达到98.88%的准确率,优于之前报道的基于SNN BP算法的最好效果。

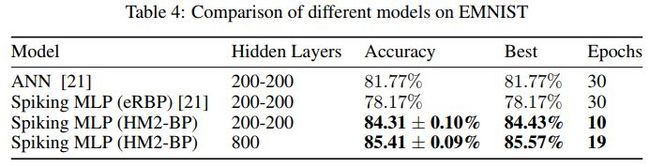

HM2-BP基于SNNs用于EMNIST时,取得了最高的准确率,在数据集T146语料上也取得了高识别率,该语料库包含了16个说话者所说的英语字母,该任务是具有挑战性的时空语音识别基准任务,先前没有基于SNNs的方法在该数据集上取得成功。在处理异步脉冲流时,该方法取得了优于传统深度学习模型的效果。

宏微观反向传播图示如下

S-PSP的计算图示如下

输出层中的宏微观反向传播计算图示如下

隐含层中宏观反向传播图示如下

几种SNN在数据集MNIST上的效果对比如下

其中24对应的论文为

Real-time classification and sensor fusion with a spiking deep belief network

代码地址

https://github.com/dannyneil/edbn

10对应的论文为

Spiking deep networks with lif neurons

6对应的论文为

Fast-classifying, high-accuracy spiking deep networks through weight and threshold balancing, IJCNN 2015

25对应的论文为

Deep spiking networks

15对应的论文为

Training deep spiking neural networks using backpropagation

32对应的论文为

Spatio-temporal backpropagation for training high-performance spiking neural networks

几种模型在N-MNIST上的效果对比如下

其中23对应的论文为

Phased lstm: Accelerating recurrent network training for long or event-based sequences,NIPS 2016

代码地址

https://github.com/philipperemy/tensorflow-phased-lstm

https://github.com/dannyneil/public_plstm

22对应的论文为

Effective sensor fusion with event-based sensors and deep network architectures

4对应的论文为

Skimming digits: neuromorphic classification of spike-encoded images

不同的脉冲卷积神经网络在MNIST上的效果对比如下

其中6对应的论文为

Fastclassifying, high-accuracy spiking deep networks through weight and threshold balancing,IJCNN 2015

7对应的论文为

Backpropagation for energy-efficient neuromorphic computing,NIPS 2015

27对应的论文为

Conversion of continuous-valued deep networks to efficient event-driven networks for image classification

不同模型在EMNIST上的效果对比如下

其中21对应的论文为

Event-driven random backpropagation:Enabling neuromorphic deep learning machines

不同结构在T146上的效果对比如下

代码地址

https://github.com/jinyyy666/mm-bp-snn

![]() 我是分割线

我是分割线![]()

您可能感兴趣