requests-beautifulsoup爬取大学排名网站

1.根据url爬取页面内容

def getHTMLText(url):

try:

r = requests.get(url,timeout=30)#设置超时时长为30s

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return ""2.使用beautifulsoup寻找排名所在的页面的标签位置,并将找到的结果保存到list中

def fillUnivList(ulist,html):

#beautifulsoup解析html代码,把html代码中的元素变成python可以调用的对象

soup = BeautifulSoup(html,'html.parser')

for tr in soup.find('tbody').children:

if isinstance(tr,bs4.element.Tag):#.string可能返回注释内容

tds = tr('td') #等同调用了find_all() 方法,找到tr下的所有td标签

ulist.append([tds[0].string,tds[1].string,tds[2].string])

pass 3.使用format方法格式化输出列表内容

def printUnivList(ulist,num):

if num > len(ulist):

num = len(ulist)

tplt = "{0:^10}\t{1:{3}^10}\t{2:^10}"#{3}表示使用format函数的第三个变量进行填充

print(tplt.format("排名","学校名称","总分",chr(12288)))

for i in range(num):

u = ulist[i]

print(tplt.format(u[0],u[1],u[2],chr(12288)))全代码:

import requests

from bs4 import BeautifulSoup

import bs4

def getHTMLText(url):

try:

r = requests.get(url,timeout=30)#设置超时时长为30s

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return ""

def fillUnivList(ulist,html):

soup = BeautifulSoup(html,'html.parser')

for tr in soup.find('tbody').children:

if isinstance(tr,bs4.element.Tag):#防止.children返回null

tds = tr('td')

ulist.append([tds[0].string,tds[1].string,tds[2].string])

pass

def printUnivList(ulist,num):

if num > len(ulist):

num = len(ulist)

tplt = "{0:^10}\t{1:{3}^10}\t{2:^10}"#{3}表示使用format函数的第三个变量进行填充

print(tplt.format("排名","学校名称","总分",chr(12288)))

for i in range(num):

u = ulist[i]

print(tplt.format(u[0],u[1],u[2],chr(12288)))

def mian():

uinfo = []

url = "http://www.gaokaopai.com/paihang-otype-2.html"

html = getHTMLText(url)

fillUnivList(uinfo,html)

printUnivList(uinfo,20)

mian()

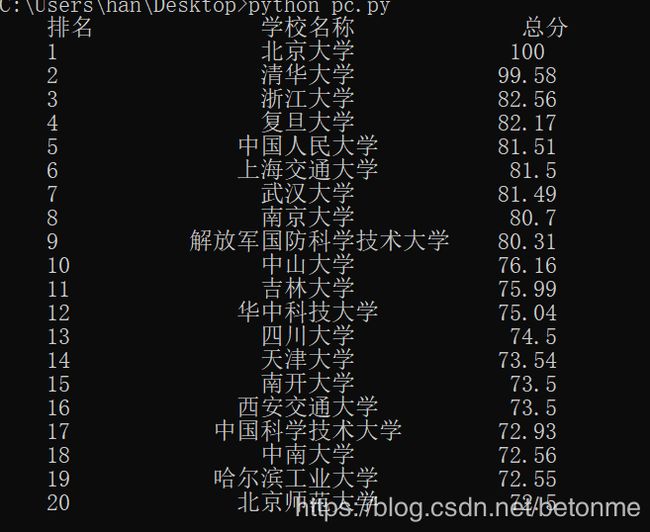

输出结果:

值得注意的是request-beautifulsoup只能爬取镶嵌在html页面里代码的内容,如果想要页面是通过js加载出来的,就无法获取。

本例中由于页面中只镶嵌了25所大学的排名其余均为js加载所得,所以只能爬取25所大学排名。

这里可通过改变爬取网页,或者通过动态网页爬取技术实现