Consul服务治理原理简介及使用过程

consul 原理简述

-

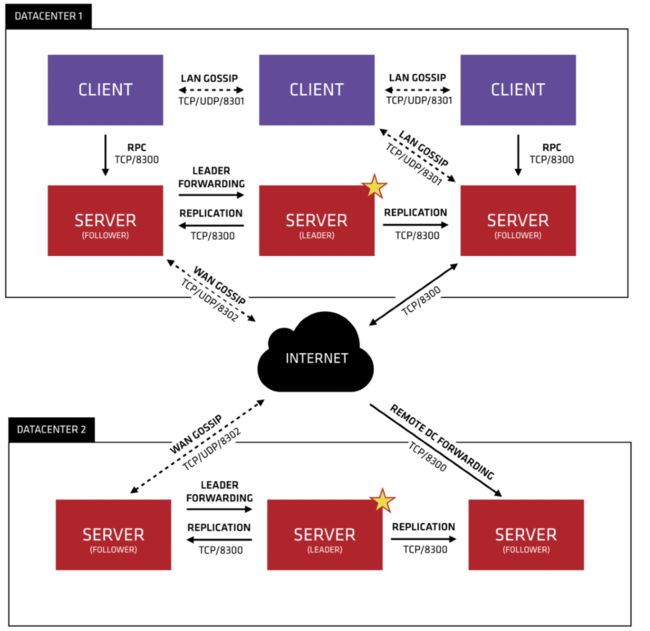

图中有两个数据中心,分别为Datacenter1和Datacenter2 Consul非常好的支持多个数据中心,每个数据中心内,有客户端和服务器端,服务器一般为3~5个,这样可以在稳定和性能上达到平衡,因为更多的机器会使数据同步很慢。不过客户端是没有限制的,可以有成千上万个。

-

数据中心内的所有节点都会加入到Gossip协议。这就意味着有一个Gossip池,其中包含这个数据中心所有的节点。

-

客户端不需要去配置服务器地址信息,发现工作会自动完成。

-

检测故障节点的工作不是放在服务器端,而是分布式的;这使得失败检测相对于本地化的心跳机制而言,更具可拓展性。

-

在选择leader这种重要的事情发生的时候,数据中心被用作消息层来做消息广播。

-

每个数据中心内的服务器都是单个Raft中节点集的一部分。这意味着他们一起工作,选择一个单一的领导者——一个具有额外职责的选定的服务器。leader负责处理所有查询和事务。事务也必须作为同步协议的一部分复制到节点集中的所有节点。由于这个要求,当非leader服务器接收到RPC请求时,就会将请求其转发给集群leader。

-

服务器端节点同时也作为WAN Gossip池的一部分,WAN池和LAN池不同的是,它针对网络高延迟做了优化,而且只包含其他Consul服务器的节点。这个池的目的是允许数据中心以最少的消耗方式发现对方。启动新的数据中心与加入现有的WAN Gossip一样简单。因为这些服务器都在这个池中运行,它还支持跨数据中心请求。当服务器收到对不同数据中心的请求时,它会将其转发到正确数据中心中的随机服务器。那个服务器可能会转发给本地的leader。

-

这样会使数据中心的耦合非常低。但是由于故障检测,连接缓存和复用,跨数据中心请求相对快速可靠。

-

总的来说,数据不会在不同的数据中心之间做复制备份。当收到一个请求处于别的数据中心的资源时,本地的Consul服务器会发一个RPC请求到远端的Consul服务器,然后返回结果。如果远端数据中心处于不可用状态,那么这么资源也会不可用,但这不影响本地的数据中心。在一些特殊的情况下,有限的数据集会被跨数据中心复制备份,比如说Consul内置的ACL复制能力,或者像consul-replicate这样的外部工具。

consul环境搭建

consul 安装

下载页面

https://www.consul.io/downloads.html

mac 下载版本

https://releases.hashicorp.com/consul/1.7.3/consul_1.7.3_darwin_amd64.zip

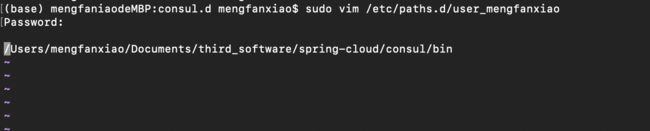

创建文件夹存放consul可执行文件

/Users/mengfanxiao/Documents/third_software/spring-cloud/consul/bin

配置环境变量

sudo vim /etc/paths.d/user_mengfanxiao

source /etc/profile

启动参数说明

-

-dev 开发者模式 该节点的启动不能用于生产环境,因为该模式下不会持久化任何状态 该启动模式仅仅是为了快速便捷的启动单节点consul

-

-ui 启动自有主机的界面

-

-bootstrap-expect 1 集群节点,表示等待多少个节点再启动,这里是1个,一个就启动

-

-bind=127.0.0.1 绑定IP ,本机IP地址,内网IP

-

-advertise-wan=10.23.123.12 绑定外网ip

-

-node=node1 节点名称,如果没有,默认是主机名

-

-server 设置为服务端

-

-data-dir /tmp/consul 数据存储目录为 /tmp/consul

-

-datacenter=dc1 数据中心

启动

-

agent可以运行在server或者client模式

consul agent -dev -server -bootstrap-expect 1 -data-dir /Users/mengfanxiao/Documents/third_software/spring-cloud/consul/data -node=node1

-

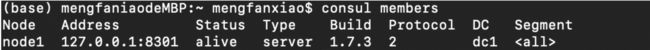

查看成员

consul members

-

创建服务

mkdir -p /Users/mengfanxiao/Documents/third_software/spring-cloud/consul/bin/consul.d

1⃣️ 创建一个web服务

echo '{"service": {"name": "web", "tags": ["rails"], "port": 801}}' >/Users/mengfanxiao/Documents/third_software/spring-cloud/consul/bin/consul.d/web.json

2⃣️ 创建一个service2服务

echo '{"service": {"name": "service2", "tags": ["rails"], "port": 802}}' >/Users/mengfanxiao/Documents/third_software/spring-cloud/consul/bin/consul.d/service2.json

-

先关闭之前的代理

-

启动代理

consul agent -dev -config-dir /Users/mengfanxiao/Documents/third_software/spring-cloud/consul/bin/consul.d/

-

通过DNS查询服务

服务的DNS名称是 NAME.service.consul 服务名称为service2、web

1⃣️ Dig是一个在类Unix命令行模式下查询DNS包括NS记录,A记录,MX记录等相关信息的工具

2⃣️

dig @127.0.0.1 -p 8600 service2.service.consul

-

Http查询

curl http://localhost:8500/v1/catalog/service/service2

-

查询健康

curl 'http://localhost:8500/v1/health/service/service2?passing'

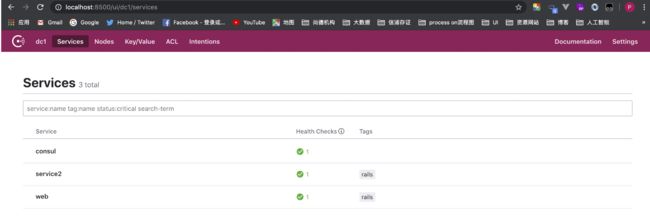

Consul Web界面

-

加入 -ui 参数, 启动自有主机的界面

consul agent -dev -ui -config-dir /Users/mengfanxiao/Documents/third_software/spring-cloud/consul/bin/consul.d/

-

在浏览器访问 http://localhost:8500/ui

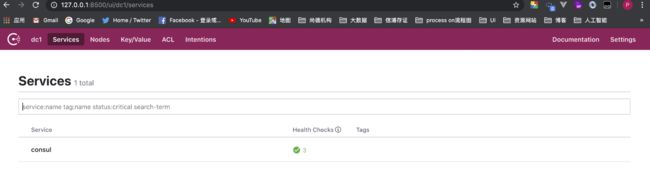

Docker consul安装

consul 服务发现 集群 docker 版

下载镜像

docker pull consul

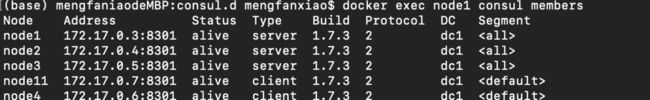

consul 服务端

-

服务端node1

docker run -d --name node1 -e 'CONSUL_LOCAL_CONFIG={"skip_leave_on_interrupt": true}' consul agent -server -node=node1 -bootstrap-expect=2

-

查看node1的ip

JOIN_IP="$(docker inspect -f '{{.NetworkSettings.IPAddress}}' node1)"

-

服务端node2

docker run -d --name node2 -e 'CONSUL_LOCAL_CONFIG={"skip_leave_on_interrupt": true}' consul agent -server -node=node2 -join $JOIN_IP

-

服务端node3

docker run -d --name node3 -e 'CONSUL_LOCAL_CONFIG={"skip_leave_on_interrupt": true}' consul agent -server -node=node3 -join $JOIN_IP

consul客户端

-

客户端node4

docker run -d --name node4 -e 'CONSUL_LOCAL_CONFIG={"skip_leave_on_interrupt": true}' consul agent -node=node4 -join $JOIN_IP

-

客户端node11 带ui

docker run -d --name node11 -p 8400:8400 -p 8500:8500 -p 8600:53/udp -e 'CONSUL_LOCAL_CONFIG={"skip_leave_on_interrupt": true}' consul agent -ui -node=node11 -client=0.0.0.0 -join $JOIN_IP

-

上述操作的执行情况

-

把节点加入集群

在创建docker容器时忘记加入-join $JOIN_IP这个参数了,那么就可以用以下方法加入集群

1⃣️

docker exec node20 consul join $JOIN_IP node20 要改为 你需要加的那个容器节点名字

2⃣️ 或者进入该容器内部执行

consul join $JOIN_IP

-

查看节点

docker exec node1 consul members

参考文献

https://blog.csdn.net/fenglailea/article/details/79093848 https://blog.csdn.net/fenglailea/article/details/79098246 https://www.consul.io/docs/internals/architecture.html

原理介绍的比较详细的一篇文章 https://blog.csdn.net/jiangqingyao/article/details/92856466