- 计算机视觉CV学习路线

我喝AD钙

我的学习笔记计算机视觉学习人工智能

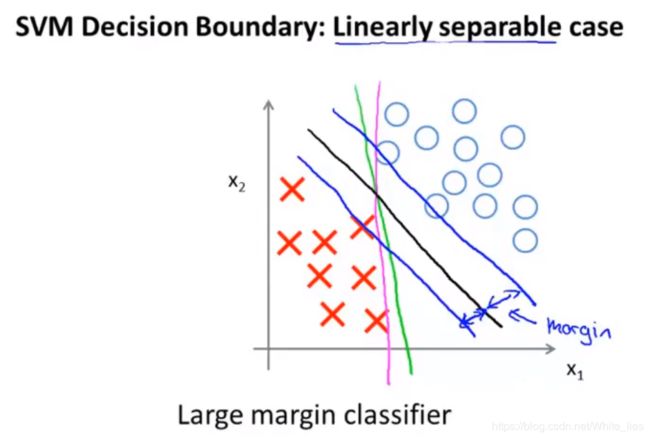

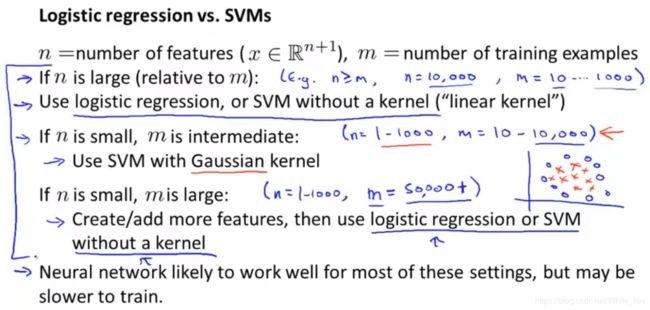

计算机视觉CV学习路线1.基础准备(可参考mooc学习)2.计算机视觉基础知识(可参考mooc学习、计算机图形学)3.经典计算机视觉算法(可参考吴恩达机器学习课程、国内外计算机图形学课程)4.深度学习基础(参考吴恩达和TF、Keras官网手册)5.深度学习在计算机视觉中的应用(李飞飞课程、arxiv论文原文和解析博客,实战参考gitee/github)6.现代计算机视觉技术(arxiv论文原文和解

- 七.正则化

愿风去了

吴恩达机器学习之正则化(Regularization)http://www.cnblogs.com/jianxinzhou/p/4083921.html从数学公式上理解L1和L2https://blog.csdn.net/b876144622/article/details/81276818虽然在线性回归中加入基函数会使模型更加灵活,但是很容易引起数据的过拟合。例如将数据投影到30维的基函数上,模

- 吴恩达机器学习全课程笔记第一篇

亿维数组

MachineLearning机器学习笔记人工智能

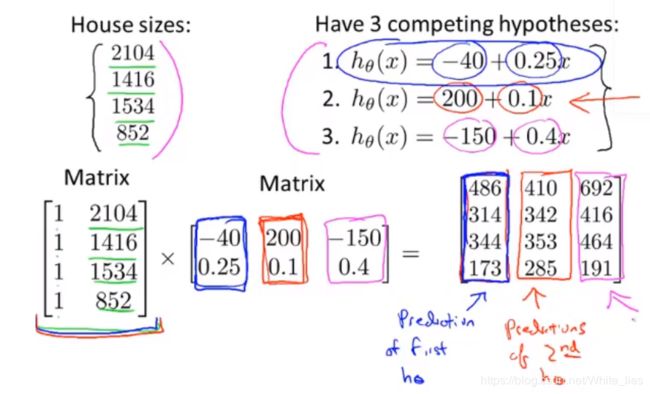

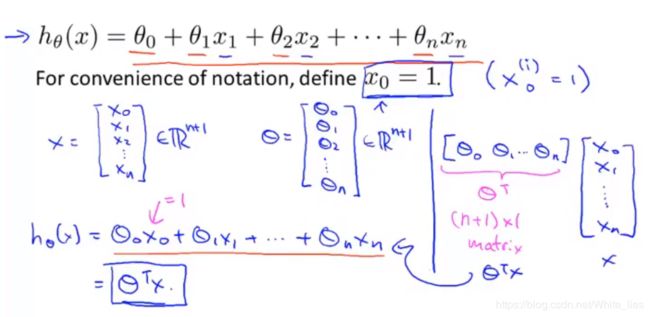

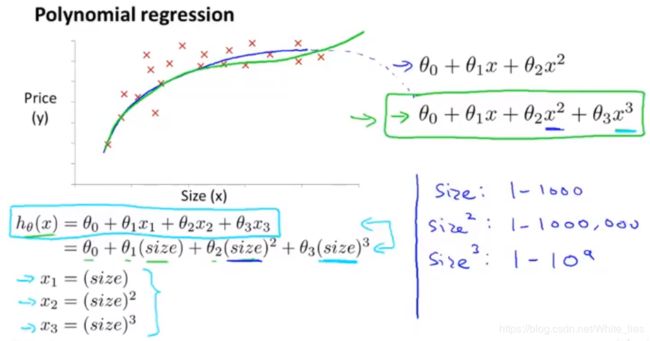

目录前言P1-P8监督学习无监督学习P9-P14线性回归模型成本(代价)函数P15-P20梯度下降P21-P24多类特征向量化多元线性回归的梯度下降P25-P30特征缩放检查梯度下降是否收敛学习率的选择特征工程多项式回归前言从今天开始,争取能够在开学之前(2.25)把b站上的【吴恩达机器学习】教程过一遍,并把笔记记录于此,本笔记将会把此课程每一p的重点内容及其截屏记录于此,以供大家参考和本人日后复

- 吴恩达机器学习全课程笔记第二篇

亿维数组

MachineLearning机器学习笔记人工智能学习

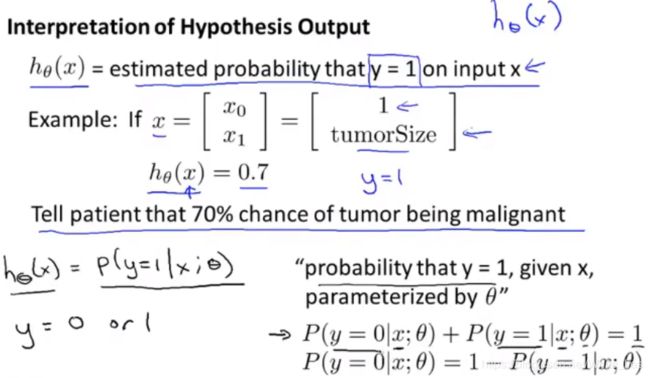

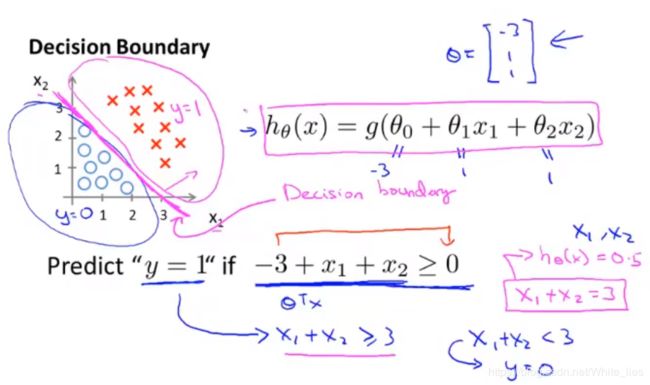

目录前言P31-P33logistics(逻辑)回归决策边界P34-P36逻辑回归的代价函数梯度下降的实现P37-P41过拟合问题正则化代价函数正则化线性回归正则化logistics回归前言这是吴恩达机器学习笔记的第二篇,第一篇笔记请见:吴恩达机器学习全课程笔记第一篇完整的课程链接如下:吴恩达机器学习教程(bilibili)推荐网站:scikit-learn中文社区吴恩达机器学习学习资料(gith

- 吴恩达机器学习—大规模机器学习

魏清宇

学习大数据集数据量多,模型效果肯定会比较好,但是大数据也有它自己的问题,计算复杂如果存在100000000个特征,计算量是相当大的,在进行梯度下降的时候,还要反复求损失函数的偏导数,这样一来计算量更大。那么有没有简单的方法来应对大量的数据呢?我们可以采取随机抽样,比如,抽取1000个样本进行模型的构建。那么如何决定抽取多少样本呢?可以通过学习曲线获得,随着数据量的增加,无论是偏差和误差,都会趋向于

- 吴恩达机器学习—正则化

魏清宇

过拟合问题欠拟合与过拟合当变量过少时,可能存在欠拟合;当变量过多时,会存在过拟合。过拟合可能对现有数据拟合效果较好,损失函数值几乎为零,但是不能进行泛化时,即不适于非训练集的其他数据。如何解决过拟合问题特征变量过多造成过拟合绘制假设模型图像,但当特征变量变多时,绘制很困难。当变量过多而训练数据较少时,容易出现过拟合。过拟合的解决办法解决过拟合问题,通常有两种方法:一种是减少特征的数量,可以通过人工

- 吴恩达机器学习—推荐系统

魏清宇

问题规划引例—电影推荐假设已有的数据如上所示,洋红色线内的数据表示缺失数据,那么我们如何根据已有的评分数据来预测这些缺失的数据呢?基于特征的推荐算法基于内容的推荐系统已知数据如上,有四个人对于不同电影的评分,我们还有分别表示电影包含浪漫成分和动作片成分的多少。那么每一个电影都可以用一个向量来表示,如第一个电影可以表示为,其中第一个元素为常数。那么对于每一个用户j,我们可以用一个学习算法学习参数,然

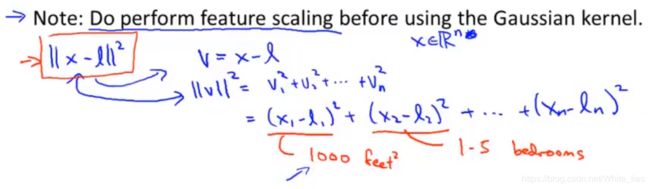

- 【吴恩达机器学习】第八周—聚类降维Kmeans算法

Sunflow007

31.jpg1.聚类(Clustering)1.1介绍之前的课程介绍的都是监督学习、而聚类属于非监督学习,在一个典型的监督学习中,我们有一个有标签的训练集,我们的目标是找到能够区分正样本和负样本的决策边界,在这里的监督学习中,我们有一系列标签,我们需要据此拟合一个假设函数。与此不同的是,在非监督学习中,我们的数据没有附带任何标签,我们拿到的数据就是这样的:1.png在这里我们有一系列点,却没有标签

- 吴恩达机器学习笔记(2)

python小白22

一.逻辑回归1.什么是逻辑回归?逻辑回归是一种预测变量为离散值0或1情况下的分类问题,在逻辑回归中,假设函数。2.模型描述在假设函数中,,为实数,为Sigmoid函数,也叫Logistic函数。模型解释:,即就是对一个输入,的概率估计。损失函数的理解:所谓最大似然估计,就是我们想知道哪套参数组合对应的曲线最可能拟合我们观测到的数据,也就是该套参数拟合出观测数据的概率最大,而损失函数的要求是预测结果

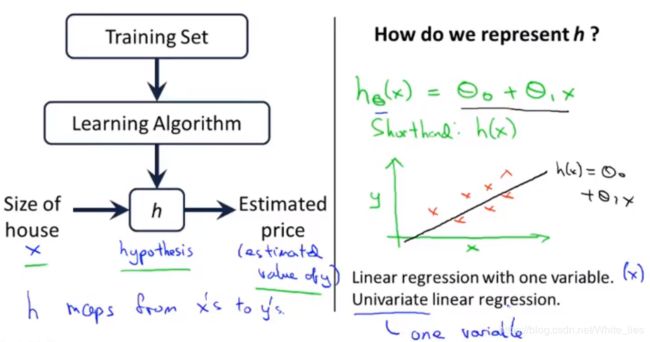

- 【Andrew Ng机器学习】单变量线性回归-模型描述

jenye_

课程:吴恩达机器学习一个监督学习的例子——房价预测使用的是一组俄勒冈州波特兰市的城市住房价格的数据。根据不同的尺寸的房间对应的不同售价,组成的数据集来画图。你有一个朋友想要卖房子,假设房子的大小是1250平方英尺,那么这套房可以卖多少钱?此时就可以进行模型拟合。根据这个模型,那么你可以告诉他这套房或许可以卖到220k。监督学习:每一个例子都有“正确的答案”,也就是说我们知道了数据集中卖出的房子的实

- ML:2-2-3 多分类问题multicalss

skylar0

分类机器学习人工智能

文章目录1.多分类问题的定义2.softmax3.神经网络的softmax输出【吴恩达机器学习65-67】1.多分类问题的定义classification问题可能的output大于2种。multiclass的预测图像可能是右侧这样的。2.softmaxsoftmaxregression算法是logisticregression的泛化(通用化)。【binaryclassification---->m

- Coursera吴恩达机器学习课程笔记——神经网络: 学习(Neural Networks: Learning)

yanglamei1962

机器学习笔记神经网络

9神经网络:学习(NeuralNetworks:Learning)9.1代价函数(CostFunction)神经网络的分类问题有两种:二元分类问题(0/1分类)只有一个输出单元(K=1K=1K=1)多元(KKK)分类问题输出单元不止一个(K>1K\gt1K>1)神经网络的代价函数公式:hΘ(x)=a(L)=g(Θ(L−1)a(L−1))=g(z(L))h_\Theta(x)=a^{(L)}=g(\

- 吴恩达机器学习笔记十二 Sigmoid激活函数的替代方案 激活函数的选择 为什么要使用激活函数

爱学习的小仙女!

机器学习机器学习人工智能

在需求预测案例中,awareness这个输入可能不是二元(binary)的,或许是一点(alittlebit)、有些(somewhat)或完全(extremely),此时相比将awareness规定为0、1,不如考虑概率,认为它是一个0-1之间的数。激活函数可以采用ReLU函数(rectifiedlinearunit)三个常用的激活函数使用线性激活函数也可以看作是没有激活函数。激活函数的选择输出层

- 吴恩达机器学习笔记十 神经网络 TensorFlow 人工智能

爱学习的小仙女!

机器学习神经网络人工智能深度学习

神经网络:说几层的时候是指隐藏层及输出层,不包含输入层。例如下图是一个四层神经网络。前向传播(forwardpropagation)越靠近输出层,该层的神经元数量越少TensorFlow(张量流)实现神经网络的搭建sequential()把两层顺序连接起来;如果有新的x,用predict()人工智能

- 吴恩达机器学习- 正则化

YANWeichuan

过拟合和欠拟合定义和形态解决方法减少特征值数量正则化正则化惩罚θ系数线性回归正则化逻辑回归正则化

- 最强机器学习入门博客(吴恩达机器学习课程总结)

PengHao666999

机器学习人工智能

机器学习的概述诞生现实生活许多领域的问题不能通过显式编程实现,比如制造自动驾驶汽车、智能工厂、规模农业、计算机视觉等等,一种好的实现方式是通过学习算法让计算机自己学习如何做。现在现在是学习机器学习最好的时机,因为机器学习在未来能产生巨大的价值未来机器学习在软件领域方面取得了巨大的价值,比如智能推荐,网络搜索,图像识别等机器学习在许多其他的领域仍有巨大的价值,比如未来在自动驾驶汽车,工厂,农业,医疗

- 在学习吴恩达机器学习课程中遇到的一些问题

ttyykx

学习机器学习jupyter

C1_W1_Lab04_Cost_function_Soln中遇到的一些问题1、importnumpyasnp%matplotlibnotebookimportmatplotlib.pyplotaspltfromlab_utils_uniimportplt_intuition,plt_stationary,plt_update_onclick,soup_bowlplt.style.use('./d

- 吴恩达机器学习Coursera-week11

geekpy

PhotoOCR在此章的课程中,Andrew主要是想通过OCR问题的解决来阐释在实际项目中我们应该如何定义问题,并将一个大问题分解为多个小问题,并通过pipeline的方式将对这些小问题的解决方案串联起来,从而解决这个大问题。我认为这是解决实际问题的一个经典的方法论,有助于我们在实际工作和生活中更好地思考问题,分解问题,并最终解决问题。ProblemDescriptionandPipeline此小

- 吴恩达机器学习介绍第一章介绍

清☆茶

机器学习人工智能

1.机器学习的概念在进行特定编程的情况下,给予计算机学习的能力。机器学习是一种人工智能的分支,它关注如何通过计算机算法和模型来使计算机系统从数据中学习和改进。机器学习的目标是让计算机系统能够自动分析和理解数据,并根据数据的模式和规律做出预测和决策,而无需明确的编程指令。机器学习可以分为监督学习、无监督学习和强化学习三种类型。在监督学习中,计算机系统通过使用带有标签的训练数据来学习模式和规律,然后根

- 【Andrew Ng机器学习】单变量线性回归-梯度下降

jenye_

课程:吴恩达机器学习此篇我们将学习梯度下降算法,我们之前已经定义了代价函数J,梯度下降法可以将代价函数J最小化。梯度下降是很常用的算法,他不仅被用在线性回归上,还被广泛应用与机器学习的众多领域。之后,我们也会用到梯度下降法最小化其他函数,而不仅仅是最小化线性回归的额代价函数J。我们的问题我们有一个代价函数J(\theta_0|theta_1$),可能是线性回归的代价函数,也可能是其他需要最小化的函

- 第八章 正则化

tomas家的小拨浪鼓

该系列文章为,观看“吴恩达机器学习”系列视频的学习笔记。虽然每个视频都很简单,但不得不说每一句都非常的简洁扼要,浅显易懂。非常适合我这样的小白入门。本章含盖8.1过拟合问题8.2代价函数8.3线性回归的正则化8.4Logistic回归的正则化8.1过拟合问题在将线性回归和logistic回归应用到某些机器学习应用中时,会出现过度拟合问题,导致它们表现欠佳。正则化能够改善或者减少过度拟合问题。什么是

- 2022-12-14科研日志

独孤西

今天主要学习了吴恩达机器学习的网课,又复习了一下机器学习;然后看了看VIO相关资料论文,今天看了几篇知网上搜到的关于VIO的硕士博士毕业论文和一篇20年的VIO综述,这方面的论文对于一个领域一般都有比较全面的描述。通过阅读我也了解了VIO领域的一些典型成果。VIO主流成果VIO是属于SLAM领域中的一个子课题,典型的VIO系统同样是由前端、后端、回环检测等几部分构成的。VIO的前端按是否提取特征点

- 吴恩达机器学习笔记-Logistic回归模型

Carey_Wu

回归函数在逻辑回归模型中我们不能再像之前的线性回归一样使用相同的代价函数,否则会使得输出的结果图像呈现波浪状,也就是说不再是个凸函数。代价函数的表达式之前有表示过,这里我们把1/2放到求和里面来。这里的求和部分我们可以表示为:很显然,如果我们把在之前说过的分类问题的假设函数带进去,即,得到的结果可能就是上述所说的不断起伏的状况。如果这里使用梯度下降法,不能保证能得到全局收敛的值,这个函数就是所谓的

- 吴恩达机器学习笔记(1)

python小白22

一.初识机器学习1.监督学习在监督学习中,训练数据既有特征又有标签,通过训练,让机器可以自己找到特征和标签之间的联系,在面对只有特征没有标签的数据时,可以判断出标签。监督学习可以分为回归问题和分类问题。回归问题是利用训练出的模型,预测连续的数值输出;分类问题是预测离散值的输出。2.无监督学习无监督学习是给算法大量的数据,要求它找出数据的类型结构。无监督学习的数据没有标签,或是所有数据都是同一种标签

- ML:2-2neural network layer

skylar0

机器学习

文章目录1.神经网络层2.更复杂的神经网络3.神经网络的前向传播【吴恩达机器学习笔记p47-49】1.神经网络层【了解神经网络如何完成预测的】input:4个数字的向量。3个神经元分别做logisticregression。下角标:标识第i个神经元的值。上角标:表示第j层layer的值。这3个神经元所做的logisticregression的结果组成了一个向量a将传给ouputlayer。第1层的

- ML:5-1 neural networks

skylar0

机器学习

文章目录course2框架1.neuralnetworks(deeplearning)2.DemandPrediction【吴恩达机器学习p43-46】course2框架一、neuralnetworks-inference(预测)二、neuralnetworks-training三、practiceadviceforbuildingmachinelearningsystems四、decisiont

- 吴恩达机器学习笔记(1)——单变量线性回归

机智的神棍酱

上一个笔记,我们大概了解了什么是机器学习以及机器学习的两个重要的分类,本篇笔记将带领大家了解机器学习的第一个模型——线性回归例题为了让大家更加直观的理解这个模型,我们引入一个例题,我们有一组波特兰市的城市住房的价格数据,我们要通过这些数据来找出一个函数,来预测任意面积下的房价,这就是一个简单的线性回归问题。这里给出的数据是一组房子面积对应的房价数据集其中m代表训练集,x是输入,y是输出。我们用(x

- 【吴恩达机器学习】第一周课程笔记

Estella_07

机器学习笔记人工智能

Hello,这里是小梁。下面是我近期学习机器学习的笔记,出发点是希望对自己起到一个督促和输出的作用如果你对我的笔记感兴趣欢迎Like,有不足之处也欢迎评论留言B站【2022吴恩达机器学习Deeplearning.ai课程】笔记参考【吴恩达《MachineLearning》精炼笔记】1机器学习的定义与分类1.1监督学习Supervisedlearning1.2无监督学习Unsupervisedlea

- 吴恩达机器学习笔记

AADGSEGA

机器学习

吴恩达机器学习笔记第一周基本概念监督学习分为回归算法和分类算法无监督学习事先没有正确答案。例如将客户群分成不同类,混合的声音区分开先在Octave或者matlab实现,可行,再尝试用Java或者python或者C++重新写出来只考虑两个变量的线性回归:例如找出一条函数拟合房价的那个例子里面的数据点。数据集:输入x[i],输出y[i],中间函数是h。使用成本函数(即方差误差,这里假设是只有房屋大小这

- ML学习安排和资源链接

Nice night

#ML吴恩达机器学习

第一阶段:学习前置数学知识机器学习的数学基础_二进制人工智能的博客-CSDN博客第二阶段:认知机器学习吴恩达机器学习【2022中文版教程全集】_哔哩哔哩_bilibili视频5h,看了一点发现后面没字幕了,这个(强推|双字)2022吴恩达机器学习Deeplearning.ai课程_哔哩哔哩_bilibili视频19h。但是这个是属于新课,所以还是先看第三阶段上:仔细了解机器学习视频链接:[中英字幕

- SAX解析xml文件

小猪猪08

xml

1.创建SAXParserFactory实例

2.通过SAXParserFactory对象获取SAXParser实例

3.创建一个类SAXParserHander继续DefaultHandler,并且实例化这个类

4.SAXParser实例的parse来获取文件

public static void main(String[] args) {

//

- 为什么mysql里的ibdata1文件不断的增长?

brotherlamp

linuxlinux运维linux资料linux视频linux运维自学

我们在 Percona 支持栏目经常收到关于 MySQL 的 ibdata1 文件的这个问题。

当监控服务器发送一个关于 MySQL 服务器存储的报警时,恐慌就开始了 —— 就是说磁盘快要满了。

一番调查后你意识到大多数地盘空间被 InnoDB 的共享表空间 ibdata1 使用。而你已经启用了 innodbfileper_table,所以问题是:

ibdata1存了什么?

当你启用了 i

- Quartz-quartz.properties配置

eksliang

quartz

其实Quartz JAR文件的org.quartz包下就包含了一个quartz.properties属性配置文件并提供了默认设置。如果需要调整默认配置,可以在类路径下建立一个新的quartz.properties,它将自动被Quartz加载并覆盖默认的设置。

下面是这些默认值的解释

#-----集群的配置

org.quartz.scheduler.instanceName =

- informatica session的使用

18289753290

workflowsessionlogInformatica

如果希望workflow存储最近20次的log,在session里的Config Object设置,log options做配置,save session log :sessions run ;savesessio log for these runs:20

session下面的source 里面有个tracing

- Scrapy抓取网页时出现CRC check failed 0x471e6e9a != 0x7c07b839L的错误

酷的飞上天空

scrapy

Scrapy版本0.14.4

出现问题现象:

ERROR: Error downloading <GET http://xxxxx CRC check failed

解决方法

1.设置网络请求时的header中的属性'Accept-Encoding': '*;q=0'

明确表示不支持任何形式的压缩格式,避免程序的解压

- java Swing小集锦

永夜-极光

java swing

1.关闭窗体弹出确认对话框

1.1 this.setDefaultCloseOperation (JFrame.DO_NOTHING_ON_CLOSE);

1.2

this.addWindowListener (

new WindowAdapter () {

public void windo

- 强制删除.svn文件夹

随便小屋

java

在windows上,从别处复制的项目中可能带有.svn文件夹,手动删除太麻烦,并且每个文件夹下都有。所以写了个程序进行删除。因为.svn文件夹在windows上是只读的,所以用File中的delete()和deleteOnExist()方法都不能将其删除,所以只能采用windows命令方式进行删除

- GET和POST有什么区别?及为什么网上的多数答案都是错的。

aijuans

get post

如果有人问你,GET和POST,有什么区别?你会如何回答? 我的经历

前几天有人问我这个问题。我说GET是用于获取数据的,POST,一般用于将数据发给服务器之用。

这个答案好像并不是他想要的。于是他继续追问有没有别的区别?我说这就是个名字而已,如果服务器支持,他完全可以把G

- 谈谈新浪微博背后的那些算法

aoyouzi

谈谈新浪微博背后的那些算法

本文对微博中常见的问题的对应算法进行了简单的介绍,在实际应用中的算法比介绍的要复杂的多。当然,本文覆盖的主题并不全,比如好友推荐、热点跟踪等就没有涉及到。但古人云“窥一斑而见全豹”,希望本文的介绍能帮助大家更好的理解微博这样的社交网络应用。

微博是一个很多人都在用的社交应用。天天刷微博的人每天都会进行着这样几个操作:原创、转发、回复、阅读、关注、@等。其中,前四个是针对短博文,最后的关注和@则针

- Connection reset 连接被重置的解决方法

百合不是茶

java字符流连接被重置

流是java的核心部分,,昨天在做android服务器连接服务器的时候出了问题,就将代码放到java中执行,结果还是一样连接被重置

被重置的代码如下;

客户端代码;

package 通信软件服务器;

import java.io.BufferedWriter;

import java.io.OutputStream;

import java.io.O

- web.xml配置详解之filter

bijian1013

javaweb.xmlfilter

一.定义

<filter>

<filter-name>encodingfilter</filter-name>

<filter-class>com.my.app.EncodingFilter</filter-class>

<init-param>

<param-name>encoding<

- Heritrix

Bill_chen

多线程xml算法制造配置管理

作为纯Java语言开发的、功能强大的网络爬虫Heritrix,其功能极其强大,且扩展性良好,深受热爱搜索技术的盆友们的喜爱,但它配置较为复杂,且源码不好理解,最近又使劲看了下,结合自己的学习和理解,跟大家分享Heritrix的点点滴滴。

Heritrix的下载(http://sourceforge.net/projects/archive-crawler/)安装、配置,就不罗嗦了,可以自己找找资

- 【Zookeeper】FAQ

bit1129

zookeeper

1.脱离IDE,运行简单的Java客户端程序

#ZkClient是简单的Zookeeper~$ java -cp "./:zookeeper-3.4.6.jar:./lib/*" ZKClient

1. Zookeeper是的Watcher回调是同步操作,需要添加异步处理的代码

2. 如果Zookeeper集群跨越多个机房,那么Leader/

- The user specified as a definer ('aaa'@'localhost') does not exist

白糖_

localhost

今天遇到一个客户BUG,当前的jdbc连接用户是root,然后部分删除操作都会报下面这个错误:The user specified as a definer ('aaa'@'localhost') does not exist

最后找原因发现删除操作做了触发器,而触发器里面有这样一句

/*!50017 DEFINER = ''aaa@'localhost' */

原来最初

- javascript中showModelDialog刷新父页面

bozch

JavaScript刷新父页面showModalDialog

在页面中使用showModalDialog打开模式子页面窗口的时候,如果想在子页面中操作父页面中的某个节点,可以通过如下的进行:

window.showModalDialog('url',self,‘status...’); // 首先中间参数使用self

在子页面使用w

- 编程之美-买书折扣

bylijinnan

编程之美

import java.util.Arrays;

public class BookDiscount {

/**编程之美 买书折扣

书上的贪心算法的分析很有意思,我看了半天看不懂,结果作者说,贪心算法在这个问题上是不适用的。。

下面用动态规划实现。

哈利波特这本书一共有五卷,每卷都是8欧元,如果读者一次购买不同的两卷可扣除5%的折扣,三卷10%,四卷20%,五卷

- 关于struts2.3.4项目跨站执行脚本以及远程执行漏洞修复概要

chenbowen00

strutsWEB安全

因为近期负责的几个银行系统软件,需要交付客户,因此客户专门请了安全公司对系统进行了安全评测,结果发现了诸如跨站执行脚本,远程执行漏洞以及弱口令等问题。

下面记录下本次解决的过程以便后续

1、首先从最简单的开始处理,服务器的弱口令问题,首先根据安全工具提供的测试描述中发现应用服务器中存在一个匿名用户,默认是不需要密码的,经过分析发现服务器使用了FTP协议,

而使用ftp协议默认会产生一个匿名用

- [电力与暖气]煤炭燃烧与电力加温

comsci

在宇宙中,用贝塔射线观测地球某个部分,看上去,好像一个个马蜂窝,又像珊瑚礁一样,原来是某个国家的采煤区.....

不过,这个采煤区的煤炭看来是要用完了.....那么依赖将起燃烧并取暖的城市,在极度严寒的季节中...该怎么办呢?

&nbs

- oracle O7_DICTIONARY_ACCESSIBILITY参数

daizj

oracle

O7_DICTIONARY_ACCESSIBILITY参数控制对数据字典的访问.设置为true,如果用户被授予了如select any table等any table权限,用户即使不是dba或sysdba用户也可以访问数据字典.在9i及以上版本默认为false,8i及以前版本默认为true.如果设置为true就可能会带来安全上的一些问题.这也就为什么O7_DICTIONARY_ACCESSIBIL

- 比较全面的MySQL优化参考

dengkane

mysql

本文整理了一些MySQL的通用优化方法,做个简单的总结分享,旨在帮助那些没有专职MySQL DBA的企业做好基本的优化工作,至于具体的SQL优化,大部分通过加适当的索引即可达到效果,更复杂的就需要具体分析了,可以参考本站的一些优化案例或者联系我,下方有我的联系方式。这是上篇。

1、硬件层相关优化

1.1、CPU相关

在服务器的BIOS设置中,可

- C语言homework2,有一个逆序打印数字的小算法

dcj3sjt126com

c

#h1#

0、完成课堂例子

1、将一个四位数逆序打印

1234 ==> 4321

实现方法一:

# include <stdio.h>

int main(void)

{

int i = 1234;

int one = i%10;

int two = i / 10 % 10;

int three = i / 100 % 10;

- apacheBench对网站进行压力测试

dcj3sjt126com

apachebench

ab 的全称是 ApacheBench , 是 Apache 附带的一个小工具 , 专门用于 HTTP Server 的 benchmark testing , 可以同时模拟多个并发请求。前段时间看到公司的开发人员也在用它作一些测试,看起来也不错,很简单,也很容易使用,所以今天花一点时间看了一下。

通过下面的一个简单的例子和注释,相信大家可以更容易理解这个工具的使用。

- 2种办法让HashMap线程安全

flyfoxs

javajdkjni

多线程之--2种办法让HashMap线程安全

多线程之--synchronized 和reentrantlock的优缺点

多线程之--2种JAVA乐观锁的比较( NonfairSync VS. FairSync)

HashMap不是线程安全的,往往在写程序时需要通过一些方法来回避.其实JDK原生的提供了2种方法让HashMap支持线程安全.

- Spring Security(04)——认证简介

234390216

Spring Security认证过程

认证简介

目录

1.1 认证过程

1.2 Web应用的认证过程

1.2.1 ExceptionTranslationFilter

1.2.2 在request之间共享SecurityContext

1

- Java 位运算

Javahuhui

java位运算

// 左移( << ) 低位补0

// 0000 0000 0000 0000 0000 0000 0000 0110 然后左移2位后,低位补0:

// 0000 0000 0000 0000 0000 0000 0001 1000

System.out.println(6 << 2);// 运行结果是24

// 右移( >> ) 高位补"

- mysql免安装版配置

ldzyz007

mysql

1、my-small.ini是为了小型数据库而设计的。不应该把这个模型用于含有一些常用项目的数据库。

2、my-medium.ini是为中等规模的数据库而设计的。如果你正在企业中使用RHEL,可能会比这个操作系统的最小RAM需求(256MB)明显多得多的物理内存。由此可见,如果有那么多RAM内存可以使用,自然可以在同一台机器上运行其它服务。

3、my-large.ini是为专用于一个SQL数据

- MFC和ado数据库使用时遇到的问题

你不认识的休道人

sqlC++mfc

===================================================================

第一个

===================================================================

try{

CString sql;

sql.Format("select * from p

- 表单重复提交Double Submits

rensanning

double

可能发生的场景:

*多次点击提交按钮

*刷新页面

*点击浏览器回退按钮

*直接访问收藏夹中的地址

*重复发送HTTP请求(Ajax)

(1)点击按钮后disable该按钮一会儿,这样能避免急躁的用户频繁点击按钮。

这种方法确实有些粗暴,友好一点的可以把按钮的文字变一下做个提示,比如Bootstrap的做法:

http://getbootstrap.co

- Java String 十大常见问题

tomcat_oracle

java正则表达式

1.字符串比较,使用“==”还是equals()? "=="判断两个引用的是不是同一个内存地址(同一个物理对象)。 equals()判断两个字符串的值是否相等。 除非你想判断两个string引用是否同一个对象,否则应该总是使用equals()方法。 如果你了解字符串的驻留(String Interning)则会更好地理解这个问题。

- SpringMVC 登陆拦截器实现登陆控制

xp9802

springMVC

思路,先登陆后,将登陆信息存储在session中,然后通过拦截器,对系统中的页面和资源进行访问拦截,同时对于登陆本身相关的页面和资源不拦截。

实现方法:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23