【Python3】简易爬虫实现船舶的MMSI的获取

文章目录

- 目的

- 分析请求

- 编写代码

- 尾记

目的

工作中遇到一个需求,通过需要通过网站查询船舶名称得到MMSI码,网站来自船讯网。

分析请求

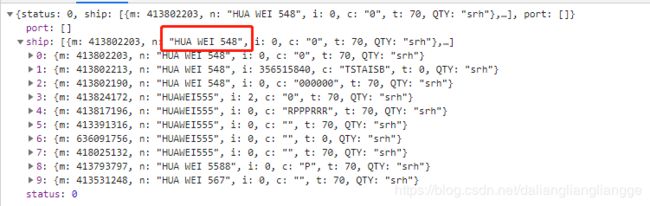

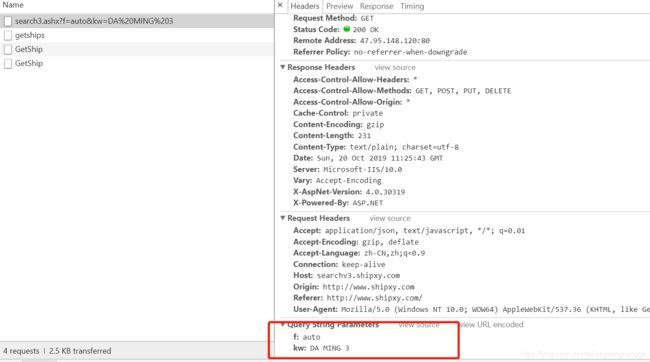

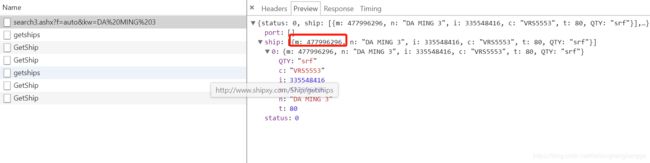

根据以往爬虫的经验,打开F12,通过输入船舶名称,观察发送的请求,发现返回数据的网址

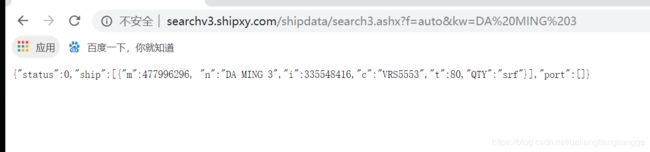

本身网址是一个get请求,直接用这个网址请求,也能返回数据,即网址本身并没有加密,这就简单许多,直接通过改变参数,就能实现数据的获取,马上开始动手

编写代码

代码中,通过request发送请求,为了不给服务器造成太大压力,每隔0.5秒发送一个请求,因为会出现查询不到的情况,通过exception判断,数据结果一是通过pandas中的to_excel存为excel文件,或者是直接通过pymysql入数据库,为了提高入库的速度,采用一次拼接三百条的方式入库

import requests

import os

import time

import pymysql

import pandas as pd

import re

import random

'''

author:shikailiang

function:通过读取船舶数据,分别请求拿到json数据入库

'''

#定义入库的类

class company_ship_in_database:

def __init__(self):

self.conn = pymysql.connect(host="", user="", password="", database="", charset="utf8")

self.cursor = self.conn.cursor()

self.last_path = os.path.abspath(os.path.dirname(os.getcwd()))

#写入mysql

def if_inbase(self, ship_name):

exits_sql = "select * from bms_company_ship where ship_name=\'" + ship_name + '\''

self.cursor.execute(exits_sql)

if self.cursor.fetchall():

return True

else:

return False

def in_database(self,data_list):

#data_list为所有数据的列表

j=1

sql = ""

# sql0 = "insert into bms_company_ship(oc_name,ship_name,mmsi) values"

# rowcount=len(data_list)

for i in data_list:

if self.if_inbase(i[1][1]):

update_sql="UPDATE bms_company_ship SET mmsi = '"+ str(i[0]) +"' WHERE ship_name = '" + i[1][1] + "'"

# print(j)

self.cursor.execute(update_sql)

self.conn.commit()

print("已经更新第" + str(j) + "条")

else:

# sql2 = (("(" + "'{}'," * 3)[:-1] + ")").format(i[1][0],i[1][1],i[0])

# sql = sql + "," + sql2

# print(sql0 + sql[1:])

# if j <= rowcount:

#如果执行错误回滚当前事务

# print(sql0 + sql[1:])

insert_sql='insert into bms_company_ship(oc_name,ship_name,mmsi) values("{}","{}","{}")'.format(i[1][0],i[1][1],i[0])

self.cursor.execute(insert_sql)

print("已经插入第" + str(j) + "条")

self.conn.commit()

j=j+1

# def is_have_mmsi(self,ship_list):

# sql='select * from cjh_product.bms_ocship where ship_name=' + ship_list[1]

# self.cursor.execute(sql)

#通过pandas写入excel

def in_xls(self, data_list):

#data_list为所有数据的列表

df=pd.DataFrame(data_list)

df.to_excel(self.last_path + r"\data\result.xls",header=False,index=False)

#请求船的方法

def company_ship_in_database(self):

data_path = self.last_path + r"\data"

file=open(data_path + "\company.txt")

data=[]

j = 0

for i in file.readlines():

chuan=i.strip().split()

dic={

'f':'auto',

'kw':chuan[1]

}

rq=requests.get("http://searchv3.shipxy.com/shipdata/search3.ashx",params=dic)

if rq.status_code==200:

try:

result_json=rq.json()

result=result_json['ship'][0]

if re.search('\d+',result['n']).group()==re.search('\d+',chuan[1]).group():

# print(re.search('\d+',result['n']).group())

# print(re.search('\d+',chuan[1]).group())

result=result['m']

data.append([result,chuan])

else:

data.append(["", chuan])

except:

data.append(["",chuan])

else:

print(chuan + "请求错误")

# time.sleep(random.random())

j = j + 1

if divmod(j,100)[1] == 0:

print("已经请求" + str(j) + "条")

# if j > 20:

# # self.in_xls(data)

# self.in_database(data)

# break

# self.in_xls(data)

self.in_database(data)

if __name__=="__main__":

company_ship=company_ship_in_database()

company_ship.company_ship_in_database()

尾记

写程序的过程中其实有发现一个问题,即我们请求的其实是输入文字时候自动发送的请求,其实有一个问题,如果我们需要查询的是"华为5"的船,但是如果系统中没有这个船,就是返回"华为548"的船,所以在代码中需要做一个判断

即用正则提取出船的数字,然后和返回的船的数字进行比对,如果一致,即为同一条船舶,即在代码中做了如下处理

if re.search('\d+',result['n']).group()==re.search('\d+',chuan[1]).group():