ELK日志分析平台(二) --- Logstash数据采集实战

一、logstash简介

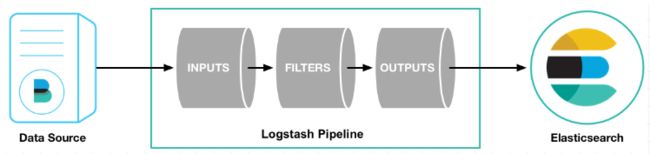

Logstash是一个开源的服务器端数据处理管道。

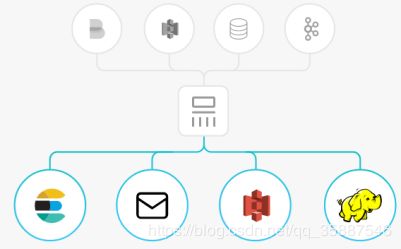

logstash拥有200多个插件,能够同时从多个来源采集数据,转换数据,然后将数据发送到您最喜欢的 “存储库” 中。(大多都是 Elasticsearch。)

Logstash管道有两个必需的元素,输入和输出,以及一个可选元素过滤器。

输入

输入:采集各种样式、大小和来源的数据

- Logstash 支持各种输入选择 ,同时从众多常用来源捕捉事件。

- 能够以连续的流式传输方式,轻松地从您的日志、指标、Web 应用、数据存储以及各种 AWS 服务采集数据。

过滤器

过滤器:实时解析和转换数据

数据从源传输到存储库的过程中,Logstash 过滤器能够解析各个事件,识别已命名的字段以构建结构,并将它们转换成通用格式,以便更轻松、更快速地分析和实现商业价值。

- 利用 Grok 从非结构化数据中派生出结构

- 从 IP 地址破译出地理坐标

- 将 PII 数据匿名化,完全排除敏感字段

- 简化整体处理,不受数据源、格式或架构的影响

输出

输出:选择您的存储库,导出您的数据

- 尽管 Elasticsearch 是我们的首选输出方向,能够为我们的搜索和分析带来无限可能,但它并非唯一选择。

- Logstash 提供众多输出选择,您可以将数据发送到您要指定的地方,并且能够灵活地解锁众多下游用例。

二、Logstash安装与配置

软件下载:https://elasticsearch.cn/download/

注意:下载的版本要和es的版本一致

安装:

我们之前的es集群部署在server1、server2和server3上,Logstash部署在server4(172.25.1.4)上:

Logstash依赖于jdk,因此首先安装jdk:

[root@server4 ~]# ls

jdk-8u181-linux-x64.rpm logstash-7.6.1.rpm

[root@server4 ~]# rpm -ivh jdk-8u181-linux-x64.rpm

[root@server4 ~]# rpm -ivh logstash-7.6.1.rpm

安装后其配置文件的位置为:/etc/logstash/logstash.yml

测试是否安装好:

标准输入到标准输出:

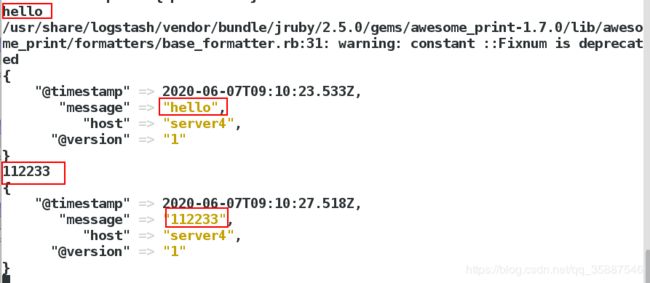

[root@server4 bin]# /usr/share/logstash/bin/logstash -e 'input { stdin { } } output { stdout {} }'

......

[INFO ] 2020-06-07 17:06:25.315 [Api Webserver] agent - Successfully started Logstash API endpoint {:port=>9600}

等待成功启动后,输入测试字符:

从返回可以看出Logstash正常工作。

从返回可以看出Logstash正常工作。

输入完成后按ctrl+c退出。

三、Logstash的使用

使用文件运行

当然也可以在include目录/etc/logstash/conf.d/中定义conf文件,然后在conf中输入:

[root@server4 conf.d]# vim test.conf

[root@server4 conf.d]# cat test.conf

input {

stdin {}

}

output {

stdout {}

}

用文件的形式运行:

[root@server4 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/test.conf

标准输出到文件

[root@server4 conf.d]# vim test.conf

[root@server4 conf.d]# cat test.conf

input {

stdin {}

}

output {

file {

path => "/tmp/testfile"

codec => line { format => "custom format: %{message}"}

}

}

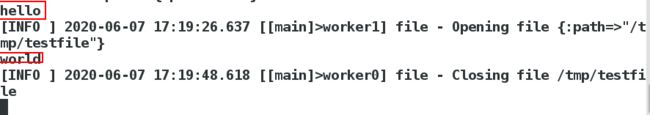

运行:

[root@server4 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/test.conf

以上内容表示在终端输入的内容会保存到/tmp/testfile文件中,codec定义了保存的格式,运行后输入: 在另一个终端中查看文件内容:

在另一个终端中查看文件内容:

[root@server4 ~]# cat /tmp/testfile

custom format: hello

custom format: world

可以看到内容成功保存。

注意:如果长时间不录入内容时文件会关闭,再次录入会再次打开。

标准输入到es主机

在include目录中可以定义多个conf文件。

[root@server4 conf.d]# vim es.conf

[root@server4 conf.d]# cat es.conf

input {

stdin {}

}

output {

elasticsearch {

index => "logstach-%{+YYYY.MM.dd}" #es保存的格式

hosts => ["172.25.1.1:9200"] #es主机地址

}

}

运行:

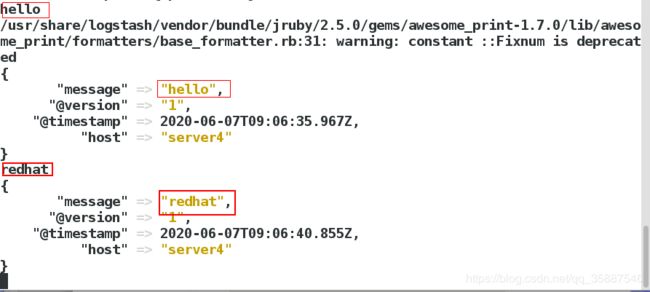

[root@server4 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/es.conf

运行后输入以下内容:

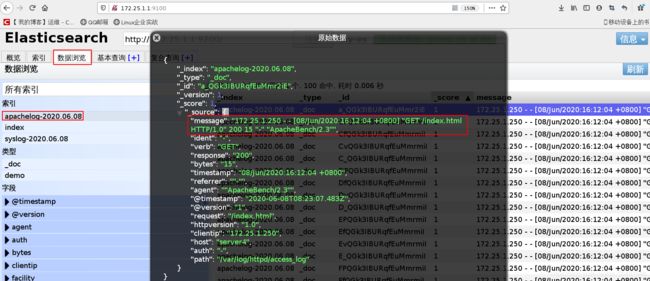

输入后查看es:

输入后查看es:

可以看到已经保存到了es,也可以查看数据,点击数据概览->logstach-2020.0607:

可以看到已经保存到了es,也可以查看数据,点击数据概览->logstach-2020.0607:

在message字段中可以看到输入的内容,需要注意的是每行信息都会生成一个文件。

也可以在输出中调用两个模块,如:

[root@server4 conf.d]# vim es.conf

[root@server4 conf.d]# cat es.conf

input {

stdin {}

}

output {

stdout {}

elasticsearch {

index => "logstach-%{+YYYY.MM.dd}"

hosts => ["172.25.1.1:9200"]

}

}

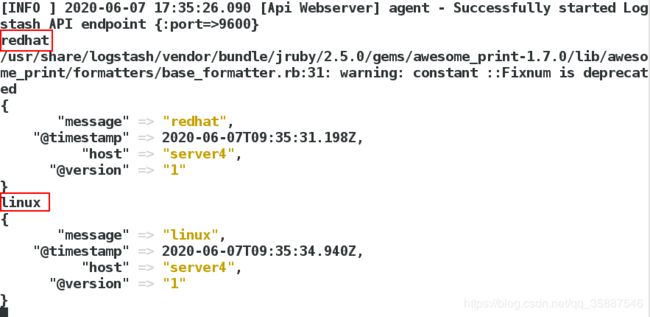

[root@server4 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/es.conf

把文件内容输出到es主机

在logstach运行时会调用logstach用户,因此我们需要保证logstach用户对调用的文件有读取权限:

[root@server4 conf.d]# ll /var/log/messages

-rw------- 1 root root 62122 Jun 7 17:19 /var/log/messages

[root@server4 conf.d]# chmod 644 /var/log/messages

[root@server4 conf.d]# ll /var/log/messages

-rw-r--r-- 1 root root 62122 Jun 7 17:19 /var/log/messages

编辑conf文件内容:

[root@server4 conf.d]# vim es.conf

[root@server4 conf.d]# cat es.conf

input {

file {

path => "/var/log/messages"

start_position => "beginning"

}

}

output {

stdout {}

elasticsearch {

index => "logstach-%{+YYYY.MM.dd}"

hosts => ["172.25.1.1:9200"]

}

}

[root@server4 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/es.conf

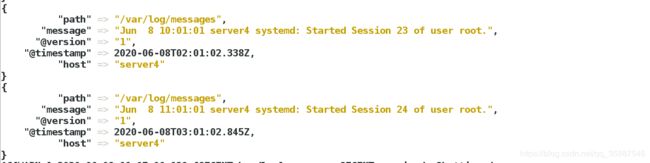

上述内容表示从文件/var/log/messages的开头读取信息后存入es主机中:

sincedb文件

当我们再次运行一次时:

[root@server4 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/es.conf

可以看到在终端没有输出(此处先不要退出Logstash),表示Logstash并没有再读取文件/var/log/messages,这是什么原因呢,原因就是logstash会把进度保存到sincedb文件中,再次运行时发现已经读取过,为了避免重复读取因此就不会读取了。.sincedb文件保存在/usr/share/logstash/data/plugins/inputs/file/目录中:

在另一终端:

[root@server4 conf.d]# cd /usr/share/logstash/data/plugins/inputs/file/

[root@server4 file]# ls

[root@server4 file]# ll .sincedb_452905a167cf4509fd08acb964fdb20c

-rw-r--r-- 1 root root 118 Jun 8 11:07 .sincedb_452905a167cf4509fd08acb964fdb20c

[root@server4 file]# cat .sincedb_452905a167cf4509fd08acb964fdb20c

12767815 0 64768 62122 1591522869.9633632 /var/log/messages

sincedb文件一共6个字段

- inode编号

- 文件系统的主要设备号

- 文件系统的次要设备号

- 文件中的当前字节偏移量

- 最后一个活动时间戳(浮点数)

- 与此记录匹配的最后一个已知路径

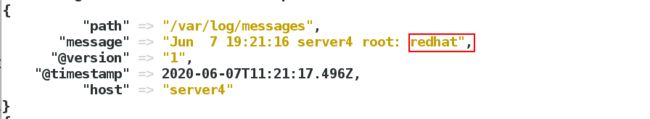

此时在日志文件中增加内容:

[root@server4 ~]# logger redhat

[root@server4 ~]# tail -1 /var/log/messages

Jun 7 19:21:16 server4 root: redhat

当把sincedb文件删除后,读取时就是重新读取。

Logstash采集远程日志

logstash可以伪装成日志服务器,直接接受远程日志。

[root@server4 conf.d]# vim es.conf

[root@server4 conf.d]# cat es.conf

input {

syslog {

port => 514

}

}

output {

stdout {}

elasticsearch {

index => "syslog-%{+YYYY.MM.dd}"

hosts => ["172.25.1.1:9200"]

}

}

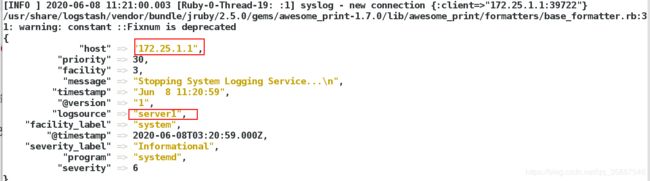

以上内容表示调用syslog模块打开514端口采集远程主机日志后保存到es主机,运行:

[root@server4 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/es.conf

运行后在另一终端查看端口情况:

[root@server4 ~]# netstat -antulp | grep :514

tcp6 0 0 :::514 :::* LISTEN 12746/java

udp 0 0 0.0.0.0:514 0.0.0.0:* 12746/java

可以看到514端口已经打开。

在远程主机配置rsyslog:

[root@server1 ~]# vim /etc/rsyslog.conf

[root@server1 ~]# tail -1 /etc/rsyslog.conf

*.* @@172.25.1.4:514

[root@server1 ~]# systemctl restart rsyslog.service

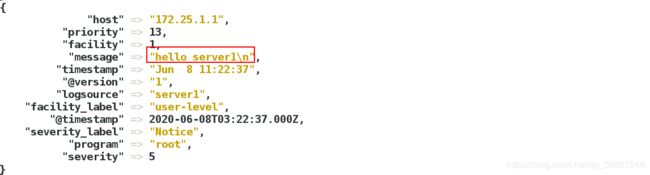

此时查看logstash主机输出:

在其他主机(server1,server2)上也进行与server1相同的配置。

在server1进行测试:

[root@server1 ~]# logger hello server1

在logstach主机终端查看:

可以看到测试日志信息已经保存到es中。

可以看到测试日志信息已经保存到es中。

多行过滤插件

多行过滤可以把多行日志记录合并为一行事件:

[root@server4 conf.d]# vim test.conf

[root@server4 conf.d]# cat test.conf

input {

stdin { #标准输入模块

codec => multiline { #多行输入模块

pattern => "^EOF" #匹配模式为以EOF开头

negate => true #表示匹配到

what => previous #匹配到后向上合并

}

}

}

output {

stdout {}

}

[root@server4 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/test.conf

用以上这种方法可以处理一些多行的日志信息,比如es.log文件中的信息:

图中这个日志信息在原来的方法匹配过后每一行都会成为一条信息,而通过多行匹配可以将其整合为一条信息,通过观察可以看出每条日志信息的开头都是[,因此可以通过匹配这个符号来进行多行匹配:

[root@server4 conf.d]# vim es.conf

[root@server4 conf.d]# cat es.conf

input {

file {

path => "/var/log/my-es.log" #制定文件路径,注意读取权限

start_position => "beginning"

codec => multiline {

pattern => "^\[" #由于[为特殊字符,因此需要转义

negate => true

what => previous

}

}

}

output {

elasticsearch {

index => "eslog-%{+YYYY.MM.dd}"

hosts => ["172.25.1.1:9200"]

}

}

[root@server4 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/es.conf

以上这种方式就可以实现日志逐条采集而不是逐行采集,在es查看:

可以看到多行日志以及合并为一条。

四、grok过滤插件

grok过滤插件可以将非结构的数据结构化:

[root@server4 conf.d]# vim test.conf

[root@server4 conf.d]# cat test.conf

input {

stdin {}

}

filter {

grok {

match => { "message" => "%{IP:client} %{WORD:method} %{URIPATHPARAM:request} %{NUMBER:bytes} %{NUMBER:duration}" }

}

}

output {

stdout {}

}

[root@server4 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/test.conf

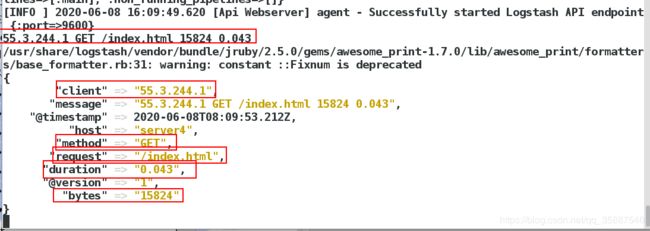

运行后输入以下测试信息:

55.3.244.1 GET /index.html 15824 0.043

可以看到录入的时非结构化的数据,但是通过过滤后变成了结构化的数据。

apache服务日志过滤实战

再进行一个实验,安装httpd并启动,写入测试页面:

[root@server4 conf.d]# yum install httpd -y

[root@server4 conf.d]# systemctl start httpd

[root@server4 conf.d]# cd /var/www/html/

[root@server4 html]# vim index.html

[root@server4 html]# cat index.html

www.redhat.com

在其他主机请求这个页面:

[root@foundation1 bin]# ab -c 1 -n 100 http://172.25.1.4/index.html

表示请求一百次index页面。

在server4更改日志访问权限,使得Logstash用户能够访问到:

[root@server4 html]# cd /var/log/httpd/

[root@server4 httpd]# ls

access_log error_log

[root@server4 httpd]# ll -d .

drwx------ 2 root root 41 Jun 8 16:10 .

[root@server4 httpd]# chmod 755 .

[root@server4 httpd]# ll -d .

drwxr-xr-x 2 root root 41 Jun 8 16:10 .

[root@server4 httpd]# ll access_log #访问日志文件

-rw-r--r-- 1 root root 10200 Jun 8 16:12 access_log

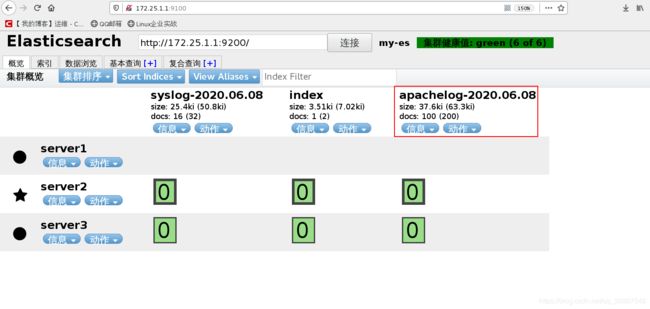

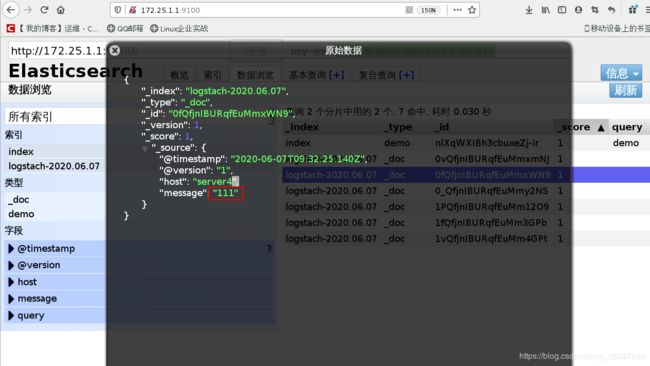

读取并过滤该日志:

[root@server4 conf.d]# vim es.conf

[root@server4 conf.d]# cat es.conf

input {

file {

path => "/var/log/httpd/access_log"

start_position => "beginning"

}

}

filter {

grok {

match => { "message" => "%{HTTPD_COMBINEDLOG}" } #logstach内置了apache的日志格式,直接调用即可

}

}

output {

elasticsearch {

index => "apachelog-%{+YYYY.MM.dd}"

hosts => ["172.25.1.1:9200"]

}

}

[root@server4 conf.d]# /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/es.conf