利用数据交换平台打通数据治理脉络

11月1日,Informatica举办了网络会议《Informatica数据交换平台主要特性及案例分享》,本文根据Informatica 资深技术顾问续岩演讲内容整理而来。

续岩

Informatica资深技术顾问

观看完整视频回放请长按识别如下二维码:

随着大数据技术的不断普及应用,以及数据资产概念的深入人心,很多企业已经启动或准备着手开展数据治理项目。

数据治理的渊源可以往上追溯到公司治理和IT治理。公司治理是关系到企业生死存亡的关键点,它会为企业未来发展指明方向。为了更好地支撑公司治理的方向和策略,IT治理会提供相应的IT系统支撑和规划。具体到数据治理,其实是在IT治理和公司治理之下的。无论企业处于什么行业,在数据的要求方面都是共通的,例如数据质量、数据的可访问性、数据的可用性、数据的一致性、数据安全性、数据可审计性等,这都是我们在数据治理过程中对数据提出来的要求。

为了更好地实现数据治理,我们通常需要三驾马车来支持:策略与流程、标准、技术平台。策略与流程从纲领角度为数据治理的开展铺平道路,自上而下形成相应的组织架构、管理目标、管理策略和流程。在数据治理的推广过程中,还需要辅助以标准规范,这样才能够保障数据治理项目的顺利开展。这包括数据的定义和分类、企业数据模型、开发和技术标准、主数据等。此外,要更好地实现数据治理项目的落地,还需要一个底层的可靠的全面的技术平台支持,为数据治理提供基础架构,这样才能避免数据治理项目变成空谈。

**数据集成是数据治理中的重中之重**

谈到具体的数据治理架构,我们用下面这张图做个简单的阐释:

首先,我们需要搭建一个数据治理组织,里面会有相应的治理委员会为数据治理的规划、标准、流程、定岗定责等提供非常好的支撑。在数据治理委员会的指导下,我们才可以更好地去开展数据治理的相关工作。比如说数据资产目录、元数据管理等,之外还有数据集成管理、数据质量管理、数据安全、数据服务以及企业数据中心等。

在这众多的建设项目中,Informatica认为最基础的莫过于元数据管理和数据集成管理。大家可能都认可元数据管理或者叫数据资产目录是数据治理中很重要的环节,但关于数据集成管理在数据治理中的作用,有些人可能会持怀疑态度。为什么我们说数据集成是数据治理中非常关键的环节呢?我认为有两个原因:

第一,我们在进行数据资产目录管理或者叫元数据管理的时候,不仅要从各个系统里搜寻、查询数据资产的分布情况,同时还要追溯整个数据流转的脉络。而数据流转的脉络则与数据集成密不可分。如果企业内部存在多种多样的数据集成方式,例如Java代码、存储过程、DB Link等,那么我们在进行数据追踪、审计的时候,就会发现无从下手。随着我们需要进行管理和维护的方式与渠道越来越多,这势必会给数据治理项目增加更多的成本和维护难度。

第二,在数据治理项目中,对元数据管理,或者说对数据资产目录的管理,仅仅是一个起始点,仅仅是对数据状况摸底的一个过程。更重要的是我们要以此为基础,去进行真正的数据价值的挖掘以及治理。比如说质量监控、主数据管理、数据服务等,但这些与数据集成密不可分。因此,我们肯定需要一个全面的数据集成平台,以支持数据治理项目的运转。

基于上述两点,我们可以看出,数据集成平台对于数据治理是非常重要的基础环节。只有打好数据集成平台这个基础,我们才能做到厚积薄发,才能在后续治理过程中实现更好的价值,降低管理和维护成本。

**Informatica DIH实现数据运算与数据承载的完美结合**

谈到数据集成,大家都不会陌生。早在建设数据仓库或数据中心的时候,大家就会采用ETL工具来搭建数据集成平台。数据集成平台承载的是数据的运算、抓取和转换能力,它可以帮助我们在不同系统之间实现数据交互,消除数据孤岛,但ETL工具本身并不会承载数据。数据从源端到目标端进行了流转,但在ETL工具这个层面不会有任何的存留。那么自然而然带来了问题:当一个系统有很多访问需求的时候,例如核心系统承载了整个企业内部的百分之八九十的关键数据,因此对数据的访问就会非常频繁。但核心系统的真正目的实际上是为了承载核心业务的发展,并不是为了数据共享而建。所以当我们有越来越多的数据访问,尤其是要去访问数据核心系统的时候,势必会给系统带来很大的压力,最终影响企业的正常运营。为此我们提出了数据中心、ODS等概念,进行数据系统的分压与承载,以承担起整个企业内部的数据交换和分发功能。

基于上述两点,Informatica提出能够合二为一,既具备高效的ETL运算能力,又能够提供数据承载能力的产品,这就是我们的DIH——Informatica Data Integration Hub数据交换平台。Informatica DIH在整个系统的架构中,就像一个数据总线,是一个数据的集成hub,它把所有系统之间的数据交互集中在一个平台之上,底层采用了PowerCenter高效的数据运转流程,可以快速地从各个系统中进行数据的访问控制,并能够把数据高效地推送到消费系统之上。Informatica DIH既有数据承载能力,又有数据运算能力,极大地满足了企业对于数据系统之间解耦,同时降低系统依赖性的需求。

Informatica DIH还有一个很大的改变,就是我们改变了传统的ETL方式,变成以管理为核心的模式。采用基于数据主题的自助发布和订阅方式,来快速适应企业系统内部的数据交互需求。也就是说当数据需求出现的时候,我们可以登录DIH平台查找已有的数据主题进行订阅。那么这些数据就会按照我们的方式自动形成相应的数据流转工作流,将数据按照我们所需要的频度,从数据来源系统抽取到消费系统,这样就大大地缩短了数据开发的周期。在此之上,Informatica DIH还提供了相应的数据生命周期管理、数据集中统计等功能。

**Informatica DIH产品主要功能**

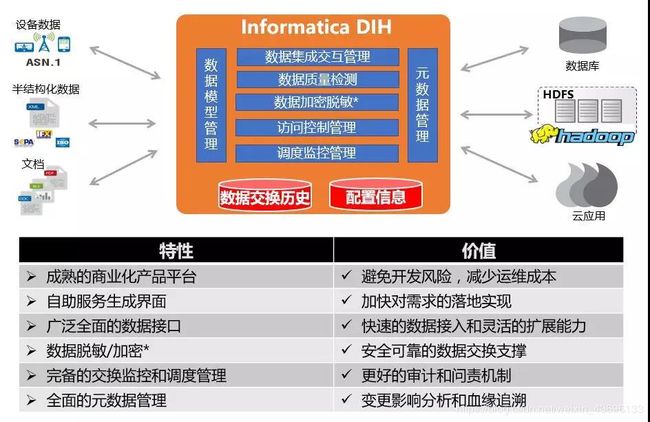

下面,我们来具体看一下Informatica DIH详细的功能模块。

在底层存储上,Informatica DIH除了保留最传统、最关键的元数据信息外,还多了一个存储区域,那就是历史数据交换区。基于这个历史数据交换区,DIH可以更好地为企业数据交换提供承载能力。所有的数据访问和数据发布都可以在DIH产品平台之上来进行运转。

我们再来看Informatica DIH数据模型管理模块。Informatica系统内部的这些交互是以数据为主题,作为基本单元的。一个数据主题是一个逻辑数据对象,它与物理表之间的关系可以是一对多的关系。举例来讲,客户信息可以是一个数据主题,那么客户信息实际上承载的物理表可能有客户主表信息、客户资料信息、客户地址表信息、客户电话信息等。通过对数据主题这个模型的定义,我们可以更完整的把数据和客户信息定义成一个基本的交换单元,通过对这个交换单元的发布和订阅,能够更全面地实现数据的交互。

在数据交互方面,Informatica数据集成交互管理模块实际上就是我们刚才谈到的基于数据主题的发布订阅功能,可以实现数据从DIH平台上的自助式发布,以及从DIH平台向消费系统的发布,这样就实现了系统之间的解耦,避免了数据需求方系统对数据发布方的依赖,并且可以实现不同时间频度的数据传输。

在此之上,Informatica DIH还具备数据质量检测或者叫数据质量防火墙的功能。这个功能是Informatica数据质量、数据治理产品的亮点。数据质量检测可以利用DIH平台作为数据交换的唯一入口,来进行数据指标验证和清理规则的切入。通过这种方式,当所有数据进入到DIH平台的时候,就是标准的,并可以分享、可以信赖的数据。通过一次清洗多次使用的方式,极大地提升了Informatica数据质量的验证效率和清理效率,同时也为未来维护数据质量、统一模型、统一引擎提供了平台支撑。

在某些特殊应用场景下,我们可能会有些敏感信息需要进行发布,可能会有一些客户的隐私信息需要进行共享。在这个过程中,我们就可以根据需求,在数据集成的过程中去添加数据脱敏,以及数据加密模块来实现对隐私信息的保护。

同时,数据集成交互还需要考虑历史数据的堆积。因为随着时间的推移,在一个系统之内的数据会不断累加,尤其作为一个交换平台来讲,每天的数据承载量很大。如果没有优秀的数据生命周期管理功能,数据系统的运行健康状态就会受到影响。Informatica DIH产品提供了优秀的数据生命周期管理功能,它可以基于数据主题去订阅每一个数据主题的生命周期时间。当这份数据被所有的需求方取走之后,它会开始计时,到达相应的有效期,这部分发布的数据就会自动从DIH平台中清除掉或者被转走,从而保证数据交换平台的健康稳定运行。

此外,在安全控制方面,Informatica DIH也提供了全面的访问控制功能,以实现对不同用户和数据主题之间的访问权限管理,管控可以访问和发布的数据主题。由于DIH平台采用了集中的数据存储功能,所以我们对于数据审计和监控有了一个唯一入口。在DIH平台之上,我们可以非常清晰地看到每个系统对数据的使用情况,以及数据发布和需求量,从而可以得到更准确更全面的数据热度分析,为以后的数据挖掘和使用提供更有力的数据支持。

正如前文所述,Informatica DIH产品基于PowerCenter强大的ETL引擎之上,因此它天然地继承了PowerCenter所有的强大功能,包括集群部署、高并发分区式处理,以及全面的接口管理,包括大数据平台、云平台、企业数据库、文档文件等常见的数据类型支持。

通过将ETL运算能力与数据承载能力完美结合,Informatica DIH数据交换平台可以更加全面地为企业数据集成提供平台支撑,为数据治理打通脉络,帮助企业最终做到以数据为核心,实现流程驱动、责任明确的深入治理。