Pandas由浅入深(二)

Pandas高级部分

pandas之取行或者列

刚刚我们知道了如何给数据按照某一行或者列排序,那么现在我们想单独研究使用次数前100的数据,应该如何做?

##按照狗名字出现的次数对数据进行排序

df_sorted = df.sort_values(by="Count_AnimalName")

##取前100条

df_sorted[:100]

那么问题来了:

我们具体要选择某一列该怎么选择呢?df[" Count_AnimalName "]

我们要同时选择行和列改怎么办?df[:100][" Count_AnimalName "]

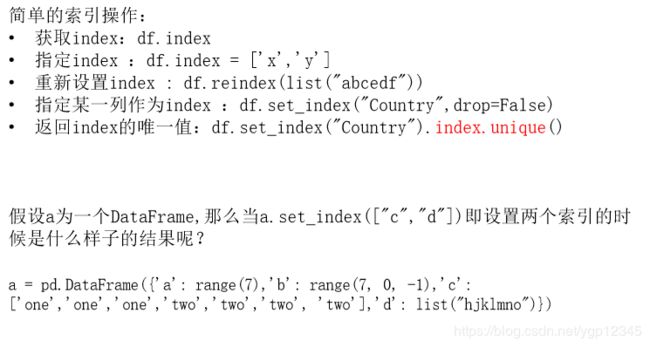

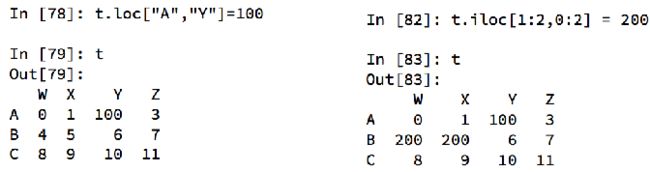

Pandas指loc与iloc

还有更多的经过pandas优化过的选择方式:

df.loc 通过标签索引行数据

df.iloc 通过位置获取行数据

赋值更改数据的过程:

pandas之布尔索引

回到之前狗的名字的问题上,假如我们想找到所有的使用次数超过800的狗的名字,应该怎么选择?

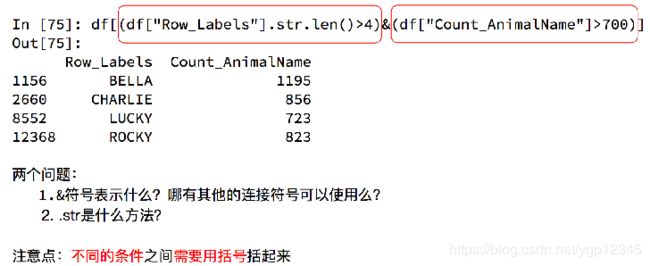

回到之前狗的名字的问题上,假如我们想找到所有的使用次数超过700并且名字的字符串的长度大于4的狗的名字,应该怎么选择?

pandas之字符串方法

缺失数据的处理

观察下面这组数据:

我们的数据缺失通常有两种情况:

一种就是空,None等,在pandas是NaN(和np.nan一样)

另一种是我们让其为0,蓝色框中。

对于NaN的数据,在numpy中我们是如何处理的?

在pandas中我们处理起来非常容易

判断数据是否为NaN:pd.isnull(df),pd.notnull(df)

处理方式1:删除NaN所在的行列dropna (axis=0, how='any', inplace=False)第一个参数是指删行还是列,第二个参数是指定删除方式,any是只要由NAN就删,all是全部为NAN才删,inplace是指是否开辟新的空间去存结果!

处理方式2:填充数据,t.fillna(t.mean()),t.fiallna(t.median()),t.fillna(0)

处理为0的数据:t[t==0]=np.nan

当然并不是每次为0的数据都需要处理

计算平均值等情况,nan是不参与计算的,但是0会。

pandas常用统计方法

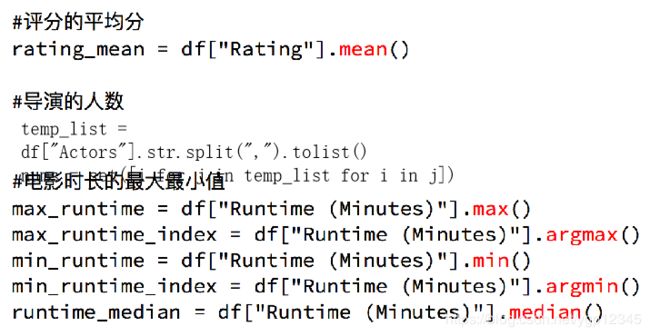

假设现在我们有一组从2006年到2016年1000部最流行的电影数据,我们想知道这些电影数据中评分的平均分,导演的人数等信息,我们应该怎么获取?

file_path = "IMDB-Movie-Data.csv"

df = pd.read_csv(file_path)

# print(df.info())

print(df.head(1))

#获取平均评分

print(df["Rating"].mean())

#导演的人数,unique是去重

# print(len(set(df["Director"].tolist())))

print(len(df["Director"].unique()))

#获取演员的人数,在文件中,Actors的这一列对应的是一个包含演员名字的数组!用df["Actors"]取出后就变成序列

temp_actors_list = df["Actors"].str.split(", ").tolist()

print(temp_actors_list)

##遍历二维列表,使其变成一维

actors_list = [i for j in temp_actors_list for i in j]

print(actors_list)

actors_num = len(set(actors_list))##去重

print(actors_num)

结果:

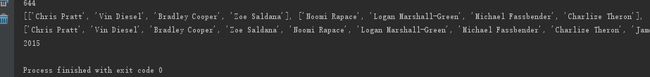

我们可以看到按","切分后,是一个二维列表,然后遍历打开成一维列表!!

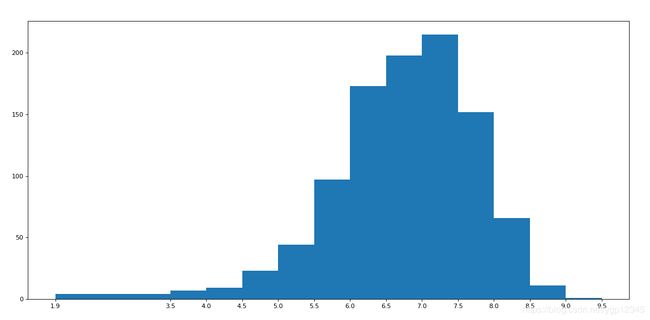

对于这一组电影数据,如果我们想rating的分布情况,应该如何呈现数据?

rating_data = np.array([8.1, 7.0, 7.3, 7.2, 6.2, 6.1, 8.3, 6.4, 7.1, 7.0, 7.5, 7.8, 7.9, 7.7, 6.4, 6.6, 8.2, 6.7, 8.1, 8.0, 6.7, 7.9, 6.7, 6.5, 5.3, 6.8, 8.3, 4.7, 6.2, 5.9, 6.3, 7.5, 7.1, 8.0, 5.6, 7.9, 8.6, 7.6, 6.9, 7.1, 6.3, 7.5, 2.7, 7.2, 6.3, 6.7, 7.3, 5.6, 7.1, 3.7, 8.1, 5.8, 5.6, 7.2, 9.0, 7.3, 7.2, 7.4, 7.0, 7.5, 6.7, 6.8, 6.5, 4.1, 8.5, 7.7, 7.4, 8.1, 7.5, 7.2, 5.9, 7.1, 7.5, 6.8, 8.1, 7.1, 8.1, 8.3, 7.3, 5.3, 8.8, 7.9, 8.2, 8.1, 7.2, 7.0, 6.4, 7.8, 7.8, 7.4, 8.1, 7.0, 8.1, 7.1, 7.4, 7.4, 8.6, 5.8, 6.3, 8.5, 7.0, 7.0, 8.0, 7.9, 7.3, 7.7, 5.4, 6.3, 5.8, 7.7, 6.3, 8.1, 6.1, 7.7, 8.1, 5.8, 6.2, 8.8, 7.2, 7.4, 6.7, 6.7, 6.0, 7.4, 8.5, 7.5, 5.7, 6.6, 6.4, 8.0, 7.3, 6.0, 6.4, 8.5, 7.1, 7.3, 8.1, 7.3, 8.1, 7.1, 8.0, 6.2, 7.8, 8.2, 8.4, 8.1, 7.4, 7.6, 7.6, 6.2, 6.4, 7.2, 5.8, 7.6, 8.1, 4.7, 7.0, 7.4, 7.5, 7.9, 6.0, 7.0, 8.0, 6.1, 8.0, 5.2, 6.5, 7.3, 7.3, 6.8, 7.9, 7.9, 5.2, 8.0, 7.5, 6.5, 7.6, 7.0, 7.4, 7.3, 6.7, 6.8, 7.0, 5.9, 8.0, 6.0, 6.3, 6.6, 7.8, 6.3, 7.2, 5.6, 8.1, 5.8, 8.2, 6.9, 6.3, 8.1, 8.1, 6.3, 7.9, 6.5, 7.3, 7.9, 5.7, 7.8, 7.5, 7.5, 6.8, 6.7, 6.1, 5.3, 7.1, 5.8, 7.0, 5.5, 7.8, 5.7, 6.1, 7.7, 6.7, 7.1, 6.9, 7.8, 7.0, 7.0, 7.1, 6.4, 7.0, 4.8, 8.2, 5.2, 7.8, 7.4, 6.1, 8.0, 6.8, 3.9, 8.1, 5.9, 7.6, 8.2, 5.8, 6.5, 5.9, 7.6, 7.9, 7.4, 7.1, 8.6, 4.9, 7.3, 7.9, 6.7, 7.5, 7.8, 5.8, 7.6, 6.4, 7.1, 7.8, 8.0, 6.2, 7.0, 6.0, 4.9, 6.0, 7.5, 6.7, 3.7, 7.8, 7.9, 7.2, 8.0, 6.8, 7.0, 7.1, 7.7, 7.0, 7.2, 7.3, 7.6, 7.1, 7.0, 6.0, 6.1, 5.8, 5.3, 5.8, 6.1, 7.5, 7.2, 5.7, 7.7, 7.1, 6.6, 5.7, 6.8, 7.1, 8.1, 7.2, 7.5, 7.0, 5.5, 6.4, 6.7, 6.2, 5.5, 6.0, 6.1, 7.7, 7.8, 6.8, 7.4, 7.5, 7.0, 5.2, 5.3, 6.2, 7.3, 6.5, 6.4, 7.3, 6.7, 7.7, 6.0, 6.0, 7.4, 7.0, 5.4, 6.9, 7.3, 8.0, 7.4, 8.1, 6.1, 7.8, 5.9, 7.8, 6.5, 6.6, 7.4, 6.4, 6.8, 6.2, 5.8, 7.7, 7.3, 5.1, 7.7, 7.3, 6.6, 7.1, 6.7, 6.3, 5.5, 7.4, 7.7, 6.6, 7.8, 6.9, 5.7, 7.8, 7.7, 6.3, 8.0, 5.5, 6.9, 7.0, 5.7, 6.0, 6.8, 6.3, 6.7, 6.9, 5.7, 6.9, 7.6, 7.1, 6.1, 7.6, 7.4, 6.6, 7.6, 7.8, 7.1, 5.6, 6.7, 6.7, 6.6, 6.3, 5.8, 7.2, 5.0, 5.4, 7.2, 6.8, 5.5, 6.0, 6.1, 6.4, 3.9, 7.1, 7.7, 6.7, 6.7, 7.4, 7.8, 6.6, 6.1, 7.8, 6.5, 7.3, 7.2, 5.6, 5.4, 6.9, 7.8, 7.7, 7.2, 6.8, 5.7, 5.8, 6.2, 5.9, 7.8, 6.5, 8.1, 5.2, 6.0, 8.4, 4.7, 7.0, 7.4, 6.4, 7.1, 7.1, 7.6, 6.6, 5.6, 6.3, 7.5, 7.7, 7.4, 6.0, 6.6, 7.1, 7.9, 7.8, 5.9, 7.0, 7.0, 6.8, 6.5, 6.1, 8.3, 6.7, 6.0, 6.4, 7.3, 7.6, 6.0, 6.6, 7.5, 6.3, 7.5, 6.4, 6.9, 8.0, 6.7, 7.8, 6.4, 5.8, 7.5, 7.7, 7.4, 8.5, 5.7, 8.3, 6.7, 7.2, 6.5, 6.3, 7.7, 6.3, 7.8, 6.7, 6.7, 6.6, 8.0, 6.5, 6.9, 7.0, 5.3, 6.3, 7.2, 6.8, 7.1, 7.4, 8.3, 6.3, 7.2, 6.5, 7.3, 7.9, 5.7, 6.5, 7.7, 4.3, 7.8, 7.8, 7.2, 5.0, 7.1, 5.7, 7.1, 6.0, 6.9, 7.9, 6.2, 7.2, 5.3, 4.7, 6.6, 7.0, 3.9, 6.6, 5.4, 6.4, 6.7, 6.9, 5.4, 7.0, 6.4, 7.2, 6.5, 7.0, 5.7, 7.3, 6.1, 7.2, 7.4, 6.3, 7.1, 5.7, 6.7, 6.8, 6.5, 6.8, 7.9, 5.8, 7.1, 4.3, 6.3, 7.1, 4.6, 7.1, 6.3, 6.9, 6.6, 6.5, 6.5, 6.8, 7.8, 6.1, 5.8, 6.3, 7.5, 6.1, 6.5, 6.0, 7.1, 7.1, 7.8, 6.8, 5.8, 6.8, 6.8, 7.6, 6.3, 4.9, 4.2, 5.1, 5.7, 7.6, 5.2, 7.2, 6.0, 7.3, 7.2, 7.8, 6.2, 7.1, 6.4, 6.1, 7.2, 6.6, 6.2, 7.9, 7.3, 6.7, 6.4, 6.4, 7.2, 5.1, 7.4, 7.2, 6.9, 8.1, 7.0, 6.2, 7.6, 6.7, 7.5, 6.6, 6.3, 4.0, 6.9, 6.3, 7.3, 7.3, 6.4, 6.6, 5.6, 6.0, 6.3, 6.7, 6.0, 6.1, 6.2, 6.7, 6.6, 7.0, 4.9, 8.4, 7.0, 7.5, 7.3, 5.6, 6.7, 8.0, 8.1, 4.8, 7.5, 5.5, 8.2, 6.6, 3.2, 5.3, 5.6, 7.4, 6.4, 6.8, 6.7, 6.4, 7.0, 7.9, 5.9, 7.7, 6.7, 7.0, 6.9, 7.7, 6.6, 7.1, 6.6, 5.7, 6.3, 6.5, 8.0, 6.1, 6.5, 7.6, 5.6, 5.9, 7.2, 6.7, 7.2, 6.5, 7.2, 6.7, 7.5, 6.5, 5.9, 7.7, 8.0, 7.6, 6.1, 8.3, 7.1, 5.4, 7.8, 6.5, 5.5, 7.9, 8.1, 6.1, 7.3, 7.2, 5.5, 6.5, 7.0, 7.1, 6.6, 6.5, 5.8, 7.1, 6.5, 7.4, 6.2, 6.0, 7.6, 7.3, 8.2, 5.8, 6.5, 6.6, 6.2, 5.8, 6.4, 6.7, 7.1, 6.0, 5.1, 6.2, 6.2, 6.6, 7.6, 6.8, 6.7, 6.3, 7.0, 6.9, 6.6, 7.7, 7.5, 5.6, 7.1, 5.7, 5.2, 5.4, 6.6, 8.2, 7.6, 6.2, 6.1, 4.6, 5.7, 6.1, 5.9, 7.2, 6.5, 7.9, 6.3, 5.0, 7.3, 5.2, 6.6, 5.2, 7.8, 7.5, 7.3, 7.3, 6.6, 5.7, 8.2, 6.7, 6.2, 6.3, 5.7, 6.6, 4.5, 8.1, 5.6, 7.3, 6.2, 5.1, 4.7, 4.8, 7.2, 6.9, 6.5, 7.3, 6.5, 6.9, 7.8, 6.8, 4.6, 6.7, 6.4, 6.0, 6.3, 6.6, 7.8, 6.6, 6.2, 7.3, 7.4, 6.5, 7.0, 4.3, 7.2, 6.2, 6.2, 6.8, 6.0, 6.6, 7.1, 6.8, 5.2, 6.7, 6.2, 7.0, 6.3, 7.8, 7.6, 5.4, 7.6, 5.4, 4.6, 6.9, 6.8, 5.8, 7.0, 5.8, 5.3, 4.6, 5.3, 7.6, 1.9, 7.2, 6.4, 7.4, 5.7, 6.4, 6.3, 7.5, 5.5, 4.2, 7.8, 6.3, 6.4, 7.1, 7.1, 6.8, 7.3, 6.7, 7.8, 6.3, 7.5, 6.8, 7.4, 6.8, 7.1, 7.6, 5.9, 6.6, 7.5, 6.4, 7.8, 7.2, 8.4, 6.2, 7.1, 6.3, 6.5, 6.9, 6.9, 6.6, 6.9, 7.7, 2.7, 5.4, 7.0, 6.6, 7.0, 6.9, 7.3, 5.8, 5.8, 6.9, 7.5, 6.3, 6.9, 6.1, 7.5, 6.8, 6.5, 5.5, 7.7, 3.5, 6.2, 7.1, 5.5, 7.1, 7.1, 7.1, 7.9, 6.5, 5.5, 6.5, 5.6, 6.8, 7.9, 6.2, 6.2, 6.7, 6.9, 6.5, 6.6, 6.4, 4.7, 7.2, 7.2, 6.7, 7.5, 6.6, 6.7, 7.5, 6.1, 6.4, 6.3, 6.4, 6.8, 6.1, 4.9, 7.3, 5.9, 6.1, 7.1, 5.9, 6.8, 5.4, 6.3, 6.2, 6.6, 4.4, 6.8, 7.3, 7.4, 6.1, 4.9, 5.8, 6.1, 6.4, 6.9, 7.2, 5.6, 4.9, 6.1, 7.8, 7.3, 4.3, 7.2, 6.4, 6.2, 5.2, 7.7, 6.2, 7.8, 7.0, 5.9, 6.7, 6.3, 6.9, 7.0, 6.7, 7.3, 3.5, 6.5, 4.8, 6.9, 5.9, 6.2, 7.4, 6.0, 6.2, 5.0, 7.0, 7.6, 7.0, 5.3, 7.4, 6.5, 6.8, 5.6, 5.9, 6.3, 7.1, 7.5, 6.6, 8.5, 6.3, 5.9, 6.7, 6.2, 5.5, 6.2, 5.6, 5.3])

max_rating = rating_data.max()

min_rating = rating_data.min()

print(min_rating,max_rating)

#设置不等宽的组距,hist方法中取到的会是一个左闭右开的去见[1.9,3.5)

num_bin_list = [1.9,3.5]

i=3.5

while i<=max_rating:

i += 0.5

num_bin_list.append(i)

print(num_bin_list)

#设置图形的大小

plt.figure(figsize=(20,8),dpi=80)

##经过以上的while循环,可以绘制出一幅前半段组距1.9-3.5(组距1.6)之间的,之后的数据组距都为0.5

plt.hist(rating_data,num_bin_list)

#xticks让之前的组距能够对应上

plt.xticks(num_bin_list)

plt.show()

结果:

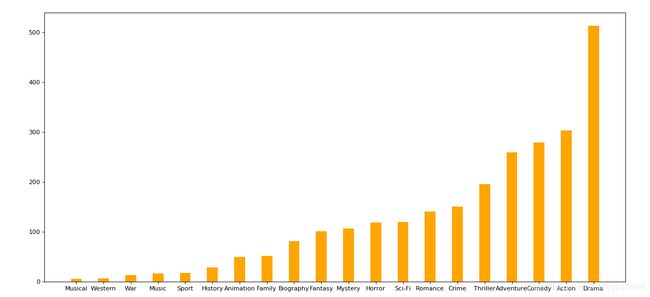

对于这一组电影数据,如果我们希望统计电影分类(genre)的情况,应该如何处理数据?

思路:重新构造一个全为0的数组,列名为分类,如果某一条数据中分类出现过,就让0变为1。

file_path = "./IMDB-Movie-Data.csv"

df = pd.read_csv(file_path)

print(df["Genre"].head(3))

#统计分类的列表

print(type(df["Genre"]))

temp_list = df["Genre"].str.split(",").tolist() #[[],[],[]]

##得出该数据中含有多少种不同分类,set给数据去重

genre_list = list(set([i for j in temp_list for i in j]))

#构造全为0的数组

zeros_df = pd.DataFrame(np.zeros((df.shape[0],len(genre_list))),columns=genre_list)

# print(zeros_df)

#给每个电影出现分类的位置赋值1

for i in range(df.shape[0]):

#zeros_df.loc[0,["Sci-fi","Mucical"]] = 1

zeros_df.loc[i,temp_list[i]] = 1

# print(zeros_df.head(3))

#统计每个分类的电影的数量和

genre_count = zeros_df.sum(axis=0)

print(genre_count)

#排序

genre_count = genre_count.sort_values()

_x = genre_count.index

_y = genre_count.values

#画图

plt.figure(figsize=(20,8),dpi=80)

plt.bar(range(len(_x)),_y,width=0.4,color="orange")

plt.xticks(range(len(_x)),_x)

plt.show()

结果:

上图第一个红框的结果是每一部电影所对应的分类的情况,我只显示了三行。第二个红框是我新建的一个dataframe,他的列索引就是各个分类,行索引对应的是每一部电影,我将每部电影里出现的分类对应的0置为1,第三个红框是统计每个分类所出现的次数,第四个红框是给结果排个序。

绘制成图像如下:

数据合并之join

数据合并之merge

分组和聚合

现在我们有一组关于全球星巴克店铺的统计数据,如果我想知道美国的星巴克数量和中国的哪个多,或者我想知道中国每个省份星巴克的数量的情况,那么应该怎么办?

file_path = "./starbucks_store_worldwide.csv"

df = pd.read_csv(file_path)

# print(df.head(1))

# print(df.info())

# grouped = df.groupby(by="Country")

# print(grouped)

#DataFrameGroupBy

#可以进行遍历

# for i,j in grouped:

# print(i)

# print("-"*100)

# print(j,type(j))

# print("*"*100)

# df[df["Country"]="US"]

#调用聚合方法

# country_count = grouped["Brand"].count()

# print(country_count["US"])

# print(country_count["CN"])

#统计中国每个省店铺的数量

# china_data = df[df["Country"] =="CN"]

#

# grouped = china_data.groupby(by="State/Province").count()["Brand"]

#

# print(grouped)

#数据按照多个条件进行分组,返回Series,给了两个分组条件,就有两个索引

# grouped = df["Brand"].groupby(by=[df["Country"],df["State/Province"]]).count()

# print(grouped)

# print(type(grouped))

#数据按照多个条件进行分组,返回DataFrame

##看清楚下面什么时候使用[[“”]]?

grouped1 = df[["Brand"]].groupby(by=[df["Country"],df["State/Province"]]).count()

# grouped2= df.groupby(by=[df["Country"],df["State/Province"]])[["Brand"]].count()

# grouped3 = df.groupby(by=[df["Country"],df["State/Province"]]).count()[["Brand"]]

print(grouped1,type(grouped1))

# print("*"*100)

# print(grouped2,type(grouped2))

# print("*"*100)

#

# print(grouped3,type(grouped3))

#索引的方法和属性

print(grouped1.index)

结果:

在pandas中类似的分组的操作我们有很简单的方式来完成

df.groupby(by=“columns_name”)

那么问题来了,调用groupby方法之后返回的是什么内容?

grouped = df.groupby(by=“columns_name”)

grouped是一个DataFrameGroupBy对象,是可迭代的

grouped中的每一个元素是一个元组

元组里面是(索引(分组的值),分组之后的DataFrame)。

要统计美国和中国的星巴克的数量,我们应该怎么做?

DataFrameGroupBy对象有很多经过优化的方法

注意以上两种写法!![]与[[]]

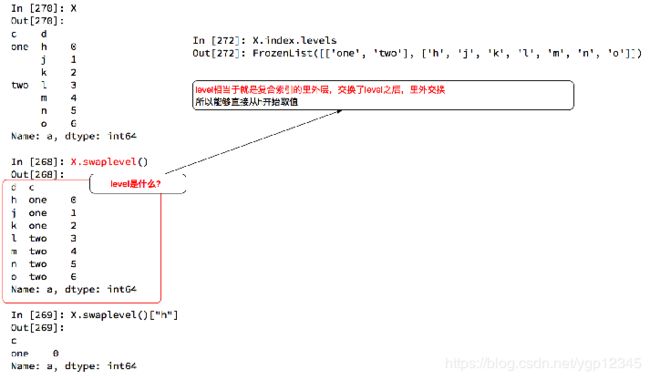

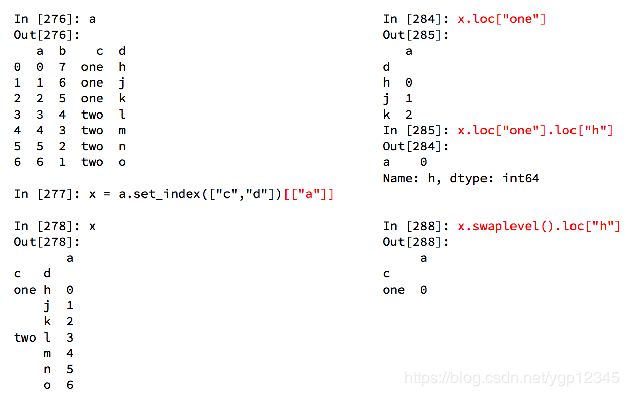

索引和复合索引

Series复合索引

我只想取索引h对应值怎么办?series直接方括号就能取,dataframe必须loc。

DataFrame复合索引

两个方括号就变成dataframe了,那么,回到星巴克数据的问题上来,如果我们想单独的获取分组之后北京的星巴克总数,应该怎么做?

1.使用matplotlib呈现出店铺总数排名前10的国家

file_path = "./starbucks_store_worldwide.csv"

df = pd.read_csv(file_path)

#使用matplotlib呈现出店铺总数排名前10的国家

#准备数据

data1 = df.groupby(by="Country").count()["Brand"].sort_values(ascending=False)[:10]

_x = data1.index

print(data1,type(data1))##是序列类型

_y = data1.values

#画图

plt.figure(figsize=(20,8),dpi=80)

plt.bar(range(len(_x)),_y)

plt.xticks(range(len(_x)),_x)

plt.show()

2.使用matplotlib呈现出每个中国每个城市的店铺数量

my_font = font_manager.FontProperties(fname="C:\\Windows\\Fonts\\FZSTK.TTF",size=15)

file_path = "./starbucks_store_worldwide.csv"

df = pd.read_csv(file_path)

df = df[df["Country"]=="CN"]

#使用matplotlib呈现出店铺总数排名前10的国家

#准备数据

data1 = df.groupby(by="City").count()["Brand"].sort_values(ascending=False)[:25]

_x = data1.index

_y = data1.values

#画图

plt.figure(figsize=(20,12),dpi=80)

# plt.bar(range(len(_x)),_y,width=0.3,color="orange")

plt.barh(range(len(_x)),_y,height=0.3,color="orange")

plt.yticks(range(len(_x)),_x,fontproperties=my_font)

plt.show()

现在我们有全球排名靠前的10000本书的数据,那么请统计一下下面几个问题:

1.不同年份书的数量

2.不同年份书的平均评分情况

file_path = "./books.csv"

df = pd.read_csv(file_path)

# print(df.head(2))

#

# print(df.info())

# data1 = df[pd.notnull(df["original_publication_year"])]

#

# grouped = data1.groupby(by="original_publication_year").count()["title"]

#不同年份书的平均评分情况

#去除original_publication_year列中nan的行

data1 = df[pd.notnull(df["original_publication_year"])]

##下面语句的含义是我取平均评分这一列,然后按照data1里的original_publication_year分组,不能直接写发行年份,因为平均分这一列本身不包含发行年

grouped = data1["average_rating"].groupby(by=data1["original_publication_year"]).mean()

# print(grouped),是序列类型

##这的索引就是年份

_x = grouped.index

##_y就是每一年对应的平均值

_y = grouped.values

#画图

plt.figure(figsize=(20,8),dpi=80)

plt.plot(range(len(_x)),_y)

print(len(_x))

plt.xticks(list(range(len(_x)))[::10],_x[::10].astype(int),rotation=45)

plt.show()

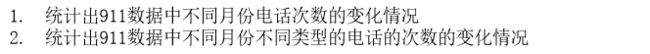

现在我们有2015到2017年25万条911的紧急电话的数据,请统计出出这些数据中不同类型的紧急情况的次数,如果我们还想统计出不同月份不同类型紧急电话的次数的变化情况,应该怎么做呢?

df = pd.read_csv("./911.csv")

print(df.head(5))

#获取分类

# print()df["title"].str.split(": ")serial类

##每一个索引对应一个列表,用tolist变成一个大列表,里面有很多小列表

temp_list = df["title"].str.split(": ").tolist()

#下面的i就是小列表,i[0]是小列表中第一个元素。

cate_list = list(set([i[0] for i in temp_list]))

print(cate_list)

#构造全为0的数组

zeros_df = pd.DataFrame(np.zeros((df.shape[0],len(cate_list))),columns=cate_list)

#赋值

for cate in cate_list:

zeros_df[cate][df["title"].str.contains(cate)] = 1

# break

# print(zeros_df)

sum_ret = zeros_df.sum(axis=0)

print(sum_ret)

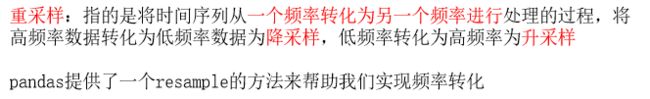

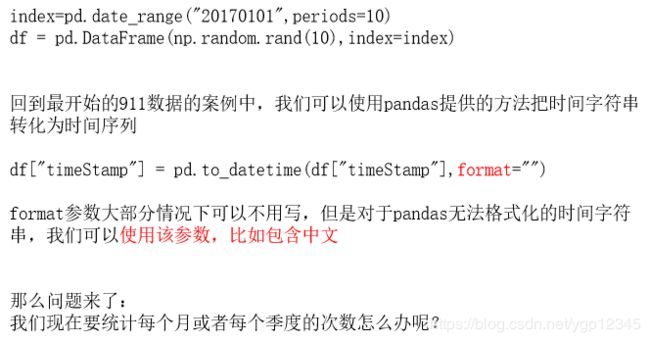

pandas中的时间序列

不管在什么行业,时间序列都是一种非常重要的数据形式,很多统计数据以及数据的规律也都和时间序列有着非常重要的联系,

而且在pandas中处理时间序列是非常简单的。

生成一段时间范围

关于频率的更多缩写

在DataFrame中使用时间序列

pandas重采样

df = pd.read_csv("./911.csv")

##转成真正的日期类型

df["timeStamp"] = pd.to_datetime(df["timeStamp"])

##设置索引

df.set_index("timeStamp",inplace=True)

#统计出911数据中不同月份电话次数的

count_by_month = df.resample("M").count()["title"]

print(count_by_month)

#画图

_x = count_by_month.index

_y = count_by_month.values

# for i in _x:

# print(dir(i))

# break

_x = [i.strftime("%Y%m%d") for i in _x]

plt.figure(figsize=(20,8),dpi=80)

plt.plot(range(len(_x)),_y)

plt.xticks(range(len(_x)),_x,rotation=45)

plt.show()

#911数据中不同月份不同类型的电话的次数的变化情况

import pandas as pd

import numpy as np

from matplotlib import pyplot as plt

#把时间字符串转为时间类型设置为索引

df = pd.read_csv("./911.csv")

df["timeStamp"] = pd.to_datetime(df["timeStamp"])

#添加列,表示分类

temp_list = df["title"].str.split(": ").tolist()

cate_list = [i[0] for i in temp_list]

# print(np.array(cate_list).reshape((df.shape[0],1)))

df["cate"] = pd.DataFrame(np.array(cate_list).reshape((df.shape[0],1)))

df.set_index("timeStamp",inplace=True)

print(df.head(1))

plt.figure(figsize=(20, 8), dpi=80)

#分组

for group_name,group_data in df.groupby(by="cate"):

#对不同的分类都进行绘图

count_by_month = group_data.resample("M").count()["title"]

# 画图

_x = count_by_month.index

print(_x)

_y = count_by_month.values

_x = [i.strftime("%Y%m%d") for i in _x]

plt.plot(range(len(_x)), _y, label=group_name)

plt.xticks(range(len(_x)), _x, rotation=45)

plt.legend(loc="best")

plt.show()

file_path = "./PM2.5/BeijingPM20100101_20151231.csv"

df = pd.read_csv(file_path)

#把分开的时间字符串通过periodIndex的方法转化为pandas的时间类型

period = pd.PeriodIndex(year=df["year"],month=df["month"],day=df["day"],hour=df["hour"],freq="H")

df["datetime"] = period

# print(df.head(10))

#把datetime 设置为索引

df.set_index("datetime",inplace=True)

#进行降采样

df = df.resample("7D").mean()

print(df.head())

#处理缺失数据,删除缺失数据

# print(df["PM_US Post"])

data =df["PM_US Post"]

data_china = df["PM_Nongzhanguan"]

print(data_china.head(100))

#画图

_x = data.index

_x = [i.strftime("%Y%m%d") for i in _x]

_x_china = [i.strftime("%Y%m%d") for i in data_china.index]

print(len(_x_china),len(_x_china))

_y = data.values

_y_china = data_china.values

plt.figure(figsize=(20,8),dpi=80)

##label是图例

plt.plot(range(len(_x)),_y,label="US_POST",alpha=0.7)

plt.plot(range(len(_x_china)),_y_china,label="CN_POST",alpha=0.7)

plt.xticks(range(0,len(_x_china),10),list(_x_china)[::10],rotation=45)

plt.legend(loc="best")

plt.show()