论文《Semi-Supervised Semantic Image Segmentation with Self-correcting Networks》阅读笔记

盘点关于CVPR2020关于图像分割的论文

-

Semi-Supervised Semantic Image Segmentation with Self-correcting Networks

论文地址:https://arxiv.org/abs/1811.07073

-

Deep Snake for Real-Time Instance Segmentation

论文地址:https://arxiv.org/abs/2001.01629

-

CenterMask : Real-Time Anchor-Free Instance Segmentation

论文地址:https://arxiv.org/abs/1911.06667

代码:https://github.com/youngwanLEE/CenterMask

-

SketchGCN: Semantic Sketch Segmentation with Graph Convolutional Networks

论文地址:https://arxiv.org/abs/2003.00678

-

PolarMask: Single Shot Instance Segmentation with Polar Representation

论文地址:https://arxiv.org/abs/1909.13226

代码:https://github.com/xieenze/PolarMask

-

xMUDA: Cross-Modal Unsupervised Domain Adaptation for 3D Semantic Segmentation

论文地址:https://arxiv.org/abs/1911.12676

-

BlendMask: Top-Down Meets Bottom-Up for Instance Segmentation

论文地址:https://arxiv.org/abs/2001.00309

- Enhancing Generic Segmentation with Learned Region Representations

论文地址:https://arxiv.org/abs/1911.08564

==========================================================================================

好了下面进入正题……

主要思想

带标签的boundingbox的在小数据集上的应用,分割模型具有概率性,以适应辅助分割模型的不确定性。自校正分割模型,基于当前对象的概率模板提升弱监督标签。

self-correction mechnism有两个思路:一是使用的函数将辅助预测(辅助预测不清楚的可以参考:https://www.researchgate.net/publication/319702011_Hybrid_Loss_Guided_Convolutional_Networks_for_Whole_Heart_Parsing)和模型预测线性地组合在一起,最小化加权的KL散度。但这种方式要求在模型训练的过程中达到权重自适应的效果。

使用boundingbox的方式可以被称作robust learning,因为在训练前减少了大部分无关的或者噪声标签。在这种情况下,一个通用的简化假设将输出标签上的噪声调制为与输入无关。

在半监督方面的创新点:(1)用辅助CNN提取概率标签的方法代替人工标注的方法(2)使用自校正模型来校正辅助CNN的输出和分割CNN的辅助输出的不一致性。

网络结构

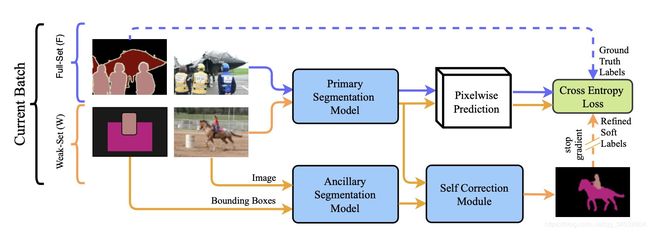

1.三个模型:(1)The Primary segmentation model 生成对象语义分割结果(2)The Ancillary segmentation model 输出带有boundingbox的分割结果,这是由一个weak set训练而来的(3)The Self-correction模块校正辅助分割模块和weak set上的主要模型。

接下来一一介绍这三个模型

2. The Ancillary segmentation model

在boudingbox中给出每个像素的标签就可实现全监督训练该模型,并且可以将其用作W中图像的训练信号。在inferrence阶段,图像及其边界框都被馈送到网络以获得panc(y | x( w),b(w)),分割标签分布。

在设计辅助模型时的主要观察结果是,基于编码器/解码器的分割网络通常依赖于从图像分类模型初始化的编码器。通常,这可以通过迁移大型图像分类数据集中的与训练模型来提高分割效果。 为了保持相同的优势,作者使用并行边界框编码器网络扩展了基于编码器-解码器的分割模型,该网络以不同比例嵌入边界框信息。经解码激活函数输出的boundingbox相当于一个注意力图,并且不同规模的特征图进行了融合。

3.No Self-Correction

训练主模型的最简单方法是,在全监督的集合F上使用ground truth标签,在弱集合W上使用辅助模型生成的标签,对其进行训练,以进行预测。对于这种“无自校正”模型, 图1中的自我校正模块仅复制由辅助分割模型做出的预测。

上述优化函数第一项交叉熵损失以one-hot 真实标签作为优化目标,第二项是以panc为目标的软概率标签的交叉熵。注意,由θ参数化的辅助模型是固定的。我们称此方法为无自校正模型,因为它直接依赖于辅助模型来训练W中的示例的主要模型。

4. Linear Self-Correction

无自校正模型是直接从辅助模型中输出的预测结果,用的弱数据集,准确性无法保证;而自校正模型是在两个模型上运行,用主模型的输出结果校正辅助模型的结果。使用KL散度的线性组合来推断缺失标签的分布,以解决一般分类问题。(本人理解的是,KL散度用于衡量两个概率之间的分布差异,一个是辅助模型,其中条件多了一个boundingbox,另一个就是主模型)

线性自校正模型的缺点是,超参数需要进行微调。

5.卷积自校正网络Convolutional Self-Correction

将主模型和辅助模型concat后进行卷积,因为qconv子网络是被随机初始化的。这里作者用到了一个trick:在阶段1中只使用一半F的数据,如果使用所有F来训练panc(y | x,b)模型,它将训练以在该集合上几乎完美地预测分割mask,因此,随后的卷积自校正网络只会学会依赖panc(y | x,b)。 为了克服此训练问题,F的后半部分被单独拿出来,以帮助自校正网络学习如何组合panc(y | x,b)和p(y | x)。