最小二乘法的导出

最小二乘法可以由最大似然估计进行导出

最大似然函数

相机的经典SLAM模型

第一个为运动方程, 第二个为观测方程。wk; vk;j 噪声项,假设服从零均值的高斯分布:

我们说,对机器人状态的估计,就是求已知输入数据 u 和观测数据 z 的条件下,计算状态 x 的条件概率分布:![]()

当我们没有测量运动的传感器,只有一张张的图像时,即只考虑观测方程带来的数据时,相当于估计 P(xjz) 的条件概率分布。根据贝叶斯法则可知:

贝叶斯法则左侧通常称为后验概率。它右侧的 P(z|x) 称为似然,另一部分 P(x) 称为先验。 直接求后验分布是困难的,但是求一个状态最优估计,使得在该状态下,后验概率最大化( Maximize a Posterior, MAP),则是可行的:![]()

求解最大后验概率, 相当于最大化似然和先验的乘积。进一步,我们当然也可以说,对不起,我不知道机器人位姿大概在什么地方,此时就没有了先验。那么,可以求解x 的最大似然估计( Maximize Likelihood Estimation, MLE) :![]()

最大似然估计,可以理解成:“ 在什么样的状态下,最可能产生现在观测到的数据”

最小二乘法的导出

对于观测方程:

假设了噪声项 vk ∼ N (0; Qk;j),所以观测数据的条件概率为:

考虑一个任意的高维高斯分布 x ∼ N(µ; Σ),它的概率密度函数展开形式为:

取它的负对数,则变为:

因此最小右侧的二次型,就得到了最大似然估计,带入SLAM的观测模型:

该式等价于最小化噪声项(即误差)的平方( Σ 范数意义下)。

非线性优化算法

- 最小二乘问题:

- 非线性优化的步骤:

注:非线性优化问题关键是求解增量 ∆xk

一阶和二阶梯度法

将最小二乘函数在x附近进行二阶泰勒展开:

注:J 是 ∥f(x)∥2 关于 x 的导数(雅可比矩阵),而 H 则是二阶导数(海塞( Hessian)矩阵)

如果保留一阶梯度,这为最速下降法:

如果保留二阶梯度,这为牛顿法:

求右侧等式关于 ∆x 的导数并令它为零,就得到了增量的解:

注:最速下降法过于贪心,容易走出锯齿路线,反而增加了迭代次数。而牛顿法则需要计算目标函数的 H 矩阵,这在问题规模较大时非常困难,我们通常倾向于避免 H 的计算。

Gauss-Newton

将 f(x) 进行一阶的泰勒展开(请注意不是目标函数 f(x)2)![]()

注:对比牛顿法可见, Gauss-Newton 用 J T J 作为牛顿法中二阶 Hessian 矩阵的近似,从而省略了计算 H 的过程。

原则上,它要求我们所用的近似 H 矩阵是可逆的(而且是正定的),但实际数据中计算得到的 J T J 却只有半正定性。

也就是说,在使用 Gauss Newton 方法时,可能出现 J T J 为奇异矩阵或者病态 (illcondition) 的情况,此时增量的稳定性较差,导致算法不收敛。

Levenberg-Marquadt

Levenberg-Marquadt 方法在一定程度上修正了这些问题,一般认为它比 Gauss Newton 更为鲁棒。尽管它的收敛速度可能会比 Gauss Newton 更慢,被称之为阻尼牛顿法(Damped Newton Method)

给 ∆x 添加一个信赖区域( Trust Region),不能让它太大而使得近似不准确。一个比较好的方法是根据我们的近似模型跟实际函数之间的差异来确定这个范围:如果差异小,我们就让范围尽可能大;如果差异大,我们就缩小这个近似范围。

注:ρ 的分子是实际函数下降的值,分母是近似模型下降的值。如果 ρ 接近于 1,则近似是好的。如果 ρ 太小,说明实际减小的值远少于近似减小的值,则认为近似比较差,需要缩小近似范围。反之,如果 ρ 比较大,则说明实际下降的比预计的更大,我们可以放大近似范围。

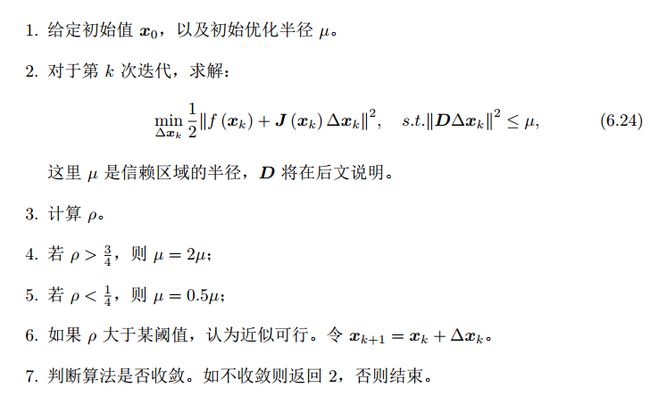

- 算法步骤

注:这里 λ 为 Lagrange 乘子。

多了一项 λDT D。如果考虑它的简化形式,即 D = I,那么相当于求解:![]()

当参数 λ 比较小时, H 占主要地位,这说明二次近似模型在该范围内是比较好的, L-M 方法更接近于 G-N 法。

另一方面,当 λ 比较大时, λI 占据主要地位, L-M更接近于一阶梯度下降法(即最速下降),这说明附近的二次近似不够好。

L-M 的求解方式,可在一定程度上避免线性方程组的系数矩阵的非奇异和病态问题,提供更稳定更准确的增量 ∆x。