- matlab mle 优化,MLE+: Matlab Toolbox for Integrated Modeling, Control and Optimization for Buildings...

Simon Zhong

matlabmle优化

摘要:FollowingunilateralopticnervesectioninadultPVGhoodedrat,theaxonguidancecueephrin-A2isup-regulatedincaudalbutnotrostralsuperiorcolliculus(SC)andtheEphA5receptorisdown-regulatedinaxotomisedretinalgan

- 个人学习笔记7-6:动手学深度学习pytorch版-李沐

浪子L

深度学习深度学习笔记计算机视觉python人工智能神经网络pytorch

#人工智能##深度学习##语义分割##计算机视觉##神经网络#计算机视觉13.11全卷积网络全卷积网络(fullyconvolutionalnetwork,FCN)采用卷积神经网络实现了从图像像素到像素类别的变换。引入l转置卷积(transposedconvolution)实现的,输出的类别预测与输入图像在像素级别上具有一一对应关系:通道维的输出即该位置对应像素的类别预测。13.11.1构造模型下

- 深度学习-点击率预估-研究论文2024-09-14速读

sp_fyf_2024

深度学习人工智能

深度学习-点击率预估-研究论文2024-09-14速读1.DeepTargetSessionInterestNetworkforClick-ThroughRatePredictionHZhong,JMa,XDuan,SGu,JYao-2024InternationalJointConferenceonNeuralNetworks,2024深度目标会话兴趣网络用于点击率预测摘要:这篇文章提出了一种新

- linux挂载文件夹

小码快撩

linux

1.使用NFS(NetworkFileSystem)NFS是一种分布式文件系统协议,允许一个系统将其文件系统的一部分共享给其他系统。检查是否安装NFSrpm-qa|grepnfs2.启动和启用NFS服务假设服务名称为nfs-server.service,你可以使用以下命令启动和启用它:sudosystemctlstartnfs-server.servicesudosystemctlenablenf

- 相对与绝对路径、命令:cd、mkdir、rmdir、rm

强出头

2.6相对和绝对路径绝对路径:都是从根目录/开始的就是绝对路径,无论在任何目录下都能通过该路径找到该文件相对路径:不是以根目录开头的,相对当前目录的路径[root@mylinuxetc]#cat/etc/sysconfig/network-scripts/ifcfg-ens33(这里我们使用绝对路径查看文件ifcfg-ens33)[root@mylinuxetc]#cd/etc/sysconfig

- uniapp 获取各种小程序code

灵魂清零

uniapp小程序

各种小程序在进入小程序是都需要去获取code才能拿到基础信息,自己记录一下用uniapp开发小程序是获取微信小程序、百度小程序、头条小程序、支付宝小程序的codeVue.prototype.$global={appLogin(){returnnewPromise((resole,reject)=>{varthat=this;varwxLoginUrl=app.globalData.url+"/lo

- seq_len 不等于 hidden_size 难道不会报错吗,他们是一会事情吗

zhangfeng1133

python人工智能开发语言pytorch

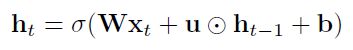

seq_len与hidden_size在RNN中代表不同概念,不等不会报错。seq_len:序列长度,表示在处理数据时,每个批次(batch)中序列的长度。RNN网络会按照seq_len指定的长度进行循环计算1。hidden_size:隐藏层中隐藏神经元的个数,也是输出向量的长度。它决定了RNN网络中隐藏层的状态向量的维度12。在RNN的训练过程中,seq_len和hidden_si

- 【NLP5-RNN模型、LSTM模型和GRU模型】

一蓑烟雨紫洛

nlprnnlstmgrunlp

RNN模型、LSTM模型和GRU模型1、什么是RNN模型RNN(RecurrentNeuralNetwork)中文称为循环神经网络,它一般以序列数据为输入,通过网络内部的结构设计有效捕捉序列之间的关系特征,一般也是以序列形式进行输出RNN的循环机制使模型隐层上一时间步产生的结果,能够作为当下时间步输入的一部分(当下时间步的输入除了正常的输入外还包括上一步的隐层输出)对当下时间步的输出产生影响2、R

- 深度学习--对抗生成网络(GAN, Generative Adversarial Network)

Ambition_LAO

深度学习生成对抗网络

对抗生成网络(GAN,GenerativeAdversarialNetwork)是一种深度学习模型,由IanGoodfellow等人在2014年提出。GAN主要用于生成数据,通过两个神经网络相互对抗,来生成以假乱真的新数据。以下是对GAN的详细阐述,包括其概念、作用、核心要点、实现过程、代码实现和适用场景。1.概念GAN由两个神经网络组成:生成器(Generator)和判别器(Discrimina

- ajax 获取一步数据,ajax异步获取数据

可可子姐姐教英语

ajax获取一步数据

functioncreateXHR(){if(typeofXMLHttpRequest!="undefined"){returnnewXMLHttpRequest();}elseif(typeofActiveXObject!="undefined"){varversion=["MSXML2.XMLHttp.6.0","MSXML2.XMLHttp.3.0","MSXML2.XMLHttp"];fo

- 多层建筑能源参数化模型和城市冠层模型的区别

WW、forever

WRF模型原理及应用城市模拟

多层建筑能源参数化(Multi-layerBuildingEnergyParameterization,BEP)模型和城市冠层模型(UrbanCanopyModel,UCM)都是用于模拟城市环境中能量交换和微气候的数值模型,但它们的侧重点和应用场景有所不同。以下是两者的主要区别:1.目标和应用场景BEP模型:目标:主要用于模拟多层建筑群的能量交换过程,特别是建筑内部和外部的热量传输、建筑能耗以及建

- Linux网络服务配置:从基础到高级

M78NB666

linux运维服务器

一、网络服务配置基础1.网络接口配置Linux系统中,网络接口的配置通常通过/etc/network/interfaces文件(Debian/Ubuntu)或/etc/sysconfig/network-scripts/ifcfg-文件(RedHat/CentOS)来完成。配置内容包括IP地址、子网掩码、网关等。2.DNS配置DNS配置通常在/etc/resolv.conf文件中设置,包括指定DN

- JS 获取时间

买买买买菜

/**针对Ext的工具类*/exportvarMrYangUtil=function(){/****获得当前时间*/this.getCurrentDate=function(){returnnewDate();};/****获得本周起止时间*/this.getCurrentWeek=function(){//起止日期数组varstartStop=newArray();//获取当前时间varcurr

- python数组的基本操作

迟遇3

python开发语言

一.创建数组arr:list[int]=[0]*8num1:list[int]=[1,5,9,8,6]二.访问元素1.指定访问(通过索引(下标))defrandom_a(nums:list[int])->int:returnnums[2]print(random_a(arr))2.随机访问(会访问不同的元素)defrandom_access(nums:list[int])->int:"""随机访问

- 前端发布 CDN缓存

跳动的世界线

前端缓存CDN

公司给服务器加了CDN,导致有时前端代码上传打包后,正式环境页面效果却不更新。每次都需要去找运维刷CDN…让我彻底记住了CDN缓存CDN(ContentDeliveryNetwork,内容分发网络)是一种广泛使用的互联网技术,旨在提高用户访问网站的速度和可靠性。CDN的核心思想是将网站的内容缓存到全球分布的边缘节点上,让用户能够从最近的节点获取数据,从而减少延迟和带宽消耗。CDN缓存机制的基本原理

- 边缘计算PCDN的使用场景及优势

神鸟云-Hu

边缘计算人工智能

一、定义PCDN,全称为PrivateContentDeliveryNetwork,即私有内容分发网络。它是一种基于P2P技术和CDN的内容分发加速网络,通过在网络中添加大量的低成本缓存服务器,将用户请求的内容从原始服务器分发到这些缓存服务器,从而实现内容更快、更稳定地传输到终端用户。二、功能PCDN的主要功能是加速内容传输。通过在CDN网络中加入更多的缓存服务器,将热点内容分布到更广泛的网络上,

- antd of vue treeSelect——异步加载

who_become_gods

onLoadData(treeNode){varthat=thisreturnnewPromise((resolve)=>{if(treeNode.

- 概率图模型(PGM)综述

医学影像处理

概率图模型概率图模型综述

RefLink:http://www.sigvc.org/bbs/thread-728-1-1.htmlGraphicalModel的基本类型基本的GraphicalModel可以大致分为两个类别:贝叶斯网络(BayesianNetwork)和马尔可夫随机场(MarkovRandomField)。它们的主要区别在于采用不同类型的图来表达变量之间的关系:贝叶斯网络采用有向无环图(DirectedAc

- 【加密社】深入理解TON智能合约 (FunC语法)

加密社

闲侃Nethereum教程区块链智能合约

king:摘要:在TON(TheOpenNetwork)区块链平台中,智能合约扮演着举足轻重的角色。本文将通过分析一段TON智能合约代码带领读者学习dict(字典)和list(列表)在FunC语言中的用法,以及如何在实际场景中实现高效的验证者选举。一、引言TON区块链平台的智能合约采用FunC语法一、引言TON区块链平台的智能合约采用FunC语言编写,该语言提供了丰富的数据结构,如dict和lis

- Ubuntu 22.04网络无法连接的解决方法

威桑

Linuxubuntulinux

在使用Ubuntu22.04系统时,在一次重启后桌面右上角并没有有线网络图标,并且打开浏览器无法访问百度。虚拟机网络连接方式是NAT模式,电脑主机也是有网络的。删除NetworkManager缓存文件,重启网络后问题就解决了。sudoserviceNetworkManagerstopsudorm/var/lib/NetworkManager/NetworkManager.statesudoserv

- 探索深度学习的奥秘:从理论到实践的奇幻之旅

小周不想卷

深度学习

目录引言:穿越智能的迷雾一、深度学习的奇幻起源:从感知机到神经网络1.1感知机的启蒙1.2神经网络的诞生与演进1.3深度学习的崛起二、深度学习的核心魔法:神经网络架构2.1前馈神经网络(FeedforwardNeuralNetwork,FNN)2.2卷积神经网络(CNN)2.3循环神经网络(RNN)及其变体(LSTM,GRU)2.4生成对抗网络(GAN)三、深度学习的魔法秘籍:算法与训练3.1损失

- VMware工具下centos7虚拟机无法使用yum的解决方法

hardly study

centoslinux运维服务器centos

一、检查网络配置是否正常执行pingwww.baidu.com,如果测试不通,则需进一步检查网卡配置(建议安装虚拟机时选择NAT模式)二、检查网卡信息2.1确认并修改网卡信息路径:/etc/sysconfig/network-scripts/ifcfg-ens33ONBOOT=no表示在系统启动时不激活ens33的网卡设备,修改onboot=yes,激活网卡2.2重启network服务system

- python用递归方式实现最大公约数_Python - 最大公约数算法

weixin_39765325

#Python3.6#最大公约数,最大公因子#GreatestCommonDivisor#辗转相除法defgcd(num1:object,num2:object)->object:print('num1={},num2={},r={}'.format(num1,num2,num1%num2))ifnum1%num2==0:returnnum2returngcd(num2,num1%num2)#更相

- CycleGAN学习:Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks, 2017.

屎山搬运工

深度学习CycleGANGAN风格迁移

【导读】图像到图像的转换技术一般需要大量的成对数据,然而要收集这些数据异常耗时耗力。因此本文主要介绍了无需成对示例便能实现图像转换的CycleGAN图像转换技术。文章分为五部分,分别概述了:图像转换的问题;CycleGAN的非成对图像转换原理;CycleGAN的架构模型;CycleGAN的应用以及注意事项。图像到图像的转换涉及到生成给定图像的新的合成版本,并进行特定的修改,例如将夏季景观转换为冬季

- arXiv综述论文“Graph Neural Networks: A Review of Methods and Applications”

硅谷秋水

自动驾驶

arXiv于2019年7月10日上载的GNN综述论文“GraphNeuralNetworks:AReviewofMethodsandApplications“。摘要:许多学习任务需要处理图数据,该图数据包含元素之间的丰富关系信息。建模物理系统、学习分子指纹、预测蛋白质界面以及对疾病进行分类都需要一个模型从图输入学习。在其他如文本和图像之类非结构数据学习的领域中,对提取的结构推理,例如句子的依存关系

- go-etcd实战

小书go

golang实战演练golangetcd服务发现服务注册微服务

etcd简介etcdisastronglyconsistent,distributedkey-valuestorethatprovidesareliablewaytostoredatathatneedstobeaccessedbyadistributedsystemorclusterofmachines.Itgracefullyhandlesleaderelectionsduringnetwork

- C# 网口通信(通过Sockets类)

萨达大

c#服务器网络网口通讯上位机

文章目录1.引入Sockets2.定义TcpClient3.连接网口4.发送数据5.关闭连接1.引入SocketsusingSystem.Net.Sockets;2.定义TcpClientprivateTcpClienttcpClient;//TcpClient实例privateNetworkStreamstream;//网络流,用于与服务器通信3.连接网口tcpClient=newTcpClie

- Centos7配置网络

挨踢的懒猫

我们的机器刚装完系统不能上网,需要根据信息技术部分配的IP对网络进行配置。一、列出网卡ifconfig会发现列出了两张网卡,ens160:主机的以太网卡lo:本地回环网卡。二、配置网络由于我们的IP都是静态分配,而CentOS默认是使用DHCP动态获取IP,所以ens160网卡没有IP,需要手动配置IP等信息。1.配置以太网卡sudovi/etc/sysconfig/network-scripts

- 喜大普奔:HashiCorp Vagrant 2.2.0发布!

HashiCorpChina

OCT172018BRIANCAINWearepleasedtoannouncethereleaseofVagrant2.2.0.Vagrantisatoolforbuildinganddistributingdevelopmentenvironments.ThehighlightofthisreleaseistheintroductionofVagrantCloudcommandlinetool

- 【干货】你可能不知道的 20个 Linux 网络工具

迷途不归路

转载自公众号:DevOps技术栈原文链接:http://linoxide.com/monitoring-2/network-monitoring-tools-linux/如果要在你的系统上监控网络,那么使用命令行工具是非常实用的,并且对于Linux用户来说,有着许许多多现成的工具可以使用,如:nethogs,ntopng,nload,iftop,iptraf,bmon,slurm,tcptrack

- mondb入手

木zi_鸣

mongodb

windows 启动mongodb 编写bat文件,

mongod --dbpath D:\software\MongoDBDATA

mongod --help 查询各种配置

配置在mongob

打开批处理,即可启动,27017原生端口,shell操作监控端口 扩展28017,web端操作端口

启动配置文件配置,

数据更灵活

- 大型高并发高负载网站的系统架构

bijian1013

高并发负载均衡

扩展Web应用程序

一.概念

简单的来说,如果一个系统可扩展,那么你可以通过扩展来提供系统的性能。这代表着系统能够容纳更高的负载、更大的数据集,并且系统是可维护的。扩展和语言、某项具体的技术都是无关的。扩展可以分为两种:

1.

- DISPLAY变量和xhost(原创)

czmmiao

display

DISPLAY

在Linux/Unix类操作系统上, DISPLAY用来设置将图形显示到何处. 直接登陆图形界面或者登陆命令行界面后使用startx启动图形, DISPLAY环境变量将自动设置为:0:0, 此时可以打开终端, 输出图形程序的名称(比如xclock)来启动程序, 图形将显示在本地窗口上, 在终端上输入printenv查看当前环境变量, 输出结果中有如下内容:DISPLAY=:0.0

- 获取B/S客户端IP

周凡杨

java编程jspWeb浏览器

最近想写个B/S架构的聊天系统,因为以前做过C/S架构的QQ聊天系统,所以对于Socket通信编程只是一个巩固。对于C/S架构的聊天系统,由于存在客户端Java应用,所以直接在代码中获取客户端的IP,应用的方法为:

String ip = InetAddress.getLocalHost().getHostAddress();

然而对于WEB

- 浅谈类和对象

朱辉辉33

编程

类是对一类事物的总称,对象是描述一个物体的特征,类是对象的抽象。简单来说,类是抽象的,不占用内存,对象是具体的,

占用存储空间。

类是由属性和方法构成的,基本格式是public class 类名{

//定义属性

private/public 数据类型 属性名;

//定义方法

publ

- android activity与viewpager+fragment的生命周期问题

肆无忌惮_

viewpager

有一个Activity里面是ViewPager,ViewPager里面放了两个Fragment。

第一次进入这个Activity。开启了服务,并在onResume方法中绑定服务后,对Service进行了一定的初始化,其中调用了Fragment中的一个属性。

super.onResume();

bindService(intent, conn, BIND_AUTO_CREATE);

- base64Encode对图片进行编码

843977358

base64图片encoder

/**

* 对图片进行base64encoder编码

*

* @author mrZhang

* @param path

* @return

*/

public static String encodeImage(String path) {

BASE64Encoder encoder = null;

byte[] b = null;

I

- Request Header简介

aigo

servlet

当一个客户端(通常是浏览器)向Web服务器发送一个请求是,它要发送一个请求的命令行,一般是GET或POST命令,当发送POST命令时,它还必须向服务器发送一个叫“Content-Length”的请求头(Request Header) 用以指明请求数据的长度,除了Content-Length之外,它还可以向服务器发送其它一些Headers,如:

- HttpClient4.3 创建SSL协议的HttpClient对象

alleni123

httpclient爬虫ssl

public class HttpClientUtils

{

public static CloseableHttpClient createSSLClientDefault(CookieStore cookies){

SSLContext sslContext=null;

try

{

sslContext=new SSLContextBuilder().l

- java取反 -右移-左移-无符号右移的探讨

百合不是茶

位运算符 位移

取反:

在二进制中第一位,1表示符数,0表示正数

byte a = -1;

原码:10000001

反码:11111110

补码:11111111

//异或: 00000000

byte b = -2;

原码:10000010

反码:11111101

补码:11111110

//异或: 00000001

- java多线程join的作用与用法

bijian1013

java多线程

对于JAVA的join,JDK 是这样说的:join public final void join (long millis )throws InterruptedException Waits at most millis milliseconds for this thread to die. A timeout of 0 means t

- Java发送http请求(get 与post方法请求)

bijian1013

javaspring

PostRequest.java

package com.bijian.study;

import java.io.BufferedReader;

import java.io.DataOutputStream;

import java.io.IOException;

import java.io.InputStreamReader;

import java.net.HttpURL

- 【Struts2二】struts.xml中package下的action配置项默认值

bit1129

struts.xml

在第一部份,定义了struts.xml文件,如下所示:

<!DOCTYPE struts PUBLIC

"-//Apache Software Foundation//DTD Struts Configuration 2.3//EN"

"http://struts.apache.org/dtds/struts

- 【Kafka十三】Kafka Simple Consumer

bit1129

simple

代码中关于Host和Port是割裂开的,这会导致单机环境下的伪分布式Kafka集群环境下,这个例子没法运行。

实际情况是需要将host和port绑定到一起,

package kafka.examples.lowlevel;

import kafka.api.FetchRequest;

import kafka.api.FetchRequestBuilder;

impo

- nodejs学习api

ronin47

nodejs api

NodeJS基础 什么是NodeJS

JS是脚本语言,脚本语言都需要一个解析器才能运行。对于写在HTML页面里的JS,浏览器充当了解析器的角色。而对于需要独立运行的JS,NodeJS就是一个解析器。

每一种解析器都是一个运行环境,不但允许JS定义各种数据结构,进行各种计算,还允许JS使用运行环境提供的内置对象和方法做一些事情。例如运行在浏览器中的JS的用途是操作DOM,浏览器就提供了docum

- java-64.寻找第N个丑数

bylijinnan

java

public class UglyNumber {

/**

* 64.查找第N个丑数

具体思路可参考 [url] http://zhedahht.blog.163.com/blog/static/2541117420094245366965/[/url]

*

题目:我们把只包含因子

2、3和5的数称作丑数(Ugly Number)。例如6、8都是丑数,但14

- 二维数组(矩阵)对角线输出

bylijinnan

二维数组

/**

二维数组 对角线输出 两个方向

例如对于数组:

{ 1, 2, 3, 4 },

{ 5, 6, 7, 8 },

{ 9, 10, 11, 12 },

{ 13, 14, 15, 16 },

slash方向输出:

1

5 2

9 6 3

13 10 7 4

14 11 8

15 12

16

backslash输出:

4

3

- [JWFD开源工作流设计]工作流跳跃模式开发关键点(今日更新)

comsci

工作流

既然是做开源软件的,我们的宗旨就是给大家分享设计和代码,那么现在我就用很简单扼要的语言来透露这个跳跃模式的设计原理

大家如果用过JWFD的ARC-自动运行控制器,或者看过代码,应该知道在ARC算法模块中有一个函数叫做SAN(),这个函数就是ARC的核心控制器,要实现跳跃模式,在SAN函数中一定要对LN链表数据结构进行操作,首先写一段代码,把

- redis常见使用

cuityang

redis常见使用

redis 通常被认为是一个数据结构服务器,主要是因为其有着丰富的数据结构 strings、map、 list、sets、 sorted sets

引入jar包 jedis-2.1.0.jar (本文下方提供下载)

package redistest;

import redis.clients.jedis.Jedis;

public class Listtest

- 配置多个redis

dalan_123

redis

配置多个redis客户端

<?xml version="1.0" encoding="UTF-8"?><beans xmlns="http://www.springframework.org/schema/beans" xmlns:xsi=&quo

- attrib命令

dcj3sjt126com

attr

attrib指令用于修改文件的属性.文件的常见属性有:只读.存档.隐藏和系统.

只读属性是指文件只可以做读的操作.不能对文件进行写的操作.就是文件的写保护.

存档属性是用来标记文件改动的.即在上一次备份后文件有所改动.一些备份软件在备份的时候会只去备份带有存档属性的文件.

- Yii使用公共函数

dcj3sjt126com

yii

在网站项目中,没必要把公用的函数写成一个工具类,有时候面向过程其实更方便。 在入口文件index.php里添加 require_once('protected/function.php'); 即可对其引用,成为公用的函数集合。 function.php如下:

<?php /** * This is the shortcut to D

- linux 系统资源的查看(free、uname、uptime、netstat)

eksliang

netstatlinux unamelinux uptimelinux free

linux 系统资源的查看

转载请出自出处:http://eksliang.iteye.com/blog/2167081

http://eksliang.iteye.com 一、free查看内存的使用情况

语法如下:

free [-b][-k][-m][-g] [-t]

参数含义

-b:直接输入free时,显示的单位是kb我们可以使用b(bytes),m

- JAVA的位操作符

greemranqq

位运算JAVA位移<<>>>

最近几种进制,加上各种位操作符,发现都比较模糊,不能完全掌握,这里就再熟悉熟悉。

1.按位操作符 :

按位操作符是用来操作基本数据类型中的单个bit,即二进制位,会对两个参数执行布尔代数运算,获得结果。

与(&)运算:

1&1 = 1, 1&0 = 0, 0&0 &

- Web前段学习网站

ihuning

Web

Web前段学习网站

菜鸟学习:http://www.w3cschool.cc/

JQuery中文网:http://www.jquerycn.cn/

内存溢出:http://outofmemory.cn/#csdn.blog

http://www.icoolxue.com/

http://www.jikexue

- 强强联合:FluxBB 作者加盟 Flarum

justjavac

r

原文:FluxBB Joins Forces With Flarum作者:Toby Zerner译文:强强联合:FluxBB 作者加盟 Flarum译者:justjavac

FluxBB 是一个快速、轻量级论坛软件,它的开发者是一名德国的 PHP 天才 Franz Liedke。FluxBB 的下一个版本(2.0)将被完全重写,并已经开发了一段时间。FluxBB 看起来非常有前途的,

- java统计在线人数(session存储信息的)

macroli

javaWeb

这篇日志是我写的第三次了 前两次都发布失败!郁闷极了!

由于在web开发中常常用到这一部分所以在此记录一下,呵呵,就到备忘录了!

我对于登录信息时使用session存储的,所以我这里是通过实现HttpSessionAttributeListener这个接口完成的。

1、实现接口类,在web.xml文件中配置监听类,从而可以使该类完成其工作。

public class Ses

- bootstrp carousel初体验 快速构建图片播放

qiaolevip

每天进步一点点学习永无止境bootstrap纵观千象

img{

border: 1px solid white;

box-shadow: 2px 2px 12px #333;

_width: expression(this.width > 600 ? "600px" : this.width + "px");

_height: expression(this.width &

- SparkSQL读取HBase数据,通过自定义外部数据源

superlxw1234

sparksparksqlsparksql读取hbasesparksql外部数据源

关键字:SparkSQL读取HBase、SparkSQL自定义外部数据源

前面文章介绍了SparSQL通过Hive操作HBase表。

SparkSQL从1.2开始支持自定义外部数据源(External DataSource),这样就可以通过API接口来实现自己的外部数据源。这里基于Spark1.4.0,简单介绍SparkSQL自定义外部数据源,访

- Spring Boot 1.3.0.M1发布

wiselyman

spring boot

Spring Boot 1.3.0.M1于6.12日发布,现在可以从Spring milestone repository下载。这个版本是基于Spring Framework 4.2.0.RC1,并在Spring Boot 1.2之上提供了大量的新特性improvements and new features。主要包含以下:

1.提供一个新的sprin