- 大数据学习|理解和对比 Apache Hive 和 Apache Iceberg

进击的小白菜

数据库大数据大数据学习apache

文章目录数据模型与存储事务支持性能优化使用场景总结数据模型与存储Hive:Hive使用的是传统的关系型数据模型,数据存储在Hadoop分布式文件系统(HDFS)中,通常是以文本格式(如CSV或TSV)或者二进制格式(如Parquet或ORC)。Hive的表定义和元数据存储在一个外部的关系数据库中,如MySQL,用于跟踪表结构、分区和其他元数据信息。Iceberg:Iceberg设计为一个现代的表格

- Python大数据学习day01——大数据开发概论

笨小孩124

python学习总结大数据学习python

目录大数据概念大数据特点大数据应用场景大数据分析业务步骤大数据职业规划大数据学习路线1.大数据解决问题海量数据存储——海量数据运算——海量数据迁移2.大数据特点(大、多、值、快、信)数据体量大种类和来源多源化实现低价值密度速度快数据的质量准确可信3.大数据应用4.大数据分析步骤明确分析目的思路——数据收集——数据处理(ETL)——数据分析——数据展现——撰写报告5.大数据职业规划6.大数据学习路线

- 大数据学习路线基础指南

一马什么梅一

大数据学习

随着信息技术的迅猛发展,大数据已成为当今社会的热门话题。无论是企业决策、市场分析还是科学研究,大数据都扮演着举足轻重的角色。对于想要投身这一领域的学习者来说,制定一份清晰、系统的大数据学习路线是至关重要的。提供一份从零基础到精通的大数据学习指南希望对大家有所帮助一、基础阶段:掌握核心概念与技能1.了解大数据基础学习大数据的定义、特点、价值以及应用领域。理解大数据与传统

- 学习大数据开发,需要满足哪些条件?学历,性别,专业有限制吗?

yoku酱

给大家介绍一下关于零基础学习大数据需要哪些条件?首先我们在平时的工作中,经常有小白同学问学习大数据有学历限制吗?我是大专学历可以学习大数据技术吗?我没有计算机基础,可以学习大数据吗?大数据学习是不是很难,零基础能学会吗?我是女生,可以学习大数据技术吗?下面我们针对这些问题来一一作答!首先对于零基础的童鞋想参加大数据开发学习,需要:1、一些数学常识,尤其是想从事数据分析这一块,至少要了解常用计算模型

- 001kafka源码项目gradle报错UnsupportedClassVersionError-kafka-报错-大数据学习

gaog2zh

大数据kafka大数据

1报错提示java.lang.UnsupportedClassVersionError:org/eclipse/jgit/lib/AnyObjectIdhasbeencompiledbyamorerecentversionoftheJavaRuntime(classfileversion55.0),thisversionoftheJavaRuntimeonlyrecognizesclassfile

- python+大数据学习打卡day1

岁月不静好456

bigdata学习

【大数据从0-1打卡-day1】1、简单了解一些关于大数据的概念数据:数据就是对客观事件进行记录并可以鉴别的符号。他不仅仅是指数字,还可以是有一定意义的字母、文字、符号、语音、文字、图画、视频或者这些元素的结合等。企业数据分析方向:现状分析:离线分析原因分析:实时分析预测分析:机器学习数据分析基本流程:采集、处理、分析、应用大数据:大数据(bigdata),指的是所涉及的资料量规模巨大到无法透过主

- 大数据基础必备,大数据是什么?

大数据05

随着互联网时代的到来,颠覆了传统行业的盈利模式,大家都把注意力集中在了互联网上。前几年大数据时代的来临,为各行各业提供了更加开阔的数据用作分析。大数据学习群:199427210百科对于大数据是这样解释的:麦肯锡全球研究所给出的定义是:一种规模大到在获取、存储、管理、分析方面大大超出了传统数据库软件工具能力范围的数据集合,具有海量的数据规模、快速的数据流转、多样的数据类型和价值密度低四大特征。大数据

- 自学大数据:大数据学习线路及各阶段学习书籍

yoku酱

大数据学习路线及各阶段学习书籍推荐!阶段一、大数据基础——java语言基础方面(1)Java语言基础Java开发介绍、熟悉Eclipse开发工具、Java语言基础、Java流程控制、Java字符串、Java数组与类和对象、数字处理类与核心技术、I/O与反射、多线程、Swing程序与集合类(2)HTML、CSS与JavaScriptPC端网站布局、HTML5+CSS3基础、WebApp页面布局、原生

- 学习大数据需要掌握哪些知识?

大数据学习01

大数据已经成为时代发展的趋势,很多人纷纷选择学习大数据,想要进入大数据行业。大数据技术体系庞大,包括的知识较多,系统的学习大数据可以让你全面掌握大数据技能。学习大数据需要掌握哪些知识?1、学习大数据首先要学习Java基础怎样进行大数据学习的快速入门?学大数据课程之前要先学习一种计算机编程语言。Java是大数据学习需要的编程语言基础,因为大数据的开发基于常用的高级语言。而且不论是学习hadoop,还

- 大数据学习入门级书籍推荐,零基础小伙伴们关注一下吧

kuntoria

1.《大数据分析:点“数”成金》大数据学习入门级书籍推荐你现在正坐在一座金矿之上,这些金子或被深埋于备份、存档数据之中,或正藏在你眼前的数据集里,它们是提升公司效益、拓展新的商业关系、制订更直观决策的秘诀所在,足以使你的企业更上一层楼。你将明白如何利用、分析和驾驭数据来获得丰厚回报。作者FrankOhlhorst“厚积”数十年的技术经验而“薄发”于此书,他将向读者介绍怎样将大数据分析应用于各行各业

- 2021-11-07大数据学习日志——MySQL进阶——报表项目

王络不稳定

mysql数据库database

01_数据表介绍学习目标了解项目使用的数据表结构及表关系课程使用微软的Northwind数据集,零售业务,包含了客户,供应商和订单数据。原始数据集可以在微软GitHub仓库下载。为了满足课程需求,数据库数据在原始数据基础上做了微调。基于此份数据,我们将通过SQL来创建数据报表,满足业务需求。1.1数据表整体概览1.2员工表(employees)保存员工基本信息,包含如下字段:employee_id

- 大数据学习之Redis,十大数据类型的具体应用(五)

十二点的泡面

redis学习redis数据库

目录3.9Redis地理空间(GEO)简介原理Redis在3.2版本以后增加了地理位置的处理哦命令命令实操如何获得某个地址的经纬度3.9Redis地理空间(GEO)简介移动互联网时代LBS应用越来越多,交友软件中附近的小姐姐、外卖软件中附近的美食店铺、高德地图附近的核酸检査点等等,那这种附近各种形形色色的XXX地址位置选择是如何实现的?地球上的地理位置是使用二维的经纬度表示,经度范围(-180,1

- 量化学习:大数据时代的学习方式

weixin_44387107

大数据大数据人工智能机器学习数据挖掘数据分析

摘要:未来人工智能、大数据、学习分析等技术被广泛应用于教育教学中,量化学习将成为新的研究热点。本研究首先对量化学习的内涵、特征、工具和方法进行概述,然后阐述了量化学习的价值意义和应用案例,进而分析了量化学习发展趋势与其面临的挑战。关键词:量化学习;大数据;《地平线报告》(高等教育版)在这里相信有许多想要学习大数据的同学,大家可以+下大数据学习裙:740041381,即可免费领取套系统的大数据学习教

- 大数据是什么?华为云学院带你探索大数据之旅

舒意从生

大数据是什么?华为云学院带你探索大数据之旅我们首先从大数据是什么开始讲起,!下面由我来带领大家!展开我们本次的大数据学习之旅!大数据是什么,内容将包括大数据的产生,发展大数据的基本概念。首先我们来追溯一下大数据的产生与发展,大数据的产生和发展主要经历了三个阶段。第一个阶段,我们称为是萌芽期!自上世纪九十年代至本世纪初,随着数据挖掘理论和数据库技术的逐步成熟,一批商业智能工具和知识的管理技术也开始得

- 大数据学习(32)hive优化方法总结

viperrrrrrr

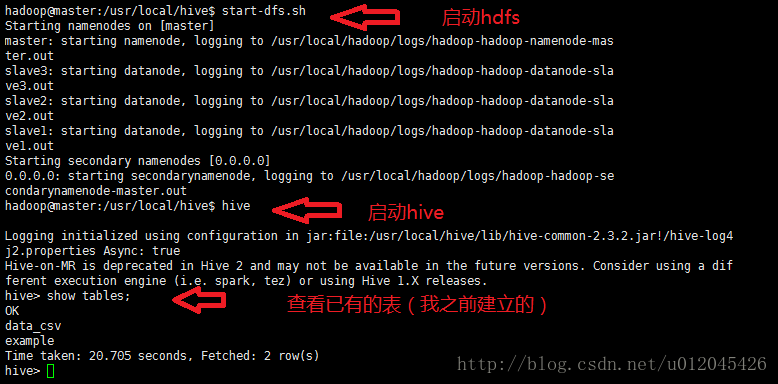

大数据学习hive

&&大数据学习&&系列专栏:哲学语录:承认自己的无知,乃是开启智慧的大门如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦Hive优化主要从以下几个方面考虑:数据倾斜:对于数据倾斜问题,可以尝试进行数据重分布,将倾斜的数据进行重新整理。也可以通过多线程处理和数据分箱等技术进行优化。减少job数:对于大量的小任务,可以尝试进行任务的合并,减少任务的启动次数,从而提高效率。合理设置ma

- 大数据学习之Redis,十大数据类型的具体应用(四)

十二点的泡面

学习redis数据库

3.8Redis基数统计(HyperLogLog)需求统计某个网站的UV、统计某个文章的UV什么是UVuniqueVisitor,独立访客,一般理解为客户端IP大规模的防止作弊,需要去重复统计独立访客比如IP同样就认为是同一个客户需要去重考虑用户搜索网站的关键词的数量统计用户每天搜索不同词条个数是什么?去重复统计功能的基数估计算法-就是HyperLogLogRedisHyperLogLog是用来做

- 大数据学习之Redis,十大数据类型的具体应用(一)

十二点的泡面

redis学习redis数据库

目录3.数据类型命令及落地应用3.1备注3.2Redis字符串(String)单值单value多值操作获取指定区间范围内的值数值增减获取字符串长度和内容追加分布式锁getset(先get后set)3.3Redis列表(List)简单说明单key多value3.4Redis哈希(Hash)KV模式不变,但是V是一个键值对3.数据类型命令及落地应用3.1备注命令不区分大小写,而key是区分大小写的永远

- 大数据学习之Redis,十大数据类型的具体应用(三)

十二点的泡面

学习redis数据库

目录3.7Redis位图(bitmap)概念需求是什么说明能干嘛?基本命令3.7Redis位图(bitmap)概念由0和1状态表现的二进制位的bit数组需求用户是否登陆过?Y/N广告是否被点击过?钉钉打卡上下班,签到统计是什么说明用String类型作为底层数据结构实现的一种统计二值状态的数据类型位图本质是数组,它是基丁String数据类型的按位的操作。该数组由多个二进制位组成,每个二进制位都对应一

- 大数据学习之Redis,十大数据类型的具体应用(二)

十二点的泡面

redis学习redis数据库

目录3.5Redis集合(Set)单值多value,且无重复sadd/smembers/sismember/srem/scardsrandmember/spopsmove集合运算应用场景3.6Redis有序集合Zset(sortedset)有序有重复zadd/zrange/zrevrangezrangebyscorezscore/zcard/zremzincrby/zcount/zmpopzran

- 从术语到Spark,10篇必读大数据学习资源

大数据的时代

本文给想进入大数据领域的朋友提供了一系列的资源,由浅入深,比如“需要了解的51条大数据术语”、“学习python的四个理由”、“十一个必须要参加的大数据会议”等有趣的话题。相信各种背景的朋友都会在这篇文章中有所收获。之前,我们已就数据可视化进行了深入探讨。这次,我们将从更基本的概念讲起,以便在涉足更复杂的数据科学和商业智能之前能够真正理解大数据。文中会引领大家阅读介绍大数据的相关文章,研究网络上流

- 大数据学习之Redis、从零基础到入门(三)

十二点的泡面

redisbootstrap前端html

目录三、redis10大数据类型1.哪十个?1.1redis字符串(String)1.2redis列表(List)1.3redis哈希表(Hash)1.4redis集合(Set)1.5redis有序集合(ZSet)1.6redis地理空间(GEO)1.7redis基数统计(HyperLongLog)1.8redis位图(bitmap)编辑1.9redis位域(bitfiled)1.10redis流

- 大数据学习之Redis、从零基础到入门(一)

十二点的泡面

redis大数据学习redis

目录一、Redis入门概述1.是什么?官方解释:2.能干嘛?2.1主流功能与应用2.1.1分布式缓存2.1.2内存存储和持久化(RDB+AOF)2.1.3高可用架构搭建2.1.4缓存穿透、击穿、雪崩2.1.5分布式锁2.1.6队列2.2总体功能概括2.3优势3.去哪下?官网地址:英文:中文:中文文档:下载安装包:其他文档资料:Redis源码地址:Redis在线测试:Redis命令参考:4.怎么玩?

- 大数据学习之Redis、从零基础到入门(二)

十二点的泡面

redis大数据学习redis

二、Redis安装配置1.VMWare本地虚拟机VMWare准备的为64位查看自己的VMWare是32位还是64位getconfLONG_BIT2.Redis的安装2.1系统选择选择Linux系统2.2Linux版安装2.2.1Linux环境安装Redis必须先具备gcc编译环境①什么是gccgcc是linux下的一个编译程序,是C程序的编译工具GCC(GNUCompilerCollection)

- 大数据运维到底是什么 又需要做些什么

科技资讯快报

疫情期间,大数据的广泛应用发挥了巨大的作用,作为新兴的IT领域技术,大数据行业受到越来越多的人关注,于是想要入行的、转行的纷纷选择大数据学习,那么大数据运维到底是什么?又需要做些什么?直白的解释大数据运维,就是有一些数据需要进行维护,运维的意思在这里就是维护。作为一名合格的大数据运维,需要承担的责任繁琐而严谨,今天就来了解其中的一部分,首先大数据运维需要承担团队的日常管理,组织制定中心基础设施的保

- 大数据学习之路

金光闪闪耶

一、为什么要学习大数据?在我第一份实习的时候,忘记在什么场景下我leader突然说了一句:「干Java不就是增删改查嘛」,而恰好那时候知乎都是「干了3年Java,还是只会增删改查,迷茫」等问题,我听完leader那句话就心里一颤。因为这句话,我又一次的陷入迷茫,我不清楚自己是不是应该继续的Java,所以那段时间我干过爬虫,也撸了一阵子的西瓜书和统计学什么的。在知乎上所有相关的问题和答案我都看了,也

- 大数据学习之Flink算子、了解(Source)源算子(基础篇二)

十二点的泡面

Flink算子大数据学习flink

Source源算子(基础篇二)目录Source源算子(基础篇二)二、源算子(source)1.准备工作2.从集合中读取数据可以使用代码中的fromCollection()方法直接读取列表也可以使用代码中的fromElements()方法直接列出数据获取3.从文件中读取数据说明:4.从Socket读取数据(1)编写StreamWordCount(2)在Linux环境的主机bigdata1上,执行下列

- 大数据学习之Flink算子、了解(Transformation)转换算子(基础篇三)

十二点的泡面

算子Flink大数据学习flink

Transformation转换算子(基础篇三)目录Transformation转换算子(基础篇三)三、转换算子(Transformation)1.基本转换算子1.1映射(Map)1.2过滤(filter)1.3扁平映射(flatmap)1.4基本转换算子的例子2.聚合算子(Aggregation)2.1按键分区(keyBy)2.2简单聚合2.3归约聚合(reduce)3.用户自定义函数(UDF)

- 大数据学习之Flink算子、了解DataStream API(基础篇一)

十二点的泡面

Flink算子大数据学习flink

DataStreamAPI(基础篇)注:本文只涉及DataStream原因:随着大数据和流式计算需求的增长,处理实时数据流变得越来越重要。因此,DataStream由于其处理实时数据流的特性和能力,逐渐替代了DataSet成为了主流的数据处理方式。目录DataStreamAPI(基础篇)前摘:一、执行环境1.创建执行环境2.执行模式3.触发程序执行二、源算子(source)三、转换算子(Trans

- 大数据学习之Flink、比较不同框架的容错机制

十二点的泡面

大数据Flink大数据学习flink

第一章、Flink的容错机制第二章、Flink核心组件和工作原理第三章、Flink的恢复策略第四章、Flink容错机制的注意事项第五章、Flink的容错机制与其他框架的容错机制相比较目录第五章、Flink的容错机制与其他框架的容错机制相比较Ⅰ、Flink的容错机制与其他框架的容错机制相比较相同点:1.容错机制的目的:2.持久化存储:不同点:1.适用场景:2.容错机制的细节:3.数据一致性:综上所述

- 大数据学习之Flink、Flink容错机制的注意事项

十二点的泡面

大数据Flink大数据学习flink

第一章、Flink的容错机制第二章、Flink核心组件和工作原理第三章、Flink的恢复策略第四章、Flink容错机制的注意事项第五章、Flink的容错机制与其他框架的容错机制相比较目录第四章、Flink容错机制的注意事项Ⅰ、注意事项1.Checkpoint的稳定性:2.状态一致性:3.失败的Checkpoint或Savepoint处理:4.资源管理:5.版本控制:6.监控和日志分析:第四章、Fl

- 分享100个最新免费的高匿HTTP代理IP

mcj8089

代理IP代理服务器匿名代理免费代理IP最新代理IP

推荐两个代理IP网站:

1. 全网代理IP:http://proxy.goubanjia.com/

2. 敲代码免费IP:http://ip.qiaodm.com/

120.198.243.130:80,中国/广东省

58.251.78.71:8088,中国/广东省

183.207.228.22:83,中国/

- mysql高级特性之数据分区

annan211

java数据结构mongodb分区mysql

mysql高级特性

1 以存储引擎的角度分析,分区表和物理表没有区别。是按照一定的规则将数据分别存储的逻辑设计。器底层是由多个物理字表组成。

2 分区的原理

分区表由多个相关的底层表实现,这些底层表也是由句柄对象表示,所以我们可以直接访问各个分区。存储引擎管理分区的各个底层

表和管理普通表一样(所有底层表都必须使用相同的存储引擎),分区表的索引只是

- JS采用正则表达式简单获取URL地址栏参数

chiangfai

js地址栏参数获取

GetUrlParam:function GetUrlParam(param){

var reg = new RegExp("(^|&)"+ param +"=([^&]*)(&|$)");

var r = window.location.search.substr(1).match(reg);

if(r!=null

- 怎样将数据表拷贝到powerdesigner (本地数据库表)

Array_06

powerDesigner

==================================================

1、打开PowerDesigner12,在菜单中按照如下方式进行操作

file->Reverse Engineer->DataBase

点击后,弹出 New Physical Data Model 的对话框

2、在General选项卡中

Model name:模板名字,自

- logbackのhelloworld

飞翔的马甲

日志logback

一、概述

1.日志是啥?

当我是个逗比的时候我是这么理解的:log.debug()代替了system.out.print();

当我项目工作时,以为是一堆得.log文件。

这两天项目发布新版本,比较轻松,决定好好地研究下日志以及logback。

传送门1:日志的作用与方法:

http://www.infoq.com/cn/articles/why-and-how-log

上面的作

- 新浪微博爬虫模拟登陆

随意而生

新浪微博

转载自:http://hi.baidu.com/erliang20088/item/251db4b040b8ce58ba0e1235

近来由于毕设需要,重新修改了新浪微博爬虫废了不少劲,希望下边的总结能够帮助后来的同学们。

现行版的模拟登陆与以前相比,最大的改动在于cookie获取时候的模拟url的请求

- synchronized

香水浓

javathread

Java语言的关键字,可用来给对象和方法或者代码块加锁,当它锁定一个方法或者一个代码块的时候,同一时刻最多只有一个线程执行这段代码。当两个并发线程访问同一个对象object中的这个加锁同步代码块时,一个时间内只能有一个线程得到执行。另一个线程必须等待当前线程执行完这个代码块以后才能执行该代码块。然而,当一个线程访问object的一个加锁代码块时,另一个线程仍然

- maven 简单实用教程

AdyZhang

maven

1. Maven介绍 1.1. 简介 java编写的用于构建系统的自动化工具。目前版本是2.0.9,注意maven2和maven1有很大区别,阅读第三方文档时需要区分版本。 1.2. Maven资源 见官方网站;The 5 minute test,官方简易入门文档;Getting Started Tutorial,官方入门文档;Build Coo

- Android 通过 intent传值获得null

aijuans

android

我在通过intent 获得传递兑现过的时候报错,空指针,我是getMap方法进行传值,代码如下 1 2 3 4 5 6 7 8 9

public

void

getMap(View view){

Intent i =

- apache 做代理 报如下错误:The proxy server received an invalid response from an upstream

baalwolf

response

网站配置是apache+tomcat,tomcat没有报错,apache报错是:

The proxy server received an invalid response from an upstream server. The proxy server could not handle the request GET /. Reason: Error reading fr

- Tomcat6 内存和线程配置

BigBird2012

tomcat6

1、修改启动时内存参数、并指定JVM时区 (在windows server 2008 下时间少了8个小时)

在Tomcat上运行j2ee项目代码时,经常会出现内存溢出的情况,解决办法是在系统参数中增加系统参数:

window下, 在catalina.bat最前面

set JAVA_OPTS=-XX:PermSize=64M -XX:MaxPermSize=128m -Xms5

- Karam与TDD

bijian1013

KaramTDD

一.TDD

测试驱动开发(Test-Driven Development,TDD)是一种敏捷(AGILE)开发方法论,它把开发流程倒转了过来,在进行代码实现之前,首先保证编写测试用例,从而用测试来驱动开发(而不是把测试作为一项验证工具来使用)。

TDD的原则很简单:

a.只有当某个

- [Zookeeper学习笔记之七]Zookeeper源代码分析之Zookeeper.States

bit1129

zookeeper

public enum States {

CONNECTING, //Zookeeper服务器不可用,客户端处于尝试链接状态

ASSOCIATING, //???

CONNECTED, //链接建立,可以与Zookeeper服务器正常通信

CONNECTEDREADONLY, //处于只读状态的链接状态,只读模式可以在

- 【Scala十四】Scala核心八:闭包

bit1129

scala

Free variable A free variable of an expression is a variable that’s used inside the expression but not defined inside the expression. For instance, in the function literal expression (x: Int) => (x

- android发送json并解析返回json

ronin47

android

package com.http.test;

import org.apache.http.HttpResponse;

import org.apache.http.HttpStatus;

import org.apache.http.client.HttpClient;

import org.apache.http.client.methods.HttpGet;

import

- 一份IT实习生的总结

brotherlamp

PHPphp资料php教程php培训php视频

今天突然发现在不知不觉中自己已经实习了 3 个月了,现在可能不算是真正意义上的实习吧,因为现在自己才大三,在这边撸代码的同时还要考虑到学校的功课跟期末考试。让我震惊的是,我完全想不到在这 3 个月里我到底学到了什么,这是一件多么悲催的事情啊。同时我对我应该 get 到什么新技能也很迷茫。所以今晚还是总结下把,让自己在接下来的实习生活有更加明确的方向。最后感谢工作室给我们几个人这个机会让我们提前出来

- 据说是2012年10月人人网校招的一道笔试题-给出一个重物重量为X,另外提供的小砝码重量分别为1,3,9。。。3^N。 将重物放到天平左侧,问在两边如何添加砝码

bylijinnan

java

public class ScalesBalance {

/**

* 题目:

* 给出一个重物重量为X,另外提供的小砝码重量分别为1,3,9。。。3^N。 (假设N无限大,但一种重量的砝码只有一个)

* 将重物放到天平左侧,问在两边如何添加砝码使两边平衡

*

* 分析:

* 三进制

* 我们约定括号表示里面的数是三进制,例如 47=(1202

- dom4j最常用最简单的方法

chiangfai

dom4j

要使用dom4j读写XML文档,需要先下载dom4j包,dom4j官方网站在 http://www.dom4j.org/目前最新dom4j包下载地址:http://nchc.dl.sourceforge.net/sourceforge/dom4j/dom4j-1.6.1.zip

解开后有两个包,仅操作XML文档的话把dom4j-1.6.1.jar加入工程就可以了,如果需要使用XPath的话还需要

- 简单HBase笔记

chenchao051

hbase

一、Client-side write buffer 客户端缓存请求 描述:可以缓存客户端的请求,以此来减少RPC的次数,但是缓存只是被存在一个ArrayList中,所以多线程访问时不安全的。 可以使用getWriteBuffer()方法来取得客户端缓存中的数据。 默认关闭。 二、Scan的Caching 描述: next( )方法请求一行就要使用一次RPC,即使

- mysqldump导出时出现when doing LOCK TABLES

daizj

mysqlmysqdump导数据

执行 mysqldump -uxxx -pxxx -hxxx -Pxxxx database tablename > tablename.sql

导出表时,会报

mysqldump: Got error: 1044: Access denied for user 'xxx'@'xxx' to database 'xxx' when doing LOCK TABLES

解决

- CSS渲染原理

dcj3sjt126com

Web

从事Web前端开发的人都与CSS打交道很多,有的人也许不知道css是怎么去工作的,写出来的css浏览器是怎么样去解析的呢?当这个成为我们提高css水平的一个瓶颈时,是否应该多了解一下呢?

一、浏览器的发展与CSS

- 《阿甘正传》台词

dcj3sjt126com

Part Ⅰ:

《阿甘正传》Forrest Gump经典中英文对白

Forrest: Hello! My names Forrest. Forrest Gump. You wanna Chocolate? I could eat about a million and a half othese. My momma always said life was like a box ochocol

- Java处理JSON

dyy_gusi

json

Json在数据传输中很好用,原因是JSON 比 XML 更小、更快,更易解析。

在Java程序中,如何使用处理JSON,现在有很多工具可以处理,比较流行常用的是google的gson和alibaba的fastjson,具体使用如下:

1、读取json然后处理

class ReadJSON

{

public static void main(String[] args)

- win7下nginx和php的配置

geeksun

nginx

1. 安装包准备

nginx : 从nginx.org下载nginx-1.8.0.zip

php: 从php.net下载php-5.6.10-Win32-VC11-x64.zip, php是免安装文件。

RunHiddenConsole: 用于隐藏命令行窗口

2. 配置

# java用8080端口做应用服务器,nginx反向代理到这个端口即可

p

- 基于2.8版本redis配置文件中文解释

hongtoushizi

redis

转载自: http://wangwei007.blog.51cto.com/68019/1548167

在Redis中直接启动redis-server服务时, 采用的是默认的配置文件。采用redis-server xxx.conf 这样的方式可以按照指定的配置文件来运行Redis服务。下面是Redis2.8.9的配置文

- 第五章 常用Lua开发库3-模板渲染

jinnianshilongnian

nginxlua

动态web网页开发是Web开发中一个常见的场景,比如像京东商品详情页,其页面逻辑是非常复杂的,需要使用模板技术来实现。而Lua中也有许多模板引擎,如目前我在使用的lua-resty-template,可以渲染很复杂的页面,借助LuaJIT其性能也是可以接受的。

如果学习过JavaEE中的servlet和JSP的话,应该知道JSP模板最终会被翻译成Servlet来执行;而lua-r

- JZSearch大数据搜索引擎

颠覆者

JavaScript

系统简介:

大数据的特点有四个层面:第一,数据体量巨大。从TB级别,跃升到PB级别;第二,数据类型繁多。网络日志、视频、图片、地理位置信息等等。第三,价值密度低。以视频为例,连续不间断监控过程中,可能有用的数据仅仅有一两秒。第四,处理速度快。最后这一点也是和传统的数据挖掘技术有着本质的不同。业界将其归纳为4个“V”——Volume,Variety,Value,Velocity。大数据搜索引

- 10招让你成为杰出的Java程序员

pda158

java编程框架

如果你是一个热衷于技术的

Java 程序员, 那么下面的 10 个要点可以让你在众多 Java 开发人员中脱颖而出。

1. 拥有扎实的基础和深刻理解 OO 原则 对于 Java 程序员,深刻理解 Object Oriented Programming(面向对象编程)这一概念是必须的。没有 OOPS 的坚实基础,就领会不了像 Java 这些面向对象编程语言

- tomcat之oracle连接池配置

小网客

oracle

tomcat版本7.0

配置oracle连接池方式:

修改tomcat的server.xml配置文件:

<GlobalNamingResources>

<Resource name="utermdatasource" auth="Container"

type="javax.sql.DataSou

- Oracle 分页算法汇总

vipbooks

oraclesql算法.net

这是我找到的一些关于Oracle分页的算法,大家那里还有没有其他好的算法没?我们大家一起分享一下!

-- Oracle 分页算法一

select * from (

select page.*,rownum rn from (select * from help) page

-- 20 = (currentPag