论文阅读>烟雾检测:Vision based smoke detection system using image energy and color information

原文

Vision based smoke detection system using image energy and color information

文章目录

- 原文

- 基于图像能量和颜色信息的视觉烟雾检测系统

- 摘要

- 关键词

- 1 介绍

- 2 相关工作

- 3 系统概述

- 4 烟雾分割的背景模型

- 4.1 背景引导

- 4.2 背景更新和前景提取

- 4.3 对象验证

- 4.4 快速虚影抑制

- 5 用于前景对象分类的烟雾检测

- 5.1 使用离散小波变换的能量分析

- 5.2 检测混合烟雾区域的颜色分析

- 5.3 贝叶斯分类方法

- 6 实验结果和讨论

- 7 结论

- 参考文献

基于图像能量和颜色信息的视觉烟雾检测系统

Vision based smoke detection system using image energy and color information

Simone Calderara · Paolo Piccinini · Rita Cucchiara

摘要

烟雾检测是许多视频监控应用中的一项关键任务,对提高城市地区的安全水平有很大的影响。存在许多商业烟雾探测传感器,但是它们中的大多数不能应用于开放空间或室外场景。

为此,本文提出了一种烟雾探测系统,该系统利用普通的CCD摄像传感器探测图像中的烟雾并触发报警。

首先,提出了一个合适的背景模型来可靠地提取烟雾区域,避免在室外场景中的过度分离和误报,在室外场景中存在许多干扰物,例如移动的树或光反射。

利用小波变换系数和颜色信息分析图像能量,采用一种新的贝叶斯方法检测场景中的烟雾区域。

建立了图像能量的统计模型,利用速度高斯混合分析了烟雾覆盖场景时通常出现的能量衰减,然后通过评估参考烟雾颜色和输入帧之间的颜色混合来加强检测。

所提出的系统能够在夜间和白天条件下快速检测烟雾事件,并且减少了错误警报的数量,因此特别适合于监控大型室外场景, 在这些场景中,普通传感器会失效。

在录制的视频和实时摄像机上进行了广泛的实验,评估了在许多实际情况下(例如室外存储和森林)系统的效率。

关键词

烟雾检测,图像处理,高斯混合模型,离散小波变换。

Smoke detection

Image processing

MoG(Gaussian mixture model)

DWT(Discrete Wavelet Transform)

1 介绍

自动或半自动环境监测是政治政策的一个关键问题,旨在防止因自然或人为事件造成的危机,这些事件可能危及人的安全以及建筑物和自然的安全。在这些事件中,烟和火对于安全和商业动机来说是最重要的。

视频流中的烟雾检测仍然是计算机视觉和模式识别领域的一个公开挑战。它涉及定义可靠的方法,以尽快检测可能由爆炸、火灾或特殊环境条件引起的烟雾的快速扩散。出于这些动机,烟雾探测模块丰富了室内和室外监控的标准视频监控系统。

由于烟雾本身的形状、运动和纹理模式的可变性,烟雾检测的视频分析任务并不繁琐,其外观取决于场景的亮度条件、背景流形和颜色。由于烟雾改变了背景的视觉线索,通常采用背景抑制技术,然后是验证/分类任务。在有其他移动物体、阴影和背景变化的情况下,烟雾识别变得更具挑战性。

本文提出利用图像能量和颜色信息作为检测烟雾的关键特征。在我们的方法中,使用新颖和鲁棒的背景抑制技术提取运动对象,即使在不利条件下也能确保鲁棒的分割,减少误报的数量。随后,由于场景中的烟雾压力,斑点被分类为真实物体或伪影。使用小波变换计算图像能量,并使用高斯混合模型(MoG)对其时间演化进行建模,以捕捉当烟雾覆盖部分场景时通常出现的缓慢能量衰减。

此外,MoG分类使用贝叶斯框架对场景颜色变化进行了改进,以加快和改善决策过程。

值得注意的是,与大多数以前的解决方案不同,我们没有对外部条件和摄像机的视场做出任何假设,这使得我们的系统足够灵活,可以应用于不同的设置和多种照明条件下。我们在http://imagelab.ing.unimore.it/visor网站的公开数据集上评估系统性能,测量检测率和检测时间。

结果表明,在几个室外固定摄像机设置中,检测率令人满意,误报警数量减少,召回率为100%,这在任何烟雾检测系统中都是迫切需要的。

2 相关工作

研究环境、自然或人工对视频场景的影响的问题已经在人文学中进行了深入的研究,并且肯定会在许多不同的情况下影响每个人的生活。

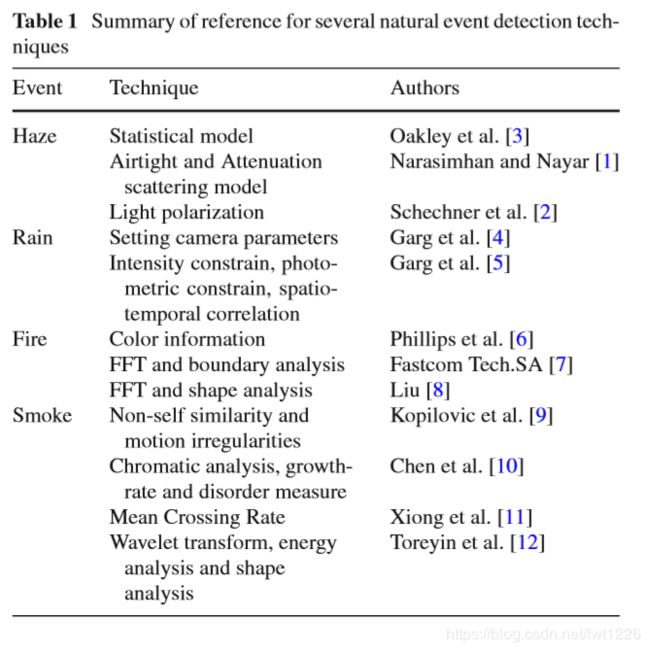

在可以直观分析的现象中,我们可以列举自然事件,如天气状况变化(由于雨、雾等)和人为因素,如火灾或不同来源的烟雾(表1)。

文献中的这些方法对天气状况的检测主要是通过两种方式来处理所分析事件的不同性质。一方面,雾和霾事件与场景恢复和色彩恢复问题相关;另一方面,雨和雪通常被作为检测和去除问题。在Narasimhan和Nayar[1]中,他们提出了一种基于大气光学的有趣方法来恢复“清晰”的图像。 “一天”的场景颜色来自两个或多个图像,在不同和未知的天气条件下会停滞。他们还开发了一种使用两个散射模型Attenuation和Airlight(由雾霾引起的散射)对三维场景结构进行深度分割和提取的方法,并提出了约束,即观察者和被观察对象都必须达到地面水平。Schechner等人[2]提出了一种从图像中去除雾霾的方法。该方法依赖于由大气散射的自然环境光被部分偏振的特性。该方法不依赖于先前关于散射模型的知识或关于照明方向的知识,而仅需要两个独立的图像。 Oakley等人[3]使用统计模型检测空中照明,在真实像素值和失真像素值之间施加线性关系。

关于由于雨水的存在而产生的视觉效果,Garg等人[13]研究了单个雨滴的外观,建立了雨滴折射和反射的光度和几何模型,假设雨滴的行为像广角镜头,尽管它是一个透明的实体,但它的亮度与背景亮度无关。在[4]中,描述了一种无需后处理且不改变场景感知的从视频中去除雨水的技术。在[5]中,作者开发了一种能够在视频序列中检测雨水的算法。雨的检测由几个步骤组成:第一步,选择在一组三个后续帧上呈现强度峰值的所有像素;第二步,使用光度约束来丢弃假阳性;第三步,计算降雨的时空相关性和方向。尽管这些方法在许多工业场景中都有一定的意义,例如露天仓库,但是火灾和烟雾探测问题无疑是至关重要的,并且是一个很难用摄像机解决的难题。

因此,我们将注意力集中在烟雾检测问题以及如何快速可靠地检测现场危险烟雾的存在上。烟雾检测的问题在一些工作中已经被解决,利用了形状随时间变化的图像中像素的局部特征或度量方法。在早期的工作中,Kopilovic等人[9]利用了烟雾的非刚性导致的运动不规则性,他们使用两个相邻的图像计算了光场,然后使用运动方向分布的熵作为关键特征来区分烟雾运动与非烟雾运动。类似地,在[14]中利用了运动,从多维时间嵌入空间中的点的聚类分析中提取局部运动。目标是跟踪像素的局部动态包络,然后使用速度分布直方图来区分烟雾和各种自然现象(例如云和被风吹倒的树木,可能导致这种包络 )。在此工作中,未考虑视频监视场景中典型的其他移动对象的存在。

最近,Chen,Yin等人[10]提出了一种基于帧差的运动分割后的像素级烟雾检测方法。像素可以用一个非常简单的基于颜色的静态判定规则初步分类为烟雾像素;它基于颜色空间中的两个阈值,假设烟雾通常显示灰色。进一步的动态决策规则依赖于烟雾的扩散属性;分割的烟雾区域周长的和与提取的烟雾像素的数量之间的比率可以给出分割的对象中的无序度的度量。类似地,其他的研究评估了可能被归类为烟雾的目标的轮廓。在[11]中,烟雾检测基于四个步骤:背景减法、闪烁提取、轮廓初始化和轮廓分类,使用关于烟雾的启发式和经验知识。

Toreyin等人[15]定义了一种有趣而稳健的方法,并在[12,16]中进一步改进。他们使用柯林斯背景减法提取运动目标[17]。然后,通过使用小波变换评估边缘和纹理变化,提供闪烁分析和湍流测量。在得到的子图像的每个块中,计算能量变化。能量由小波域中高频分量的总和给出。最后给出两个阈值来测量可接受的能量变化。用简单的三态随机马尔可夫模型(RMM)模拟变化的动态性,用烟雾和非烟雾像素进行训练。最后,如[11,10]所述,根据控制点和形状质心之间的距离,对烟雾形状的复杂性进行了分析。在给定的例子中,这种方法相当稳健,但是没有提供对不同特征贡献的精确评估。但是,在我们的实验中,我们观察到烟雾区域有时会出现强烈的形状变化和边缘复杂性。由于摄像机的视场和风向都无法在视觉上显示出来,我们避免使用此特征。

3 系统概述

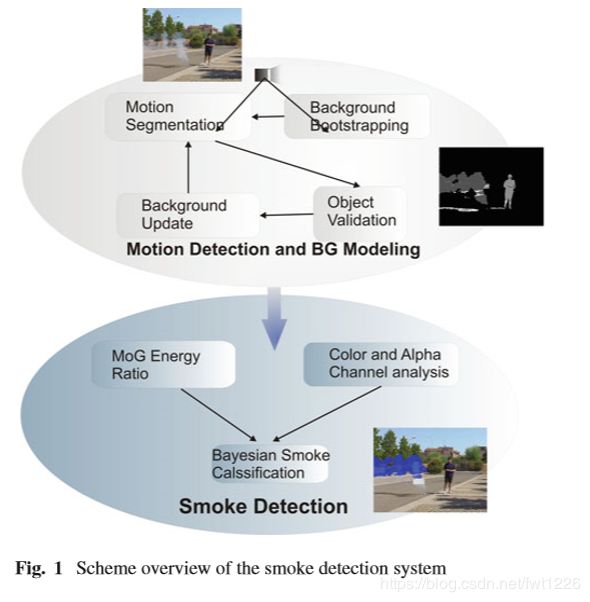

提出的系统方案如图1所示。

首先,使用鲁棒的背景模型提取运动目标,该背景模型能够在由于场景中的噪声而存在多个干扰物的情况下可靠地分割运动。特别地,预先设定的背景足够坚固,可以消除所有可能的假警报源,如阴影或小物体,这些可能会对烟雾探测系统的精度产生负面影响。然后使用小波变换系数和背景模型能量与当前输入帧之间的比率来分析图像能量。基于这个比率,使用高斯混合(MoG)的统计模型来捕获能量衰减,该能量衰减表示检测场景中可能的烟雾区域的良好提示。此外, 颜色属性用于检测参考颜色和背景模型之间发生混合的区域。这种复杂的分析将揭示可能发生烟雾事件的图像区域。最后,通过观察候选烟雾区域和运动目标遮罩之间的间隔量来检测烟雾。

论文结构如下。

第4节描述了用于检测运动物体的背景模型。

第5节描述了用于烟雾检测的特征和采用的贝叶斯分类器。

第6节详细说明了所有系统参数,并讨论了所进行的实验。

4 烟雾分割的背景模型

所采用的运动检测算法是专门设计的,以确保即使在复杂的室外场景中也能进行鲁棒和可靠的背景估计。 这是对SAKBOT系统[18]的一种改进,它增加了室外不受控制环境的鲁棒性。SAKBOT后台模型是一个基于知识的更新阶段的暂时性中间模型。这意味着被称为运动对象的图像区域不包括在背景更新阶段, 因此不被注入到中间模型中。这种更新方案确保了干净的背景和正确提取轻微移动或静态对象的能力。 [18]中对模型进行了适当修改,改进了背景初始化、运动检测和对象验证。期望的背景模型应该体现出一些重要的特性,在场景中准确地检测烟雾对象并获得高精度的结果,特别是:

—— 检测必须在夜间和白天条件下准确无误

—— 没有重影(即,由于不一致地背景更新或场景结构调整而明显移动的目标,例如一辆停着的车开走了),场景中一定存在微小目标和阴影

—— 背景必须不断更新,以应对环境变化

—— 背景不得将烟雾纳入背景模型,因此需要选择性。

由于这些原因,我们把重点放在背景引导、更新和重影消除上,以避免场景中噪声的存在,主要目的是获得清晰的斑点,用于可靠的烟雾检测。

4.1 背景引导

所有背景抑制方法的第一个问题都是背景初始化或引导,它需要既快速又准确。不幸的是,为了计算建立模型的统计数据,很多帧通常不可能有清晰的背景。因此,重要的是实现一种方法,即使从“脏”帧开 始,也能尽快初始化背景模型。

我们的方法基本上是将图像分割成块(16×16个像素),并且每当检测到块内有足够多的像素是静态的时, 选择性地用块更新背景模型。通过两个连续帧之间的阈值单个差异来评估运动。如果块中超过95%的像素被检测为不在运动中,则用这些像素 更新引导模型。当这种情况发生超过10次(即使是非连续的)时,整个块被认为是“稳定的”,并且不再被评估。一旦所有模块都设置为“稳定”,背景模型就准备好了;此外,如果在两个连续帧中没有块将它们的状态改变为“稳定”,则增加单个差异的阈值以避免死锁并加速引导。

4.2 背景更新和前景提取

一旦模型被正确初始化,背景模型就使用时间中值来更新。一个固定的k+1大小的环形缓冲器被用来收集过去每个像素的k值。除了k个值外,在时间t-1时像素(i,j)的最后一个稳定背景模型值会添加到缓冲区中,以说明最后一个可靠的背景信息,![]() 可用。然后这些n=k+1值根据它们的灰度级强度排序,并且中值被用作像素(i,j)在时间t时背景模型

可用。然后这些n=k+1值根据它们的灰度级强度排序,并且中值被用作像素(i,j)在时间t时背景模型![]() 的估计。 一旦背景模型被创建和更新,前景被提取,一帧又一帧地使用背景差分技术。在下文中,我们将把当前的背景模型称为BGt,省略了时间索引。计算当前图像It和背景模型BGt之间的差异,并提取前景掩模 Mt(i,j):

的估计。 一旦背景模型被创建和更新,前景被提取,一帧又一帧地使用背景差分技术。在下文中,我们将把当前的背景模型称为BGt,省略了时间索引。计算当前图像It和背景模型BGt之间的差异,并提取前景掩模 Mt(i,j):

![]()

其中,iT是1*3的特性向量。然后使用两个不同阈值对掩膜Mt(i,j)进行二值化:一个低阈值Tlow,用来滤除由于小强度变化而提取的噪声像素;一个高阈值Thigh,用来识别出现大强度变化的像素。这两个阈值都是局部的,即图像的每个像素都有不同的值。假设bp(i,j)是像素位置(i,j)的有序循环缓冲器b内在位置p处的值,则![]() 是中值。阈值计算为中间值周围的缓冲元素之间的加权差值:

是中值。阈值计算为中间值周围的缓冲元素之间的加权差值:

其中λ是固定的乘数,而l和h是固定的标量值。对于n=9的缓冲值,我们实验性地设置了λ=7,l=2,h=4。

很容易看出,由于向量b是有序的,Thigh总是高于或等于Tlow。我们的实验证明这些设置在大多数常见的监控场景中表现良好。采用动态每个像素阈值的原因很简单,因为使用固定的每帧阈值会使系统对局部照明变化的反应性降低。

最终的二值化运动掩模Bt由分别使用低阈值和高阈值计算的两个二值化运动掩模的组合而获得:如果像素存在于低阈值二值化掩模中,则该像素在Bt中被标记为前景,并且该像素在空间上连接到高阈值二值化掩模中的至少一个像素,然后采用两遍标记算法,从Bt中提取时间t处的运动对象列表MOVt。

列表中的每个元素都是一个候选的前景对象,并且由于过度分割而产生的小对象会根据它们的面积来显示。

4.3 对象验证

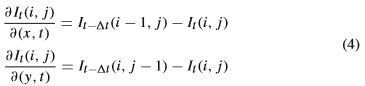

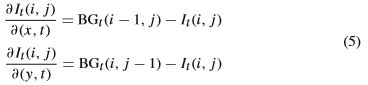

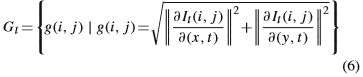

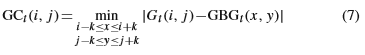

一旦提取了运动的视觉对象,就执行对象级验证步骤,以便移除场景中由小的重复运动产生的所有运动对象,例如挥动的树。这种验证是在考虑到来自物体的颜色信息和强度梯度的联合贡献的情况下进行的。 利用沿时空方向![]() 的方向导数,相对于空间和时间坐标计算梯度:

的方向导数,相对于空间和时间坐标计算梯度:

对于静止点,我们可以用背景模型BGt来近似过去的样本。

梯度模块通过使用以下等式获得:

从我们的测试中可以看出,这种梯度模块对背景中的小运动非常稳健,这主要归功于时空偏导数的使用。受到微运动影响的小运动物体,具有在空间中梯度相当恒定的特性节奏方向。此外,联合时空导数使得物体梯度计算更加精确,因为它还检测物体内部的梯度。

给定移动对象的列表MVOt,在时间t时,将梯度Gt与背景GBGt的梯度(在空间域)进行比较,以评估它们的一致性。该梯度相干性GCt在k×k像素邻域内计算,作为Gt和GBGt之间绝对值的最小值:

不幸的是,当梯度模块(Gt或GBGt)接近零时,数据是不可靠的,因此我们将梯度相干性与颜色相干性CCt相结合,以利用当前输入帧It和背景模型BGt之间的差异来加强验证:

其中|| ||表示RGB颜色空间中的范数。

总验证分数是为每个对象计算的每像素验证分数的归一化总和,通过将两个相干性度量相乘获得:

![]()

其中,分母是第i个具有运动视觉对象的区域,MVOit。验证是通过对对象的验证分别进行阈值化来获得的, 如果低于阈值,则对象被丢弃,并且其像素被标记为属于背景,在更新阶段中使用。

4.4 快速虚影抑制

当采用选择性更新方案时,虚影可能影响运动对象的提取。具体来说,每当静态对象包含在背景模型中时,就会出现虚影;随后,对象消失,导致错误的前地检测,并导致更新方案中的死锁。很明显,必须开发一种方法来检测虚影并将它们强制到背景模型中。我们的方法类似于我们用于背景引导的方法,但是是在区域级别而不是像素级别。所有经过验证的对象都用于构建一个名为“At”的图像,该图像说明了像素被单一差异检测为静态的次数:

![]()

如果出现以下情况,则有效的对象MVOit被归类为虚影:

其中Tghost是MVOi测试点被静态感测的时间量的阈值。

阈值Tghost取决于帧速率和所考虑的场景。我们设置了一个普通的监视sce-nario,帧速率为20fps, 值为200,这意味着虚影必须在它的位置上保持10秒钟,然后才能从背景中移除。

实际上,在像素属于重虚影的情况下,单个差值将低于阈值,并将开始增加At中的值。当移动的可视对象的累加器值的平均值之和超过阈值Tghost时,该对象被强制置于背景中。利用所描述的过程,该系统能够在不同的室外和室内条件下检测许多视觉对象,并且可以用作跟踪系统的第一步[19]或作为复杂对象分类应用的基础。在烟雾检测应用中,跟踪是不必要的,因为图像是分块分析的, 并且对象仅用于对可能的烟雾区域进行分类。

5 用于前景对象分类的烟雾检测

一旦有可能自动检测到不同于背景模型的运动对象,就必须分析每个感兴趣的对象以发现烟雾的存在。 该模型评估来自灰度图像能量和颜色强度衰减的共同作用,在假设烟雾在场景中生长和传播时,其图像能量由于烟雾扩散的模糊效应而衰减的情况下,将运动的视觉对象分类为可能的烟雾。

我们首先通过先前提出的运动分割算法检测可能的候选对象,然后通过使用小波变换系数评估它的时间演变来分析它们的能量。根据烟雾参考颜色模型分析对象的颜色属性,以检测场景中的颜色变化是否是由于自然变化引起的。然后将输入图像分成固定大小的块,并分别对每个块进行评估。为了进行最终分类,使用贝叶斯方法区分前景对象是否是烟雾。

5.1 使用离散小波变换的能量分析

当烟雾在场景中扩散时,它会覆盖部分背景元素。这就使使用图像能量作为发现烟雾存在的重要特征。 评估强度图像能量变化的有效方法是离散小波变换[20]。

通过将图像信号与几组滤波器进行卷积来获得小波变换,从而获得图像的多分辨率分解位置。给定输入图像It,解码位置产生四个子图像,即原始图像Ct的压缩版本、水平系数图像Ht、垂直系数图像Vt和诊断系数图像Dt。用[20]中提出的算法计算的分解示例如图2所示。

图2 离散小波变换的示例。

最左边的图像是原始图像。

正确的图像是经过转换的图像。

这些成分包括:左上压缩图像Ct,右上水平图像Ht,左下垂直图像Vt和右下对角图像Dt。

通过将图像分成固定大小的规则块bk,并对来自每个系数图像的平方贡献进行求和,来逐块评估能量:

![]()

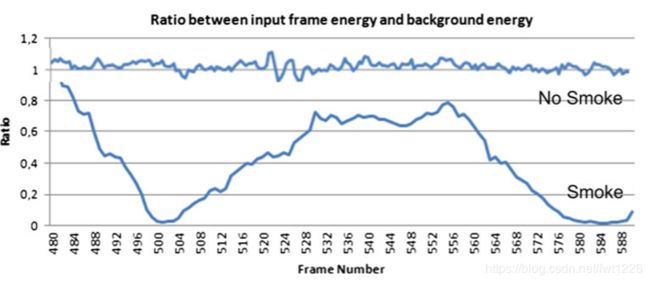

在有烟的情况下,特定块的能量值随时间显著变化,图3。

图3 非烟雾和烟雾区的能量比趋势。

在有烟的情况下,能量比值会逐渐下降。

当烟雾覆盖场景的一部分时,边缘会变得平滑,因此能量会降低。此能量下降可以通过计算当前输入帧It与背景模型BGt之一的图像能量之比rk来进一步强调。 能量比的优点是标准化能量值,并允许在不同场景之间进行比较,其中块能量本身可以显着变化。 bk块的比率为:

![]()

能量比的分析在两种不同的情况下进行,以说明全局和局部能量衰减。

公式(13)的图像能量比包含至少一个烟雾事件的多个剪辑计算;对整个图像进行计算,将每个块的能量比贡献相加,目的是在场景中存在烟雾的情况下,找到全球能量比的平均值。然后,针对所有图像和所有曲线收集能量值,并将其建模为概率分布,以正确捕获这些值的平均值和周围的变化。我们选择使用参数化方法来学习概率分布,因为分布形状不是先验可预测的。

特别地,采用Parzen窗口技术,利用高斯核从多个时间段的能量比率值计算的非参数分布中建立非参数分布。Parzen窗口方法是一种核密度估计器,它从来自一组样本X={xi|i=1,…,N}中的x计算非参数分布,近似pdf是通过对所有采样值的核求和 来计算的,使用标准高斯核函数![]() 作为核:

作为核:

除了全局能量评估之外,还会逐帧对每个块进行局部评估,以捕捉能量比的时间演变。当观察到能量下降相当长一段时间时,会发生边缘平滑过程。由于场景中光线的变化,边缘平滑过程会受到噪声的影响。 采用混合高斯模型来提高分析的鲁棒性。MoG在正确模拟多模态随机过程的变化方面有很大的优势。

为了计算高斯混合参数,每帧使用[21]中提出的在线期望最大化算法。 在线EM更新基于充分统计的概念。 如果给定统计量T(η),数据θ的条件概率分布与参数η无关,则统计量T(x)对于基础参数η就足够了。 得益于Fisher-Neyman的因式分解定理[22],x的似然函数Lη(x)可以分解为两个分量,一个独立于参数η,另一个独立于另一个依赖于足够的统计量T(x):Lη(x)= h(x)gη(T(x))。 [23]已经证明在分布软指数族(例如高斯pdf)的情况下,因式分解定理可以写为:

![]()

因此,单个高斯分布的充分统计量是:

![]()

在属于指数族的分布混合的情况下,混合参数的在线更新可以通过简单地更新混合的充分统计量来获得:

其中Tk(x)是第k个单一分布的s.s更新过程(已观察到样本(I-1)th)可通过以下方式获得:

具体地,对于图像It的每个块bk,在时间t,计算值rk (bk,It,BG)t),并且使用等式(18)更新块bk的 MoG。

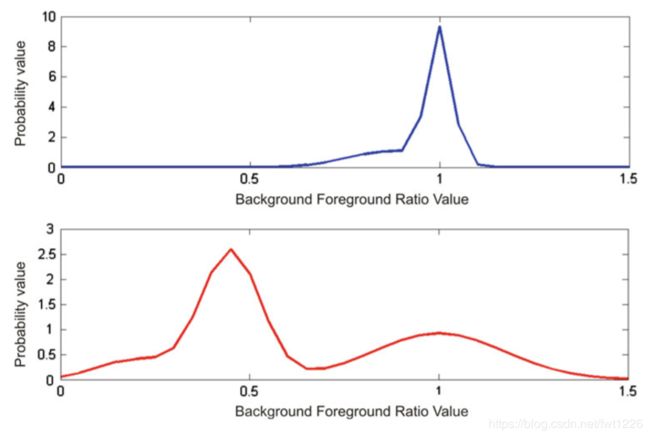

这一过程的主要优点是混合组分再加权过程能够模拟能量比的缓慢和逐渐变化。不经常出现的值被过滤掉,并被分配给混合的最不可能的高斯。这一性质有助于评价烟雾区的梯度能量降低过程,该过程在时间上具有缓慢和连续的特点,图4。

图4通过观察单个块的能量比值获得的高斯混合。

上图显示的是街区没有烟雾时的混合物。

下图显示了场景中有烟时混合物的变化。

值得注意的是,当一个街区被烟雾覆盖时,混合物成分的平均值逐渐向0移动。

读者请注意,这两个图中的轴比例因子是不同的。

为了捕捉能量比的时间变化,高斯混合模型优于隐马尔可夫模型。尽管hmm被广泛用于对时间随机过程 进行分类和建模,但是数据值序列对于获得良好的分类是至关重要的。相反,如前所述,由于噪声和自 然场景照明,块能量比受到能量值的强烈波动的影响。这一原因使得下降顺序在不同的设置中不可预测 地变化;因此,特定的能量下降时间序列会产生误导性的结果。相反,分析全球趋势很有意思。图像能 量确实是探测烟雾区域的好线索,但是由于许多不同的原因和照明变化,它可能会逐渐下降,因此必须 结合能量本身使用额外的特征来获得可靠的探测。

5.2 检测混合烟雾区域的颜色分析

当烟雾事件发生时,被烟雾覆盖的场景区域会改变其颜色属性。烟雾可以是完全不透明的,也可以是部分透明的。在前一种情况下,被覆盖的区域完全改变其颜色,而在后一种情况下 ,覆盖区域的颜色与烟雾颜色混合,如图5所示。

这个简单的观察在所有观察到的情况下都是有效的,并且直观地表现了烟雾区域颜色的线索。

所提出的模型简单地采用了基于由计算机图形启发的混合函数的评估。在RGB颜色空间中选择参考颜色模型来表示场景中烟雾的颜色。通过分析燃烧不同材料产生的不同色调来选择模型。出于解释的目的, 可以将分析集中到浅灰色模型作为图2的最左侧图像中的烟雾的情况。然后,在时间t的输入帧中的每个 像素It(i,j)对照烟雾模型和背景模型BGt进行检查,以评估参考颜色的存在,使用等式19计算混合参数bl。评估考虑了场景颜色和烟雾颜色混合在一起的情况。

![]()

其中BGt是时间t的当前背景模型,而S是烟雾参考颜色模型的RGB向量。

为了滤除误差和可能的测量误差,对每个图像块计算混合值作为块中bl值的平均值:

其中块大小是N×N。

总之,β量化了每个块在多大程度上与参考颜色模型全局共享颜色属性。

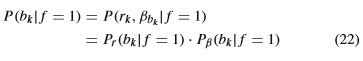

5.3 贝叶斯分类方法

在前面的小节中,已经尽可能地给出了分块能量比r和颜色混合值β用于识别场景中烟雾区域的特征。选择贝叶斯公式来识别区块bk是否可能属于烟雾区域。对于每个区块, 区块bk中烟雾存在的后验概率(事件f=1)定义为:

![]()

似然值是通过结合来自能量比的分布和颜色信息获得的,考虑到两个项在统计上是独立的,以简化处理。

由能量比衰减引起的似然贡献是通过将平均值低于所考虑的阈值的最大似然估计的加权高斯相加而获得 的,所述阈值是通过观察烟雾区域中的平均能量比值而经验计算的。

当第i个高斯平均值μi低于阈值时。 根据等式,颜色对似然值的贡献根据等式20直接计算为块颜色混合度量βbk。

![]()

使用观察到的多个包含烟雾的剪辑获得的先验知识对分类进行偏见。在当前帧中,烟雾事件的先验概率与场景的平均能量比值直接相关,并通过获得的非参数分布使用等式14来计算。

其中It由M个块组成。

如果后验概率大于0.5,则该块被认为是候选烟块。烟雾存在的测试是在前景对象分割之后执行的。对于场景中的每个分割对象,都会计算与对象的斑点相交的候选块的数量。 最后,当MVO的70%区域覆盖候选烟雾块时,将其分类为烟雾。

6 实验结果和讨论

所提出的烟雾检测系统可以与使用背景模型提供运动对象分割的任何视频监视系统结合使用。 应定期更新背景模型,但背景中不应包含烟雾区域。 这可以通过选择较慢的背景更新速率并避免更新检测到烟雾物体的背景区域来实现。 使用带有选择性更新的Stauffer[24]和Grimson背景模型以及第4节中提出的背景模型进行了测试,并比较了精度和召回率方面的结果,以证明所提出的背景可以提高烟雾检测系统的可靠性,如表2所示。

在测试过程中,所有系统参数均保持不变,以评估整个方法在许多不同场景和不同环境条件下的推广程度。该系统在室内和室外环境中的50个不同长度的片段上进行了测试,在烟雾事件期间,场景中存在诸如人或车辆之类的移动物体。每个剪辑都包含一个烟雾事件。数据集的一部分可从网站http://imagelab.ing.unimore.it/visor上公开获得。每个可能性项都经过单独评估,以衡量对系统性能的影响。

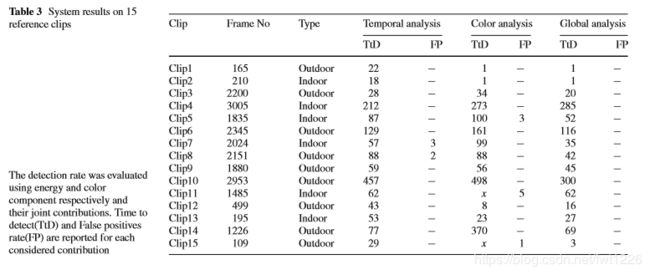

表3总结了在15个参考片段上获得的结果。

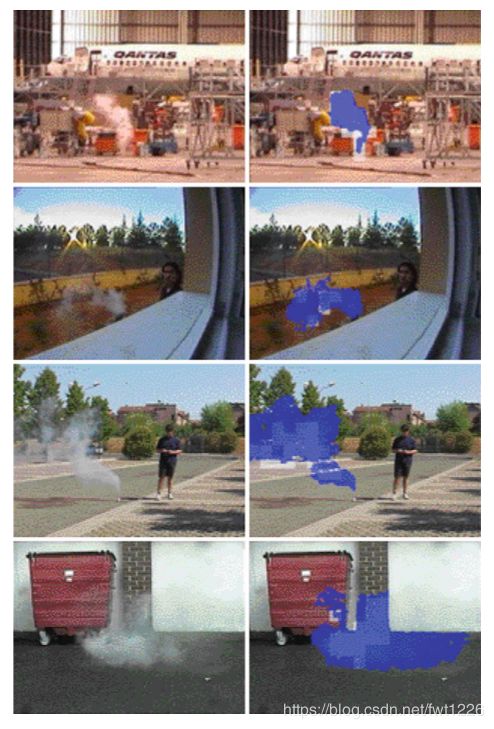

该表的第一列报告视频类型及其帧长。剪辑的平均帧速率为25fps。其余的列分别报告使用每个似然项获得的结果,最后报告整个系统的结果。报告所有测试片段发生烟雾事件后的检测时间。该表清楚地表明,在大多数观察到的病例中,由时态分析引起的似然项(方程23)是有效的。主要问题是检测时间长。这是由于用于捕获能量比衰减的基于时间的统计信息引起的。尽管由于颜色混合而产生的似然贡献具有加快检测过程的优势,但如果单独使用,往往会检测出很多假阳性。请参阅表3的第七列。通过观察表3的最后两列,我们可以指出,即使在每种可能性贡献都失败的情况下,完整的方法也足够快速和可靠。整个系统在用于测试目的的50个剪辑上的结果为,3s后发生烟雾事件的报告检测率达77%,6s后发生率为98.5%,最终10s后为100%,平均误报率为4%。图6显示了在不同条件下工作的系统的一些快照。

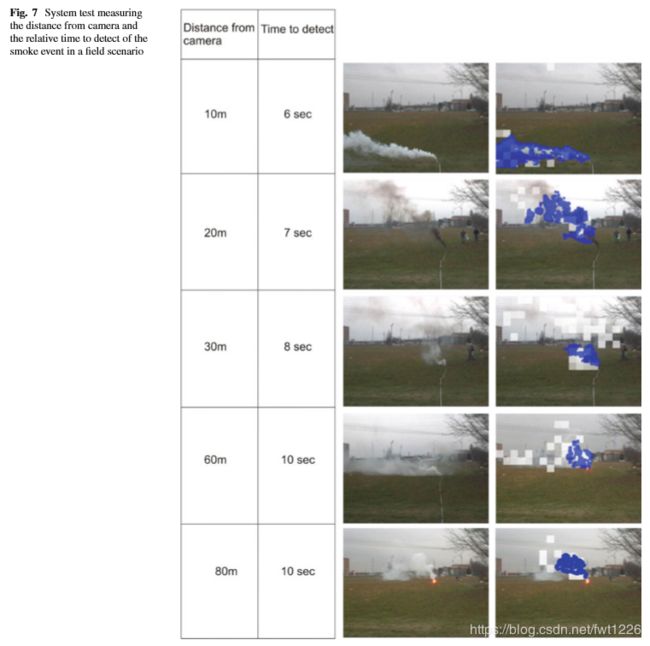

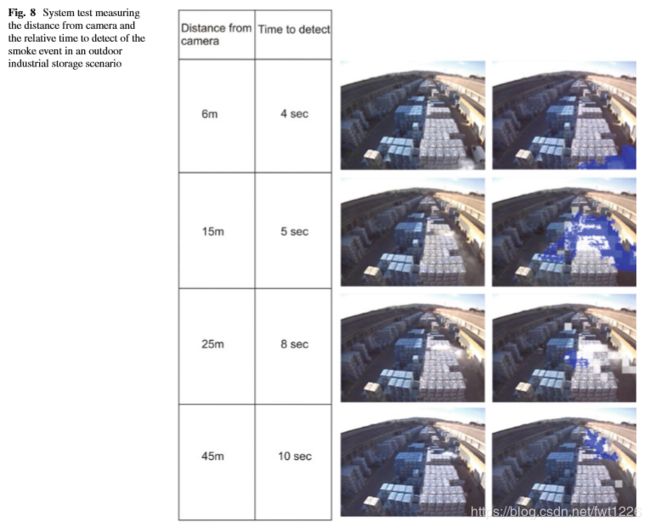

在实际条件下进行了其他实验以测试系统。特别是,在几种情况下对烟雾检测系统进行了测试,以在距摄像机不同距离处生成合成烟雾事件。首先,使用现场场景,其中没有遮挡物干扰烟雾在场景中的传播,并且检测系统的时间因烟雾事件自身产生的距离而异。图7显示了现场情况下的结果。值得注意的是,该系统具有最多10s的检测时间,并且能够在距相机90米的地方没有阻塞的情况下检测到烟雾。给出了触发警报的系统的几个快照。值得一提的是,这些测试是在不同的天数,不同的条件下进行的,并且在一周内未报告任何误报。另一测试场验证了该系统在室外工业存储场景中的适用性。为了部分解决该问题,可以将摄像机安装在足够高的杆上,以将烟气从地面上吸走足够远。这导致检测时间稍慢,但不影响系统效能。结果如图8所示。

图7 系统测试,测量与摄像机之间的距离以及在现场情况下检测烟雾事件的相对时间。

图8 系统测试,测量在室外工业存储场景中距摄像机的距离和检测烟雾事件的相对时间。

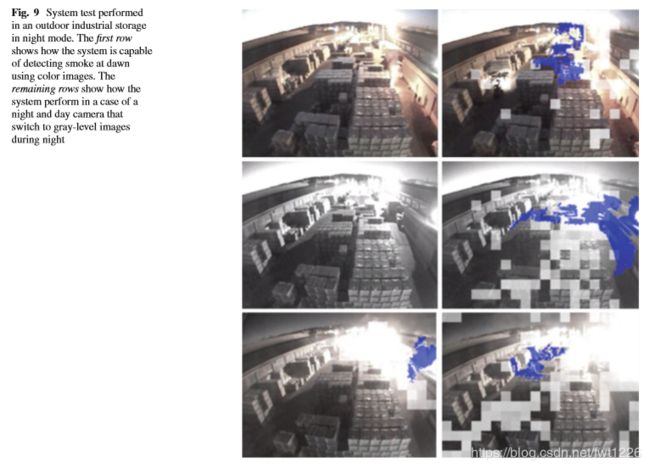

图9 系统测试是在室外工业存储中以夜间模式执行的。

第一行显示了系统如何使用彩色图像在黎明时检测烟雾。

其余各行显示了在昼夜摄像头在夜间切换为灰度图像的情况下系统的性能。

图10 系统在木质场景中进行了测试。

警报触发后,灰色块显示可能的烟雾区域,深灰色区域显示烟雾。

另外,即使在场景中存在少量照明的情况下,该系统也已在夜间条件下使用夜间和日间照相机进行了测试,如图9所示。在这种情况下,该系统在每周工作24天后,烟雾事件的检出率为100%,但平均虚假警报的数量增加了。在理想的情况下(例如现场),在室外存储情况下,白天存在的虚假警报的平均数量是每周一次,其中存在运行中的车辆,并且有几处噪声影响现场,而在理想的情况下,虚假警报的发生率是2周。在夜间检测的情况下,室外存储场景中的虚假警报数量每三天增加两个。这主要是由于前灯软车在场景中移动,使摄像机传感器饱和。这可以部分避免使用适当的前灯探测器来提高系统性能。

图10是在森林场景中进行的另一种测试活动,其中树林可能会严重阻塞烟气。在这种情况下,性能与现场情况相同,但是在最坏的情况下(80m距离),平均检测时间增加到12s。得出结论,该系统在烟雾事件和真实场景的视频剪辑上进行了几天的测试,以检测烟雾事件的准确性和可靠性(减少误报)来测试性能。在测试活动中面临许多挑战性的情况,并且在每种考虑的情况下,系统的响应都是足够的。拟议的烟雾探测完整系统可在一个摄像机在任何工作条件下(白天和黑夜)以及严重阻塞的情况下,在不到13秒的时间内探测到烟雾,从而覆盖最大80m2的区域。错误警报的数量是可以接受的,可以通过考虑夜间场景中的前灯问题来进一步改善。

7 结论

总之,我们提出了一种能够使用小波变换能量系数和图像颜色属性来检测前景对象是否冒烟的系统。 所提出的贝叶斯方法已经在公共数据上得到了广泛的评估,并且报告了检测率和检测时间的中间值。采用两种可能性的似然度测量方法解决了每个所选特征中大多数出现的问题,并大大促进了检测过程。 该系统在所有测试场景中均表现良好,并且结果非常可靠。

参考文献

1.Narasimhan Srinivasa, G., Nayar Shree, K.: Vision and the atmosphere. Int. J. Comput. Vision 48(3), 233–254 (2002)

2. Schechner Yoav, Y., Narasimhan Srinivasa, G. Nayar, Shree, K.: Polarization-based vision through haze. Appl. Opt. 42,

3 (2003) 3. Oakley, J. P., Bu, H.: Correction of simple contrast loss in color images. IEEE Trans. Image Process. 16(2), 511–522

4. Garg, K., Nayar, S.K.: When does a camera see rain? IEEE Int. Conf. Comp. Vis. (ICCV) 2, 1067–1074 (2005)

5. Garg, K., Nayar, S.K.: Detection and removal of rain from videos. In: IEEE Computer Society Conference on Computer Vision and Pattern Recognition, vol. 1, no. 1, pp. 528–535 (2004)

6. Phillips, W. III., Shah, M., Lobo, N.V.: FlameRecognition in Video. Pattern Recognit. Lett. 23(1–3), 319–327 (2002)

7. Fastcom Tech.SA, Blvd. de Grancy 19A, CH-1006 Lausanne, Switzerland: Method and device for detecting fires based on image analysis. In: Patent Coop. Treaty(PCT) Appl.No: PCT/CH02/00118, PCT Pubn.No: WO02/069292

8.Liu,C.B.,Ahuja,N.:VisionBasedFireDetection.In:Proceedings of International Conferenceon PatternR ecognition,ICPR’04,vol. 4 (2004).

9.Kopilovic,I.,Vagvolgyi,B.,Sziranyi,T.:Applicationofpanoramic annular lens for motion analysis tasks: surveillance and smoke detection. In: Proceedings of 15th International Conference on Pattern Recognition, vol. 4, pp. 714–717. IEEE, 3–7 September (2000)

10. Chen, T.-H., Yin, Y.-H., Huang, S.-F., Ye, Y.-T.: The smoke detection for early fire-alarming system base on video processing. In: International Conference on Intelligent Information Hiding and Multimedia, pp. 427–430 (2006)

11. Xiong, Z., Caballero, R., Wang, H., Finn, A., Lelic, M. A., Peng, P.: Video-based smoke detection: possibilities, techniques, and challenges suppression and detection research and applications. A Technical Working Conference (SUPDET 2007). March 5–8 Orlando, Florida (2007)

12. Toreyin, B.U., Dedeoglu, Y., Cetin, A.E., Fazekas, D., Chetverikov, T. Amiaz, N. Kiryati.: Dynamic texture detection, segmentation and analysis In: Conference On Image And Video Retrieval, pp. 131–134. ACM, New York (2007)

13. Garg, K., Nayar, S.K.: Photometric Model of a Rain Drop. TechnicalReport,DepartmentofComputerScience,ColumbiaUniversity, September 2004

14. Vicente, J., Guillemant, P.: An image processing technique for automatically detecting forest fire. Int. J.Therm.Sci.41(12), 1113– 1120 (2002)

15. Toreyin, B.U., Dedeoglu, Y., Cetin A.E.: Flame detection in video using hidden Markov models. In: IEEE International Conference on Image Processing IEEE (2005)

16. Toreyin, B.U., Dedeoglu, Y., Cetin A.E.: Wavelet based real-time smoke detection in video. In: EUSIPCO ’05 (2005)

17.Collins,R.T.,Collins,A.J.,Lipton,Kanade,T.:Asystemforvideo surveillance and monitoring. In: 8th International Topical Meeting on Robotics and Remote Systems. American Nuclear Society (1999)

18.Cucchiara,R.,Grana,C.,Piccardi,M.,Prati,A.:Detectingmoving objects,ghosts and shadows in video streams.IEEE Trans. Pattern Anal. Mach. Intell. 25(10), 1337–1342 (2003)

19. Vezzani, R., Cucchiara, R.: AD-HOC: appearance driven human tracking with occlusion handling.In:First International Workshop on Tracking Humans for the Evaluation of their Motion in Image Sequences (THEMIS’2008), Leeds, UK

20. Mallat, S.G.: A theory for multiresolution signal decomposition: the wavelet representation. IEEE Trans. Pattern Recogn. Mach. Intell. 11(7), 674–693 (1989)

21. Sato, M.: Fast learning of on-line EM algorithm. Technical Report TR-H-281, ATR Human Information Processing Research Laboratories

22. Casella, G., Berger, R.: Sattistical Inference, 2nd edn. Duxbury Press, Belmont (2002)

23. Bishop, C.: Pattern Recognition and Machine Learning. Springer, Berlin (2006)

24.Stauffer, C., Grimson, W.E.L.: Adaptive background mixture models for real-time tracking. In: Proceedings IEEE Conference on Computer Vision and Pattern Recognition. IEEE, pp. 246–252 (1999)

25.Sato, M.: Fast learning of on-line EM algorithm, Technical Report TR-H-281. ATR Human Information Processing Research Laboratories