- Polynomial regression简介

当我们在研究两个数值型变量的关系时,常常首先以其中一个变量为横坐标,另一个变量为纵坐标画一个散点图,这样可以快速直观地知道两个变量的大致关系。如果呈现较为明显的线性关系,则我们可以选择线性回归来拟合二者的关系;如果无明显直线关系,而是呈现未知的曲线关系,这时候,我们可选择使用polynomial regression来拟合两者的关系。

Polynomial regression, 中文应该是叫多项式回归,一个因变量一个预测变量(独立变量)的多项式回归模型如下公式:

polynomial_model.png

其中,X 是独立变量, beta (如果这里没有正常显示希腊字符,一定是简书markdwon出了问题了)是需要求解的系数,h 表示多项式的度。我们在用多项式回归拟合数据时,一般需要设置的参数便是上面公式中的 h,这个我不是很懂该怎么选,可能有经验的人从散点图中可以看出来选什么比较好,我就是从h=2开始尝试,依次往上增加,看哪个拟合数据最好。

- R语言实现--实例 2.1 实例数据初探

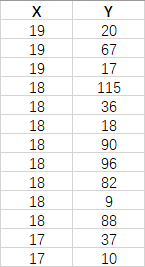

本实例也是比较简单,就是想知道变量Y跟变量X之间的关系,实例数据总共包含150个数据点,下表给出了部分数据概览:

image.png

因为X有重复值,可以当作因子先简单画个盒图(横轴是X,纵轴是Y)看看,从途中可以看到Y是随着X的增长而增长的,而且看起来也不是显著的呈线性关系。

image.png

2.2 R语言实现多项式回归拟合

虽然多项式回归用于拟合两个变量之间的非线性关系,但是,从前面公式可以看出,它对于系数 beta来说还是线性形式,所以实现起来还是当作线性来求解的。在R语言中,其也是通过线性模型函数来实现的:

dat <- read.table("input.txt",header = TRUE) fit.plm <- lm(y~poly(x,2),data = dat) # h=2 ,if h=3, then use poly(x,3)summary(fit.plm) # 查看拟合的结果

结果:

Call:lm(formula = y ~ poly(x, 2), data = dat)

Residuals:Min 1Q Median 3Q Max-35.160 -4.300 0.668 2.830 70.840

Coefficients:Estimate Std. Error t value Pr(>|t|)(Intercept) 13.453 1.117 12.043 < 2e-16 ***poly(x, 2)1 161.568 13.682 11.809 < 2e-16 ***poly(x, 2)2 88.267 13.682 6.451 1.51e-09 ***

Signif. codes: 0 ‘’ 0.001 ‘’ 0.01 ‘’ 0.05 ‘.’ 0.1 ‘ ’ 1

Residual standard error: 13.68 on 147 degrees of freedomMultiple R-squared: 0.5519, Adjusted R-squared: 0.5458F-statistic: 90.53 on 2 and 147 DF, p-value: < 2.2e-16

上面的拟合结果来看,使用2次多项式回归拟合我们的数据还比较合适。即我们使用的模型是: y = beta0 + beta1x + beta2x^2 (公式都没法被markdown解析了,大家将就下看吧,抱歉了);这里拟合的系数看上面结果的 “Coefficients” 部分,beta0 = 13.45, 对应的p-value < 2e-16; beta1 = 161.56, p-value < 2e-16;beta2 = 88.26, p-value = 1.51e-09;p-value都很显著;再看看决定系数R2(即R-squared), R2 = 0.55, 总体检验p-value<2.2e-16,(这里决定系数的解释,大家可以去谷歌查看一下线性回归分析中它的解释)。