- 机器学习是怎么一步一步由神经网络发展到今天的Transformer架构的?

yuanpan

机器学习神经网络transformer

机器学习和神经网络的发展经历了一系列重要的架构和技术阶段。以下是更全面的总结,涵盖了从早期神经网络到卷积神经网络之前的架构演变:1.早期神经网络:感知机(Perceptron)时间:1950年代末至1960年代。背景:感知机由FrankRosenblatt提出,是第一个具有学习能力的神经网络模型。它由单层神经元组成,可以用于简单的二分类任务。特点:输入层和输出层之间直接连接,没有隐藏层。使用简单的

- 常见经典目标检测算法

109702008

人工智能#深度学习目标检测人工智能

ChatGPT目标检测(ObjectDetection)是计算机视觉领域的一个重要分支,其目的是识别数字图像中的不同对象,并给出它们的位置和类别。近年来,许多经典的目标检测算法被提出并广泛应用。以下是一些常见的经典目标检测算法:1.R-CNN(RegionswithCNNfeatures):R-CNN通过使用区域提议方法(如选择性搜索)首先生成潜在的边界框,然后使用卷积神经网络(CNN)提取特征,

- 深度学习的颠覆性发展:从卷积神经网络到Transformer

AI天才研究院

AI大模型应用入门实战与进阶ChatGPT大数据人工智能语言模型AILLMJavaPython架构设计AgentRPA

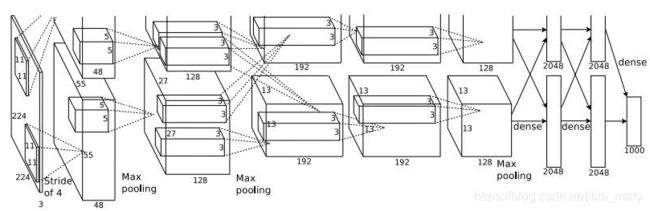

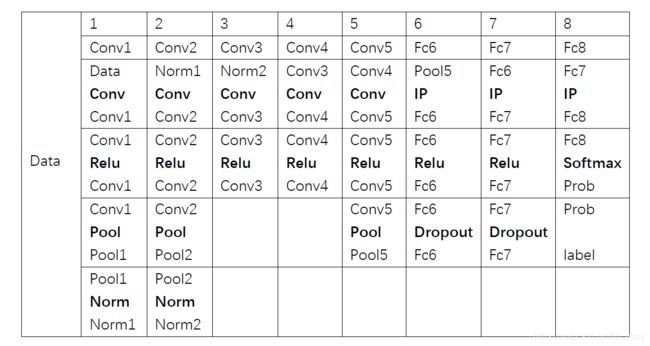

1.背景介绍深度学习是人工智能的核心技术之一,它通过模拟人类大脑中的神经网络学习从大数据中抽取知识,从而实现智能化的自动化处理。深度学习的发展历程可以分为以下几个阶段:2006年,GeoffreyHinton等人开始研究卷积神经网络(ConvolutionalNeuralNetworks,CNN),这是深度学习的第一个大突破。CNN主要应用于图像处理和语音识别等领域。2012年,AlexKrizh

- DeepLabv3+改进18:在主干网络中添加REP_BLOCK

AICurator

深度学习python机器学习deeplabv3+语义分割

【DeepLabv3+改进专栏!探索语义分割新高度】你是否在为图像分割的精度与效率发愁?本专栏重磅推出:✅独家改进策略:融合注意力机制、轻量化设计与多尺度优化✅即插即用模块:ASPP+升级、解码器PS:订阅专栏提供完整代码论文简介我们提出了一种通用的卷积神经网络(ConvNet)构建模块,可在不增加推理时间成本的情况下提升性能。该模块名为多样化分支块(DBB),通过结合不同尺度和复杂度的多样化分支

- YOLO魔改之频率分割模块(FDM)

清风AI

YOLO算法魔改系列YOLO人工智能计算机视觉目标检测python深度学习

目标检测原理目标检测是一种将目标分割和识别相结合的图像处理技术,旨在从图像中定位并识别特定目标。深度学习方法,如FasterR-CNN和YOLO系列,已成为主流解决方案。这些方法通常采用两阶段或单阶段策略,通过卷积神经网络(CNN)提取特征并进行分类和定位。在小目标检测中,为克服分辨率低和特征不明显的问题,模型设计中会特别注重特征融合和多尺度处理,以增强对小目标的感知能力。YOLOv8基础YOLO

- 目标检测YOLO实战应用案例100讲-基于毫米波雷达与摄像头协同的道路目标检测与识别(续)

林聪木

目标检测YOLO人工智能

目录3.2实测数据采集与分析3.2.1回波数据处理3.2.2毫米波雷达数据采集实验3.3基于传统图像特征的目标识别算法3.3.1基于灰度共生矩阵的时频图特征提取3.3.2支持向量机分类器3.3.3实验及结果分析3.4基于卷积神经网络的目标识别算法3.4.1卷积神经网络的基本理论3.4.2卷积神经网络框架设计3.4.3实验及结果分析基于图像的目标检测算法4.1目标检测算法一般流程4.2典型目标检测算

- 使用 TensorFlow 进行图像处理:深度解析卷积神经网络(CNN)

一碗黄焖鸡三碗米饭

人工智能前沿与实践tensorflow图像处理cnn人工智能机器学习pythonai

目录使用TensorFlow进行图像处理:深度解析卷积神经网络(CNN)1.什么是卷积神经网络(CNN)?CNN的基本结构为什么CNN适合图像处理?2.使用TensorFlow构建CNN2.1环境准备2.2加载并预处理MNIST数据集2.3构建CNN模型2.4编译和训练模型2.5评估模型3.CNN的优化与改进3.1使用数据增强3.2调整网络结构4.CNN在其他图像处理任务中的应用5.总结参考文献在

- 什么是机器视觉3D引导大模型

视觉人机器视觉

机器视觉3D3d数码相机机器人人工智能大数据

机器视觉3D引导大模型是结合深度学习、多模态数据融合与三维感知技术的智能化解决方案,旨在提升工业自动化、医疗、物流等领域的操作精度与效率。以下从技术架构、行业应用、挑战与未来趋势等方面综合分析:一、技术架构与核心原理多模态数据融合与深度学习3D视觉引导大模型通常整合RGB图像、点云数据、深度信息等多模态输入,通过深度学习算法(如卷积神经网络、Transformer)进行特征提取与融合。例如,油田机

- 深度学习五大模型:CNN、Transformer、BERT、RNN、GAN详细解析

深度学习

卷积神经网络(ConvolutionalNeuralNetwork,CNN)原理:CNN主要由卷积层、池化层和全连接层组成。卷积层通过卷积核在输入数据上进行卷积运算,提取局部特征;池化层则对特征图进行下采样,降低特征维度,同时保留主要特征;全连接层将特征图展开为一维向量,并进行分类或回归计算。CNN利用卷积操作实现局部连接和权重共享,能够自动学习数据中的空间特征。适用场景:广泛应用于图像处理相关的

- 深度学习中的Channel,通道数是什么?

%KT%

深度学习深度学习人工智能

参考文章:直观理解深度学习的卷积操作,超赞!-CSDN博客如何理解卷积神经网络中的通道(channel)_神经网络通道数-CSDN博客深度学习-卷积神经网络—卷积操作详细介绍_深度卷积的作用-CSDN博客正文:在跑深度学习代码的过程中,经常遇到的一个报错是:模型尺寸不匹配的问题。一般pytorch中尺寸/张量的表现方式是:torch.size([16,3,24,24])。这四个参数的含义如下:16

- 注意力机制+多尺度卷积

一只小小的土拨鼠

解构前沿:文献精读深度学习python人工智能YOLO深度学习

多尺度卷积先提供丰富的特征信息,注意力机制再从中筛选出关键信息,这样结合起来,不仅可以进一步提高模型的识别精度和效率,显著提升模型性能,还可以增强模型的可解释性。MPARN:multi-scalepathattentionresidualnetworkforfaultdiagnosisofrotatingmachines方法:论文介绍了一种用于旋转机械故障诊断的多尺度卷积神经网络结构,称为多尺度路

- Pytorch 小记 第八回:GoogleNet卷积神经网络模型代码

Start_Present

pytorchcnn神经网络分类python深度学习

本次小记,提供了一份基于pytorch的GoogleNet卷积神经网络模型的代码。除此之外,对代码中不容易理解的部分进行了讲解。本代码的平台是PyCharm2024.1.3,python版本3.11numpy版本是1.26.4,pytorch版本2.0.0+cu118,d2l的版本是1.0.3importnumpyasnpimporttorchfromtorchimportnnfromtorchv

- pytorch的使用:卷积神经网络模块

樱花的浪漫

pytorchcnnpytorch深度学习计算机视觉

1.读取数据分别构建训练集和测试集(验证集)DataLoader来迭代取数据使用transforms将数据转换为tensor格式#定义超参数input_size=28#图像的总尺寸28*28num_classes=10#标签的种类数num_epochs=3#训练的总循环周期batch_size=64#一个撮(批次)的大小,64张图片#训练集train_dataset=datasets.MNIST(

- 【Attention】SEAttention

shanks66

Attention各种深度学习模块人工智能深度学习python

SEAttention摘要卷积神经网络(CNNs)的核心构建模块是卷积算子,它使网络能够通过在每一层的局部感受野内融合空间和通道信息来构建有价值的特征。此前大量研究聚焦于这种关系中的空间成分,试图通过在整个特征层级中提升空间编码质量来增强CNN的表征能力。在这项工作中,我们将重点放在通道关系上,并提出一种新颖的架构单元,称为“挤压与激励”(Squeeze-and-Excitation,简称SE)模

- 【sklearn 04】DNN、CNN、RNN

@金色海岸

sklearndnncnn

DNNDNN(DeepNeuralNetworks,深度神经网络)是一种相对浅层机器学习模型具有更多参数,需要更多数据进行训练的机器学习算法CNNCNN(convolutionalNeuralNetworks,卷积神经网络)是一种从局部特征开始学习并逐渐整合的神经网络。卷积神经网络通过卷积层来进行特征提取,通过池化层进行降维,相比较全连接的神经网络,卷积神经网络降低了模型复杂度,减少了模型的参数,

- java实现卷积神经网络CNN(附带源码)

Katie。

Java实战项目java

Java实现卷积神经网络(CNN)项目详解目录项目概述1.1项目背景与意义1.2什么是卷积神经网络(CNN)1.3卷积神经网络的应用场景相关知识与理论基础2.1神经网络与深度学习概述2.2卷积操作与卷积层原理2.3激活函数与池化层2.4全连接层与损失函数2.5前向传播、反向传播与梯度下降项目需求与分析3.1项目目标3.2功能需求分析3.3性能与扩展性要求3.4异常处理与鲁棒性考虑系统设计与实现思路

- MobileNet家族:从v1到v4的架构演进与发展历程

彩旗工作室

人工智能架构人工智能机器学习cnn卷积神经网络

MobileNet是一个专为移动设备和嵌入式系统设计的轻量化卷积神经网络(CNN)家族,旨在在资源受限的环境中实现高效的图像分类、对象检测和语义分割等任务。自2017年首次推出以来,MobileNet经历了从v1到v4的多次迭代,每一代都在计算效率、模型大小和准确性上取得了显著进步。本文将详细探讨MobileNetv1、v2、v3和v4的原理、架构设计及其发展历程,并分析其关键创新和性能表现。Mo

- Vision Transformer (ViT) 详细描述及 PyTorch 代码全解析

AIGC_ZY

CVtransformerpytorch深度学习

VisionTransformer(ViT)是一种将Transformer架构应用于图像分类任务的模型。它摒弃了传统卷积神经网络(CNN)的卷积操作,而是将图像分割成patches,并将这些patches视为序列输入到Transformer编码器中。ViT的处理流程输入图像被分割成多个固定大小的patch,每个patch经过线性投影变成嵌入向量,然后加上位置编码。接着,这些嵌入向量会和类别标签(c

- YOLOv5+UI界面在车辆检测中的应用与实现

深度学习&目标检测实战项目

YOLOv5实战项目YOLOui分类数据挖掘目标跟踪人工智能

1.引言随着智能交通系统(ITS)的快速发展,车辆检测已成为计算机视觉领域的重要研究方向。车辆检测技术广泛应用于交通流量监控、车辆违章抓拍、无人驾驶等场景中。近年来,深度学习技术的突破,特别是卷积神经网络(CNN)的崛起,使得目标检测技术取得了显著进展。其中,YOLO(YouOnlyLookOnce)系列模型以其高效的实时检测能力和出色的性能成为车辆检测领域的首选方法之一。在本文中,我们将基于YO

- YOLO11改进-模块-引入多尺度差异融合模块MDFM

一勺汤

YOLOv11模型改进系列深度学习人工智能YOLOYOLOv11目标检测模块改进

遥感变化检测(RSCD)专注于识别在不同时间获取的两幅遥感图像之间发生变化的区域。近年来,卷积神经网络(CNN)在具有挑战性的RSCD任务中展现出了良好的效果。然而,这些方法未能有效地融合双时相特征,也未提取出对后续RSCD任务有益的有用信息。此外,它们在特征聚合中没有考虑多层次特征交互,并且忽略了差异特征与双时相特征之间的关系,从而影响了RSCD的结果。为解决上述问题,本文通过孪生卷积网络提取不

- YOLO优化之扫描融合模块(SimVSS Block)

清风AI

人工智能计算机视觉YOLO目标检测深度学习目标跟踪

研究背景在自动驾驶技术快速发展的背景下,目标检测作为其核心组成部分面临着严峻挑战。驾驶场景中目标尺度和大小的巨大差异,以及视觉特征不显著且易受噪声干扰的问题,对辅助驾驶系统的安全性构成了潜在威胁。传统的卷积神经网络(CNN)虽然在目标检测领域取得了显著进展,但仍存在局限性,如局部关注性导致难以有效检测不同尺度的目标。为克服这些问题,研究人员开始探索将状态空间模型(SSM)引入目标检测领域,以期提高

- 《Python深度学习》第四讲:计算机视觉中的深度学习

earthzhang2021

2025讲书课专栏python深度学习计算机视觉1024程序员节numpy算法人工智能

计算机视觉是深度学习中最酷的应用之一,它让计算机能够像人类一样“看”和理解图像。想象一下,计算机可以自动识别照片中的物体、人脸,甚至可以读懂交通标志。这一切听起来是不是很神奇?其实,这一切都离不开深度学习中的卷积神经网络(CNN)。今天,我们就来深入了解一下CNN是如何工作的。5.1卷积神经网络简介先来看下卷积神经网络(CNN)是什么。CNN是一种专门用于处理图像数据的神经网络。它的灵感来源于人类

- 人工智能概念

zhangpeng455547940

计算机人工智能

机器学习、深度学习、大模型机器学习提供框架,使得系统可以从数据中学习算法:线性回归、逻辑回归、支持向量机、决策树、随机森林、K近邻算法深度学习是实现这一目标的工具,模仿人脑,使用多层神经网络进行学习算法:多层感知器、卷积神经网络、循环神经网络、长短期记忆网络大模型指参数量巨大的深度学习模型人工智能应用:自然语言处理、图像识别与生成、语音识别、政务与企业服务...

- 卷积神经网络可视化

天行者@

cnn人工智能神经网络

卷积神经网络(CNN)的可视化是理解模型行为、调试性能和解释预测结果的重要工具。以下从技术原理、实现方法和应用场景三个维度,系统梳理CNN可视化的核心技术,并提供代码示例和前沿方向分析:一、CNN可视化的核心维度1.卷积核可视化原理:提取卷积层的权重,将其转换为图像形式,观察滤波器学习到的模式。实现步骤:提取卷积层权重(形状为[out_channels,in_channels,kernel_siz

- 基于YOLOv5的车牌识别系统:从数据集到UI界面的实现

深度学习&目标检测实战项目

YOLOv5实战项目YOLOui分类数据挖掘目标跟踪

1.引言随着智能交通系统的发展,车牌识别技术已成为交通管理、停车场自动化、路面监控等应用中的关键技术之一。车牌识别系统(LicensePlateRecognition,LPR)主要用于识别车辆的车牌号码,并将其转化为可以进一步处理的数据。车牌识别系统通常由图像处理、字符识别、目标检测等多种技术组成。近年来,随着深度学习技术的飞速发展,基于卷积神经网络(CNN)的目标检测算法,如YOLO(YouOn

- 卷积神经网络中的卷积操作

m0_61360701

深度学习cnn深度学习人工智能

1.什么是卷积操作?在卷积神经网络(CNN)中,卷积操作是一种数学运算,它的目的是从图像(或其他数据)中提取局部特征。简单来说,卷积就像是用一个小的“扫描仪”在图像上滑动,每次扫描一小块区域,并从中提取有用的信息。2.卷积操作的类比:印章想象你有一张纸和一个印章。印章是一个小的图案,比如一个简单的形状(圆形、方形等)。当你把印章按在纸上时,印章会与纸上的内容接触,并留下一个印记。然后你移动印章,重

- 卷积神经网络(CNN)详解:从原理到应用的全景解析

彩旗工作室

人工智能cnn人工智能神经网络卷积神经网络

一、定义与核心特征卷积神经网络(ConvolutionalNeuralNetwork,CNN)是一种专为处理网格状数据(如图像、视频)设计的深度前馈神经网络,其核心特征包括:局部连接:卷积层神经元仅与输入数据的局部区域连接,减少参数数量;权重共享:同一卷积核在整个输入数据上滑动,增强平移不变性;层级特征提取:从低级特征(边缘、纹理)到高级特征(物体部件)的逐层抽象。二、历史演进与关键突破1960年

- backbone和head分开转onnx的优势

yuweififi

人工智能深度学习机器学习

模型转换为ONNX格式时,将其分成backbone和head两个部分,通常是出于以下原因:1.模块化设计backbone通常是模型的特征提取部分(例如卷积神经网络的主干部分),负责从输入数据中提取高级特征。head是模型的输出部分,负责根据backbone提取的特征生成最终的预测结果(例如分类、检测、分割等)。将模型分成两部分可以实现模块化设计,便于在不同任务中复用backbone或head。例如

- LeNet-5卷积神经网络详解

LChuck

深度学习人工智能神经网络深度学习数据结构计算机视觉AIGC

LeNet-5卷积神经网络详解1.历史背景LeNet-5是由YannLeCun等人在1998年提出的一种卷积神经网络架构,是深度学习领域的一个重要里程碑。这个网络最初是为了解决手写数字识别问题而设计的,在当时取得了突破性的成果。它的成功不仅证明了卷积神经网络在计算机视觉任务中的有效性,更为后来深度学习的发展奠定了重要基础。图1:LeNet-5网络结构示意图2.网络结构LeNet-5的结构非常优雅且

- 计算机视觉深度学习入门(4)

yyc_audio

计算机视觉人工智能计算机视觉深度学习神经网络

在小型数据集上从头开始训练一个卷积神经网络利用少量数据来训练图像分类模型,这是一种很常见的情况。如果你从事与计算机视觉相关的职业,那么很可能会在实践中遇到这种情况。“少量”样本既可能是几百张图片,也可能是上万张图片。我们来看一个实例——猫狗图片分类,数据集包含5000张猫和狗的图片(2500张猫的图片,2500张狗的图片)。我们将2000张图片用于训练,1000张用于验证,2000张用于测试。将介

- 对于规范和实现,你会混淆吗?

yangshangchuan

HotSpot

昨晚和朋友聊天,喝了点咖啡,由于我经常喝茶,很长时间没喝咖啡了,所以失眠了,于是起床读JVM规范,读完后在朋友圈发了一条信息:

JVM Run-Time Data Areas:The Java Virtual Machine defines various run-time data areas that are used during execution of a program. So

- android 网络

百合不是茶

网络

android的网络编程和java的一样没什么好分析的都是一些死的照着写就可以了,所以记录下来 方便查找 , 服务器使用的是TomCat

服务器代码; servlet的使用需要在xml中注册

package servlet;

import java.io.IOException;

import java.util.Arr

- [读书笔记]读法拉第传

comsci

读书笔记

1831年的时候,一年可以赚到1000英镑的人..应该很少的...

要成为一个科学家,没有足够的资金支持,很多实验都无法完成

但是当钱赚够了以后....就不能够一直在商业和市场中徘徊......

- 随机数的产生

沐刃青蛟

随机数

c++中阐述随机数的方法有两种:

一是产生假随机数(不管操作多少次,所产生的数都不会改变)

这类随机数是使用了默认的种子值产生的,所以每次都是一样的。

//默认种子

for (int i = 0; i < 5; i++)

{

cout<<

- PHP检测函数所在的文件名

IT独行者

PHP函数

很简单的功能,用到PHP中的反射机制,具体使用的是ReflectionFunction类,可以获取指定函数所在PHP脚本中的具体位置。 创建引用脚本。

代码:

[php]

view plain

copy

// Filename: functions.php

<?php&nbs

- 银行各系统功能简介

文强chu

金融

银行各系统功能简介 业务系统 核心业务系统 业务功能包括:总账管理、卡系统管理、客户信息管理、额度控管、存款、贷款、资金业务、国际结算、支付结算、对外接口等 清分清算系统 以清算日期为准,将账务类交易、非账务类交易的手续费、代理费、网络服务费等相关费用,按费用类型计算应收、应付金额,经过清算人员确认后上送核心系统完成结算的过程 国际结算系

- Python学习1(pip django 安装以及第一个project)

小桔子

pythondjangopip

最近开始学习python,要安装个pip的工具。听说这个工具很强大,安装了它,在安装第三方工具的话so easy!然后也下载了,按照别人给的教程开始安装,奶奶的怎么也安装不上!

第一步:官方下载pip-1.5.6.tar.gz, https://pypi.python.org/pypi/pip easy!

第二部:解压这个压缩文件,会看到一个setup.p

- php 数组

aichenglong

PHP排序数组循环多维数组

1 php中的创建数组

$product = array('tires','oil','spark');//array()实际上是语言结构而不 是函数

2 如果需要创建一个升序的排列的数字保存在一个数组中,可以使用range()函数来自动创建数组

$numbers=range(1,10)//1 2 3 4 5 6 7 8 9 10

$numbers=range(1,10,

- 安装python2.7

AILIKES

python

安装python2.7

1、下载可从 http://www.python.org/进行下载#wget https://www.python.org/ftp/python/2.7.10/Python-2.7.10.tgz

2、复制解压

#mkdir -p /opt/usr/python

#cp /opt/soft/Python-2

- java异常的处理探讨

百合不是茶

JAVA异常

//java异常

/*

1,了解java 中的异常处理机制,有三种操作

a,声明异常

b,抛出异常

c,捕获异常

2,学会使用try-catch-finally来处理异常

3,学会如何声明异常和抛出异常

4,学会创建自己的异常

*/

//2,学会使用try-catch-finally来处理异常

- getElementsByName实例

bijian1013

element

实例1:

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd">

<html xmlns="http://www.w3.org/1999/x

- 探索JUnit4扩展:Runner

bijian1013

java单元测试JUnit

参加敏捷培训时,教练提到Junit4的Runner和Rule,于是特上网查一下,发现很多都讲的太理论,或者是举的例子实在是太牵强。多搜索了几下,搜索到两篇我觉得写的非常好的文章。

文章地址:http://www.blogjava.net/jiangshachina/archive/20

- [MongoDB学习笔记二]MongoDB副本集

bit1129

mongodb

1. 副本集的特性

1)一台主服务器(Primary),多台从服务器(Secondary)

2)Primary挂了之后,从服务器自动完成从它们之中选举一台服务器作为主服务器,继续工作,这就解决了单点故障,因此,在这种情况下,MongoDB集群能够继续工作

3)挂了的主服务器恢复到集群中只能以Secondary服务器的角色加入进来

2

- 【Spark八十一】Hive in the spark assembly

bit1129

assembly

Spark SQL supports most commonly used features of HiveQL. However, different HiveQL statements are executed in different manners:

1. DDL statements (e.g. CREATE TABLE, DROP TABLE, etc.)

- Nginx问题定位之监控进程异常退出

ronin47

nginx在运行过程中是否稳定,是否有异常退出过?这里总结几项平时会用到的小技巧。

1. 在error.log中查看是否有signal项,如果有,看看signal是多少。

比如,这是一个异常退出的情况:

$grep signal error.log

2012/12/24 16:39:56 [alert] 13661#0: worker process 13666 exited on s

- No grammar constraints (DTD or XML schema).....两种解决方法

byalias

xml

方法一:常用方法 关闭XML验证

工具栏:windows => preferences => xml => xml files => validation => Indicate when no grammar is specified:选择Ignore即可。

方法二:(个人推荐)

添加 内容如下

<?xml version=

- Netty源码学习-DefaultChannelPipeline

bylijinnan

netty

package com.ljn.channel;

/**

* ChannelPipeline采用的是Intercepting Filter 模式

* 但由于用到两个双向链表和内部类,这个模式看起来不是那么明显,需要仔细查看调用过程才发现

*

* 下面对ChannelPipeline作一个模拟,只模拟关键代码:

*/

public class Pipeline {

- MYSQL数据库常用备份及恢复语句

chicony

mysql

备份MySQL数据库的命令,可以加选不同的参数选项来实现不同格式的要求。

mysqldump -h主机 -u用户名 -p密码 数据库名 > 文件

备份MySQL数据库为带删除表的格式,能够让该备份覆盖已有数据库而不需要手动删除原有数据库。

mysqldump -–add-drop-table -uusername -ppassword databasename > ba

- 小白谈谈云计算--基于Google三大论文

CrazyMizzz

Google云计算GFS

之前在没有接触到云计算之前,只是对云计算有一点点模糊的概念,觉得这是一个很高大上的东西,似乎离我们大一的还很远。后来有机会上了一节云计算的普及课程吧,并且在之前的一周里拜读了谷歌三大论文。不敢说理解,至少囫囵吞枣啃下了一大堆看不明白的理论。现在就简单聊聊我对于云计算的了解。

我先说说GFS

&n

- hadoop 平衡空间设置方法

daizj

hadoopbalancer

在hdfs-site.xml中增加设置balance的带宽,默认只有1M:

<property>

<name>dfs.balance.bandwidthPerSec</name>

<value>10485760</value>

<description&g

- Eclipse程序员要掌握的常用快捷键

dcj3sjt126com

编程

判断一个人的编程水平,就看他用键盘多,还是鼠标多。用键盘一是为了输入代码(当然了,也包括注释),再有就是熟练使用快捷键。 曾有人在豆瓣评

《卓有成效的程序员》:“人有多大懒,才有多大闲”。之前我整理了一个

程序员图书列表,目的也就是通过读书,让程序员变懒。 程序员作为特殊的群体,有的人可以这么懒,懒到事情都交给机器去做,而有的人又可以那么勤奋,每天都孜孜不倦得

- Android学习之路

dcj3sjt126com

Android学习

转自:http://blog.csdn.net/ryantang03/article/details/6901459

以前有J2EE基础,接触JAVA也有两三年的时间了,上手Android并不困难,思维上稍微转变一下就可以很快适应。以前做的都是WEB项目,现今体验移动终端项目,让我越来越觉得移动互联网应用是未来的主宰。

下面说说我学习Android的感受,我学Android首先是看MARS的视

- java 遍历Map的四种方法

eksliang

javaHashMapjava 遍历Map的四种方法

转载请出自出处:

http://eksliang.iteye.com/blog/2059996

package com.ickes;

import java.util.HashMap;

import java.util.Iterator;

import java.util.Map;

import java.util.Map.Entry;

/**

* 遍历Map的四种方式

- 【精典】数据库相关相关

gengzg

数据库

package C3P0;

import java.sql.Connection;

import java.sql.SQLException;

import java.beans.PropertyVetoException;

import com.mchange.v2.c3p0.ComboPooledDataSource;

public class DBPool{

- 自动补全

huyana_town

自动补全

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd"><html xmlns="http://www.w3.org/1999/xhtml&quo

- jquery在线预览PDF文件,打开PDF文件

天梯梦

jquery

最主要的是使用到了一个jquery的插件jquery.media.js,使用这个插件就很容易实现了。

核心代码

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.

- ViewPager刷新单个页面的方法

lovelease

androidviewpagertag刷新

使用ViewPager做滑动切换图片的效果时,如果图片是从网络下载的,那么再子线程中下载完图片时我们会使用handler通知UI线程,然后UI线程就可以调用mViewPager.getAdapter().notifyDataSetChanged()进行页面的刷新,但是viewpager不同于listview,你会发现单纯的调用notifyDataSetChanged()并不能刷新页面

- 利用按位取反(~)从复合枚举值里清除枚举值

草料场

enum

以 C# 中的 System.Drawing.FontStyle 为例。

如果需要同时有多种效果,

如:“粗体”和“下划线”的效果,可以用按位或(|)

FontStyle style = FontStyle.Bold | FontStyle.Underline;

如果需要去除 style 里的某一种效果,

- Linux系统新手学习的11点建议

刘星宇

编程工作linux脚本

随着Linux应用的扩展许多朋友开始接触Linux,根据学习Windwos的经验往往有一些茫然的感觉:不知从何处开始学起。这里介绍学习Linux的一些建议。

一、从基础开始:常常有些朋友在Linux论坛问一些问题,不过,其中大多数的问题都是很基础的。例如:为什么我使用一个命令的时候,系统告诉我找不到该目录,我要如何限制使用者的权限等问题,这些问题其实都不是很难的,只要了解了 Linu

- hibernate dao层应用之HibernateDaoSupport二次封装

wangzhezichuan

DAOHibernate

/**

* <p>方法描述:sql语句查询 返回List<Class> </p>

* <p>方法备注: Class 只能是自定义类 </p>

* @param calzz

* @param sql

* @return

* <p>创建人:王川</p>

* <p>创建时间:Jul