资源 | 斯坦福最新NLP课程上线,选择PyTorch放弃TensorFlow

整理 | Jane

出品 | AI科技大本营

今天在斯坦福大学 2019 年冬季 CS224n 最新课程已经正式更新到官网啦。新一年,大家可以开始跟着名校课程学起来啦~今年一个非常大的变化就是所有内容实现都使用 PyTorch,不再使用 TensorFlow。内容设计方面新增了 Transformers、Subword Models、Human Language 等内容。

下面,营长就先从课程简介、需要哪些知识储备、往年课程回顾等几个重要内容为大家介绍一下~

关于 CS224n

近年来,深度学习方法在不同的 NLP 任务中都有着很好的表现,NLP 技术的应用也越来越多。在本课程中,大家可以深入了解深度学习在 NLP 中的前沿研究与最新进展。通过学术讲座、定期作业和最终项目,大家可以学习到设计、部署神经网络所必备的技能,并且深入理解神经网络。与往年不同,今年的课程选择使用 PyTorch,不再使用 TensorFlow 了。

前期知识准备

1.Python:在课程中肯定离不开 Numpy 和 Pytorch,所以对 Python 和 Numpy 不熟悉的同学们,要赶紧学习一下了。当然,如果掌握其他的编程语言,如 C、C++、Java、JS 或 Matlab 等,也会有所帮助。

补习 Python 和 Numpy:

http://cs231n.github.io/python-numpy-tutorial/

2.数学基础:微积分和线性代数;掌握矩阵、向量符号运算等。

3.概率论与数理统计基础:了解概率论的基础知识,如高斯分布、均值、标准差等。

4.机器学习基础知识:有一定的机器学习或深度学习知识,在课程学习中肯定有所帮助。不过没有基础的同学也不用气馁,只要你想学,现在学习资源很多,只要想学还是可以掌握一定的基础内容的。

课程信息

1.讲座:每周二、周四 下午 4:30--5:50

2.授课讲师:

3.每周课程内容

营长列出了官网给出的每周上课的主要内容,同时也给出了一些推荐阅读,营长每年看到这些课程和推荐阅读的时候,都真心感慨,“唉,这一年想好好学习,真心压力不小啊!”

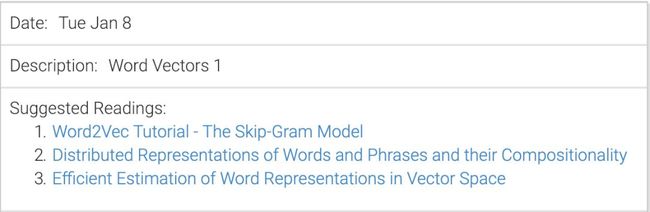

第 1 周(1 月 8 日、周二):词向量 1

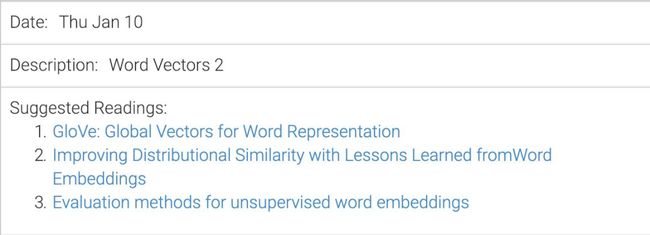

第 2 周(1 月 10 日、周二):词向量 2

第 3 周(1 月 15 日、周二):反向传播

第 4 周(1 月 17 日、周四):神经网络

第 5 周(1 月 22 日、周二):依存性解析

第 6 周(1 月 24 日、周四):RNN 网络和语言模型

第 7 周(1 月 29 日、周二):梯度消失与 RNNs 变式

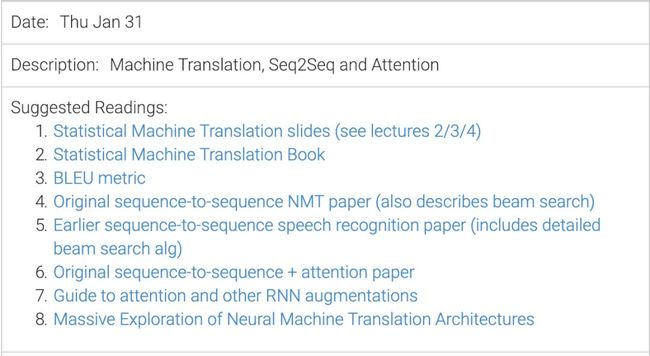

第 8 周(1 月 31 日、周四):机器翻译、 Seq2Seq 模型与注意力机制

第 9 周(2 月 5 日、周二):终期项目实践技巧

第 10 周(2 月 7 日、周四):确定终期项目

第 11 周(2 月 12 日、周二):NLP 的 ConvNets

第 12 周(2 月 14 日、周四):Subword 模型

第 13 周(2 月 19 日、周二):语境表征和预训练

第 14 周(2 月 21 日、周四):Transformer 模型

第 15 周(2 月 26 日、周二):NLG

第 16 周(2 月 28 日、周四):指代消解

第 17 周(3 月 5 日、周二):树循环网络与选区解析

第 18 周(3 月 7 日、周四):TBD

第 19 周(3 月 12 日、周二):安全、偏见与公平等问题

第 20 周(3 月 14 日、周四):NLP、深度学习的未来

4.福利

下面这些学习资料都可以在线免费阅读!这些书籍、PPT 都可以在大家学习过程中起到作用:

- https://web.stanford.edu/class/archive/cs/cs224n/cs224n.1184/syllabus.html

- https://web.stanford.edu/~jurafsky/slp3/

- https://github.com/jacobeisenstein/gt-nlp-class/blob/master/notes/eisenstein-nlp-notes.pdf

- http://u.cs.biu.ac.il/~yogo/nnlp.pdf

- http://www.deeplearningbook.org/

如果没有神经网络或者深度学习基础或者背景,可以先从下面这两本书入门:

- http://neuralnetworksanddeeplearning.com/

- https://mitpress.mit.edu/books/introduction-deep-learning

往年课程资源

斯坦福大学 2019 年冬季课程 CS 224n 最初开设于 2017 年,由 CS224n(Natural Language Processing) 和 CS 224d(Natural Language Processing with Deep Learning)两门课程合并。在课程官网上,还可以看到给出的往年课程资源,大家可以到课程主页上找到很多学习资料哦~

2018 年冬季课程、报告:

https://web.stanford.edu/class/archive/cs/cs224n/cs224n.1184/

https://web.stanford.edu/class/archive/cs/cs224n/cs224n.1184/reports.html

2017 年冬季课程、报告:

https://web.stanford.edu/class/archive/cs/cs224n/cs224n.1174/

https://web.stanford.edu/class/archive/cs/cs224n/cs224n.1174/reports.html

更早之前的课程:

http://cs224d.stanford.edu/reports_2016.html

https://web.stanford.edu/class/archive/cs/cs224n/cs224n.1162/

https://web.stanford.edu/class/archive/cs/cs224n/cs224n.1184/

(原文)2019 年最新课程全介绍:

http://web.stanford.edu/class/cs224n/

(*本文由AI科技大本营整理,转载请联系微信1092722531)