- python中beautifulsoup怎么安装_Python3爬虫中Beautiful Soup库的安装方法是什么

柳虎璐

Python3BeautifulSoup安装教程lxml爬虫

Python3爬虫中BeautifulSoup库的安装方法是什么发布时间:2020-08-0517:38:09来源:亿速云阅读:70作者:小新这篇文章将为大家详细讲解有关Python3爬虫中BeautifulSoup库的安装方法是什么,小编觉得挺实用的,因此分享给大家做个参考,希望大家阅读完这篇文章后可以有所收获。BeautifulSoup是Python的一个HTML或XML的解析库,我们可以用它

- python3.8安装lxml库,Python3爬虫利器之lxml解析库的安装

Intopia

lxml是Python的一个解析库,支持HTML和XML的解析,支持XPath解析方式,而且解析效率非常高。本节中,我们了解一下lxml的安装方式,这主要从Windows、Linux和Mac三大平台来介绍。1.相关链接官方网站:http://lxml.deGitHub:https://github.com/lxml/lxmlPyPI:https://pypi.python.org/pypi/lxm

- 【Python3爬虫】Scrapy入门教程

TM0831

Python3爬虫Python3网络爬虫

Python版本:3.5系统:Windows一、准备工作需要先安装几个库(pip,lxml,pywin32,Twisted,pyOpenSSL),这些都比较容易,如果使用的是Pycharm,就可以更方便的安装模块,在settings里可以选择版本进行下载。如果在命令行模式下输入pip-V出现'pip'不是内部或外部命令,也不是可运行的程序或批处理文件,先确保自己在环境变量中配置E:\Python3

- python3爬虫——贴吧实战

没耕过田的牛

爬虫python

初学者之贴吧爬虫一、思路二、步骤1.引入库2.载入网页数据3.分析结构提取信息4.将结果写入txt文件中三、封装四、总结一、思路明确目的及需求,以剑来吧为例。本次实例练习准备爬取“剑来吧”每个帖子的标题、帖子链接、发帖作者、发帖时间、回帖数量,那么拿到网页,二话不说先进入开发者模式先观察html文档结构——找规律。因为直接在网页源码上看很难看出结构特征,可以将源码粘贴到工作区排版后再进一步观察,很

- python3爬虫--入门篇3--url去重策略

布口袋_天晴了

1.访问过的url保存到数据库中[频繁存取,时间消耗高]2.将访问过的url保存到set中,只需要o(1)的代价[内存的占用量会较高]3.url经过md5等哈希后保存到set中。[Scrapy默认采用md5方法压缩url的,内存占用会大大减小]4.用bitmap方法,将访问过的url通过hash函数映射到某一位[压缩更多,极大节省内存,但哈希冲突的可能性还是比较大]5.bloomfilter方法对

- python爬虫ajax请求_Python3爬虫中关于Ajax分析方法的总结

weixin_39951378

python爬虫ajax请求

这里还以前面的微博为例,我们知道拖动刷新的内容由Ajax加载,而且页面的URL没有变化,那么应该到哪里去查看这些Ajax请求呢?1.查看请求这里还需要借助浏览器的开发者工具,下面以Chrome浏览器为例来介绍。首先,用Chrome浏览器打开微博的链接https://m.weibo.cn/u/2830678474,随后在页面中点击鼠标右键,从弹出的快捷菜单中选择“检查”选项,此时便会弹出开发者工具,

- Python3爬虫教程基础篇之二:网络库Reqeusts详解(上)

小天真_5eeb

Requests是什么Requests是KennethReitz编写的一个优雅、易用的HTTP库。Requests的底层基于Python官方库urllib,但Requets良好的API设计更适合人类使用。Requests的核心类Requests最核心的两个类,一个是request(对HTTP请求的分装),另一个是response(对HTTP返回结果的封装)。简单来说,一次HTTP请求,其实就是:构

- Python进阶--下载想要的格言(基于格言网的Python爬虫程序)

在猴站学算法

python开发语言爬虫

注:由于上篇帖子(Python进阶--爬取下载人生格言(基于格言网的Python3爬虫)-CSDN博客)篇幅长度的限制,此篇帖子对上篇做一个拓展延伸。目录一、爬取格言网中想要内容的url1、找到想要的内容2、抓包分析,找到想要内容的url3、改写爬虫代码二、输入想要的内容即可下载到本地1、抓包分析2、具备上一页和下一页的正常目录页下载内容代码3、只具备下一页的非正常目录页下载内容代码4、针对以上情

- Python进阶--爬取下载人生格言(基于格言网的Python3爬虫)

在猴站学算法

python开发语言爬虫

目录一、此处需要安装第三方库:二、抓包分析及Python代码1、打开人生格言网(人生格言-人生格言大全_格言网)进行抓包分析2、请求模块的代码3、抓包分析人生格言界面4、获取各种类型的人生格言链接5、获取下一页的链接6、获取人生格言的具体内容7、下载保存三、所有代码及具体步骤1、具体步骤2、所有代码如下:3、运行结果一、此处需要安装第三方库:在Pycharm平台终端或者命令提示符窗口中输入以下代码

- PYthon进阶--网页采集器(基于百度搜索的Python3爬虫程序)

在猴站学算法

python百度爬虫

简介:基于百度搜索引擎的PYthon3爬虫程序的网页采集器,小白和爬虫学习者都可以学会。运行爬虫程序,输入关键词,即可将所搜出来的网页内容保存在本地。知识点:requests模块的get方法一、此处需要安装第三方库requests:在Pycharm平台终端或者命令提示符窗口中输入以下代码即可安装pipinstallrequests二、抓包分析及编写Python代码1、打开百度搜索进行抓包分析打开百

- Python3爬虫学习——requests库笔记

甲寅Emore

Python学习笔记Python3爬虫笔记爬虫学习python

Python3爬虫学习——requests库笔记前言本笔记用于记录整理requests库的一些基本知识,内容会根据博主自己的认知作增添或压缩。其实自己看了下之前写的urllib库笔记,觉得那么写万字长文并不妥当,没有起到快速查阅的笔记作用,所以这次做了点改变。另外就是requests库的官方文档的中文味儿太冲了,比如Requests唯一的一个非转基因的PythonHTTP库,人类可以安全享用。警告

- python3爬虫验证码识别——超级鹰打码平台的使用&实战:识别古诗文网登录页面中的验证码

小小白学计算机

python网络爬虫python打码平台的使用爬虫验证码识别超级鹰

一、验证码和爬虫之间的爱恨情仇?反爬机制:验证码.识别验证码图片中的数据,用于模拟登陆操作。二、识别验证码的操作:人工肉眼识别。(不推荐)第三方自动识别(推荐)-超级鹰打码:https://www.chaojiying.com/超级鹰打码平台的使用流程:1.注册:2.登录:查询该用户是否还有剩余的题分创建一个软件:超级鹰首页>用户中心>软件ID>生成一个软件ID>录入软件名称>提交(软件id和秘钥

- scrapy爬取58同城租房信息(第一节)

Houtasu

本节主要讲解爬虫思路目标网址:https://cd.58.com/chuzu/0/目标数据:个人房源中的所有页面的信息具体为下图中的第一行描述,第二行房屋类型及大小,第三行的所在区域及详细地址,第四行的出租人,以及右边的价格,左边的图片链接。image.png存储方式:mongoDB,并通过mongoExport.exe导出为csv文件。首先f12查看审查元素,可以看到这些房源信息都是直接在ul列

- python3爬虫(5):财务报表爬取入库

哲学的天空

8

转载请注明作者和出处:http://blog.csdn.net/c406495762Github代码获取:https://github.com/Jack-Cherish/python-spider知乎:https://www.zhihu.com/people/Jack–Cui/Python版本:Python3.x运行平台:WindowsIDE:Sublimetext3一前言二小福利三实战背景四网站

- python中pip安装数据库db_Python3爬虫实战-3、数据库的安装:MySQL、MongoDB、Redis

梦尽需终

抓取下网页代码之后,下一步就是从网页中提取信息,提取信息的方式有多种多样,可以使用正则来提取,但是写起来会相对比较繁琐。在这里还有许多强大的解析库,如LXML、BeautifulSoup、PyQuery等等,提供了非常强大的解析方法,如XPath解析、CSS选择器解析等等,利用它们我们可以高效便捷地从从网页中提取出有效信息。本节我们就来介绍一下这些库的安装过程。1.2.1LXML的安装LXML是P

- python3爬虫入门教程-有什么好的python3爬虫入门教程或书籍吗?

weixin_37988176

2018.2.23更新。现在书也来了,经过一段时间的学习,我把我的爬虫经验写成了一本书,名字叫《Python3网络爬虫开发实战》/>本书通过多个实战案例详细介绍了Python3网络爬虫的知识,本书由图灵教育-人民邮电出版社出版发行。全书预览图:/>购买链接如下:《前150名发签名版Python3网络爬虫开发实战》【摘要书评试读】-京东图书item.jd.com《Python3网络爬虫开发实战》(崔

- python3爬虫-快速入门如何爬取图片和标题

嗨学编程

本人对于Python学习创建了一个小小的学习圈子,为各位提供了一个平台,大家一起来讨论学习Python。欢迎各位到来Python学习群:960410445一起讨论视频分享学习。Python是未来的发展方向,正在挑战我们的分析能力及对世界的认知方式,因此,我们与时俱进,迎接变化,并不断的成长,掌握Python核心技术,才是掌握真正的价值所在。大致思路1、发送请求2、得到响应数据3、储存数据分享一些简

- python程序设计学什么-python程序设计百度云:python后端开发需要学什么?

weixin_37988176

python爬虫入门教程全集千锋官网上有一些是零基础入门学习的很不错python3爬虫入门教程廖雪峰老师的网上文字加少量视频python3的入门级教程和莫烦老师的视频教程大佬们谁有老男孩教育的Python爬虫视频教程云链接,万分感谢Python全栈开发与人工智Python开发基础知习内容包括:Python基础语法、数据类型、字码、文件操作、函数、装饰器、迭代器、内置方法、常用模块等。免费课程备用:

- python3爬虫lxml模块的安装

weixin_30487317

1:在下载lxml之前,要先查看python的版本信息,在CMD命令行输入python再输入importpip;print(pip.pep425tags.get_supported())-----------------------------------------------------------------------------------------------------------

- python3爬虫中文乱码之请求头‘Accept-Encoding’:br 的问题

calm_peng

pythonpython爬虫杂谈

当用python3做爬虫的时候,一些网站为了防爬虫会设置一些检查机制,这时我们就需要添加请求头,伪装成浏览器正常访问。header的内容在浏览器的开发者工具中便可看到,将这些信息添加到我们的爬虫代码中即可。‘Accept-Encoding’:是浏览器发给服务器,声明浏览器支持的编码类型。一般有gzip,deflate,br等等。python3中的requests包中response.text和re

- python3爬虫(5)--构造随机User-Agent池、构造免费随机ip池、常见异常处理

Jalen data analysis

python数据采集python3python3爬虫python设置代理ippython爬虫异常处理

利用python进行数据采集的过程中,很多网站都设置了反爬虫机制,其中最常见的就是相同的User-Agent、ip或者Cookie不能连续进行数据采集,所以我们需要构建很多User-Agent、ip或者Cookie以防止被封停。同时批量采集数据时会出现很多常见异常。1、构造有很多方法,这里我们就将众多的User-Agent和ip存在csv文件中,供我们数据采集的时候使用。2、代理ip请求失败怎么解

- Python3爬虫、数据清洗与可视化实战之用API爬取天气预报数据

zhouyong80

Python3学习python爬虫数据清洗可视化

注册免费API和阅读技术文档示例接口为和风天气的天气预报,该网站为个人开发者提供免费的预报数据(有访问次数限制)。注册地址:http://console.heweather.com注册后在控制台可以看到个人认证的key(密钥),这个key是访问API的钥匙。文档地址:https://dev.heweather.com/docs/api/weather免费版接口地址:https://free-api

- Python3爬虫教程之ADSL拨号爬虫ip池的使用

q56731523

爬虫tcp/ippython爬虫ip代理ip

在我之前做爬虫经常需要维护自己的爬虫ip池,他可以挑选出很多有用的爬虫地址,因为不是专业的而且这些爬虫ip通常是公共爬虫ip,所以可用率不是太高,而且这样类型的地址很大情况下都是多人共用的,被封地址概率很大。另外要说的是这些爬虫ip时效也非常的短,虽然筛选过后但是还是避免不了这样的问题存在。之前我们也了解了付费爬虫ip的使用,付费爬虫ip的质量相对免费爬虫ip就会好不少,这的确已经是一个相对不错的

- Python3爬虫环境配置——解析库安装(附tesserocr安装方法)

云端听茗

Python3爬虫环境配置——解析库安装(附tesserocr安装方法)抓取网页代码后,第二步就是提取信息,为了方便程序设计,这里不采用繁琐的正则提取,利用社区里强大的Python解析库,如lxml、BeautifulSoup、pyquery等。此外,还有非常强大的解析方法,如XPath解析和CSS选择器解析,可以高效便捷地提取网页信息。一、常用库常用的解析库参见上文列举,安装常用解析库的方式同社

- python3爬虫初级入门和正则表达式

快乐糖果屋

python爬虫python爬虫正则表达式

用python抓取指定页面:代码如下:importurllib.requesturl="http://www.baidu.com"data=urllib.request.urlopen(url).read()#data=data.decode('UTF-8')print(data)123456urllib.request.urlopen(url)官方文档返回一个http.client.HTTPRe

- Python3爬虫神器BeautifulSoup(三)——搜索文档树

孤魂游

搜索文档树里面主要讲find()以及find_all()的用法。在讲这两个用法之前先来说说过滤器,什么过滤器呢?顾名思义,过滤器就是按照条件过滤掉不符合的,留下符合的。那么在Python中这些条件可以是什么呢?我们来依次介绍1.字符串(这个没什么好讲的)2.正则表达式(不知道的可以百度一下什么意思)3.列表:如果传入列表参数,BeautifulSoup会将与列表中任一元素匹配的内容返回.4.Tru

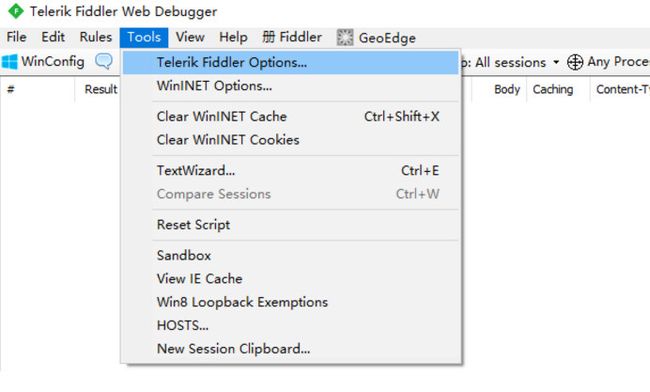

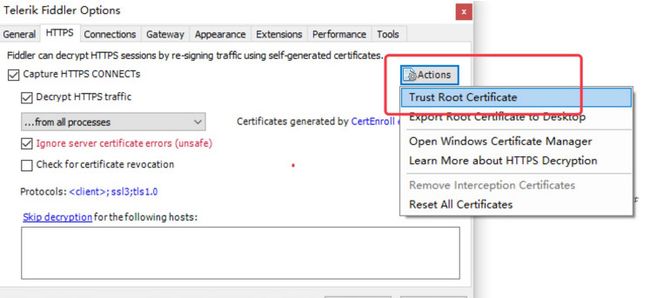

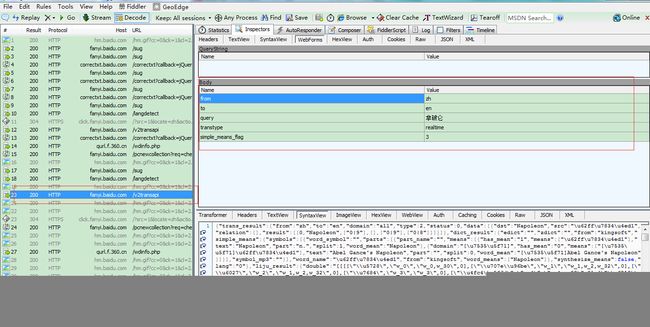

- python爬虫app脱壳 用什么工具_Python3爬虫使用Fidder实现APP爬取示例

weixin_39588679

python爬虫app脱壳用什么工具

之前爬取都是网页上的数据,今天要来说一下怎么借助Fidder来爬取手机APP上的数据。一、环境配置1、Fidder的安装和配置没有安装Fidder软件的可以进入这个网址下载,然后就是傻瓜式的安装,安装步骤很简单。在安装完成后,打开软件,进行如下设置:这里使用默认的8888端口就好了,如果要修改的话,要避免和其他端口冲突。2、手机的配置首先打开cmd,输入ipconfig查看IP地址,记录下这个IP

- iWorld-VR: 以VR的形式查看iPhone本地相册中的全景照片

Jmsp

iOSPythondjangopythonswiftGVR

以VR的形式查看iPhone本地相册中的全景照片Python3爬虫+Django应用+Heroku免费云+Swift3+GVR1、用户下载app后,可以在app中预览、下载各种各样的高清平面图和全景照片;2、用户也可以在本地相册中选择要预览的全景照片,在分享界面选择app提供的插件‘VRView’进行360°的图片预览。安装地址:https://itunes.apple.com/cn/app/lu

- Python3爬虫实例-爬取双色球开奖记录并保存到数据库

1eeMamas

python爬虫

importrequestsfromfake_useragentimportUserAgentfromlxmlimportetreeimportpymysqlclassSqlHelper(object):def__init__(self):self.connect()defconnect(self):self.conn=pymysql.connect(host='127.0.0.1',port=3

- Python3爬虫学习——urlib库笔记

甲寅Emore

Python3爬虫笔记Python学习笔记爬虫学习python

Python3爬虫学习——urllib库前言本笔记仅个人认知和见解,水平有限,还请见谅。内容大多来自Python文档和学习材料,作相应的扩充或压缩后的笔记。没有很多实例,大多是理论知识文章目录Python3爬虫学习——urllib库前言urllib库概述1.用request发送请求urlopenRequesturlopen与Request的关系与小结Handler与OpenerDirectorHa

- SAX解析xml文件

小猪猪08

xml

1.创建SAXParserFactory实例

2.通过SAXParserFactory对象获取SAXParser实例

3.创建一个类SAXParserHander继续DefaultHandler,并且实例化这个类

4.SAXParser实例的parse来获取文件

public static void main(String[] args) {

//

- 为什么mysql里的ibdata1文件不断的增长?

brotherlamp

linuxlinux运维linux资料linux视频linux运维自学

我们在 Percona 支持栏目经常收到关于 MySQL 的 ibdata1 文件的这个问题。

当监控服务器发送一个关于 MySQL 服务器存储的报警时,恐慌就开始了 —— 就是说磁盘快要满了。

一番调查后你意识到大多数地盘空间被 InnoDB 的共享表空间 ibdata1 使用。而你已经启用了 innodbfileper_table,所以问题是:

ibdata1存了什么?

当你启用了 i

- Quartz-quartz.properties配置

eksliang

quartz

其实Quartz JAR文件的org.quartz包下就包含了一个quartz.properties属性配置文件并提供了默认设置。如果需要调整默认配置,可以在类路径下建立一个新的quartz.properties,它将自动被Quartz加载并覆盖默认的设置。

下面是这些默认值的解释

#-----集群的配置

org.quartz.scheduler.instanceName =

- informatica session的使用

18289753290

workflowsessionlogInformatica

如果希望workflow存储最近20次的log,在session里的Config Object设置,log options做配置,save session log :sessions run ;savesessio log for these runs:20

session下面的source 里面有个tracing

- Scrapy抓取网页时出现CRC check failed 0x471e6e9a != 0x7c07b839L的错误

酷的飞上天空

scrapy

Scrapy版本0.14.4

出现问题现象:

ERROR: Error downloading <GET http://xxxxx CRC check failed

解决方法

1.设置网络请求时的header中的属性'Accept-Encoding': '*;q=0'

明确表示不支持任何形式的压缩格式,避免程序的解压

- java Swing小集锦

永夜-极光

java swing

1.关闭窗体弹出确认对话框

1.1 this.setDefaultCloseOperation (JFrame.DO_NOTHING_ON_CLOSE);

1.2

this.addWindowListener (

new WindowAdapter () {

public void windo

- 强制删除.svn文件夹

随便小屋

java

在windows上,从别处复制的项目中可能带有.svn文件夹,手动删除太麻烦,并且每个文件夹下都有。所以写了个程序进行删除。因为.svn文件夹在windows上是只读的,所以用File中的delete()和deleteOnExist()方法都不能将其删除,所以只能采用windows命令方式进行删除

- GET和POST有什么区别?及为什么网上的多数答案都是错的。

aijuans

get post

如果有人问你,GET和POST,有什么区别?你会如何回答? 我的经历

前几天有人问我这个问题。我说GET是用于获取数据的,POST,一般用于将数据发给服务器之用。

这个答案好像并不是他想要的。于是他继续追问有没有别的区别?我说这就是个名字而已,如果服务器支持,他完全可以把G

- 谈谈新浪微博背后的那些算法

aoyouzi

谈谈新浪微博背后的那些算法

本文对微博中常见的问题的对应算法进行了简单的介绍,在实际应用中的算法比介绍的要复杂的多。当然,本文覆盖的主题并不全,比如好友推荐、热点跟踪等就没有涉及到。但古人云“窥一斑而见全豹”,希望本文的介绍能帮助大家更好的理解微博这样的社交网络应用。

微博是一个很多人都在用的社交应用。天天刷微博的人每天都会进行着这样几个操作:原创、转发、回复、阅读、关注、@等。其中,前四个是针对短博文,最后的关注和@则针

- Connection reset 连接被重置的解决方法

百合不是茶

java字符流连接被重置

流是java的核心部分,,昨天在做android服务器连接服务器的时候出了问题,就将代码放到java中执行,结果还是一样连接被重置

被重置的代码如下;

客户端代码;

package 通信软件服务器;

import java.io.BufferedWriter;

import java.io.OutputStream;

import java.io.O

- web.xml配置详解之filter

bijian1013

javaweb.xmlfilter

一.定义

<filter>

<filter-name>encodingfilter</filter-name>

<filter-class>com.my.app.EncodingFilter</filter-class>

<init-param>

<param-name>encoding<

- Heritrix

Bill_chen

多线程xml算法制造配置管理

作为纯Java语言开发的、功能强大的网络爬虫Heritrix,其功能极其强大,且扩展性良好,深受热爱搜索技术的盆友们的喜爱,但它配置较为复杂,且源码不好理解,最近又使劲看了下,结合自己的学习和理解,跟大家分享Heritrix的点点滴滴。

Heritrix的下载(http://sourceforge.net/projects/archive-crawler/)安装、配置,就不罗嗦了,可以自己找找资

- 【Zookeeper】FAQ

bit1129

zookeeper

1.脱离IDE,运行简单的Java客户端程序

#ZkClient是简单的Zookeeper~$ java -cp "./:zookeeper-3.4.6.jar:./lib/*" ZKClient

1. Zookeeper是的Watcher回调是同步操作,需要添加异步处理的代码

2. 如果Zookeeper集群跨越多个机房,那么Leader/

- The user specified as a definer ('aaa'@'localhost') does not exist

白糖_

localhost

今天遇到一个客户BUG,当前的jdbc连接用户是root,然后部分删除操作都会报下面这个错误:The user specified as a definer ('aaa'@'localhost') does not exist

最后找原因发现删除操作做了触发器,而触发器里面有这样一句

/*!50017 DEFINER = ''aaa@'localhost' */

原来最初

- javascript中showModelDialog刷新父页面

bozch

JavaScript刷新父页面showModalDialog

在页面中使用showModalDialog打开模式子页面窗口的时候,如果想在子页面中操作父页面中的某个节点,可以通过如下的进行:

window.showModalDialog('url',self,‘status...’); // 首先中间参数使用self

在子页面使用w

- 编程之美-买书折扣

bylijinnan

编程之美

import java.util.Arrays;

public class BookDiscount {

/**编程之美 买书折扣

书上的贪心算法的分析很有意思,我看了半天看不懂,结果作者说,贪心算法在这个问题上是不适用的。。

下面用动态规划实现。

哈利波特这本书一共有五卷,每卷都是8欧元,如果读者一次购买不同的两卷可扣除5%的折扣,三卷10%,四卷20%,五卷

- 关于struts2.3.4项目跨站执行脚本以及远程执行漏洞修复概要

chenbowen00

strutsWEB安全

因为近期负责的几个银行系统软件,需要交付客户,因此客户专门请了安全公司对系统进行了安全评测,结果发现了诸如跨站执行脚本,远程执行漏洞以及弱口令等问题。

下面记录下本次解决的过程以便后续

1、首先从最简单的开始处理,服务器的弱口令问题,首先根据安全工具提供的测试描述中发现应用服务器中存在一个匿名用户,默认是不需要密码的,经过分析发现服务器使用了FTP协议,

而使用ftp协议默认会产生一个匿名用

- [电力与暖气]煤炭燃烧与电力加温

comsci

在宇宙中,用贝塔射线观测地球某个部分,看上去,好像一个个马蜂窝,又像珊瑚礁一样,原来是某个国家的采煤区.....

不过,这个采煤区的煤炭看来是要用完了.....那么依赖将起燃烧并取暖的城市,在极度严寒的季节中...该怎么办呢?

&nbs

- oracle O7_DICTIONARY_ACCESSIBILITY参数

daizj

oracle

O7_DICTIONARY_ACCESSIBILITY参数控制对数据字典的访问.设置为true,如果用户被授予了如select any table等any table权限,用户即使不是dba或sysdba用户也可以访问数据字典.在9i及以上版本默认为false,8i及以前版本默认为true.如果设置为true就可能会带来安全上的一些问题.这也就为什么O7_DICTIONARY_ACCESSIBIL

- 比较全面的MySQL优化参考

dengkane

mysql

本文整理了一些MySQL的通用优化方法,做个简单的总结分享,旨在帮助那些没有专职MySQL DBA的企业做好基本的优化工作,至于具体的SQL优化,大部分通过加适当的索引即可达到效果,更复杂的就需要具体分析了,可以参考本站的一些优化案例或者联系我,下方有我的联系方式。这是上篇。

1、硬件层相关优化

1.1、CPU相关

在服务器的BIOS设置中,可

- C语言homework2,有一个逆序打印数字的小算法

dcj3sjt126com

c

#h1#

0、完成课堂例子

1、将一个四位数逆序打印

1234 ==> 4321

实现方法一:

# include <stdio.h>

int main(void)

{

int i = 1234;

int one = i%10;

int two = i / 10 % 10;

int three = i / 100 % 10;

- apacheBench对网站进行压力测试

dcj3sjt126com

apachebench

ab 的全称是 ApacheBench , 是 Apache 附带的一个小工具 , 专门用于 HTTP Server 的 benchmark testing , 可以同时模拟多个并发请求。前段时间看到公司的开发人员也在用它作一些测试,看起来也不错,很简单,也很容易使用,所以今天花一点时间看了一下。

通过下面的一个简单的例子和注释,相信大家可以更容易理解这个工具的使用。

- 2种办法让HashMap线程安全

flyfoxs

javajdkjni

多线程之--2种办法让HashMap线程安全

多线程之--synchronized 和reentrantlock的优缺点

多线程之--2种JAVA乐观锁的比较( NonfairSync VS. FairSync)

HashMap不是线程安全的,往往在写程序时需要通过一些方法来回避.其实JDK原生的提供了2种方法让HashMap支持线程安全.

- Spring Security(04)——认证简介

234390216

Spring Security认证过程

认证简介

目录

1.1 认证过程

1.2 Web应用的认证过程

1.2.1 ExceptionTranslationFilter

1.2.2 在request之间共享SecurityContext

1

- Java 位运算

Javahuhui

java位运算

// 左移( << ) 低位补0

// 0000 0000 0000 0000 0000 0000 0000 0110 然后左移2位后,低位补0:

// 0000 0000 0000 0000 0000 0000 0001 1000

System.out.println(6 << 2);// 运行结果是24

// 右移( >> ) 高位补"

- mysql免安装版配置

ldzyz007

mysql

1、my-small.ini是为了小型数据库而设计的。不应该把这个模型用于含有一些常用项目的数据库。

2、my-medium.ini是为中等规模的数据库而设计的。如果你正在企业中使用RHEL,可能会比这个操作系统的最小RAM需求(256MB)明显多得多的物理内存。由此可见,如果有那么多RAM内存可以使用,自然可以在同一台机器上运行其它服务。

3、my-large.ini是为专用于一个SQL数据

- MFC和ado数据库使用时遇到的问题

你不认识的休道人

sqlC++mfc

===================================================================

第一个

===================================================================

try{

CString sql;

sql.Format("select * from p

- 表单重复提交Double Submits

rensanning

double

可能发生的场景:

*多次点击提交按钮

*刷新页面

*点击浏览器回退按钮

*直接访问收藏夹中的地址

*重复发送HTTP请求(Ajax)

(1)点击按钮后disable该按钮一会儿,这样能避免急躁的用户频繁点击按钮。

这种方法确实有些粗暴,友好一点的可以把按钮的文字变一下做个提示,比如Bootstrap的做法:

http://getbootstrap.co

- Java String 十大常见问题

tomcat_oracle

java正则表达式

1.字符串比较,使用“==”还是equals()? "=="判断两个引用的是不是同一个内存地址(同一个物理对象)。 equals()判断两个字符串的值是否相等。 除非你想判断两个string引用是否同一个对象,否则应该总是使用equals()方法。 如果你了解字符串的驻留(String Interning)则会更好地理解这个问题。

- SpringMVC 登陆拦截器实现登陆控制

xp9802

springMVC

思路,先登陆后,将登陆信息存储在session中,然后通过拦截器,对系统中的页面和资源进行访问拦截,同时对于登陆本身相关的页面和资源不拦截。

实现方法:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23