MTL多目标学习介绍综述等

工业界解决多目标问题的方案基本有三种策略:多模型分数融合、排序学习(Learning To Rank,LTR)、多任务学习(Multi-Task Learning,MTL)

1、 An Overview of Multi-Task Learning in Deep Neural Networks-June 2017

.两种深度学习 MTL 方法 2017

Hard sharing:在多任务之间共享隐层,降低over fitting的风险

Soft sharing各任务之间有自己的模型和参数,主要靠regularization鼓励任务之间的模型参数相似。MTL的工作机制有几点:

Implicit data augmentation 数据增强

Attention focusing 注意

Eavesdropping 窃听

Representation bias 表示偏向

Regularization 正则化非神经网络模型中的MTL,主要有两种:

Block-sparse regularization:enforcing sparsity across tasks through norm regularization

Learning task relationships:modelling the relationships between tasks2An overview of multi-task learning

MTL方法分成几类:

feature learning approach 特征学习

low-rank approach 低秩 参数

task clustering approach 任务聚类 参数

task relation learning approach 任务关系学习 参数

decomposition approach 分解 参数

和其他机器学习方法结合:

semi-supervised learning

active learning

unsupervised learning

reinforcement learning

multi-view learning

graphical models

‘What to share’

feature:特征

instance:实例 (很少)

parameter:参数2:Thung K, Wee C, "A Brief Review on Multi-Task Learning", Multimedia Tools and Applications, August 2018.

按照输入输出

· multi-input single-output (MISO)

· single-input multioutput (SIMO)

· multi-input multi-output (MIMO)

按照正则化方法,MTL分类:

· LASSO

· group sparsity

· low rank

· task exclusiveness (unrelated tasks)

· graph Laplacian regularization

· decomposition

incomplete data MTL处理方法:

· use only samples with complete data for MTL study, with the cost of reduced statistical power of analysis due to smaller dataset;

· impute the missing data before performing the MTL study, where the imputation is very much prone to error for data missing in blocks

· design a MTL method that is applicable to incomplete data.深度学习的MTL方法:共享层

3:Vandenhende S et al., "Revisiting Multi-Task Learning in the Deep Learning Era", arXiv 2004.13379, 2020

深度学习的MTL主要是网络模型的设计能够从多任务监督信号中学会表征共享。MTL的优点主要是:1)由于层共享,减少了内存占用量。 2)由于避免重复计算共享层特征,提高推理速度。 3)如果相关任务共享补充信息或作为彼此的regularizer,则可以提高模型性能。 比如计算机视觉中的检测和分类,检测和分割,分割和深度估计等等

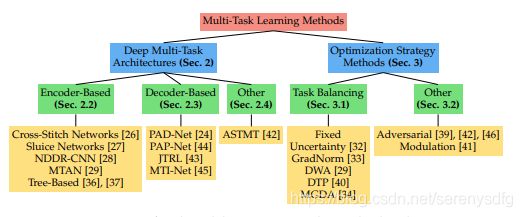

4、Revisiting Multi-Task Learning in the Deep Learning Era

1,MTL的性能在很大程度上取决于任务字典。它的大小、任务类型、标签源等等,都影响最终的结果。

2,当使用单一MTL模型处理多个密集预测任务时,基于解码器的架构目前在多任务性能方面提供了更多优势,与基于编码器的架构相比,其计算开销有限。

3、我们分析了多种任务均衡策略,并分离出对任务均衡学习最有效的要素,如降低噪声任务的权重、平衡任务梯度等**

参考:知乎https://zhuanlan.zhihu.com/p/145706170

综述:https://mp.weixin.qq.com/s/TdRln-cOJTMiSqUP7DMNEw (Multi-task Learning and Beyond: 过去,现在与未来)

基于共享表示(shared representation),把多个相关的任务放在一起学习的一种机器学习方法

共享表示有两种方式:

(1)基于参数的共享(Parameter based):比如基于神经网络的MTL,高斯处理过程。

(2)基于约束的共享(regularization based):比如均值,联合特征(Joint feature)学习(创建一个常见的特征集合

hard parameter sharinG共享参数得过拟合几率比较低

soft parameter sharing优点及使用场景 https://zhuanlan.zhihu.com/p/59413549

(好的总结)https://www.cnblogs.com/zeze/p/8244357.html