MySQL数据库(九) 集群 Cluster 和性能优化

文章目录

- 6 MySQL 集群 Cluster

- 6.1 MySQL主从复制

- 6.1.1 主从复制架构和原理

- 6.1.2 实现主从复制配置

- 6.1.3 主从复制相关

- 6.1.4 实现级联复制

- 6.1.5 主主复制

- 6.1.6 半同步复制

- 6.1.7 复制过滤器

- 6.1.8 主从复制加密

- 6.1.9 GTID复制

- 6.1.10 复制的监控和维护

- 6.1.11 复制的问题和解决方案

- 6.2 MySQL 中间件代理服务器

- 6.2.1 关系型数据库和 NoSQL 数据库

- 6.2.2 数据切分

- 6.2.3 MySQL中间件各种应用

- 6.2.4 Mycat

- 6.2.5 ProxySQL

- 6.3 MySQL高可用

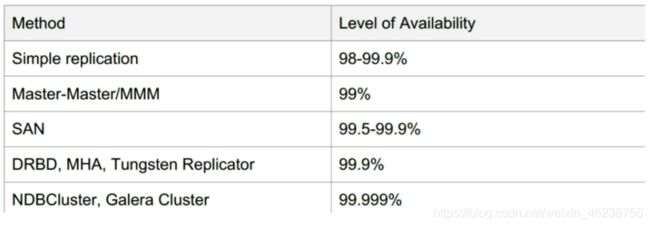

- 6.3.1 MySQL高可用解决方案

- 6.3.2 MHA Master High Availability

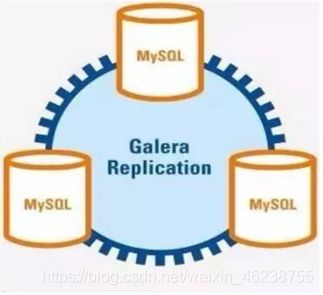

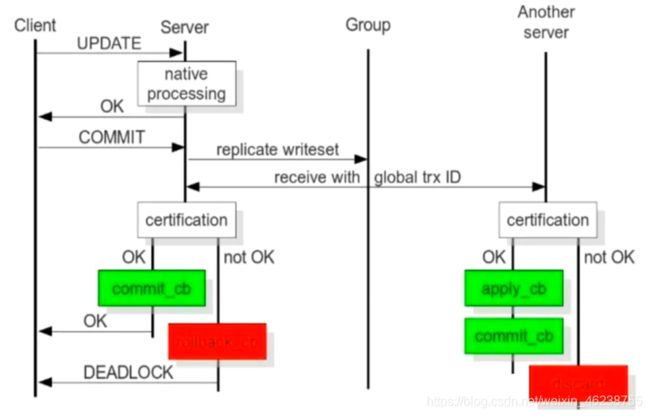

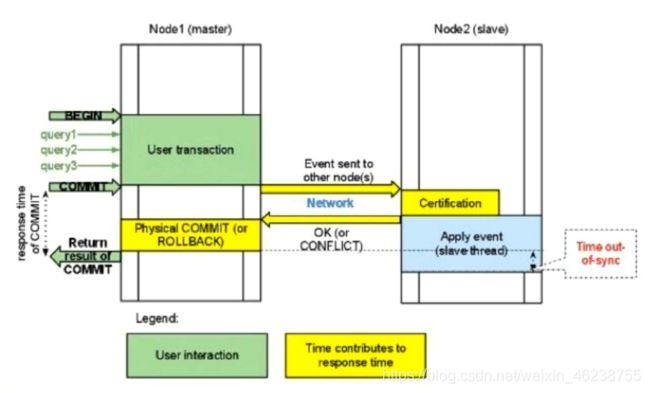

- 6.3.3 Galera Cluster

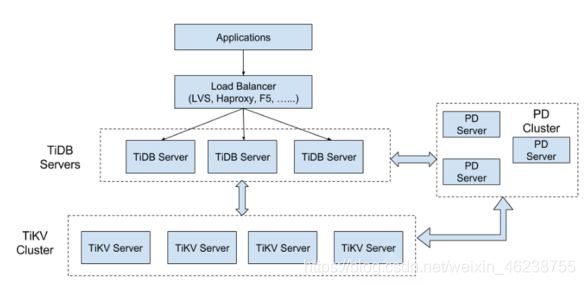

- 6.3.4 TiDB概述

- 7 性能优化

- 7.1 压力测试工具

- 7.1.1 常见MySQl压力测试工具

- 7.1.2 mysqlslap

- 7.2 生产环境 my.cnf 配置案例

- 7.3 MySQL配置最佳实践

- 7.3.1 基础规范

- 7.3.2 命名规范

- 7.3.3 表设计规范

- 7.3.4 字段设计规范

- 7.3.5索引设计规范

- 7.3.6 SQL使用规范

6 MySQL 集群 Cluster

6.1 MySQL主从复制

6.1.1 主从复制架构和原理

6.1.1.1 服务性能扩展方式

- Scale Up,向上扩展,垂直扩展 (给予更好的配置)

- Scale Out,向外扩展,横向扩展 (更多的服务器)

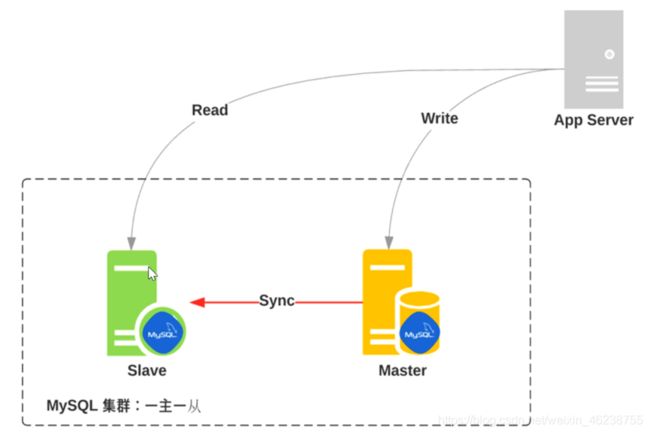

6.1.1.2 MySQL的扩展

- 读写分离

- 复制:每个节点都有相同的数据集,向外扩展,基于二进制日志的单向复制

6.1.1.3 复制的功用

- 数据分布

- 负载均衡读

- 备份

- 高可用和故障切换

- MySQL升级测试

6.1.1.4 复制架构

一主一从复制架构

6.1.1.5 主从复制原理(面试)

主从复制相关线程

主节点:必须开启二进制日志功能

dump Thread:为每个Slave的I/O Thread启动一个dump线程,用于向其发送binary log events

从节点:建议开启二进制日志功能,可以预防主服务器挂掉,上位

I/O Thread:向Master请求二进制日志事件,并保存于中继日志中

SQL Thread:从中继日志中读取日志事件,在本地完成重放

跟复制功能相关的文件:

- master.info:用于保存slave连接至master时的相关信息,例如账号、密码、服务器地址等

- relay-log.info:保存在当前slave节点上已经复制的当前二进制日志和本地relay log日志的对应关系

范例: 中继日志

[root@slave ~]#file /var/lib/mysql/mariadb-relay-bin.000001

/var/lib/mysql/mariadb-relay-bin.000001: MySQL replication log, server id 18 MySQL V5+, server version 10.3.17-MariaDB-log

[root@slave ~]#mysqlbinlog /var/lib/mysql/mariadb-relay-bin.000001|head

/*!50530 SET @@SESSION.PSEUDO_SLAVE_MODE=1*/;

/*!40019 SET @@session.max_insert_delayed_threads=0*/;

/*!50003 SET @OLD_COMPLETION_TYPE=@@COMPLETION_TYPE,COMPLETION_TYPE=0*/;

DELIMITER /*!*/;

# at 4

#200615 17:58:48 server id 18 end_log_pos 256 CRC32 0x7bd00c79 Start:

binlog v 4, server v 10.3.17-MariaDB-log created 200615 17:58:48

BINLOG '

WEbnXg8cAAAA/AAAAAABAAAAAAQAMTAuMy4xNy1NYXJpYURCLWxvZwAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAEzgNAAgAEgAEBAQEEgAA5AAEGggAAAAICAgCAAAACgoKAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAA

6.1.1.6 主从复制特点

- 异步复制

- 主从数据不一致比较常见

6.1.1.7 各种复制架构

- 一Master/一Slave

- 一主多从

- 从服务器还可以再有从服务器(级联,复制延迟大)

- Master/Master

- 一从多主:适用于多个不同数据库

- 环状复制

复制需要考虑二进制日志事件记录格式

- STATEMENT(5.0之前)会造成主从数据不一致

- ROW(5.1之后,推荐)

- MIXED

6.1.2 实现主从复制配置

参考官网

https://mariadb.com/kb/en/library/setting-up-replication/

https://dev.mysql.com/doc/refman/5.5/en/replication-configuration.html

主节点配置:

(1) 启用二进制日志

[mysqld]

log_bin

(2) 为当前节点设置一个全局惟一的ID号

[mysqld]

server-id=#

log-basename=master #可选项,设置datadir中日志名称,确保不依赖主机名

说明:

server-id的取值范围

1 to 4294967295 (>= MariaDB 10.2.2),默认值为1

0 to 4294967295 (<= MariaDB 10.2.1),默认值为0,如果从节点为0,所有master都将拒绝此slave的连接

(3) 创建有复制权限的用户账号

GRANT REPLICATION SLAVE ON *.* TO 'repluser'@'HOST' IDENTIFIED BY 'replpass';

(4) 查看从二进制日志的文件和位置开始进行复制

SHOW MASTER LOG;

从节点配置:

(1) 启动中继日志

[mysqld]

server_id=# #为当前节点设置一个全局惟的ID号

log-bin

read_only=ON #设置数据库只读,针对supper user无效

relay_log=relay-log #relay log的文件路径,默认值hostname-relay-bin

relay_log_index=relay-log.index #默认值hostname-relay-bin.index

(2) 使用有复制权限的用户账号连接至主服务器,并启动复制线程

CHANGE MASTER TO MASTER_HOST='masterhost',

MASTER_USER='repluser',

MASTER_PASSWORD='replpass',

MASTER_LOG_FILE='mariadb-bin.xxxxxx',

MASTER_LOG_POS=#;

START SLAVE [IO_THREAD|SQL_THREAD];

SHOW SLAVE STATUS;

范例:新建主从复制

#主节点

[root@master ~]#vim /etc/my.cnf.d/mariadb-server.cnf

[mysqld]

server-id=8

log-bin

[root@master ~]#systemctl restart mariadb

[root@master ~]#mysql

MariaDB [(none)]> grant replication slave on *.* to repluser@'192.168.8.%'

identified by 'magedu';

#查看二进制文件和位置

MariaDB [(none)]> show master logs;

+--------------------+-----------+

| Log_name | File_size |

+--------------------+-----------+

| mariadb-bin.000001 | 28052 |

| mariadb-bin.000002 | 545 |

+--------------------+-----------+

2 rows in set (0.001 sec)

#从节点

[root@slave ~]#vim /etc/my.cnf.d/mariadb-server.cnf

[mysqld]

server-id=18

[root@slave ~]#systemctl restart mariadb

[root@slave1 ~]#mysql

MariaDB [(none)]> help change master to

MariaDB [(none)]> CHANGE MASTER TO MASTER_HOST='192.168.8.8',

MASTER_USER='repluser', MASTER_PASSWORD='magedu', MASTER_PORT=3306,

MASTER_LOG_FILE='mariadb-bin.000002', MASTER_LOG_POS=545;

MariaDB [(none)]> start slave;

Query OK, 0 rows affected, 1 warning (0.000 sec)

MariaDB [(none)]> show slave status\G

*************************** 1. row ***************************

Slave_IO_State: Waiting for master to send event

Master_Host: 192.168.8.8

Master_User: repluser

Master_Port: 3306

Connect_Retry: 60

Master_Log_File: mariadb-bin.000002

Read_Master_Log_Pos: 26987890

Relay_Log_File: mariadb-relay-bin.000002

Relay_Log_Pos: 26987902

Relay_Master_Log_File: mariadb-bin.000002

Slave_IO_Running: Yes

Slave_SQL_Running: Yes

Replicate_Do_DB:

Replicate_Ignore_DB:

Replicate_Do_Table:

Replicate_Ignore_Table:

Replicate_Wild_Do_Table:

Replicate_Wild_Ignore_Table:

Last_Errno: 0

Last_Error:

Skip_Counter: 0

Exec_Master_Log_Pos: 26987890

Relay_Log_Space: 26988213

Until_Condition: None

Until_Log_File:

Until_Log_Pos: 0

Master_SSL_Allowed: No

Master_SSL_CA_File:

Master_SSL_CA_Path:

Master_SSL_Cert:

Master_SSL_Cipher:

Master_SSL_Key:

Seconds_Behind_Master: 0 #复制的延迟时间

Master_SSL_Verify_Server_Cert: No

Last_IO_Errno: 0

Last_IO_Error:

Last_SQL_Errno: 0

Last_SQL_Error:

Replicate_Ignore_Server_Ids:

Master_Server_Id: 8

Master_SSL_Crl:

Master_SSL_Crlpath:

Using_Gtid: No

Gtid_IO_Pos:

Replicate_Do_Domain_Ids:

Replicate_Ignore_Domain_Ids:

Parallel_Mode: conservative

SQL_Delay: 0

SQL_Remaining_Delay: NULL

Slave_SQL_Running_State: Slave has read all relay log; waiting for the slave I/O thread to update it

Slave_DDL_Groups: 34

Slave_Non_Transactional_Groups: 0

Slave_Transactional_Groups: 100006

1 row in set (0.000 sec)

范例:主服务器非新建时,主服务器运行一段时间后,新增从节点服务器

如果主节点已经运行了一段时间,且有大量数据时,如何配置并启动slave节点

- 通过备份恢复数据至从服务器

- 复制起始位置为备份时,二进制日志文件及其POS

主服务器:

[root@centos8 ~]#vim /etc/my.cnf.d/mariadb-server.cnf

[mysqld]

server-id=8

log-bin

[root@centos8 ~]#systemctl restart mariadb

[root@centos8 ~]#ll /var/lib/mysql/ #多出两个文件

-rw-rw---- 1 mysql mysql 330 Jun 14 09:50 mariadb-bin.000001

-rw-rw---- 1 mysql mysql 21 Jun 14 09:50 mariadb-bin.index

#查看日志节点

MariaDB [(none)]> show master logs; #先查看节点,再创建账户

+--------------------+-----------+

| Log_name | File_size |

+--------------------+-----------+

| mariadb-bin.000001 | 330 |

+--------------------+-----------+

1 row in set (0.000 sec)

#主节点上要建立一个参与复制的账户

MariaDB [(none)]> grant replication slave on *.* to repluser@'10.0.0.%' identified by 'magedu';

#repluser是用户名,10.0.0.%代表可以从这个网段中任何一个主机连接,identified by 指定密码

MariaDB [(none)]> show databases;

+--------------------+

| Database |

+--------------------+

| hellodb |

| information_schema |

| mysql |

| performance_schema |

+--------------------+

4 rows in set (0.000 sec)

[root@centos8 ~]#mkdir /backup/

[root@centos8 ~]#mysqldump -A --single-transaction --master-data=1 -F > /backup/all.sql

[root@centos8 ~]#ll /backup/all.sql

-rw-r--r-- 1 root root 487711 Jun 14 09:55 /backup/all.sql

[root@centos8 ~]#vim /backup/all.sql

CHANGE MASTER TO MASTER_LOG_FILE='mariadb-bin.000002', MASTER_LOG_POS=375;

#复制数据库

[root@centos8 ~]#scp /backup/all.sql 10.0.0.18:/data

从服务器:

[root@centos8 ~]#vim /etc/my.cnf.d/mariadb-server.cnf

[mysqld]

server-id=18

[root@centos8 ~]#systemctl start mariadb

#主从复制的配置

方法一:

[root@centos8 ~]#vim /data/all.sql

CHANGE MASTER TO

MASTER_HOST='10.0.0.8',

MASTER_USER='repluser',

MASTER_PASSWORD='magedu',

MASTER_PORT=3306,

MASTER_LOG_FILE='mariadb-bin.000002', MASTER_LOG_POS=375;

CREATE DATABASE /*!32312 IF NOT EXISTS*/ `hellodb` /*!40100 DEFAULT CHARACTER SET utf8 */;

方法二:

MariaDB [(none)]> help change master to

MariaDB [(none)]> CHANGE MASTER TO MASTER_HOST='10.0.0.8',

MASTER_USER='repluser', MASTER_PASSWORD='magedu', MASTER_PORT=3306,

MASTER_LOG_FILE='mariadb-bin.000002', MASTER_LOG_POS=375;

#还原数据库和复制信息

[root@centos8 ~]#mysql < /data/all.sql

#此时复制信息已经准备好了

MariaDB [(none)]> show slave status\G

*************************** 1. row ***************************

Slave_IO_State:

Master_Host: 10.0.0.8

Master_User: repluser

Master_Port: 3306

Connect_Retry: 60

Master_Log_File: mariadb-bin.000002

Read_Master_Log_Pos: 375

Relay_Log_File: mariadb-relay-bin.000001

Relay_Log_Pos: 4

Relay_Master_Log_File: mariadb-bin.000002

Slave_IO_Running: No #I/O线程未启用

Slave_SQL_Running: No #SQL线程未启用

Replicate_Do_DB:

Replicate_Ignore_DB:

Replicate_Do_Table:

Replicate_Ignore_Table:

Replicate_Wild_Do_Table:

Replicate_Wild_Ignore_Table:

Last_Errno: 0

Last_Error:

Skip_Counter: 0

Exec_Master_Log_Pos: 375

Relay_Log_Space: 256

Until_Condition: None

Until_Log_File:

Until_Log_Pos: 0

Master_SSL_Allowed: No

Master_SSL_CA_File:

Master_SSL_CA_Path:

Master_SSL_Cert:

Master_SSL_Cipher:

Master_SSL_Key:

Seconds_Behind_Master: NULL #复制延期,主节点和从节点复制差了多长时间,注意观察,最好是0

Master_SSL_Verify_Server_Cert: No

Last_IO_Errno: 0

Last_IO_Error:

Last_SQL_Errno: 0

Last_SQL_Error:

Replicate_Ignore_Server_Ids:

Master_Server_Id: 0

Master_SSL_Crl:

Master_SSL_Crlpath:

Using_Gtid: No

Gtid_IO_Pos:

Replicate_Do_Domain_Ids:

Replicate_Ignore_Domain_Ids:

Parallel_Mode: conservative

SQL_Delay: 0

SQL_Remaining_Delay: NULL

Slave_SQL_Running_State:

Slave_DDL_Groups: 0

Slave_Non_Transactional_Groups: 0

Slave_Transactional_Groups: 0

1 row in set (0.000 sec)

#查看新增加的文件

[root@centos8 ~]#ll /var/lib/mysql/ -t

total 122952

-rw-rw---- 1 mysql mysql 50331648 Jun 14 10:31 ib_logfile0

-rw-rw---- 1 mysql mysql 12582912 Jun 14 10:31 ibdata1

drwx------ 2 mysql mysql 4096 Jun 14 10:31 mysql

drwx------ 2 mysql mysql 272 Jun 14 10:31 hellodb

-rw-rw---- 1 mysql mysql 56 Jun 14 10:31 relay-log.info #二进制日志和中继日志的对应关系

-rw-rw---- 1 mysql mysql 256 Jun 14 10:31 mariadb-relay-bin.000001

-rw-rw---- 1 mysql mysql 27 Jun 14 10:31 mariadb-relay-bin.index #复制下来的中继日志

-rw-rw---- 1 mysql mysql 154 Jun 14 10:31 master.info #主节点的信息

#启用两个线程

MariaDB [(none)]> show processlist; #这是从节点启用前的进程

+----+-------------+-----------+------+---------+------+--------------------------+------------------+----------+

| Id | User | Host | db | Command | Time | State | Info | Progress |

+----+-------------+-----------+------+---------+------+--------------------------+------------------+----------+

| 2 | system user | | NULL | Daemon | NULL | InnoDB purge worker | NULL | 0.000 |

| 1 | system user | | NULL | Daemon | NULL | InnoDB purge coordinator | NULL | 0.000 |

| 3 | system user | | NULL | Daemon | NULL | InnoDB purge worker | NULL | 0.000 |

| 4 | system user | | NULL | Daemon | NULL | InnoDB purge worker | NULL | 0.000 |

| 5 | system user | | NULL | Daemon | NULL | InnoDB shutdown handler | NULL | 0.000 |

| 9 | root | localhost | NULL | Query | 0 | Init | show processlist | 0.000 |

+----+-------------+-----------+------+---------+------+--------------------------+------------------+----------+

6 rows in set (0.000 sec)

MariaDB [(none)]> start slave;

Query OK, 0 rows affected (0.002 sec)

MariaDB [(none)]> show slave status\G

*************************** 1. row ***************************

Slave_IO_State: Waiting for master to send event

Master_Host: 10.0.0.8

Master_User: repluser

Master_Port: 3306

Connect_Retry: 60

Master_Log_File: mariadb-bin.000002

Read_Master_Log_Pos: 572

Relay_Log_File: mariadb-relay-bin.000002

Relay_Log_Pos: 754

Relay_Master_Log_File: mariadb-bin.000002

Slave_IO_Running: Yes #线程已开启

Slave_SQL_Running: Yes #线程已开启

Seconds_Behind_Master: 0 #复制延迟为0;说明已经复制成功

...省略...

MariaDB [(none)]> show processlist; #这是从节点的进程

+----+-------------+-----------+------+-----------+------+-----------------------------------------------------------------------------+------------------+----------+

| Id | User | Host | db | Command | Time | State | Info | Progress |

+----+-------------+-----------+------+-----------+------+-----------------------------------------------------------------------------+------------------+----------+

| 2 | system user | | NULL | Daemon | NULL | InnoDB purge worker | NULL | 0.000 |

| 1 | system user | | NULL | Daemon | NULL | InnoDB purge coordinator | NULL | 0.000 |

| 3 | system user | | NULL | Daemon | NULL | InnoDB purge worker | NULL | 0.000 |

| 4 | system user | | NULL | Daemon | NULL | InnoDB purge worker | NULL | 0.000 |

| 5 | system user | | NULL | Daemon | NULL | InnoDB shutdown handler | NULL | 0.000 |

| 13 | system user | | NULL | Slave_IO | 143 | Waiting for master to send event | NULL | 0.000 |

| 14 | system user | | NULL | Slave_SQL | 143 | Slave has read all relay log; waiting for the slave I/O thread to update it | NULL | 0.000 |

| 15 | root | localhost | NULL | Query | 0 | Init | show processlist | 0.000 |

+----+-------------+-----------+------+-----------+------+-----------------------------------------------------------------------------+------------------+----------+

8 rows in set (0.000 sec)

MariaDB [(none)]> show processlist; #从节点启用后,主节点上的Dump线程同时启用

+----+-------------+-----------------+------+-------------+------+-----------------------------------------------------------------------+------------------+----------+

| Id | User | Host | db | Command | Time | State | Info | Progress |

+----+-------------+-----------------+------+-------------+------+-----------------------------------------------------------------------+------------------+----------+

| 1 | system user | | NULL | Daemon | NULL | InnoDB purge worker | NULL | 0.000 |

| 2 | system user | | NULL | Daemon | NULL | InnoDB purge coordinator | NULL | 0.000 |

| 3 | system user | | NULL | Daemon | NULL | InnoDB purge worker | NULL | 0.000 |

| 4 | system user | | NULL | Daemon | NULL | InnoDB purge worker | NULL | 0.000 |

| 5 | system user | | NULL | Daemon | NULL | InnoDB shutdown handler | NULL | 0.000 |

| 11 | root | localhost | NULL | Query | 0 | Init | show processlist | 0.000 |

| 12 | repluser | 10.0.0.18:55922 | NULL | Binlog Dump | 323 | Master has sent all binlog to slave; waiting for binlog to be updated | NULL | 0.000 |

+----+-------------+-----------------+------+-------------+------+-----------------------------------------------------------------------+------------------+----------+

7 rows in set (0.000 sec)

简洁步骤:

#在主服务器完全备份

[root@master ~]#mysqldump -A -F --single-transaction --master-data=1 >

/backup/fullbackup_`date +%F_%T`.sql

[root@master ~]#ll /backup/

total 2988

-rw-r--r-- 1 root root 3055918 Nov 27 17:41 fullbackup_2019-11-27_17:41:17.sql

[root@master ~]#scp /backup/fullbackup_2019-11-27_17\:41\:17.sql

192.168.8.11:/data/

#建议优化主和从节点服务器的性能

#global innodb_flush_log_at_trx_commit=2

#sync_binlog=0

MariaDB [hellodb]> set global innodb_flush_log_at_trx_commit=2;

Query OK, 0 rows affected (0.001 sec)

MariaDB [hellodb]> show variables like 'sync_binlog';

+---------------+-------+

| Variable_name | Value |

+---------------+-------+

| sync_binlog | 0 |

+---------------+-------+

1 row in set (0.001 sec)

#将完全备份还原到新的从节点

[root@slave ~]#dnf -y install mariadb-server

[root@slave ~]#vim /etc/my.cnf.d/mariadb-server.cnf

[mysqld]

server-id=11

read-only

[root@slave ~]#systemctl restart mariadb

#配置从节点,从完全备份的位置之后开始复制

[root@slave ~]#grep '^CHANGE MASTER' /data/fullbackup_2019-11-27_17\:41\:17.sql

CHANGE MASTER TO MASTER_LOG_FILE='mariadb-bin.000003', MASTER_LOG_POS=389;

[root@slave ~]#vim /data/fullbackup_2019-11-27_17\:41\:17.sql

CHANGE MASTER TO

MASTER_HOST='192.168.8.10',

MASTER_USER='repluser',

MASTER_PASSWORD='magedu',

MASTER_PORT=3306,

MASTER_LOG_FILE='mariadb-bin.000003', MASTER_LOG_POS=389;

[root@slave ~]#mysql < /data/fullbackup_2019-11-27_17\:41\:17.sql

[root@slave ~]#mysql

Welcome to the MariaDB monitor. Commands end with ; or \g.

Your MariaDB connection id is 9

Server version: 10.3.11-MariaDB MariaDB Server

Copyright (c) 2000, 2018, Oracle, MariaDB Corporation Ab and others.

Type 'help;' or '\h' for help. Type '\c' to clear the current input statement.

MariaDB [(none)]> show slave status\G;

*************************** 1. row ***************************

Slave_IO_State:

Master_Host: 192.168.8.10

Master_User: repluser

Master_Port: 3306

Connect_Retry: 60

Master_Log_File: mariadb-bin.000003

Read_Master_Log_Pos: 389

Relay_Log_File: mariadb-relay-bin.000001

Relay_Log_Pos: 4

Relay_Master_Log_File: mariadb-bin.000003

Slave_IO_Running: No

Slave_SQL_Running: No

Replicate_Do_DB:

Replicate_Ignore_DB:

Replicate_Do_Table:

Replicate_Ignore_Table:

Replicate_Wild_Do_Table:

Replicate_Wild_Ignore_Table:

Last_Errno: 0

Last_Error:

Skip_Counter: 0

Exec_Master_Log_Pos: 389

Relay_Log_Space: 256

Until_Condition: None

Until_Log_File:

Until_Log_Pos: 0

Master_SSL_Allowed: No

Master_SSL_CA_File:

Master_SSL_CA_Path:

Master_SSL_Cert:

Master_SSL_Cipher:

Master_SSL_Key:

Seconds_Behind_Master: NULL

Master_SSL_Verify_Server_Cert: No

Last_IO_Errno: 0

Last_IO_Error:

Last_SQL_Errno: 0

Last_SQL_Error:

Replicate_Ignore_Server_Ids:

Master_Server_Id: 0

Master_SSL_Crl:

Master_SSL_Crlpath:

Using_Gtid: No

Gtid_IO_Pos:

Replicate_Do_Domain_Ids:

Replicate_Ignore_Domain_Ids:

Parallel_Mode: conservative

SQL_Delay: 0

SQL_Remaining_Delay: NULL

Slave_SQL_Running_State:

Slave_DDL_Groups: 0

Slave_Non_Transactional_Groups: 0

Slave_Transactional_Groups: 0

1 row in set (0.000 sec)

MariaDB [(none)]> start slave;

6.1.3 主从复制相关

-

限制从服务器为只读

read_only=ON #注意:此限制对拥有SUPER权限的用户均无效注意:以下命令会阻止所有用户, 包括主服务器复制的更新

FLUSH TABLES WITH READ LOCK; -

在从节点清除信息

注意:以下都需要先 STOP SLAVE

RESET SLAVE #从服务器清除master.info ,relay-log.info, relay log ,开始新的relay log RESET SLAVE ALL #清除所有从服务器上设置的主服务器同步信息,如HOST,PORT, USER和PASSWORD 等 -

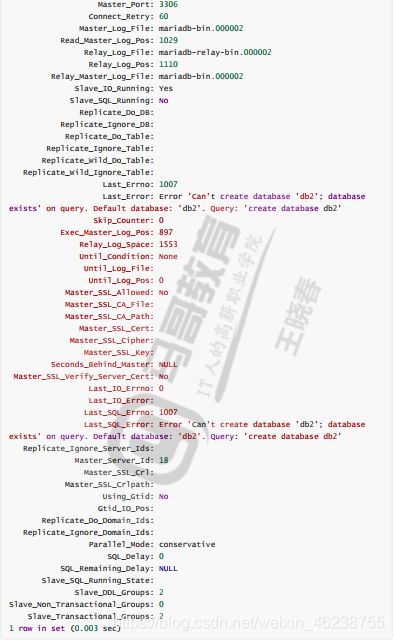

复制错误解决方法

可以在从服务器忽略几个主服务器的复制事件,此为global变量,或指定跳过事件的ID

#系统变量,指定跳过复制事件的个数 SET GLOBAL sql_slave_skip_counter = N #服务器选项,只读系统变量,指定跳过事件的ID [mysqld] slave_skip_errors=1007|ALL -

START SLAVE 语句,指定执到特定的点

START SLAVE [thread_types] START SLAVE [SQL_THREAD] UNTIL MASTER_LOG_FILE = 'log_name', MASTER_LOG_POS = log_pos START SLAVE [SQL_THREAD] UNTIL RELAY_LOG_FILE = 'log_name', RELAY_LOG_POS = log_pos thread_types: [thread_type [, thread_type] ... ] thread_type: IO_THREAD | SQL_THREAD

范例:复制冲突的解决

#方法1

MariaDB [(none)]> stop slave;

MariaDB [(none)]> set global sql_slave_skip_counter=1;

MariaDB [(none)]> start slave;

#方法2

[root@slave1 ~]#vim /etc/my.cnf.d/mariadb-server.cnf

[mysqld]

slave_skip_errors=1007|ALL

[root@slave1 ~]#systemctl restart mariadb

-

保证主从复制的事务安全

参看https://mariadb.com/kb/en/library/server-system-variables/

在master节点启用参数:sync_binlog=1 每次写后立即同步二进制日志到磁盘,性能差 #如果用到的为InnoDB存储引擎: innodb_flush_log_at_trx_commit=1 #每次事务提交立即同步日志写磁盘 innodb_support_xa=ON #分布式事务MariaDB10.3.0废除 sync_master_info=# #次事件后master.info同步到磁盘在slave节点启用服务器选项:

skip-slave-start=ON #不自动启动slave在slave节点启用参数:

sync_relay_log=# #次写后同步relay log到磁盘 sync_relay_log_info=# #次事务后同步relay-log.info到磁盘

范例:当master服务器宕机,提升一个slave成为新的master

#找到哪个从节点的数据库是最新,让它成为新master

[root@centos8 ~]#cat /var/lib/mysql/relay-log.info

5

./mariadb-relay-bin.000002

1180

mysql-bin.000002

996

0

#新master修改配置文件,关闭read-only配置

[root@slave1 ~]#vim /etc/my.cnf.d/mariadb-server.cnf

[mysqld]

server-id=18

read-only=OFF

log-bin=/data/mysql/logbin/mysql-bin

#清除旧的master复制信息

MariaDB [hellodb]>set global read_only=off;

MariaDB [hellodb]>stop slave;

MariaDB [hellodb]>reset slave all;

#在新master上完全备份

[root@slave1 ~]#mysqldump -A --single-transaction --master-data=1 -F > backup.sql

[root@slave1 ~]#scp backup.sql 10.0.0.28:

#分析旧的master 的二进制日志,将未同步到至新master的二进制日志导出来,恢复到新master,尽可能恢复数据

#其它所有 slave 重新还原数据库,指向新的master

[root@slave2 ~]#vim backup.sql

CHANGE MASTER TO

MASTER_HOST='10.0.0.18',

MASTER_USER='repluser',

MASTER_PASSWORD='centos',

MASTER_PORT=3306,

MASTER_LOG_FILE='mysql-bin.000002', MASTER_LOG_POS=371;

MariaDB [hellodb]>stop slave;

MariaDB [hellodb]>reset slave all;

MariaDB [hellodb]>set sql_log_bin=off;

MariaDB [hellodb]>source backup.sql;

MariaDB [hellodb]>set sql_log_bin=on;

MariaDB [hellodb]>start slave;

6.1.4 实现级联复制

需要在中间的从服务器启用以下配置 ,实现中间slave节点能将master的二进制日志在本机进行数据库更新,并且也同时更新本机的二进制,从而实现级联复制

[mysqld]

server-id=18

log_bin

log_slave_updates

read-only

案例:三台主机实现级联复制

#在10.0.0.8充当master

#在10.0.0.18充当级联slave

#在10.0.0.28充当slave

#在master实现

[root@centos8 ~]#vim /etc/my.cnf.d/mariadb-server.cnf

[mysqld]

server-id=8

log-bin

[root@centos8 ~]#systemctl restart mariadb

[root@centos8 ~]#mysql

MariaDB [(none)]> show master logs; #先查看节点,再创建账户,这样复制过去的日志里就有创建账号的记录

+--------------------+-----------+

| Log_name | File_size |

+--------------------+-----------+

| mariadb-bin.000001 | 28198 |

| mariadb-bin.000002 | 541 |

+--------------------+-----------+

MariaDB [(none)]> grant replication slave on *.* to repluser@'10.0.0.%' identified by 'magedu';

[root@centos8 ~]#mysqldump -A -F --single-transaction --master-data=1 > /data/all.sql

[root@centos8 ~]#scp /data/all.sql 10.0.0.18:/data

[root@centos8 ~]#scp /data/all.sql 10.0.0.28:/data

#在中间级联slave实现

[root@centos8 ~]#vim /etc/my.cnf.d/mariadb-server.cnf

[mysqld]

server-id=18

log-bin

read-only

log_slave_updates #级联复制中间节点的必选项

[root@centos8 ~]#systemctl restart mariadb

#还原数据库

[root@centos8 ~]#vim /data/all.sql

CHANGE MASTER TO

MASTER_HOST='10.0.0.8',

MASTER_USER='repluser',

MASTER_PASSWORD='magedu',

MASTER_PORT=3306,

MASTER_LOG_FILE='mariadb-bin.000002',

MASTER_LOG_POS=541;

[root@centos8 ~]#mysql

MariaDB [(none)]> set sql_log_bin=0;

MariaDB [(none)]> source /data/all.sql

MariaDB [(none)]> show master logs; #记录二进制位置,给第三个节点使用

+--------------------+-----------+

| Log_name | File_size |

+--------------------+-----------+

| mariadb-bin.000001 | 28200 |

| mariadb-bin.000002 | 471 |

+--------------------+-----------+

MariaDB [(none)]> set sql_log_bin=0;

MariaDB [(none)]> start slave;

#在第三个节点slave上实现

[root@centos8 ~]#vim /etc/my.cnf.d/mariadb-server.cnf

[mysqld]

server-id=28

read-only

[root@centos8 ~]#systemctl restart mariadb

[root@centos8 ~]#vim /data/all.sql

CHANGE MASTER TO

MASTER_HOST='10.0.0.18', #中间节点的IP

MASTER_USER='repluser',

MASTER_PASSWORD='magedu',

MASTER_PORT=3306,

MASTER_LOG_FILE='mariadb-bin.000002', MASTER_LOG_POS=471;

[root@centos8 ~]#mysql < /data/all.sql

[root@centos8 ~]#mysql -e 'start slave;'

6.1.5 主主复制

注意:统一版本,配置上时主主复制,实际当成一主一从,即可以考虑设置为一读一写,这样在主服务器宕掉的情况下,从服务器可以迅速上位,两边配置基本一样,只有读写不同

主主复制:两个节点,都可以更新数据,并且互为主从

容易产生的问题:数据不一致;因此慎用

考虑要点:自动增长id

配置一个节点使用奇数id

auto_increment_offset=1 #开始点

auto_increment_increment=2 #增长幅度

另一个节点使用偶数id

auto_increment_offset=2

auto_increment_increment=2

主主复制的配置步骤:

(1) 各节点使用一个惟一server_id

(2) 都启动binary log和relay log

(3) 创建拥有复制权限的用户账号(在复制数据之后,二进制日志里就记录了创建过程)

(4) 定义自动增长id字段的数值范围各为奇偶

(5) 均把对方指定为主节点,并启动复制线程

范例:实现两个节点的主主复制模型

检查两个数据库是否都是新装,若有一个有数据,那就先备份

备份建议加时间

help change master to

再导入数据前关闭二进制日志功能

开启线程

二进制日志没增长,数据却复制过来了,原因是:

主服务器:dump线程

从服务器:iothread线程、sqlthread线程

本机的二进制日志只记录本机收到的二进制修改,别的机器传来的不影响本机的二进制日志

#在第一个master节点上实现

[root@master1 ~]#vim /etc/my.cnf.d/mariadb-server.cnf

[mysqld]

server-id=8 #指定id

log-bin #开启二进制日志

auto_increment_offset=1 #开始点

auto_increment_increment=2 #增长幅度

[root@master1 ~]#systemctl start mariadb

[root@master1 ~]#mysql

MariaDB [(none)]>show master logs; #记录位置

+--------------------+-----------+

| Log_name | File_size |

+--------------------+-----------+

| mariadb-bin.000001 | 330 |

+--------------------+-----------+

1 row in set (0.000 sec)

#建立复制账号,此操作是在记录位置之后发生的,所以账号就复制过去了,另一个服务器就不需要再创建,两边用同一个账号进行彼此复制

MariaDB [(none)]> grant replication slave on *.* to repluser@'10.0.0.%' identified by 'magedu';

#在第二个master节点上实现

[rootmaster2 ~]#vim /etc/my.cnf.d/mariadb-server.cnf

[mysqld]

server-id=18

log-bin

auto_increment_offset=2 #开始点

auto_increment_increment=2 #增长幅度

[root@master2 ~]#systemctl start mariadb

[root@master2 ~]#mysql

MariaDB [(none)]> CHANGE MASTER TO

MASTER_HOST='10.0.0.8',

MASTER_USER='repluser',

MASTER_PASSWORD='magedu',

MASTER_PORT=3306,

MASTER_LOG_FILE='mariadb-bin.000001',

MASTER_LOG_POS=330;

Query OK, 0 rows affected (0.019 sec)

MariaDB [(none)]> start slave; #开启进程,实现了单向复制

Query OK, 0 rows affected (0.003 sec)

MariaDB [(none)]> show master logs; #查看二进制位置

MariaDB [(none)]> show master logs;

+--------------------+-----------+

| Log_name | File_size |

+--------------------+-----------+

| mariadb-bin.000001 | 330 |

+--------------------+-----------+

1 row in set (0.000 sec)

#在第一个master节点上实现

MariaDB [(none)]> CHANGE MASTER TO

MASTER_HOST='10.0.0.18',

MASTER_USER='repluser',

MASTER_PASSWORD='magedu',

MASTER_PORT=3306,

MASTER_LOG_FILE='mariadb-bin.000001',

MASTER_LOG_POS=330;

Query OK, 0 rows affected (0.007 sec)

MariaDB [(none)]> start slave;

Query OK, 0 rows affected (0.002 sec)

MariaDB [(none)]> create database db1;

MariaDB [(none)]> use db1

MariaDB [db1]> create table t1(id int auto_increment primary key,name char(10));

#两个节点分别插入数据

#在第一个节点上执行,奇数增长,

MariaDB [db1]> create database db1;

MariaDB [db1]> insert t1 (name) values('user1');

#在第二个节点上执行,偶数增长

MariaDB [db1]> insert t1 (name) values('user2');

#两个节点同时插入数据

MariaDB [db1]> insert t1 (name) values('userX');

MariaDB [db1]> select * from t1;

+----+-------+

| id | name |

+----+-------+

| 1 | user1 |

| 2 | user2 |

| 3 | userX |

| 4 | userX |

+----+-------+

4 rows in set (0.001 sec)

#两个节点同时创建数据库,发生复制冲突

MariaDB [db1]> create database db2;

MariaDB [db1]> show slave status\G

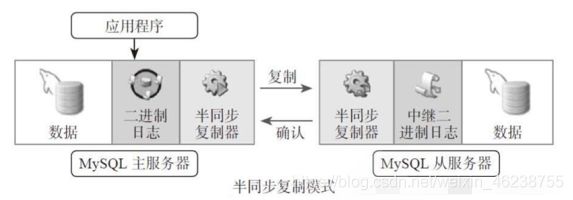

6.1.6 半同步复制

默认情况下,MySQL的复制功能是异步的(客户端更新数据,主服务器收到后立刻返回成功结果,但此时数据还并没有复制到从服务器上),异步复制可以提供最佳的性能,主库把binlog日志发送给从库即结束,并不验证从库是否接收完毕。这意味着当主服务器或从服务器端发生故障时,有可能从服务器没有接收到主服务器发送过来的binlog日志,这就会造成主服务器和从服务器的数据不一致,甚至在恢复时造成数据的丢失

半同步复制实现:

客户端发请求写操作发送给主服务器,主服务器在自己服务器上更新,找一个从节点复制且必须复制成功(也就是所有从节点中至少有一个成功),最后主服务器把成功结果返还给客户端

说明:半同步机制里,任何一个从节点超过10秒(默认)没复制成功,主服务器就告诉客户数据已经更新成功

官方文档: https://mariadb.com/kb/en/library/semisynchronous-replication/

范例:CentOS 8 在Mariadb-10.3.11上实现 实现半同步复制

#在master实现,启用半同步功能

[root@master ~]#vim /etc/my.cnf.d/mariadb-server.cnf

[mysqld]

server-id=8

log-bin

plugin-load-add = semisync_master

rpl_semi_sync_master_enabled=ON

rpl_semi_sync_master_timeout=3000 #设置3s内无法同步,也将返回成功信息给客户端

[root@centos8 ~]#systemctl restart mariadb

MariaDB [(none)]> SHOW GLOBAL VARIABLES LIKE '%semi%';

+---------------------------------------+--------------+

| Variable_name | Value |

+---------------------------------------+--------------+

| rpl_semi_sync_master_enabled | ON |

| rpl_semi_sync_master_timeout | 3000 |

| rpl_semi_sync_master_trace_level | 32 |

| rpl_semi_sync_master_wait_no_slave | ON |

| rpl_semi_sync_master_wait_point | AFTER_COMMIT |

| rpl_semi_sync_slave_delay_master | OFF |

| rpl_semi_sync_slave_enabled | OFF |

| rpl_semi_sync_slave_kill_conn_timeout | 5 |

| rpl_semi_sync_slave_trace_level | 32 |

+---------------------------------------+--------------+

9 rows in set (0.002 sec)

MariaDB [(none)]> show global status like '%semi%';

+--------------------------------------------+-------+

| Variable_name | Value |

+--------------------------------------------+-------+

| Rpl_semi_sync_master_clients | 0 |

| Rpl_semi_sync_master_get_ack | 0 |

| Rpl_semi_sync_master_net_avg_wait_time | 0 |

| Rpl_semi_sync_master_net_wait_time | 0 |

| Rpl_semi_sync_master_net_waits | 0 |

| Rpl_semi_sync_master_no_times | 0 |

| Rpl_semi_sync_master_no_tx | 0 |

| Rpl_semi_sync_master_request_ack | 0 |

| Rpl_semi_sync_master_status | ON |

| Rpl_semi_sync_master_timefunc_failures | 0 |

| Rpl_semi_sync_master_tx_avg_wait_time | 0 |

| Rpl_semi_sync_master_tx_wait_time | 0 |

| Rpl_semi_sync_master_tx_waits | 0 |

| Rpl_semi_sync_master_wait_pos_backtraverse | 0 |

| Rpl_semi_sync_master_wait_sessions | 0 |

| Rpl_semi_sync_master_yes_tx | 0 |

| Rpl_semi_sync_slave_send_ack | 1 |

| Rpl_semi_sync_slave_status | OFF |

+--------------------------------------------+-------+

18 rows in set (0.001 sec)

MariaDB [(none)]> show master logs;

+--------------------+-----------+

| Log_name | File_size |

+--------------------+-----------+

| mariadb-bin.000001 | 28198 |

| mariadb-bin.000002 | 344 |

+--------------------+-----------+

2 rows in set (0.000 sec)

MariaDB [(none)]> grant replication slave on *.* to repluser@'10.0.0.%' identified by 'magedu';

Query OK, 0 rows affected (3.001 sec)

#在其它所有slave节点上都实现,启用半同步功能

[root@slave ~]#vim /etc/my.cnf.d/mariadb-server.cnf

[mysqld]

server-id=18

plugin_load_add = semisync_slave

rpl_semi_sync_slave_enabled=ON

[root@slave ~]#systemctl restart mariadb

[root@slave ~]#mysql

MariaDB [(none)]> show global variables like '%semi%';

+---------------------------------------+--------------+

| Variable_name | Value |

+---------------------------------------+--------------+

| rpl_semi_sync_master_enabled | OFF |

| rpl_semi_sync_master_timeout | 10000 |

| rpl_semi_sync_master_trace_level | 32 |

| rpl_semi_sync_master_wait_no_slave | ON |

| rpl_semi_sync_master_wait_point | AFTER_COMMIT |

| rpl_semi_sync_slave_delay_master | OFF |

| rpl_semi_sync_slave_enabled | ON |

| rpl_semi_sync_slave_kill_conn_timeout | 5 |

| rpl_semi_sync_slave_trace_level | 32 |

+---------------------------------------+--------------+

9 rows in set (0.001 sec)

MariaDB [(none)]> SHOW GLOBAL STATUS LIKE '%semi%';

+--------------------------------------------+-------+

| Variable_name | Value |

+--------------------------------------------+-------+

| Rpl_semi_sync_master_clients | 0 |

| Rpl_semi_sync_master_get_ack | 0 |

| Rpl_semi_sync_master_net_avg_wait_time | 0 |

| Rpl_semi_sync_master_net_wait_time | 0 |

| Rpl_semi_sync_master_net_waits | 0 |

| Rpl_semi_sync_master_no_times | 0 |

| Rpl_semi_sync_master_no_tx | 0 |

| Rpl_semi_sync_master_request_ack | 0 |

| Rpl_semi_sync_master_status | OFF |

| Rpl_semi_sync_master_timefunc_failures | 0 |

| Rpl_semi_sync_master_tx_avg_wait_time | 0 |

| Rpl_semi_sync_master_tx_wait_time | 0 |

| Rpl_semi_sync_master_tx_waits | 0 |

| Rpl_semi_sync_master_wait_pos_backtraverse | 0 |

| Rpl_semi_sync_master_wait_sessions | 0 |

| Rpl_semi_sync_master_yes_tx | 0 |

| Rpl_semi_sync_slave_send_ack | 1 |

| Rpl_semi_sync_slave_status | ON |

+--------------------------------------------+-------+

18 rows in set (0.001 sec)

MariaDB [(none)]> CHANGE MASTER TO

-> MASTER_HOST='10.0.0.8',

-> MASTER_USER='repluser',

-> MASTER_PASSWORD='magedu',

-> MASTER_PORT=3306,

-> MASTER_LOG_FILE='mariadb-bin.000002',

-> MASTER_LOG_POS=344;

Query OK, 0 rows affected (0.008 sec)

MariaDB [(none)]> start slave;

Query OK, 0 rows affected (0.002 sec)

MariaDB [(none)]> show slave status\G;

*************************** 1. row ***************************

Slave_IO_State: Waiting for master to send event

Master_Host: 10.0.0.8

Master_User: repluser

Master_Port: 3306

Connect_Retry: 60

Master_Log_File: mariadb-bin.000002

Read_Master_Log_Pos: 541

Relay_Log_File: mariadb-relay-bin.000002

Relay_Log_Pos: 754

Relay_Master_Log_File: mariadb-bin.000002

Slave_IO_Running: Yes

Slave_SQL_Running: Yes

Replicate_Do_DB:

Replicate_Ignore_DB:

Replicate_Do_Table:

Replicate_Ignore_Table:

Replicate_Wild_Do_Table:

Replicate_Wild_Ignore_Table:

Last_Errno: 0

Last_Error:

Skip_Counter: 0

Exec_Master_Log_Pos: 541

Relay_Log_Space: 1065

Until_Condition: None

Until_Log_File:

Until_Log_Pos: 0

Master_SSL_Allowed: No

Master_SSL_CA_File:

Master_SSL_CA_Path:

Master_SSL_Cert:

Master_SSL_Cipher:

Master_SSL_Key:

Seconds_Behind_Master: 0

Master_SSL_Verify_Server_Cert: No

Last_IO_Errno: 0

Last_IO_Error:

Last_SQL_Errno: 0

Last_SQL_Error:

Replicate_Ignore_Server_Ids:

Master_Server_Id: 8

Master_SSL_Crl:

Master_SSL_Crlpath:

Using_Gtid: No

Gtid_IO_Pos:

Replicate_Do_Domain_Ids:

Replicate_Ignore_Domain_Ids:

Parallel_Mode: conservative

SQL_Delay: 0

SQL_Remaining_Delay: NULL

Slave_SQL_Running_State: Slave has read all relay log; waiting for the slave I/O thread to update it

Slave_DDL_Groups: 1

Slave_Non_Transactional_Groups: 0

Slave_Transactional_Groups: 0

1 row in set (0.000 sec)

#在master上实现

MariaDB [db1]> SHOW GLOBAL STATUS LIKE '%semi%';

+--------------------------------------------+-------+

| Variable_name | Value |

+--------------------------------------------+-------+

| Rpl_semi_sync_master_clients | 2 |

| Rpl_semi_sync_master_get_ack | 3 |

| Rpl_semi_sync_master_net_avg_wait_time | 0 |

| Rpl_semi_sync_master_net_wait_time | 0 |

| Rpl_semi_sync_master_net_waits | 3 |

| Rpl_semi_sync_master_no_times | 1 |

| Rpl_semi_sync_master_no_tx | 1 |

| Rpl_semi_sync_master_request_ack | 2 |

| Rpl_semi_sync_master_status | ON |

| Rpl_semi_sync_master_timefunc_failures | 0 |

| Rpl_semi_sync_master_tx_avg_wait_time | 3495 |

| Rpl_semi_sync_master_tx_wait_time | 3495 |

| Rpl_semi_sync_master_tx_waits | 1 |

| Rpl_semi_sync_master_wait_pos_backtraverse | 0 |

| Rpl_semi_sync_master_wait_sessions | 0 |

| Rpl_semi_sync_master_yes_tx | 1 |

| Rpl_semi_sync_slave_send_ack | 0 |

| Rpl_semi_sync_slave_status | OFF |

+--------------------------------------------+-------+

18 rows in set (0.002 sec)

#测试

#在master实现,创建数据库,立即成功

MariaDB [db1]> create database db2;

Query OK, 1 row affected (0.004 sec)

#在所有slave节点实现,停止复制线程

MariaDB [(none)]> stop slave;

Query OK, 0 rows affected (0.011 sec)

#在master实现,创建数据库,等待3s才能成功

MariaDB [db1]> create database db3;

Query OK, 1 row affected (3.003 sec)

#在任意一个slave节点实现,恢复复制线程

MariaDB [(none)]> start slave;

Query OK, 0 rows affected (0.006 sec)

#在master实现,创建数据库,立即成功

MariaDB [db1]> create database db4;

Query OK, 1 row affected (0.002 sec)

范例:CentOS 7 实现半同步复制

#主服务器配置:

INSTALL PLUGIN rpl_semi_sync_master SONAME 'semisync_master.so';

UNINSTALL PLUGIN rpl_semi_sync_master ;

SHOW PLUGINS; #查看插件

SET GLOBAL rpl_semi_sync_master_enabled=1;

SET GLOBAL rpl_semi_sync_master_timeout = 1000; #超时长1s,默认值为10s

SHOW GLOBAL VARIABLES LIKE '%semi%';

SHOW GLOBAL STATUS LIKE '%semi%';

#从服务器配置:

INSTALL PLUGIN rpl_semi_sync_slave SONAME 'semisync_slave.so';

SET GLOBAL rpl_semi_sync_slave_enabled=1;

#mariadb-10.3版以后

#主服务器配置:

[mysqld]

plugin_load_add = semisync_master

#从服务器配置:

[mysqld]

plugin_load_add = semisync_slave

6.1.7 复制过滤器

让从节点仅复制指定的数据库,或指定数据库的指定表

复制过滤器两种实现方式:

(1) 服务器选项:主服务器仅向二进制日志中记录与特定数据库相关的事件

此方法存在的问题:基于二进制还原将无法实现;不建议使用

注意:此项和binlog_format相关

参看:https://mariadb.com/kb/en/library/mysqld-options/#-binlog-ignore-db

vim /etc/my.cnf

binlog-do-db = #数据库白名单列表,不支持同时指定多个值,如果想实现多个数据库需多行实现

binlog-ignore-db = #数据库黑名单列表,不记录二进制

#以上两个都是服务器选项,只能改配置文件

范例:

#主服务器修改配置文件,修改为只有hellodb可以记录二进制日志

MariaDB [(none)]> show master status;

+--------------------+----------+--------------+------------------+

| File | Position | Binlog_Do_DB | Binlog_Ignore_DB |

+--------------------+----------+--------------+------------------+

| mariadb-bin.000003 | 344 | hellodb | |

+--------------------+----------+--------------+------------------+

1 row in set (0.000 sec)

#主服务器上查看hellodb库中teachers表并插入新的一行

MariaDB [hellodb]> select * from teachers;

+-----+---------------+-----+--------+

| TID | Name | Age | Gender |

+-----+---------------+-----+--------+

| 1 | Song Jiang | 45 | M |

| 2 | Zhang Sanfeng | 94 | M |

| 3 | Miejue Shitai | 77 | F |

| 4 | Lin Chaoying | 93 | F |

+-----+---------------+-----+--------+

4 rows in set (0.001 sec)

MariaDB [hellodb]> insert teachers (name,age,gender)values('mage',50,'M');

Query OK, 1 row affected (0.003 sec)

#从服务器上能查看到新的一行

MariaDB [hellodb]> select * from teachers;

+-----+---------------+-----+--------+

| TID | Name | Age | Gender |

+-----+---------------+-----+--------+

| 1 | Song Jiang | 45 | M |

| 2 | Zhang Sanfeng | 94 | M |

| 3 | Miejue Shitai | 77 | F |

| 4 | Lin Chaoying | 93 | F |

| 5 | mage | 50 | M |

+-----+---------------+-----+--------+

5 rows in set (0.000 sec)

#主服务器上创建一个新表

MariaDB [hellodb]> create database db5;

Query OK, 1 row affected (0.000 sec)

#从服务器上查看不到

MariaDB [hellodb]> show databases;

+--------------------+

| Database |

+--------------------+

| db1 |

| db2 |

| db3 |

| db4 |

| hellodb |

| information_schema |

| mysql |

| performance_schema |

+--------------------+

8 rows in set (0.001 sec)

注意:

This option will not work with cross-database updates with statement-based

logging. See the Statement-Based Logging section for more information.

This option can not be set dynamically.

When setting it on the command-line or in a server option group in an option file, the option does not accept a comma-separated list. If you would like to specify multiple filters, then you need to specify the option multiple times.

(2) 从服务器SQL_THREAD在relay log(中继日志)中的事件时,仅读取与特定数据库(特定表)相关的事件并应用于本地

此方法存在的问题:会造成网络及磁盘IO浪费

从服务器上的复制过滤器相关变量

replicate_do_db=db1,db2,db3 #指定复制库的白名单,变量可以指定逗号分隔的多个值,选项不支持多值,只能分别写多行实现

replicate_ignore_db= #指定复制库黑名单,既是服务器选项又是变量

replicate_do_table= #指定复制表的白名单

replicate_ignore_table= #指定复制表的黑名单

replicate_wild_do_table= foo%.bar% #支持通配符

replicate_wild_ignore_tablemysql=

When setting it dynamically with SET GLOBAL, the system variable accepts a

comma-separated list of filters.

When setting it on the command-line or in a server option group in an option file, the system variable does not accept a comma-separated list. If you would like to specify multiple filters, then you need to specify the system variable multiple times.

注意:跨库的更新将无法同步

范例:

[mysqld]

replicate_do_db=db1

replicate_do_db=db2

replicate_do_db=db3

MariaDB [db1]> create table db2.t1(id int);

Query OK, 0 rows affected (0.010 sec)

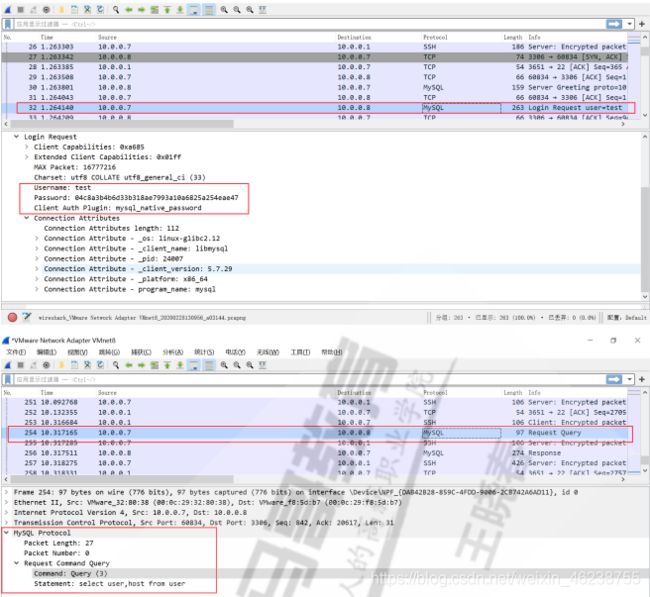

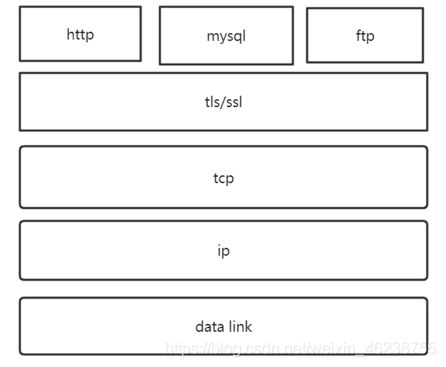

6.1.8 主从复制加密

基于SSL复制:在默认的主从复制过程或远程连接到MySQL/MariaDB所有的链接通信中的数据都是明文的,外网里访问数据或则复制,存在安全隐患。通过SSL/TLS加密的方式进行复制的方法,来进一步提高数据的安全性

官网文档:https://mariadb.com/kb/en/library/replication-with-secure-connections/

实现MySQL复制加密

- 生成 CA 及 master 和 slave 的证书

[root@master ~]#mkdir /etc/my.cnf.d/ssl/

[root@master ~]#cat ca.sh

#!/bin/bash

. /etc/init.d/functions

CERT_INFO=([00]="/O=magedu/CN=ca.magedu.org" \

[01]="cakey.pem" \

[02]="cacert.pem" \

[03]=2048 \

[04]=3650 \

[05]=0 \

[10]="/C=CN/ST=hubei/L=wuhan/O=magedu/CN=master.magedu.org" \

[11]="master.key" \

[12]="master.crt" \

[13]=2048 \

[14]=365

[15]=1 \

[16]="master.csr" \

[20]="/C=CN/ST=hubei/L=wuhan/O=magedu/CN=slave.cuiqinghe.org" \

[21]="slave.key" \

[22]="slave.crt" \

[23]=2048 \

[24]=365 \

[25]=2 \

[26]="slave.csr" )

COLOR="echo -e \\E[1;32m"

END="\\E[0m"

DIR=/data

cd $DIR

for i in {0..2};do

if [ $i -eq 0 ] ;then

openssl req -x509 -newkey rsa:${CERT_INFO[${i}3]} -subj ${CERT_INFO[${i}0]} \

-set_serial ${CERT_INFO[${i}5]} -keyout ${CERT_INFO[${i}1]} -nodes -days ${CERT_INFO[${i}4]} \

-out ${CERT_INFO[${i}2]} &>/dev/null

else

openssl req -newkey rsa:${CERT_INFO[${i}3]} -nodes -subj ${CERT_INFO[${i}0]} \

-keyout ${CERT_INFO[${i}1]} -out ${CERT_INFO[${i}6]} &>/dev/null

openssl x509 -req -in ${CERT_INFO[${i}6]} -CA ${CERT_INFO[02]} -CAkey ${CERT_INFO[01]} \

-set_serial ${CERT_INFO[${i}5]} -days ${CERT_INFO[${i}4]} -out ${CERT_INFO[${i}2]} &>/dev/null

fi

$COLOR"**************************************生成证书信息**************************************"$END

openssl x509 -in ${CERT_INFO[${i}2]} -noout -subject -dates -serial

echo

done

chmod 600 *.key

action "证书生成完成"

#执行脚本生成证书

[root@master ~]#bash ca.sh

**************************************生成证书信息**************************************

subject=O = magedu, CN = ca.magedu.org

notBefore=Jun 16 07:27:05 2020 GMT

notAfter=Jun 14 07:27:05 2030 GMT

serial=00

**************************************生成证书信息**************************************

subject=C = CN, ST = hubei, L = wuhan, O = magedu, CN = master.magedu.org

notBefore=Jun 16 07:27:05 2020 GMT

notAfter=Jun 16 07:27:05 2021 GMT

serial=01

**************************************生成证书信息**************************************

subject=C = CN, ST = hubei, L = wuhan, O = magedu, CN = slave.cuiqinghe.org

notBefore=Jun 16 07:27:05 2020 GMT

notAfter=Jun 16 07:27:05 2021 GMT

serial=02

证书生成完成 [ OK ]

[root@master ~]#tree /data/

/data/

├── cacert.pem

├── cakey.pem

├── master.crt

├── master.csr

├── master.key

├── slave.crt

├── slave.csr

└── slave.key

0 directories, 8 files

[root@master ~]#cp /data/* /etc/my.cnf.d/ssl/

[root@master ~]#cd /etc/my.cnf.d/ssl/

[root@master ssl]#ll

total 32

-rw-r--r-- 1 root root 1143 Jun 16 15:28 cacert.pem

-rw------- 1 root root 1704 Jun 16 15:28 cakey.pem

-rw-r--r-- 1 root root 1090 Jun 16 15:28 master.crt

-rw-r--r-- 1 root root 985 Jun 16 15:28 master.csr

-rw------- 1 root root 1704 Jun 16 15:28 master.key

-rw-r--r-- 1 root root 1090 Jun 16 15:28 slave.crt

-rw-r--r-- 1 root root 989 Jun 16 15:28 slave.csr

-rw------- 1 root root 1704 Jun 16 15:28 slave.key

[root@master ssl]#chown -R mysql.mysql /etc/my.cnf.d/ssl/

[root@master ssl]#ll

total 32

-rw-r--r-- 1 mysql mysql 1143 Jun 16 15:28 cacert.pem

-rw------- 1 mysql mysql 1704 Jun 16 15:28 cakey.pem

-rw-r--r-- 1 mysql mysql 1090 Jun 16 15:28 master.crt

-rw-r--r-- 1 mysql mysql 985 Jun 16 15:28 master.csr

-rw------- 1 mysql mysql 1704 Jun 16 15:28 master.key

-rw-r--r-- 1 mysql mysql 1090 Jun 16 15:28 slave.crt

-rw-r--r-- 1 mysql mysql 989 Jun 16 15:28 slave.csr

-rw------- 1 mysql mysql 1704 Jun 16 15:28 slave.key

- 主服务器开启 SSL,配置证书和私钥路径

[mysqld]

log-bin

server_id=1

ssl

ssl-ca=/etc/my.cnf.d/ssl/cacert.pem

ssl-cert=/etc/my.cnf.d/ssl/master.crt

ssl-key=/etc/my.cnf.d/ssl/master.key

MariaDB [(none)]> show variables like '%ssl%';

+---------------------+----------------------------------+

| Variable_name | Value |

+---------------------+----------------------------------+

| have_openssl | YES |

| have_ssl | YES |

| ssl_ca | /etc/my.cnf.d/ssl/cacert.pem |

| ssl_capath | |

| ssl_cert | /etc/my.cnf.d/ssl/master.crt |

| ssl_cipher | |

| ssl_crl | |

| ssl_crlpath | |

| ssl_key | /etc/my.cnf.d/ssl/master.key |

| version_ssl_library | OpenSSL 1.1.1c FIPS 28 May 2019 |

+---------------------+----------------------------------+

10 rows in set (0.001 sec)

- 创建一个要求必须使用 SSL 连接的复制账号

GRANT REPLICATION SLAVE ON *.* TO 'repluser'@'10.0.0.%' IDENTIFIED BY 'magedu' REQUIRE SSL;

- 从服务器slave上使用CHANGER MASTER TO 命令时指明ssl相关选项

[root@slave1 ~]#mysql -urepluser -pmagedu -h10.0.0.8

ERROR 1045 (28000): Access denied for user 'repluser'@'10.0.0.18' (using password: YES)

[root@centos8 ~]#mysql -urepluser -pmagedu -h10.0.0.8 --ssl-ca=/etc/my.cnf.d/ssl/cacert.pem --ssl-cert=/etc/my.cnf.d/ssl/slave.crt --ssl-key=/etc/my.cnf.d/ssl/slave.key

MariaDB [(none)]>

MariaDB [(none)]> \s

--------------

mysql Ver 15.1 Distrib 10.3.17-MariaDB, for Linux (x86_64) using readline 5.1

Connection id: 53

Current database:

Current user: [email protected]

SSL: Cipher in use is TLS_AES_256_GCM_SHA384 #已加密

Current pager: stdout

Using outfile: ''

Using delimiter: ;

Server: MariaDB

Server version: 10.3.17-MariaDB-log MariaDB Server

Protocol version: 10

Connection: 10.0.0.8 via TCP/IP

Server characterset: latin1

Db characterset: latin1

Client characterset: utf8

Conn. characterset: utf8

TCP port: 3306

Uptime: 23 min 4 sec

Threads: 10 Questions: 11 Slow queries: 0 Opens: 17 Flush tables: 1 Open tables: 11 Queries per second avg: 0.007

--------------

#主服务器上查看进程

MariaDB [(none)]> show processlist;

+----+-------------+-----------------+------+---------+------+--------------------------+------------------+----------+

| Id | User | Host | db | Command | Time | State | Info | Progress |

+----+-------------+-----------------+------+---------+------+--------------------------+------------------+----------+

| 1 | system user | | NULL | Daemon | NULL | InnoDB purge worker | NULL | 0.000 |

| 2 | system user | | NULL | Daemon | NULL | InnoDB purge coordinator | NULL | 0.000 |

| 3 | system user | | NULL | Daemon | NULL | InnoDB purge worker | NULL | 0.000 |

| 4 | system user | | NULL | Daemon | NULL | InnoDB purge worker | NULL | 0.000 |

| 5 | system user | | NULL | Daemon | NULL | InnoDB shutdown handler | NULL | 0.000 |

| 9 | root | localhost | NULL | Query | 0 | Init | show processlist | 0.000 |

| 53 | repluser | 10.0.0.18:56006 | NULL | Sleep | 35 | | NULL | 0.000 |

+----+-------------+-----------------+------+---------+------+--------------------------+------------------+----------+

7 rows in set (0.001 sec)

[root@centos8 ~]#vim /etc/my.cnf.d/mariadb-server.cnf

[mysqld]

server-id=2

#可选方式1

ssl

ssl-ca=/etc/my.cnf.d/ssl/cacert.pem

ssl-cert=/etc/my.cnf.d/ssl/slave.crt

ssl-key=/etc/my.cnf.d/ssl/slave.key

MariaDB [(none)]> CHANGE MASTER TO

MASTER_HOST='10.0.0.8',

MASTER_USER='repluser',

MASTER_PASSWORD='magedu',

MASTER_PORT=3306,

MASTER_LOG_FILE='mariadb-bin.000002',

MASTER_LOG_POS=344,

MASTER_SSL=1;

#可选方式2

MariaDB [(none)]> CHANGE MASTER TO

MASTER_HOST='10.0.0.8',

MASTER_USER='repluser',

MASTER_PASSWORD='magedu',

MASTER_PORT=3306,

MASTER_LOG_FILE='mariadb-bin.000002',

MASTER_LOG_POS=344,

MASTER_SSL=1,

MASTER_SSL_CA = '/etc/my.cnf.d/ssl/cacert.pem',

MASTER_SSL_CERT = '/etc/my.cnf.d/ssl/slave.crt',

MASTER_SSL_KEY = '/etc/my.cnf.d/ssl/slave.key';

MariaDB [(none)]> start slave;

Query OK, 0 rows affected (0.001 sec)

MariaDB [(none)]> show slave status\G;

*************************** 1. row ***************************

Slave_IO_State: Waiting for master to send event

Master_Host: 10.0.0.8

Master_User: repluser

Master_Port: 3306

Connect_Retry: 60

Master_Log_File: mariadb-bin.000002

Read_Master_Log_Pos: 682

Relay_Log_File: mariadb-relay-bin.000002

Relay_Log_Pos: 895

Relay_Master_Log_File: mariadb-bin.000002

Slave_IO_Running: Yes

Slave_SQL_Running: Yes

Replicate_Do_DB:

Replicate_Ignore_DB:

Replicate_Do_Table:

Replicate_Ignore_Table:

Replicate_Wild_Do_Table:

Replicate_Wild_Ignore_Table:

Last_Errno: 0

Last_Error:

Skip_Counter: 0

Exec_Master_Log_Pos: 682

Relay_Log_Space: 1206

Until_Condition: None

Until_Log_File:

Until_Log_Pos: 0

Master_SSL_Allowed: Yes

1 row in set (0.000 sec)

6.1.9 GTID复制

GTID复制:(Global Transaction ID 全局事务标识符) MySQL 5.6 版本开始支持,GTID复制不像传统的复制方式(异步复制、半同步复制)需要找到binlog文件名和POS点,只需知道master的IP、端口、账号、密码即可。开启GTID后,执行change master to master_auto_postion=1即可,它会自动寻找到相应的位置开始同步

GTID 架构

GTID = server_uuid:transaction_id,在一组复制中,全局唯一

server_uuid 来源于 /var/lib/mysql/auto.cnf

GTID服务器相关选项

gtid_mode #gtid模式

enforce_gtid_consistency #保证GTID安全的参数

GTID配置范例

- 主服务器

vim /etc/my.cnf

server-id=1

log-bin=mysql-bin #可选

gtid_mode=ON

enforce_gtid_consistency

mysql> grant replication slave on *.* to 'repluser'@'10.0.0.%' identified by 'magedu';

- 从服务器

vim /etc/my.cnf

server-id=2

gtid_mode=ON

enforce_gtid_consistency

mysql>CHANGE MASTER TO MASTER_HOST='10.0.0.100',

MASTER_USER='repluser',

MASTER_PASSWORD='magedu',

MASTER_PORT=3306,

MASTER_AUTO_POSITION=1;

mysql>start slave;

#主服务器上的日志节点

mysql> show master logs;

+--------------------+-----------+

| Log_name | File_size |

+--------------------+-----------+

| centos8-bin.000001 | 177 |

| centos8-bin.000002 | 437 |

| centos8-bin.000003 | 448 |

+--------------------+-----------+

3 rows in set (0.00 sec)

#从服务器

mysql> show slave status\G;

*************************** 1. row ***************************

Slave_IO_State: Waiting for master to send event

Master_Host: 10.0.0.8

Master_User: repluser

Master_Port: 3306

Connect_Retry: 60

Master_Log_File: centos8-bin.000003

Read_Master_Log_Pos: 448

Relay_Log_File: centos8-relay-bin.000002

Relay_Log_Pos: 665

Relay_Master_Log_File: centos8-bin.000003

Slave_IO_Running: Yes

Slave_SQL_Running: Yes

Replicate_Do_DB:

Replicate_Ignore_DB:

Replicate_Do_Table:

Replicate_Ignore_Table:

Replicate_Wild_Do_Table:

Replicate_Wild_Ignore_Table:

Last_Errno: 0

Last_Error:

Skip_Counter: 0

Exec_Master_Log_Pos: 448

Relay_Log_Space: 874

Until_Condition: None

Until_Log_File:

Until_Log_Pos: 0

Master_SSL_Allowed: No

Master_SSL_CA_File:

Master_SSL_CA_Path:

Master_SSL_Cert:

Master_SSL_Cipher:

Master_SSL_Key:

Seconds_Behind_Master: 0

Master_SSL_Verify_Server_Cert: No

Last_IO_Errno: 0

Last_IO_Error:

Last_SQL_Errno: 0

Last_SQL_Error:

Replicate_Ignore_Server_Ids:

Master_Server_Id: 1

Master_UUID: f61f784f-afbe-11ea-8710-000c2930800a

Master_Info_File: /data/mysql/master.info

SQL_Delay: 0

SQL_Remaining_Delay: NULL

Slave_SQL_Running_State: Slave has read all relay log; waiting for more updates

Master_Retry_Count: 86400

Master_Bind:

Last_IO_Error_Timestamp:

Last_SQL_Error_Timestamp:

Master_SSL_Crl:

Master_SSL_Crlpath:

Retrieved_Gtid_Set: f61f784f-afbe-11ea-8710-000c2930800a:1

Executed_Gtid_Set: f61f784f-afbe-11ea-8710-000c2930800a:1

Auto_Position: 1

Replicate_Rewrite_DB:

Channel_Name:

Master_TLS_Version:

1 row in set (0.01 sec)

6.1.10 复制的监控和维护

(1) 清理日志

PURGE { BINARY | MASTER } LOGS { TO 'log_name' | BEFORE datetime_expr }

RESET MASTER TO # #mysql 不支持

RESET SLAVE [ALL] #清理二进制日志在从节点上生成的信息

(2) 复制监控

SHOW MASTER STATUS

SHOW BINARY LOGS

SHOW BINLOG EVENTS

SHOW SLAVE STATUS

SHOW PROCESSLIST

(3) 从服务器是否落后于主服务

Seconds_Behind_Master:0 #0代表主节点和从节点完全同步

(4) 如何确定主从节点数据是否一致

percona-toolkit

(5) 数据不一致如何修复

删除从数据库,重新复制

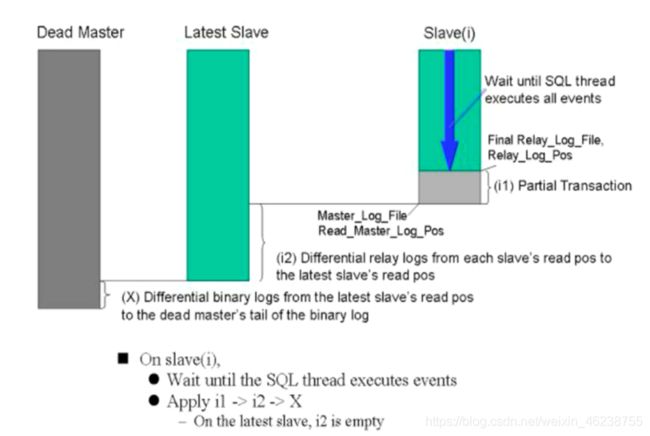

6.1.11 复制的问题和解决方案

6.1.11.1 数据损坏或丢失

- Master:MHA + semisync replication

- Slave: 重新复制

6.1.11.2 不惟一的server id

重新复制

6.1.11.3 复制延迟

- 需要额外的监控工具的辅助

- 一从多主:mariadb10 版后支持

- 多线程复制:对多个数据库复制

6.1.11.4 MySQL主从数据不一致

-

造成主从不一致的原因

- 主库binlog格式为Statement,同步到从库执行后可能造成主从不一致。

- 主库执行更改前有执行set sql_log_bin=0,会使主库不记录binlog,从库也无法变更这部分数据。

- 从节点未设置只读,误操作写入数据

- 主库或从库意外宕机,宕机可能会造成binlog或者relaylog文件出现损坏,导致主从不一致

- 主从实例版本不一致,特别是高版本是主,低版本为从的情况下,主数据库上面支持的功能,从数据库上面可能不支持该功能

- MySQL自身bug导致

-

主从不一致修复方法

-

将从库重新实现

虽然这也是一种解决方法,但是这个方案恢复时间比较慢,而且有时候从库也是承担一部分的查询操作的,不能贸然重建。 -

使用percona-toolkit工具辅助

PT工具包中包含pt-table-checksum和pt-table-sync两个工具,主要用于检测主从是否一致以及修复数据不一致情况。这种方案优点是修复速度快,不需要停止主从辅助,缺点是需要知识积累,需要时间去学习,去测试,特别是在生产环境,还是要小心使用

关于使用方法,可以参考下面链接:https://www.cnblogs.com/feiren/p/7777218.html

-

-

手动重建不一致的表

在从库发现某几张表与主库数据不一致,而这几张表数据量也比较大,手工比对数据不现实,并且重做整个库也比较慢,这个时候可以只重做这几张表来修复主从不一致这种方案缺点是在执行导入期间需要暂时停止从库复制,不过也是可以接受的

范例:A,B,C这三张表主从数据不一致

1、从库停止Slave复制 mysql>stop slave; 2、在主库上dump这三张表,并记录下同步的binlog和POS点 mysqldump -uroot -pmagedu -q --single-transaction --master-data=2 testdb A B C >/backup/A_B_C.sql 3、查看A_B_C.sql文件,找出记录的binlog和POS点 head A_B_C.sql 例如:MASTERLOGFILE='mysql-bin.888888', MASTERLOGPOS=666666; 4、把A_B_C.sql拷贝到Slave机器上,并做指向新位置 mysql>start slave until MASTERLOGFILE='mysql-bin.888888', MASTERLOGPOS=666666; #以上指令是为了保障其他表的数据不丢失,一直同步,直到同步完那个点结束,A,B,C表的数据在之前的备份已经生成了一份快照,只需要导入进入,然后开启同步即可 5、在Slave机器上导入A_B_C.sql mysql -uroot -pmagedu testdb mysql>set sql_log_bin=0; mysql>source /backup/A_B_C.sql mysql>set sql_log_bin=1; 6、导入完毕后,从库开启同步即可。 mysql>start slave;

- 如何避免主从不一致

- 主库binlog采用ROW格式

- 主从实例数据库版本保持一致

- 主库做好账号权限把控,不可以执行set sql_log_bin=0

- 从库开启只读,不允许人为写入

- 定期进行主从一致性检验

6.2 MySQL 中间件代理服务器

6.2.1 关系型数据库和 NoSQL 数据库

数据库主要分为两大类:关系型数据库与 NoSQL 数据库。

-

关系型数据库,是建立在关系模型基础上的数据库,其借助于集合代数等数学概念和方法来处理数据库中的数据。主流的 MySQL、Oracle、MS SQL Server 和 DB2 都属于这类传统数据库。

-

NoSQL 数据库,全称为 Not Only SQL,意思就是适用关系型数据库的时候就使用关系型数据库,不适用的时候也没有必要非使用关系型数据库不可,可以考虑使用更加合适的数据存储。主要分为临时性键值存储 (memcached、Redis)、永久性键值存储(ROMA、Redis)、面向文档的数据库(MongoDB、CouchDB)、面向列的数据库(Cassandra、HBase),每种 NoSQL 都有其特有的使用场景及优点。

Oracle,mysql 等传统的关系数据库非常成熟并且已大规模商用,为什么还要用 NoSQL 数据库呢?主要是由于随着互联网发展,数据量越来越大,对性能要求越来越高,传统数据库存在着先天性的缺陷,即单机(单库)性能瓶颈,并且扩展困难。这样既有单机单库瓶颈,却又扩展困难,自然无法满足日益增长的海量数据存储及其性能要求,所以才会出现了各种不同的 NoSQL 产品,NoSQL 根本性的优势在于在云计算时代,简单、易于大规模分布式扩展,并且读写性能非常高

RDBMS和NOSQL的特点及优缺点:

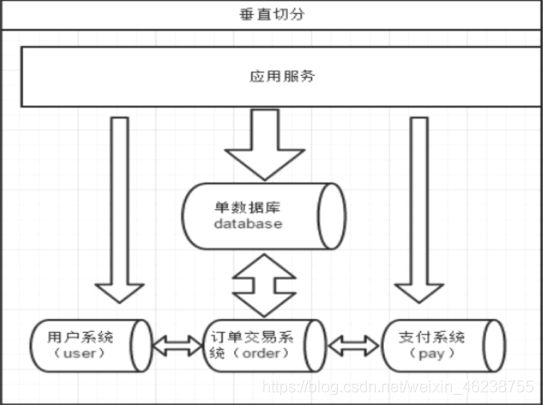

6.2.2 数据切分

简单来说,就是指通过某种特定的条件,将我们存放在同一个数据库中的数据分散存放到多个数据库(主机) 上面,以达到分散单台设备负载的效果。

数据的切分(Sharding)根据其切分规则的类型,可以分为两种切分模式。

一种是按照不同的表(或者 Schema)来切分到不同的数据库(主机)之上,这种切可以称之为数据的垂直(纵向)切分;另外一种则是根据 表中的数据的逻辑关系,将同一个表中的数据按照某种条件拆分到多台数据库(主机)上面,这种切分称之为数据的水平(横向)切分。

垂直切分的最大特点就是规则简单,实施也更为方便,尤其适合各业务之间的耦合度非常低,相互影响很小, 业务逻辑非常清晰的系统。在这种系统中,可以很容易做到将不同业务模块所使用的表分拆到不同的数据库中。 根据不同的表来进行拆分,对应用程序的影响也更小,拆分规则也会比较简单清晰。

水平切分于垂直切分相比,相对来说稍微复杂一些。因为要将同一个表中的不同数据拆分到不同的数据库中, 对于应用程序来说,拆分规则本身就较根据表名来拆分更为复杂,后期的数据维护也会更为复杂一些。

6.2.2.1 垂直切分

表之间不能有连接关系

一个数据库由很多表的构成,每个表对应着不同的业务,垂直切分是指按照业务将表进行分类,分布到不同的数据库上面,这样也就将数据或者说压力分担到不同的库上面,如下图:

系统被切分成了,用户,订单交易,支付几个模块。 一个架构设计较好的应用系统,其总体功能肯定是由很多个功能模块所组成的,而每一个功能模块所需要的数据对应到数据库中就是一个或者多个表。而在架构设计中,各个功能模块相互之间的交互点越统一越少,系统的耦合度就越低,系统各个模块的维护性以及扩展性也就越好。这样的系统,实现数据的垂直切分也就越容易。

但是往往系统之有些表难以做到完全独立,存在着跨库 join 的情况,对于这类表,就需要去做平衡,是数据库让步业务,共用一个数据源,还是分成多个库,业务之间通过接口来做调用。在系统初期数据量比较 少,或者资源有限的情况下,会选择共用数据源,但是当数据发展到了一定的规模,负载很大的情况,就需要必须去做分割。

一般来讲业务存在着复杂 join 的场景是难以切分的,往往业务独立的易于切分。如何切分,切分到何种程度是考验技术架构的一个难题。

垂直切分的优缺点:

优点:

- 拆分后业务清晰,拆分规则明确

- 系统之间整合或扩展容易

- 数据维护简

缺点:

- 部分业务表无法 join,只能通过接口方式解决,提高了系统复杂度;

- 受每种业务不同的限制存在单库性能瓶颈,不易数据扩展跟性能提高

- 事务处理复杂

由于垂直切分是按照业务的分类将表分散到不同的库,所以有些业务表会过于庞大,存在单库读写与存储瓶颈,所以就需要水平拆分来做解决。

6.2.2.2 水平切分

对应shard中查询相关数据

相对于垂直拆分,水平拆分不是将表做分类,而是按照某个字段的某种规则来分散到多个库之中,每个表中包含一部分数据。简单来说,我们可以将数据的水平切分理解为是按照数据行的切分,就是将表中的某些行切分 到一个数据库,而另外的某些行又切分到其他的数据库中,如图:

拆分数据就需要定义分片规则。关系型数据库是行列的二维模型,拆分的第一原则是找到拆分维度。比如: 从会员的角度来分析,商户订单交易类系统中查询会员某天某月某个订单,那么就需要按照会员结合日期来拆分, 不同的数据按照会员 ID 做分组,这样所有的数据查询 join 都会在单库内解决;如果从商户的角度来讲,要查询某 个商家某天所有的订单数,就需要按照商户 ID 做拆分;但是如果系统既想按会员拆分,又想按商家数据,则会有 一定的困难。如何找到合适的分片规则需要综合考虑衡量。

几种典型的分片规则包括:

- 按照用户 ID 求模,将数据分散到不同的数据库,具有相同数据用户的数据都被分散到一个库中

- 按照日期,将不同月甚至日的数据分散到不同的库中

- 按照某个特定的字段求摸,或者根据特定范围段分散到不同的库中

如图,切分原则都是根据业务找到适合的切分规则分散到不同的库,下面用用户 ID 求模举例:

既然数据做了拆分有优点也就优缺点。

优点:

- 拆分规则抽象好,join 操作基本可以数据库做

- 不存在单库大数据,高并发的性能瓶颈

- 应用端改造较少

- 提高了系统的稳定性跟负载能力

缺点:

- 拆分规则难以抽象

- 分片事务一致性难以解决

- 数据多次扩展难度跟维护量极大

- 跨库 join 性能较差

前面讲了垂直切分跟水平切分的不同跟优缺点,会发现每种切分方式都有缺点,但共同特点缺点有:

- 引入分布式事务的问题

- 跨节点 Join 的问题

- 跨节点合并排序分页问题

- 多数据源管理问题

针对数据源管理,目前主要有两种思路:

A. 客户端模式,在每个应用程序模块中配置管理自己需要的一个(或者多个)数据源,直接访问各个数据库, 在模块内完成数据的整合

B. 通过中间代理层来统一管理所有的数据源,后端数据库集群对前端应用程序透明; 可能 90%以上的人在面对上面这两种解决思路的时候都会倾向于选择第二种,尤其是系统不断变得庞大复杂 的时候。确实,这是一个非常正确的选择,虽然短期内需要付出的成本可能会相对更大一些,但是对整个系统的 扩展性来说,是非常有帮助的。

MySQL中间件服务器可以通过将数据切分解决传统数据库的缺陷,又有了 NoSQL 易于扩展的优点。通过中间代理层规避了多数 据源的处理问题,对应用完全透明,同时对数据切分后存在的问题,也做了解决方案。

由于数据切分后数据 Join 的难度在此也分享一下数据切分的经验:

第一原则:能不切分尽量不要切分

第二原则:如果要切分一定要选择合适的切分规则,提前规划好。

第三原则:数据切分尽量通过数据冗余或表分组(Table Group)来降低跨库 Join 的可能

第四原则:由于数据库中间件对数据 Join 实现的优劣难以把握,而且实现高性能难度极大,业务读取尽量 少使用多表 Join。

6.2.3 MySQL中间件各种应用

mysql-proxy:Oracle,https://downloads.mysql.com/archives/proxy/

Atlas:Qihoo,https://github.com/Qihoo360/Atlas/blob/master/README_ZH.md

dbproxy:美团,https://github.com/Meituan-Dianping/DBProxy

Cetus:网易乐得,https://github.com/Lede-Inc/cetus

Amoeba:https://sourceforge.net/projects/amoeba/

Cobar:阿里巴巴,Amoeba的升级版, https://github.com/alibaba/cobar

Mycat:基于Cobar http://www.mycat.io/ (原网站)

http://www.mycat.org.cn/

https://github.com/MyCATApache/Mycat-Server

ProxySQL:https://proxysql.com/

6.2.4 Mycat

6.2.4.1 Mycat介绍

在整个IT系统架构中,数据库是非常重要,通常又是访问压力较大的一个服务,除了在程序开发的本身做优化,如:SQL语句优化、代码优化,数据库的处理本身优化也是非常重要的。主从、热备、分表分库等都是系统发展迟早会遇到的技术问题问题。Mycat是一个广受好评的数据库中间件,已经在很多产品上进行使用了。

Mycat是一个开源的分布式数据库系统,是一个实现了MySQL协议的服务器,前端用户可以把它看作是一个数据库代理(类似于Mysql Proxy),用MySQL客户端工具和命令行访问,而其后端可以用MySQL原生协议与多个MySQL服务器通信,也可以用JDBC协议与大多数主流数据库服务器通信,其核心功能是分表分库,即将一个大表水平分割为N个小表,存储在后端MySQL服务器里或者其他数据库里。

Mycat发展到目前的版本,已经不是一个单纯的MySQL代理了,它的后端可以支持MySQL、SQL Server、Oracle、DB2、PostgreSQL等主流数据库,也支持MongoDB这种新型NoSQL方式的存储,未来还会支持更多类型的存储。而在最终用户看来,无论是那种存储方式,在MyCat里,都是一个传统的数据库表,支持标准的SQL语句进行数据的操作,这样一来,对前端业务系统来说,可以大幅降低开发难度,提升开发速度

Mycat可以简单概括为

- 一个彻底开源的,面向企业应用开发的大数据库集群

- 支持事务、ACID、可以替代MySQL的加强版数据库

- 一个可以视为MySQL集群的企业级数据库,用来替代昂贵的Oracle集群

- 一个融合内存缓存技术、NoSQL技术、HDFS大数据的新型SQL Server

- 结合传统数据库和新型分布式数据仓库的新一代企业级数据库产品

- 一个新颖的数据库中间件产品

Mycat 官网:http://www.mycat.org.cn/

Mycat关键特性

- 支持SQL92标准

- 遵守MySQL 原生协议,跨语言,跨平台,跨数据库的通用中间件代理

- 基于心跳的自动故障切换,支持读写分离,支持MySQL主从,以及galera cluster集群

- 支持Galera for MySQL集群,Percona Cluster或者MariaDB cluster

- 基于Nio实现,有效管理线程,高并发问题

- 支持数据的多片自动路由与聚合,支持sum,count,max等常用的聚合函数,支持跨库分页

- 支持单库内部任意join,支持跨库2表join,甚至基于caltlet的多表join

- 支持通过全局表,ER关系的分片策略,实现了高效的多表join查询

- 支持多租户方案

- 支持分布式事务(弱xa)

- 支持全局序列号,解决分布式下的主键生成问题

- 分片规则丰富,插件化开发,易于扩展

- 强大的web,命令行监控

- 支持前端作为mysq通用代理,后端JDBC方式支持Oracle、DB2、SQL Server 、 mongodb 、巨杉

- 支持密码加密

- 支持服务降级

- 支持IP白名单

- 支持SQL黑名单、sql注入攻击拦截

- 支持分表(1.6)

- 集群基于ZooKeeper管理,在线升级,扩容,智能优化,大数据处理(2.0开发版)

为什么要用MyCat

这里要先搞清楚Mycat和MySQL的区别(Mycat的核心作用)。我们可以把上层看作是对下层的抽象,例如操作系统是对各类计算机硬件的抽象。那么我们什么时候需要抽象?假如只有一种硬件的时候,我们需要开发一个操作系统吗?再比如一个项目只需要一个人完成的时候不需要leader,但是当需要几十人完成时,就应该有一个管理者,发挥沟通协调等作用,而这个管理者对于他的上层来说就是对项目组的抽象

同样的,当我们的应用只需要一台数据库服务器的时候我们并不需要Mycat,而如果你需要分库甚至分表,这时候应用要面对很多个数据库的时候,这个时候就需要对数据库层做一个抽象,来管理这些数据库,而最上面的应用只需要面对一个数据库层的抽象或者说数据库中间件就好了,这就是Mycat的核心作用。所以可以这样理解:数据库是对底层存储文件的抽象,而Mycat是对数据库的抽象

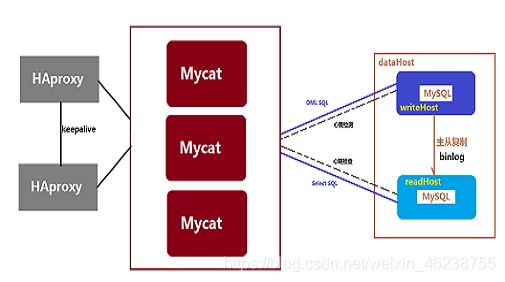

Mycat工作原理

Mycat外还有一层代理,是为了解决Mycat的单点失败问题,keeplaive可以解决两个服务器共享一个IP的功能,对外只有一个VIP(虚拟)

Mycat的原理中最重要的一个动词是“拦截”,它拦截了用户发送过来的SQL语句,首先对SQL语句做了一些特定的分析:如分片分析、路由分析、读写分离分析、缓存分析等,然后将此SQL发往后端的真实数据库,并将返回的结果做适当的处理,最终再返回给用户

Mycat应用场景

Mycat适用的场景很丰富,以下是几个典型的应用场景

- 单纯的读写分离,此时配置最为简单,支持读写分离,主从切换

- 分表分库,对于超过1000万的表进行分片,最大支持1000亿的单表分片

- 多租户应用,每个应用一个库,但应用程序只连接Mycat,从而不改造程序本身,实现多租户化

- 报表系统,借助于Mycat的分表能力,处理大规模报表的统计

- 替代Hbase,分析大数据

- 作为海量数据实时查询的一种简单有效方案,比如100亿条频繁查询的记录需要在3秒内查询出来结果,除了基于主键的查询,还可能存在范围查询或其他属性查询,此时Mycat可能是最简单有效的选择

- Mycat长期路线图

- 强化分布式数据库中间件的方面的功能,使之具备丰富的插件、强大的数据库智能优化功能、全面的系统监控能力、以及方便的数据运维工具,实现在线数据扩容、迁移等高级功能

- 进一步挺进大数据计算领域,深度结合Spark Stream和Storm等分布式实时流引擎,能够完成快速的巨表关联、排序、分组聚合等 OLAP方向的能力,并集成一些热门常用的实时分析算法,让工程师以及DBA们更容易用Mycat实现一些高级数据分析处理功能

- 不断强化Mycat开源社区的技术水平,吸引更多的IT技术专家,使得Mycat社区成为中国的Apache,并将Mycat推到Apache基金会,成为国内顶尖开源项目,最终能够让一部分志愿者成为专职的Mycat开发者,荣耀跟实力一起提升

Mycat不适合的应用场景

-

设计使用Mycat时有非分片字段查询,请慎重使用Mycat,可以考虑放弃!

-

设计使用Mycat时有分页排序,请慎重使用Mycat,可以考虑放弃!

-

设计使用Mycat时如果要进行表JOIN操作,要确保两个表的关联字段具有相同的数据分布,否则请慎重使用Mycat,可以考虑放弃!

-

设计使用Mycat时如果有分布式事务,得先看是否得保证事务得强一致性,否则请慎重使用Mycat,可以考虑放弃!

MyCat的高可用性:

需要注意: 在生产环境中, Mycat节点最好使用双节点, 即双机热备环境, 防止Mycat这一层出现单点故障。可以使用的高可用集群方式有:

- Keepalived+Mycat+Mysql

- Keepalived+LVS+Mycat+Mysql

- Keepalived+Haproxy+Mycat+Mysql

6.2.4.2 Mycat安装

下载安装JDK

yum -y install java

#确认安装成功

java -version

openjdk version "1.8.0_201"

OpenJDK Runtime Environment (build 1.8.0_201-b09)

OpenJDK 64-Bit Server VM (build 25.201-b09, mixed mode)

下载安装mycat

wget http://dl.mycat.org.cn/1.6.7.4/Mycat-server-1.6.7.4-release/Mycat-server-1.6.7.4-release-20200105164103-linux.tar.gz

mkdir /app

tar xvf Mycat-server-1.6.7.4-release-20200105164103-linux.tar.gz -C /app

ls /app/mycat/

bin catlet conf lib logs version.txt

mycat安装目录结构:

- bin mycat命令,启动、重启、停止等

- catlet catlet为Mycat的一个扩展功能

- conf Mycat 配置信息,重点关注

- lib Mycat引用的jar包,Mycat是java开发的

- logs 日志文件,包括Mycat启动的日志和运行的日志

- version.txt mycat版本说明

logs目录:

- wrapper.log mycat启动日志

- mycat.log mycat详细工作日志

Mycat的配置文件都在conf目录里面,这里介绍几个常用的文件:

- server.xml Mycat软件本身相关的配置文件,设置账号、参数等

- schema.xml Mycat对应的物理数据库和数据库表的配置,读写分离、高可用、分布式策略定制、节点控制

- rule.xml Mycat分片(分库分表)规则配置文件,记录分片规则列表、使用方法等

启动和连接

#配置环境变量

vim /etc/profile.d/mycat.sh

PATH=/app/mycat/bin:$PATH

source /etc/profile.d/mycat.sh

#启动

mycat start

#查看日志,确定成功

cat /app/mycat/logs/wrapper.log

...省略...

INFO | jvm 1 | 2019/11/01 21:41:02 | MyCAT Server startup successfully. see logs in logs/mycat.log

#连接mycat:

mysql -uroot -p123456 -h 127.0.0.1 -P8066

6.2.4.3 Mycat 主要配置文件说明

server.xml

存放Mycat软件本身相关的配置文件,比如:连接Mycat的用户,密码,数据库名称等

server.xml文件中配置的参数解释说明:

参数 说明

user 用户配置节点

name 客户端登录MyCAT的用户名,也就是客户端用来连接Mycat的用户名。

password 客户端登录MyCAT的密码

schemas 数据库名,这里会和schema.xml中的配置关联,多个用逗号分开,例如:db1,db2

privileges 配置用户针对表的增删改查的权限

readOnly mycat逻辑库所具有的权限。true为只读,false为读写都有,默认为false

注意:

- server.xml文件里登录mycat的用户名和密码可以任意定义,这个账号和密码是为客户机登录mycat时使用的账号信息

- 逻辑库名(如上面的TESTDB,也就是登录mycat后显示的库名,切换这个库之后,显示的就是代理的真实mysql数据库的表)要在schema.xml里面也定义,否则会导致mycat服务启动失败!

- 这里只定义了一个标签,所以把多余的都注释了。如果定义多个标签,即设置多个连接mycat的用户名和密码,那么就需要在schema.xml文件中定义多个对应的库!

schema.xml

是最主要的配置项,此文件关联mysql读写分离策略,读写分离、分库分表策略、分片节点都是在此文件中配置的.MyCat作为中间件,它只是一个代理,本身并不进行数据存储,需要连接后端的MySQL物理服务器,此文件就是用来连接MySQL服务器的

schema.xml文件中配置的参数解释说明:

参数 说明

schema 数据库设置,此数据库为逻辑数据库,name与server.xml中schema对应

dataNode 分片信息,也就是分库相关配置

dataHost 物理数据库,真正存储数据的数据库

配置说明

name属性唯一标识dataHost标签,供上层的标签使用。

maxCon属性指定每个读写实例连接池的最大连接。也就是说,标签内嵌套的writeHost、readHost标签都会使用这个属性的值来实例化出连接池的最大连接数

minCon属性指定每个读写实例连接池的最小连接,初始化连接池的大小

每个节点的属性逐一说明

schema:

属性 说明

name 逻辑数据库名,与server.xml中的schema对应

checkSQLschema 数据库前缀相关设置,这里为false

sqlMaxLimit select 时默认的limit,避免查询全表

table

属性 说明

name 表名,物理数据库中表名

dataNode 表存储到哪些节点,多个节点用逗号分隔。节点为下文dataNode设置的name

primaryKey 主键字段名,自动生成主键时需要设置

autoIncrement 是否自增

rule 分片规则名,具体规则下文rule详细介绍

dataNode

属性 说明

name 节点名,与table中dataNode对应

datahost 物理数据库名,与datahost中name对应

database 物理数据库中数据库名

dataHost

属性 说明

name 物理数据库名,与dataNode中dataHost对应

balance 均衡负载的方式

writeType 写入方式

dbType 数据库类型

heartbeat 心跳检测语句,注意语句结尾的分号要加

schema.xml文件中有三点需要注意:balance=“1”,writeType=“0” ,switchType=“1”

schema.xml中的balance的取值决定了负载均衡对非事务内的读操作的处理。balance 属性负载均衡类型,目前的取值有 4 种:

- balance=“0”:不开启读写分离机制,所有读操作都发送到当前可用的writeHost上,即读请求仅发送到writeHost上

- balance=“1”:一般用此模式,读请求随机分发到当前writeHost对应的readHost和standby的writeHost上。即全部的readHost与stand by writeHost 参与 select 语句的负载均衡,简单的说,当双主双从模式(M1 ->S1 , M2->S2,并且 M1 与 M2 互为主备),正常情况下, M2,S1, S2 都参与 select语句的负载均衡

- balance=“2”:读请求随机分发到当前dataHost内所有的writeHost和readHost上。即所有读操作都随机的在writeHost、 readhost 上分发

- balance=“3”:读请求随机分发到当前writeHost对应的readHost上。即所有读请求随机的分发到wiriterHost 对应的 readhost 执行, writerHost 不负担读压力,注意 balance=3 只在 1.4 及其以后版本有,1.3 没有

writeHost和readHost 标签

这两个标签都指定后端数据库的相关配置给mycat,用于实例化后端连接池。

唯一不同的是:writeHost指定写实例、readHost指定读实例,组着这些读写实例来满足系统的要求。

在一个dataHost内可以定义多个writeHost和readHost。但是,如果writeHost指定的后端数据库宕机,那么这个writeHost绑定的所有readHost都将不可用。另一方面,由于这个writeHost宕机系统会自动的检测到,并切换到备用的writeHost上去

注意:

Mycat主从分离只是在读的时候做了处理,写入数据的时候,只会写入到writehost,需要通过mycat的主从复制将数据复制到readhost

6.2.4.4 实战案例:利用Mycat实现MySQL的读写分离

系统环境:

cat /etc/centos-release

CentOS Linux release 8.0.1905 (Core)

服务器共三台

mycat-server 10.0.0.8 内存建议2G以上

mysql-master 10.0.0.18

mysql-slave 10.0.0.12

关闭SELinux和防火墙

systemctl stop firewalld

setenforce 0

时间同步

1、创建 MySQL 主从数据库

[root@centos8 ~]#yum -y install mariadb-server

1) 修改master和slave上的配置文件

#master上的my.cnf

[root@centos8 ~]#vim /etc/my.cnf.d/mariadb-server.cnf

[mysqld]

server-id = 1

log-bin

#slave上的my.cnf

[mysqld]

server-id = 2

[root@centos8 ~]#systemctl start mariadb

2) Master上创建复制用户

[root@centos8 ~]#mysql -uroot -pmagedu

MariaDB [(none)]>GRANT REPLICATION SLAVE ON *.* TO 'repluser'@'10.0.0.28'

IDENTIFIED BY 'magedu';

MariaDB [(none)]> FLUSH PRIVILEGES; #保证权限能生效

MariaDB [(none)]> show master logs;

+--------------------+-----------+

| Log_name | File_size |

+--------------------+-----------+

| mariadb-bin.000001 | 330 |

+--------------------+-----------+

1 row in set (0.000 sec)

3) Slave上执行

[root@centos8 ~]#mysql -uroot -p

MariaDB [(none)]> CHANGE MASTER TO

-> MASTER_HOST='10.0.0.18',

-> MASTER_USER='repluser',

-> MASTER_PASSWORD='magedu',

-> MASTER_LOG_FILE='mariadb-bin.000001',

-> MASTER_LOG_POS=330;

MariaDB [(none)]> start slave;

Query OK, 0 rows affected (0.00 sec)

MariaDB [(none)]> show slave status\G

*************************** 1. row ***************************

Slave_IO_State: Waiting for master to send event

Master_Host: 10.0.0.18

Master_User: repluser

Master_Port: 3306

Connect_Retry: 60

Master_Log_File: mariadb-bin.000001

Read_Master_Log_Pos: 527

Relay_Log_File: mariadb-relay-bin.000002

Relay_Log_Pos: 754

Relay_Master_Log_File: mariadb-bin.000001

Slave_IO_Running: Yes

Slave_SQL_Running: Yes

...省略...

2、在10.0.0.8安装mycat并启动

[root@centos8 ~]#yum -y install java mariadb

#确认安装成功

[root@centos8 ~]#java -version

openjdk version "1.8.0_252"

OpenJDK Runtime Environment (build 1.8.0_252-b09)

OpenJDK 64-Bit Server VM (build 25.252-b09, mixed mode)

#下载并安装

[root@centos8 ~]#wget http://dl.mycat.org.cn/1.6.7.4/Mycat-server-1.6.7.4-release/Mycat-server-1.6.7.4-release-20200105164103-linux.tar.gz

[root@centos8 ~]#mkdir /app

[root@centos8 ~]#tar xvf Mycat-server-1.6.7.4-release-20200105164103-linux.tar.gz -C /app

#配置环境变量

[root@centos8 ~]#echo 'PATH=/app/mycat/bin:$PATH' > /etc/profile.d/mycat.sh

[root@centos8 ~]#source /etc/profile.d/mycat.sh

#查看端口

[root@centos8 ~]#ss -ntl

State Recv-Q Send-Q Local Address:Port Peer Address:Port

LISTEN 0 128 0.0.0.0:111 0.0.0.0:*

LISTEN 0 128 0.0.0.0:22 0.0.0.0:*

LISTEN 0 128 0.0.0.0:5355 0.0.0.0:*

LISTEN 0 128 [::]:111 [::]:*

LISTEN 0 128 [::]:22 [::]:*

LISTEN 0 80 *:3306 *:*

LISTEN 0 128 [::]:5355 [::]:*

#启动mycat

[root@centos8 ~]#mycat start

Starting Mycat-server...

[root@centos8 ~]#ss -ntlp

State Recv-Q Send-Q Local Address:Port Peer Address:Port

LISTEN 0 128 0.0.0.0:111 0.0.0.0:* users:(("rpcbind",pid=738,fd=4),("systemd",pid=1,fd=71))

LISTEN 0 128 0.0.0.0:22 0.0.0.0:* users:(("sshd",pid=810,fd=4))

LISTEN 0 1 127.0.0.1:32000 0.0.0.0:* users:(("java",pid=4932,fd=4))

LISTEN 0 128 0.0.0.0:5355 0.0.0.0:* users:(("systemd-resolve",pid=950,fd=13))

LISTEN 0 128 [::]:111 [::]:* users:(("rpcbind",pid=738,fd=6),("systemd",pid=1,fd=73))

LISTEN 0 128 [::]:22 [::]:* users:(("sshd",pid=810,fd=6))

LISTEN 0 50 *:36505 *:* users:(("java",pid=4932,fd=65))

LISTEN 0 50 *:1984 *:* users:(("java",pid=4932,fd=64))

LISTEN 0 100 *:8066 *:* users:(("java",pid=4932,fd=85))

LISTEN 0 50 *:46051 *:* users:(("java",pid=4932,fd=63))

LISTEN 0 100 *:9066 *:* users:(("java",pid=4932,fd=81))

LISTEN 0 80 *:3306 *:* users:(("mysqld",pid=4254,fd=21))

LISTEN 0 128 [::]:5355 [::]:* users:(("systemd-resolve",pid=950,fd=15))

#查看日志,确定成功,可能需要等一会儿才能看到成功的提示

[root@centos8 ~]#tail /app/mycat/logs/wrapper.log

STATUS | wrapper | 2020/06/16 22:45:41 | Launching a JVM...

ERROR | wrapper | 2020/06/16 22:46:10 | Startup failed: Timed out waiting for a signal from the JVM.

ERROR | wrapper | 2020/06/16 22:46:10 | JVM did not exit on request, terminated

INFO | wrapper | 2020/06/16 22:46:10 | JVM exited on its own while waiting to kill the application.

STATUS | wrapper | 2020/06/16 22:46:10 | JVM exited in response to signal SIGKILL (9).

STATUS | wrapper | 2020/06/16 22:46:15 | Launching a JVM...

INFO | jvm 2 | 2020/06/16 22:46:15 | Wrapper (Version 3.2.3) http://wrapper.tanukisoftware.org

INFO | jvm 2 | 2020/06/16 22:46:15 | Copyright 1999-2006 Tanuki Software, Inc. All Rights Reserved.

INFO | jvm 2 | 2020/06/16 22:46:15 |

INFO | jvm 2 | 2020/06/16 22:46:18 | MyCAT Server startup successfully. see logs in logs/mycat.log

#用默认密码123456来连接mycat

[root@centos8 ~]#mysql -uroot -p123456 -h 10.0.0.8 -P8066

Welcome to the MariaDB monitor. Commands end with ; or \g.

Your MySQL connection id is 1

Server version: 5.6.29-mycat-1.6.7.4-release-20200105164103 MyCat Server (OpenCloudDB)

Copyright (c) 2000, 2018, Oracle, MariaDB Corporation Ab and others.

Type 'help;' or '\h' for help. Type '\c' to clear the current input statement.

MySQL [(none)]> show databases;

+----------+

| DATABASE |

+----------+

| TESTDB |

+----------+

1 row in set (0.001 sec)

MySQL [(none)]> USE TESTDB

Reading table information for completion of table and column names

You can turn off this feature to get a quicker startup with -A

Database changed

MySQL [TESTDB]> show tables;

+------------------+

| Tables in TESTDB |

+------------------+

| address |

| travelrecord |

+------------------+

2 rows in set (0.012 sec)

MySQL [TESTDB]> select * from travelrecord ;

ERROR 1105 (HY000): backend connect: java.lang.IllegalArgumentException: Invalid DataSource:0

4、在mycat 服务器上修改server.xml文件配置Mycat的连接信息

[root@centos8 ~]#vim /app/mycat/conf/server.xml

...省略...

<user name="root"> #连接Mycat的用户名

<property name="password">magedu</property> #连接Mycat的密码

<property name="schemas">TESTDB</property> #数据库名要和schema.xml相对应

</user>

</mycat:server>

这里使用的是root,密码为magedu,逻辑数据库为TESTDB,这些信息都可以自己随意定义,读写权限都有,没有针对表做任何特殊的权限。重点关注上面这段配置,其他默认即可。

5、修改schema.xml实现读写分离策略

[root@centos8 ~]#vim /app/mycat/conf/schema.xml

<?xml version="1.0"?>

<!DOCTYPE mycat:schema SYSTEM "schema.dtd">

<mycat:schema xmlns:mycat="http://io.mycat/"> <schema name="TESTDB" checkSQLschema="false" sqlMaxLimit="100" dataNode="dn1"></schema>

<dataNode name="dn1" dataHost="localhost1" database="mycat" />

<dataHost name="localhost1" maxCon="1000" minCon="10" balance="1"

writeType="0" dbType="mysql" dbDriver="native" switchType="1" slaveThreshold="100">

<heartbeat>select user()</heartbeat>

<writeHost host="host1" url="10.0.0.18:3306" user="root" password="123456">

<readHost host="host2" url="10.0.0.28:3306" user="root" password="123456" />

</writeHost>

</dataHost>

</mycat:schema>

#重新启动mycat

[root@centos8 ~]#mycat restart

上面配置中,balance改为1,表示读写分离。以上配置达到的效果就是10.0.0.18为主库,10.0.0.28为从库

注意:要保证10.0.0.18和10.0.0.28机器能使用root/123456权限成功登录mysql数据库。同时,也一定要授权mycat机器能使用root/123456权限成功登录这两台机器的mysql数据库!!这很重要,否则会导致登录mycat后,对库和表操作失败!

范例:schema.xml

6、在后端主服务器创建用户并对mycat授权

[root@centos8 ~]#mysql -uroot -p

mysql> create database mycat;

mysql>GRANT ALL ON *.* TO 'root'@'10.0.0.%' IDENTIFIED BY '123456' WITH GRANT OPTION;

mysql> privileges;

7、在Mycat服务器上连接并测试

[root@centos8 ~]#mysql -uroot -pmagedu -h127.0.0.1 -P8066 -DTESTDB

mysql> show databases;

+----------+

| DATABASE |

+----------+

| TESTDB | //只能看一个虚拟数据库

+----------+

MySQL [(none)]> use TESTDB;

MySQL [TESTDB]> create table t1(id int);

MySQL [TESTDB]> select @@server_id;

MySQL [TESTDB]> select @@hostname;

8、通过通用日志确认实现读写分离

在mysql中查看通用日志

show variables like 'general_log'; #查看日志是否开启

set global general_log=on; #开启日志功能

show variables like 'general_log_file'; #查看日志文件保存位置

set global general_log_file='tmp/general.log'; #设置日志文件保存位置

在主和从服务器分别启用通用日志,查看读写分离

[root@centos8 ~]#vim /etc/my.cnf.d/mariadb-server.cnf

[mysqld]

general_log=ON

[root@centos8 ~]#systemctl restart mariadb

[root@centos8 ~]#tail -f /var/lib/mysql/centos8.log

9、停止从节点,MyCAT自动调度读请求至主节点 (需要exit一次)

[root@slave ~]#systemctl stop mariadb

[root@client ~]#mysql -uroot -pmagedu -h10.0.0.8 -P8066

MySQL [(none)]> select @@server_id;

+-------------+

| @@server_id |

+-------------+

| 1 |

+-------------+

1 row in set (0.00 sec)

#停止主节点,MyCAT不会自动调度读请求至从节点

MySQL [TESTDB]> insert teachers values(5,'wang',30,'M');

ERROR 1184 (HY000): java.net.ConnectException: Connection refused