RHCS套件高可用(nginx+mysql+高可用磁盘)

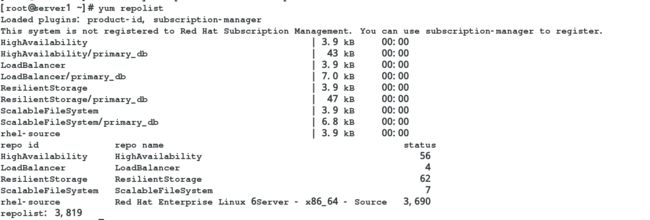

1.配置yum源

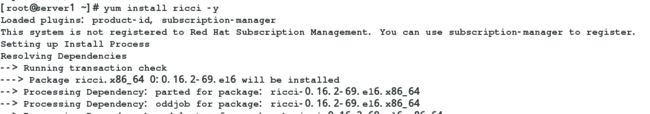

2.server1和server4都安装ricci,设置密码并启动

[root@server1 ~]# yum install ricci -y

[root@server1 ~]# passwd ricci

[root@server1 ~]# /etc/init.d/ricci start

[root@server1 ~]# chkconfig ricci on

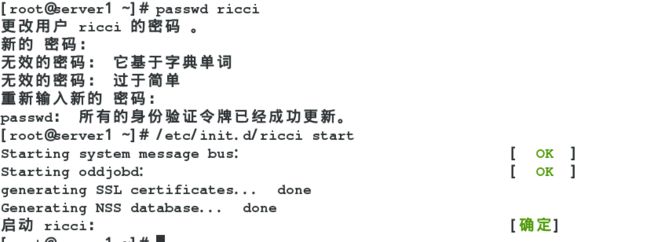

3.在server1上安装luci,并启动

[root@server1 ~]# yum install luci -y

[root@server1 ~]# /etc/init.d/luci start

[root@server1 ~]# chkconfig luci on

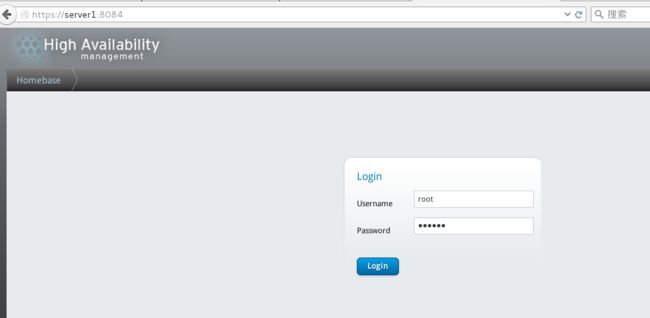

4.界面登陆设置,用户为server1的root用户及其密码

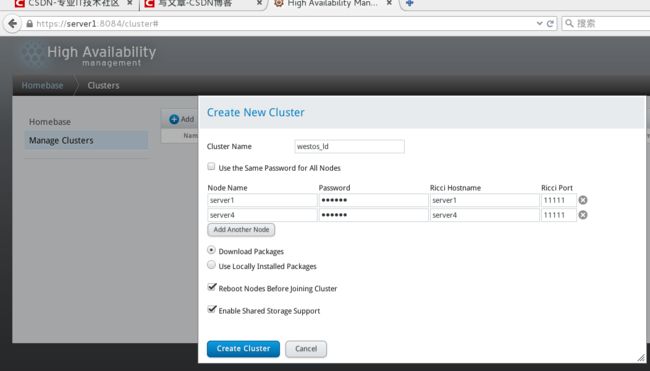

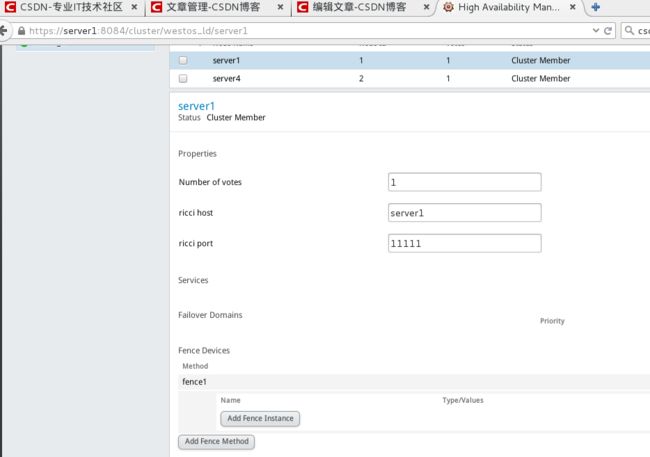

按图标进行创建,passwd是server1和server4中ricci密码

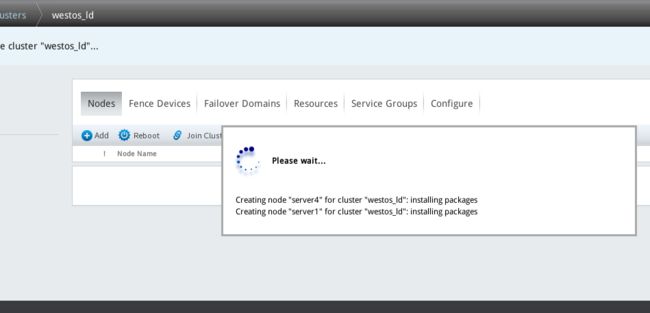

设置中,server1和server4会重新启动

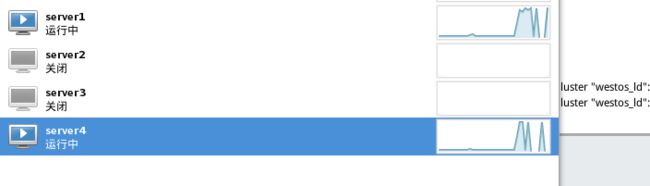

由于设置了ricci和luci的开机自启,可以直接在浏览器中看到创建成功

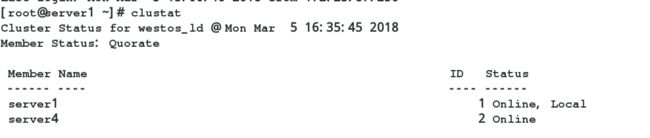

5.命令界面查看

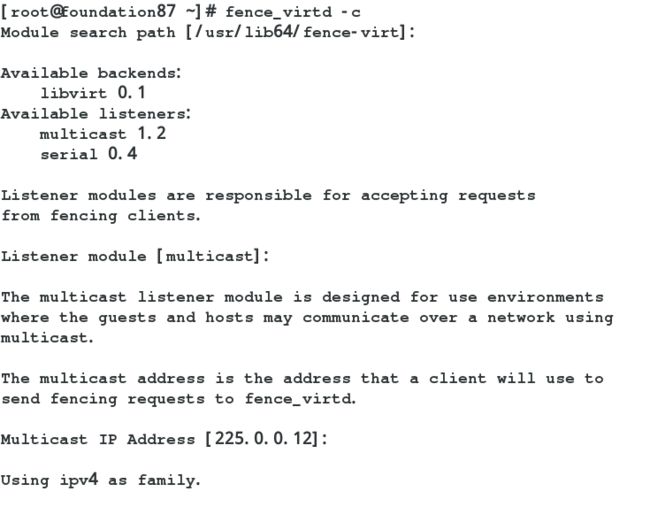

二.安装fence系统

1.安装

[root@foundation87 ~]# yum install fence-* -y

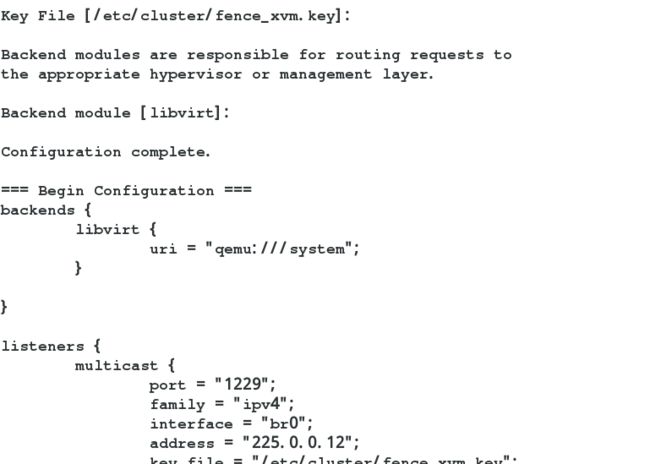

创建fence

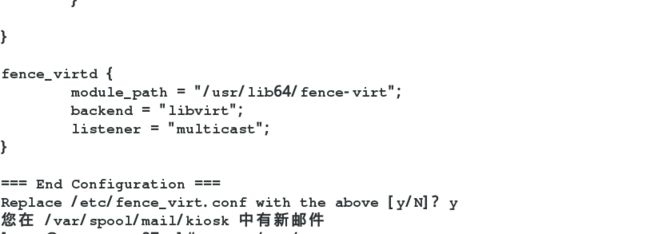

[root@foundation87 ~]# fence_virtd -c

多播模式,地址默认,端口选择实际

创建cluster目录

[root@foundation87 ~]# mkdir /etc/cluster

生成随机密钥文件,重启服务

[root@foundation87 cluster]# dd if=/dev/urandom of=/etc/cluster/fency_xvm.key bs=128 count=1

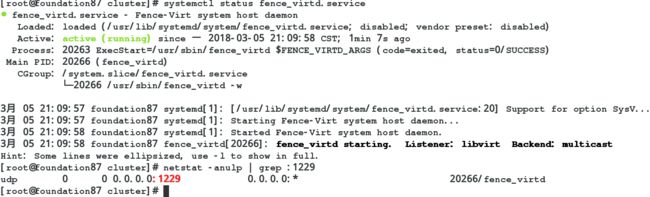

查看fence服务是否启动正常

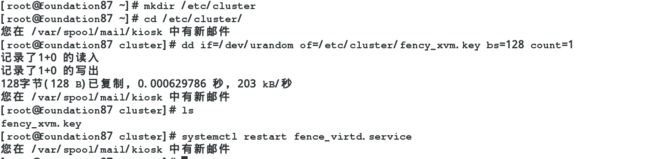

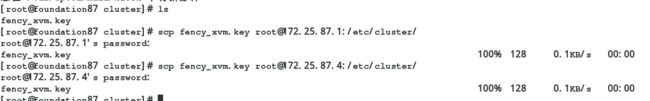

把密钥文件传递给server1和server4

[root@foundation87 cluster]# scp fency_xvm.key root@172.25.87.1:/etc/cluster/

[root@foundation87 cluster]# scp fency_xvm.key root@172.25.87.4:/etc/cluster/

2.创建fence设备

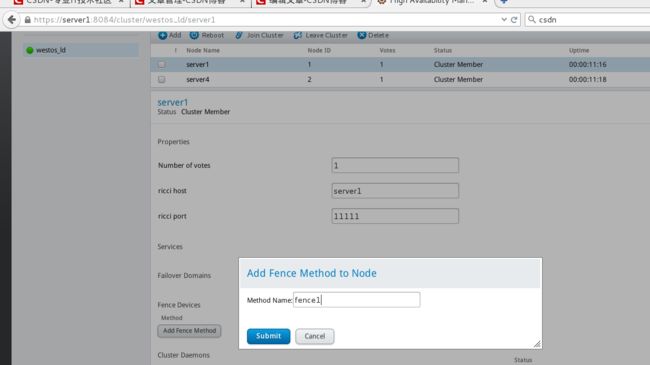

打开web luci管理系统,选择Fence Devices 中Add

选择server1,点击Add Fence Method 为fence1

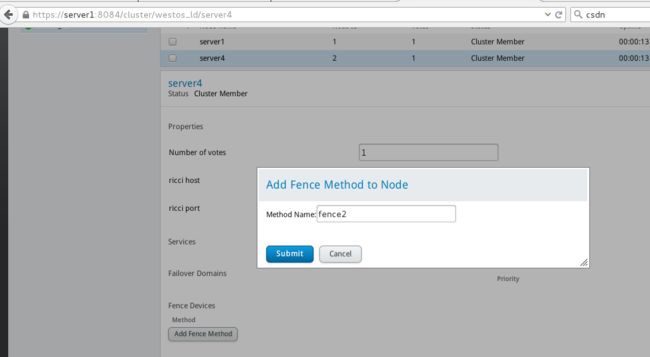

选择server4,点击Add Fence Method 为fence2

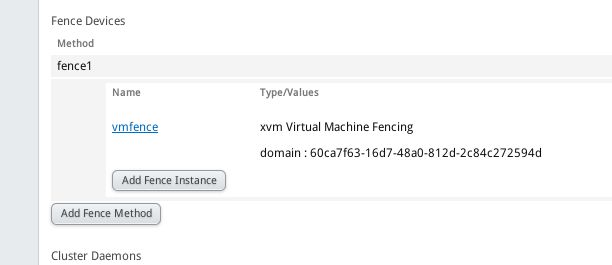

选择 Fence1 中 Add Fence Instance

添加Domain为虚拟机的uuid

添加后效果

fence2同样的方法添加

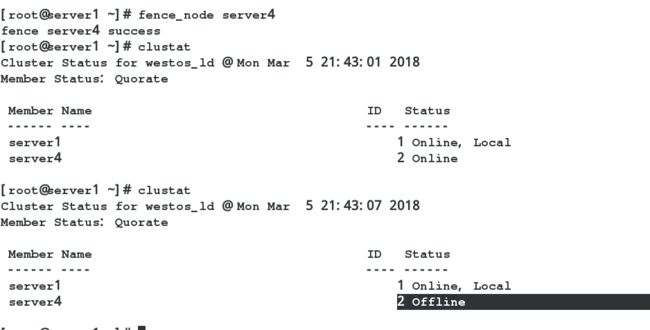

3.测试

在server1中把server4破坏,fence起作用,server4在重启

[root@server1 ~]# fence_node server4

[root@server1 ~]# clustat

三.在搭建好的集群上添加Nginx服务

1.server1和server4上都部署好 nginx,server2和server4部署好后端http (轮询)

2.配置 Luci web 端

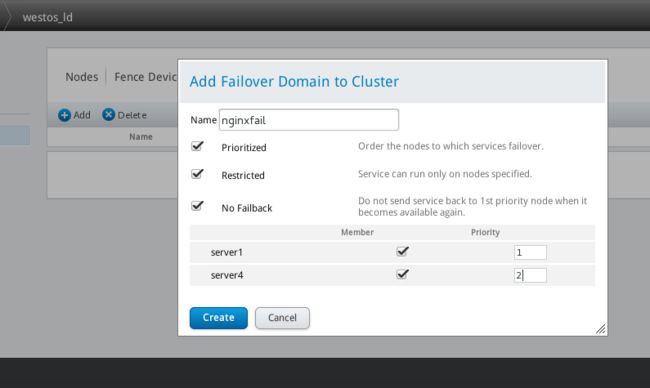

(1)添加服务 这里采用的是双机热备

选择Failover Domains,如图,填写Name(nginxfail),如图选择,前面打勾的三个分别是结点失效之后可以跳到另一个结点、只服务运行指定的结点、当结点失效之跳到另一个结点之后,原先的结点恢复之后,不会跳回原先的结点。下面的Member打勾,是指服务运行server1和server4结点,后面的Priority值越小,优先级越高,选择Create

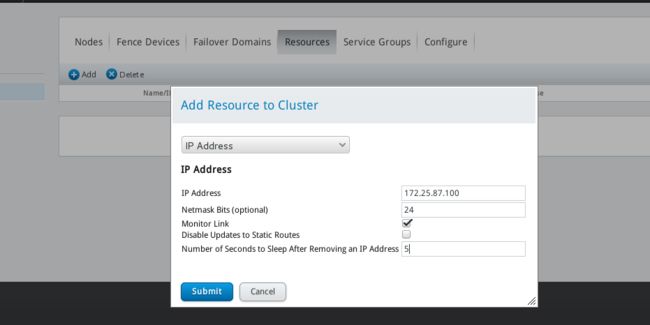

(2)选择Resourcs,点击Add,选择添加IPAddress如图,添加的ip必须是未被占用的ip,24是子网掩码的位数,5指的是等待时间为5秒。选择Submit

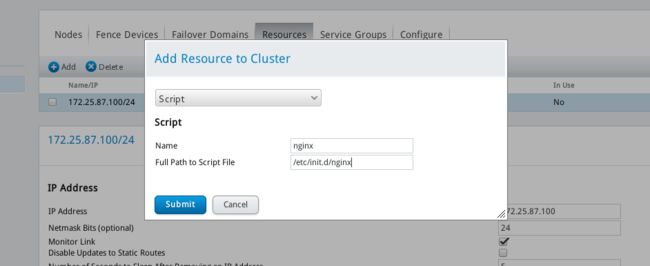

(3)以相同的方法添加Script,nginx是服务的名字,/etc/init.d/nginx是服务启动脚本的路径,选择Submit

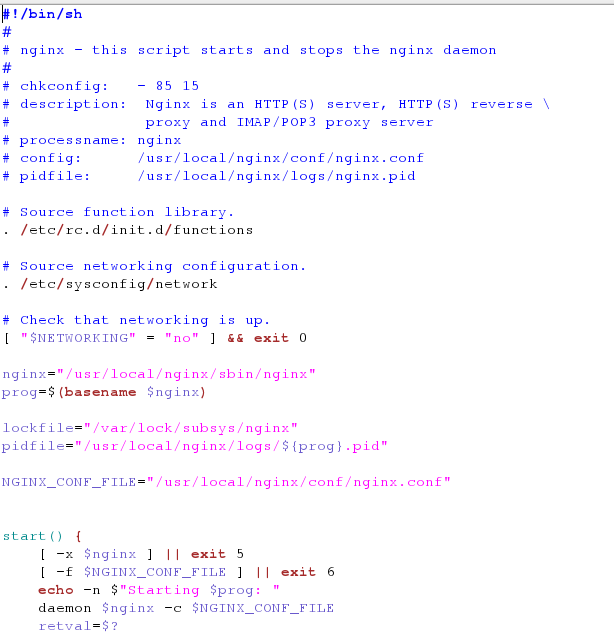

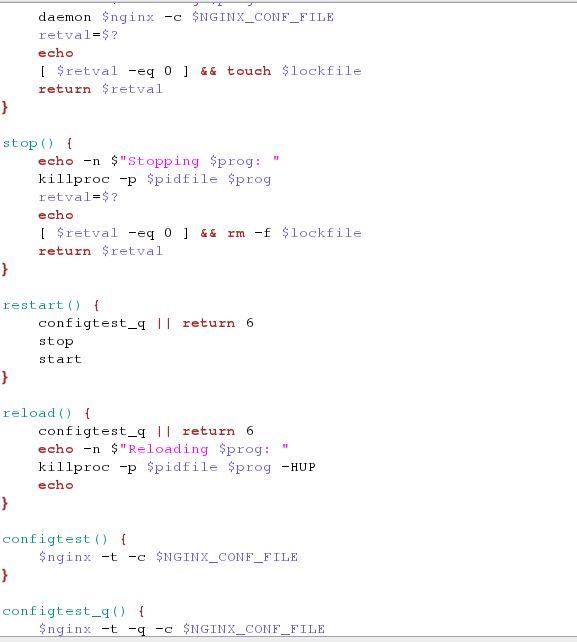

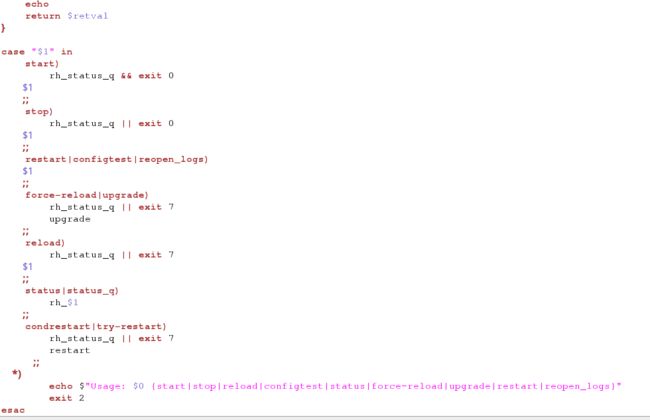

注:将nginx的脚本放置到/etc/init.d/nginx下,脚本为自己编写,用户启动nginx

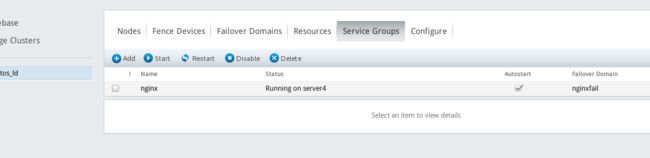

(3)选择Service Groups,点击Add如图,nginx是服务的名字,下面两个勾指分别的是自动开启服务、运行 ,选择Add Resource,将全局资源IP Address 和Script加入

选择Submit,完成,nginx服务组running

3.测试

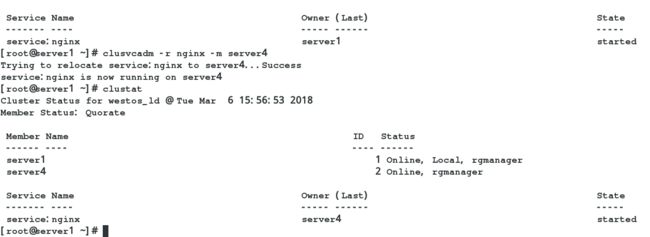

clustat ,将server1的webib服务转移到server4上

clustat 查看状态

clusvcadm -r nginx -m server4 将nginx组转移到server4上

clusvcadm -e nginx 重新激活nginx组

clusvcadm -d nginx 停止nginx组

服务没有停止,已经转义到server4上

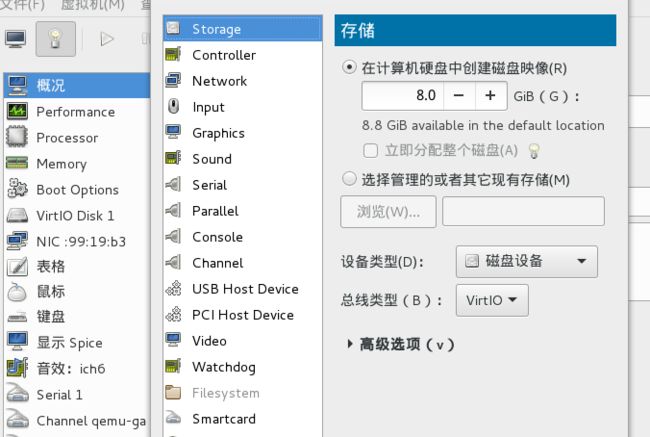

四.在搭建好的集群上添加服务sicis共享磁盘(双机热备)

1.server2上服务端scisi, server1和server4上iscisi

[root@server1 ~]# yum install iscsi-* -y

[root@server4 ~]# yum install iscsi-* -y

[root@server2 ~]# yum install scsi-* -y

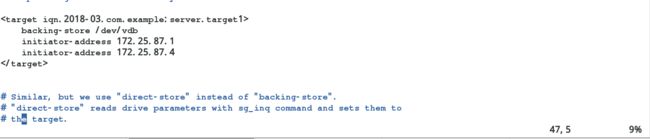

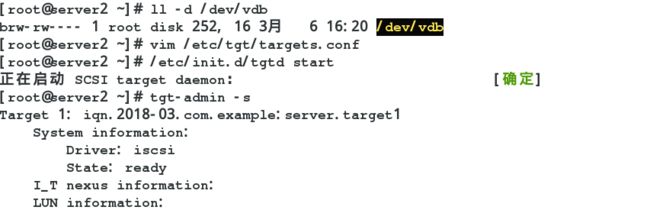

2.配置server2

配置scisi文件,重启服务

[root@server2 ~]# ll -d /dev/vdb

[root@server2 ~]# vim /etc/tgt/targets.conf

[root@server2 ~]# /etc/init.d/tgtd start

[root@server2 ~]# tgt-admin -s 查看配置是否成功

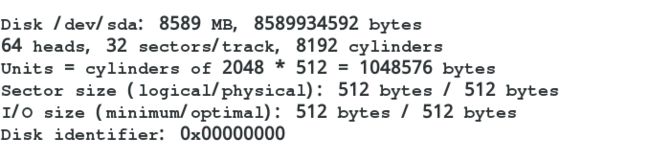

3.配置server1 和 server4 iscsi端

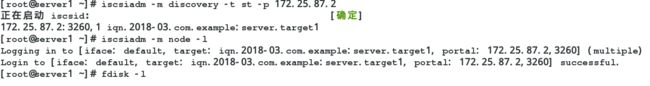

[root@server1 ~]# iscsiadm -m discovery -t st -p 172.25.87.2

[root@server1 ~]# iscsiadm -m node -l

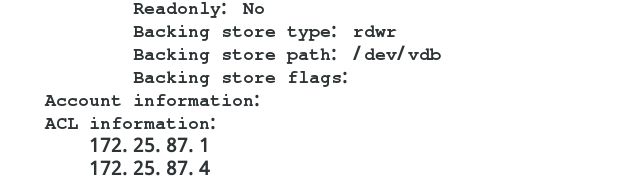

[root@server1 ~]# fdisk -l

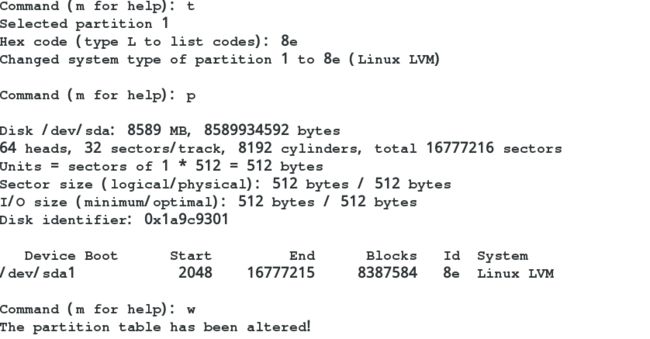

4.在server1上创建iscsi分区,创建为lvm格式

[root@server1 ~]# fdisk -cu /dev/sda

5.在server1上创建lvm分区

1)创建 pv vg lv

[root@server1 ~]# pvcreate /dev/sda1

[root@server1 ~]# vgcreate clustervg /dev/sda1

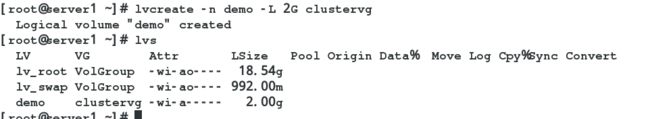

[root@server1 ~]# lvcreate -n demo -L 2G clustervg

2)创建分区

[root@server1 ~]# mkfs.ext4 /dev/clustervg/demo

6.在server1上挂载sicis磁盘

[root@server1 ~]# mount /dev/clustervg/demo /mnt/

7. 在server4上挂载sicis磁盘

[root@server4 ~]# partprobe

[root@server4 ~]# mount /dev/clustervg/demo /mnt/

五.在搭好的集群上添加mysql服务

1.配置mysql

[root@server1 ~]# yum install mysql-server -y

[root@server1 ~]# /etc/init.d/mysqld start

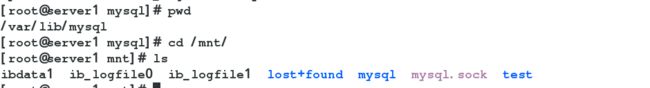

2.将iscsi磁盘挂载在/mnt下,将/var/lib/mysql数据cp到/mnt下

[root@server1 mysql]# pwd

/var/lib/mysql

[root@server1 mysql]# cp -a * /mnt/

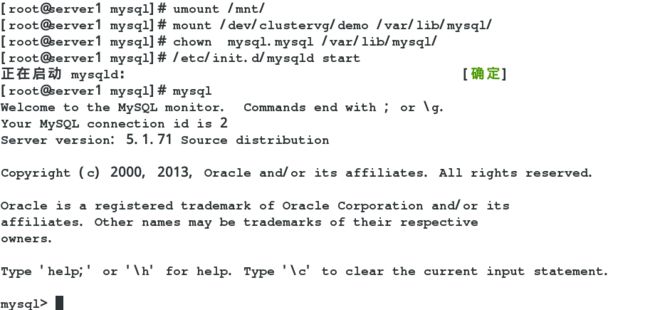

3.取消挂载,更改var/lib/mysql所属人为mysql,要不然iscsi内的数据运行会出问题,重新在server1上启动数据库,运行数据库正常,证明使用iscsi内的数据正常

[root@server1 mysql]# umount /mnt/

[root@server1 mysql]# mount /dev/clustervg/demo /var/lib/mysql/

[root@server1 mysql]# chown mysql.mysql /var/lib/mysql/

[root@server1 mysql]# /etc/init.d/mysqld start

4.关闭数据库并取消数据库挂载

[root@server1 mysql]# /etc/init.d/mysqld stop

[root@server1 ~]# umount /var/lib/mysql/

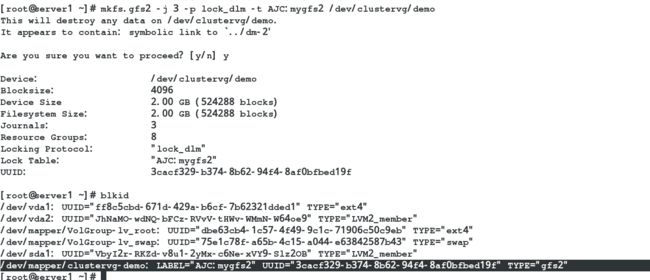

七.创建高可用集群共享盘,可以同时读取写入

1.将原来iscsi磁盘格式化为高可用集群共享盘

[root@server1 ~]# mkfs.gfs2 -j 3 -p lock_dlm -t AJC:mygfs2 /dev/clustervg/demo

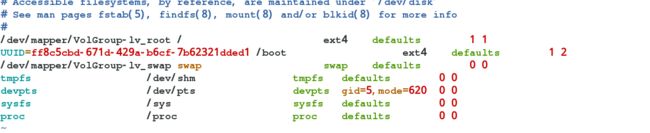

2.查出其uuid,写入/etc/fstab开机自动挂载(server1和server4),server1和server4同时可以写入

[root@server1 ~]# blkid

[root@server1 ~]# vim /etc/fstab

WWWW