docker 的使用 命令

1:

redis docker部署:

docker pull redis:latest docker run -d -p 6379:6379 redis

执行 :

docker exec -it 容器id bash 进入容器

推出容器:

exit

关闭容器:

在启动容器的时候可以指定名字然后方便使用,id太长了

docker run --name myredis

‘’‘’‘’

#下载centos镜像,运行一个名为mycentos的容器,并在容器里运行/bin/bash docker run -ti --name mycentos centos /bin/bash #退出 exit #关闭 docker stop mycentos #重启 docker start mycentos #重启后,在mycentos再打开/bin/bash docker exec -ti mycentos /bin/bash

docker 制作 centos(scrapy 环境)

一、下载centos7镜像

[root@cgls ]docker pull centos7

二、启动centos7容器

[root@cgls ]docker run -name centos7 -v /cgls:/opt/webapp -t -i centos /bin/bash

三、为容器安装ifconfig服务

[root@cgls ]yum install net-tools.x86_64

查看你的网卡

[root@cgls ]ifconfig

四、安装scrapy

执行下面五个命令,进行scrapy和scrapy相关插件的安装

命令一:

[root@cgls]# yum install gcc libffi-devel openssl-devel libxml2 libxslt-devel libxml2-devel python-devel -y

命令二:

[root@cgls]# yum install python-setuptools

命令三:

[root@cgls]# easy_install pip

命令四:

[root@cgls]# easy_install lxml

命令五:

[root@cgls]# pip install scrapy

五、安装相关的python插件

[root@cgls]# pip install redis

1

六、生成镜像

[root@cgls]# docker commit eafd9111ada6 cgls/centos7

指定了要提交的修改过的容器的ID、目标镜像仓库、镜像名。

---------------------

作者:cuigelasi

来源:CSDN

原文:https://blog.csdn.net/cuigelasi/article/details/53888340

版权声明:本文为博主原创文章,转载请附上博文链接!

docker容器运行与退出

#下载centos镜像,运行一个名为mycentos的容器,并在容器里运行/bin/bash docker run -ti --name mycentos centos /bin/bash #退出 exit #关闭 docker stop mycentos #重启 docker start mycentos #重启后,在mycentos再打开/bin/bash docker exec -ti mycentos /bin/bash

docker——Dockerfile创建镜像

写在前面:

继续docker的学习,昨天用docker成功跑了tomcat,但是在centos中镜像跑的容器手动装jdk和tomcat,今天学习用Dockerfile创建镜像,并在上面搭建java环境,跑一个spring boot小项目。

Dockerfile:

Dockerfile由一行行命令语句组成,并且支持用“#”开头作为注释,一般的,Dockerfile分为四部分:基础镜像信息,维护者信息,镜像操作指令和容器启动时执行的指令。

Dockerfile指令:

1、FROM

格式:FROM 或 FROM

:

第一条指令必须为FROM指令,并且,如果在同一个Dockerfile中创建多个镜像时,可以使用多个FROM指令(每个镜像一次)

2、MAINTAINET

格式:MAINTAINET

指定维护者的信息

3、RUN

格式:RUN

每条指令将在当前镜像基础上执行,并提交为新的镜像。(可以用“\”换行)

4、CMD

格式:CMD ["","",""]

指定启动容器时执行的命令,每个Dockerfile只能有一条CMD指令,如果指定了多条指令,则最后一条执行。(会被启动时指定的命令覆盖)

5、EXPOSE

格式:EXPOSE

告诉Docker服务端暴露端口,在容器启动时需要通过 -p 做端口映射

6、ENV

格式:ENV

指定环境变量,会被RUN指令使用,并在容器运行时保存

7、ADD

格式:ADD

复制指定的

8、COPY

格式:COPY

复制本地主机的

9、ENTRYPOINT

格式:ENTRYPOINT ["","",""]

配置容器启动后执行的命令,并且不可被 docker run 提供的参数覆盖。(每个 Dockerfile 中只能有一个 ENTRYPOINT ,当指定多个时,只有最后一个起效)

10、VOLUME

格式:VOLUME ["/mnt"]

创建一个可以从本地主机或其他容器挂载的挂载点,一般用来存放数据库和需要保持的数据等

11、USER

格式:USER daemon

指定运行容器时的用户名或 UID,后续的 RUN 也会使用指定用户。

12、WORKDIR

格式:WORKDIR /path/to/workdir

为后续的 RUN 、 CMD 、 ENTRYPOINT 指令配置工作目录。(可以使用多个 WORKDIR 指令,后续命令如果参数是相对路径, 则会基于之前命令指定的路径)

13、ONBUILD

格式:ONBUILD [INSTRUCTION]

配置当所创建的镜像作为其它新创建镜像的基础镜像时,所执行的操作指令

------------------分割线----------------------

创建镜像:

1、准备jdk、需要运行的spring boot小项目

将jdk压缩包解压到Dockerfile所在的目录中,将spring boot小项目websocket.jar复制到Dockerfile所在的目录下:

![]()

2、创建Dockerfile,内容如下:

![]()

1 FROM centos 2 3 MAINTAINER yaolin 4 5 COPY jdk1.7.0_79 jdk1.7.0_79 6 ADD websocket.jar app.jar 7 8 ENV JAVA_HOME=/jdk1.7.0_79 9 ENV PATH=$JAVA_HOME/bin:$PATH 10 ENV CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar 11 12 EXPOSE 8080 13 14 ENTRYPOINT ["java","-jar","/app.jar"]

![]()

指定基镜像 centos

指定维护者信息 yaolin

复制jdk

添加spring boot 小项目,并重命名为app.jar

配置jdk环境

暴露8080端口

指定执行启动spring boot小项目

3、编译并生成镜像 (. 表示当前路径)

docker build -t yaolin/websocket .

![]()

4、查看生成的镜像

docker images

![]()

5、创建容器并运行

docker run -p 192.168.0.105:8080:8080 --name websocket yaolin/websocket

![]()

可以看到容器正常运行并打印日志,但是这种运行方式会抢占终端。改为使用docker start websocket的方式启动:

![]()

6、访问(在实体机,不是在虚拟机,这里我的Spring boot 小项目好像有点问题,报了500错误,但是可以访问说明容器已经正常运行了spring boot项目了)

![]()

未完,待续....

Scrapy 对接 Docker

环境配置问题可能一直会让我们头疼,包括如下几种情况。

-

我们在本地写好了一个Scrapy爬虫项目,想要把它放到服务器上运行,但是服务器上没有安装Python环境。

-

其他人给了我们一个Scrapy爬虫项目,项目使用包的版本和本地环境版本不一致,项目无法直接运行。

-

我们需要同时管理不同版本的Scrapy项目,如早期的项目依赖于Scrapy 0.25,现在的项目依赖于Scrapy 1.4.0。

在这些情况下,我们需要解决的就是环境的安装配置、环境的版本冲突解决等问题。

对于Python来说,VirtualEnv的确可以解决版本冲突的问题。但是,VirtualEnv不太方便做项目部署,我们还是需要安装Python环境,

如何解决上述问题呢?答案是用Docker。Docker可以提供操作系统级别的虚拟环境,一个Docker镜像一般都包含一个完整的操作系统,而这些系统内也有已经配置好的开发环境,如Python 3.6环境等。

我们可以直接使用此Docker的Python 3镜像运行一个容器,将项目直接放到容器里运行,就不用再额外配置Python 3环境。这样就解决了环境配置的问题。

我们也可以进一步将Scrapy项目制作成一个新的Docker镜像,镜像里只包含适用于本项目的Python环境。如果要部署到其他平台,只需要下载该镜像并运行就好了,因为Docker运行时采用虚拟环境,和宿主机是完全隔离的,所以也不需要担心环境冲突问题。

如果我们能够把Scrapy项目制作成一个Docker镜像,只要其他主机安装了Docker,那么只要将镜像下载并运行即可,而不必再担心环境配置问题或版本冲突问题。

接下来,我们尝试把一个Scrapy项目制作成一个Docker镜像。

一、本节目标

我们要实现把前文Scrapy的入门项目打包成一个Docker镜像的过程。项目爬取的网址为:http://quotes.toscrape.com/。本章Scrapy入门一节已经实现了Scrapy对此站点的爬取过程,项目代码为:https://github.com/Python3WebSpider/ScrapyTutorial。如果本地不存在的话可以将代码Clone下来。

二、准备工作

请确保已经安装好Docker和MongoDB并可以正常运行。

三、创建Dockerfile

首先在项目的根目录下新建一个requirements.txt文件,将整个项目依赖的Python环境包都列出来,如下所示:

scrapy

pymongo复制代码如果库需要特定的版本,我们还可以指定版本号,如下所示:

scrapy>=1.4.0

pymongo>=3.4.0复制代码在项目根目录下新建一个Dockerfile文件,文件不加任何后缀名,修改内容如下所示:

FROM python:3.6

ENV PATH /usr/local/bin:$PATH

ADD . /code

WORKDIR /code

RUN pip3 install -r requirements.txt

CMD scrapy crawl quotes复制代码第一行的FROM代表使用的Docker基础镜像,在这里我们直接使用python:3.6的镜像,在此基础上运行Scrapy项目。

第二行ENV是环境变量设置,将/usr/local/bin:$PATH赋值给PATH,即增加/usr/local/bin这个环境变量路径。

第三行ADD是将本地的代码放置到虚拟容器中。它有两个参数:第一个参数是.,代表本地当前路径;第二个参数是/code,代表虚拟容器中的路径,也就是将本地项目所有内容放置到虚拟容器的/code目录下,以便于在虚拟容器中运行代码。

第四行WORKDIR是指定工作目录,这里将刚才添加的代码路径设成工作路径。这个路径下的目录结构和当前本地目录结构是相同的,所以我们可以直接执行库安装命令、爬虫运行命令等。

第五行RUN是执行某些命令来做一些环境准备工作。由于Docker虚拟容器内只有Python 3环境,而没有所需要的Python库,所以我们运行此命令来在虚拟容器中安装相应的Python库如Scrapy,这样就可以在虚拟容器中执行Scrapy命令了。

第六行CMD是容器启动命令。在容器运行时,此命令会被执行。在这里我们直接用scrapy crawl quotes来启动爬虫。

四、修改MongDB连接

接下来我们需要修改MongoDB的连接信息。如果我们继续用localhost是无法找到MongoDB的,因为在Docker虚拟容器里localhost实际指向容器本身的运行IP,而容器内部并没有安装MongoDB,所以爬虫无法连接MongoDB。

这里的MongoDB地址可以有如下两种选择。

-

如果只想在本机测试,我们可以将地址修改为宿主机的IP,也就是容器外部的本机IP,一般是一个局域网IP,使用

ifconfig命令即可查看。 -

如果要部署到远程主机运行,一般MongoDB都是可公网访问的地址,修改为此地址即可。

在本节中,我们的目标是将项目打包成一个镜像,让其他远程主机也可运行这个项目。所以我们直接将此处MongoDB地址修改为某个公网可访问的远程数据库地址,修改MONGO_URI如下所示:

MONGO_URI = 'mongodb://admin:admin123@120.27.34.25:27017'复制代码此处地址可以修改为自己的远程MongoDB数据库地址。

这样项目的配置就完成了。

五、构建镜像

接下来我们构建Docker镜像,执行如下命令:

docker build -t quotes:latest .复制代码执行过程中的输出如下所示:

Sending build context to Docker daemon 191.5 kB

Step 1/6 : FROM python:3.6

---> 968120d8cbe8

Step 2/6 : ENV PATH /usr/local/bin:$PATH

---> Using cache

---> 387abbba1189

Step 3/6 : ADD . /code

---> a844ee0db9c6

Removing intermediate container 4dc41779c573

Step 4/6 : WORKDIR /code

---> 619b2c064ae9

Removing intermediate container bcd7cd7f7337

Step 5/6 : RUN pip3 install -r requirements.txt

---> Running in 9452c83a12c5

...

Removing intermediate container 9452c83a12c5

Step 6/6 : CMD scrapy crawl quotes

---> Running in c092b5557ab8

---> c8101aca6e2a

Removing intermediate container c092b5557ab8

Successfully built c8101aca6e2a复制代码这样的输出就说明镜像构建成功。这时我们查看一下构建的镜像,如下所示:

docker images复制代码返回结果中的一行代码如下所示:

quotes latest 41c8499ce210 2 minutes ago 769 MB复制代码这就是我们新构建的镜像。

六、运行

镜像可以先在本地测试运行,我们执行如下命令:

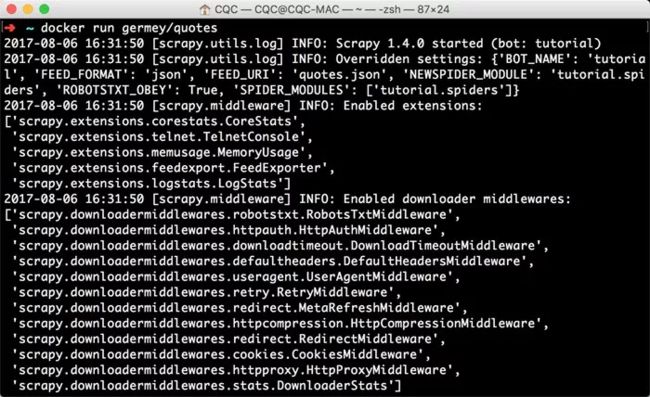

docker run quotes复制代码这样我们就利用此镜像新建并运行了一个Docker容器,运行效果完全一致,如下图所示。

如果出现类似图上的运行结果,这就证明构建的镜像没有问题。

七、推送至Docker Hub

构建完成之后,我们可以将镜像Push到Docker镜像托管平台,如Docker Hub或者私有的Docker Registry等,这样我们就可以从远程服务器下拉镜像并运行了。

以Docker Hub为例,如果项目包含一些私有的连接信息(如数据库),我们最好将Repository设为私有或者直接放到私有的Docker Registry。

首先在https://hub.docker.com注册一个账号,新建一个Repository,名为quotes。比如,我的用户名为germey,新建的Repository名为quotes,那么此Repository的地址就可以用germey/quotes来表示。

为新建的镜像打一个标签,命令如下所示:

docker tag quotes:latest germey/quotes:latest复制代码Push镜像到Docker Hub即可,命令如下所示:

docker push germey/quotes复制代码Docker Hub便会出现新Push的Docker镜像了,如下图所示。

如果我们想在其他的主机上运行这个镜像,主机上装好Docker后,可以直接执行如下命令:

docker run germey/quotes复制代码这样就会自动下载镜像,启动容器运行。不需要配置Python环境,不需要关心版本冲突问题。

运行效果如下图所示。

整个项目爬取完成后,数据就可以存储到指定的数据库中。

八、结语

我们讲解了将Scrapy项目制作成Docker镜像并部署到远程服务器运行的过程。使用此种方式,我们在本节开头所列出的问题都迎刃而解。

本资源首发于崔庆才的个人博客静觅: Python3网络爬虫开发实战教程 | 静觅

如想了解更多爬虫资讯,请关注我的个人微信公众号:进击的Coder

weixin.qq.com/r/5zsjOyvEZ… (二维码自动识别)

docker不能一直运行直接退出:

现象

启动docker容器

docker run –name [CONTAINER_NAME] [CONTAINER_ID]

查看容器运行状态

docker ps -a

发现刚刚启动的mydocker容器已经退出

原因

docker容器的主线程(dockfile中CMD执行的命令)结束,容器会退出

办法

可以使用交互式启动

docker run -i [CONTAINER_NAME or CONTAINER_ID]

1

上面的不太友好,建议使用后台模式和tty选项

docker run -dit [CONTAINER_NAME or CONTAINER_ID]

1

查看容器状态

docker ps -a

1

docker调出后台容器

docker attach [CONTAINER_NAME or CONTAINER_ID]

1

TIPs:退出时,使用[ctrl + D],这样会结束docker当前线程,容器结束,可以使用[ctrl + P][ctrl + Q]退出而不终止容器运行

如下命令,会在指定容器中执行指定命令,[ctrl+D]退出后不会终止容器运行

docker exec -it [CONTAINER_NAME or CONTAINER_ID] /bin/bash

---------------------

作者:neurobot

来源:CSDN

原文:https://blog.csdn.net/o1_1o/article/details/52710733

版权声明:本文为博主原创文章,转载请附上博文链接!