判断RDD有多少个分区

为了调优和故障排查,经常有必要知道RDD中有多少个Partition。有如下几个方式可以找到这些信息:

使用Spark web UI查看任务执行和分区情况

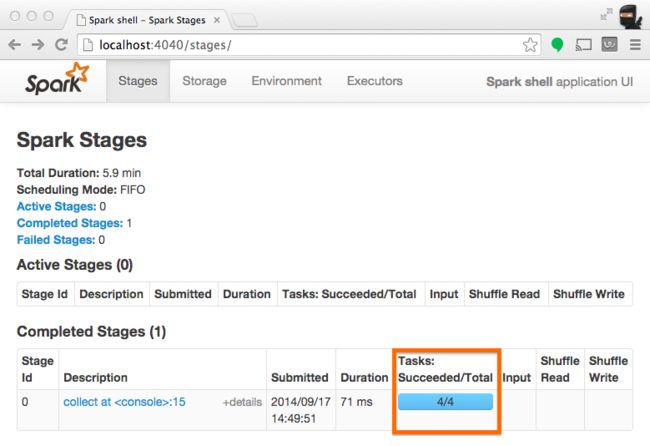

当一个stage执行的时候,你可以在Spark UI中查看一个指定stage的分区个数。例如,下面的代码创建了一个有100个元素,4个分区的RDD。然后在将元素收集回driver程序前做了一个虚拟的map任务:

scala> val someRDD = sc.parallelize(1 to 100, 4)

someRDD: org.apache.spark.rdd.RDD[Int] = ParallelCollectionRDD[0] at parallelize at :12

scala> someRDD.map(x => x).collect

res1: Array[Int] = Array(1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12, 13, 14, 15, 16, 17, 18, 19, 20, 21, 22, 23, 24, 25, 26, 27, 28, 29, 30, 31, 32, 33, 34, 35, 36, 37, 38, 39, 40, 41, 42, 43, 44, 45, 46, 47, 48, 49, 50, 51, 52, 53, 54, 55, 56, 57, 58, 59, 60, 61, 62, 63, 64, 65, 66, 67, 68, 69, 70, 71, 72, 73, 74, 75, 76, 77, 78, 79, 80, 81, 82, 83, 84, 85, 86, 87, 88, 89, 90, 91, 92, 93, 94, 95, 96, 97, 98, 99, 100) 在spark的application UI中,你可以看到如下的截图,其中Total Tastks代表分区的个数:

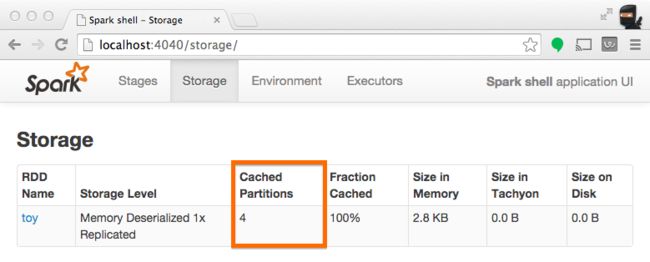

使用Spark UI查看分区缓存

当持久化RDD的时候,这可以用来理解有多少partition被存储。下面的例子中,我们在处理一个RDD前先缓存它。完成之后,我们可以在UI中理解这个操作之后,什么东西被存储了。

scala> someRDD.setName("toy").cache

res2: someRDD.type = toy ParallelCollectionRDD[0] at parallelize at :12

scala> someRDD.map(x => x).collect

res3: Array[Int] = Array(1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12, 13, 14, 15, 16, 17, 18, 19, 20, 21, 22, 23, 24, 25, 26, 27, 28, 29, 30, 31, 32, 33, 34, 35, 36, 37, 38, 39, 40, 41, 42, 43, 44, 45, 46, 47, 48, 49, 50, 51, 52, 53, 54, 55, 56, 57, 58, 59, 60, 61, 62, 63, 64, 65, 66, 67, 68, 69, 70, 71, 72, 73, 74, 75, 76, 77, 78, 79, 80, 81, 82, 83, 84, 85, 86, 87, 88, 89, 90, 91, 92, 93, 94, 95, 96, 97, 98, 99, 100) 在scala的API中,一个RDD保存着它的分区数组的索引,利用这个你可以找出RDD中有多少个分区:

scala> val someRDD = sc.parallelize(1 to 100, 30)

someRDD: org.apache.spark.rdd.RDD[Int] = ParallelCollectionRDD[0] at parallelize at :12

scala> someRDD.partitions.size

res0: Int = 30 在python的API中,也有显式地给出分区数的方法:

In [1]: someRDD = sc.parallelize(range(101),30)

In [2]: someRDD.getNumPartitions()

Out[2]: 30注意在上面的例子中,分区数被故意在初始化的时候设置为30.

本文内容整理自https://databricks.gitbooks.io/databricks-spark-knowledge-base/content/performance_optimization/how_many_partitions_does_an_rdd_have.html,所有权力归原作者所有。