Java干货——datax的二次开发集成rabbitMQ

1.开发背景

最近公司需求,经大量调研后,决定采用阿里的datax,实现多系统之间数据同步,满足平行入库和经复杂业务逻辑处理后入库。

2.开发需求

平行入库直接应用datax现有逻辑,即可实现sqlserver到mysql的数据同步;需要复杂处理入库,则考虑应用rabbitMQ和datax的二次开发插件实现。

3.插件集成过程

3.1下载datax

datax的GitHub地址:https://github.com/alibaba/DataX

下载zip压缩文件

3.2本地解压,导入idea

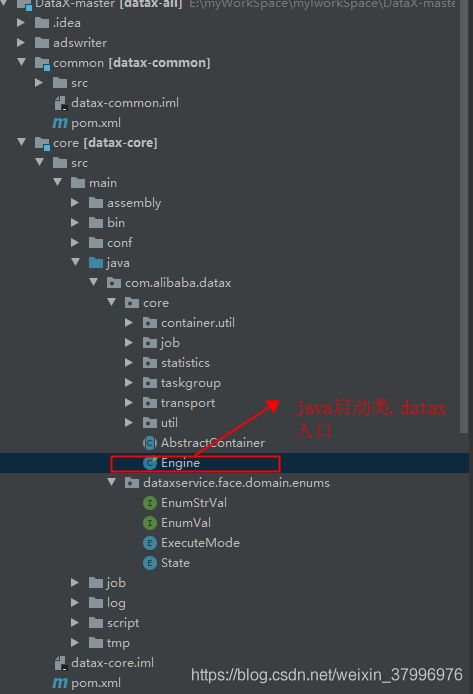

导入过程时间过程,请耐心等待。。。,导入后的结构图

3.3简单介绍datax

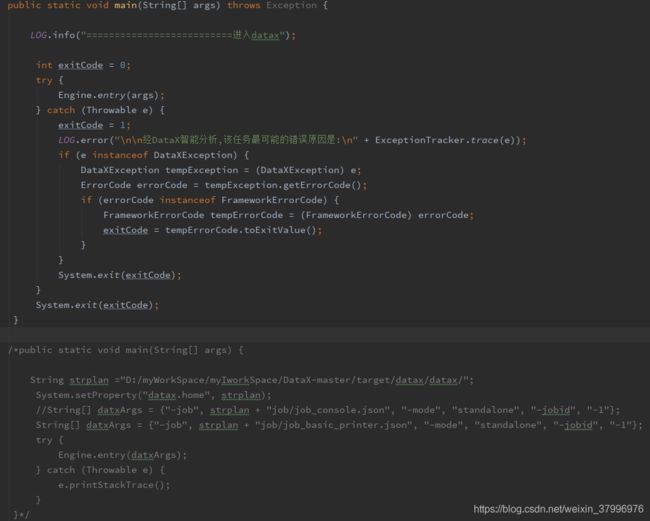

datax启动入口

此处可以通过main方法修改启动,修改执行的json文件的路径(当然datax也更好的支持python的启动命令)

3.4datax集成rabbitMQ

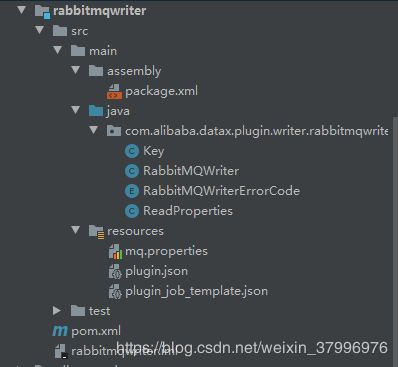

创建一个模块rabbitmqwriter,根据其他模块复制相应的结构,

3.5修改rabbitmqwriter相应文件和编写处理过程

rabbitmqwriter模块package.xml

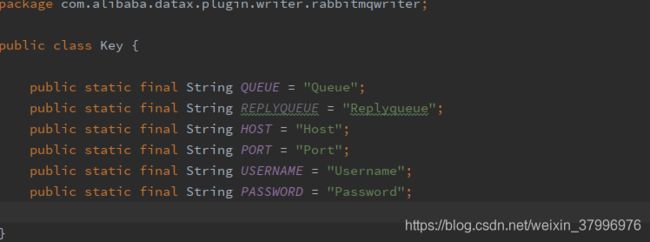

rabbitmqwriter模块Key

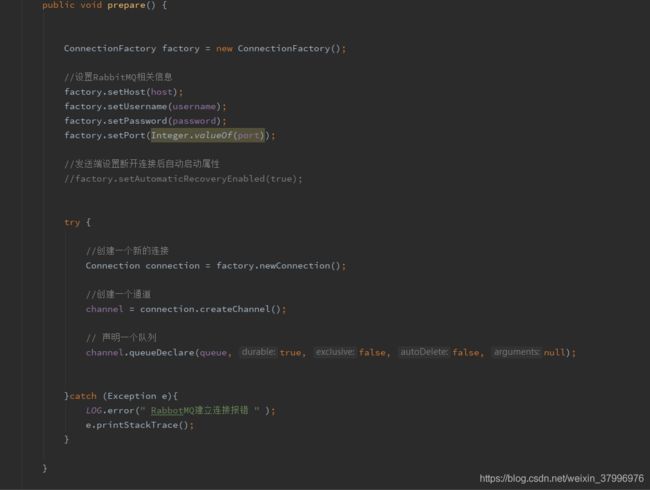

rabbitmqwriter模块RabbitMQWriter(其实是rabbitmq客户端)

rabbitmqwriter模块RabbitMQWriterErrorCode

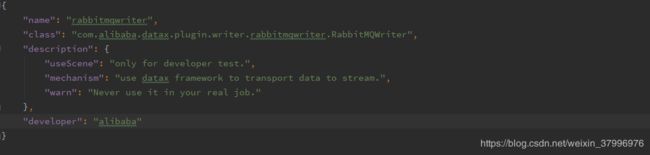

rabbitmqwriter模块plugin.json

rabbitmqwriter模块pom.xml 添加rabbitmq的jar

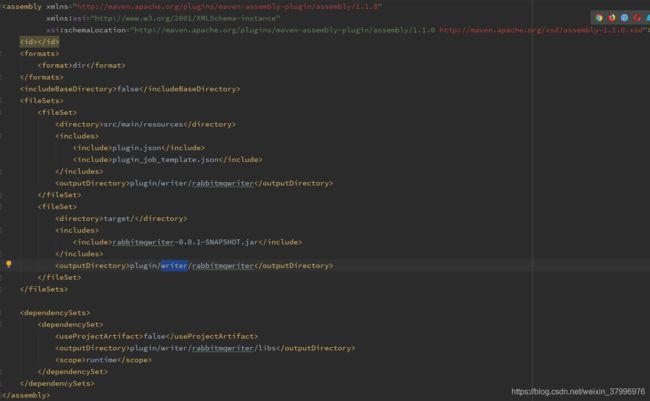

3.5修改datax主工程配置

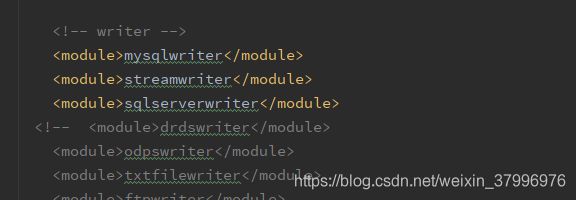

修改主目录package.xml,添加rabbitmqwriter模块,将应用不到的模块屏蔽掉。

修改主目录pom.xml

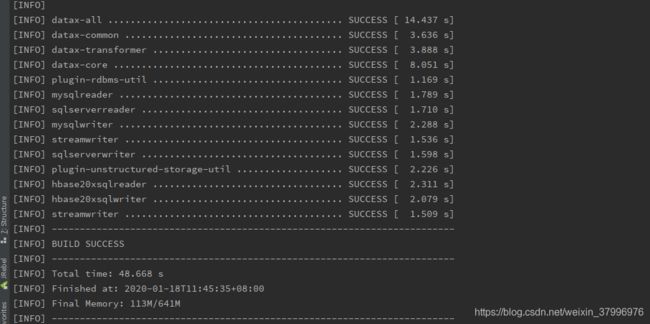

4maven打包

在idea的terminal中执行 mvn -U clean package assembly:assembly -Dmaven.test.skip=true

完成打包

5编写json文件

6启动

python /datax/bin/datax.py -p Dpath=/data/log/2020/01/05" /datax/job/kafkatohdfs.json