- 【扩散模型Diffusion Model系列】1-一篇文章带你快速入门扩散模型Diffusion Model,个人入门学习路线+优质学习博客资料

Leafing_

DiffusionModel扩散模型人工智能深度学习AIGC扩散模型AI视频生成算法人工智能深度学习

文章目录零、写在前面一、扩散理论缘起DDPM再见,马尔科夫!高视角DDIMLevelup!更高视角SDE、ScoreMatching、ODE走直线!RectifiedFlow和FlowMatching二、模型结构传统派LDMUNet:StableDiffusion维新派MMDiT:StableDiffusion3/Flux三、加速采样多走一步,再比较ConsistencyModel/LCM半白箱采

- C# WPF入门学习主线篇(二十四)—— 数据绑定基础

Ice bear433

学习C#WPFc#wpf学习

C#WPF入门学习主线篇(二十四)——数据绑定基础数据绑定是WPF的重要特性之一,它允许UI元素和数据源之间建立连接,从而实现数据的自动更新和显示。通过数据绑定,开发者可以减少大量的手动更新代码,使应用程序更具响应性和可维护性。本篇博客将详细介绍WPF数据绑定的基础知识,包括单向绑定、双向绑定、绑定路径和数据上下文。1.数据绑定基础数据绑定是指将控件的属性与数据源进行连接,使得控件的显示内容和数据

- Python零基础快速入门学习笔记

恨不相逢未涨时

pythonpython学习笔记

文章目录1.安装python2.安装vscode3.python语法3.1流程控制3.1.1条件语句3.1.2循环语句3.2模块与包3.2.1模块3.2.2包3.3数据类型3.3.1数字(Number)3.3.2字符串(string)3.3.3列表(list)3.3.4元组(tuple)3.3.5集合(set)3.3.6字典(dict)3.4异常处理3.5类、对象、方法3.5.1类与对象3.5.2

- PySpark实现导出两个包含多个Parquet数据文件的S3目录里的对应值的差异值分析

weixin_30777913

pythonspark数据分析云计算

编写PySpark代码实现从一个包含多个Parquet数据文件的AmazonS3目录的dataframe数据里取两个维度字段,一个度量字段的数据,根据这两个维度字段的数据分组统计,计算度量字段的数据的分组总计值,得到一个包含两个维度字段和度量字段的分组总计值字段的dataframe,再从另一个包含多个Parquet数据文件的S3目录的dataframe数据里取两个维度字段,一个度量字段的数据组成一

- 大语言模型(LLM)入门学习路线图_llm教程,从零基础到精通,理论与实践结合的最佳路径!

AGI学习社

语言模型学习人工智能LLM大模型大数据自然语言处理

Github项目上有一个大语言模型学习路线笔记,它全面涵盖了大语言模型的所需的基础知识学习,LLM前沿算法和架构,以及如何将大语言模型进行工程化实践。这份资料是初学者或有一定基础的开发/算法人员入门活深入大型语言模型学习的优秀参考。这份资料重点介绍了我们应该掌握哪些核心知识,并推荐了一系列优质的学习视频和博客,旨在帮助大家系统性地掌握大型语言模型的相关技术。大语言模型(LargeLanguageM

- 大语言模型(LLM)入门学习路线图,从零基础到精通,理论与实践结合的最佳路径!

ai大模型应用开发

语言模型学习人工智能机器学习AI自然语言处理

Github项目上有一个大语言模型学习路线笔记,它全面涵盖了大语言模型的所需的基础知识学习,LLM前沿算法和架构,以及如何将大语言模型进行工程化实践。这份资料是初学者或有一定基础的开发/算法人员入门活深入大型语言模型学习的优秀参考。这份资料重点介绍了我们应该掌握哪些核心知识,并推荐了一系列优质的学习视频和博客,旨在帮助大家系统性地掌握大型语言模型的相关技术。大语言模型(LargeLanguageM

- Unity入门学习笔记(Day01)

Alika-snowr

unity学习unity学习笔记

一.认识unity工作面板1.1.projectwindow(项目面板)显示当前项目中的所有文件和目录,包含了项目里面所有的资源文件1.2.consolewindow(输出面板)显示当前游戏开发中生成的警告错误1.3.hierarchywindow(层次面板)也称为场景面板,显示当前的场景中所有游戏游戏对象,并显示父子级关系;我们说开发的游戏是由一个一个的场景组成的(类型与拍戏的场次场景)游戏物体

- Java初级入门学习

周杰伦fans

ai学习参考JAVA后端框架java学习开发语言

JAVA学习@[TOC](JAVA学习)**一、Java初级入门学习路径****1.Java基础语法****2.面向对象编程(OOP)****3.数据库与JDBC****4.JavaWeb基础****二、主流框架推荐与学习建议****1.Spring框架****2.SpringMVC****3.MyBatis****4.SpringBoot****三、后续学习建议****1.实战项目****2.进

- 分布式计算入门(PySpark处理NASA服务器日志)

闲人编程

Python数据分析实战精要服务器运维统计分析日志NASA服务器分布式计算PySpark

目录分布式计算入门(PySpark处理NASA服务器日志)1.引言2.分布式计算概述2.1分布式计算的基本概念2.2ApacheSpark与PySpark3.NASA服务器日志数据集介绍3.1数据背景3.2数据格式与挑战4.PySpark基础与分布式日志处理4.1PySpark基本架构4.2日志数据加载与解析4.3数据清洗与内存优化4.4GPU加速与SparkRAPIDS5.实验环境与依赖库6.数

- 小甲鱼零基础入门python教程视频_小甲鱼零基础入门学习python 共96集(含源码+课件+课后习题) 百度云盘...

weixin_39725154

【Python教程】小甲鱼零基础入门学习python共96集(含源码+课件+课后习题)小甲鱼零基础入门学习python共96集(含源码+课件+课后习题)百度云盘下载链接1:http://pan.baidu.com/s/1i5eR1fZ密码:8juz??解压密码:www.zygx8.com小甲鱼零基础入门学习Python视频(无课件)http://pan.baidu.com/s/1eRANzPK小甲

- [Python入门学习记录(小甲鱼)]第4章 分支与循环

LIN-JUN-WEI

python学习开发语言嵌入式硬件单片机

第4章分支和循环讲些条件语句和循环语句4.1完整条件语句ifx>1:print(1)elifxstopstep0forxinrange(10)print(x)#打印0-9加上list()会像列表一下展示print(list(range(0,-10,-1)))#[0,-1,-2,-3,-4,-5,-6,-7,-8,-9]4.6break语句就一样,跳出这整个循环fornuminrange(1,11)

- 【PCIe 总线及设备入门学习专栏 4.5 -- PCIe 中断 MSI 与 MSI-X 机制介绍】

主公讲 ARM

#【PCIeBus专栏】PCIemsiPCIeMSI-XPCIe中断机制MSI-X中断机制MSI中断机制PCI中断

文章目录PCI设备中断机制PCIe设备中断机制PCIeMSI中断机制MSICapabilityMSI-X中断机制MSI-XcapabilityMSI-XTablePBAMSI-Xcapability解析MSI/MSI-X操作流程扫描设备配置设备MSI配置MSI-X配置中断触发与处理PCI设备中断机制以前的PCI设备是支持物理上的INTA/B/C/D中断信号,设备可以可以表明自己通过哪个引脚来发出中

- 基于Vue&Axios制作音乐播放器(bilibili黑马程序员Vue入门学习记录)

xxxrsongseven

前端javascriptvuevue.js前端css

目录使用Vue制作一个音乐播放器前言VueVue导入Vue挂载Vue指令v-textv-htmlv-onv-showv-ifv-bindv-forv-modelaxiosaxios导入axios使用音乐网站代码HTMLCSSJS使用Vue制作一个音乐播放器前言第一次写,如有不足请指正!音乐播放器效果展示音乐播放器(密码:He371226)(域名出了点问题,临时使用)学习链接:黑马程序员vue前端基

- Rust入门学习笔记

凌云行者

Rustrust入门笔记

Rust简介特点即安全又高效,并发是一种静态编译语言,要在写代码时声明数据类型擅长领域高性能WebServiceWebAssembly命令行工具网络编程嵌入式设备系统编程操作更新rust:rustupupdate卸载rust:rustupselfuninstall查看rust版本:rustc--version查看本地文档:rustupdoc用vscode打开某项目:进入项目目录后code.文件名后

- PySpark实现获取S3上Parquet文件的数据结构,并自动在Snowflake里建表和生成对应的建表和导入数据的SQL

weixin_30777913

pythonawssqlspark

PySpark实现S3上解析存储Parquet文件的多个路径,获取其中的数据Schema,再根据这些Schema,参考以下文本,得到创建S3路径Stage的SQL语句和上传数据到Snowflake数据库的SQL语句,同样的Stage路径只需创建一个Stage对象即可,并在S3上保存为SQL,并在Snowflake里创建对应的表,并在S3上存储创建表的SQL语句。要将存储在S3上的Parquet文件

- 学习嵌入式必须学习32单片机吗?

嵌入式开发胖胖

单片机学习嵌入式硬件

不要去学STM32”。我不是说STM32不好,而是这种为了学习单片机而去学习单片机的思路不对。你问,如何系统地入门学习stm32?这本身就是一个错误的问题。假如你会使用8051,会写C语言,那么STM32本身并不需要刻意的学习。你要考虑的是,我可以用STM32实现什么?为什么使用STM32而不是8051?是因为51的频率太低,无法满足计算需求

- 【ESP 保姆级教程】玩转巴法云篇② ——MQTT设备云,MQTT协议下的数据通信(ESP32版本)

单片机菜鸟哥

ESP8266/ESP32保姆级教程300篇单片机嵌入式硬件

忘记过去,超越自己❤️博客主页单片机菜鸟哥,一个野生非专业硬件IOT爱好者❤️❤️本篇创建记录2023-03-30❤️❤️本篇更新记录2023-03-30❤️欢迎关注点赞收藏⭐️留言此博客均由博主单独编写,不存在任何商业团队运营,如发现错误,请留言轰炸哦!及时修正!感谢支持!ArduinoESP8266教程累计帮助过超过1W+同学入门学习硬件网络编程,入选过选修课程,刊登过无线电杂志菜鸟项目合集快

- Deepseek提示词

易林示

AI人工智能

【公式6】任务型提问(信息获取/执行)结构:核心目标(一句话概括需求)背景补充(相关细节或限制条件)明确要求(期望的格式/重点)示例:"我需要一份Python入门学习计划(核心目标)。目前每天有2小时学习时间,零基础(背景)。请分周列出知识点和推荐资源(要求)。"【公式7】问题解决型提问(分析/建议)结构:问题描述(具体现象或难点)尝试过的方法(已采取的措施)预期目标(希望达成的结果)示例:"我的

- 机器学习_PySpark-3.0.3随机森林回归(RandomForestRegressor)实例

Mostcow

数据分析Python机器学习随机森林回归大数据

机器学习_PySpark-3.0.3随机森林回归(RandomForestRegressor)实例随机森林回归(RandomForestRegression):任务类型:随机森林回归主要用于回归任务。在回归任务中,算法试图预测一个连续的数值输出,而不是一个离散的类别。输出:随机森林回归的输出是一个连续的数值,表示输入数据的预测结果。算法原理:随机森林回归同样基于决策树,但在回归任务中,每个决策树的

- 强者联盟——Python语言结合Spark框架

博文视点

全栈工程师全栈全栈数据SparkPythonPySpark

引言:Spark由AMPLab实验室开发,其本质是基于内存的快速迭代框架,“迭代”是机器学习最大的特点,因此非常适合做机器学习。得益于在数据科学中强大的表现,Python语言的粉丝遍布天下,如今又遇上强大的分布式内存计算框架Spark,两个领域的强者走到一起,自然能碰出更加强大的火花(Spark可以翻译为火花),因此本文主要讲述了PySpark。本文选自《全栈数据之门》。全栈框架Spark由AMP

- Airflow和PySPARK实现带多组参数和标签的Amazon Redshift数据仓库批量数据导出程序

weixin_30777913

pythonspark云计算

设计一个基于多个带标签SQL模板作为配置文件和多组参数的PySPARK代码程序,实现根据不同的输入参数,用Airflow进行调度,自动批量地将AmazonRedshift数据仓库的数据导出为Parquet、CSV和Excel文件到S3上,标签和多个参数(以“_”分割)为组成导出数据文件名,文件已经存在则覆盖原始文件。PySpark程序需要异常处理,输出带时间戳和每个运行批次和每个导出文件作业运行状

- Rust 入门学习笔记(一)

mask-li

rust学习开发语言

介绍Rust程序设计语言的本质实际在于赋能(empowerment):无论你现在编写的是何种代码,Rust能让你在更为广泛的编程领域走得更远,写出自信。(这一点并不显而易见)举例来说,那些“系统层面”的工作涉及内存管理、数据表示和并发等底层细节。从传统角度来看,这是一个神秘的编程领域,只为浸润多年的极少数人所触及,也只有他们能避开那些臭名昭著的陷阱。即使谨慎的实践者,亦唯恐代码出现漏洞、崩溃或损坏

- 【PCIe 总线及设备入门学习专栏 10.1 -- Linux PCIe 驱动框架 之 RK3399 Region1 访问】

主公讲 ARM

#【PCIeBus专栏】pcie

文章目录CPU读写region0的地址MEM/IO读写示例配置Region1用于内存读写配置Region1地址转换Region1地址访问descregistersCPU读写region0的地址本篇文章紧接【PCIe总线及设备入门学习专栏10–LinuxPCIe驱动框架】由【PCIe总线及设备入门学习专栏10–LinuxPCIe驱动框架】我们知道RK3399的PCIecontrollerRegion

- 瑞芯微RK安卓Android主板GPIO按键配置方法,触觉智能嵌入式开发

Industio_触觉智能

嵌入式开发RK3562RK3568RK3566串口调试开发板外设

触觉智能分享,瑞芯微RK安卓Android主板GPIO按键配置方法,方便大家更好利用空闲IO!由触觉智能PurplePiOH鸿蒙开发板演示,搭载了瑞芯微RK3566四核处理器,树莓派卡片电脑设计,支持安卓Android、开源鸿蒙OpenHarmony、Linux多系统,适合嵌入式开发入门学习。设备树修改空闲IO选择由下图可得当前IO是主板上一个没有用到的IO,对应的GPIO为:GPIO4_A4。设

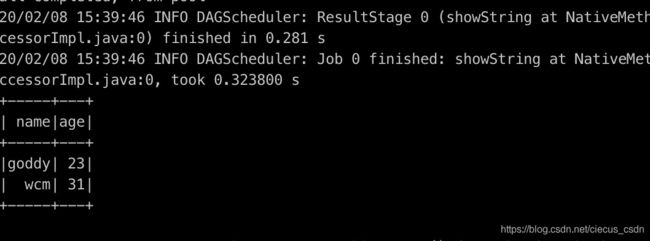

- Spark之PySpark

james二次元

大数据SparkPythonPySpark

PySpark是ApacheSpark的PythonAPI,它允许开发者使用Python编程语言进行大规模数据处理和分析。ApacheSpark是一个快速、通用、可扩展的大数据处理引擎,支持批处理、流处理、机器学习、图计算等多种数据处理模式。PySpark使得Python开发者能够利用Spark强大的分布式计算能力,处理大数据集,并执行高效的并行计算。一、PySpark核心概念1.RDD(弹性分布

- 大语言模型(LLM)入门学习路线图,附资源汇总,收藏这篇就够了

AI小白熊

语言模型学习人工智能aitransformer深度学习

Github项目上有一个[大语言模型学习路线笔记]“大语言模型学习路线笔记”),它全面涵盖了大语言模型的所需的基础知识学习,LLM前沿算法和架构,以及如何将大语言模型进行工程化实践。这份资料是初学者或有一定基础的开发/算法人员入门活深入大型语言模型学习的优秀参考。这份资料重点介绍了我们应该掌握哪些核心知识,并推荐了一系列优质的学习视频和博客,旨在帮助大家系统性地掌握大型语言模型的相关技术。大语言模

- Python入门学习指南

小码快撩

python开发语言

Python是一种高级编程语言,因其简洁和易读性而广受欢迎。无论你是编程新手还是有经验的开发者,Python都是一个很好的选择。本文将带你入门Python编程,涵盖基本概念和常用语法。1.安装Python首先,你需要在你的计算机上安装Python。你可以从Python官方网站下载并安装最新版本的Python。安装过程中,请确保勾选“AddPythontoPATH”选项。2.第一个Python程序安

- 不要再走弯路了2025最全的黑客入门学习路线在这

渗透代老师

学习网络安全安全网络web安全

基于入门网络安全/黑客打造的:黑客&网络安全入门&进阶学习资源包在大多数的思维里总觉得[学习]得先收集资料、学习编程、学习计算机基础,这样不是不可以,但是这样学效率太低了!你要知道网络安全是一门技术,任何技术的学习一定是以实践为主的。也就是说很多的理论知识其实是可以在实践中去验证拓展的,这样学习比起你啃原理、啃书本要好理解很多。所以想要学习网络安全选对正确的学习方法很重要,这可以帮你少走很多弯路。

- 探索Perl语言:入门学习与实战指南

洛秋_

后端开发perl

文章目录探索Perl语言:入门学习与实战指南一、Perl语言概述二、Perl的安装与配置安装PerlWindowsmacOSLinux配置Perl三、基本语法与数据类型标量变量数组哈希四、控制结构条件语句循环语句五、子程序与模块子程序模块六、文件操作与正则表达式文件读取与写入正则表达式应用七、常用模块介绍DBI模块LWP模块JSON模块八、实战案例简单的Web爬虫数据库操作九、测试接口与详细解释接

- OpenCV-Python实战(4)——OpenCV常见图像处理技术_opencv图像处理实战简答

2401_84281648

程序员opencvpython图像处理

OpenCV-Python实战(4)——OpenCV常见图像处理技术0.前言1.拆分与合并通道2.图像的几何变换2.1缩放图像2.2平移图像2.3旋转图像2.4图像的仿射变换2.5图像的透视变换2.6裁剪图像3.图像滤波如何自学黑客&网络安全黑客零基础入门学习路线&规划初级黑客1、网络安全理论知识(2天)①了解行业相关背景,前景,确定发展方向。②学习网络安全相关法律法规。③网络安全运营的概念。④等

- xml解析

小猪猪08

xml

1、DOM解析的步奏

准备工作:

1.创建DocumentBuilderFactory的对象

2.创建DocumentBuilder对象

3.通过DocumentBuilder对象的parse(String fileName)方法解析xml文件

4.通过Document的getElem

- 每个开发人员都需要了解的一个SQL技巧

brotherlamp

linuxlinux视频linux教程linux自学linux资料

对于数据过滤而言CHECK约束已经算是相当不错了。然而它仍存在一些缺陷,比如说它们是应用到表上面的,但有的时候你可能希望指定一条约束,而它只在特定条件下才生效。

使用SQL标准的WITH CHECK OPTION子句就能完成这点,至少Oracle和SQL Server都实现了这个功能。下面是实现方式:

CREATE TABLE books (

id &

- Quartz——CronTrigger触发器

eksliang

quartzCronTrigger

转载请出自出处:http://eksliang.iteye.com/blog/2208295 一.概述

CronTrigger 能够提供比 SimpleTrigger 更有具体实际意义的调度方案,调度规则基于 Cron 表达式,CronTrigger 支持日历相关的重复时间间隔(比如每月第一个周一执行),而不是简单的周期时间间隔。 二.Cron表达式介绍 1)Cron表达式规则表

Quartz

- Informatica基础

18289753290

InformaticaMonitormanagerworkflowDesigner

1.

1)PowerCenter Designer:设计开发环境,定义源及目标数据结构;设计转换规则,生成ETL映射。

2)Workflow Manager:合理地实现复杂的ETL工作流,基于时间,事件的作业调度

3)Workflow Monitor:监控Workflow和Session运行情况,生成日志和报告

4)Repository Manager:

- linux下为程序创建启动和关闭的的sh文件,scrapyd为例

酷的飞上天空

scrapy

对于一些未提供service管理的程序 每次启动和关闭都要加上全部路径,想到可以做一个简单的启动和关闭控制的文件

下面以scrapy启动server为例,文件名为run.sh:

#端口号,根据此端口号确定PID

PORT=6800

#启动命令所在目录

HOME='/home/jmscra/scrapy/'

#查询出监听了PORT端口

- 人--自私与无私

永夜-极光

今天上毛概课,老师提出一个问题--人是自私的还是无私的,根源是什么?

从客观的角度来看,人有自私的行为,也有无私的

- Ubuntu安装NS-3 环境脚本

随便小屋

ubuntu

将附件下载下来之后解压,将解压后的文件ns3environment.sh复制到下载目录下(其实放在哪里都可以,就是为了和我下面的命令相统一)。输入命令:

sudo ./ns3environment.sh >>result

这样系统就自动安装ns3的环境,运行的结果在result文件中,如果提示

com

- 创业的简单感受

aijuans

创业的简单感受

2009年11月9日我进入a公司实习,2012年4月26日,我离开a公司,开始自己的创业之旅。

今天是2012年5月30日,我忽然很想谈谈自己创业一个月的感受。

当初离开边锋时,我就对自己说:“自己选择的路,就是跪着也要把他走完”,我也做好了心理准备,准备迎接一次次的困难。我这次走出来,不管成败

- 如何经营自己的独立人脉

aoyouzi

如何经营自己的独立人脉

独立人脉不是父母、亲戚的人脉,而是自己主动投入构造的人脉圈。“放长线,钓大鱼”,先行投入才能产生后续产出。 现在几乎做所有的事情都需要人脉。以银行柜员为例,需要拉储户,而其本质就是社会人脉,就是社交!很多人都说,人脉我不行,因为我爸不行、我妈不行、我姨不行、我舅不行……我谁谁谁都不行,怎么能建立人脉?我这里说的人脉,是你的独立人脉。 以一个普通的银行柜员

- JSP基础

百合不是茶

jsp注释隐式对象

1,JSP语句的声明

<%! 声明 %> 声明:这个就是提供java代码声明变量、方法等的场所。

表达式 <%= 表达式 %> 这个相当于赋值,可以在页面上显示表达式的结果,

程序代码段/小型指令 <% 程序代码片段 %>

2,JSP的注释

<!-- -->

- web.xml之session-config、mime-mapping

bijian1013

javaweb.xmlservletsession-configmime-mapping

session-config

1.定义:

<session-config>

<session-timeout>20</session-timeout>

</session-config>

2.作用:用于定义整个WEB站点session的有效期限,单位是分钟。

mime-mapping

1.定义:

<mime-m

- 互联网开放平台(1)

Bill_chen

互联网qq新浪微博百度腾讯

现在各互联网公司都推出了自己的开放平台供用户创造自己的应用,互联网的开放技术欣欣向荣,自己总结如下:

1.淘宝开放平台(TOP)

网址:http://open.taobao.com/

依赖淘宝强大的电子商务数据,将淘宝内部业务数据作为API开放出去,同时将外部ISV的应用引入进来。

目前TOP的三条主线:

TOP访问网站:open.taobao.com

ISV后台:my.open.ta

- 【MongoDB学习笔记九】MongoDB索引

bit1129

mongodb

索引

可以在任意列上建立索引

索引的构造和使用与传统关系型数据库几乎一样,适用于Oracle的索引优化技巧也适用于Mongodb

使用索引可以加快查询,但同时会降低修改,插入等的性能

内嵌文档照样可以建立使用索引

测试数据

var p1 = {

"name":"Jack",

"age&q

- JDBC常用API之外的总结

白糖_

jdbc

做JAVA的人玩JDBC肯定已经很熟练了,像DriverManager、Connection、ResultSet、Statement这些基本类大家肯定很常用啦,我不赘述那些诸如注册JDBC驱动、创建连接、获取数据集的API了,在这我介绍一些写框架时常用的API,大家共同学习吧。

ResultSetMetaData获取ResultSet对象的元数据信息

- apache VelocityEngine使用记录

bozch

VelocityEngine

VelocityEngine是一个模板引擎,能够基于模板生成指定的文件代码。

使用方法如下:

VelocityEngine engine = new VelocityEngine();// 定义模板引擎

Properties properties = new Properties();// 模板引擎属

- 编程之美-快速找出故障机器

bylijinnan

编程之美

package beautyOfCoding;

import java.util.Arrays;

public class TheLostID {

/*编程之美

假设一个机器仅存储一个标号为ID的记录,假设机器总量在10亿以下且ID是小于10亿的整数,假设每份数据保存两个备份,这样就有两个机器存储了同样的数据。

1.假设在某个时间得到一个数据文件ID的列表,是

- 关于Java中redirect与forward的区别

chenbowen00

javaservlet

在Servlet中两种实现:

forward方式:request.getRequestDispatcher(“/somePage.jsp”).forward(request, response);

redirect方式:response.sendRedirect(“/somePage.jsp”);

forward是服务器内部重定向,程序收到请求后重新定向到另一个程序,客户机并不知

- [信号与系统]人体最关键的两个信号节点

comsci

系统

如果把人体看做是一个带生物磁场的导体,那么这个导体有两个很重要的节点,第一个在头部,中医的名称叫做 百汇穴, 另外一个节点在腰部,中医的名称叫做 命门

如果要保护自己的脑部磁场不受到外界有害信号的攻击,最简单的

- oracle 存储过程执行权限

daizj

oracle存储过程权限执行者调用者

在数据库系统中存储过程是必不可少的利器,存储过程是预先编译好的为实现一个复杂功能的一段Sql语句集合。它的优点我就不多说了,说一下我碰到的问题吧。我在项目开发的过程中需要用存储过程来实现一个功能,其中涉及到判断一张表是否已经建立,没有建立就由存储过程来建立这张表。

CREATE OR REPLACE PROCEDURE TestProc

IS

fla

- 为mysql数据库建立索引

dengkane

mysql性能索引

前些时候,一位颇高级的程序员居然问我什么叫做索引,令我感到十分的惊奇,我想这绝不会是沧海一粟,因为有成千上万的开发者(可能大部分是使用MySQL的)都没有受过有关数据库的正规培训,尽管他们都为客户做过一些开发,但却对如何为数据库建立适当的索引所知较少,因此我起了写一篇相关文章的念头。 最普通的情况,是为出现在where子句的字段建一个索引。为方便讲述,我们先建立一个如下的表。

- 学习C语言常见误区 如何看懂一个程序 如何掌握一个程序以及几个小题目示例

dcj3sjt126com

c算法

如果看懂一个程序,分三步

1、流程

2、每个语句的功能

3、试数

如何学习一些小算法的程序

尝试自己去编程解决它,大部分人都自己无法解决

如果解决不了就看答案

关键是把答案看懂,这个是要花很大的精力,也是我们学习的重点

看懂之后尝试自己去修改程序,并且知道修改之后程序的不同输出结果的含义

照着答案去敲

调试错误

- centos6.3安装php5.4报错

dcj3sjt126com

centos6

报错内容如下:

Resolving Dependencies

--> Running transaction check

---> Package php54w.x86_64 0:5.4.38-1.w6 will be installed

--> Processing Dependency: php54w-common(x86-64) = 5.4.38-1.w6 for

- JSONP请求

flyer0126

jsonp

使用jsonp不能发起POST请求。

It is not possible to make a JSONP POST request.

JSONP works by creating a <script> tag that executes Javascript from a different domain; it is not pos

- Spring Security(03)——核心类简介

234390216

Authentication

核心类简介

目录

1.1 Authentication

1.2 SecurityContextHolder

1.3 AuthenticationManager和AuthenticationProvider

1.3.1 &nb

- 在CentOS上部署JAVA服务

java--hhf

javajdkcentosJava服务

本文将介绍如何在CentOS上运行Java Web服务,其中将包括如何搭建JAVA运行环境、如何开启端口号、如何使得服务在命令执行窗口关闭后依旧运行

第一步:卸载旧Linux自带的JDK

①查看本机JDK版本

java -version

结果如下

java version "1.6.0"

- oracle、sqlserver、mysql常用函数对比[to_char、to_number、to_date]

ldzyz007

oraclemysqlSQL Server

oracle &n

- 记Protocol Oriented Programming in Swift of WWDC 2015

ningandjin

protocolWWDC 2015Swift2.0

其实最先朋友让我就这个题目写篇文章的时候,我是拒绝的,因为觉得苹果就是在炒冷饭, 把已经流行了数十年的OOP中的“面向接口编程”还拿来讲,看完整个Session之后呢,虽然还是觉得在炒冷饭,但是毕竟还是加了蛋的,有些东西还是值得说说的。

通常谈到面向接口编程,其主要作用是把系统��设计和具体实现分离开,让系统的每个部分都可以在不影响别的部分的情况下,改变自身的具体实现。接口的设计就反映了系统

- 搭建 CentOS 6 服务器(15) - Keepalived、HAProxy、LVS

rensanning

keepalived

(一)Keepalived

(1)安装

# cd /usr/local/src

# wget http://www.keepalived.org/software/keepalived-1.2.15.tar.gz

# tar zxvf keepalived-1.2.15.tar.gz

# cd keepalived-1.2.15

# ./configure

# make &a

- ORACLE数据库SCN和时间的互相转换

tomcat_oracle

oraclesql

SCN(System Change Number 简称 SCN)是当Oracle数据库更新后,由DBMS自动维护去累积递增的一个数字,可以理解成ORACLE数据库的时间戳,从ORACLE 10G开始,提供了函数可以实现SCN和时间进行相互转换;

用途:在进行数据库的还原和利用数据库的闪回功能时,进行SCN和时间的转换就变的非常必要了;

操作方法: 1、通过dbms_f

- Spring MVC 方法注解拦截器

xp9802

spring mvc

应用场景,在方法级别对本次调用进行鉴权,如api接口中有个用户唯一标示accessToken,对于有accessToken的每次请求可以在方法加一个拦截器,获得本次请求的用户,存放到request或者session域。

python中,之前在python flask中可以使用装饰器来对方法进行预处理,进行权限处理

先看一个实例,使用@access_required拦截:

?

![]()