【深度学习】DeepMind关系推理网络

Santoro, Adam, et al. “A simple neural network module for relational reasoning.” arXiv preprint arXiv:1706.01427 (2017).

简介

本文用一个普适的关系网络RNs(Relation Networks)来解决“关系推理”(relational reasoning)问题。其使用的模型结构简单,效果远胜已有算法,甚至超出人类表现。

论文于2017年6月5日在arxiv发布。由于其原理简明,爱好者们很快给出了pytorch实现、keras实现以及tensorflow实现。

关系推理问题

关系推理问题由三部分组成。

一系列事实,即推理的素材。可以是:

- 一张图片:红色的球,黄色的圆柱,蓝色的立方体。

- 一组场景信息:每个物体的类别,颜色,尺寸,位置。

- 几个句子:Mike拿着足球。Mike去了办公室。

- 一段数据:几个球在物理系统中弹跳,其中某几个有隐形杆相连。给出这些球的实时位置。

一个问题,作为推理的提示。由于强调关系,这些问题都涉及不止一个对象。例如:

- 红色和黄色物体是否为同一类?

- 哪个物体离蓝色球最远?

- 足球在哪里?

- 那些物体在运动时是相连的?

一个回答,即推理的结果。例如:

- (红色和黄色物体)是(同一类)。

- 黄圆柱。

- (足球在)办公室。

- A球和B球(是相连的)。

在训练集中,每组数据包含1.2.3;在测试集中,每组数据包含1.2, 要求回答出3。

说明:问题和回答不局限于自然语言。也可能使用结构化数据表示。

网络结构

系统

事实 O 和问题 Q 都经过不同的embedding网络提取特征变为 o,q 。这l两者构成系统的processing部分。

对于不同类别的输入,embedding可能是CNN(图像)或LSTM(自然语言)。

两个特征送入reasoning部分,推理出回答 a 。

传统的推理网络中,reasoning部分可能是MLP,LSTM,或者带有attention的LSTM。

关系网络RN

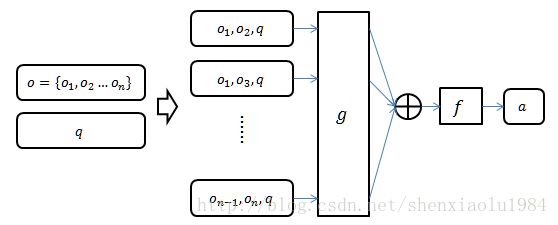

本文使用关系网络(Relational Network)实现reasoning部分。

其理念非常直观

- 把事实特征分解成一系列对象 o={o1,o2...on}

- 把对象两两配对,和问题特征 q 组成三元组

- 将三元组送入一个统一的MLP网络 g

- 得到的结果相加,再次送入一个MLP网络 f ,输出回答 a

可以用一个公式表达:

RN的这种结构明确地表达了关系推理的两个思想:

1. 最终答案和成对的对象有关

2. 问题本身也会影响如何考察对象对

举例:如果问题中包含“多远”,则应该关注两个对象的距离;如果问题中包含“和…颜色相同”,则应该关注两个对象的颜色。

具体实现

本文的实验设置非常详尽,具体可参看附录部分。这里只概述几个例子,大致建立基本概念。

特征提取

图像

不同任务均使用CNN对图像进行编码。差别仅在于卷积层具体参数。

使用如下步骤获得对象 oi

- 原始图像归一化尺寸

- 经过一个卷积层获得 p×q×k 的结果

- 再经过Batch Normalization层和ReLU

- 结果中每个像素位置的 k 维特征 + 该像素归一化位置 = k+2 维 oi 1

试验中k=24。

自然语言

首先每个单词经过特征提取网络转化为32位特征。

之后把句子经过LSTM转换成特征,LSTM的单元数为32,128或256。

对于由多个句子组成的事实,每个句子的特征+该句子在事实集合中位置 = 对象 oi ;

对于问题,该问句的特征即为 q 。

结构化数据

将每个物体的结构化数据(位置、颜色、尺寸、材质)直接作为对象特征。

RN网络

不同任务使用RN网络结构类似,以下举出一例。

g :4层MLP,每层256个节点;ReLU激活。

f :3层MLP,各层节点256-256-29;50%的drop-out;ReLU激活;softmax输出各种答案的概率。

结论

比起已有系统的特征提取部分(ResNet,VGG),本文的特征提取模型简单,却仍取得更好效果。这证明:

关系推理问题的难点在“推理”部分,而非信息处理部分。

对于非关系推理类问题,本文系统与已有系统表现类似;但在关系推理问题中,本文远远胜出。说明:

本文RN网络的成对结构是解决关系推理的关键。

作者在未来工作的展望中,希望把RN结构应用到更广泛的问题中,例如强化学习的复杂场景理解,社交网络建模,抽象问题求解等。还可以利用attention机制缩减对象对的规模,以节约资源。

- 本文的一作Adam Santoro(ID: asantoro)在这个reddit讨论串中阐明了这一点。 ↩