- 【Elasticsearch 实战应用】

wenshao.du

elasticsearch

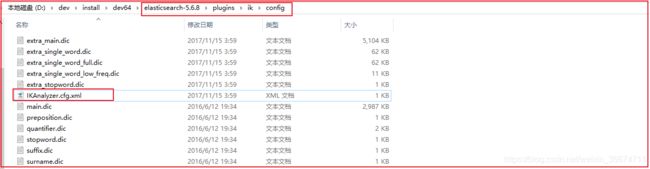

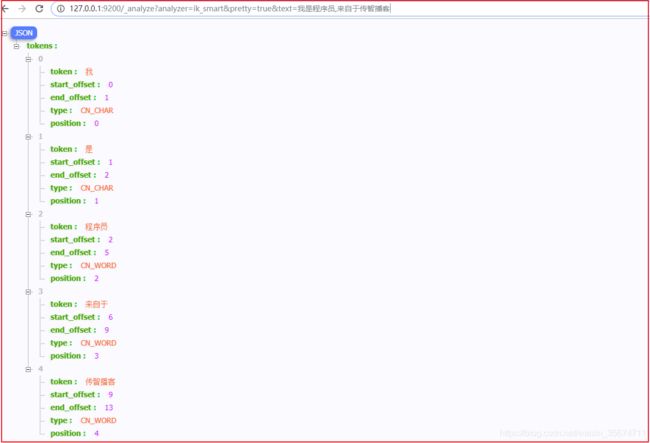

Elasticsearch实战应用在现代企业技术架构中,Elasticsearch因其出色的性能、可扩展性和易用性,成为了处理大规模数据和构建搜索引擎的首选工具。本文将通过一个实际案例,详细讲解如何在SpringBoot项目中集成Elasticsearch,进行数据索引、搜索、聚合分析等操作。1.Elasticsearch简介Elasticsearch是一个基于ApacheLucene构建的开源分

- 在Linux中修改vm.max_map_count参数的步骤

行路见知

linux运维

使用docker安装es时报错,Elasticsearch需要更多的虚拟内存区域ERROR:[1]bootstrapchecksfailed.Youmustaddressthepointsdescribedinthefollowing[1]linesbeforestartingElasticsearch.bootstrapcheckfailure[1]of[1]:maxvirtualmemorya

- 【Elasticsearch集群】轻松部署 Elasticsearch:8.0 集群

库洛王子

Elasticsearchelasticsearchjenkins大数据

概要一文教你轻松掌握Elasticsearch:8.0+集群部署,JDK17+环境准备准备3台centos服务器:192.168.0.10、192.168.0.11、192.168.0.121、更新系统yumupdate2、安装jdkElasticsearch8.x要求JDK17。JDK17是当前的LTS版本,建议使用它来运行Elasticsearch8.x以获得最佳性能和安全支持。(步骤略)4、

- Elasticsearch 中的节点(比如共 20 个),其中的10 个选了一个 master,另外 10 个选了另一个 master,怎么办?思维导图 代码示例(java 架构)

用心去追梦

elasticsearchjava架构

在Elasticsearch中,如果出现集群分裂(Split-brain)的情况,即一部分节点选举了一个Master节点,而另一部分节点选举了另一个Master节点,这会导致数据不一致和集群不可用。Elasticsearch通过配置discovery.seed_hosts和cluster.initial_master_nodes参数来避免这种情况,并确保有足够的节点参与选举以达成共识。为了防止Sp

- ElasticSearch索引别名的应用

elasticsearch

个人博客:无奈何杨(wnhyang)个人语雀:wnhyang共享语雀:在线知识共享Github:wnhyang-OverviewElasticsearch索引别名是一种极为灵活且强大的功能,它允许用户为一个或多个索引创建逻辑上的别名。这些别名用途广泛,涵盖查询、索引操作以及索引管理等多个方面。以下为一些常见的索引别名应用场景:简化查询通过创建别名,用户能够以更简洁的名称访问一个或多个索引。例如,若

- 试试 Elasticsearch 的 unsigned_long(qbit)

elasticsearch整数

前言本文在Elasticsearch7.17下测试Elasticsearch自7.10引入了64位无符号整数unsigned_long,之前只有long已知long的数据范围[-2^63,2^63-1]即[-9223372036854775808,9223372036854775807]已知unsigned_long的数据范围[0,2^64-1]即[0,18446744073709551615]试

- Elasticsearch 8.x 重要变化(qbit)

前言本文记录的重要变化重要与否为qbit个人判断官方Releasenotes:https://www.elastic.co/guide/en/elasticsearch/reference/curre...收费功能查看:ElasticStacksubscriptions回顾:向量搜索创新的时间线8.0(2022-02-11)What’snewin8.0默认启用安全特性(Securityfeatur

- 学英语学技术:Elasticsearch 线程池

学会了没

elasticsearch大数据搜索引擎

单词汉语意思音标allocate分配/ˈæləˌkeɪt/coordination协调/koʊˌɔːrdɪˈneɪʃn/deprecated废弃的/ˈdɛprəˌkeɪtɪd/elasticsearch弹性搜索(专有名词)/ˌɛlɪkˈsɜːrtʃ/execute执行/ˈɛksɪˌkjuːt/generic通用的/dʒəˈnɛrɪk/initial初始的/ɪˈnɪʃəl/metadata元数据/ˈ

- 芝法酱学习笔记(2.5)——elastic-search 8.x初探(自用)

芝法酱

elasticsearchspringboot

一、elastic-search的下载官网的下载地址在这里。官网文档地址在这里访问路径是doc/search让人惊呆了,新版的elastic-search竟然需要JDK23。ThelocaledatabaseusedbyElasticsearch,usedtomapfromvariousdateformatstotheunderlyingdatestorageformat,dependsonthe

- Nacos 监控全攻略:从 Prometheus 数据采集到核心指标解读

磐基Stack专业服务团队

NacosNacos

文章目录第1章Prometheus采集Nacosmetrics数据第2章Nacosmetrics含义2.1jvmmetrics2.2Nacos监控指标2.3nacos异常指标2.4clientmetricsNacos2.X版本已有完善的监控体系,支持通过暴露metrics数据接入第三方监控系统监控Nacos运行状态,目前支持prometheus、elasticsearch和influxdb。下面重

- docker部署ELK日志系统+kafka

weixin_50837690

dockerkafkaelkelasticsearch

docker部署ELK日志系统+kafka1.部署elasticsearch#拉取镜像dockerpullelasticsearch:7.6.2#创建文件夹mkdir-p/data/elk/es/config#创建elasticsearch.yml文件vi/data/elk/es/config/elasticsearch.yml------------------------写入---------

- 基于docker微服务日志ELK+Kafka搭建

我是奶龙!我是奶龙!我是奶龙!

docker微服务elkspringcloudspringbootkafka

ELK是Elasticsearch、Logstash、Kibana的简称Elasticsearch是实时全文搜索和分析引擎,提供搜集、分析、存储数据三大功能;是一套开放REST和JAVAAPI等结构提供高效搜索功能,可扩展的分布式系统。它构建于ApacheLucene搜索引擎库之上。Logstash是一个用来搜集、分析、过滤日志的工具。它支持几乎任何类型的日志,包括系统日志、错误日志和自定义应用程

- Elasticsearch二次开发:实现实时定时同步同义词、近义词与停用词

codeBrute

elasticsearch中文分词

Elasticsearch二次开发:实现实时定时同步同义词、近义词与停用词引言Elasticsearch(ES)作为开源搜索引擎的典范,以其强大的全文搜索、结构化搜索以及分析能力,在各个领域得到了广泛应用。在复杂的搜索场景中,同义词、近义词和停用词的处理对于提升搜索的准确性和用户体验至关重要。为了满足动态变化的业务需求,实现同义词、近义词与停用词的定时同步成为了一项关键任务。本文将详细介绍如何在E

- ElasticSearch10-性能优化

李宥小哥

常用中间件性能优化jenkins运维

零、文章目录ElasticSearch10-性能优化1、硬件优化(1)存储配置ElasticSearch是基于Lucene的,Lucene将数据存储在磁盘上,磁盘的IO就是ElasticSearch的瓶颈所在。Elasticsearch默认的数据存储路径是在Elasticsearch安装目录下的data子目录中。不过,这个路径是可以配置的,具体的默认路径可能因操作系统和安装方式的不同而有所差异。对

- ElasticSearch11-8.x 新特性

李宥小哥

常用中间件中间件

零、文章目录ElasticSearch11-8.x新特性1、API变更(1)类型(_type)移除在Elasticsearch8.x中,索引中的_type已经被完全移除。这意味着所有文档在同一个索引中将不再区分类型,简化了索引结构,但同时也要求开发者调整应用程序逻辑以适应这一变化。(2)客户端库更新Elasticsearch8.x不再支持rest-high-level-client,而是推荐使用新

- elasticsearch8.0+ 创建APIkey

petunsecn

devops运维elasticsearch

客户端连接ES,除了“用户名+密码”外,Elasticsearch也提供了APIkeys的访问方式。使用APIkey,也可方便的配置其不同的访问权限,用户,过期等。创建APIkey的方式:1.登录kibana,在Management--APIKey,点击【CrateAPIkey】具体参考:APIKeys|KibanaGuide[8.11]|Elastic2使用RESTAPIs创建POST/_sec

- es java match_ElasticSearch查询 第四篇:匹配查询(Match)

哈哈哈哈哈哈哈哈鸽

esjavamatch

《ElasticSearch查询》目录导航:匹配(Match)查询属于全文(Fulltext)查询,不同于词条查询,ElasticSearch引擎在处理全文搜索时,首先分析(analyze)查询字符串,然后根据分词构建查询,最终返回查询结果。匹配查询共有三种类型,分别是布尔(boolean)、短语(phrase)和短语前缀(phrase_prefix),默认的匹配查询是布尔类型,这意味着,Elas

- CaigouSearch 基于ngram分词的轻量PHP全文检索插件

php全文检索模糊搜索

简单易用最关键,菜狗搜索:https://github.com/rock365/caigou这是一个基于ngram分词的PHP模糊搜索插件,且完全免费,对博客等中小型网站来说,绰绰有余,因为它是用PHP开发的,所以能跟PHP项目完美融合。如果你对elasticsearch的语法比较了解,那么你很快就会上手,不了解也没关系,照着文档复制填写就行了,没有任何难度。注意:id字段必须为整型递增安装导入在

- Elasticsearch 实战应用

周盛欢

搜索引擎elasticsearchjenkins

一、啥是Elasticsearch嘿,小伙伴们,今天给大家唠唠Elasticsearch。简单来说,它就是一个超厉害的搜索引擎,就像我们平时用的百度、谷歌一样,但它是专门给开发者用的,能帮你在海量数据里快速找到想要的东西。二、为啥要用Elasticsearch想象一下,你有个电商网站,商品信息多得跟天上的星星似的。要是没有Elasticsearch,用户想搜个商品,得等半天才能出结果,那多糟心啊。

- SpringBoot 使用ElasticsearchRestTemplate

hbzslb

springbootjavamybatis

1.pom.xml添加org.springframework.bootspring-boot-starter-data-elasticsearch2.6.22.配置文件配置地址spring:data:elasticsearch:cluster-name:elasticsearchcluster-nodes:localhost:92003.开始使用3.0.创建实体类@Data@AllArgsCons

- ElasticSearch(3) - 慢查询优化思路

川涂

搜索elasticsearch数据库mysql

ES的慢查询可能会导致性能瓶颈,影响系统的响应时间和用户体验。要优化ES查询性能,可以从查询语句和表结构两个方面入。从查询语句优化角度,可以优化查询类型、合理使用fliter、限制字段返回等都是有效的方法。从表结构优化角度,选择合适的字段类型、合理设置索引、优化分片和副本设置等也是提高性能的关键。1.查询语句优化1.1使用合适的查询类型精确匹配(TermQuery):对于精确值匹配,使用term查

- 优化Elasticsearch搜索性能:查询调优与索引设计

一勺菠萝丶

Java#ELK#SpringBootelasticsearch大数据搜索引擎

在构建基于Elasticsearch的搜索解决方案时,性能优化是关键。本文将深入探讨如何通过查询调优和索引设计来优化Elasticsearch的搜索性能,从而提高用户体验和系统效率。查询调优优化查询是提高Elasticsearch性能的重要方法。以下是一些有效的查询调优策略,并附上具体例子以便理解:使用合适的查询类型:选择最合适的查询类型可以提高查询效率。例如,对于精确匹配,使用termquery

- es查询大文本效率_Elasticsearch 技术分析(七): Elasticsearch 的性能优化

weixin_39672296

es查询大文本效率

javajava8java开发Elasticsearch技术分析(七):Elasticsearch的性能优化硬件选择Elasticsearch(后文简称ES)的基础是Lucene,所有的索引和文档数据是存储在本地的磁盘中,具体的路径可在ES的配置文件../config/elasticsearch.yml中配置,如下:#-----------------------------------Paths

- Elasticsearch中父子文档的关联:利用Join类型赋予文档的层级关系

码到三十五

elasticsearch高手elasticsearchjava

码到三十五:个人主页心中有诗画,指尖舞代码,目光览世界,步履越千山,人间尽值得!Elasticsearch是一个强大的搜索引擎,它提供了丰富的功能来满足复杂的搜索需求。其中,父子索引类型的join功能是一个强大的工具,它允许我们在同一索引中创建具有层级关系的文档。在这篇博客中,我们将深入探讨Elasticsearch中的父子索引类型join,包括其工作原理、如何使用以及需要注意的事项。目录前言1.

- 详细描述一下Elasticsearch索引文档的过程?

java1234_小锋

javaelasticsearch大数据搜索引擎

大家好,我是锋哥。今天分享关于【详细描述一下Elasticsearch索引文档的过程?】面试题。希望对大家有帮助;详细描述一下Elasticsearch索引文档的过程?1000道互联网大厂Java工程师精选面试题-Java资源分享网Elasticsearch是一个开源的分布式搜索和分析引擎,广泛用于处理大规模数据。其核心功能之一就是索引文档,它通过特定的流程将数据存储在索引中,并使数据可被高效搜索

- 电商项目-基于ElasticSearch实现商品搜索功能(三)

kong7906928

项目功能Java框架elasticsearch电商项目商品搜索

本系列文章主要介绍基于SpringDataElasticsearch实现商品搜索的后端代码,介绍代码逻辑和代码实现。主要实现功能:根据搜索关键字查询、条件筛选、规格过滤、价格区间搜索、搜索查询分页、搜索查询排序、高亮查询。主要应用技术:canal,Eureka,微服务架构(MicroservicesArchitecture),SpringDataElasticsearch一、搜索分页1分页分析基于

- Elasticsearch搭建框架以及测试

小郭爱编程

elasticsearch学习介绍Elasticsearch简介Elasticsearch是一个建立在全文搜索引擎ApacheLucene™基础上的搜索引擎,可以说Lucene是当今最先进,最高效的全功能开源搜索引擎框架。用通俗的话理解就是:将不同服务器需要的数据,弄成一个文档,放到es中去,当我们去搜索的时候,就是去搜索文档。es是一个非关系型数据库,和redis一样,redis是一个键值对的数

- 微服务实战——ElasticSearch(搜索)

松弛进取

微服务实战java后端微服务springcloud分布式

商品检索——ElasticSearch(搜索)1.检索条件&排序条件分析全文检索:skuTitle->keyword排序:saleCount(销量)、hotScore(热度分)、skuPrice(价格)过滤:hasStock、skuPrice区间、brandId、catalog3Id、attrs聚合:attrs完整查询参数keyword=小米&sort=saleCount_desc/asc&has

- 设计一个缓存策略,动态缓存热点数据

「已注销」

智力题&场景题缓存数据库java排行榜

写在前面,因为我们最近的大作业项目需要用到热点排行这个功能,因为我们是要使用Elasticsearch来存储数据,然后最初设想是在ES中实现这个热点排行的功能,但是经过仔细思考,在我们这个项目中使用ES来做热点排行是一个很蠢的方式,因为我们这只是一个很小的排行,所以最终我们还是使用Redis来实现热点排行使用LRU?LRU是一种常见的算法,假如我们设定TOP10的热点数据,那么我们可以规定LRU容

- 学英语学Elasticsearch:04 Elastic integrations 工具箱实现对第三方数据源的采集、存储、可视化,开箱即用

学会了没

elasticsearch大数据搜索引擎ElasticAgentLogstash与第三方集成

:先看关键单词,再看英文,最后看中文总结,再回头看一遍英文原文,效果更佳!!关键词ingestion摄取/ɪnˈdʒɛstʃən/observability可观察性/ˌɑːbzərvəˈbɪlɪti/scalability可扩展性/ˌskeɪləˈbɪlɪti/deployment部署/dɪˈplɔɪmənt/functionality功能/ˌfʌŋkʃəˈnæləti/pre-packaged预

- Hadoop(一)

朱辉辉33

hadooplinux

今天在诺基亚第一天开始培训大数据,因为之前没接触过Linux,所以这次一起学了,任务量还是蛮大的。

首先下载安装了Xshell软件,然后公司给了账号密码连接上了河南郑州那边的服务器,接下来开始按照给的资料学习,全英文的,头也不讲解,说锻炼我们的学习能力,然后就开始跌跌撞撞的自学。这里写部分已经运行成功的代码吧.

在hdfs下,运行hadoop fs -mkdir /u

- maven An error occurred while filtering resources

blackproof

maven报错

转:http://stackoverflow.com/questions/18145774/eclipse-an-error-occurred-while-filtering-resources

maven报错:

maven An error occurred while filtering resources

Maven -> Update Proje

- jdk常用故障排查命令

daysinsun

jvm

linux下常见定位命令:

1、jps 输出Java进程

-q 只输出进程ID的名称,省略主类的名称;

-m 输出进程启动时传递给main函数的参数;

&nb

- java 位移运算与乘法运算

周凡杨

java位移运算乘法

对于 JAVA 编程中,适当的采用位移运算,会减少代码的运行时间,提高项目的运行效率。这个可以从一道面试题说起:

问题:

用最有效率的方法算出2 乘以8 等於几?”

答案:2 << 3

由此就引发了我的思考,为什么位移运算会比乘法运算更快呢?其实简单的想想,计算机的内存是用由 0 和 1 组成的二

- java中的枚举(enmu)

g21121

java

从jdk1.5开始,java增加了enum(枚举)这个类型,但是大家在平时运用中还是比较少用到枚举的,而且很多人和我一样对枚举一知半解,下面就跟大家一起学习下enmu枚举。先看一个最简单的枚举类型,一个返回类型的枚举:

public enum ResultType {

/**

* 成功

*/

SUCCESS,

/**

* 失败

*/

FAIL,

- MQ初级学习

510888780

activemq

1.下载ActiveMQ

去官方网站下载:http://activemq.apache.org/

2.运行ActiveMQ

解压缩apache-activemq-5.9.0-bin.zip到C盘,然后双击apache-activemq-5.9.0-\bin\activemq-admin.bat运行ActiveMQ程序。

启动ActiveMQ以后,登陆:http://localhos

- Spring_Transactional_Propagation

布衣凌宇

springtransactional

//事务传播属性

@Transactional(propagation=Propagation.REQUIRED)//如果有事务,那么加入事务,没有的话新创建一个

@Transactional(propagation=Propagation.NOT_SUPPORTED)//这个方法不开启事务

@Transactional(propagation=Propagation.REQUIREDS_N

- 我的spring学习笔记12-idref与ref的区别

aijuans

spring

idref用来将容器内其他bean的id传给<constructor-arg>/<property>元素,同时提供错误验证功能。例如:

<bean id ="theTargetBean" class="..." />

<bean id ="theClientBean" class=&quo

- Jqplot之折线图

antlove

jsjqueryWebtimeseriesjqplot

timeseriesChart.html

<script type="text/javascript" src="jslib/jquery.min.js"></script>

<script type="text/javascript" src="jslib/excanvas.min.js&

- JDBC中事务处理应用

百合不是茶

javaJDBC编程事务控制语句

解释事务的概念; 事务控制是sql语句中的核心之一;事务控制的作用就是保证数据的正常执行与异常之后可以恢复

事务常用命令:

Commit提交

- [转]ConcurrentHashMap Collections.synchronizedMap和Hashtable讨论

bijian1013

java多线程线程安全HashMap

在Java类库中出现的第一个关联的集合类是Hashtable,它是JDK1.0的一部分。 Hashtable提供了一种易于使用的、线程安全的、关联的map功能,这当然也是方便的。然而,线程安全性是凭代价换来的――Hashtable的所有方法都是同步的。此时,无竞争的同步会导致可观的性能代价。Hashtable的后继者HashMap是作为JDK1.2中的集合框架的一部分出现的,它通过提供一个不同步的

- ng-if与ng-show、ng-hide指令的区别和注意事项

bijian1013

JavaScriptAngularJS

angularJS中的ng-show、ng-hide、ng-if指令都可以用来控制dom元素的显示或隐藏。ng-show和ng-hide根据所给表达式的值来显示或隐藏HTML元素。当赋值给ng-show指令的值为false时元素会被隐藏,值为true时元素会显示。ng-hide功能类似,使用方式相反。元素的显示或

- 【持久化框架MyBatis3七】MyBatis3定义typeHandler

bit1129

TypeHandler

什么是typeHandler?

typeHandler用于将某个类型的数据映射到表的某一列上,以完成MyBatis列跟某个属性的映射

内置typeHandler

MyBatis内置了很多typeHandler,这写typeHandler通过org.apache.ibatis.type.TypeHandlerRegistry进行注册,比如对于日期型数据的typeHandler,

- 上传下载文件rz,sz命令

bitcarter

linux命令rz

刚开始使用rz上传和sz下载命令:

因为我们是通过secureCRT终端工具进行使用的所以会有上传下载这样的需求:

我遇到的问题:

sz下载A文件10M左右,没有问题

但是将这个文件A再传到另一天服务器上时就出现传不上去,甚至出现乱码,死掉现象,具体问题

解决方法:

上传命令改为;rz -ybe

下载命令改为:sz -be filename

如果还是有问题:

那就是文

- 通过ngx-lua来统计nginx上的虚拟主机性能数据

ronin47

ngx-lua 统计 解禁ip

介绍

以前我们为nginx做统计,都是通过对日志的分析来完成.比较麻烦,现在基于ngx_lua插件,开发了实时统计站点状态的脚本,解放生产力.项目主页: https://github.com/skyeydemon/ngx-lua-stats 功能

支持分不同虚拟主机统计, 同一个虚拟主机下可以分不同的location统计.

可以统计与query-times request-time

- java-68-把数组排成最小的数。一个正整数数组,将它们连接起来排成一个数,输出能排出的所有数字中最小的。例如输入数组{32, 321},则输出32132

bylijinnan

java

import java.util.Arrays;

import java.util.Comparator;

public class MinNumFromIntArray {

/**

* Q68输入一个正整数数组,将它们连接起来排成一个数,输出能排出的所有数字中最小的一个。

* 例如输入数组{32, 321},则输出这两个能排成的最小数字32132。请给出解决问题

- Oracle基本操作

ccii

Oracle SQL总结Oracle SQL语法Oracle基本操作Oracle SQL

一、表操作

1. 常用数据类型

NUMBER(p,s):可变长度的数字。p表示整数加小数的最大位数,s为最大小数位数。支持最大精度为38位

NVARCHAR2(size):变长字符串,最大长度为4000字节(以字符数为单位)

VARCHAR2(size):变长字符串,最大长度为4000字节(以字节数为单位)

CHAR(size):定长字符串,最大长度为2000字节,最小为1字节,默认

- [强人工智能]实现强人工智能的路线图

comsci

人工智能

1:创建一个用于记录拓扑网络连接的矩阵数据表

2:自动构造或者人工复制一个包含10万个连接(1000*1000)的流程图

3:将这个流程图导入到矩阵数据表中

4:在矩阵的每个有意义的节点中嵌入一段简单的

- 给Tomcat,Apache配置gzip压缩(HTTP压缩)功能

cwqcwqmax9

apache

背景:

HTTP 压缩可以大大提高浏览网站的速度,它的原理是,在客户端请求网页后,从服务器端将网页文件压缩,再下载到客户端,由客户端的浏览器负责解压缩并浏览。相对于普通的浏览过程HTML ,CSS,Javascript , Text ,它可以节省40%左右的流量。更为重要的是,它可以对动态生成的,包括CGI、PHP , JSP , ASP , Servlet,SHTML等输出的网页也能进行压缩,

- SpringMVC and Struts2

dashuaifu

struts2springMVC

SpringMVC VS Struts2

1:

spring3开发效率高于struts

2:

spring3 mvc可以认为已经100%零配置

3:

struts2是类级别的拦截, 一个类对应一个request上下文,

springmvc是方法级别的拦截,一个方法对应一个request上下文,而方法同时又跟一个url对应

所以说从架构本身上 spring3 mvc就容易实现r

- windows常用命令行命令

dcj3sjt126com

windowscmdcommand

在windows系统中,点击开始-运行,可以直接输入命令行,快速打开一些原本需要多次点击图标才能打开的界面,如常用的输入cmd打开dos命令行,输入taskmgr打开任务管理器。此处列出了网上搜集到的一些常用命令。winver 检查windows版本 wmimgmt.msc 打开windows管理体系结构(wmi) wupdmgr windows更新程序 wscrip

- 再看知名应用背后的第三方开源项目

dcj3sjt126com

ios

知名应用程序的设计和技术一直都是开发者需要学习的,同样这些应用所使用的开源框架也是不可忽视的一部分。此前《

iOS第三方开源库的吐槽和备忘》中作者ibireme列举了国内多款知名应用所使用的开源框架,并对其中一些框架进行了分析,同样国外开发者

@iOSCowboy也在博客中给我们列出了国外多款知名应用使用的开源框架。另外txx's blog中详细介绍了

Facebook Paper使用的第三

- Objective-c单例模式的正确写法

jsntghf

单例iosiPhone

一般情况下,可能我们写的单例模式是这样的:

#import <Foundation/Foundation.h>

@interface Downloader : NSObject

+ (instancetype)sharedDownloader;

@end

#import "Downloader.h"

@implementation

- jquery easyui datagrid 加载成功,选中某一行

hae

jqueryeasyuidatagrid数据加载

1.首先你需要设置datagrid的onLoadSuccess

$(

'#dg'

).datagrid({onLoadSuccess :

function

(data){

$(

'#dg'

).datagrid(

'selectRow'

,3);

}});

2.onL

- jQuery用户数字打分评价效果

ini

JavaScripthtmljqueryWebcss

效果体验:http://hovertree.com/texiao/jquery/5.htmHTML文件代码:

<!DOCTYPE html>

<html xmlns="http://www.w3.org/1999/xhtml">

<head>

<title>jQuery用户数字打分评分代码 - HoverTree</

- mybatis的paramType

kerryg

DAOsql

MyBatis传多个参数:

1、采用#{0},#{1}获得参数:

Dao层函数方法:

public User selectUser(String name,String area);

对应的Mapper.xml

<select id="selectUser" result

- centos 7安装mysql5.5

MrLee23

centos

首先centos7 已经不支持mysql,因为收费了你懂得,所以内部集成了mariadb,而安装mysql的话会和mariadb的文件冲突,所以需要先卸载掉mariadb,以下为卸载mariadb,安装mysql的步骤。

#列出所有被安装的rpm package rpm -qa | grep mariadb

#卸载

rpm -e mariadb-libs-5.

- 利用thrift来实现消息群发

qifeifei

thrift

Thrift项目一般用来做内部项目接偶用的,还有能跨不同语言的功能,非常方便,一般前端系统和后台server线上都是3个节点,然后前端通过获取client来访问后台server,那么如果是多太server,就是有一个负载均衡的方法,然后最后访问其中一个节点。那么换个思路,能不能发送给所有节点的server呢,如果能就

- 实现一个sizeof获取Java对象大小

teasp

javaHotSpot内存对象大小sizeof

由于Java的设计者不想让程序员管理和了解内存的使用,我们想要知道一个对象在内存中的大小变得比较困难了。本文提供了可以获取对象的大小的方法,但是由于各个虚拟机在内存使用上可能存在不同,因此该方法不能在各虚拟机上都适用,而是仅在hotspot 32位虚拟机上,或者其它内存管理方式与hotspot 32位虚拟机相同的虚拟机上 适用。

- SVN错误及处理

xiangqian0505

SVN提交文件时服务器强行关闭

在SVN服务控制台打开资源库“SVN无法读取current” ---摘自网络 写道 SVN无法读取current修复方法 Can't read file : End of file found

文件:repository/db/txn_current、repository/db/current

其中current记录当前最新版本号,txn_current记录版本库中版本