统计学习方法笔记-逻辑斯谛回归与最大熵模型

逻辑斯谛回归是统计学习中的经典分类方法。最大熵是概率模型学习的一个准则,将其推广到分类问题得到最大熵模型。逻辑斯谛回归模型与最大熵模型都属于对数线性模型。

逻辑斯谛回归模型

逻辑斯谛分布:

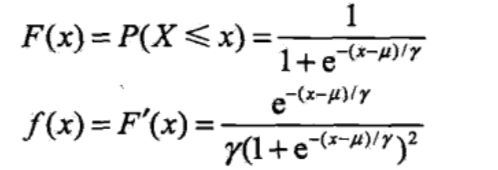

设X是连续随机变量,X服从逻辑斯谛分布是指X具有下列的分布函数和密度函数:

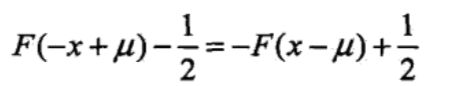

逻辑斯谛分布的密度函数f(x)和分布函数F(x)的图形分别如下图所示,分布函数属于逻辑斯谛函数,图形是一条S行曲线。该曲线以点(

μ,1/2)为中心对称,满足:

曲线在中心点附近增长速度较快,在两端增长速度较慢,形状参数

γ的值越小,曲线在中心附近增长得越快。

二项逻辑斯谛回归模型:

二项逻辑斯谛回归模型是一种分类模型,由条件概率分布P(Y | X)表示,形式为参数化的逻辑斯谛分布,这里Y的取值为0或1.我们通过监督学习的方法来估计模型参数。

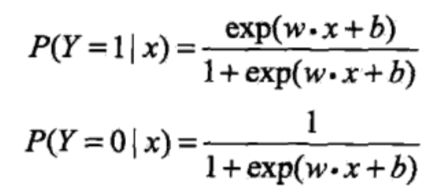

定义:二项逻辑斯谛回归模型是如下的条件概率分布:

w称为权值向量,b称为偏置。对于给定的输入实例x,对比P(Y = 1 | x) 和P(Y = 0 | x)的值,将实例x分到概率值较大的那一类。

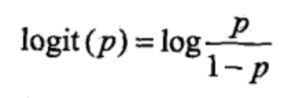

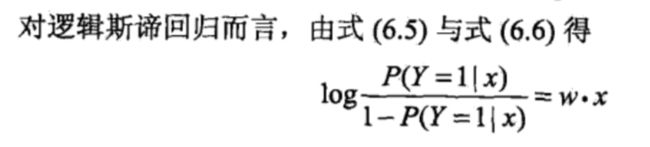

一个事件的几率是指该事件发生的概率与该事件不发生的概率的比值。如果事件的概率是p,那么该事件的几率是p/(1 - p),该事件的对数几率或logit函数是

也就是说,在逻辑斯蒂回归模型中,输出Y = 1的对数几率是输入x的线性函数。

模型参数估计:

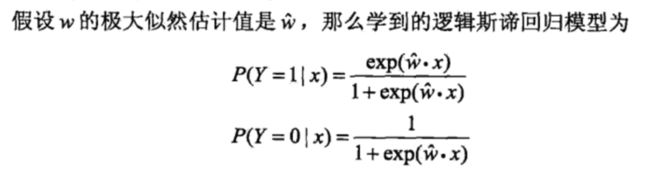

可以应用极大似然估计法估计模型参数,从而得到逻辑斯谛回归模型。

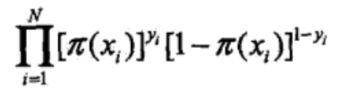

似然函数为:

(上式中对单个式子而言,即取yi值的概率而去掉另一个值的概率,然后希望这个值大于0.5并且尽可能大,扩展到整个式子也就是对上式似然函数取极大值)

对数的似然函数为:

对L(w)求极大值,得到w的估计值。

多项逻辑斯谛回归:

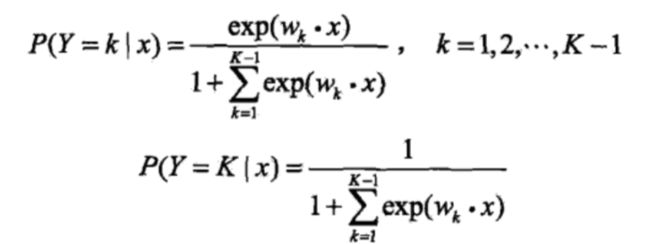

上面介绍的逻辑斯谛回归模型是二项分类模型,用于二类分类。可以将其推广为多项逻辑斯谛回归模型,用于多类分类。假设离散随机变量Y的取值是{1,2,3,···,K},那么多项逻辑斯谛回归模型是:

(之所以Y = K时和Y=k的时的概率不一样,表面上可以理解为总概率得为1)

也可以用在二项逻辑斯谛回归的参数估计法来求多项逻辑斯谛回归(单个式子只保留正确yi的概率,然后求整个式子的极大值)。

最大熵模型

最大熵模型是由最大熵原理推导实现的。最大熵原理是概率模型学习的一个准则。

最大熵原理:

最大熵原理是概率模型学习的一个准则。最大熵原理认为,学习概率模型时,在所有可能的概率模型(分布)中,熵最大的模型是最好的模型。通常用约束条件来确定概率模型的集合,所以,最大熵原理也可以表述为在满足约束条件的模型集合中选取熵最大的模型。

式中,当且仅当X是均分布时,右边的等号成立,也就是说当X服从均分布时,熵最大。

直观地,最大熵原理要选择的概率模型首先必须满足已有的事实,即约束条件。在没有更多信息的情况下,那些不确定的部分都是“等可能的”才最好,既然是不确定的部分,那么谁都不偏向尽量等可能,这样才是最公平的。尽量“等可能”不容易操作,而熵则是一个可优化的数值指标(熵越大所求的部分越等可能)。

(在下认为,这儿之所以和决策树不一样(剪枝的时候,取熵最小),那是因为最大熵原理是:在没有更多信息的情况下,对不确定的部分尽量“等可能”;而决策树剪枝的时候之所以根据叶结点求最小熵,是因为这是已经确定的要求(约束),就是要让叶结点尽量是同一个类,让熵最小,所以决策树看似和最大熵原理冲突,其实不冲突,因为它是用在约束部分,而不是非约束部分)

最大熵模型的定义:

最大熵原理是统计学习的一般原理,将它应用到分类得到最大熵模型。

定义:假设满足所有约束条件的集合为

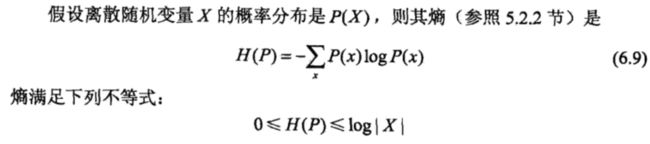

定义在条件概率分布P(Y | X)上的条件熵为

则条件集合C中条件熵H(P)最大的模型称为最大熵模型,式中对数为自然对数。

上面式子可以用之前学过的条件熵公式推导出来,具体推导如下:

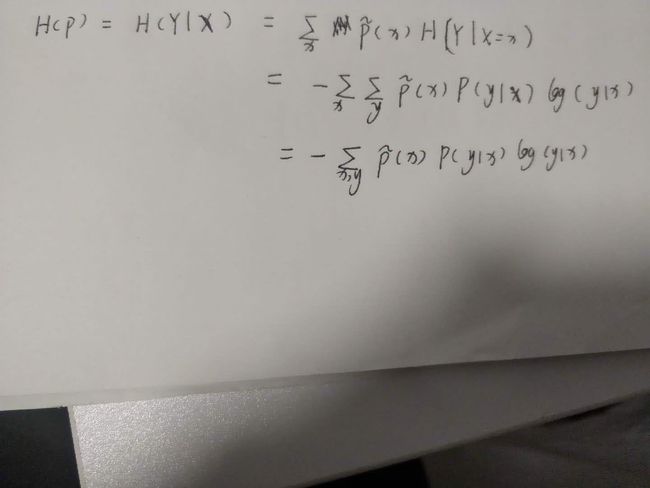

最大熵模型的学习

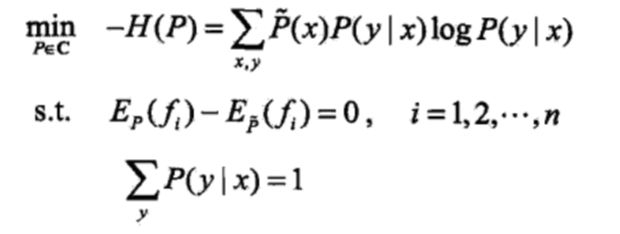

最大熵模型的学习等价于约束最优化问题:

按照最优化问题的习惯,将求最大值问题改写为等价的求最小值问题:

求解上式约束最优化问题如下:

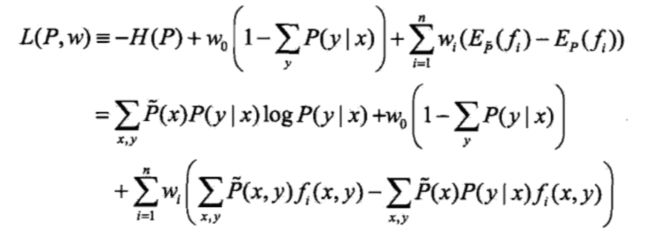

将约束最优化问题转换为无约束最优化的对偶问题,为此引入拉格朗日乘子

w

0 ,

w

1

,

w

2 ,···,

w

n ,定义拉格朗日函数L(P,w):

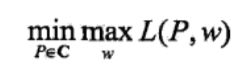

最优化的原始问题是

之所以在这儿相对w求极大值,从后面可知这儿求极大值相当于对似然函数求极大值,

两者都是最大熵模型学习的依据

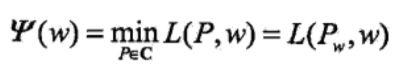

对偶问题是

由于拉格朗日函数L(P,w)是P的凸函数,原始问题的解和对偶问题的解是等价的。

求L(P,w)对P(y|x)的偏导数如下:

(待写过程)

之所以上式求出的结论可以作为最大熵模型,是因为此式子是通用式子,故求出来的模型可以作为通用的最大熵模型

极大似然估计:

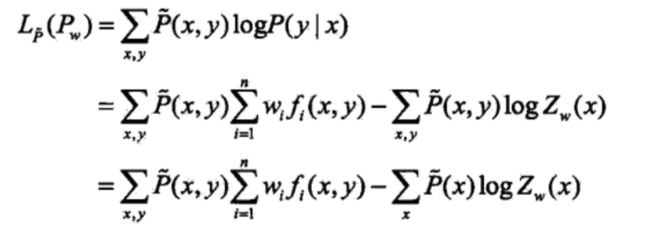

条件概率分布P(Y|X)的对数似然函数表示为

(之所以要这么一个指数,主要是因为如果某一个P(y|x)为0那极大似然函数值为0,求出来的结果肯定有问题,故加这么个指数如果x和y完全没联系就让其为为1,对数据不造成任何影响~)

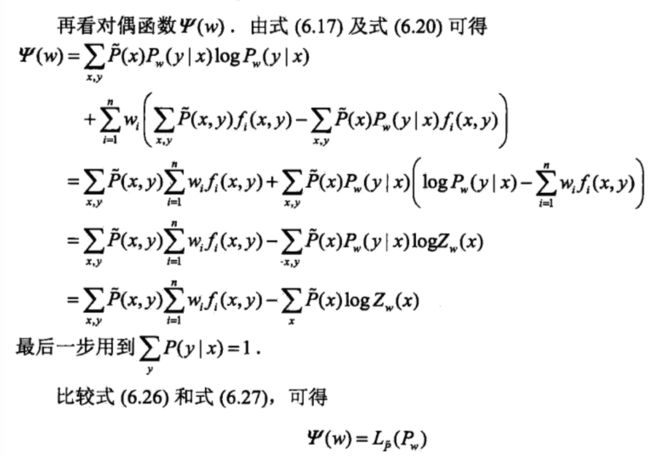

当条件概率分布P(y|x)是最大熵模型时,对数似然函数为

证明了最大熵模型学习中的对偶函数极大化等价于最大熵模型的极大似然估计。

模型学习的最优化算法

改进的迭代尺度法:

已知最大熵模型为:

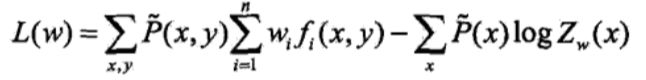

带入对数似然函数得到

最优化算法的目标是通过极大似然估计学习模型参数,即求对数似然函数的极大值w。