- scrapy学习笔记0827

github_czy

scrapy学习笔记

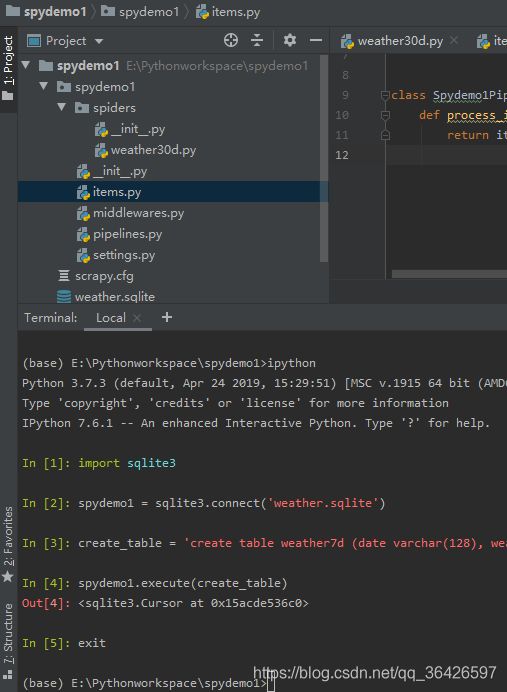

1.总之先启动先安装scrapy,pipinstallscrapy创建scrapy项目,生成的项目结构应该如图所示,scrapystartprojectexample选择需要爬取的页面并分析,这里选定的页面是Allproducts|BookstoScrape-Sandbox一个供给爬虫学者练手的网站,我们需要爬取上面的书籍信息,解析我们需要的内容在那一段html标签里可以使用浏览器自带的开发者工具

- scrapy学习笔记0828-下

github_czy

scrapy学习笔记

1.爬取动态页面我们遇见的大多数网站不大可能会是单纯的静态网站,实际中更常见的是JavaScript通过HTTP请求跟网站动态交互获取数据(AJAX),然后使用数据更新HTML页面。爬取此类动态网页需要先执行页面中的JavaScript代码渲染页面,再进行爬取。在这里我们采用scrapy官方推荐的Splash渲染引擎,我们需要通过docker来安装splash并使其运行起来,这里就暂时不展开,安装

- 爬虫框架Scrapy学习笔记-3

friklogff

爬虫python爬虫scrapy学习

Scrapy管道详解:数据存储和图片下载引言在网络爬虫开发中,数据的存储和处理是至关重要的环节。Scrapy作为Python中一款强大的网络爬虫框架,提供了丰富的数据存储和处理功能,其中最重要的概念之一就是管道(Pipeline)。本文将深入探讨Scrapy管道的使用,包括如何将爬取的数据保存到不同的数据存储中,以及如何下载和处理图片数据。摘要本文将围绕以下主题展开讨论:CSV文件写入:介绍如何将

- Scrapy学习笔记(一)——使用Pycharm搭建编写Scrapy项目的环境

DivingKitten

EnvPython

写在前面:Python版本:3.6.1Pycharm版本:2018.1.4第一步:命令行构建Scrapy项目Pycharm中没有直接构建Scrapy项目的模板和指令,所以需要自行在命令行中通过指令进行项目的创建。格式:scrapy[指令][项目名]eg:scrapystartproject[project]第二步:使用Pycharm打开项目并配置编译环境项目创建完成后,便可以通过Pycharm打开

- Scrapy+Selenium自动化获取个人CSDN文章质量分

friklogff

python爬虫scrapyselenium自动化python学习

前言本文将介绍如何使用Scrapy和Selenium这两个强大的Python工具来自动获取个人CSDN文章的质量分数。我们将详细讨论Scrapy爬虫框架的使用,以及如何结合Selenium浏览器自动化工具来实现这一目标。无需手动浏览每篇文章,我们可以轻松地获取并记录文章的质量分数,从而更好地了解我们的博客表现。CSDN文章质量分查询链接Scrapy相关基础知识:爬虫框架Scrapy学习笔记-1爬虫

- 爬虫框架Scrapy学习笔记-2

friklogff

爬虫python爬虫scrapy学习

前言Scrapy是一个功能强大的Python爬虫框架,它被广泛用于抓取和处理互联网上的数据。本文将介绍Scrapy框架的架构概览、工作流程、安装步骤以及一个示例爬虫的详细说明,旨在帮助初学者了解如何使用Scrapy来构建和运行自己的网络爬虫。Scrapy架构概览Scrapy由以下主要组件构成:引擎(Engine):负责控制数据流在各个组件之间的流动,触发事务。调度器(Scheduler):接收引擎

- Scrapy学习笔记-Anaconda下安装

肥叔菌

安装Scrapy参考自Scrapy的官方手册:https://docs.scrapy.org/en/latest/intro/install.htmlScrapy在CPython(默认Python实现)和PyPy(从PyPy5.9开始)下的Python3.5或更高版本上运行。Anaconda下安装如果您使用的是Anaconda或Miniconda,则可以从conda-forge渠道安装该软件包,该

- Scrapy学习笔记(8)-使用signals来监控spider的状态

leeyis

场景介绍有时候我们需要在spider启动或者结束的时候执行一些特定的操作,比如说记录日志之类的,在scrapy中我们可以使用signals来实现。主要实现代码如下:#-*-coding:utf-8-*-fromscrapyimportsignalsfromscrapy.xlib.pydispatchimportdispatcherfromscrapy.linkextractorsimportLin

- 【Python_Scrapy学习笔记(一)】Scrapy框架简介

禾戊之昂

Python学习笔记#Scrapy学习笔记pythonscrapy爬虫网络爬虫

Scrapy框架简介前言Scrapy框架是一个用python实现的为了爬取网站数据、提取数据的应用框架,使用Twisted异步网络库来处理网络通讯,可以高效的完成数据爬取。本文主要介绍Scrapy框架的构成与工作原理。正文1、Scrapy安装Windows安装:-m-pipinstallScrapy或使用PyCharm可视化界面安装。2、Scrapy框架构成爬虫文件Spider:负责数据的解析提取

- 【Python_Scrapy学习笔记(十二)】基于Scrapy框架实现POST请求爬虫

禾戊之昂

Python学习笔记#Scrapy学习笔记python爬虫scrapy网络爬虫

基于Scrapy框架实现POST请求爬虫前言本文中介绍如何基于Scrapy框架实现POST请求爬虫,并以抓取指定城市的KFC门店信息为例进行展示正文1、Scrapy框架处理POST请求方法Scrapy框架提供了FormRequest()方法来发送POST请求;FormRequest()方法相比于Request()方法多了formdata参数,接受包含表单数据的字典或者可迭代的元组,并将其转化为请求

- 【Python_Scrapy学习笔记(十三)】基于Scrapy框架的图片管道实现图片抓取

禾戊之昂

Python学习笔记#Scrapy学习笔记pythonscrapy网络爬虫爬虫

基于Scrapy框架的图片管道实现图片抓取前言本文中介绍如何基于Scrapy框架的图片管道实现图片抓取,并以抓取360图片为例进行展示。正文1、Scrapy框架抓取图片原理利用Scrapy框架提供的图片管道类ImagesPipeline抓取页面图片,在使用时需要导入,并且重新get_media_requests()方法,如果对保存的文件名有要求,则需要重写file_path()方法,在settin

- 【Python_Scrapy学习笔记(十四)】基于Scrapy框架的文件管道实现文件抓取(基于Scrapy框架实现多级页面的抓取)

禾戊之昂

Python学习笔记#Scrapy学习笔记pythonscrapy网络爬虫爬虫

基于Scrapy框架的文件管道实现文件抓取(基于Scrapy框架实现多级页面的抓取)前言本文中介绍如何基于Scrapy框架的文件管道实现文件抓取(基于Scrapy框架实现多级页面的抓取),并以抓取第一PPT网站的PPT模板为例进行展示,同时抓取此网站数据的方式也是对如何使用Scrapy框架实现多级页面的抓取进行详解。正文1、Scrapy框架抓取文件原理Scrapy框架提供了文件管道类FilesPi

- 【Python_Scrapy学习笔记(十一)】基于Scrapy框架的下载器中间件添加Cookie参数

禾戊之昂

Python学习笔记#Scrapy学习笔记pythonscrapy中间件网络爬虫爬虫

基于Scrapy框架的下载器中间件添加Cookie参数前言本文中介绍如何基于Scrapy框架的下载器中间件添加Cookie参数。正文1、添加中间件的流程在middlewares.py中新建Cookie参数中间件类在settings.py中添加此下载器中间件,设置优先级并开启2、基于Scrapy框架的下载器中间件添加Cookie参数的流程在middlewares.py中新建Cookie参数中间件类#

- 【Python_Scrapy学习笔记(六)】Scrapy框架基本使用流程

禾戊之昂

#Scrapy学习笔记Python学习笔记pythonscrapy爬虫网络爬虫

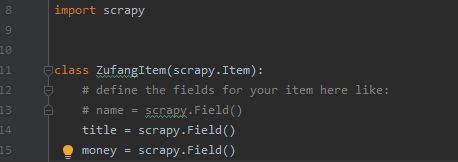

Scrapy框架基本使用流程前言本文中介绍Scrapy框架的基本使用流程,并以抓取汽车之家二手车数据为例进行讲解。正文1、Scrapy框架基本使用流程创建爬虫项目:scrapystartprojecct项目名cd到项目文件夹:cd项目名创建爬虫文件:scrapygenspider爬虫文件名浏览器地址栏中的域名定义抓取的数据结构:编写items.py文件importscrapyclass项目名ite

- 【Python_Scrapy学习笔记(七)】基于Scrapy框架实现数据持久化

禾戊之昂

Python学习笔记#Scrapy学习笔记pythonscrapy网络爬虫爬虫

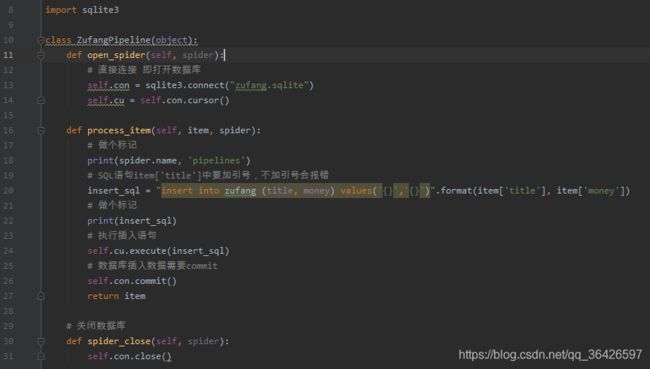

基于Scrapy框架实现数据持久化前言本文中介绍如何基于Scrapy框架实现数据持久化,包括Scrapy数据持久化到MySQL数据库、MangoDB数据库和本地csv文件、json文件。正文1、Scrapy数据持久化到MySQL数据库在settings.py中定义MySQL相关变量#定义MySQL数据库的相关变量MYSQL_HOST='xxxxxxxxx'MYSQL_USER='xxxx'MYSQ

- 【Python_Scrapy学习笔记(八)】基于Scrapy框架实现多级页面数据抓取

禾戊之昂

Python学习笔记#Scrapy学习笔记pythonscrapy网络爬虫爬虫

基于Scrapy框架实现多级页面数据抓取前言本文中介绍如何基于Scrapy框架实现多级页面数据的抓取,并以抓取汽车之家二手车数据为例进行讲解。正文在介绍如何基于Scrapy框架实现多级页面数据的抓取之前,先介绍下Scrapy框架的请求对象request和响应对象response。1、请求对象request属性及方法request.url:请求的url地址request.headers:请求头-字典

- 【Python_Scrapy学习笔记(二)】创建Scrapy爬虫项目

禾戊之昂

Python学习笔记#Scrapy学习笔记pythonscrapy网络爬虫爬虫

创建Scrapy爬虫项目前言本文主要介绍如何创建并运行Scrapy爬虫项目。正文1、创建Scrapy框架Scrapy框架提供了scrapy命令用来建立Scrapy工程,在终端terminal中输入以下命令:scrapystartproject自定义的项目名称创建好爬虫项目文件夹后先cd进入创建的爬虫项目,然后执行下列语句,即可生成一个爬虫文件:cd自定义的项目名称scrapygenspider创建

- 【Python_Scrapy学习笔记(三)】Scrapy框架之全局配置文件settings.py详解

禾戊之昂

Python学习笔记#Scrapy学习笔记pythonscrapy网络爬虫爬虫

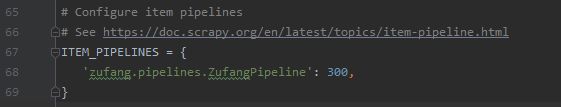

Scrapy框架之全局配置文件settings.py详解前言settings.py文件是Scrapy框架下,用来进行全局配置的设置文件,可以进行User-Agent、请求头、最大并发数等的设置,本文中介绍settings.py文件下的一些常用配置正文1、爬虫的项目目录名、爬虫文件名BOT_NAME:Scrapy项目实现的bot的名字。用来构造默认User-Agent,同时也用来log。当使用sta

- 【Python_Scrapy学习笔记(四)】Scrapy框架之数据封装文件items.py详解

禾戊之昂

Python学习笔记#Scrapy学习笔记pythonscrapy网络爬虫爬虫

Scrapy框架之数据封装文件items.py详解前言items.py文件是Scrapy框架下,用来进行数据封装的文件,可以自定义爬取的字段,本文中介绍items.py文件的基本使用方法。正文1、items介绍Scrapy提供Item类来定义公共输出数据格式,Item对象是用于收集所抓取的数据的简单容器。当使用startproject命令创建项目时,items.py文件自动被创建。2、items定

- 【Python_Scrapy学习笔记(五)】Scrapy框架之管道文件pipelines.py详解

禾戊之昂

Python学习笔记#Scrapy学习笔记pythonscrapy网络爬虫爬虫

Scrapy框架之管道文件pipelines.py详解前言pipelines.py文件是Scrapy框架下,用于接收网络爬虫传过来的数据,以便做进一步处理的文件。例如验证实体的有效性、清除不需要的信息、存入数据库(持久化实体)、存入文本文件等。本文中介绍pipelines.py文件的基本使用方法。正文1、pipelines介绍管道文件pipelines.py主要用来对抓取的数据进行处理:一般一个类

- Scrapy学习笔记(9)-使用scrapy-deltafetch实现增量爬取

leeyis

前言在之前的文章中我们都是对目标站点进行全量爬取,只要爬虫run起来就会对所有的链接都爬取一遍,这其实是很傻的做法,因为很多情况下我们并不需要爬取已经爬过的链接,除非你需要定期更新这个链接对应页面上的数据。好了,回归正题,本文介绍scrapy使用scrapy-deltafetch这个插件来实现增量爬取,这里以爬取【美食杰】上的菜谱信息为例。正文安装scrapy-deltafetch$pipinst

- Python Scrapy 学习笔记

python

title:PythonScrapy学习笔记summary:在慕课网学习Scrapy时所作的笔记author:小Kdatetime:2021-08-1716:442021-08-2812:09tags:PythonScrapy笔记webcrawlingseleniumCSSselectorXPath[TOC]PythonScrapy学习笔记Scrapy爬虫编码一般过程创建项目。这个项目可用包含爬取

- Python爬虫框架Scrapy学习笔记

梦幻python

pygamepython爬虫爬虫python数据挖掘

scrapy.png本文主要内容针对Scrapy有初步了解的同学。结合作者的实际项目中遇到的一些问题,汇成本文。之后会写一些具体的爬虫demo,放到https://github.com/hanguangchao/scrapy_awesome鉴于作者接触爬虫不久,水平有限,文章难免出现纰漏,还请各位达人留言指导。内容提要Scrapy问题记录Scrapy问题示例代码Scrapy常用代码片段Scrapy

- Scrapy学习笔记(1)

啊啊啊海@

python

Scrapy学习笔记(1)介绍什么是Scrapy框架?Scrapy是用纯Python实现一个为了爬取网站数据、提取结构性数据而编写的应用框架,用途非常广泛。多用于抓取大量静态页面。框架的力量:用户只需要定制开发几个模块就可以轻松的实现一个爬虫,用来抓取网页内容以及各种图片,非常之方便。Scrapy使用了Twisted['twɪstɪd](其主要对手是Tornado)异步网络框架来处理网络通讯,可以

- Python爬虫框架Scrapy学习笔记原创

wxystyle

python

scrapy[TOC]开始scrapy安装首先手动安装windows版本的Twistedhttps://www.lfd.uci.edu/~gohlke/pythonlibs/#twistedpipinstallTwisted-18.4.0-cp36-cp36m-win_amd64.whl安装scrapypipinstall-ihttps://pypi.douban.com/simple/scrap

- Scrapy学习笔记(3)爬取知乎首页问题及答案

浅零半泣

Scrapy爬虫

目标:爬取知乎首页前x个问题的详情及问题指定范围内的答案的摘要powerby:Python3.6Scrapy1.4jsonpymysql项目地址:https://github.com/Dengqlbq/ZhiHuSpider.gitStep1——相关简介本文将注意力放在代码实现上,代码思路的描述将另开一文代码思路:http://blog.csdn.net/sinat_34200786/articl

- scrapy学习笔记(〇)

ATangYaaaa

人若无名,便可潜心练剑。本篇补冲基础知识:scrapy架构安装和shell用法。安装顺序:1.Python3.62.python-mpipinstallpywin323.python-mpipinstalllxml4.python-mpipinstallsetuptools5.python-mpipinstallzope.interface6.下载对应已编译版本:https://www.lfd.u

- Python爬虫框架Scrapy学习笔记

codefine

scrapy.png本文主要内容针对Scrapy有初步了解的同学。结合作者的实际项目中遇到的一些问题,汇成本文。之后会写一些具体的爬虫demo,放到https://github.com/hanguangchao/scrapy_awesome鉴于作者接触爬虫不久,水平有限,文章难免出现纰漏,还请各位达人留言指导。内容提要Scrapy问题记录Scrapy问题示例代码Scrapy常用代码片段Scrapy

- 西山小菜鸟之Scrapy学习笔记---splash简介

依然关注

Scrapy爬虫

前言 本文主要介绍scrapy-splash的理论知识。文中如有不正确的地方望大家指正。本文的主要内容出自书:《精通Scrapy网络爬虫》《虫术——Python绝技》背景 近几年随着前端技术和手机端App的飞速发展,互联网架构也发生了巨大的变化,尤其是一些前端框架的大面积应用,过去基于纯后端的Web结构已经明显过时了。越来越多的网站采用前后端分离的架构。 所谓前后端分离,就是指一

- 西山小菜鸟之Scrapy学习笔记---在Scrapy中使用代理

依然关注

Scrapy爬虫

前言本文中如有错误,请各位指正。背景 在爬取各大网页信息时,通过会遇到各种各样的反爬措施:很多网站会检测某一段时间某个IP的访问次数,如果访问频率太快以至于看起来不像正常的访客,那么它就可能就会禁止此IP的访问(有兴趣的小伙伴可以试试天眼查这个网站)。所以我们需要设置一些代理服务器,每隔一段时间换一个代理,就算IP被禁止,依然可以换个IP继续爬取,同时也不会暴露自己。 虽然网上有各在代

- 强大的销售团队背后 竟然是大数据分析的身影

蓝儿唯美

数据分析

Mark Roberge是HubSpot的首席财务官,在招聘销售职位时使用了大量数据分析。但是科技并没有挤走直觉。

大家都知道数理学家实际上已经渗透到了各行各业。这些热衷数据的人们通过处理数据理解商业流程的各个方面,以重组弱点,增强优势。

Mark Roberge是美国HubSpot公司的首席财务官,HubSpot公司在构架集客营销现象方面出过一份力——因此他也是一位数理学家。他使用数据分析

- Haproxy+Keepalived高可用双机单活

bylijinnan

负载均衡keepalivedhaproxy高可用

我们的应用MyApp不支持集群,但要求双机单活(两台机器:master和slave):

1.正常情况下,只有master启动MyApp并提供服务

2.当master发生故障时,slave自动启动本机的MyApp,同时虚拟IP漂移至slave,保持对外提供服务的IP和端口不变

F5据说也能满足上面的需求,但F5的通常用法都是双机双活,单活的话还没研究过

服务器资源

10.7

- eclipse编辑器中文乱码问题解决

0624chenhong

eclipse乱码

使用Eclipse编辑文件经常出现中文乱码或者文件中有中文不能保存的问题,Eclipse提供了灵活的设置文件编码格式的选项,我们可以通过设置编码 格式解决乱码问题。在Eclipse可以从几个层面设置编码格式:Workspace、Project、Content Type、File

本文以Eclipse 3.3(英文)为例加以说明:

1. 设置Workspace的编码格式:

Windows-&g

- 基础篇--resources资源

不懂事的小屁孩

android

最近一直在做java开发,偶尔敲点android代码,突然发现有些基础给忘记了,今天用半天时间温顾一下resources的资源。

String.xml 字符串资源 涉及国际化问题

http://www.2cto.com/kf/201302/190394.html

string-array

- 接上篇补上window平台自动上传证书文件的批处理问卷

酷的飞上天空

window

@echo off

: host=服务器证书域名或ip,需要和部署时服务器的域名或ip一致 ou=公司名称, o=公司名称

set host=localhost

set ou=localhost

set o=localhost

set password=123456

set validity=3650

set salias=s

- 企业物联网大潮涌动:如何做好准备?

蓝儿唯美

企业

物联网的可能性也许是无限的。要找出架构师可以做好准备的领域然后利用日益连接的世界。

尽管物联网(IoT)还很新,企业架构师现在也应该为一个连接更加紧密的未来做好计划,而不是跟上闸门被打开后的集成挑战。“问题不在于物联网正在进入哪些领域,而是哪些地方物联网没有在企业推进,” Gartner研究总监Mike Walker说。

Gartner预测到2020年物联网设备安装量将达260亿,这些设备在全

- spring学习——数据库(mybatis持久化框架配置)

a-john

mybatis

Spring提供了一组数据访问框架,集成了多种数据访问技术。无论是JDBC,iBATIS(mybatis)还是Hibernate,Spring都能够帮助消除持久化代码中单调枯燥的数据访问逻辑。可以依赖Spring来处理底层的数据访问。

mybatis是一种Spring持久化框架,要使用mybatis,就要做好相应的配置:

1,配置数据源。有很多数据源可以选择,如:DBCP,JDBC,aliba

- Java静态代理、动态代理实例

aijuans

Java静态代理

采用Java代理模式,代理类通过调用委托类对象的方法,来提供特定的服务。委托类需要实现一个业务接口,代理类返回委托类的实例接口对象。

按照代理类的创建时期,可以分为:静态代理和动态代理。

所谓静态代理: 指程序员创建好代理类,编译时直接生成代理类的字节码文件。

所谓动态代理: 在程序运行时,通过反射机制动态生成代理类。

一、静态代理类实例:

1、Serivce.ja

- Struts1与Struts2的12点区别

asia007

Struts1与Struts2

1) 在Action实现类方面的对比:Struts 1要求Action类继承一个抽象基类;Struts 1的一个具体问题是使用抽象类编程而不是接口。Struts 2 Action类可以实现一个Action接口,也可以实现其他接口,使可选和定制的服务成为可能。Struts 2提供一个ActionSupport基类去实现常用的接口。即使Action接口不是必须实现的,只有一个包含execute方法的P

- 初学者要多看看帮助文档 不要用js来写Jquery的代码

百合不是茶

jqueryjs

解析json数据的时候需要将解析的数据写到文本框中, 出现了用js来写Jquery代码的问题;

1, JQuery的赋值 有问题

代码如下: data.username 表示的是: 网易

$("#use

- 经理怎么和员工搞好关系和信任

bijian1013

团队项目管理管理

产品经理应该有坚实的专业基础,这里的基础包括产品方向和产品策略的把握,包括设计,也包括对技术的理解和见识,对运营和市场的敏感,以及良好的沟通和协作能力。换言之,既然是产品经理,整个产品的方方面面都应该能摸得出门道。这也不懂那也不懂,如何让人信服?如何让自己懂?就是不断学习,不仅仅从书本中,更从平时和各种角色的沟通

- 如何为rich:tree不同类型节点设置右键菜单

sunjing

contextMenutreeRichfaces

组合使用target和targetSelector就可以啦,如下: <rich:tree id="ruleTree" value="#{treeAction.ruleTree}" var="node" nodeType="#{node.type}"

selectionChangeListener=&qu

- 【Redis二】Redis2.8.17搭建主从复制环境

bit1129

redis

开始使用Redis2.8.17

Redis第一篇在Redis2.4.5上搭建主从复制环境,对它的主从复制的工作机制,真正的惊呆了。不知道Redis2.8.17的主从复制机制是怎样的,Redis到了2.4.5这个版本,主从复制还做成那样,Impossible is nothing! 本篇把主从复制环境再搭一遍看看效果,这次在Unbuntu上用官方支持的版本。 Ubuntu上安装Red

- JSONObject转换JSON--将Date转换为指定格式

白糖_

JSONObject

项目中,经常会用JSONObject插件将JavaBean或List<JavaBean>转换为JSON格式的字符串,而JavaBean的属性有时候会有java.util.Date这个类型的时间对象,这时JSONObject默认会将Date属性转换成这样的格式:

{"nanos":0,"time":-27076233600000,

- JavaScript语言精粹读书笔记

braveCS

JavaScript

【经典用法】:

//①定义新方法

Function .prototype.method=function(name, func){

this.prototype[name]=func;

return this;

}

//②给Object增加一个create方法,这个方法创建一个使用原对

- 编程之美-找符合条件的整数 用字符串来表示大整数避免溢出

bylijinnan

编程之美

import java.util.LinkedList;

public class FindInteger {

/**

* 编程之美 找符合条件的整数 用字符串来表示大整数避免溢出

* 题目:任意给定一个正整数N,求一个最小的正整数M(M>1),使得N*M的十进制表示形式里只含有1和0

*

* 假设当前正在搜索由0,1组成的K位十进制数

- 读书笔记

chengxuyuancsdn

读书笔记

1、Struts访问资源

2、把静态参数传递给一个动作

3、<result>type属性

4、s:iterator、s:if c:forEach

5、StringBuilder和StringBuffer

6、spring配置拦截器

1、访问资源

(1)通过ServletActionContext对象和实现ServletContextAware,ServletReque

- [通讯与电力]光网城市建设的一些问题

comsci

问题

信号防护的问题,前面已经说过了,这里要说光网交换机与市电保障的关系

我们过去用的ADSL线路,因为是电话线,在小区和街道电力中断的情况下,只要在家里用笔记本电脑+蓄电池,连接ADSL,同样可以上网........

- oracle 空间RESUMABLE

daizj

oracle空间不足RESUMABLE错误挂起

空间RESUMABLE操作 转

Oracle从9i开始引入这个功能,当出现空间不足等相关的错误时,Oracle可以不是马上返回错误信息,并回滚当前的操作,而是将操作挂起,直到挂起时间超过RESUMABLE TIMEOUT,或者空间不足的错误被解决。

这一篇简单介绍空间RESUMABLE的例子。

第一次碰到这个特性是在一次安装9i数据库的过程中,在利用D

- 重构第一次写的线程池

dieslrae

线程池 python

最近没有什么学习欲望,修改之前的线程池的计划一直搁置,这几天比较闲,还是做了一次重构,由之前的2个类拆分为现在的4个类.

1、首先是工作线程类:TaskThread,此类为一个工作线程,用于完成一个工作任务,提供等待(wait),继续(proceed),绑定任务(bindTask)等方法

#!/usr/bin/env python

# -*- coding:utf8 -*-

- C语言学习六指针

dcj3sjt126com

c

初识指针,简单示例程序:

/*

指针就是地址,地址就是指针

地址就是内存单元的编号

指针变量是存放地址的变量

指针和指针变量是两个不同的概念

但是要注意: 通常我们叙述时会把指针变量简称为指针,实际它们含义并不一样

*/

# include <stdio.h>

int main(void)

{

int * p; // p是变量的名字, int *

- yii2 beforeSave afterSave beforeDelete

dcj3sjt126com

delete

public function afterSave($insert, $changedAttributes)

{

parent::afterSave($insert, $changedAttributes);

if($insert) {

//这里是新增数据

} else {

//这里是更新数据

}

}

- timertask

shuizhaosi888

timertask

java.util.Timer timer = new java.util.Timer(true);

// true 说明这个timer以daemon方式运行(优先级低,

// 程序结束timer也自动结束),注意,javax.swing

// 包中也有一个Timer类,如果import中用到swing包,

// 要注意名字的冲突。

TimerTask task = new

- Spring Security(13)——session管理

234390216

sessionSpring Security攻击保护超时

session管理

目录

1.1 检测session超时

1.2 concurrency-control

1.3 session 固定攻击保护

- 公司项目NODEJS实践0.3[ mongo / session ...]

逐行分析JS源代码

mongodbsessionnodejs

http://www.upopen.cn

一、前言

书接上回,我们搭建了WEB服务端路由、模板等功能,完成了register 通过ajax与后端的通信,今天主要完成数据与mongodb的存取,实现注册 / 登录 /

- pojo.vo.po.domain区别

LiaoJuncai

javaVOPOJOjavabeandomain

POJO = "Plain Old Java Object",是MartinFowler等发明的一个术语,用来表示普通的Java对象,不是JavaBean, EntityBean 或者 SessionBean。POJO不但当任何特殊的角色,也不实现任何特殊的Java框架的接口如,EJB, JDBC等等。

即POJO是一个简单的普通的Java对象,它包含业务逻辑

- Windows Error Code

OhMyCC

windows

0 操作成功完成.

1 功能错误.

2 系统找不到指定的文件.

3 系统找不到指定的路径.

4 系统无法打开文件.

5 拒绝访问.

6 句柄无效.

7 存储控制块被损坏.

8 存储空间不足, 无法处理此命令.

9 存储控制块地址无效.

10 环境错误.

11 试图加载格式错误的程序.

12 访问码无效.

13 数据无效.

14 存储器不足, 无法完成此操作.

15 系

- 在storm集群环境下发布Topology

roadrunners

集群stormtopologyspoutbolt

storm的topology设计和开发就略过了。本章主要来说说如何在storm的集群环境中,通过storm的管理命令来发布和管理集群中的topology。

1、打包

打包插件是使用maven提供的maven-shade-plugin,详细见maven-shade-plugin。

<plugin>

<groupId>org.apache.maven.

- 为什么不允许代码里出现“魔数”

tomcat_oracle

java

在一个新项目中,我最先做的事情之一,就是建立使用诸如Checkstyle和Findbugs之类工具的准则。目的是制定一些代码规范,以及避免通过静态代码分析就能够检测到的bug。 迟早会有人给出案例说这样太离谱了。其中的一个案例是Checkstyle的魔数检查。它会对任何没有定义常量就使用的数字字面量给出警告,除了-1、0、1和2。 很多开发者在这个检查方面都有问题,这可以从结果

- zoj 3511 Cake Robbery(线段树)

阿尔萨斯

线段树

题目链接:zoj 3511 Cake Robbery

题目大意:就是有一个N边形的蛋糕,切M刀,从中挑选一块边数最多的,保证没有两条边重叠。

解题思路:有多少个顶点即为有多少条边,所以直接按照切刀切掉点的个数排序,然后用线段树维护剩下的还有哪些点。

#include <cstdio>

#include <cstring>

#include <vector&