hadoop完全分布式集群安装(hdfs/yarn/mysql/hive/hbase的安装)

准备好三台虚拟机,确保可以ping通百度 ping www.baidu.com

如果ip已经配好 可以ping通其他虚拟机 ,但是ping不通外网

【连接在下面】

如果遇到ping不通外网可以看看这个解决方案

一 、安装JDK

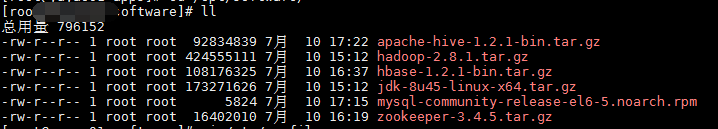

将jdk压缩文件【一般用1.8版本】上传到 其中一个节点 的software下面

] cd /opt

] mkdir software

] mkdir apps解压JDK到/opt/apps下面 并且重命名为jdk【也可以不进行重命名 ,那下面配环境记得使用全路径】

] tar -zxvf jdk-8u45-linux-x64.tar.gz -C /opt/apps/

] mv jdk-8u45-linux-x64 jdk配置环境/etc/profile

] vi /etc/profile

#jdk environment

export JAVA_HOME=/opt/apps/jdk

export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre/bin:$PATH

然后 应用一下配置好的环境

] source /etc/profile二 安装hadoop【完全分布式】

hadoop上传到 其中一个节点 的software下面 然后解压到 apps下

] tar -zxvf hadoop-2.8.1.tar.gz -C /opt/apps/

] cd /opt/apps

] mv hadoop-2.8.1/ hadoop配置环境变量

] vi /etc/profile

#hadoop environment

export HADOOP_HOME=/opt/apps/hadoop

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

将$HADOOP_HOME/etc/hadoop/下的文件 mapred-site.xml.template 复制一份为mapred-site.xml

] cp mapred-site.xml.template mapred-site.xml【重点】[改成自己主机的节点名称]

配置core-site.xml文件 把master修改为其中主节点的主机名称

fs.defaultFS

hdfs://s01:8020

hadoop.tmp.dir

/opt/apps/hadoop/tmp

再配置hdfs-site.xml文件

] vi hdfs-site.xml

dfs.namenode.name.dir

file://${hadoop.tmp.dir}/dfs/name

dfs.datanode.data.dir

file://${hadoop.tmp.dir}/dfs/data

dfs.replication

3

dfs.blocksize

134217728

dfs.namenode.secondary.http-address

slave1:50090

然后配置mapred-site.xml文件

] vi mapred-site.xml

mapreduce.framework.name

yarn

mapreduce.jobhistory.address

s01:10020

mapreduce.jobhistory.webapp.address

s01:19888

配置yarn-site.xml文件

] vi yarn-site.xml

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.resourcemanager.hostname

s01

配置hadoop-env.sh脚本文件

] vi hadoop-env.sh

# The java implementation to use.

export JAVA_HOME=/opt/apps/jdk配置slaves文件,此文件用于指定datanode守护进程所在的机器节点主机名 /opt/apps/hadoop/etc/hadoop/下

] vi slaves

s01

s02

s03【重点】分发到另外两台机器 【另外两台机器/opt/要下面有apps文件夹】

apps]# scp -r ./hadoop s02:/opt/apps/

apps]# scp -r ./hadoop s03:/opt/apps/

apps]# scp -r ./jdk s02:/opt/apps/

apps]# scp -r ./jdk s03:/opt/apps/

apps]# scp /etc/profile s02:/etc/

apps]# scp /etc/profile s03:/etc/检查是否同步了/etc/hosts文件

格式化namenode

] hdfs namenode -format启动脚本start-all.sh测试

三 安装mysql

如果有本地yum源可以直接安装,没有本地yum源也可以安装临时yum源,也可以用mysql依赖下载

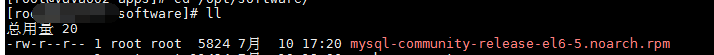

上传mysql插件到linux上

在此文件夹下安装mysql

] yum -y localinstall mysql-community-release-el6-5.noarch.rpm

] yum -y install mysql-server安装完成mysql 启动mysql

] service mysqld start

] mysqladmin -uroot password '123456'

] mysql -uroot -p123456

# 登陆进入mysql

GRANT ALL PRIVILEGES ON *.* TO root@'%' IDENTIFIED BY '123456' with grant option;

flush privileges;

四 安装hive

上传hive到software下 解压到apps下 重命名为 hive

] tar -zxvf apache-hive-1.2.1-bin.tar.gz -C /opt/apps/

] cd /opt/apps

] mv apache-hive-1.2.1-bin/ hive配置环境变量

] vi /etc/profile

export HIVE_HOME=/opt/apps/hive

export PATH=$PATH:$HIVE_HOME/bin/opt/apps/hive/conf/ 配置hive的配置文件:hive-env.sh

# Set HADOOP_HOME to point to a specific hadoop install directory

HADOOP_HOME=/opt/apps/hadoop

# Hive Configuration Directory can be controlled by:

export HIVE_CONF_DIR=/opt/apps/hive/conf启动hive服务

] start-dfs.sh

] start-yarn.sh

] hive五 安装zookeeper

上传zookeeper到software下 解压到apps下 重命名为 zookeeper

] tar -zxvf zookeeper-3.4.5.tar.gz -C /opt/apps/

] cd /opt/apps

] mv zookeeper-3.4.5/ zookeeper

#配置环境变量

] vi /etc/profile

export ZOOKEEPER_HOME=/opt/apps/zookeeper

export PATH=$ZOOKEEPER_HOME/bin:$PATH

#分发到另外两台

apps]# scp /etc/profile s02:/etc/

apps]# scp /etc/profile s03:/etc/] cd ./zookeeper/conf/

] cp zoo_sample.cfg zoo.cfg

] vi zoo.cfg

server.1=s01:2888:3888 # 添加三个服务器节点

server.2=s02:2888:3888

server.3=s03:2888:3888在$ZK_HOME/目录下添加myid文件,内容为server的id号

] echo "1" >> myid分发到另外两台机器

] cd /opt/apps

] scp -r zookeeper s02:/opt/apps

] scp -r zookeeper s03:/opt/apps在第二台机器的myid文件里面写入2

] echo "2" > /opt/apps/zookeeper/myid在第三台机器的myid文件里面写入3

] echo "3" > /opt/apps/zookeeper/myid在每一台机器启动zookeeper

zkServer.sh start六 安装Hbase

上传Hbase到software下 解压到apps下 重命名为 Hbase 配置环境变量

] tar -zxvf hbase-1.2.1-bin.tar.gz -C /opt/apps/

] cd /opt/apps

] mv hbase-1.2.1-bin/ hbase

export HBASE_HOME=/opt/apps/hbase

export PATH=$PATH:$HBASE_HOME/bin

/opt/apps/hbase/conf 里面的hbase-env.sh

export HBASE_MANAGES_ZK=false

export JAVA_HOME=/opt/apps/jdkhbase-site.xml

hbase.cluster.distributed

true

hbase.rootdir

hdfs://s01:9000/hbase

hbase.zookeeper.quorum

s01,s02,s03

regionservers

s01

s02

s03] scp -r hbase/ s02:/opt/apps/

] scp -r hbase/ s03:/opt/apps/我们的s01的conf下backup-masters 写入 高可用副节点名称

s02启动hbase

] start-hbase.sh

] hbase shell