Heterogeneous Graph Neural Networks for Extractive Document Summarization

异构图神经网络用于抽取文档摘要(2020 ACL)

abstract

学习跨句子之间的关系作为提取文档摘要过程中的关键步骤,已有多种方法被提出来研究该问题。一种直观的方法是将它们放在基于图的神经网络中,该网络具有更复杂的结构以捕获句子之间的关系。在本文中,我们提出了一种基于异构图的神经网络(HETERSUMGRAPH)用于提取摘要,该网络包含除句子外的不同粒度级别的语义节点。这些额外的节点充当句子之间的“中介”,并丰富了跨句关系。此外,通过引入文档节点,我们的图结构可以灵活地扩展,从单个文档设置到多文档。据我们所知,我这第一个提出将不同类型的节点引入基于图的神经网络中以进行提取文档摘要,并进行全面的分析以阐述该模型的优点。

1 Introduction

文档摘要旨在从原始文档中提取相关句子并将其重组为摘要。近年来,在此任务上使用深度神经网络取得了巨大的成功(Cheng和Lapata,2016; Narayan等人,2018; Arumae和Liu,2018; Zhong等人,2019a; Liu和Lapata,2019b) 。这些现有模型主要遵循编码器-解码器框架,其中每个句子将由不同形式的神经组件进行编码。

为了有效地从文档中提取与生成摘要相关的句子,核心步骤是对跨句子关系进行建模。当前的大多数模型都捕获了与递归神经网络(RNN)的跨句关系(Cheng和Lapata,2016年; Nallapati等人,2017年; Zhou等人,2018年)。但是,基于RNN的模型通常很难捕获句子级别的长距离依赖关系,尤其是在长文档或多个文档的情况下。一种更直观的方法是使用图形结构对句子之间的关系进行建模。然而,寻找有效的图结构进行摘要抽取是具有挑战性的。早期的传统工作利用句间余弦相似性来建立连通图,例如LexRank(Erkan和Radev,2004)和TextRank(Mihalcea ad Tarau,2004)。最近,一些论文在构建摘要图时考虑了语篇之间的关系,例如具有句子个性化特征的模型: Approximate Discourse Graph (ADG)(ADG)(Yasunaga等人,2017)和Rhetorical Structure Theory graph 。但是,它们通常依赖于外部工具,并且需要考虑错误传播问题。一种更直接的方法是创建一个句子级的全连接图。在某种程度上,例如最近工作中使用的Transformer编码器(Vaswani等人,2017)(Zhong等人,2019a; Liu和Lapata,2019b,用以学习句子之间的成对交互。尽管取得了成功,但如何构建有效的图结构进行摘要抽取仍是一个未解决的问题。

在本文中,我们提出了一种用于提取摘要的异构图网络。我们不仅仅在句子级节点上构建图,还引入更多的语义单元作为图中的额外补充节点,以丰富句子之间的关系。这些额外的节点充当连接句子的中介。即,每个额外节点与包含该节点的句子之间有“特别”的关系。在通过异构图的消息传递过程中,这些额外节点以及句子节点将被迭代更新。

尽管可以使用更高级的特征(例如实体或主题),但为简单起见,我们在本文中将单词用作语义单元。每个句子都与其包含的单词相关。所有句子对和单词对都没有直接边相连。构造的异构词句图具有以下优点:

(a)考虑到结构中重叠的单词,不同的句子之间可以相互交互。

(b)单词节点还可以聚合句子中的信息并得到更新。与我们的模型不同,现有模型通常将单词保留为嵌入层。

(c)通过多个消息传递过程可以充分利用不同粒度的信息。

(d)我们的异构图网络可扩展为更多类型的节点。例如,我们可以引入文档节点进行多文档摘要抽取。

我们重点介绍我们的贡献,如下所示:

(1)据我们所知,我们是第一个构建用于提取文档摘要的异构图网络以建模句子之间的关系的模型,该网络不仅包含句子节点,而且还包含其他语义单元。尽管我们在本文中仅使用单词节点,但可以合并更多高级语义单元(例如实体)。

(2)我们提出的框架在扩展方面非常灵活,可以轻松地从单个文档适应多文档摘要任务。

(3)在没有预先训练的语言模型的情况下,我们的模型可以在三个基准数据集上胜过所有现有竞争对手。消融研究和定性分析表明了我们模型的有效性。

2 Related Work

Extractive Document Summarization

随着神经网络的发展,文档摘要抽取已经取得了很大的进步。他们大多数专注于编码器解码器框架并使用递归神经网络(Cheng和Lapata,2016; Nallapati等,2017; Zhou等,2018)或Transformer编码器(Zhong等,2019b; Wang等人,2019a)。最近,预训练的语言模型也在摘要抽取中用于上下文词表示(Zhong等人,2019a; Liu和Lapata,2019b; Xu等人,2019; Zhong等人,2020)。

提取摘要的另一种直观结构是图,它可以更好地利用句子之间的统计或语言信息。早期的工作着重于用词的内容相似性构建的文档图,例如LexRank(Erkan和Radev,2004)和TextRank(Mihalcea和Tarau,2004)。最近的一些工作旨在通过图神经网络(GNN)将关系优先级合并到编码器中(Yasunaga等人,2017; Xu等人,2019)。从方法上讲,这些工作仅使用一种类型的节点,这些节点将每个文档表示为同构图。

Heterogeneous Graph for NLP

图神经网络及其相关的学习方法(即消息传递(Gilmer等,2017),自注意力(Velickovic等,2017))最初是为同构图设计的,其中整个图共享相同类型的节点。但是,实际应用中的图形通常会带有多种类型的节点(Shi等人,2016),即异构图。为了对这些结构进行建模,最近的工作进行了初步探索。 Tu等。 (2019)引入了一种异构图神经网络来对文档,实体和候选对象进行编码,以实现多跳阅读理解。林梅等。 (2019)专注于半监督短文本分类,并构建了主题-实体异构神经图。

为了抽取摘要,Wei(2012)提出了一个由主题(topic),单词和句子节点组成的异质图,并使用马尔可夫链模型进行迭代更新。 Wang等。 (2019b)用关键字和句子来更新TextRank的图,从而提出了HeteroRank。受到基于异构图的神经网络在其他NLP任务上的成功的启发,我们将其引入提取文本摘要中,以学习更好的节点表示形式。

3 Methodology

给定一个具有n个句子的文档D = {s1,···,sn},我们可以将提取摘要看作序列标记任务,如(Narayan等人,2018; Liu和Lapata,2019b)。我们的目标是预测一个句子的序列y1,…,yn(yi∈{0,1}),其中yi = 1表示摘要中应包含第i个句子。Nallapati等人引入贪心算法以及自动指标ROUGE提取真实标签(我们称为ORACLE)。

一般而言,我们的异构摘要图由两种类型的节点组成:作为中继节点的基本语义节点(例如单词,概念等)和作为超级节点的其他语篇单元(例如短语,句子,文档等)。每个超级节点都与其中包含的基本节点相连,并将关系的重要性作为其边缘特征。因此,高级话语节点可以通过基本节点建立彼此之间的关系。【也就是句子之间的关系可以通过共同包含的words构建】

在本文中,为简单起见,我们将单词用作基本语义节点。 3.1节中的HETERSUMGRAPH是一种特殊情况,仅使用包含一种类型的超节点(句子)进行分类,而3.5节中的HETERDOCSUMGRAPH使用两个类型(文档和句子)。基于我们的框架,还可以引入其他类型的超节点(如段落),唯一的区别在于图形结构。

3.1 Document as a Heterogeneous Graph

给定一个图G = {V,E},其中V代表节点集,E代表节点之间的边,我们的无向异构图可以正式定义为V = Vw∪Vs和E = {e11,···,emn }。在此,Vw = {w1,…,wm}表示文档的m个唯一词,而Vs = {s1,…,sn}对应于文档中的n个句子。 E是实值边缘权重矩阵,eij = 0(i∈{1,···,m},j∈{1,···,n})表示第j个句子包含第i个单词。

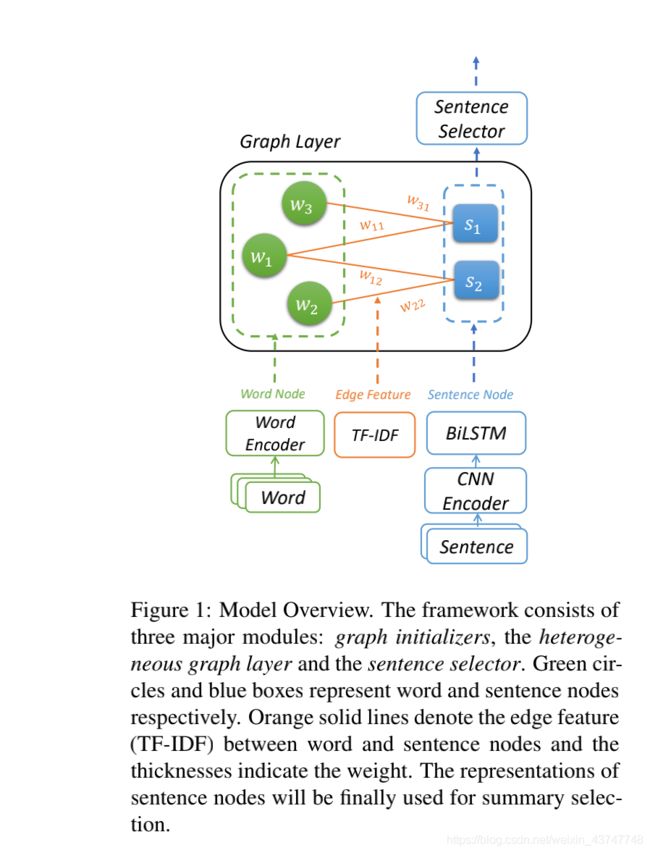

图1展示了我们模型的概述,该模型主要包括三个部分:用于节点和边的图形初始化器,异构图形层和句子选择器。初始化程序首先创建节点和边,并将其编码为文档图。然后,新异质图通过Graph Attention Network(GAT)在单词和句子节点之间迭代传递消息来更新这些节点表示(Velickovic et al。,2017)。最后,提取句子节点的表示以预测摘要的标签。

3.2 Graph Initializers

令Xw∈Rm×dw和Xs∈Rn×ds分别代表单词和句子节点的输入特征矩阵,其中dw是单词嵌入的维数,而ds是每个句子表示向量的维数。具体来说,我们首先使用具有不同内核大小的卷积神经网络(CNN)(Le Cun等,1998)为每个句子lj捕获局部n元语法特征,然后使用双向长短期记忆( BiLSTM(Hochreiter and Schmidhuber,1997)层获得句子级特征gj。CNN局部特征和BiLSTM全局特征的拼接用作句子节点特征Xsj = [lj; gj]。

为了进一步包含有关单词和句子节点之间关系重要性的信息,我们在边缘权重中注入了TF-IDF值。术语频率(TF)是wi在sj中出现的次数,文档的逆频率(IDF)作为wi的出度的逆函数【TODO】

3.3 Heterogeneous Graph Layer

给定具有节点特征Xw∪Xs和边缘特征E的构造图G,我们使用图注意力网络(Velickovic et al。,2017)更新语义节点的表示。

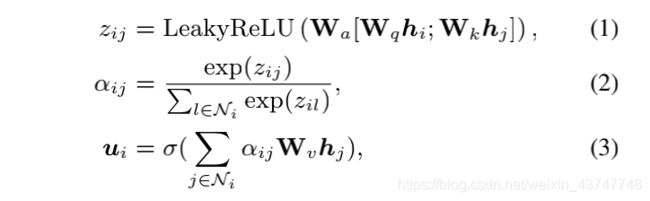

我们将hi∈Rdh,i∈{1,···,(m + n)}【m个words和n条sentences】称为输入节点的隐藏状态,并且图形注意(GAT)层的设计如下:

其中Wa,Wq,Wk,Wv是可训练的权重,而αij是hi和hj之间的注意权重。多头注意力可以表示为:

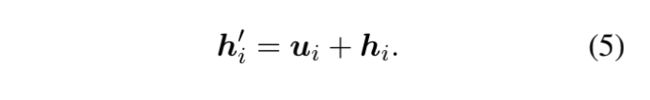

此外,我们还添加了残差连接,以避免梯度在多次迭代后消失。因此,最终输出可以表示为:

我们进一步修改GAT层以给边缘标记权重eij,并将其映射到多维嵌入空间eij∈R mn×de。因此,等式1修改如下:

在每个graph attention layer之后,我们引入一个位置前馈(position-wise feed-forward (FFN))层,该层由两个线性变换组成,就像Transformer一样(Vaswani et al。,2017)。

Iterative updating

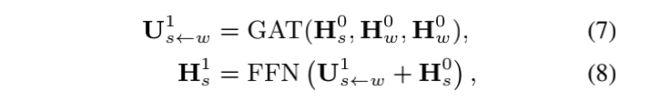

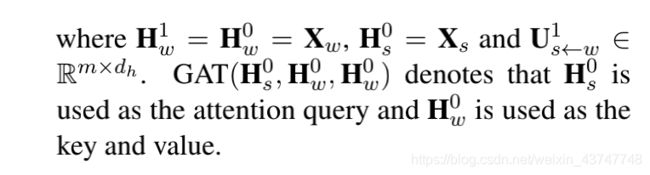

为了在单词和句子节点之间传递消息,我们定义了信息传播,如图2所示。具体地说,在初始化之后,我们通过上述GAT和FFN层用邻近的单词节点更新句子节点:

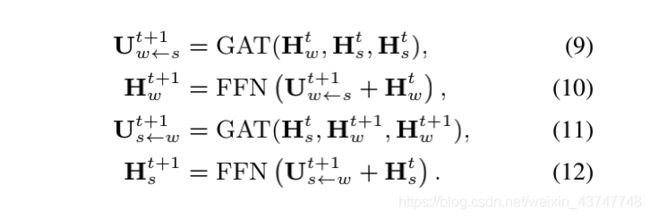

之后,我们使用更新后的句子获取单词节点的新表示,并进一步迭代更新句子节点。每个迭代都包含一个句子到单词和单词到句子的更新过程。对于第t次迭代,该过程可以表示为:

如图2所示,单词节点可以聚合句子中的文档级信息。例如,单词节点的度的值高则表示该单词出现在许多个句子中,并且很可能是文档的关键字。关于句子节点,倾向于选择具有更重要单词的句子作为摘要。

3.4 Sentence Selector

最后,我们需要从异构图中提取摘要中包含的句子节点。因此,我们对句子进行节点分类,并且交叉熵损失被用作整个系统的训练目标。

Trigram blocking

继保卢斯等。 (2017)以及Liu和Lapata(2019b),我们使用Trigram块编码进行解码。具体来说,我们根据其得分对句子进行排序,并丢弃与之前句子单词有三元重叠的句子。【这里的意思是筛选分数较高的句子并且如果句子之间的重叠连续超过3个词的也丢弃掉吗???】

3.5 Multi-document Summarization

对于多文档摘要,文档级别的关系对于更好地理解核心主题和内容至关重要。但是,大多数现有的神经模型都忽略了这种分层结构,而是将文档连接到一个平面序列中(Liu等人,2018; Fabbri等人,2019)。其他人则尝试通过基于注意力的全连接图为这种关系建模(Liu and Lapata,2019a)。

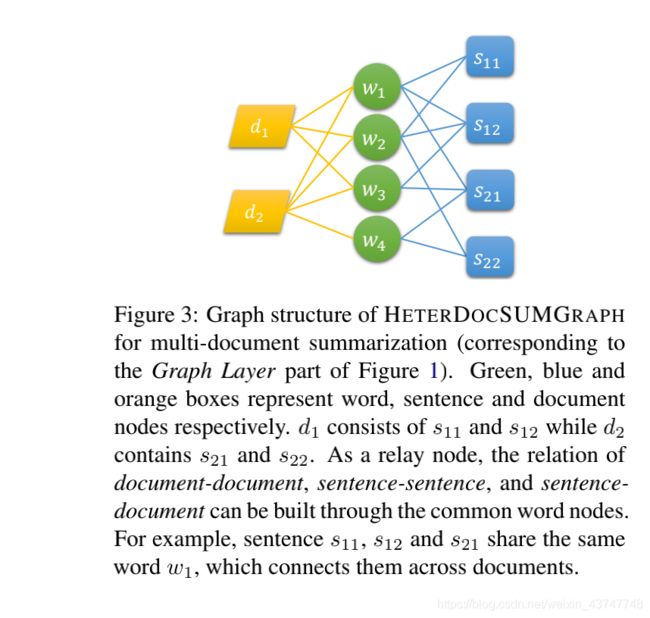

我们的框架可以通过添加文档的超级节点来建立与句子级别相同的文档级别关系(如图3所示),这意味着它可以轻松地从单文档摘要转换为多文档摘要。然后将异构图扩展到三种类型的节点:V = Vw∪Vs∪Vd和Vd = {d1,…,dl},其中l是源文档的数量。我们将其命名为HETERDOC SUMGRAPH。

如图3所示,单词节点成为句子和文档之间的桥梁。包含相同单词的词义相互连接,而不管它们在文档中的距离如何,而文档则根据它们相似的内容建立关系。

可以将文档节点视为句子节点的一种特殊类型:文档节点与包含的单词节点连接,并且TF-IDF值用作边缘权重。此外,文档节点还与句子节点共享相同的更新过程。区别在于初始化,即文档节点将其句子节点特征的平均值池化作为其初始状态。在句子选择期间,将句子节点与相应的文档表示连接起来,以获得最终分数,以进行多文档摘要。

4 Experiment

我们评估单文档和多文档摘要任务的模型。下面,我们以数据集的描述开始实验。

4.1 Datasets

CNN/DailyMail

NYT50

Multi-News

4.2 Settings and Hyper-parameters

对于单文档和多文档摘要,我们将词汇量限制为50,000,并使用300维GloVe嵌入初始化token(Pennington等,2014)。创建单词节点时,我们会过滤停用词和标点符号,并将输入文档截断为最大50个句子的长度。为了减少普通单词带来的噪音,我们在整个数据集中进一步删除了TF-IDF值较低的词汇的10%。我们使用ds = 128初始化句子节点,并使用de = 50初始化GATe中的边缘特征eij。每个GAT层为8个头部,隐藏大小为dh = 64,而FFN层的内部隐藏大小为512。

在训练期间,我们使用32的批次大小,学习率为5e-4,使用Adam优化器(Kingma和Ba,2014)。当连续三个时期的有效损失均未下降时,将执行提前停止。我们根据验证集的性能选择迭代次数t =1。在解码时,对于CNN / DailyMail和NYT50数据集,我们选择前3个句子,数据集Multi-New选择前9个句子。

4.3 Models for Comparison

Ext-BiLSTM

Ext-Transformer

HETERSUMGRAPH

5 Results and Analysis

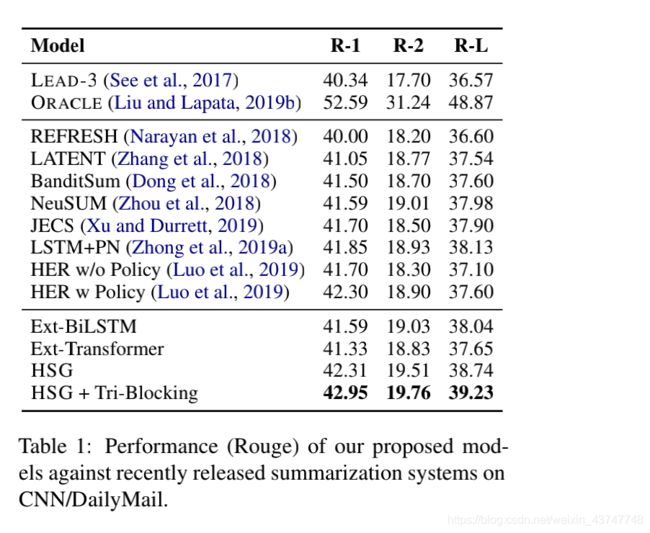

5.1 Single-document Summarization

我们在CNN / DailyMail和NYT50上评估了单文档模型,并报告了R,R-2和R-L的单字,双字组和最长公共子序列与参考摘要的重叠。由于计算资源有限,我们没有在模型中应用预训练的上下文编码器(即BERT(Devlin等,2018),我们将视作我们的未来工作。因此,在这里,为了公平起见,我们仅与没有BERT的模型进行比较。

我们推理过滤掉噪声词会使模型更好地关注有用的词节点,但会损失一些二元信息。残差连接在原始节点表示和更新后的节点的组合中起着重要作用,这些节点不能仅仅用节点拼接所替代。此外,边的特征的引入,词的更新和BiLSTM对句子的初始化对于实验结果也是有效的。

5.2 Multi-document Summarization

5.3 Qualitative Analysis(定性分析)

Degree of word nodes

在HETERSUMGRAPH中,单词节点的度表示其在跨句子中的出现频率,因此可以在某种程度上衡量文档的冗余度。同时,度较高的单词可以聚合多个句子中的信息,这意味着它们可以从迭代过程中获取更多信息。因此,重要的是要探索单词的节点度对摘要实验结果的影响。

Number of source documents

6 Conclusion

在本文中,我们提出了一种基于异构图的神经网络用于提取摘要。在摘要图中引入更细粒度的语义单元有助于我们的模型在句子之间建立更复杂的关系。此外,与基于非BERT的模型相比,我们的模型在CNN / DailyMail上取得了最佳结果,并且我们将考虑预训练的语言模型,以便将来更好地编码节点。

论文地址

代码链接