机器学习之逻辑回归学习分享

数据来源

https://developer.aliyun.com/ai/scenario/9ad3416619b11423180f656d1c9ae44f7?

逻辑回归原理

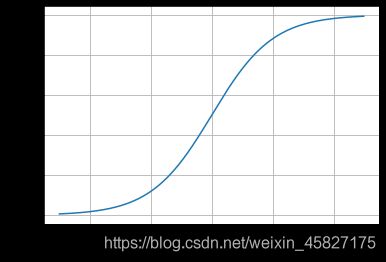

逻辑回归虽然名字里有回归二字,但它其实是分类方法,主要用于二分类问题。逻辑回归利用了Logistic函数(即Sigmoid函数),函数形式为:

L o g i s t ( z ) = 1 1 + e − z Logist(z)=\frac{1}{1+e^{-z}} Logist(z)=1+e−z1

其对应的函数图像为:

可以看出函数的取值范围为(0,1),且z=0时,y等于0.5。当x取值足够大的时候,可以看成0类和1类问题,z>0且y>0.5,则分为1类问题,反之则是0类问题

因为回归的基本方程为: z = w 0 + ∑ w i x i z=w0+\sum wixi z=w0+∑wixi

将其代入Simiod得: p = p ( y = 1 ∣ x , θ ) = h ( x , θ ) = 1 1 + e − ( w 0 + ∑ w i x i ) p=p(y=1|x,\theta)=h(x,\theta)=\frac{1}{1+e^{-(w0+\sum wixi)}} p=p(y=1∣x,θ)=h(x,θ)=1+e−(w0+∑wixi)1

因为逻辑回归满足伯努利分布,所以

p ( y ∣ x ; θ ) = h ( ( x , θ ) ) y ∗ ( 1 − h ( x , θ ) ) 1 − y p(y|x;\theta)=h((x,\theta))^{y}*(1-h(x,\theta))^{1-y} p(y∣x;θ)=h((x,θ))y∗(1−h(x,θ))1−y

因此

输入x分类结果为类别1的概率为: p ( y = 1 ∣ x , θ ) = h ( x , θ ) p(y=1|x,\theta)=h(x,\theta) p(y=1∣x,θ)=h(x,θ)输入x分类结果为类别0的概率为:

p ( y = 0 ∣ x , θ ) = 1 − h ( x , θ ) p(y=0|x,\theta)=1-h(x,\theta) p(y=0∣x,θ)=1−h(x,θ)

逻辑回归的优缺点

逻辑回归的优点:实现简单,易于理解和实现;计算代价不高,速度很快,存储资源低

逻辑回归的缺点:容易欠拟合,分类精度不高

为什么LR要用Simoid()函数

LR模型是一个二分类模型,即对一个X,预测其发生或不发生,但实际上预测并不能达到100%的概率,所以LR模型以50%为分界,即得到的事件概率超过50%则认为事件发生,反之则认为事件不发生,最后通过Y的取值是{0,1}表示是正例还是反例。

综上所述,Simoid很好的符合了LR需要的条件

逻辑回归与线性回归的联系和异同

联系:逻辑回归就是线性回归经过Simoi变换后映射到0到1的范围之内。

区别:

- 线性回归用于回归任务,逻辑回归用于分类任务

- 线性回归输出值为连续值,逻辑回归输出值为概率值

- 损失函数不同

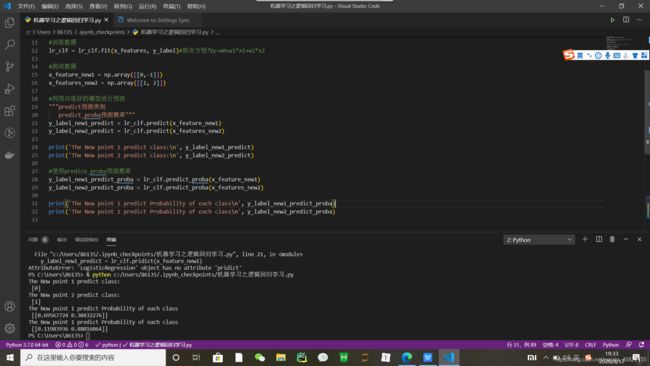

python实现逻辑回归

import numpy as np

from sklearn.linear_model import LogisticRegression

#构建数据集

x_features = np.array([[-1, -2], [-2, -1], [-3, -2], [1, 3], [2, 1], [3, 2]])

y_label = np.array([0, 0, 0, 1, 1, 1])

#调用逻辑回归模型

lr_clf = LogisticRegression()

#训练数据

lr_clf = lr_clf.fit(x_features, y_label)#拟合方程为y=w0+w1*x1+w2*x2

#测试数据

x_feature_new1 = np.array([[0,-1]])

x_features_new2 = np.array([[1, 2]])

#利用训练好的模型进行预测

"""predict预测类别

predict_proba预测概率"""

y_label_new1_predict = lr_clf.predict(x_feature_new1)

y_label_new2_predict = lr_clf.predict(x_features_new2)

print('The New point 1 predict class:\n', y_label_new1_predict)

print('The New point 2 predict class:\n', y_label_new2_predict)

#使用predice_proba预测概率

y_label_new1_predict_proba = lr_clf.predict_proba(x_feature_new1)

y_label_new2_predict_proba = lr_clf.predict_proba(x_features_new2)

print('The New point 1 predict Probability of each class\n', y_label_new1_predict_proba)

print('The New point 1 predict Probability of each class\n', y_label_new2_predict_proba)

最后,由于本人是纯小白刚刚入门,如果有什么错误,敬请指教