参数估计:最大似然估计、贝叶斯估计与最大后验估计

简介:

参数估计的方法有多种,这里我们分析三种基于概率的方法,分别是最大似然估计(Maximum Likelihood)、贝叶斯估计(Bayes)和最大后验估计(Maximum a posteriori)。我们假设我们观察的变量是![]() ,观察的变量取值(样本)为,要估计的参数是,

,观察的变量取值(样本)为,要估计的参数是,![]() 的分布函数是(我们用条件概率来显式地说明这个分布是依赖于取值的)。实际中,

的分布函数是(我们用条件概率来显式地说明这个分布是依赖于取值的)。实际中,![]() 和都可以是几个变量的向量,这里我们不妨认为它们都是标量(theta若是标量求导,若是向量求偏导)。这里的p(x|θ)可以是高斯分布或其他分布。

和都可以是几个变量的向量,这里我们不妨认为它们都是标量(theta若是标量求导,若是向量求偏导)。这里的p(x|θ)可以是高斯分布或其他分布。

- 最大似然估计 Maximum Likelihood (ML)

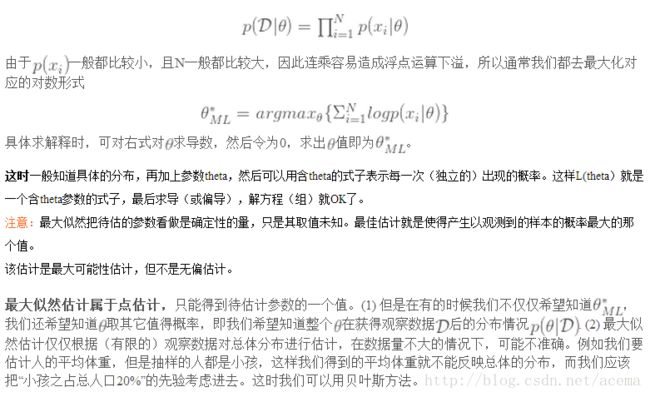

“likelihood/似然”的意思就是“事件(即观察数据)发生的可能性”,最大似然估计就是要找到的一个估计值,使“事件发生的可能性”最大,也就是使最大。一般来说,我们认为多次取样得到的![]() 是独立同分布的(iid),这样

是独立同分布的(iid),这样

由于一般都比较小,且N一般都比较大,因此连乘容易造成浮点运算下溢,所以通常我们都去最大化对应的对数形式

具体求解释时,可对右式对求导数,然后令为0,求出值即为。

最大似然估计属于点估计,只能得到待估计参数的一个值。(1) 但是在有的时候我们不仅仅希望知道,我们还希望知道取其它值得概率,即我们希望知道整个在获得观察数据后的分布情况. (2) 最大似然估计仅仅根据(有限的)观察数据对总体分布进行估计,在数据量不大的情况下,可能不准确。例如我们要估计人的平均体重,但是抽样的人都是小孩,这样我们得到的平均体重就不能反映总体的分布,而我们应该把“小孩之占总人口20%”的先验考虑进去。这时我们可以用贝叶斯方法。

- 贝叶斯估计 Bayes

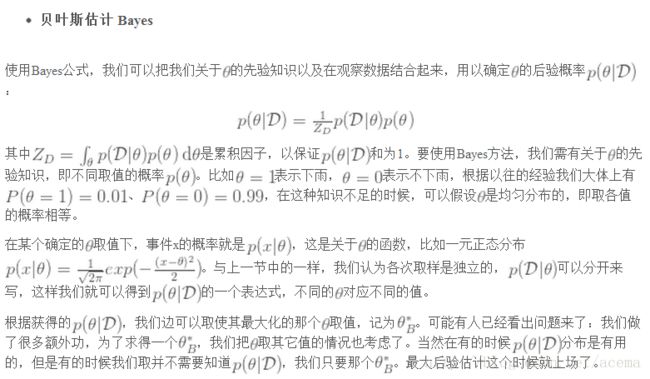

使用Bayes公式,我们可以把我们关于的先验知识以及在观察数据结合起来,用以确定的后验概率:

其中是累积因子,以保证和为1。要使用Bayes方法,我们需有关于的先验知识,即不同取值的概率。比如表示下雨,表示不下雨,根据以往的经验我们大体上有、,在这种知识不足的时候,可以假设是均匀分布的,即取各值的概率相等。

在某个确定的取值下,事件x的概率就是,这是关于的函数,比如一元正态分布。与上一节中的一样,我们认为各次取样是独立的,可以分开来写,这样我们就可以得到的一个表达式,不同的对应不同的值。

根据获得的,我们边可以取使其最大化的那个取值,记为。可能有人已经看出问题来了:我们做了很多额外功,为了求得一个,我们把取其它值的情况也考虑了。当然在有的时候分布是有用的,但是有的时候我们取并不需要知道,我们只要那个。最大后验估计这个时候就上场了。

备注:贝叶斯估计则把待估计的参数看成是符合某种先验概率分布的随机变量。对样本进行观测的过程,就是把先验概率密度转化为后验概率密度,这样就利用样本的信息修正了对参数的初始估计值。在贝叶斯估计中,一个典型的效果就是,每得到新的观测样本,都使得后验概率密度函数变得更加尖锐,使其在待估参数的真实值附近形成最大的尖峰。

- 最大后验估计 MAP

最大后验估计运用了贝叶斯估计的思想,但是它并不去求解,而是直接获得。从贝叶斯估计的公式可以看出,![]() 是与无关的,要求得使最的的,等价于求解下面的式子:

是与无关的,要求得使最的的,等价于求解下面的式子:

与最大似然估计中一样,我们通常最大化对应的对数形式:

这样,我们便无需去计算,也不需要求得具体的部分,便可以得到想要的。

和最大似然很相似,也是假定参数未知,但是为确定数值。只是优化函数为后验概率形式,多了一个先验概率项。

区别与总结:

总结:

三种方法各有千秋,使用于不同的场合。当对先验概率的估计没有信心,可以使用最大似然估计(当然也可以使用其它两种)。贝叶斯估计得到了后验概率的分布,最大似然估计适用于只需要知道使后验概率最大的那个。总体上,极大似然计算简单,而贝叶斯在某些特殊情况下,效果好于极大似然。

另外一方面,我们可以感觉到,最大似然估计和Bayes/MAP有很大的不同,原因在于后两种估计方法利用了先验知识,如果利用恰当,可以得到更好的结果。其实这也是两大派别(Frequentists and Bayesians)的一个区别。

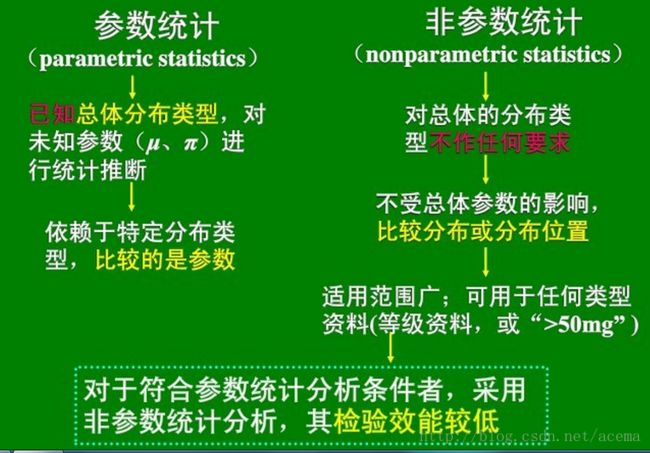

最后附上一张参数估计与非参数估计的对比图:

图片版: