应用 | Redis实现 主从,单例,集群,哨兵,配置应用

小小经过一天的休整

公众号更新规则:每周六将会停更一次,进行短期的休整,其余时间继续每天一更。

Redis 主从配置

这里配置Redis主从

什么是主从

主从复制,是指把一台Redis服务器上的数据,复制到其余Redis服务器上。前者为主节点,后者为从节点。

作用

数据冗余,用于实现数据的热备份,属于一种数据冗余的实现方式。

故障恢复,主节点出现问题,从节点提供服务,快速实现故障恢复,属于服务角度的冗余。

负载均衡,进行读取的时候,通过多个主节点,多个从节点,实现Redis服务器的并发量得以提高。

高可用。主从复制是实现哨兵和集群的基础。

使用主从复制

1. 启动两个节点

这里通过更改配置文件的方式,修改监听的端口号,一个为6379,一个为6380,用于监听两个端口号。![]()

启动两个节点,分别是6379和6380.默认启动都是主节点。

启动两个节点,分别是6379和6380.默认启动都是主节点。

2. 建立复制

这里在6380节点执行复制命令,让其变成从节点。

3. 观察

这里主节点数据会复制到从节点中、

从节点查询一个不存在的key

断开复制

单例

这里的单例,指的是Redis连接池的单例,这里举例的语言为Java,使用的连接池为JedisPool 通过 JedisPool 实现连接池的单例。

双锁机制

通过双重锁机制,实现redis的单例

/**

* 双锁机制,安全且在多线程情况下能保持高性能

*/

public class JedisPoolDoubleCheck {

private static volatile JedisPool jedisPool = null;

private JedisPoolDoubleCheck(){}

public static JedisPool getRedisPoolUtil() {

if(null == jedisPool ){

synchronized (JedisPoolDoubleCheck.class){

if(null == jedisPool){

GenericObjectPoolConfig poolConfig = new GenericObjectPoolConfig();

poolConfig.setMaxTotal(100);

poolConfig.setMaxIdle(10);

poolConfig.setMaxWaitMillis(100*1000);

poolConfig.setTestOnBorrow(true);

jedisPool = new JedisPool(poolConfig,"192.168.10.151",6379);

}

}

}

return jedisPool;

}

}

classloader

通过类加载器,实现单例连接Redis

/**

* 登记式/静态内部类

*

*/

public class JedisPoolInnerClass {

private JedisPoolInnerClass(){}

private static GenericObjectPoolConfig poolConfig = new GenericObjectPoolConfig();

static {

poolConfig.setMaxTotal(100);

poolConfig.setMaxIdle(10);

poolConfig.setMaxWaitMillis(100*1000);

poolConfig.setTestOnBorrow(true);

}

private static class JedisPoolHolder{

private static final JedisPool INSTANCE = new JedisPool(poolConfig,"192.168.10.151",6379);

}

public final static JedisPool getInstance(){

return JedisPoolHolder.INSTANCE;

}

}

集群

这里使用redis 提供的命令行,实现redis集群的搭建

redis.conf 文件准备

redis server集群模式需要一些特殊的配置,下为参考

port 7000 # server端口,6台server对应7000-7005。

# bind 127.0.0.1 //这一行要注释,否则无法远程连接

cluster-enabled yes

cluster-config-file nodes.conf //node.conf文件不用管。

cluster-node-timeout 5000

appendonly yes //aof

daemonize yes

protected-mode no

准备六台sever的配置文件

mkdir redis-cluster

cd redis-cluster

mkdir 7000 7001 7002 7003 7004 7005

然后将redis.conf文件拷贝到 7000 到 7005 目录里面(每个redis.conf的只有端口不同)

启动服务器

对应每一个目录,启动一个服务器

redis-server redis.conf

到这里我们就有以集群模式启动的6台(端口7000-7005)redis server,但是每台服务器还没有进行slot指派,此时是不能对外提供服务的。

搭建集群(slot指派)

下面的命令将7000-7005的六台服务器组成一个集群 其中复制因子为1所,以会有3台master,另外3台为slave。16384个slot会尽可能均匀的指派给3台master, 而3台slave异步的从其master进行复制。

redis-cli --cluster create 127.0.0.1:7000 127.0.0.1:7001 127.0.0.1:7002 127.0.0.1:7003 127.0.0.1:7004 127.0.0.1:7005 --cluster-replicas 1

密码设置

通过redis-cli连接每一台server,然后设置密码

config set masterauth [password]

config set requirepass [password]

哨兵机制

这里基于哨兵,实现redis的高可用

机器规划

集群配置

redis.conf配置

Master(192.168.50.100)机器配置如下:

#后台启动

daemonize yes

pidfile "/home/redis/redis/redisRun/redis_6379.pid"

port 6379

timeout 0

tcp-keepalive 0

loglevel notice

logfile "/home/redis/redislog/redis.log"

databases 16

save 900 1

save 300 10

save 60 10000

stop-writes-on-bgsave-error yes

rdbcompression yes

rdbchecksum yes

dbfilename "dump.rdb"

dir "/home/redis/redisdb"

#如果做故障切换,不论主从节点都要填写密码且要保持一致

masterauth "123456"

slave-serve-stale-data yes

slave-read-only yes

repl-disable-tcp-nodelay no

slave-priority 98

#当前redis密码

requirepass "123456"

appendonly yes

# appendfsync always

appendfsync everysec

# appendfsync no

no-appendfsync-on-rewrite no

auto-aof-rewrite-percentage 100

auto-aof-rewrite-min-size 64mb

lua-time-limit 5000

slowlog-log-slower-than 10000

slowlog-max-len 128

notify-keyspace-events ""

hash-max-ziplist-entries 512

hash-max-ziplist-value 64

list-max-ziplist-entries 512

list-max-ziplist-value 64

set-max-intset-entries 512

zset-max-ziplist-entries 128

zset-max-ziplist-value 64

activerehashing yes

client-output-buffer-limit normal 0 0 0

client-output-buffer-limit slave 256mb 64mb 60

client-output-buffer-limit pubsub 32mb 8mb 60

hz 10

aof-rewrite-incremental-fsync yes

# Generated by CONFIG REWRITE

Slave(192.168.50.101-103)机器配置如下:

daemonize yes

pidfile "/home/redis/redis/redisRun/redis_6379.pid"

port 6379

timeout 0

tcp-keepalive 0

loglevel notice

logfile "/home/redis/redislog/redis.log"

databases 16

save 900 1

save 300 10

save 60 10000

stop-writes-on-bgsave-error yes

rdbcompression yes

rdbchecksum yes

dbfilename "dump.rdb"

dir "/home/redis/redisdb"

#主节点密码

masterauth "123456"

slave-serve-stale-data yes

slave-read-only yes

repl-disable-tcp-nodelay no

slave-priority 98

requirepass "123456"

appendonly yes

# appendfsync always

appendfsync everysec

# appendfsync no

no-appendfsync-on-rewrite no

auto-aof-rewrite-percentage 100

auto-aof-rewrite-min-size 64mb

lua-time-limit 5000

slowlog-log-slower-than 10000

slowlog-max-len 128

notify-keyspace-events ""

hash-max-ziplist-entries 512

hash-max-ziplist-value 64

list-max-ziplist-entries 512

list-max-ziplist-value 64

set-max-intset-entries 512

zset-max-ziplist-entries 128

zset-max-ziplist-value 64

activerehashing yes

client-output-buffer-limit normal 0 0 0

client-output-buffer-limit slave 256mb 64mb 60

client-output-buffer-limit pubsub 32mb 8mb 60

hz 10

aof-rewrite-incremental-fsync yes

# Generated by CONFIG REWRITE

#配置主节点信息

slaveof 192.168.50.100 6379

哨兵配置如下

Master(192.168.50.100)机器配置如下:

port 26379

#1表示在sentinel集群中只要有两个节点检测到redis主节点出故障就进行切换,单sentinel节点无效(自己测试发现的)

#如果3s内mymaster无响应,则认为mymaster宕机了

#如果10秒后,mysater仍没活过来,则启动failover

sentinel monitor mymaster 192.168.50.100 6379 1

sentinel down-after-milliseconds mymaster 3000

sentinel failover-timeout mymaster 10000

daemonize yes

#指定工作目录

dir "/home/redis/sentinel-work"

protected-mode no

logfile "/home/redis/sentinellog/sentinel.log"

#redis主节点密码

sentinel auth-pass mymaster 123456

# Generated by CONFIG REWRITE

Slave(192.168.50.100-102)机器配置同上

启动集群

启动192.168.50.100-103各机器Redis节点命令如下:

redis-server /home/redis/redis/redis.conf

在192.168.50.100启动Redis哨兵节点命令如下:

redis-sentinel /home/redis/redis/sentinel.conf

启动后效果

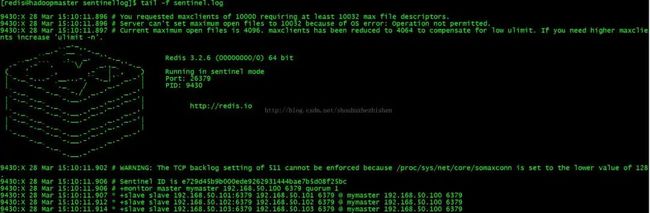

哨兵节点

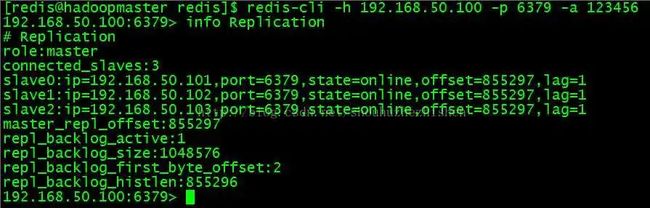

登录Master(192.168.50.100)的redis查看Master的情况:

执行登录命令如下:

redis-cli -h 192.168.50.100 -p 6379 -a 123456

列出Master的信息:

info Replication

登录Slave(192.168.50.101)的redis查看Slave的情况:

执行登录命令如下:

redis-cli -h 192.168.50.101 -p 6379 -a 123456

列出Slave的信息:

info Replication

登录Slave(192.168.50.102)的redis查看Slave的情况:

执行登录命令如下:

redis-cli -h 192.168.50.102 -p 6379 -a 123456

列出Slave的信息:

info Replication

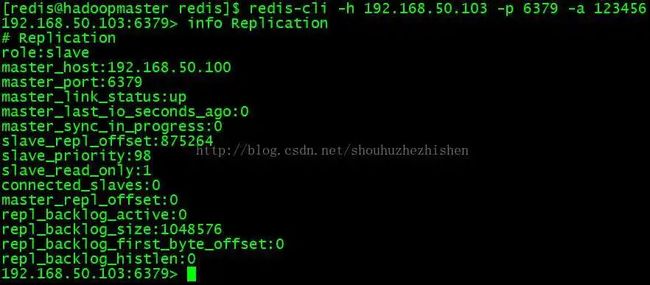

登录Slave(192.168.50.103)的redis查看Slave的情况:

执行登录命令如下:

redis-cli -h 192.168.50.103 -p 6379 -a 123456

列出Slave的信息:

info Replication

小明菜市场

推荐阅读

● 实战 | 后端日志的前世今生

● 实战 | Java 流之Stream,Lambda以及日期

● 理论 | 优雅的构建一个健壮的API接口

● 实战 | webmagic爬取实战之爬取保险经纪人信息

● 实战 | WebMagic 爬取某保险经纪人网站经纪人列表之网站列表爬取