Python小白逆袭大神七日打卡营飞桨paddlepaddle

这里写自定义目录标题

- Python小白逆袭大神七日打卡营全纪录

- day1-Python基础

- day2-《青春有你2》选手信息爬取

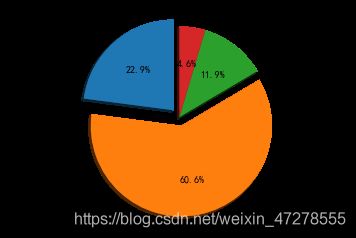

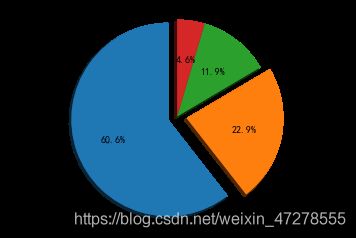

- day3-《青春有你2》选手数据分析

- day4-《青春有你2》选手识别

- day5-综合大作业

Python小白逆袭大神七日打卡营全纪录

day1-Python基础

作业一:输出 9*9 乘法口诀表(注意格式)

注意:提交作业时要有代码执行输出结果。

def table():

#在这里写下您的乘法口诀表代码吧!

for i in range(1,10): #大循环9次

str_row = ""#每一行的字符串 9行

for j in range(1,i+1):

str_row += "{0}*{1}={2}".format(j,i,i*j)+" "

print(str_row)

if __name__ == '__main__':

table()11=1

12=2 22=4

13=3 23=6 33=9

14=4 24=8 34=12 44=16

15=5 25=10 35=15 45=20 55=25

16=6 26=12 36=18 46=24 56=30 66=36

17=7 27=14 37=21 47=28 57=35 67=42 77=49

18=8 28=16 38=24 48=32 58=40 68=48 78=56 88=64

19=9 29=18 39=27 49=36 59=45 69=54 79=63 89=72 9*9=81

作业二:查找特定名称文件

遍历”Day1-homework”目录下文件;

找到文件名包含“2020”的文件;

将文件名保存到数组result中;

按照序号、文件名分行打印输出。

注意:提交作业时要有代码执行输出结果。

#导入OS模块

import os

#待搜索的目录路径

path = "Day1-homework"

#待搜索的名称

filename = "2020"

#定义保存结果的数组

result = []

def findfiles():

#在这里写下您的查找文件代码吧!

i = 1 #要求文件的序号

for dirpath,dirnames,sub_filenames in os.walk(path):

#对文件有”2020“进行删选

for sub_filename in sub_filenames:

str_sub_filename = str(sub_filename)

if(str_sub_filename.find(filename,0,len(str_sub_filename))!=-1):

result.append(sub_filename)

#将指定文件加入result

print('{}, \''.format(i)+dirpath+sub_filename+'\'')

i = i+1 #序号递增

if __name__ == '__main__':

findfiles()1, ‘Day1-homework/4/2204:22:2020.txt’

2, ‘Day1-homework/26/26new2020.txt’

3, ‘Day1-homework/18182020.doc’

day2-《青春有你2》选手信息爬取

度学习一般过程:

收集数据,尤其是有标签、高质量的数据是一件昂贵的工作。

爬虫的过程,就是模仿浏览器的行为,往目标站点发送请求,接收服务器的响应数据,提取需要的信息,并进行保存的过程。

Python为爬虫的实现提供了工具:requests模块、BeautifulSoup库

任务描述

本次实践使用Python来爬取百度百科中《青春有你2》所有参赛选手的信息。

数据获取:https://baike.baidu.com/item/青春有你第二季

上网的全过程:

普通用户:

打开浏览器 --> 往目标站点发送请求 --> 接收响应数据 --> 渲染到页面上。

爬虫程序:

模拟浏览器 --> 往目标站点发送请求 --> 接收响应数据 --> 提取有用的数据 --> 保存到本地/数据库。

爬虫的过程:

1.发送请求(requests模块)

2.获取响应数据(服务器返回)

3.解析并提取数据(BeautifulSoup查找或者re正则)

4.保存数据

本实践中将会使用以下两个模块,首先对这两个模块简单了解以下:

request模块:

requests是python实现的简单易用的HTTP库,官网地址:http://cn.python-requests.org/zh_CN/latest/

requests.get(url)可以发送一个http get请求,返回服务器响应内容。

BeautifulSoup库:

BeautifulSoup 是一个可以从HTML或XML文件中提取数据的Python库。网址:https://beautifulsoup.readthedocs.io/zh_CN/v4.4.0/

BeautifulSoup支持Python标准库中的HTML解析器,还支持一些第三方的解析器,其中一个是 lxml。

BeautifulSoup(markup, “html.parser”)或者BeautifulSoup(markup, “lxml”),推荐使用lxml作为解析器,因为效率更高。

!!!作业说明!!!

1.请在下方提示位置,补充代码,完成《青春有你2》选手图片爬取,将爬取图片进行保存,保证代码正常运行

2.打印爬取的所有图片的绝对路径,以及爬取的图片总数,此部分已经给出代码。请在提交前,一定要保证有打印结果

一、爬取百度百科中《青春有你2》中所有参赛选手信息,返回页面数据

import json

import re

import requests

import datetime

from bs4 import BeautifulSoup

import os

#获取当天的日期,并进行格式化,用于后面文件命名,格式:20200420

today = datetime.date.today().strftime('%Y%m%d')

def crawl_wiki_data():

"""

爬取百度百科中《青春有你2》中参赛选手信息,返回html

"""

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/67.0.3396.99 Safari/537.36'

}

url='https://baike.baidu.com/item/青春有你第二季'

try:

response = requests.get(url,headers=headers)

print(response.status_code)

#将一段文档传入BeautifulSoup的构造方法,就能得到一个文档的对象, 可以传入一段字符串

soup = BeautifulSoup(response.text,'lxml')

#返回的是class为table-view log-set-param的