Pyramid Feature Attention Network for Saliency detection 用于显著性检测的金字塔特征注意网络

Pyramid Feature Attention Network for Saliency detection

引言

显著性检测是计算机视觉领域的基本挑战之一,怎么有效去提取特征非常关键,目前的一些方法主要都是采用多尺度卷积提取特征的方法,然而有些特征对于显著性检测是没有作用的,有的会引起干扰。这篇文章旨在解决这一问题,提出一种金字塔特征注意网络,重点关注有效的高层上下文特征和低层次的空间结构特征。

首先作者设计了上下文感知金字塔特征提取模块(CPFE)用于多尺度高层次特征映射来获得丰富的上下文特征,其次采用CPFE的特征映射后的信道注意(CA)和低层次特征映射后的空间注意力(SA),然后将CA和SA的输出融合在一起,最后用一种边缘保留损失来指导网络学习更详细的边界定位信息。

介绍

目前最有效的显著性检测方法是基于FCN的。FCN将多个卷积层和池化层叠加起来,逐步增加接收域,生成高级语义信息,在显著性检测中起着至关重要的作用,然而池化层缩小了特征映射的大小,并恶化了突出对象的边界。有些网络用手工设计特征来保护突出物体的边界,提取手工特征来计算超像素的显著值。通过手工艺特征将图像划分为区域。 在生成显着性图时,手工艺特征和CNN高级特征是互补的,但在这些方法中分开提取。难以有效地融合单独提取的互补特征,此外,手工工艺特征提取是一个耗时的过程。

除了手工工艺特征外,一些工作还发现网络不同层的特征也是互补的,并集成了用于显着性检测的多尺度特征。 更具体地,深层的特征通常包含全局上下文感知信息,其适合于正确地定位显着区域。 浅层的特征包含空间结构细节,适合于定位边界。 这些方法融合了不同的尺度特征而没有考虑它们对显着性的不同贡献,它对于显着性检测不是最佳的。 为了克服这些问题,将关注模型和门函数引入显着性检测网络。 但是,这些方法忽略了高级和低级特征的不同特征,可能会影响有效特征的提取。

因此如何获得各种功能并选择有效功能成为显着性检测中的一个重要问题。

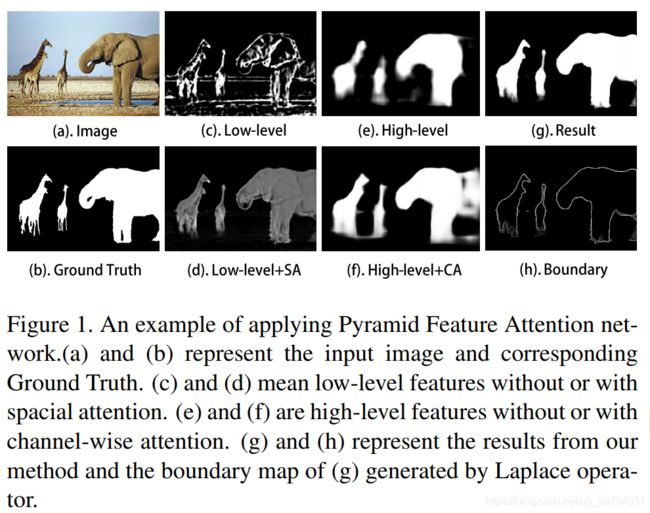

作者提出了一种新的显着物体检测方法 - 金字塔特征注意(PFA)网络。考虑到不同级别特征的不同特征(图1(c,e)),来自低级特征的显着性图包含许多噪声,而来自高级特征的显着性图仅获得近似区域。因此,对于受SIFT特征提取算法启发的高级特征,设计了一个上下文感知金字塔特征提取(CPFE)模块,以获得多尺度多感受域高级特征,然后使用通道方式注意(CA)选择适当的比例和感受域以产生显着性区域。在训练过程中,CA为通道提供较大的权重,这对于显着性检测起着重要作用(图1(f))。为了优化显着区域的边界,将低级特征与边缘信息融合在一起。但并非所有边缘信息都有效地提炼显着性图,而是期望关注显着对象和背景之间的界限。因此,我们使用空间注意来更好地关注有效的低级特征,并获得明确的显着性边界(图1(d))。在处理不同的注意机制后,高级特征和低级特征具有互补意识,适合生成显着图。此外,与以前的显着性检测方法不同,作者提出边缘保留损失,以指导网络在边界定位中学习更详细的信息。

简而言之,本文的贡献总结如下:

1.提出了一个用于图像显着性检测的金字塔特征注意(PFA)网络。 对于高级功能,采用上下文感知金字塔特征提取模块和通道智能注意模块来捕获丰富的上下文信息。 对于低级功能,采用空间注意模块来过滤掉一些背景细节。

2.设计了一种新颖的边缘保存损失,以指导网络在边界定位中学习更详细的信息。

在CPFE模块中,VGG网络的三个高级块侧采用多尺度的回转卷积,然后通道注意机制将大权重分配给对显着对象表现出高响应的通道。对于低级特征,存在一些背景区域,其分散了显着性图的生成。空间注意机制根据高级特征过滤掉一些背景细节,并更多地关注前景区域,这有助于为显着性预测生成有效的特征。

Pyramid Feature Attention Network

现有的CNN模型通过堆叠多个卷积和池化层来学习对象的特征。然而,显着物体在尺度,形状和位置上有很大的变化。以前的方法通常直接使用从下到上的卷积和池化层,这可能无法有效地处理这些复杂的变化。受SIFT 特征提取的启发,作者设计一了个新颖的模块来提取尺度,形状和位置不变性的特征。尺度不变特征变换(SIFT)是计算机视觉中的特征检测算法,用于检测和描述图像中的局部特征。该算法提出了高斯表示的拉普拉斯算法,其融合了尺度空间表示和金字塔多分辨率表示。由具有相同分辨率的几个不同高斯核函数处理的标度空间表示;以及由不同分辨率的下采样处理的金字塔多分辨率表示。与SIFT中的高斯函数类似,使用atrous卷积来获得具有相同比例但不同感受域的特征。与SIFT中的金字塔多分辨率表示类似,网络采用VGG-16 的conv3-3,conv4-3和conv5-3来提取多尺度特征。

具体而言,上下文感知金字塔特征提取模块如图3所示。 将VGG-16中的conv3-3,conv4-3和conv5-3作为基础网络。 为了使最终提取的高级特征包含尺度和形状不变性的特征,采用具有不同扩张率的卷积,其被设置为3,5和7以捕获多感受野场上下文信息。 然后,通过跨通道连接组合来自不同的atrous卷积层的特征映射和1×1维度减少特征。 在此之后,获得具有上下文感知信息的三种不同比例特征,并将两个较小的特征上采样到最大的一个。 最后,通过跨渠道连接将它们组合为上下文感知金字塔特征提取模块的输出。

Attention mechanism

作者利用上下文感知金字塔特征提取来获得多尺度多感受域高级特征。不同特征具有不同的语义值来生成显着性图。但是大多数现有方法没有区别地集成了多尺度特征,这导致信息冗余。更重要的是,某些级别的不准确信息会导致性能下降甚至错误预测。过滤这些功能以及更有价值的功能非常重要。根据不同层次特征的特点,采用渠道方式关注高层特征,空间注意力为低层特征选择有效特征。另外,不会对高级特征使用空间注意,因为高级特征包含高抽象语义不需要过滤空间信息。因为低级功能的不同通道之间几乎没有语义差异,所以不会对低级功能使用信道关注。

Channel-wise attention

CNN中不同的特征通道产生对不同语义的响应。 从图1可以看出,高级特征的显着图只是一个粗略的结果,一些基本区域可能会被削弱。 我们在上下文感知金字塔特征提取之后将CA模块添加到加权多尺度多感知域高级特征。 CA将为通道提供更大的权重,这些通道对显着对象表现出高响应。

展开高级特征fh ∈ RW×H×C as fh= [fh1, fh2,…, f(h)C] 当fhi ∈ R^(W×H)fh是第i个切片,C是通道数。

首先,对每个f hi应用平均合并以获得通道方向特征向量v h∈R^C. 之后,两个连续的完全连接(FC)层完全捕获通道依赖性(见图4)。 为了限制模型复杂性和辅助泛化,通过形成围绕非线性的两个FC层的瓶颈来编码通道方向特征向量。 然后,通过使用sigmoid操作,将归一化处理度量采用映射到[0,1]的编码的通道方向特征向量。

其中W指的是通道注意块中的参数,σ1指的是S形操作,f c指的是FC层,δ指的是ReLU函数。 通过用CA加权上下文感知金字塔特征来获得块的最终输出~f^h。

Spacial attention

自然图像通常包含前景和复杂背景的丰富细节。 从图1中,低级特征的显着性图包含很多细节,很容易带来不好的结果。在显着性检测中,要获得显着对象和背景之间的详细边界,而没有可能分散人们注意力的其他纹理。 因此不能同等地考虑所有空间位置,而是采用空间关注来更多地关注前景区域,这有助于为显着性预测生成有效的特征。

表示低级特征,fl∈R^(W×H×C)组空间位置由R = {(x, y)|x =1, …, W; y = 1, …, H}表示,其中j =(x,y)是低级特征的空间坐标。 为了增加感受野和获取全局信息但不增加参数,应用两个卷积层,一个内核是1×k而另一个是k×1,用于捕获空间关注的高级特征(参见 图4)。 然后,使用sigmoid操作,对映射到[0,1]的编码空间特征映射进行归一化处理。

其中W指的是空间注意阻滞中的参数,σ2指sigmoid操作,conv1和conv2分别指1×k×C和k×1×1卷积层,我们在实验中设定k = 9。 通过用SA加权fl来获得块的最终输出~f^l。

![]()

LOSS function

其中Y表示地面实况,P表示网络输出的显着图,αs表示正样本和负样本的平衡参数,设置αs= 0.528,它是根据训练集的groundtruth计算的。 但是,损失函数只是提供生成显着图的一般指导。用更简单的策略来强调显着对象边界细节的生成。 首先,用拉普拉斯算子来获得网络输出的地面实况和显着性图的边界,然后用交叉熵损失来监督显着对象边界的生成。

拉普拉斯算子是n维欧几里德空间中的二阶微分算子,定义为梯度的散度(Δf)。 因为二阶导数可用于检测边缘,所以使用拉普拉斯算子来获得显着的对象边界。 二维拉普拉斯算子由方程式8给出,其中x和y是xy平面的标准笛卡尔坐标。 实际上,由于拉普拉斯算子使用图像的梯度,因此它在内部调用卷积运算来执行其计算。 然后使用绝对运算,然后使用tanh激活方程式9将值映射到[0,1]。 最后,使用交叉熵损失来监督显着对象边界的产生Eq.10。 总损失函数是它们的加权和:

![]()

实验

性能评估用于五个标准基准数据集:DUTS-test,ECSSD,HKUIS,PASCAL-S 和DUT-OMRON 。 DUTS 是一个大型数据集,包含10553个用于训练的图像和5019个用于测试的图像。 ECSSD在其地面真实分割中包含1000个具有许多语义上有意义且复杂的结构的图像。 HKU-IS 包含4447个具有多个断开的显着对象的挑战性图像,与图像边界重叠或低色彩对比度。 PASCAL-S 包含850个图像,不同的显着对象标记有不同的显着性。 DUT-OMRON 拥有5,168个高质量图像。 该数据集的图像具有一个或多个显着对象和相对复杂的背景。

与其他最先进的显着对象检测方法相同,三个常用标准用于性能评估,即精确度和回忆曲线(表示为PR曲线),F-度量,加权F-度量(表示为wFβ)和均值 绝对误差(MAE)。

其中β2= 0.3,如其他方法所用。 平均绝对误差(MAE)通过以下公式计算: