用于视觉识别的深度卷积网络空间金字塔池化方法

摘要

现有的深卷积神经网络(CNN)需要一个固定大小的神经网络(例如224x224)的输入图像。这种要求是“人为的”,可能会降低对任意大小/尺度的图像或子图像的识别精度。在这项工作中,我们为网络配备了另一种池化策略,即“空间金字塔池”,以消除上述需求。新的网络结构,称为Spp-Net,可以生成一个固定长度的表示,而不考虑图像大小/比例。金字塔池对于物体的变形也是健壮的。基于这些优点,spp-net总体上应该改进所有基于cnn的图像分类方法。在ImageNet 2012数据集上,我们证明了spp- net提高了各种cnn架构的准确性,尽管它们的设计不同。在pascal voc 2007和caltech 101数据集上,spp-net使用单一的全图像表示和不进行微调实现了最先进的分类结果。在目标检测中,Spp-Net的强大作用也是非常重要的。利用SPP-Net,我们只从整个图像中计算一次特征映射,然后将特征 中在任意区域(子图像)中,生成固定长度的表示,以训练检测器。该方法避免了重复计算卷积特征。在处理测试图像时,我们的方法是24-102。比R-CNN方法更快,同时在Pascal voc 2007上实现了更好的或可比的精度..在2014年ImageNet大规模视觉识别挑战(ILSVRC)中,我们的方法排名第二,在目标检测排第三。38支队伍中有3支在图像分类方面。这份手稿还介绍了为这次比赛所作的改进。

关键词。卷积神经网络,空间金字塔池,图像分类,目标检测

一,引言

我们正在目睹一个快速的,革命性的变化,我们的视觉社区,主要是由深卷积神经网络(CNN)[1]和大规模培训数据的可用性[2]。最近,基于深度网络的方法在图像分类[3],[4],[5],[6],目标检测[5],[7],[8],许多其他识别任务[9],[10],[11],[12 ]甚至是不承认的任务。

然而,在CNN的训练和测试中存在一个技术问题:流行的CNN需要固定的输入图像大小(例如224x224),限制输入图像的纵横比和比例当应用于任意大小的图像时,目前的方法大多通过裁剪[3],[4]或通过翘曲[7],[13]将输入图像与固定大小相匹配,如图1(顶部)所示。但是裁剪区域可能不包含整个图象,而变形的部分可能导致不必要的几何失真。由于内容丢失或失真,识别精度可能受到影响。此外,当对象尺度变化时,预定义的尺度可能不合适。固定输入大小会忽略涉及比例尺的问题。

那么,为什么CNN需要固定的输入大小呢?CNN主要由两部分组成:卷积层和后面的全连接层,卷积层以滑动窗口的方式工作,输出特征映射表示激活的空间排列(图2)事实上,卷积层不需要固定的图像大小,并且可以生成任意大小的特征映射。另一方面,全连接层需要通过其定义输入固定大小/长度的信息。因此,固定大小约束只来自于全连接层,这些层存在于网络的更深的阶段。

本文引入了一个空间金字塔池(SPP)[14],[15]层来消除网络的固定大小约束。具体来说,我们在最后一个卷积层的顶部添加了一个spp层。spp层集合特征并生成固定长度的输出,然后将其输入到全连接层(或其他分类器)中。换句话说,我们在网络层次结构的更深阶段(在卷积层和全连接层之间)执行一些信息“聚合”,以避免在开始时需要裁剪或变形。Fig.1(下)通过引入spp层来显示网络体系结构的变化。我们称之为新的网络结构Spp-Net。

空间金字塔池[14],[15](俗称空间金字塔匹配或SPM [15])是[16]字包模型的延伸,是计算机视觉中最成功的方法之一。它将图像划分为从更细到更粗的级别,并将它们中的本地特性聚合起来。在最近CNN流行之前,SPP一直是领先和竞争获胜的分类系统(例如[17],[18],[19])和检测(例如,[20])的关键组成部分尽管如此,spp-net还没有在CNN的范围内得到考虑,我们注意到spp对于深层CNN具有几个显着的特性:1、spp可以生成固定长度的输出,而不考虑输入大小,而以前的深层网络中使用的滑动窗口池不能使用; 2、spp使用多层空间桶,而滑动窗口池只使用单个窗口大小,多层池已被证明对象变形具有鲁棒性[ 15]; 3、spp由于输入尺度的灵活性,可以汇集在可变尺度上的特征提取,实验表明所有这些因素都提高了深层网络的识别精度。

中间裁剪或变形以适应固定尺寸:顶部。一个传统的CNN底部:我们的空间金字塔池网络结构。

SPP-NET不仅可以为测试从任意大小的图像/窗口生成表示,而且还允许我们在训练期间提供不同大小或尺度的图像。使用变尺寸图像的训练增加了尺度不变性,减少了过拟合。我们开发了一种简单的多尺寸训练方法。对于单个网络,要接受可变的输入大小,我们用共享所有参数的多个网络来近似,而每个网络都使用固定的输入大小进行训练。在每个阶段,我们用给定的输入大小训练网络,然后切换到下一个时期的另一个输入大小。实验表明,这种多尺度训练方法与传统的单尺度训练方法相一致,具有较好的测试精度。

SPP的优点与具体的CNN设计是正交的。在ImageNet 2012数据集上的一系列受控实验中,我们证明spp改进了现有出版物[3],[4],[5](或它们的修改)中的四种不同的CNN结构,而非spp对应的。这些架构有不同的滤波器编号/大小,步幅,深度或其他设计。因此,我们可以合理地推测spp应该改进更复杂(更深,更大)的卷积体系结构.spp-net还显示了caltech 101 [21]和pascal voc 2007 [22]上最先进的分类结果,只使用单一的全图像表示而不进行微调。

图2.特征图的可视化。(A)Pascal voc 2007中的两幅图像。(B)一些conv5滤波器的特征图。箭头表示最强烈的反应和它们在图像中的对应位置。(C)对应滤波器响应最强的ImageNet图像。绿色矩形标志着最强烈的反应的接受域。

SPP-NET在目标检测方面也显示出很大的优势。在主要的目标检测方法的r-CNN [7]中,通过深卷积网络提取候选窗口的特征。该方法在VOC和ImageNet数据集上均显示出显着的检测精度。但是在R-CNN中的特征计算是耗时的,因为它反复地将深卷积网络应用到每幅图像数千个扭曲区域的原始像素上。在本文中,我们证明了我们只能在整个图像上运行一次卷积层(不管窗口数),然后在特征映射上使用SPP-Net进行特征提取。这种方法比R-CNN的加速比提高了100倍以上。请注意,在特征图(而不是图像区域)上进行检测器的训练/运行实际上是一个比较流行的想法[5],[20],[23],[24]。但是SPP-Net继承了深度CNN特征映射的强大功能,同时也继承了spp在任意窗口大小上的灵活性,从而提高了精度和效率。在我们的实验中,基于SPP-Net的系统(基于R-CNN管道)计算了24 -102的特性。比R-CNN更快,而 有更好的或可比的准确性。随着最近的快速建议方法的边缘框[25],我们的系统需要0.5秒的图像处理(包括所有步骤)。这使得我们的方法在实际应用中很实用。

这份手稿的初稿已于2014年出版。在此基础上,我们参加了2014年ILSVRC [26]的比赛,并对其进行了排名。在目标检测和图像分类(两者都提供数据轨道)所在的38个团队。对ILSVRC 2014作了一些修改。我们表明,spp-net可以促进各种更深,更大的网络(3.1.2-3.1.4节)。此外,在我们的检测框架的驱动下,我们发现在具有灵活定位/大小窗口的特征映射上进行多视图测试(第3.1.5节)可以提高分类的准确性。这份手稿还提供了这些修改的细节。我们已经发布了该代码,以促进未来的研究(HTTP:/Research.microsoft.com/en-us/um/People/Kahe/)。

二,具有空间金字塔池的深层网络

2.1,卷积层和特征图

考虑流行的七层体系结构[3],[4]。前五个层是卷积层,其中一些是池化层。这些池化层也可以被视为“卷积”,因为它们使用的是滑动窗口。最后两层完全连接,输出为N·使用SoftMax,其中ñ是类别数。

图三。一种具有空间金字塔池层的网络结构。这里256是卷积5层的滤波器号,卷积5是最后的卷积层。

上面描述的深层网络需要一个固定的图像大小。然而,我们注意到,对固定大小的要求仅仅是由于全连接层,需要固定长度的向量作为输入。另一方面,卷积层接受任意大小的输入。卷积层采用滑动滤波器,其输出的纵横比与输入基本相同的这些输出被称为特征图[1] - 。它们不仅涉及响应的强度,而且涉及到它们的空间位置。

在图2中可视化了一些特征图。它们是由conv5层的一些滤波器产生的.Fig2(c)中显示了ImageNet数据集中这些过滤器的最强激活图像。我们看到一个滤波器可以被一些语义内容激活例如,第55滤波器(图)0.2,左下角)是最激活的圆形;第66滤波器(图)0.2,右上角)是由^ - 形状激活最多的;和118过滤器(图)0.2,右下角)是由一个。 - 形状激活最多输入图像中的这些形状(图)在相应位置(图中的箭头)激活特征映射0.2)

值得注意的是,我们在图中生成了特征图0.2不固定输入大小。这些由深层卷积层生成的特征映射类似于传统方法中的特征映射[27],[28]。在这些方法中,SIFT向量[29]或图像块[28]被密集提取,然后进行编码,例如矢量量化[15],[16],[30],稀疏编码[17],[18]或费舍尔核[19] 。这些编码的特征由特征图组成,然后由一袋袋单词[16]或空间金字塔[14],[15]汇集在一起。类似地,深卷积特征可以类似的方式集合起来。

2.2,空间金字塔池层

卷积层接受任意输入大小,但它们产生可变大小的输出。分类器(SVM /使用SoftMax)或全连接层需要固定长度的向量。这样的向量可以通过将特征集合在一起的一袋词方法[ 16]来生成。空间金字塔池[14],[15]改进了弓,因为它可以通过在局部空间桶中汇集来保持空间信息。这些空间垃圾箱的大小与图像大小成正比,因此无论图像大小如何,垃圾箱的数量都是固定的。这与以前深网络[3]的滑动窗口池形成了对比,其中滑动窗口的数目取决于输入的大小。

为了对任意大小的图像采用深度网络,我们将最后一个池化层(例如,在最后一个卷积层之后的池5)替换为一个空间金字塔池层.Fig3说明了我们的方法。在每个空间桶中,我们汇集每个滤波器的响应(在本文中我们使用最大池化)。空间金字塔池的输出是公里维向量,桶数表示为米(K是最后卷积层的滤波器数)。固定维向量是全连通层的输入..

使用空间金字塔池,输入图像可以是任意大小的。这不仅允许任意高宽比,而且还允许任意尺度。我们可以将输入图像调整到任意尺度(例如,min w; h = 180,224,。)并应用相同的深层网络。当输入图像处于不同的尺度时,网络(具有相同滤波尺寸)将在不同的尺度上提取特征。尺度在传统方法中起着重要的作用,例如,SIFT向量通常在多个尺度上被提取[27],[29](由斑块和高斯滤波器的大小决定)。我们将证明,刻度对深层网络的精度也很重要。

有趣的是,最粗糙的金字塔层只有一个垃圾箱覆盖整个图像。这实际上是一个“全局池化”操作,在几个并行工作中也进行了调查。在[31]中,[32]使用全局平均池来缩小模型大小并减少过度拟合;在[33]中,在所有FC层之后的测试阶段使用全局平均池来提高准确性;在[34]中,全局最大池用于弱监督的对象识别。全局池操作与传统的词袋法相对应..

2.3,训练网络

理论上,无论输入图像大小如何,标准反向传播[1]都可以训练出上述网络结构。但在实践中,GPU实现(如CUDA的ConvNet [3]和来自Caffe [35])最好在固定输入映像上运行。接下来,我们描述我们的训练解决方案,它利用这些GPU实现,同时仍然保留空间金字塔池行为。

2.3.1,单尺寸训练

以前的工作一样,我们首先考虑的是一个具有固定大小输入的网络(224x224)由图像裁剪而成。裁剪是为了增强数据。对于给定大小的图像,我们可以预先计算空间金字塔池所需的桶大小。考虑具有一个大小为一的conv5之后的功能映射.A(例如,1313)金字塔水平为nnbins,我们将这个池级别实现为一个滑动窗口池,其中窗口大小赢了四分之一,跨距为STR,BA = NC,其中D和BC表示天花板和地板操作。使用升层金字塔,

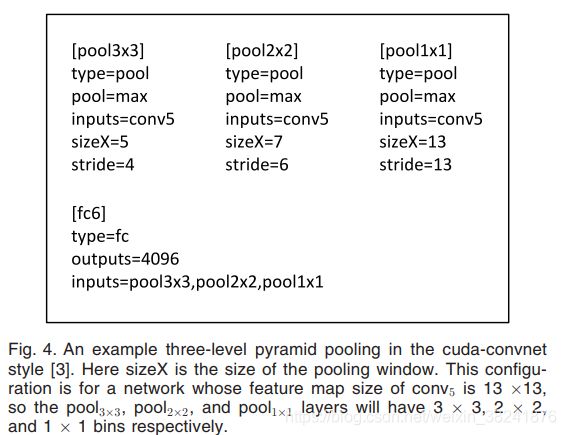

图四。一个例子,三层金字塔池的cudu-ConvNet风格[3]。这里的大小是池窗口的大小。此配置用于特征映射大小为13的网络0.13,所以池33,池22,和池11层将有3层3,22和11pool。

我们实现了升层。下一个完全连接的层(FC6)将连接升输出。无花果0.4显示了三层金字塔池的示例配置(3).3,22,11)采用CUDA的ConvNet风格[3] 。

我们的单一规模训练的主要目的是使多层次的池行为。实验表明,这是提高精度的原因之一。

2.3.2,多尺度训练

我们的网络与spp预期将应用于任何大小的图像为了解决训练中图像大小变化的问题,我们考虑了一组预定义的尺寸,我们考虑两种尺寸:180x180和224x224,而不是修剪一个更小的180x180区域,我们调整了上述224x224的大小至180x180。因此,这两个尺度上的区域仅在分辨率上不同,而在内容/布局上没有差别。网络接受180x180输入,我们实现另一个固定大小的输入(180x180)网络。conv5之后的特征映射大小是a / 1/4 1010在这种情况下。然后,我们仍然使用win = [a / n],和str = [a / n]来实现每个金字塔池级别。这个180网络的空间金字塔池层的输出与224网络具有相同的固定长度。因此,这个180网络与每个层中的224网络具有完全相同的参数。换句话说,在训练期间,我们通过两个共享参数的固定大小网络来实现可变输入大小SPP-Net。

为了减少从一个网络(例如224)切换到另一个网络(例如,180)的开销,我们在一个网络上训练整个过程,然后切换到另一个网络(保持所有的权重),以便下一个完整的过程。这是迭代的。在实验中,我们发现这种多尺度训练的收敛速度与上述单尺度训练相似。

我们的多尺寸训练的主要目的是模拟不同的输入大小,同时仍然利用现有的优化的固定大小实现。除了上述两级实现之外,我们还测试了一个使用的SxS的变体的.s作为输入,其中小号在每个时期随机和均匀地从[180-224]中取样。我们在实验部分报告了这两种变体的结果。

请注意,以上单/多尺寸解决方案仅用于训练。在测试阶段,在任何大小的图像上应用SPP-Net是很简单的。

三,用于图像分类的SPP-Net

3.1,ImageNet 2012分类实验

我们在1000个类别的ImageNet 2012年训练集上对网络进行训练。我们的训练算法遵循了以前的工作[3],[4],[36]。这些图像被调整大小,使较小的维数为256和224x224。224裁剪大小是从中间或整个图像的四个角落中挑选出来的。在两个全连接层上使用下采样3]。学习速率从0.01开始,当误差稳定时,再除以10(2)。我们的实现基于cudaconvnet [3]和caffe [35]的公开代码。本文中的所有网络都可以在2到4周内在一个单独的GeForce GTX泰坦GPU(6GB内存)上进行训练。

3.1.1基线网络体系结构

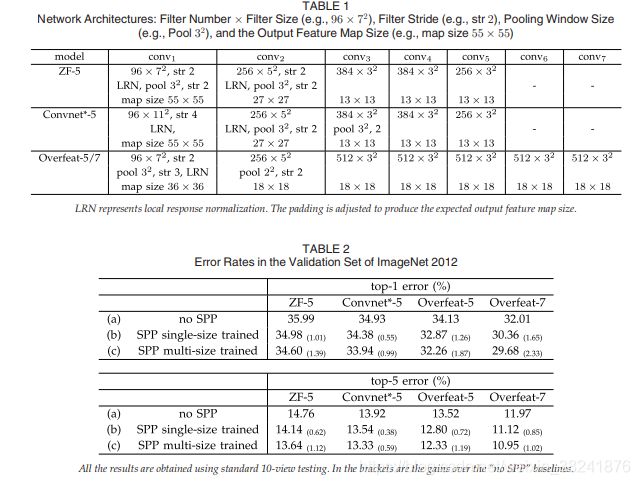

SPP的优点与所使用的卷积网络结构无关。我们研究了现有出版物[3],[4],[5](或它们的修改)中的四种不同的网络体系结构,并表明属提高了所有这些体系结构的准确性这些基线结构载于表1中,并简要介绍如下:

ZF-5这种架构是基于泽勒和费格斯(ZF)的“快速”(较小)模型[4]。这个数字表示五个卷积层.ConvNet * -5。这是对Krizhevsky等人的网络[3]的修改。我们将两个池层放在卷积2和卷积3之后(而不是在卷积1和卷积2之后)。因此,每一层之后的特征映射具有与ZF -5相同的大小。超常-5/7。这个体系结构是基于[5]的过功伟绩的,并作了一些修改,如[6]。与ZF-5 / convnet * -5相比,该体系结构产生了更大的特征映射(18)0.18而不是1313)在最后一个池层之前。在卷积3和以下卷积层中使用更大的滤波器数(512)。我们还研究了一个具有七个卷积层的更深层次的体系结构,其中卷积3到卷积7具有相同的结构。

在基线模型中,最后一个卷积层之后的池层生成6x6功能地图,与两个4096-d FC层和1000路软最大层以下。我们对这些基线网络的复制情况见表2a。我们训练了70个ZF-5时代和90个ZF-5时代。我们的ZF-5复制比[4]中报道的要好。这一增加是因为角作物是从整个图像,也是在[36]报道。

3.1.2,多级池提高了准确性。

在表2B中,我们显示了使用单尺寸训练的结果。训练和测试的规模都是224x224。在这些网络中,卷积层具有与相应的基线模型相同的结构,而最终卷积层之后的池化层被属层所取代。对于表2中的结果,我们使用四层金字塔..

金字塔是{6x6,3x3,2x2,1x1}(共50桶)。为了进行公平的比较,我们仍然使用标准的10视图预测,每个视图a 224.224作物。我们在表2b中的结果显示,与表2a中中的非属基线相比,我们的结果有了很大的改善。有趣的是,顶级错误的最大增益(1.65%)是由最精确的架构提供的。由于我们仍然使用与(A )中相同的10个裁剪视图,这些收益完全是由于多层池化。

值得注意的是,多级池的增益并不仅仅是由于更多的参数,而是因为多级池对象变形和空间布局的变化具有鲁棒性[15]。为了证明这一点,我们训练了另一个具有不同4层金字塔的ZF-5网络:{4x4,3x3,2x2,1x1}(共30个桶)由于FC6层有30层,因此该网络的参数比非属层少.30x256-d输入而不是36x256-d。该网络的前1/5错误为35.06 / 14.04。这一结果与上面的50桶金字塔相似(34.98 / 14.14),但明显优于NO-SPP金字塔(35.99 / 14.76)。

3.1.3,多尺寸训练提高准确度

表2c中显示了我们使用多尺寸训练的结果。训练规模分别为224和180,而测试规模仍为224我们仍然使用标准的10视图预测。所有架构的前1/5错误进一步下降.spp-net(overfeat-7)的前1位误差降至29.68%,比非属型差2.33%,比单尺寸训练型差0.68%。

除了使用180和224这两个离散尺寸外,我们还使用从[180; 224]中均匀抽样的随机大小进行了评估.SPP-Net(超支-7)的前1/5误差为30.06 / 10.96% 。顶部1的错误比两个大小的版本稍差,可能是因为访问224(用于测试)的次数较少。但结果仍然是更好的单一尺寸的版本。

有以前的CNN解决方案[5],[36],涉及不同的规模/规模,但它们主要是基于测试。在[5]和霍华德的方法[36]中,单网络在测试阶段被应用于多个尺度,并将分数平均。霍华德还在低/高分辨率图像区域上训练了两个不同的网络,平均分数。据我们所知,我们的方法是第一个用多个大小的输入图像训练单个网络的方法。

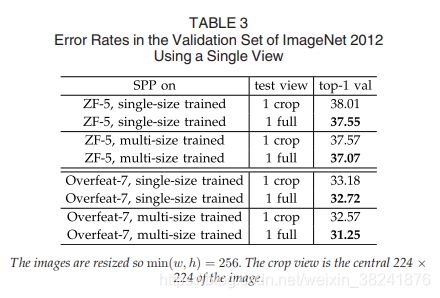

3.1.4,全图像表示提高精度

接下来,我们研究了全图像视图的准确性。我们调整图像的大小,使![]() ,同时保持其高宽比。SPP-Net被应用于这个完整的图像上,以计算整个视图的分数。为了进行公平的比较,我们还评估了中心224x224中单一视图的准确性0.224crop(用于上述评价)。单视点测试精度的比较见表3.在这里,我们评估ZF-5 /超额壮举-7顶部。 1的错误率都是通过全视图表示来降低的。这说明了保持完整内容的重要性,尽管我们的网络仅使用方形图像进行训练,但它与其他长宽比具有很好的通用性。

,同时保持其高宽比。SPP-Net被应用于这个完整的图像上,以计算整个视图的分数。为了进行公平的比较,我们还评估了中心224x224中单一视图的准确性0.224crop(用于上述评价)。单视点测试精度的比较见表3.在这里,我们评估ZF-5 /超额壮举-7顶部。 1的错误率都是通过全视图表示来降低的。这说明了保持完整内容的重要性,尽管我们的网络仅使用方形图像进行训练,但它与其他长宽比具有很好的通用性。

比较表2和表3中,我们发现多个视图的组合比单一的饱满视图要好得多。然而,完整的图像表示仍然有很好的优点。首先,我们经验性地发现(在下一节中讨论) ,即使是几十个视图的组合,附加的两个全图像视图(带有翻转)仍然可以提高大约0.2%的准确性。第二,全图像视图在方法上与传统方法[15],[17 ],[19]一致,其中整个图像的编码SIFT向量集合在一起。第三,在其他应用,如图像检索[37],图像表示,而不是分类评分,是需要的相似性排序。可以首选全图像表示。

3.1.5,基于特征图的多视图测试

在我们的检测算法的启发下(在下一节中描述),我们进一步提出了一种基于特征映射的多视图测试方法。由于属的灵活性,我们可以方便地从卷积特征映射中从任意大小的窗口(视图)中提取特征。

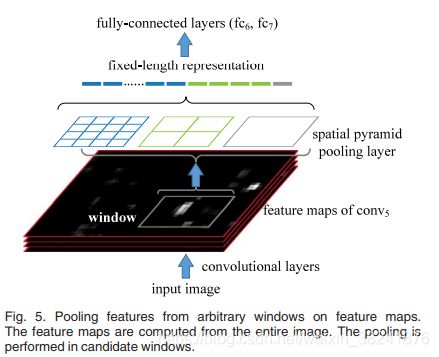

在测试阶段,调整我们图像为![]() 的大小,其中小号表示预定义的标度(如256)。然后从整个图像中计算卷积特征映射。对于翻转视图的使用,我们还计算翻转图像的特征映射。给定图像中的任何视图(窗口),我们将此窗口映射到特征映射(映射方式在附录中),然后使用spp从该窗口汇集功能(请参见图5)然后将集合的功能输入FC层,以计算此窗口的使用SoftMax得分。这些分数是最后预测的平均值。对于标准的10视图,我们使用S = 256,视图为224x224。在角落或中央有224扇窗户。实验表明,基于特征映射的10视图预测的前5位误差在原图像作物10视图预测的0.1%以内。

的大小,其中小号表示预定义的标度(如256)。然后从整个图像中计算卷积特征映射。对于翻转视图的使用,我们还计算翻转图像的特征映射。给定图像中的任何视图(窗口),我们将此窗口映射到特征映射(映射方式在附录中),然后使用spp从该窗口汇集功能(请参见图5)然后将集合的功能输入FC层,以计算此窗口的使用SoftMax得分。这些分数是最后预测的平均值。对于标准的10视图,我们使用S = 256,视图为224x224。在角落或中央有224扇窗户。实验表明,基于特征映射的10视图预测的前5位误差在原图像作物10视图预测的0.1%以内。

我们进一步应用该方法从多尺度上提取多个视图。我们将图像调整为6个尺度:![]() ,并计算每个比例尺在整个图像上的特征图。我们使用224x224作为任何尺度的视图大小,因此这些视图对于不同尺度的原始图像有不同的相对大小。我们对每个比例尺使用18次视图:中间一次,拐角处四次,两边中间四次,有/没有翻转(当s 224有六种不同的视图时)。这96个视图的组合将前5位错误从10.95%减少到9.36%。结合两个全图像视图(与翻转)进一步将前5位的错误降低到9.14%。

,并计算每个比例尺在整个图像上的特征图。我们使用224x224作为任何尺度的视图大小,因此这些视图对于不同尺度的原始图像有不同的相对大小。我们对每个比例尺使用18次视图:中间一次,拐角处四次,两边中间四次,有/没有翻转(当s 224有六种不同的视图时)。这96个视图的组合将前5位错误从10.95%减少到9.36%。结合两个全图像视图(与翻转)进一步将前5位的错误降低到9.14%。

在本文[5]中,视图也是从卷积特征图中提取出来的,而不是从图像crop中提取出来的但是,它们的视图不能具有任意大小。相反,窗口是集合功能与所需维度匹配的窗口。根据经验,我们发现这些受限窗口不如我们灵活定位/大小的窗口更有益。

3.1.6,2014年ILSVRC总结和结果

在表4中,我们比较了以前最先进的方法.Krizhevsky等人的[3]是ILSVRC 2012年的获胜方法; Overfeat [5],Howard的[36]和Zeiler和Ferguss [4]是ILSVRC 2013年的领先方法。我们只考虑单个网络的性能,以便进行可管理的比较。我们最好的单一网络在验证集上达到9.14%的前5位错误。这正是我们提交给ILSVRC 2014 [26]的单模式条目。测试集的前5位错误为9.08%(经过11种模型的组合,我们队的成绩(8.06%)被排在了第一位。

3.2,VOC 2007分类实验

该方法可以生成全景式图像表示。利用在ImageNet上进行预训练的上述网络,我们从目标数据集中的图像中提取这些表示,并重新训练SVM分类器[38]。在SVM训练中,我们故意不使用任何数据增强(翻转/多视图)。我们L2-规范SVM训练的特点。

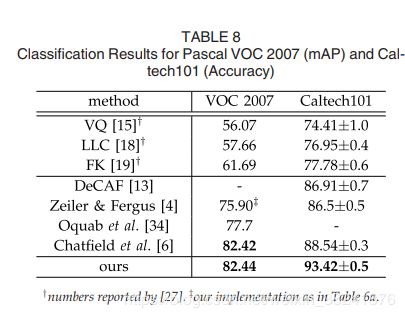

Pascal voc 2007 [22]中的分类任务涉及20个类别的9963幅图像.5011幅图像用于培训,其余图像用于测试。用平均精度(MAP)来评价系统的性能。表6汇总了结果。

所有的结果都是基于一个单一的网络。在过度壮举中,观看的数量取决于规模和步幅,在最好的尺度上有几百个。

我们从表6A中的基线开始。模型为ZF-5,没有属为了应用该模型,我们调整了图像的大小,使其更小的维数为224,并裁剪中心224x224区.svm是通过一个层的特征来训练的。在此数据集上,层越深,结果越好。在表6B中,我们用SPP-净代替无属网。作为第一步的比较,我们仍然在中心224x224上应用SPP-net.Fc层的结果有所改善。这一增益主要是由于多级池化。

表6c中显示了我们在完整图像上的结果,其中图像被调整大小,使较短的一面为224.我们发现结果有了很大的改善(78.39%对76.45%)。这是由于维护完整内容的完整图像表示所致。

由于网络的使用不依赖于规模,因此我们调整图像的大小,使较小的维数为S,并使用相同的网络提取特征。我们发现S = 392给出了基于验证集的最佳结果(表6d)。这主要是因为对象在voc 2007中占据较小的区域,而在ImageNet中占据较大的区域,因此两个集合之间的相对对象尺度是不同的。这些结果表明了分类任务中的尺度问题,而SPP-Net可以部分地解决这个“尺度不匹配”问题。

在表6E中,网络体系结构被我们最好的模型所取代(超值-7,多尺寸训练),地图增加到82.44%。表8总结了我们的结果,并与最先进的方法进行了比较。在这些方法中,VQ [15],LCC [18]和FK [19]都是基于空间金字塔匹配的,[4],[6],[13],[34]是基于深网络的。在这些结果中,Oquab等人(77.7%)和查特菲尔德等人(82.42%)是通过网络微调和多视角测试得到的。我们的结果可以与最先进的技术相媲美,只使用单一的全图像表示,而且不进行微调。

3.3,caltech 101实验

caltech 101数据集[21]包含102个类别(一个背景)的9144幅图像。我们随机抽取每个类别30张图像进行训练,每类多达50张图像进行测试。我们重复10次随机分裂,平均精度。表7总结了我们的结果。

在Pascal voc 2007和caltech 101中有一些共同的观察结果:SPP-net优于nospp-net(表7b和表7a),并且全景式表示优于作物(表7c和表7b)。但是caltech 101的结果与PASCAL voc有一定的差异。全连通层精度较低,spp层较好。这可能是因为caltech 101中的对象类别与ImageNet中的对象类别关联较少,而更深层次的对象类别则更专门此外,我们发现在我们在这个数据集上测试的量表中,Scale 224具有最好的性能。这主要是因为caltech 101中的对象也占据了图像的大区域,就像ImageNet的情况一样。

除了裁剪,我们还评估扭曲图像以适应224x224码该解决方案维护了完整的内容,但引入了失真。在SPP(ZF-5)模型上,以SPP层为特征,准确率为89.91%,低于91.44%,即在未失真的全图像上使用相同的模型。表8总结了我们的研究结果,并与现有的caltech 101方法进行了比较。我们的结果(93.42%)比以前的记录(88.54) %)有很大的差距(4.88%)。

四,用于目标检测的SPP-Net

深层网络已经被用于目标检测。我们简要回顾了最近最先进的R-CNN方法,[7] R-CNN首先通过选择性搜索(SS)[20]从每幅图像中提取约2000个候选窗口。然后,每个窗口中的图像区域被扭曲到固定大小(227x227)。利用预先训练好的深层网络来提取每个窗口的特征。然后对SVM分类器进行这些特征的训练以进行检测.r- CNN产生的结果令人信服的质量,并大大优于以往的方法。然而,由于R-CNN多次将深层卷积网络应用于每幅图像约2000个窗口,这是很费时的。特征提取是测试中的主要时间瓶颈。

我们的SPP-Net也可以用于对象检测。我们只从整个图像中提取一次特征映射(可能是多尺度的)。然后,我们在特征映射的每个候选窗口上应用空间金字塔池来汇集该窗口的固定长度表示(参见图5)由于卷积消耗的时间只有一次,我们的方法可以运行数量级。

我们的方法从特征映射的区域中提取窗口特征,而R-CNN则直接从图像区域提取。在以往的工作中,变形零件模型(DPM)[23]在HOG [24]特征映射中从窗口中提取特征,而选择性搜索方法[20]在编码SIFT特征映射中从窗口中提取特征。[5]该方法还从深卷积特征图的窗口中提取,但需要预先定义窗口的大小。相反,我们的方法可以从深卷积特征映射中提取任意窗口的特征。

4.1,检测算法

我们使用“快速”模式的选择性搜索[20],以产生约2000个候选窗口每幅图像。然后,我们调整图像的大小,例如![]() ,并从整个图像中提取特征映射。我们目前使用的是ZF -5(单尺寸训练)的SPP-Net模型。在每个候选窗口中,我们使用一个四层空间金字塔(1x1,2x2,3x3,6x6)共50个垃圾桶汇集功能。这将生成12800-d (256x50)每个窗口的表示。这些表示被提供给网络的全连接层。然后,针对这些特征,对每个类别进行二值线性SVM分类器的训练。

,并从整个图像中提取特征映射。我们目前使用的是ZF -5(单尺寸训练)的SPP-Net模型。在每个候选窗口中,我们使用一个四层空间金字塔(1x1,2x2,3x3,6x6)共50个垃圾桶汇集功能。这将生成12800-d (256x50)每个窗口的表示。这些表示被提供给网络的全连接层。然后,针对这些特征,对每个类别进行二值线性SVM分类器的训练。

我们在[7]、[20]之后实施了svm训练。我们使用地面真相窗口生成正样本。负样本是那些重叠一个正窗口最多30%的样本(用交叉结合(IOU)比率来衡量)。如果任何负样本与另一个负样本重叠超过70%,则该负样品将被移除。我们使用标准的硬负挖掘[23]来训练svm。此步骤迭代一次。训练所有20个类别的Svms所需的时间不到1小时。在测试中,使用分类器对候选窗口进行评分。然后我们在得分窗口上使用非最大抑制[23](阈值为30%)。

通过多尺度特征提取,可以对该方法进行改进。我们重新调整图像的大小,使之最小为![]() ,并计算出每个比例尺的特征图5。将这些尺度的特征结合起来的一种策略是逐道汇集它们.但我们从经验上发现,另一种策略提供了更好的结果。对于每个候选窗口,我们选择一个单标度s 2,使缩放的候选窗口具有一些最接近224x224.像素的像素。然后,我们只使用从这个比例提取的特征映射来计算这个窗口的特征。如果预定义的尺度足够密集且窗口近似平方,则我们的方法大致相当于将窗口调整为224x224然后从它中提取特征。尽管如此,我们的方法只需要从整个图像中计算一次(每个比例)的特征映射,而不管候选窗口的数量。

,并计算出每个比例尺的特征图5。将这些尺度的特征结合起来的一种策略是逐道汇集它们.但我们从经验上发现,另一种策略提供了更好的结果。对于每个候选窗口,我们选择一个单标度s 2,使缩放的候选窗口具有一些最接近224x224.像素的像素。然后,我们只使用从这个比例提取的特征映射来计算这个窗口的特征。如果预定义的尺度足够密集且窗口近似平方,则我们的方法大致相当于将窗口调整为224x224然后从它中提取特征。尽管如此,我们的方法只需要从整个图像中计算一次(每个比例)的特征映射,而不管候选窗口的数量。

我们也微调我们的预先训练的网络,如下[7]。由于我们的功能是从任意大小的窗口中的conv5功能映射集合而成的,为了简单起见,我们只对全连接层进行微调。在这种情况下,数据层在conv5之后接受固定长度的集合特性,而ffc6;7层和新的21路(额外的负类别)fc8层紧随其后。对fc8权值进行初始化,其高斯分布为![]() =0.0 1。我们将所有的学习速度修正为1e-4,然后调整到所有三个层次的1e-5。在微调过程中,正样本与地面真相窗口重叠为[0.5,1],负样本为[0.1,0,5)。在每一小批中,25%的样本为正。.我们用学习率1e-4训练250 k小批次,然后用1e-5训练50k小批次.因为我们只对FC层进行微调,所以训练速度非常快,在GPU上大约需要2个小时(不包括预缓存功能地图,大约需要1小时)。在[7]之后,我们使用包围盒回归对预测窗口进行后处理.用于回归的特性是从conv5(作为[7]中使用的池5特性的对应项)的集合特性。用于回归训练的窗口是那些与地面真相窗口重叠至少50%的窗口。

=0.0 1。我们将所有的学习速度修正为1e-4,然后调整到所有三个层次的1e-5。在微调过程中,正样本与地面真相窗口重叠为[0.5,1],负样本为[0.1,0,5)。在每一小批中,25%的样本为正。.我们用学习率1e-4训练250 k小批次,然后用1e-5训练50k小批次.因为我们只对FC层进行微调,所以训练速度非常快,在GPU上大约需要2个小时(不包括预缓存功能地图,大约需要1小时)。在[7]之后,我们使用包围盒回归对预测窗口进行后处理.用于回归的特性是从conv5(作为[7]中使用的池5特性的对应项)的集合特性。用于回归训练的窗口是那些与地面真相窗口重叠至少50%的窗口。

4.2、检测结果

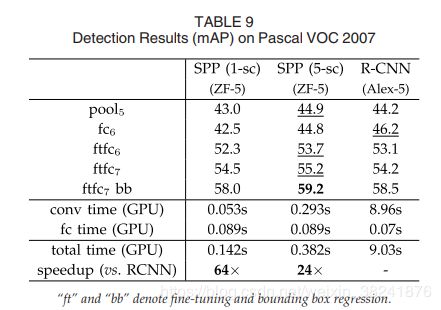

我们对PASCALVEC 2007数据集的检测任务进行了评估。表9用单尺度(S 688)或五标度显示了我们在不同层次上的结果.在这里,rcnn的结果是在[7]中报告的使用alexnet[3]与五个Conv层。使用池5层(在我们的例子中是集合特性),我们的结果(44.9%)与R-CNN的结果(44.2%)相当。但是,使用非精细的fc6层,我们的结果是差的。一种解释是,我们的FC层使用图像区域进行预训练,而在检测情况下,它们被用于特征映射区域。特征映射区域可以在窗口边界附近有很强的激活,而图像区域可能没有。这种用法上的差异可以通过细化来解决。使用精细调谐的FC层(ftfc 6;7),我们的结果可与r-cnn的微调结果相比或略好一些。经过包围盒回归,我们的五年期结果(59.2%)比r-cnn(58.5%)好0.7%,而我们的单尺度结果(58.0%)比r-cnn(58.0%)差0.5%。

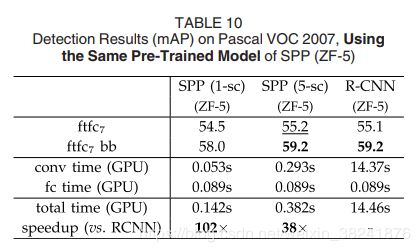

在表10中,我们进一步比较了使用相同的预先训练的spp-net(ZF-5)模型的r-cnn。在这种情况下,我们的方法和r-cnn有可比的平均分数.r-cnn的结果是由这个预先训练的模型。这是因为ZF-5的体系结构比alexnet更好,也是因为spp-net的多层池(如果使用no spp zf-5,r-cnn的结果会下降)。表11显示了每个类别的结果。表11还包括其他方法。选择性搜索[20]将空间金字塔匹配应用于SIFT特征映射。DPM[23]和Regilet[39]是基于HOG特征[24]。区域化方法通过结合包括凸5在内的各种特征,提高到46.1%[8]。探测器网[40]训练一个深网络,输出像素级的对象掩码。这种方法只需要对整个图像应用一次深层网络,就像我们的方法一样。但该方法具有较低的MAP(30.5%)。

4.3、复杂性和运行时间

管具有相当的精度,我们的方法比r-cnn快得多.在r-CNN中,卷积特征计算的复杂度为![]() ,窗数为n(~2000)。我们的方法的复杂性是

,窗数为n(~2000)。我们的方法的复杂性是![]() ,在一个标度s,其中r是高宽比。假设r约为4/3。在单尺度版本中,当s 688时,这一复杂性约为r-cnn的1/160;在五尺度版本中,这一复杂性约为r-cnn的1/24。

,在一个标度s,其中r是高宽比。假设r约为4/3。在单尺度版本中,当s 688时,这一复杂性约为r-cnn的1/160;在五尺度版本中,这一复杂性约为r-cnn的1/24。

在表10中,我们提供了使用相同spp(ZF-5)模型的特征计算运行时间的比较。R-CNN的实现来源于作者在CAFE[35]中发布的代码。我们还在CAFIE中实现了我们的特征计算。在表10中,我们使用GPU评估了100幅随机VOC图像的平均时间。r-cnn每幅图像的卷积率为14.37s,而我们的单比例尺版本每幅图像只需0.053 s。所以我们的是270比r-cnn还快。我们的五比例尺版本每幅图像的卷积值为0.293 s,49也是如此。比r-cnn还快。我们的卷积特征计算如此之快,使得FC层的计算时间占据了相当大的一部分。表10显示,计算4,096-d fc7特征的GPU时间为每幅图像0.089 s。考虑到卷积和全连接功能,我们的单尺度版本是102。速度比r-cnn快,比rcnn低1.2%;我们的5种版本是38。速度更快,并有类似的结果。

我们还比较了表9中的运行时间,其中rcnn使用alexnet[3],如原始论文[7]所示。我们的方法是24至64更快。请注意,alexnet[3]在每个Conv层上有与我们的ZF-5相同数量的过滤器。alexnet更快,因为它在某些层上使用拆分,这是为[3]中的两个GPU设计的。

我们进一步利用最近的窗口建议方法[25]实现了一个高效的完整系统。选择性搜索方案[20]在CPU上每图像大约需要1-2秒。边框法[25]只需0.2秒。请注意,仅在测试期间使用快速建议方法就足够了。使用上述相同的模型(使用ss),我们只测试边框生成的提案。地图为52.8,没有边界框回归。考虑到边框不用于培训,这是合理的。然后在训练阶段采用ss和Edgebox作为建议,在测试阶段只采用边缘盒。该地图为56.3,没有边界框回归,这是好于55.2(表10),因为额外的培训样本。在这种情况下,整个测试时间为0.5s每幅图像包括所有步骤(建议和识别)。这使得我们的方法在实际应用中很实用。Fig6展示了我们结果的一些直观例子。

4.4模型组合检测

模型组合是提高CNN分类精度的重要策略[3]。提出了一种简单的组合检测方法。我们在ImageNet中预先训练另一个网络,使用相同的结构,但使用不同的随机初始化.然后重复上述检测算法。表12(spp-net(2)显示了该网络的结果。它的地图与第一个网络相当(59.1%对59.2%),在11个类别上优于第一个网络。考虑到这两个模型,我们首先使用任一模型对测试图像上的所有候选窗口进行评分。然后,我们对两组候选窗口的合并(以及它们的分数)执行非最大抑制。一种方法给出的更加自信的窗口可以抑制由另一种方法给出的不那么自信的窗口。合并后,地图被提升到60.9%(表12)。在所有20个类别中的17个类别中,这种组合比任何一个单独的模式都表现得更好。这表明这两个模型是互补的。我们进一步发现,互补性主要是由于卷积层。我们尝试将同一卷积模型的两个随机初始化的精细调谐结果结合起来,但没有发现增益。

4.5 2014年ILSVRC检测

ILSVRC 2014年检测[26]任务涉及200个类别。培训/验证/测试集中有450 k/20k/40k图像。我们主要关注提供的数据跟踪的任务(不允许使用1000个类别的CLS培训数据)。

检测(DET)和分类(CLS)训练数据集存在三大差异,对训练前的质量有很大的影响。首先,DET训练数据仅仅是CLS训练数据的1/3。这似乎是只提供数据的DET任务的基本挑战。第二,DET的分类数是CLS的1/5。为了克服这个问题,我们利用提供的子类别标签2进行预训练。共有499个不重叠的子类别(即提供的类别层次结构中的叶节点)。所以我们在Det训练集上预先训练了一个499类的网络。第三,目标尺度在Det/CLS训练集之间的分布是不同的。在CLS中,主要对象尺度约为图像长度的0.8,而在DET中,主要对象尺度约为0.5。为了解决比例尺的差异,我们将每个训练图像的大小调整为min w;h值为1/4 400(而不是256),并随机裁剪224。224关于培训的意见。只有当作物与地面真相物体重叠至少50%时,才能使用。

我们验证了预训练对Pascal voc 2007的影响。对于CLS-训练前基线,我们考虑了池5的特性(如表9所示,地图占43.0%)。取而代之的是200种类别的网络,在DET上进行预培训,地图明显下降到32.7%.一个499个类别的预培训网络将结果提高到35.9%.有趣的是,即使训练数据量没有增加,训练更多类别的网络也会提高特征质量。最后,使用minw;h训练1/4,400而不是256,使地图进一步提高到37.8%。即使如此,我们也看到,与训练前的成绩相比,还有相当大的差距.这表明大数据对深度学习的重要性。

Fig6.Pascal voc 2007测试集上的“spp-netftfc7bb”示例检测结果(59.2%map)。所有分数>0的窗口都会显示出来。预测的类别/分数被标记。窗口颜色与预测类别相关联。这些图像是手动选择的,因为我们觉得它们令人印象深刻。请访问我们的项目网站,查看测试集中的所有4,952个检测结果。

对于2014年ILSVRC,我们训练了一个499级的超视距-7 spp-net。其余步骤类似于voc 2007的情况。在[7]之后,我们使用验证集生成正/负样本,并使用选择性搜索快速模式提出的窗口。训练集只提供使用地面真相窗口的正样本。我们对FC层进行细化,然后使用验证和训练集中的样本来训练svm。边界框回归是在验证集上训练的。

我们的单一模型在ILSVRC 2014测试集中得到31.84%的地图[26]。利用本文提出的策略,我们结合了六个相似的模型。在测试集[26]中,地图为35.11%。

对于这种数据集,我们的系统在速度上仍然有很大的优势。这需要我们的单一模式0.6秒(0.5为conv,0.1为FC,不包括提案)在GPU上提取所有五个尺度的卷积特征的测试图像。使用相同的模型,以rcnn的方式,每幅图像需要32秒。对于40k的测试图像,我们的方法需要8 gpuh来计算卷积特征,而rcnn则需要15 gpud。

五、结论

SPP-Net是一种灵活的解决方案,用于处理不同的规模、大小和高宽比。这些问题在视觉识别中是很重要的,但在深层网络环境下却很少得到考虑。我们提出了一种解决方案,以训练具有空间金字塔池层的深层网络。所得的spp-net在分类/检测任务中表现出突出的准确性,大大加快了基于DNN的检测。我们的研究还表明,计算机视觉中许多经过时间验证的技术/洞察力仍然在基于深度网络的识别中发挥着重要作用。

附录a

在附录中,我们描述了一些可能影响准确度的技术细节。将窗口映射为功能映射。在特征图的检测算法(以及对特征图的多视图测试)中,在图像域中给出了一个窗口,但是我们使用它来裁剪已被多次重采样的卷积特征图(例如卷积5)。所以我们需要对齐功能地图上的窗口。在我们的实现中,我们将窗口的角点投影到特征映射中的像素上,这样这个角点(在图像域中)最接近于该像素的接收字段的中心。这个投影取决于网络架构。对于zf-5网络,凸5中的像素对应于139。在图像域中的139个像素接受域,图像域中的凸5的有效步长为16。将x和xconv 5表示为图像域中的坐标和卷积5(我们使用MATLAB惯例,即x从1开始)。我们将左上角的投影值为:xconc 5,b x 139=2,63=16c1。这里139/2是接收场的半径,16是有效步长,63是偏移量。偏移量由图像域中接收字段的左上角计算。类似地,我们将右下角的投影为:xconc 5 d x 139=2 75 x=16e1。这里75是由接收字段右下角计算的偏移量.其他网络体系结构的映射也可以类似的方式导出。

ACKNOWLEDGMENTS

This work was done when X. Zhang and S. Ren were interns at Microsoft Research. Kaiming He is the corresponding author. REFERENCES [1] Y. LeCun, B. Boser, J. S. Denker, D. Henderson, R. E. Howard, W. Hubbard, and L. D. Jackel, “Backpropagation applied to handwritten zip code recognition,” Neural Comput., vol. 1, no. 4, pp. 541–551, 1989. [2] J. Deng, W. Dong, R. Socher, L.-J. Li, K. Li, and L. Fei-Fei, “Imagenet: A large-scale hierarchical image database,” in Proc. Proc. IEEE Conf. Comput. Vis. Pattern Recognit., 2009, pp. 248–255. [3] A. Krizhevsky, I. Sutskever, and G. Hinton, “Imagenet classification with deep convolutional neural networks,” in Proc. Adv. Neural Inf. Process. Syst., 2012, pp. 1106–1114. [4] M. D. Zeiler and R. Fergus, “Visualizing and understanding convolutional neural networks,” arXiv:1311.2901, 2013. [5] P. Sermanet, D. Eigen, X. Zhang, M. Mathieu, R. Fergus, and Y. LeCun, “Overfeat: Integrated recognition, localization and detection using convolutional networks,” arXiv:1312.6229, 2013. [6] A. V. K. Chatfield, K. Simonyan, and A. Zisserman, “Return of the devil in the details: Delving deep into convolutional nets,” in ArXiv:1405.3531, 2014. [7] R. Girshick, J. Donahue, T. Darrell, and J. Malik, “Rich feature hierarchies for accurate object detection and semantic segmentation,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit., 2014, pp. 580–587. [8] W. Y. Zou, X. Wang, M. Sun, and Y. Lin, “Generic object detection with dense neural patterns and regionlets,” in ArXiv:1404.4316, 2014. [9] A. S. Razavian, H. Azizpour, J. Sullivan, and S. Carlsson, “CNN features off-the-shelf: An astounding baseline for recognition,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit. DeepVision Workshop, 2014, pp. 806–813.[10] Y. Taigman, M. Yang, M. Ranzato, and L. Wolf, “Deepface: Closing the gap to human-level performance in face verification,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit., 2014, pp. 1701–1708. [11] N. Zhang, M. Paluri, M. Ranzato, T. Darrell, and L. Bourdevr, “Panda: Pose aligned networks for deep attribute modeling,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit., 2014, pp. 1637–1644. [12] Y. Gong, L. Wang, R. Guo, and S. Lazebnik, “Multi-scale orderless pooling of deep convolutional activation features,” in arXiv:1403.1840, 2014. [13] J. Donahue, Y. Jia, O. Vinyals, J. Hoffman, N. Zhang, E. Tzeng, and T. Darrell, “Decaf: A deep convolutional activation feature for generic visual recognition,” arXiv:1310.1531, 2013. [14] K. Grauman and T. Darrell, “The pyramid match kernel: Discriminative classification with sets of image features,” in Proc. 10th IEEE Int. Conf. Comput. Vis., 2005, pp. 1458–1465. [15] S. Lazebnik, C. Schmid, and J. Ponce, “Beyond bags of features: Spatial pyramid matching for recognizing natural scene categories,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit., 2006, pp. 2169–2178. [16] J. Sivic and A. Zisserman, “Video google: A text retrieval approach to object matching in videos,” in Proc. 9th IEEE Int. Conf. Comput. Vis., 2003, p. 1470. [17] J. Yang, K. Yu, Y. Gong, and T. Huang, “Linear spatial pyramid matching using sparse coding for image classification,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit., 2009, pp. 1794–1801. [18] J. Wang, J. Yang, K. Yu, F. Lv, T. Huang, and Y. Gong, “Localityconstrained linear coding for image classification,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit., 2010, p. 3306. [19] F. Perronnin, J. Sanchez, and T. Mensink, “Improving the Fisher kernel for large-scale image classification,” in Proc. 11th Eur. Conf. Comput. Vis., 2010, pp. 143–156. [20] K. E. van de Sande, J. R. Uijlings, T. Gevers, and A. W. Smeulders, “Segmentation as selective search for object recognition,” in Proc. 9th IEEE Int. Conf. Comput. Vis., 2011, pp. 1879–1886. [21] L. Fei-Fei, R. Fergus, and P. Perona, “Learning generative visual models from few training examples: An incremental Bayesian approach tested on 101 object categories,” Comput. Vis. Image Understanding, vol. 106, no. 1, pp. 59–70, 2007. [22] M. Everingham, L. Van Gool, C. K. I. Williams, J. Winn, and A. Zisserman, “The pascal visual object classes (VOC) challenge,” Int. J. Comput. Vis., vol. 88, no. 2, pp. 303–338, 2010. [23] P. F. Felzenszwalb, R. B. Girshick, D. McAllester, and D. Ramanan, “Object detection with discriminatively trained part-based models,” IEEE Trans. Pattern Anal. Mach. Intell., vol. 32, no. 9, pp. 1627–1645, Sep. 2010. [24] N. Dalal and B. Triggs, “Histograms of oriented gradients for human detection,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit., 2005, pp. 886–893. [25] C. L. Zitnick and P. Dollar, “Edge boxes: Locating object proposals from edges,” in Proc. 10th Eur. Conf. Comput. Vis., 2014, pp. 391– 405. [26] O. Russakovsky, J. Deng, H. Su, J. Krause, S. Satheesh, S. Ma, Z. Huang, A. Karpathy, A. Khosla, M. Bernstein, A. C. Berg, and L. Fei-Fei, “Imagenet large scale visual recognition challenge,” arXiv:1409.0575, 2014. [27] K. Chatfield, V. Lempitsky, A. Vedaldi, and A. Zisserman, “The devil is in the details: An evaluation of recent feature encoding methods,” in Proc. British Mach. Vis. Conf., 2011, pp. 1–12. [28] A. Coates and A. Ng, “The importance of encoding versus training with sparse coding and vector quantization,” in Proc. 28th Int. Conf. Mach. Learn., 2011, pp. 921–928. [29] D. G. Lowe, “Distinctive image features from scale-invariant keypoints,” Int. J. Comput. Vis., vol. 60, no. 2, pp. 91–110, 2004. [30] J. C. van Gemert, J.-M. Geusebroek, C. J. Veenman, and A. W. Smeulders, “Kernel codebooks for scene categorization,” in Proc. 10th Eur. Conf. Comput. Vis., 2008, pp. 696–709. [31] M. Lin, Q. Chen, and S. Yan, “Network in network,” arXiv:1312.4400, 2013. [32] C. Szegedy, W. Liu, Y. Jia, P. Sermanet, S. Reed, D. Anguelov, D. Erhan, V. Vanhoucke, and A. Rabinovich, “Going deeper with convolutions,” arXiv:1409.4842, 2014. [33] K. Simonyan and A. Zisserman, “Very deep convolutional networks for large-scale image recognition,” arXiv:1409.1556, 2014. [34] M. Oquab, L. Bottou, I. Laptev, and J. Sivic, “Learning and transferring mid-level image representations using convolutional neural networks,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit., 2014, pp. 1717–1724.[35] Y. Jia. (2013). Caffe: An open source convolutional architecture for fast feature embedding [Online]. Available: http://caffe.berkeleyvision.org/ [36] A. G. Howard, “Some improvements on deep convolutional neural network based image classification,” ArXiv:1312.5402, 2013. [37] H. Jegou, F. Perronnin, M. Douze, J. Sanchez, P. Perez, and C. Schmid, “Aggregating local image descriptors into compact codes,” IEEE Trans. Pattern Anal. Mach. Intell., vol. 34, no. 9, pp. 1704–1716, Sep. 2012. [38] C.-C. Chang and C.-J. Lin, “Libsvm: A library for support vector machines,” ACM Trans. Intell. Syst. Technol., vol. 2, no. 3, p. 27, 2011. [39] X. Wang, M. Yang, S. Zhu, and Y. Lin, “Regionlets for generic object detection,” in Proc. IEEE Int. Conf. Comput. Vis., 2013, pp. 17–24. [40] C. Szegedy, A. Toshev, and D. Erhan, “Deep neural networks for object detectiion,” in Proc. Adv. Neural Inf. Process. Syst., 2013, pp. 1–9.