B站吴恩达机器学习视频笔记(8)——梯度下降

前言

啊,这个吴恩达老师讲这个梯度下降的方式有点吓人,又掏公式又弄三维坐标系的,其实梯度下降没有看上去那么难,视频中讲的比较专业,虽然努努力还是可以理解的,但是相对于萌新来说不太友好,有的同学可能一看这么多公式就放弃了。不过不要紧嘛,我也是萌新嘛,我给你们解释你们不就懂的容易了,萌新何必为难萌新呢。不过我还是会把吴恩达老师讲的内容放到文章最后,你们先看简单的,再看比较难的,就会很开心。

梯度下降零公式易懂版本

刚接触机器学习的同学避不开的一个专业名词就是梯度下降。顿时心里万马奔腾,其实很简单的,你先得理解概念才能看到那些公式不怂。

我们上来就要整点实际的:1. 梯度到底是啥?2. 梯度下降有啥用?3. 为啥要下降?

梯度是个啥

其实“梯度”你替换成“导数”就可以了,梯度就是目标函数的导数。以后你在书上遇到这个词就替换成“导数”就容易理解多了。

梯度下降有啥用

用问题一的解决方案,替换“梯度”为“导数”。问题变成了:导数下降干嘛的?我暂时把答案写上稍后解释:梯度下降就是用来求某个函数最小值时自变量对应取值。这个函数名字叫做损失函数(cost/loss function),直白点就是误差函数(我在上一篇文章里已经讲过,如果你忘了,没关系,在这里我会再讲一遍)。一个算法不同参数会产生不同拟合曲线,也意味着有不同的误差。损失函数就是一个自变量为算法的参数,函数值为误差值的函数。梯度下降就是找让误差值最小时候算法取的参数。

[敲黑板,忘记的同学我再讲一遍啊]那么什么是损失函数(误差函数)?

机器学习算法中有一类算法就是产生一条曲线来拟合现有的数据,这样子就可以实现预测未来的数据,这个专业术语叫做回归(见到回归就替换成拟合就好了)。还有另外一种类似也是产生一条曲线,但是这个曲线时用来将点分隔成两块,实现分类,在这个曲线一侧为一类另外一侧算一类。但是我怎么知道这个算法产生的拟合曲线效果好不好呢?这个东东叫做误差,预测值减去真实值最后取绝对值,没错就是这么简单粗暴~~

产生的拟合曲线并不是完全和现有的点重合,拟合曲线和真实值之间有一个误差。一个算法不同参数会产生不同拟合曲线,也意味着有不同的误差。损失函数就是一个自变量为算法的参数,函数值为误差值的函数。梯度下降就是找让误差值最小时候这个算法对应的参数。

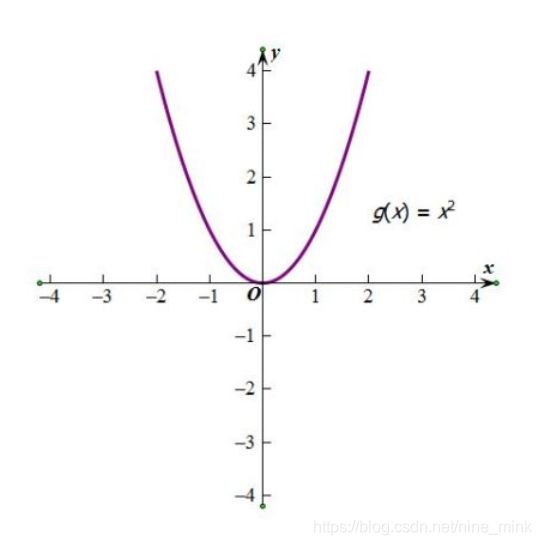

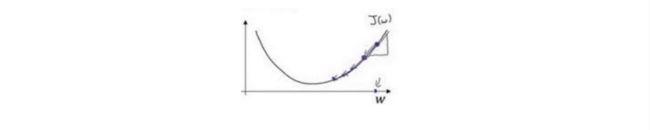

梯度为啥要下降

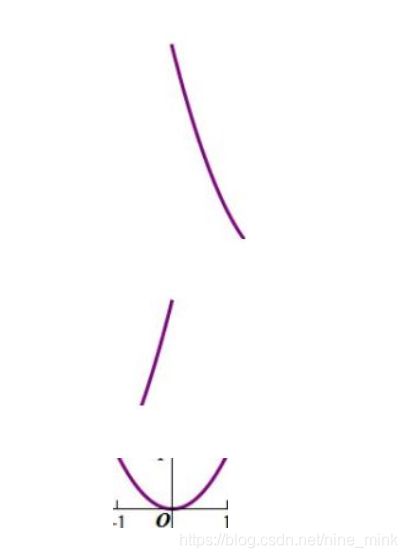

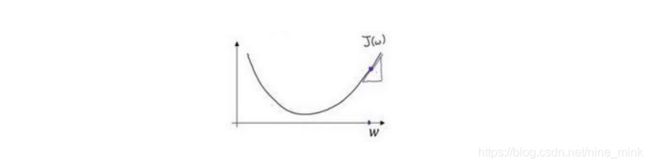

翻译问题。按照问题一的解决方法可知:我们将“梯度为啥要下降?”这个问题翻译为:找误差函数最小值所对应的自变量,为啥要让导数的绝对值变小。我们看下图这个二次函数对应曲线就是误差函数(也就是损失函数,一般是叫损失函数,误差函数是我为了好理解说的),自变量是算法的参数,函数值是该参数下所产生拟合曲线与真实值之间的误差值。注意了,注意了,注意了:一般你看到梯度下降的公式最好想到下面这个图,对就假设误差函数就这么特殊,都是开口朝上,都是平滑的,都是只有一个导数为0的点,都是弯一下而不是弯很多下。

平常我们怎么求损失函数(误差函数)最小值?☞我们目标是求这个损失函数(误差函数)最小值时候对应自变量的值,也就是求曲线最低点自变量x的取值。用高中知识怎求最小值?老师说了求最值不要怂,上来求个导,然后让导函数为0时候取最值。告诉你还真就可以这么干的,简单粗暴。不过这个方法不是梯度下降,它有个很高端大气上档次的名字叫做正规方程(Normal Equation),吓到了吧这么简单的原理居然名字这么高端,所以嘛梯度下降也差不多就名字吓人而已。但是为啥这么简单粗暴容易理解,为啥还要用梯度下降呢?因为一般来说越简单粗暴的方法效率越低~,正规方程在数据量大时候太慢了,就像冒泡排序那么简单为啥排序算法一般不用冒泡排序一样。敲重点了:梯度下降和这个原理类似见下面

梯度下降怎么求损失函数(误差函数)最小值?☞假如你拿着手机地图不用导航去找一个目的地怎么走?我一般是往某个方向走一段路程,然后发现好像离目的地近了,然后产生一个想法“这个方向能使得我离目的地距离更小”,然后我继续沿着这个方向走。(你就会疑问该不会梯度下降就这么做的吧,没错就是这么做的)。

按照那个图的特点,假设这个图放大1万倍,大到你不能一眼看到最小值。那么要你找最小值对应的自变量x,你怎么找??记住我们目的是为了找自变量x,记住我们目的是为了找x

你将可能会在电脑屏幕看到原先那个图的局部,按照它们单调性来分主要有这三种情况

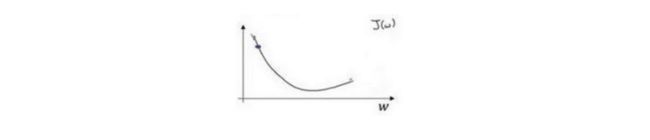

- 当你遇到情况1:单调下降,导数为负(梯度为负),要想找到函数的最小值所对应的自变量的值(曲线最低点对应x的值)怎么走?当然是水平向右滑啦,也就是让x增大,此时随着x增大,导数(梯度)的绝对值是减小的(梯度下降含义懂了吧哈哈就这个意思)

- 当你遇到情况2:单调上升,导数为正(梯度为正),要想找到函数的自变量的值(曲线最低点对应x的值)怎么走?当然是水平向左滑啦,也就是让x减小,此时随着x减小,导数(梯度)的绝对值是减小的(也就是梯度下降)。

- 情况3其实就是情况1和情况2的综合

综上所述:

- 梯度就是导数

- 梯度下降作用是找到函数的最小值所对应的自变量的值(曲线最低点对应x的值)。记住我们目的是为了找x.

- 梯度下降含义(具体操作)是:改变x的值使得导数的绝对值变小,当导数小于0时候(情况1),我们要让目前x值大一点点,再看它导数值。当导数大于0时候(情况2),我们要让目前x值减小一点点,再看它导数值。当导数接近0时候,我们就得到想要的自变量x了。也就是说找到这个算法最佳参数,使得拟合曲线与真实值误差最小。(理解这段话,就不用硬背公式啦)

这是吴恩达老师对于梯度下降的解释,可能会难懂一些,但是真的理解这些图和公式之后,理解梯度下降才更透彻一些

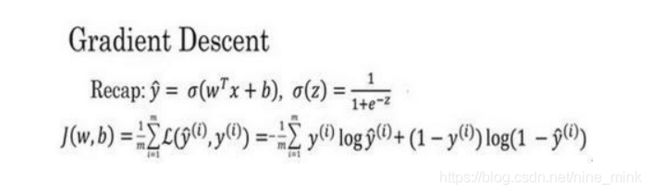

梯度下降法可以做什么?

在你测试集上,通过最小化代价函数(成本函数) J(w,b) 来训练的参数w和b

如图,在第二行给出和之前一样的逻辑回归算法的代价函数(成本函数)(上一篇文章已讲过)

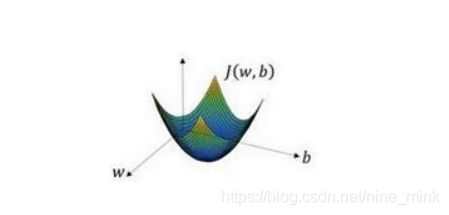

梯度下降法的形象化说明

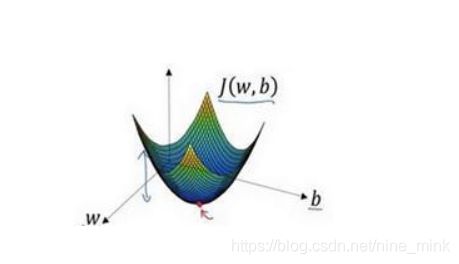

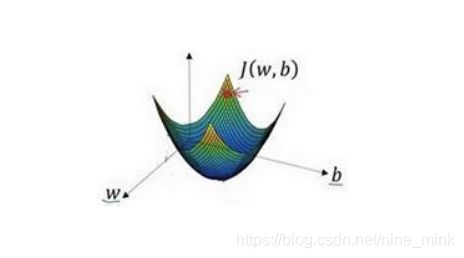

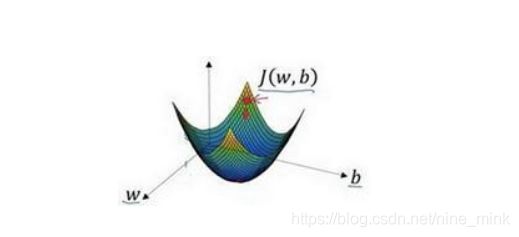

在这个图中,横轴表示你的空间参数w 和 b ,在实践中,w可以是更高的维度,但是为了更好地绘图,我们定义 w 和b,都是单一实数,代价函数(成本函数)J(w,b)是在水平轴w和b上的曲面,因此曲面的高度就是 J(w,b)在某一点的函数值。我们所做的就是找到使得代价函数(成本函数)J(w,b)函数值是最小值,对应的参数w 和b 。

在这个图中,横轴表示你的空间参数w 和 b ,在实践中,w可以是更高的维度,但是为了更好地绘图,我们定义 w 和b,都是单一实数,代价函数(成本函数)J(w,b)是在水平轴w和b上的曲面,因此曲面的高度就是 J(w,b)在某一点的函数值。我们所做的就是找到使得代价函数(成本函数)J(w,b)函数值是最小值,对应的参数w 和b 。

如图,代价函数(成本函数) J(w,b) 是一个凸函数(convex function),像一个大碗一样。

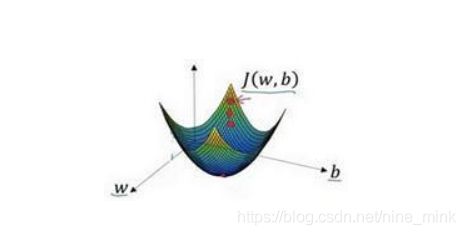

如图,这就与刚才的图有些相反,因为它是非凸的并且有很多不同的局部最小值。由于逻辑回归的代价函数(成本函数) J(w,b) 特性,我们必须定义代价函数(成本函数) J(w,b) 为凸函数。 初始化w和b

可以用如图那个小红点来初始化参数w和b ,也可以采用随机初始化的方法,对于逻辑回归几乎所有的初始化方法都有效,因为函数是凸函数,无论在哪里初始化,应该达到同一点或大致相同的点。

朝最陡的下坡方向走一步,不断地迭代

我们朝最陡的下坡方向走一步,如图,走到了如图中第二个小红点处。

我们可能停在这里也有可能继续朝最陡的下坡方向再走一步,如图,经过两次迭代走到第三个小红点处。

直到走到全局最优解或者接近全局最优解的地方

通过以上的三个步骤我们可以找到全局最优解,也就是代价函数(成本函数) 这个凸函数的最小值点。

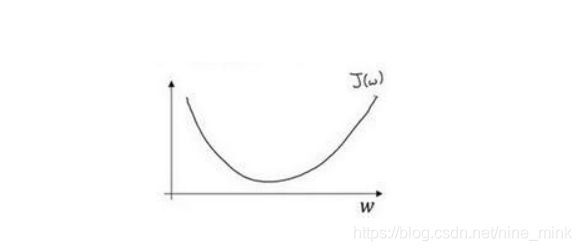

梯度下降法的细节化说明(仅有一个参数)

(这是一个二维的,较好理解些)

假定代价函数(成本函数)J(w)只有一个参数w,即用一维曲线代替多维曲线,这样可以更好画出图像。

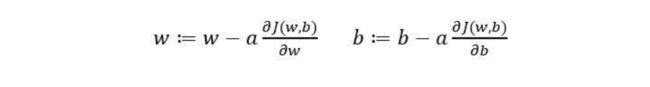

迭代就是不断重复做如图的公式:

:=表示更新参数,

a 表示学习率(learning rate),用来控制步长(step),即向下走一步的长度

就是函数J(w)对 w求导(derivative),在代码中我们会使用dw表示这个结果

就是函数J(w)对 w求导(derivative),在代码中我们会使用dw表示这个结果

对于导数更加形象化的理解就是斜率(slope),如图该点的导数就是这个点相切于J(w)的小三角形的高除宽。假设我们以如图点为初始化点,该点处的斜率的符号是正的,即

所以接下来会向左走一步。

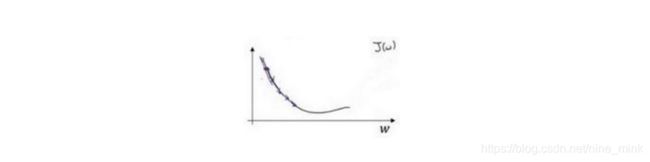

整个梯度下降法的迭代过程就是不断地向左走,直至逼近最小值点。

所以接下来会向右走一步。

整个梯度下降法的迭代过程就是不断地向右走,即朝着最小值点方向走。

梯度下降法的细节化说明(两个参数)

逻辑回归的代价函数(成本函数)J(w,b) 是含有两个参数的。

δ表示求偏导符号,可以读作round

就是函数J(w,b)对w求偏导,在代码中我们会使用dw表示这个结果。

就是函数J(w,b)对b求偏导,在代码中我们会使用 db表示这个结果,

就是函数J(w,b)对b求偏导,在代码中我们会使用 db表示这个结果,

小写字母d 用在求导数(derivative),即函数只有一个参数, 偏导数符号 δ 用在求偏导(partial derivative),即函数含有两个以上的参数。

这篇文章中会用到求导和偏导的相关知识,如果不懂的话,可能要去补习下知识咯!