使用IntelliJ IDEA来写spark(使用scala语言)

1. 创建项目:(包括配置java的JDK和scala的SDK)

file ---> new ---> project ---> scala ---> idea(选择java的JDK和scala的SDK) ---> finish ---> 结束

2. 配置spark的jar包:

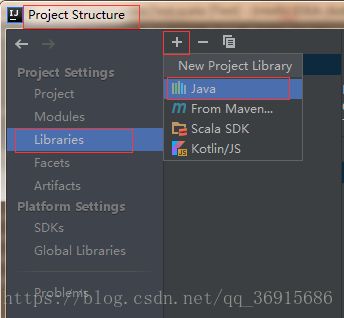

file ---> project structure ---> library ---> 左上方的+ ---> java ---> 选择spark文件夹下的jars文件

这里的spark文件夹的原名是:spark-2.3.1-bin-hadoop2.7

配置spark的目录配置: file ---> project structure ---> module ---> 在文件夹上右键选择new folder --->在Mark as 中选择文件的属性