轻松解剖数据降维——PCA

目录

-

- 为什么要进行数据降维?

- 中心矩阵是什么?

- PAC

-

- 最大投影方差

- 最小重构距离

- 从SVD角度看PAC

为什么要进行数据降维?

我们知道数据降维是减少过拟合的重要方法之一,且对于高维度的数据,不仅计算量庞大的吓人,而且容易带来维度灾难。

下面我们从几何角度看看什么是维度灾难,会带来哪些影响?

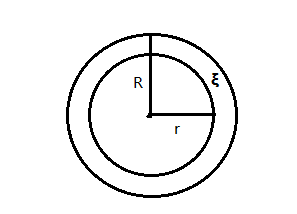

下图是一个同圆心构成的圆环,大圆半径为R = 1,圆环间隙 ξ \xi ξ足够小,即趋于0,小圆半径为r = R - ξ \xi ξ = 1 - ξ \xi ξ。

在二维平面上大圆和小圆的面积几乎相等,圆环的面积趋于0.

V 小 圆 V 大 圆 = lim ξ → 0 , k = 2 π ( 1 − ξ ) 2 π 1 2 = 1 (1) \frac{ V小圆 }{ V大圆 } = \lim\limits_{\xi \rightarrow 0 ,k = 2} \frac{\pi (1-\xi)^2}{\pi 1^2} = 1 \tag{1} V大圆V小圆=ξ→0,k=2limπ12π(1−ξ)2=1(1)

如果将下图映射到一个k维空间时,假设k很大,区域 + ∞ \infty ∞ 。

那么可得:

V 小 圆 V 大 圆 = lim ξ → 0 , k → + ∞ π ( 1 − ξ ) k π 1 k = 0 1 = 0 (2) \frac{ V小圆 }{ V大圆 } = \lim\limits_{\xi \rightarrow 0,k \rightarrow +\infty} \frac{\pi (1-\xi)^k}{\pi 1^k} = \frac{ 0 }{ 1 } = 0 \tag{2} V大圆V小圆=ξ→0,k→+∞limπ1kπ(1−ξ)k=10=0(2)

V 圆 环 V 大 圆 = lim ξ → 0 , k → + ∞ π 1 2 − π ( 1 − ξ ) k π 1 k = 1 − 0 1 = 1 (3) \frac{ V圆环 }{ V大圆 } = \lim\limits_{\xi \rightarrow 0,k \rightarrow +\infty} \frac{\pi 1^2 -\pi (1-\xi)^k}{\pi 1^k} = \frac{ 1-0 }{ 1 } = 1 \tag{3} V大圆V圆环=ξ→0,k→+∞limπ1kπ12−π(1−ξ)k=11−0=1(3)

总结:低维数据映射到高维数据,会使得数据变得更加稀疏,分布不均匀,且几乎只有原先边缘部分的数据是分散在高维空间内。这样带来的不好现象就被称为维度灾难。

中心矩阵是什么?

先不急说中心矩阵是什么?有什么作用?有什么性质?我们可以利用均值和协方差矩阵来引出它。

假设有N个样本数据,每个数据是P维特征,用矩阵X来表示这些数据。

向量 xi 没有说明,默认都是列向量。

X n p = [ x 1 , x 2 . . . , x n ] T = [ x 1 T x 2 T . . . x n T ] = [ x 11 x 12 . . . x 1 p x 21 x 22 . . . x 2 p . . . . . . x n 1 x n 2 . . . x n p ] n p (4) X_{np} = \left[ \begin{matrix} x_1, x_2...,x_n \end{matrix} \right]^T = \left[ \begin{matrix} x_1^T \\ x_2^T \\ ... \\ x_n^T \end{matrix} \right] = \left[ \begin{matrix} x_{11} & x_{12} & ... & x_{1p} \\ x_{21} & x_{22} & ... & x_{2p} \\ ...... \\ x_{n1} & x_{n2} & ... & x_{np} \end{matrix} \right]_{np} \tag{4} Xnp=[x1,x2...,xn]T=⎣⎢⎢⎡x1Tx2T...xnT⎦⎥⎥⎤=⎣⎢⎢⎡x11x21......xn1x12x22xn2.........x1px2pxnp⎦⎥⎥⎤np(4)

- 样本均值

实际上是求所有样本在不同特征下的均值,故最后结果为 p维的列向量.

设1n = [ 1 1 . . . 1 ] n × 1 \left[ \begin{matrix} 1 \\ 1 \\ ... \\ 1 \end{matrix} \right]_{n\times1} ⎣⎢⎢⎡11...1⎦⎥⎥⎤n×1,矩阵In是n维的单位矩阵。

x ‾ p = 1 n ∑ i = 1 n x i = 1 n X T 1 n (5) \overline{x}_{p} = \frac{ 1 }{ n } \sum_{i=1}^n x_i \tag{5} = \frac{ 1 }{ n } X^T1_n xp=n1i=1∑nxi=n1XT1n(5)

- 样本协方差矩阵

协方差矩阵符号记为S。

S p p = 1 n ∑ i = 1 n ( x i − x ‾ ) ( x i − x ‾ ) T (6) S_{pp} = \frac{ 1 }{ n } \sum_{i=1}^n (x_i - \overline{x})(x_i - \overline{x})^T \tag{6} Spp=n1i=1∑n(xi−x)(xi−x)T(6)

S p p = 1 n ( x 1 − x ‾ , x 2 − x ‾ , . . . , x n − x ‾ ) ( x 1 − x ‾ , x 2 − x ‾ , . . . , x n − x ‾ ) T = 1 n [ ( x 1 , x 2 , . . . , x n ) − x ‾ ( 1 , 1 , . . . , 1 ) n ] [ ( x 1 , x 2 , . . . , x n ) − x ‾ ( 1 , 1 , . . . , 1 ) n ] T = 1 n ( X T − x ‾ 1 n T ) ( X T − x ‾ 1 n T ) T 将 式 ( 5 ) 带 入 可 得 S p p = 1 n ( X T − 1 n X T 1 n 1 n T ) ( X T − 1 n X T 1 n 1 n T ) T = 1 n [ X T ( I n − 1 n 1 n 1 n T ) ] [ X T ( I n − 1 n 1 n 1 n T ) ] T = 1 n X T ( I n − 1 n 1 n 1 n T ) ( I n − 1 n 1 n 1 n T ) T X 令 H n = I n − 1 n 1 n 1 n T , 则 可 得 S p p = 1 n X T H H T X S_{pp}= \frac{ 1 }{ n }(x_1- \overline{x},x_2 - \overline{x},...,x_n- \overline{x}) (x_1- \overline{x},x_2 - \overline{x},...,x_n- \overline{x}) ^T \\ = \frac{ 1 }{ n } [(x_1,x_2,...,x_n) - \overline{x}(1,1,...,1)_n][(x_1,x_2,...,x_n) - \overline{x}(1,1,...,1)_n]^T \\ = \frac{ 1 }{ n } (X^T-\overline{x}1_n^T) (X^T-\overline{x}1_n^T)^T \\ 将式(5)带入可得 \\ S_{pp}= \frac{ 1 }{ n }(X^T-\frac{ 1 }{ n } X^T1_n1_n^T)(X^T-\frac{ 1 }{ n } X^T1_n1_n^T)^T \\ = \frac{ 1 }{ n } [X^T(I_n - \frac{ 1 }{ n }1_n1_n^T)] [X^T(I_n-\frac{ 1 }{ n }1_n1_n^T)]^T \\ = \frac{ 1 }{ n }X^T(I_n - \frac{ 1 }{ n }1_n1_n^T)(I_n - \frac{ 1 }{ n }1_n1_n^T)^TX \\ 令H_n = I_n - \frac{ 1 }{ n }1_n1_n^T,则可得 \\ S_{pp} = \frac{ 1 }{ n }X^THH^TX Spp=n1(x1−x,x2−x,...,xn−x)(x1−x,x2−x,...,xn−x)T=n1[(x1,x2,...,xn)−x(1,1,...,1)n][(x1,x2,...,xn)−x(1,1,...,1)n]T=n1(XT−x1nT)(XT−x1nT)T将式(5)带入可得Spp=n1(XT−n1XT1n1nT)(XT−n1XT1n1nT)T=n1[XT(In−n11n1nT)][XT(In−n11n1nT)]T=n1XT(In−n11n1nT)(In−n11n1nT)TX令Hn=In−n11n1nT,则可得Spp=n1XTHHTX

上述的H就是中心矩阵,他的作用是使得数据中心化,即

H n T X = [ ( x 1 − x ‾ ) T ( x 2 − x ‾ ) T . . . . . . ( x n − x ‾ ) T ] H_n^TX = \left[ \begin{matrix} (x_1 - \overline{x})^T\\ (x_2 - \overline{x})^T \\ ...... \\ (x_n - \overline{x})^T \end{matrix} \right] HnTX=⎣⎢⎢⎡(x1−x)T(x2−x)T......(xn−x)T⎦⎥⎥⎤

性质如下:

- H = H T

- Hn = H

PAC

PAC算法的思想总结一句话——将一组可能线性相关的变量通过正交变换变换成一组线性无关的变量,即原始特征重构。

接下来我们从两个角度来看PAC算法,一个是最大投影方差,另一个是最小重构距离。

最大投影方差

如上图有一堆二维分散的数据点,我们选择了u1和u2两个方向进行投影,哪个方向效果更好呢?

从图中可以直观看到u1方向更好,从数学角度看,是因为它的投影矿都d1远大于d2,从而造成投影方差更大,即投影后的数据分布更加的分散。

当我们确定了u1方向投影效果最好时,即找到了主成分。我们来尝试求最大投影方差。

设 || u1 || = 1,即 u1T u1 = 1,有n个数据点。

一般步骤:

- 中心化

x i − x ‾ x_i - \overline{x} xi−x - 求一个点的投影距离

点 x 1 的 投 影 距 离 = ( x 1 − x ‾ ) T u 1 点x_1的投影距离 =(x_1 - \overline{x})^Tu_1 点x1的投影距离=(x1−x)Tu1 - 求所有样本点的投影距离之和

投 影 长 度 之 和 P = ∑ i = 1 n ( x i − x ‾ ) T u 1 投影长度之和 P = \sum_{i=1}^n (x_i - \overline{x})^Tu_1 投影长度之和P=i=1∑n(xi−x)Tu1 - 求投影方差

J = 1 n ∑ i = 1 n [ ( x i − x ‾ ) T u 1 ] 2 = 1 n ∑ i = 1 n ( ( x i − x ‾ ) T u 1 ) T ( ( x i − x ‾ ) T u 1 ) = 1 n ∑ i = 1 n u 1 T ( x i − x ‾ ) ( x i − x ‾ ) T u 1 = u 1 T ( 1 n ∑ i = 1 n ( x i − x ‾ ) ( x i − x ‾ ) T ) u 1 根 据 式 ( 6 ) 可 得 : J = u 1 T S u 1 (7) J = \frac{ 1 }{ n } \sum_{i=1}^n [(x_i - \overline{x})^Tu_1]^2 \\ = \frac{ 1 }{ n } \sum_{i=1}^n((x_i - \overline{x})^Tu_1)^T((x_i - \overline{x})^Tu_1) \\ =\frac{ 1 }{ n } \sum_{i=1}^n u_1^T(x_i-\overline{x})(x_i-\overline{x})^Tu_1 \\ =u_1^T(\frac{ 1 }{ n } \sum_{i=1}^n(x_i-\overline{x})(x_i-\overline{x})^T)u_1 \\ 根据式(6)可得:\\ J = u_1^TSu_1 \tag{7} J=n1i=1∑n[(xi−x)Tu1]2=n1i=1∑n((xi−x)Tu1)T((xi−x)Tu1)=n1i=1∑nu1T(xi−x)(xi−x)Tu1=u1T(n1i=1∑n(xi−x)(xi−x)T)u1根据式(6)可得:J=u1TSu1(7) - 求最大投影方差

求maxJ,且u1T u1 = 1,根据拉格朗日乘子法可得:

L ( u 1 , λ ) = u 1 T S u 1 + λ ( 1 − u 1 T u 1 ) L(u_1,\lambda) = u_1^TSu_1 + \lambda(1-u_1^Tu_1) L(u1,λ)=u1TSu1+λ(1−u1Tu1)

∂ L ∂ u 1 = 2 S u 1 − 2 λ u 1 = 0 所 以 可 得 : S u 1 = λ u 1 (8) \frac{\partial L}{\partial u_1} =2Su_1-2\lambda u_1 = 0 \\ 所以可得: \\ Su_1 = \lambda u_1 \tag{8} ∂u1∂L=2Su1−2λu1=0所以可得:Su1=λu1(8)

通过观察式(8),可以发现这是一个特征值分解,即 λ \lambda λ是协方差矩阵S的特征值,u1是于特征值对应的特征向量。PCA的方法就是选择前k个最大特征值对应的特征向量,然后变成单位向量,即选取了k个主成分进行降维。

最小重构距离

实际上是比较n维数据点用另一个n维坐标轴映射,然后从n维挑选p个坐标轴映射的数据前后的误差。

下图原始数据点x是一个二维向量,通过u1和u2两个方向映射成一个新的同维度的数据点x’,很明显向量坐标将会改变,且新的x’ = (xTu1)u1 + (xTu2)u2

同样对于n个样本的p维向量xi,我们假设中心化后映射到向量u1、u2、…、un。则新的向量:

x i ′ = ∑ k = 1 p ( ( x i − x ‾ ) T u k ) u k x'_i = \sum_{k=1}^p((x_i-\overline{x})^Tu_k)u_k xi′=k=1∑p((xi−x)Tuk)uk

如果我们要从原先的p维降到q维,则映射后的向量为:

x ^ i = ∑ k = 1 q ( ( x i − x ‾ ) T u k ) u k \widehat{x}_i = \sum_{k=1}^q((x_i-\overline{x})^Tu_k)u_k x i=k=1∑q((xi−x)Tuk)uk

设重构误差为J,则:

J = 1 n ∑ i = 1 n ∣ ∣ x i − x ^ i ∣ ∣ 2 = 1 n ∑ i = 1 n ∣ ∣ ∑ k = q + 1 p ( ( x i − x ‾ ) T u k ) u k ∣ ∣ 2 = 1 n ∑ i = 1 n ∑ k = q + 1 p ( ( x i − x ‾ ) T u k ) 2 = ∑ k = q + 1 p u k T S u k J = \frac{ 1 }{ n }\sum_{i=1}^n ||x_i-\widehat{x}_i | |^2 = \frac{ 1 }{ n }\sum_{i=1}^n|| \sum_{k=q+1}^p ((x_i-\overline{x})^Tu_k)u_k||^2 \\ = \frac{ 1 }{ n }\sum_{i=1}^n \sum_{k=q+1}^p ((x_i-\overline{x})^Tu_k)^2 \\ = \sum_{k=q+1}^p u_k^TSu_k J=n1i=1∑n∣∣xi−x i∣∣2=n1i=1∑n∣∣k=q+1∑p((xi−x)Tuk)uk∣∣2=n1i=1∑nk=q+1∑p((xi−x)Tuk)2=k=q+1∑pukTSuk

同理对J进行拉格朗日乘子法,得

L ( u k , λ ) = ∑ k = q + 1 p u k T S u k + ∑ k = q + 1 p λ ( 1 − u k T u k ) L(u_k,\lambda) = \sum_{k=q+1}^pu_k^TSu_k + \sum_{k=q+1}^p\lambda(1-u_k^Tu_k) L(uk,λ)=k=q+1∑pukTSuk+k=q+1∑pλ(1−ukTuk)

∂ L ∂ u k = ∑ k = q + 1 p 2 S u 1 − ∑ k = q + 1 p 2 λ u 1 = 0 所 以 可 得 : ∑ k = q + 1 p S u 1 = ∑ k = q + 1 p λ u 1 (9) \frac{\partial L}{\partial u_k} = \sum_{k=q+1}^p2Su_1- \sum_{k=q+1}^p2\lambda u_1 = 0 \\ 所以可得: \\ \sum_{k=q+1}^pSu_1 = \sum_{k=q+1}^p\lambda u_1 \tag{9} ∂uk∂L=k=q+1∑p2Su1−k=q+1∑p2λu1=0所以可得:k=q+1∑pSu1=k=q+1∑pλu1(9)

∂ L ∂ λ = ∑ k = q + 1 p ( 1 − u k T u k ) = 0 (10) \frac{\partial L}{\partial \lambda} = \sum_{k=q+1}^p (1-u_k^Tu_k)= 0 \tag{10} ∂λ∂L=k=q+1∑p(1−ukTuk)=0(10)

将式(9)、(10)带入L函数可得:

L = ∑ k = q + 1 p λ L = \sum_{k=q+1}^p \lambda L=k=q+1∑pλ

因为要使得L最小,所以选择得特征值是从最小得几个里面选择,即从p维降到q维,需要抛弃掉最小得p-q个特征值及其对应的特征向量。

从SVD角度看PAC

方阵S进行特征值分解可得:

S p p = V p n K p p V T 其 中 V T V = 1 , 且 K = [ λ 1 0 0 . . . 0 λ 2 0 . . . . . . . . . . . . . . . 0 0 . . . λ p ] (11) S_{pp} = V_{pn}K_{pp}V^T 其中V^TV=1,且K = \left[ \begin{matrix} \lambda_1 &0 &0 &...\\ 0 &\lambda_2 &0 &...\\ ... &... & ... & ...\\ 0 & 0 & ... & \lambda_p \end{matrix} \right] \tag{11} Spp=VpnKppVT其中VTV=1,且K=⎣⎢⎢⎡λ10...00λ2...000...............λp⎦⎥⎥⎤(11)

接下来对中心化后的原数据进行奇异值分解:

H X = U Λ V T 且 U T U = V T V = E , Λ T = Λ (12) HX = U\Lambda V^T \tag{12} 且U^TU=V^TV=E,\Lambda^T =\Lambda HX=UΛVT且UTU=VTV=E,ΛT=Λ(12)

然后对协方差矩阵S进行分析:

S = 1 n X T H H T X = 1 n X T H X = 1 n X T H T H X = 1 n ( H X ) T H X S = \frac{ 1 }{ n }X^THH^TX = \frac{ 1 }{ n }X^THX= \frac{ 1 }{ n }X^TH^THX = \frac{ 1 }{ n }(HX)^THX S=n1XTHHTX=n1XTHX=n1XTHTHX=n1(HX)THX

忽略系数 1 n \frac{ 1 }{ n } n1,且将式(12)代入可得:

S p = V Λ U T U Λ V T = V Λ 2 V T (13) S_{p} = V\Lambda U^TU\Lambda V^T = V\Lambda^2V^T \tag{13} Sp=VΛUTUΛVT=VΛ2VT(13)

对比式(11)和式(13),V = V,K = Λ \Lambda Λ2,其中V表示各个特征值对应的特征向量, Λ \Lambda Λ2存储着对应协方差矩阵S的特征值。

最后我们定义一个方阵T:

T n = H X ( H X ) T = U Λ V T V Λ U T = U Λ 2 U T (14) T_{n} = HX(HX)^T = U\Lambda V^T V\Lambda U^T = U\Lambda^2U^T \tag{14} Tn=HX(HX)T=UΛVTVΛUT=UΛ2UT(14)

可以发现S和T有有相同的特征值,但两者作用不大相同。

S分解,得到特征值和特征向量V,然后得到转换后的数据点坐标——(HXV)

T分解,直接得到坐标。

∵ 坐 标 = H X V = U Λ V T V = U Λ \because坐标 = HXV = U\Lambda V^TV = U\Lambda ∵坐标=HXV=UΛVTV=UΛ

∴ T ( U Λ ) = U Λ 2 U T U Λ = U Λ 3 = ( U Λ ) Λ 2 \therefore T(U\Lambda) = U\Lambda^2U^TU\Lambda = U\Lambda^3 = (U\Lambda )\Lambda^2 ∴T(UΛ)=UΛ2UTUΛ=UΛ3=(UΛ)Λ2

总结:可以对T分解也可以对S进行分解,二者维度不一样,前者pxp,后者nxn,故应尽量选择维度更低。