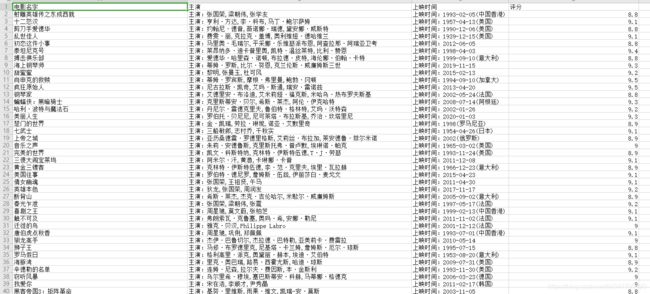

Python爬取新版猫眼Top100电影系列数据,并保存到csv文件

前言

本文的文字及图片来源于网络,仅供学习、交流使用,不具有任何商业用途,如有问题请及时联系我们以作处理。

PS:如有需要Python学习资料的小伙伴可以加点击下方链接自行获取

python免费学习资料以及群交流解答点击即可加入

开发工具

- python 3.6.5

- pycharm

import requests

import parsel

import time

import csv

相关模块pip安装即可

爬虫基本流程

1.确定url地址(网页分析) 完成一半

2.发送网络请求 requests(js\html\css)

3.数据解析(筛选数据)

4.保存数据(本地文件\数据库)

1、确定url地址

https://maoyan.com/board/4

2、发送网络请求

import requests

url = 'https://maoyan.com/board/4'

response = requests.get(url, params=params, headers=headers, cookies=cookies)

# print(response.text)

3、数据解析(筛选数据)

使用parsel模块的CSS选择器解析网页数据

猫眼电影网页数据,全部再dd标签里面,所以咱们先获取dd标签里面的数据

import parsel

selector = parsel.Selector(response.text)

dd_s = selector.css('.board-wrapper dd')

遍历dd_s 使用css提取每一项数据,因为咱们要保存到csv里面,所以可以先创建一个字典接受这些数据

for li in li_s:

name = li.css('.name a::text').get()

star = li.css('.star::text').get()

releasetime = li.css('.releasetime::text').get()

follow = li.css('.score i::text').getall()

4、保存数据

import csv

f = open('data.csv', mode='a', encoding='utf-8', newline='') # 打开文件

csv_write = csv.DictWriter(f, fieldnames=['电影名字', '主演', '上映时间', '评分']) # 制定表头

csv_write.writeheader() # 写入表头

csv_write.writerow(dit) # 写入数据

f.close() # 关闭文件