高级网络配置(bond、team、桥接)

一、bond模式

网卡的bond工作模式是 通过软件工具将多块真实物理网卡虚拟成一个网卡,配置完毕后,所有的物理网卡都成为这个虚拟物理网络接口的子部件,而且这些组合起来的物理网卡会拥有同一个IP和MAC地址。 这样将多块网卡绑定在一起的方式 一是可以增加接口的带宽,二是能够实现轮询、负载均衡和冗余功能

(active-backup)Active-backup policy(主-备份策略):只有一个设备处于活动状态,当一个宕掉另一个马上由备份转换为主设备。mac地址是外部可见得,从外面看 来,bond的MAC地址是唯一的,以避免switch(交换机)发生混乱。此模式只提供容错能力;优点是可以提供高网络连接的可用性,但是它的资源利用率较低,只有一个接口处于工作状态,在有 N 个网络接口的情况下,资源利用率为1/N

用命令方法配置网络为bond的active-backup工作模式:

(1)为虚拟机添加两块网卡(未配置)

(2)命令建立bond0

nmcli connection add con-name bond0 ifname bond0 type bond mode active-backup ip4 172.25.254.111/24

cat /proc/net/bonding/bond0(3)添加真实物理网卡到bond0

watch -n 1 cat /proc/net/bonding/bond0 ##建立监控命令查看bond0信息

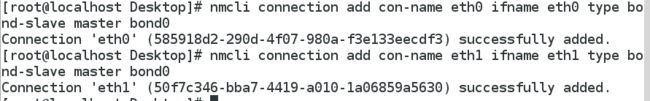

nmcli conntection add con-name eth0 ifname eth0 type bond-slave master bond0 ##加网卡eth0为接口工作

nmcli conntection add con-name eth1 ifname eth1 type bond-slave master bond0 ##加eth1

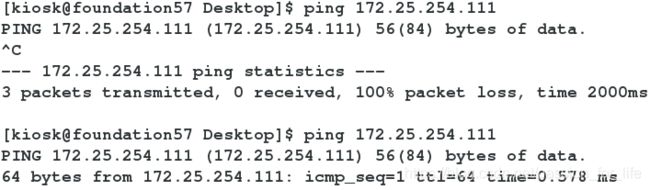

eht0 为添加的网卡名称,bond-slave 表示为bond的从属设备,master bond0 表示为 bond0 服务在没有添加物理网卡之前,其他主机不能和主机111通信,添加网卡后,可以ping通

(4)主备转换

模拟故障:

ifconfig eth0 down ##eth0出问题,此时eth1接替工作

ifconfig eth0 up ##恢复后此时eth0闲置备用状态文本方式配置:

首先还原实验环境,打开图形界面将所有删除掉,重启网络

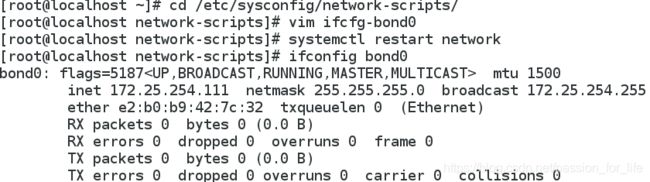

(1)在 /etc/sysconfig/network-scripts 目录下创建 bond0的配置文件:

(2)创建子接口(真实网卡)配置文件:

二、team模式

bond最多只支持两块网卡,team方式最多可支持达8块网卡,具有更强的扩展性,是加强版的bond模式

broadcast广播容错 roundrobin平衡轮叫 activebackup主备模式 loadbalance负载均衡

轮转(round-robin)策略:slave网卡轮流发送数据包,本模式提供负载均衡和容错的能力。

负载均衡(loadbalance):,将请求/数据均匀分摊到多个操作单元上执行

广播策略(broadcast):在所有的slave网卡接口传送所有的报文,提供容错的能力,但同时也极其消耗系统资源。

| Feature | Bonding | Team |

|---|---|---|

| User can set hash function | No | Yes |

| load-balancing for LACP support | No | Yes |

| NS/NA (IPv6) link monitoring | No | Yes |

| port priorities and stickiness (“primary”option enhancement) | No | Yes |

| separate per-port link monitoring setup | No | Yes |

| multiple link monitoring setup | Limited | Yes |

| lockless Tx/Rx path | No (rwlock) | Yes (RCU) |

| user-space runtime control | Limited | Full |

| Logic in user-space | No | Yes |

| Extensibility | Hard | Easy |

| Modular design | No | Yes |

| Performance overhead | Low | Very Low |

| D-Bus interface | No | Yes |

| zero config using LLDP | No | (in planning) |

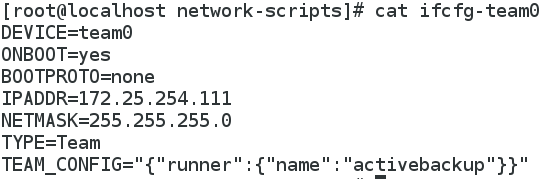

命令方式配置Team为activebackup工作模式:

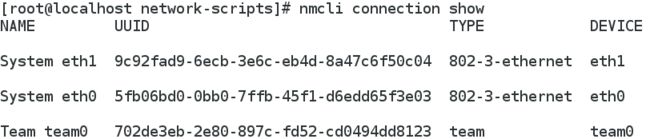

(1)还原实验环境,建team0:

nmcli connetction add con-name team0 ifname team0 type team \(太长转移)

config '{"runner":{"name":"activebackup"}}' ip4 172.25.254.111/24(2)添加子接口:

nmcli conntection add con-name eth0 ifname eth0 type team-slave master team0

nmcli conntection add con-name eth1 ifname eth1 type team-slave master team0

systemctl restart network(3)测试:可通过执行 ifconfig eth0 down 来模拟 eth0 网卡出现问题,从而观察 team0 从属设备的运行状态,如下图所示,可发现 eth0 down 后,eth1 在第一时间接替了 eth0 继续工作

ifconfig eth0 down ##eth1 run

ifocnfig eth0 up ##eth0闲置备用

ifconfig eth1 down ##eth0工作

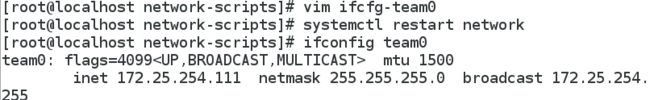

ifconfgi eth1 up ##eth1闲置备用文本方式设定:

还原环境:

nmcli connection delete team0

nmcli conection delete eth0

nmcli connection delete eth1在 /etc/sysconfig/network-scripts 目录下创建team0,eth0和eth1配置文件

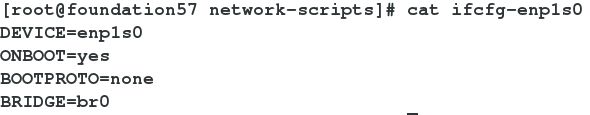

三、真机桥接模式的配置

1.NAT模式:NAT即网络地址转换,是虚拟专用网和全球IP地址之间的转换,虚拟专用网是内部网络不能被互联网中的路由器所识别,因此,需要在路由器上进行地址转换,这种方式下,由于从虚拟机的网卡传出的数据要在内核上进行数据的封装所以交换数据速度会变慢

2.桥接模式:当虚拟机系统的网络连接模式为桥接模式时,相当于在主机系统和虚拟机系统之间连接了一个网桥,而网桥两端的网络都属于同一网络,主机和虚拟机是处于同一网络中的对等主机,数据交换比较快

文本方式配置网桥

实验环境:先将自己网桥配置进行备份,然后删除掉本机的网桥配置,关闭虚拟机

建立完成后,可能无法成功重启网络,可以关闭 NetworkManager.service 后再重启网络,则网桥建立成功

命令的方式配置网桥

brctl addbr br0 ##建网桥

ifconfig br0 172.25.254.111/24 ##配ip

brctl addif br0 eth0 ##加网卡在没添加物理网卡之前,网桥和其他主机也无法通信,添加网卡后,就能ping通

网桥删除

ifconfig br0 down ##关闭网桥连接

brctl delif br0 eth0 ##删网卡

brctl delbr br0 ##删网桥

brctl show ##查看网桥