Koalas - 入门基本操作

Koalas - 入门基本操作

-

- 导入库

- 对象的创建

- 查看数据

- 缺少数据

- Spark配置

- 分组

- 获得的数据输入/输出

导入库

import pandas as pd

import numpy as np

import databricks.koalas as ks

from pyspark.sql import SparkSession

对象的创建

- 通过传递值列表来创建Koalas系列,让Koalas创建默认的整数索引:

s = ks.Series([1, 3, 5, np.nan, 6, 8])

- 通过传递对象的字典来创建Koalas DataFrame,这些对象可以转换为类似序列的对象。

kdf = ks.DataFrame(

{'a': [1, 2, 3, 4, 5, 6],

'b': [100, 200, 300, 400, 500, 600],

'c': ["one", "two", "three", "four", "five", "six"]},

index=[10, 20, 30, 40, 50, 60])

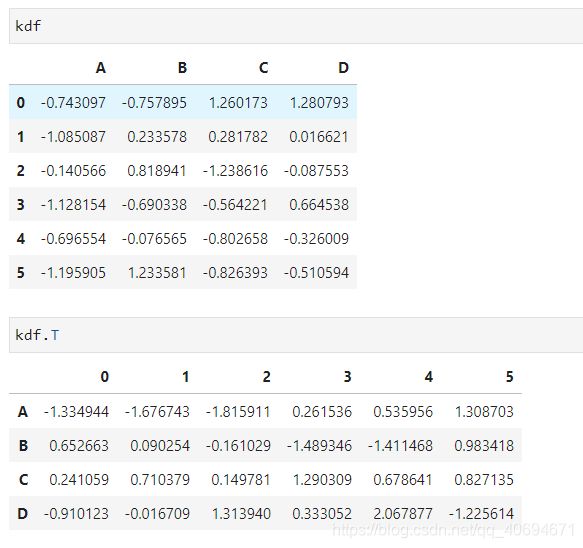

- 通过传递带有日期时间索引和带标签的列的numpy数组来创建pandas DataFrame

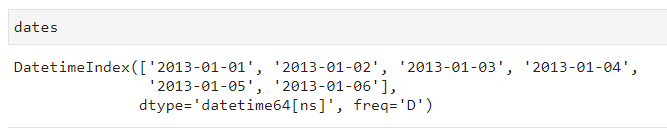

dates = pd.date_range('20130101', periods=6)

pdf = pd.DataFrame(np.random.randn(6, 4), index=dates, columns=list('ABCD'))

- 现在,此Pandas数据框可以转换为Koalas数据框

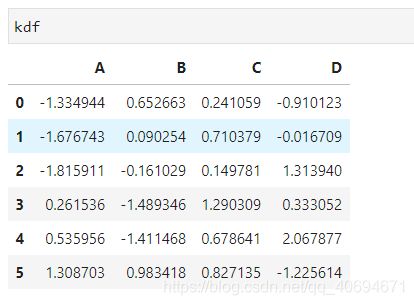

kdf = ks.from_pandas(pdf)

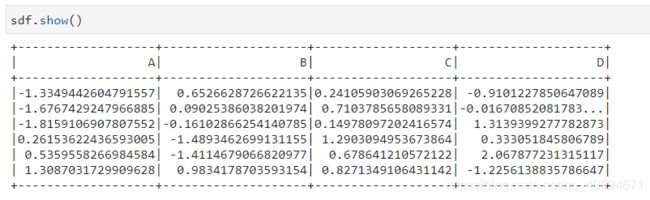

spark = SparkSession.builder.getOrCreate()

sdf = spark.createDataFrame(pdf)

- 从Spark DataFrame创建Koalas DataFrame。to_koalas()会自动附加到Spark DataFrame,并且在导入Koalas时可用作API。

kdf = sdf.to_koalas()

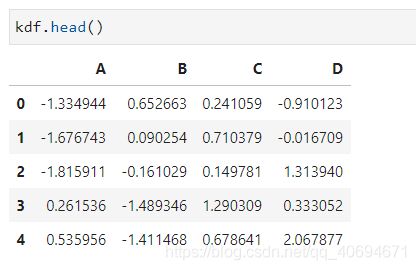

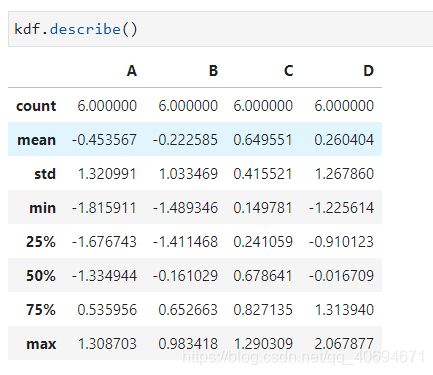

查看数据

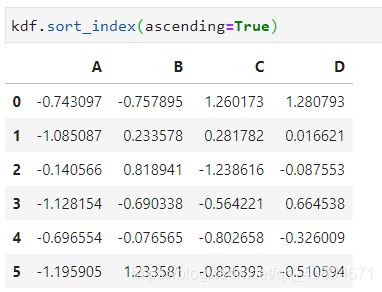

kdf.sort_index(ascending=False)

- 按值排序

kdf.sort_values(by='B')

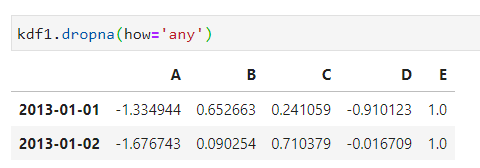

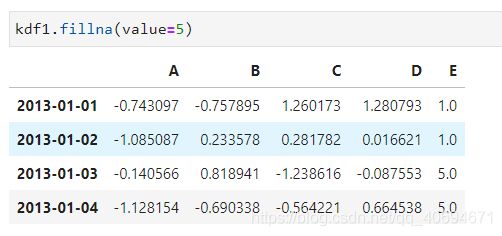

缺少数据

# 取前四行,列表新增一列:E列

pdf1 = pdf.reindex(index=dates[0:4], columns=list(pdf.columns) + ['E'])

# 给索引的第一第二行的E列赋值,因为第三第四行的E列的数据没赋值,所以为空

pdf1.loc[dates[0]:dates[1], 'E'] = 1

# 将此pandas数据框转化为Koalas数据框

kdf1 = ks.from_pandas(pdf1)

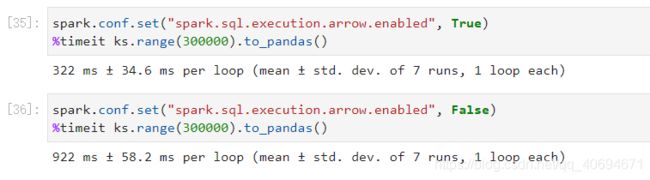

Spark配置

- PySpark中的各种配置可以在考拉内部应用。例如,您可以启用Arrow优化,以极大地加快内部熊猫的转换。

# 保持默认值

prev = spark.conf.get("spark.sql.execution.arrow.enabled")

# 使用默认索引防止开销。

ks.set_option("compute.default_index_type", "distributed")

# 忽略来自Arrow优化的警告。

import warnings

warnings.filterwarnings("ignore")

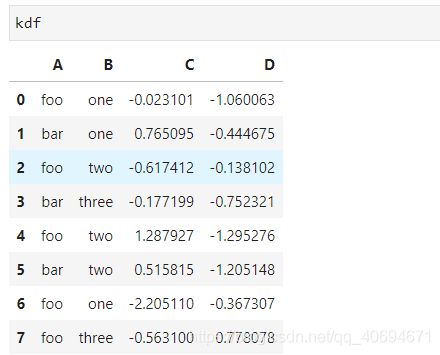

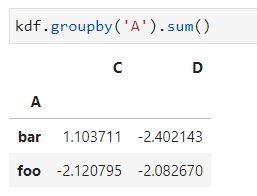

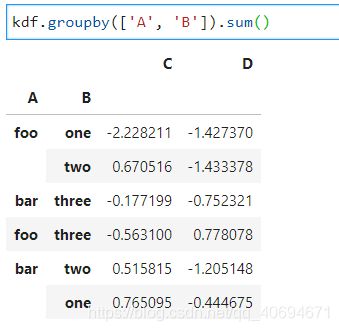

分组

“分组依据”是指涉及以下一个或多个步骤的过程:

-

根据某些条件将数据分成几组

-

将功能独立应用于每个组

-

将结果合并为数据结构

kdf = ks.DataFrame({'A': ['foo', 'bar', 'foo', 'bar',

'foo', 'bar', 'foo', 'foo'],

'B': ['one', 'one', 'two', 'three',

'two', 'two', 'one', 'three'],

'C': np.random.randn(8),

'D': np.random.randn(8)})

kdf.groupby(['A', 'B']).sum()

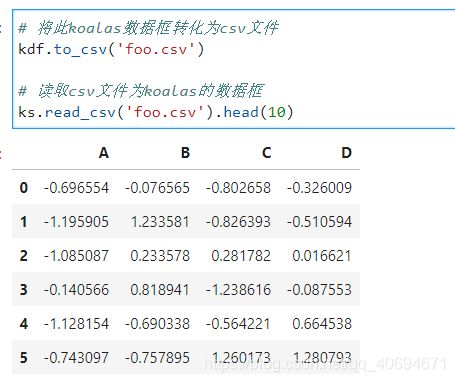

获得的数据输入/输出

- CSV

# 将此koalas数据框转化为csv文件

kdf.to_csv('foo.csv')

# 读取csv文件为koalas的数据框

ks.read_csv('foo.csv').head(10)

- Parquet

Parquet是一种高效和紧凑的文件格式,读取和写入更快。

# 将此koalas数据框转化为Parquet文件格式

kdf.to_parquet('bar.parquet')

# 读取Parquet文件为koalas的数据框

ks.read_parquet('bar.parquet').head(10)

关于koalas数据框的基本操作就介绍到这里。如果各位路过的朋友觉得对自己有帮助的话,麻烦关注一下小编或者点个赞再走哦~