《第1章:统计学习方法概论》

http://www.cnblogs.com/levone/p/3531054.html#2898984

1.4 模型评估与模型选择

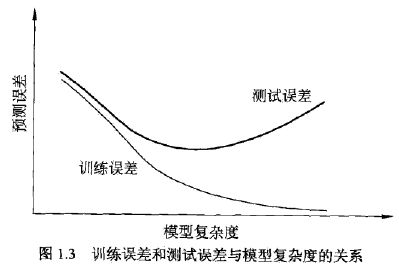

泛化能力(generalization ability):学习方法对未知数据的预测能力。

过拟合(over-fitting):学习时选择的模型所包含的参数过多,以致于出现这一模型对已知数据预测的很好,

但对未知数据预测的很差的现像。

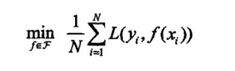

经验风险最小化(empirical risk minimization, ERM):即求解损失函数最小化:

当模型是条件概率分布,损失函数是对数损失函数时,ERM等价于极大似然估计(maximum likelihood estimation)。

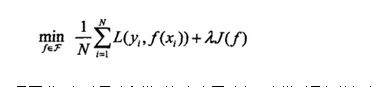

结构风险最小化(structural risk minimization, SRM):当样本容量很小时,容易产生过拟合(overfitting)问题,SRM就是为了防止过拟合。SRM等价于正则化(regularization)。SRM就是在ERM的基础上加上表示模型复杂度的正则化项(regularizer)或罚项(penalty term):

即需要满足经验风险和模型复杂度同时小。当模型是条件概率分布,损失函数时对数损失函数,模型复杂度由模型的先验概率表示时,SRM就是贝叶斯估计中的最大后验概率估计(maximum posterior probability estimation, MAP)。

为了使测试误差最小,需要选择复杂度适当的模型。有两种常用的模型选择方法:正则化与交叉验证。

1.5 正则化与交叉验证

结构风险 = 经验风险 + 正则化

如上式所示,第一项为经验风险,第二项为正则化项

正则化:结构风险中的罚项,可以选择参数向量的L1范数,参数向量的L2范数等。

正则化的作用是选择经验风险和结构风险同时较小的模型。

正则化符合奥卡姆剃刀定律(Occam's Razor, Ockham'sRazor):能够较好的解释已知数据且较为简单的模型才是好的模型。

数据集常被切分为三个部分:训练集(training set),验证集(validation set)和测试集(test set),分别用户训练模型,模型的选择以及模型的评估。但在数据不充足的前提下,再切分数据明显是不科学的。

因此引入交叉验证的方法,交叉验证(cross validation)分为:

简单交叉验证:将数据集简单切分为训练集和测试集两部分

S折交叉验证:将数据集切分为S个大小相同的子集,选择S-1个子集训练模型,剩下的一个子集测试模型;重复S次后再选取。

留一交叉验证:用于数据缺乏的情况下。是S折交叉验证的特殊情形S=N。

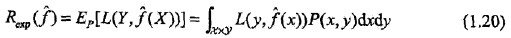

1.6 泛化能力

泛化能力(generalization ability):由该方法学习到的模型对未知数据的预测能力。

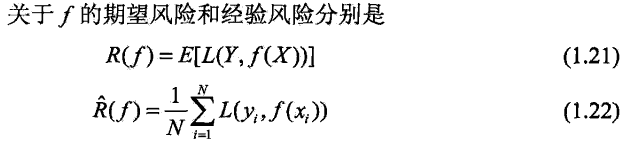

泛化误差(generalization error):就是所学习到的模型的期望风险。

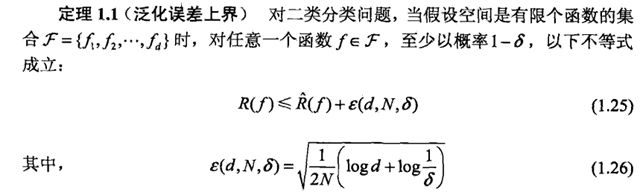

泛化误差上界(generalization error bound):它是样本容量的函数,当样本容量增加时,泛化上界趋于0;它是假设空间容量(capacity)的函数,假设空间容量越大,模型就越难学,泛化误差上界就越大。

第一项是经验误差(训练误差)

第二项,N是样本数量,当N趋于无穷时,这项为0,即期望误差等于经验误差

d表示假设空间中的函数个数,越大就越难学,泛化误差就越大

1.7 生成模型与判别模型

生成方法(generative approach)学到的模型称为生成模型(generative model),由数据学习联合概率分布P(X,Y),然后求出条件概率分布P(Y|X)作为预测模型,即P(Y|X)=P(X,Y)/P(X),典型的生成模型有朴素贝叶斯模型和隐马尔可夫模型。

优点:

可以得到联合概率分布

收敛速度更快

当存在隐变量时,仍可以使用

判别方法(discriminative approach)学到的模型称为判别模型(discriminative model),由数据直接学习决策函数f(X)或条件概率分布P(Y|X),典型的判别模型包括:k近邻算法,感知机,决策树,逻辑斯谛回归模型,最大熵模型,支持向量机,提升方法和条件随机场等。

优点,

学习准确率比较高

便于对数据进行抽象,可以简化学习问题

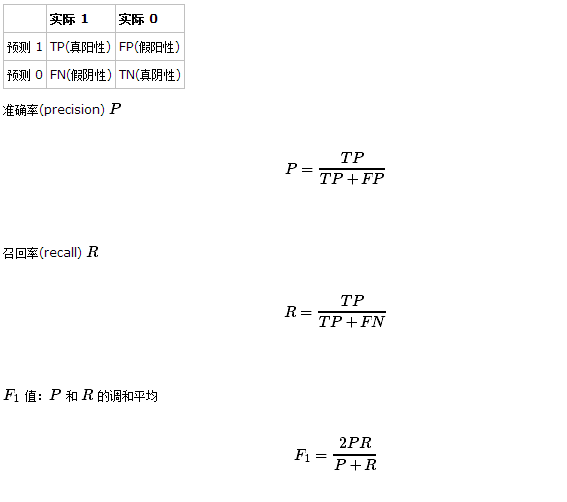

1.8 分类问题

输出变量是有限个离散值时,就是分类问题

学习出的分类模型或分类决策函数称为分类器(classifier)

1.9 标注(tagging)问题

分类问题的推广,输入是一个观测序列,而输出是一个标记序列

典型的应用,词性标注,输入词序列,输出是(词,词性)的标记序列

1.10 回归问题

回归(regression):输入输出都是连续变量,用于预测输入变量和输出变量之间的关系,即选择输入变量到输出变量间的映射函数,等价于函数拟合,选择函数曲线拟合已知数据且很好的预测未知数据。

按照输入变量的个数,分为一元回归和二元回归;按照模型类型,分为线性回归和非线性回归。

第一章主要介绍了一些基本概念,了解这些概念还是很有必要的。