人工智能——小玩意NO.1——《青春有你2》选手识别

《青春有你2》选手识别

- 《青春有你2》选手识别

-

- 人工智能框架

- 图片数据标注预处理

-

- 将收集到的数据用代码来批量标注

- 模型选取和使用方法

-

- 数据准备

- 生成数据读取器

- 配置策略

- 组建Finetune Task

- 开始Finetune

- 对模型进行测试

- 完整人物识别网络模型代码文件

- 扩展玩法

《青春有你2》选手识别

最近比较火的《青春有你2》第一次排名已经正式公布,可惜本人脸盲认不出各位小姐姐,不得已只能借助图像分类网络来帮我解决这个问题。

人工智能框架

在这里我们将借助的是百度研发的paddlepaddle框架,并且百度还提供开发工具PaddleHub,用PaddleHub可以直接下载并,使用定义好的网络结构,大大简便了网络的设计过程。

安装方法: windows下通过pip安装paddlepaddle和paddlehub即可

PaddleHub的更多内容可以去他们GitHub上看看,内容相当丰富:

https://github.com/PaddlePaddle/PaddleHub

图片数据标注预处理

对于训练监督式的神经网络来说最重要的还是数据了,我们需要人为的给数据加标签,这样才能让网络训练的时候明白每张图实际上是谁,这对于网络最后的计算损失值和优化来说相当重要

简单提一下收集数据:可以通过网络爬虫的方法去每个人的百科,微博等地爬取她们的个人照,然后分别存储在各自的文件夹下,方便之后的数据标注。下方图片是我本地的图片保存方式,其中data下面五个文件分别是: ‘安崎’, ‘王承渲’,‘许佳琪’,‘虞书欣’, ‘赵小棠’。

将收集到的数据用代码来批量标注

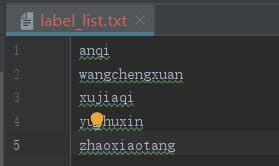

神经网络训练需要将数据集分成训练集,验证集,测试集。另外由于我们使用的是PaddleHub开发工具,还需要生成一个标签集(如下图所示)。

最后main文件夹下面包含的文件只有两个,其中一个是数据批量标注的代码文件,另一个是神经网络训练和预测的代码文件

批量标注的代码如下

通过代码给分类任务的数据做标注还是特别快的,而且可以用代码来直接生成路径和文件。

# 这是create_data.py文件

import os

import numpy as np

names = ['anqi', 'wangchengxuan', 'xujiaqi', 'yushuxin', 'zhaoxiaotang']

path = '..\\data' # 图片存储位置所在文件夹

save_dir = '..\\dataset' # 生成的标注数据保存在该文件夹下

datas = [] # 用来存放每一条标注信息

for root, dirs, files in os.walk(path):

'''

os.walk()会自动遍历路径下所有文件夹及里面的文件

root是当前遍历到的路径

files是当前遍历到的路径下所有的文件组成的列表

'''

if files != None:

for thefile in files:

for i in range(len(names)):

if names[i] in root:

# 将root和thefile两部分拼接起来并通过' '来分隔标签值

# 注意由于开发工具底层代码的原因,路径和标签值的分隔必须是' '

data = root + '\\' + thefile + ' ' + str(i)

datas.append(data)

# 如果路径不存在就创建

if not os.path.exists(save_dir):

os.makedirs(save_dir)

datas = np.array(datas) # 转化为np.ndarray数据类型,方便保存为txt文件

print(datas)

# 将所有标签数据随机打乱后分块,分别作为训练集,验证集,测试集

np.random.shuffle(datas)

train_list = datas[:int(0.8*len(datas))]

val_list = datas[int(0.8*len(datas)): -5]

test_list = datas[-5:]

label_list = np.array(names) # 之前说的标签集

with open("..\\dataset\\test_list.txt", 'ab') as abc: # 写入numpy.ndarray数据

np.savetxt(abc, test_list, fmt='%s') # fmt='%s'以字符格式保存

with open("..\\dataset\\val_list.txt", 'ab') as abc: # 写入numpy.ndarray数据

np.savetxt(abc, val_list, fmt='%s')

with open("..\\dataset\\train_list.txt", 'ab') as abc: # 写入numpy.ndarray数据

np.savetxt(abc, train_list, fmt='%s')

with open("..\\dataset\\label_list.txt", 'ab') as abc: # 写入numpy.ndarray数据

np.savetxt(abc, label_list, fmt='%s')

注意! 数据标注的序号要和label_list.txt中顺序对应,比如在这里,我们将 ‘安崎’, ‘王承渲’,‘许佳琪’,‘虞书欣’, '赵小棠’的图片路径后面分别标注为0,1,2,3,4。那么我们在label_list.txt里面也要按这个顺序输入名称。

模型选取和使用方法

可以直接通过PaddleHub下载相应的预训练模型,使用方便

module = hub.Module(name="resnet_v2_50_imagenet")

数据准备

接着需要加载图片数据集。我们使用自定义的数据进行体验,请查看适配自定义数据

from paddlehub.dataset.base_cv_dataset import BaseCVDataset

class DemoDataset(BaseCVDataset):

def __init__(self):

# 数据集存放位置

self.dataset_dir = "..\\dataset"

super(DemoDataset, self).__init__(

base_path=self.dataset_dir,

train_list_file="train_list.txt",

validate_list_file="val_list.txt",

test_list_file="test_list.txt",

label_list_file="label_list.txt",

)

生成数据读取器

接着生成一个图像分类的reader,reader负责将dataset的数据进行预处理,接着以特定格式组织并输入给模型进行训练。

当我们生成一个图像分类的reader时,需要指定输入图片的大小

data_reader = hub.reader.ImageClassificationReader(

image_width=module.get_expected_image_width(),

image_height=module.get_expected_image_height(),

images_mean=module.get_pretrained_images_mean(),

images_std=module.get_pretrained_images_std(),

dataset=dataset)

配置策略

在进行Finetune前,我们可以设置一些运行时的配置,例如如下代码中的配置,表示:

- use_cuda:设置为False表示使用CPU进行训练。如果您本机支持GPU,且安装的是GPU版本的PaddlePaddle,我们建议您将这个选项设置为True;

- epoch:迭代轮数;

- batch_size:每次训练的时候,给模型输入的每批数据大小为32,模型训练时能够并行处理批数据,因此batch_size越大,训练的效率越高,但是同时带来了内存的负荷,过大的batch_size可能导致内存不足而无法训练,因此选择一个合适的batch_size是很重要的一步;

- log_interval:每隔10 step打印一次训练日志;

- eval_interval:每隔50 step在验证集上进行一次性能评估;

- checkpoint_dir:将训练的参数和数据保存到cv_finetune_turtorial_demo目录中;

- strategy:使用DefaultFinetuneStrategy策略进行finetune;

更多运行配置,请查看RunConfig

同时PaddleHub提供了许多优化策略,如AdamWeightDecayStrategy、ULMFiTStrategy、DefaultFinetuneStrategy等,详细信息参见策略

config = hub.RunConfig(

use_cuda=False, #是否使用GPU训练,默认为False;

num_epoch=5, #Fine-tune的轮数;

checkpoint_dir="cv_finetune_turtorial_demo",#模型checkpoint保存路径, 若用户没有指定,程序会自动生成;

batch_size=3, #训练的批大小,如果使用GPU,请根据实际情况调整batch_size;

eval_interval=10, #模型评估的间隔,默认每100个step评估一次验证集;

strategy=hub.finetune.strategy.DefaultFinetuneStrategy()) #Fine-tune优化策略;

注意!!! 由于不同的电脑内存大小的原因,内存过小可能训练会非常慢,并且电脑会出现卡顿,发热等问题。可以根据个人情况调小batch_size值

组建Finetune Task

有了合适的预训练模型和准备要迁移的数据集后,我们开始组建一个Task。

由于该数据设置是一个二分类的任务,而我们下载的分类module是在ImageNet数据集上训练的千分类模型,所以我们需要对模型进行简单的微调,把模型改造为一个二分类模型:

- 获取module的上下文环境,包括输入和输出的变量,以及Paddle Program;

- 从输出变量中找到特征图提取层feature_map;

- 在feature_map后面接入一个全连接层,生成Task;

input_dict, output_dict, program = module.context(trainable=True)

img = input_dict["image"]

feature_map = output_dict["feature_map"]

feed_list = [img.name]

task = hub.ImageClassifierTask(

data_reader=data_reader,

feed_list=feed_list,

feature=feature_map,

num_classes=dataset.num_labels,

config=config)

开始Finetune

我们选择finetune_and_eval接口来进行模型训练,这个接口在finetune的过程中,会周期性的进行模型效果的评估,以便我们了解整个训练过程的性能变化。

run_states = task.finetune_and_eval()

对模型进行测试

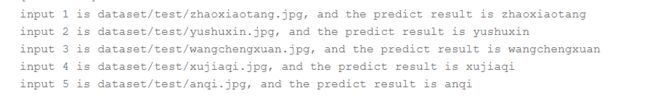

当Finetune完成后,我们使用模型来进行预测,先通过以下命令来获取测试的图片,测试的test_list.txt中只包括五条标注数据,用来判断预测效果是否可靠

with open("../dataset/test_list.txt","r") as f:

filepath = f.readlines()

data = [filepath[0].split(" ")[0],filepath[1].split(" ")[0],filepath[2].split(" ")[0],filepath[3].split(" ")[0],filepath[4].split(" ")[0]]

label_map = dataset.label_dict()

index = 0

run_states = task.predict(data=data)

results = [run_state.run_results for run_state in run_states]

for batch_result in results:

print(batch_result)

batch_result = np.argmax(batch_result, axis=2)[0]

print(batch_result)

for result in batch_result:

index += 1

result = label_map[result]

print("input %i is %s, and the predict result is %s" %

(index, data[index - 1], result))

完整人物识别网络模型代码文件

# 这是main.py文件

import paddlehub as hub

import numpy as np

from paddlehub.dataset.base_cv_dataset import BaseCVDataset

module = hub.Module(name="resnet_v2_50_imagenet")

class DemoDataset(BaseCVDataset):

def __init__(self):

# 数据集存放位置

self.dataset_dir = "..\\dataset"

super(DemoDataset, self).__init__(

base_path=self.dataset_dir,

train_list_file="train_list.txt",

validate_list_file="val_list.txt",

test_list_file="test_list.txt",

label_list_file="label_list.txt",

)

dataset = DemoDataset()

data_reader = hub.reader.ImageClassificationReader(

image_width=module.get_expected_image_width(),

image_height=module.get_expected_image_height(),

images_mean=module.get_pretrained_images_mean(),

images_std=module.get_pretrained_images_std(),

dataset=dataset)

config = hub.RunConfig(

use_cuda=False, #是否使用GPU训练,默认为False;

num_epoch=5, #Fine-tune的轮数;

checkpoint_dir="cv_finetune_turtorial_demo",#模型checkpoint保存路径, 若用户没有指定,程序会自动生成;

batch_size=3, #训练的批大小,如果使用GPU,请根据实际情况调整batch_size;

eval_interval=10, #模型评估的间隔,默认每100个step评估一次验证集;

strategy=hub.finetune.strategy.DefaultFinetuneStrategy()) #Fine-tune优化策略;

input_dict, output_dict, program = module.context(trainable=True)

img = input_dict["image"]

feature_map = output_dict["feature_map"]

feed_list = [img.name]

task = hub.ImageClassifierTask(

data_reader=data_reader,

feed_list=feed_list,

feature=feature_map,

num_classes=dataset.num_labels,

config=config)

run_states = task.finetune_and_eval()

# 测试

with open("../dataset/test_list.txt","r") as f:

filepath = f.readlines()

data = [filepath[0].split(" ")[0],filepath[1].split(" ")[0],filepath[2].split(" ")[0],filepath[3].split(" ")[0],filepath[4].split(" ")[0]]

label_map = dataset.label_dict()

index = 0

run_states = task.predict(data=data)

results = [run_state.run_results for run_state in run_states]

for batch_result in results:

print(batch_result)

batch_result = np.argmax(batch_result, axis=2)[0]

print(batch_result)

for result in batch_result:

index += 1

result = label_map[result]

print("input %i is %s, and the predict result is %s" %

(index, data[index - 1], result))

最后会输出模型下载过程和模型训练过程,会输出loss损失值和acc准确率,预测会输出每一条标注数据图像的是哪一位小姐姐

扩展玩法

通过开发工具PaddleHub制作的人物识别网络,没有人数上的限制,你可以标注更多的人物,再更多的人物中进行识别,并不需要对模型做修改,只需要标注数据的时候增加标注的人数,label_list里面也要随之增加

该神经网络小玩意的数据集大小有100多MB,如果自己不方便弄数据集测试可以留言要数据集