Cookie 是指某些网站服务器为了辨别用户身份和进行Session跟踪,而储存在用户浏览器上的文本文件,Cookie可以保持登录信息到用户下次与服务器的会话。

Cookie原理

HTTP是无状态的面向连接的协议, 为了保持连接状态, 引入了Cookie机制 Cookie是http消息头中的一种属性,包括:

Cookie名字(Name)

Cookie的值(Value)

Cookie的过期时间(Expires/Max-Age)

Cookie作用路径(Path)

Cookie所在域名(Domain),

使用Cookie进行安全连接(Secure)。

前两个参数是Cookie应用的必要条件,另外,还包括Cookie大小(Size,不同浏览器对Cookie个数及大小限制是有差异的)。

Cookie由变量名和值组成,根据 Netscape公司的规定,Cookie格式如下:

Set-Cookie: NAME=VALUE;Expires=DATE;Path=PATH;Domain=DOMAIN_NAME;SECURE

Cookie应用

Cookies在爬虫方面最典型的应用是判定注册用户是否已经登录网站,用户可能会得到提示,是否在下一次进入此网站时保留用户信息以便简化登录手续。

例子:温习下前面的例子(利用Cookie模拟登录)

from urllib import parse

import urllib.request

url =”http://demo.bxcker.com/customer/index.shtml”

#构建一个已经登录过的用户的headers信息

headers={

"Host":"demo.bxcker.com",

"Connection":"keep-alive",

"Pragma":"no-cache",

"Cache-Control":"no-cache",

"Accept":"*/*",

"X-Requested-With":"XMLHttpRequest",

"User-Agent":"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.139 Safari/537.36",

"Referer":"http://demo.bxcker.com/",

"Accept-Encoding":"gzip, deflate",

"Accept-Language":"zh-CN,zh;q=0.9",

"Cookie":"IEX-JSESSIONID=WFPlPUVbbbkQ76XPCr9tXRB4voK0eESo; Hm_lvt_4320d635415dcfd7831a11fa64aec173=1526347940; Hm_lpvt_4320d635415dcfd7831a11fa64aec173=1526347940; SPRING_SECURITY_REMEMBER_ME_COOKIE=UE9kSDFGMnVsS291S2Z2V1k5c1daQT09OjZxWFVDUUhoVmR2UTdsWnRFRnlZZ0E9PQ",

}

# 2. 通过headers里的报头信息(主要是Cookie信息),构建Request对象

request = urllib.request.Request(url,headers=headers)

# 3. 直接访问demo主页,服务器会根据headers报头信息(主要是Cookie信息),判断这是一个已经登录的用户,并返回相应的页面

response = urllib.request.urlopen(request)

4. 打印响应内容

print(html = response.read().decode('utf-8'))

运行结果:

这个例子获取Cookie过程太过复杂,我们先需要在浏览器登录账户,并且设置保存密码,并且通过抓包才能获取这个Cookie,那有么有更简单方便的方法呢?,下面来介绍cookielib库和HTTPCookieProcessor处理器。

http.cookiejar和HTTPCookieProcessor处理器

在Python处理Cookie,一般是通过cookielib模块和 urllib2模块的HTTPCookieProcessor处理器类一起使用。

cookielib模块:主要作用是提供用于存储cookie的对象

HTTPCookieProcessor处理器:主要作用是处理这些cookie对象,并构建handler对象。

cookielib 库

该模块主要的对象有CookieJar、FileCookieJar、MozillaCookieJar、LWPCookieJar。

- CookieJar:管理HTTP cookie值、存储HTTP请求生成的cookie、向传出的HTTP请求添加cookie的对象。整个cookie都存储在内存中,对CookieJar实例进行垃圾回收后cookie也将丢失。

- FileCookieJar (filename,delayload=None,policy=None):从CookieJar派生而来,用来创建FileCookieJar实例,检索cookie信息并将cookie存储到文件中。filename是存储cookie的文件名。delayload为True时支持延迟访问访问文件,即只有在需要时才读取文件或在文件中存储数据。

- MozillaCookieJar (filename,delayload=None,policy=None):从FileCookieJar派生而来,创建与Mozilla浏览器 cookies.txt兼容的FileCookieJar实例。

- LWPCookieJar (filename,delayload=None,policy=None):从FileCookieJar派生而来,创建与libwww-perl标准的 Set-Cookie3 文件格式兼容的FileCookieJar实例。

其实大多数情况下,我们只用CookieJar(),如果需要和本地文件交互,就用 MozillaCookjar() 或 LWPCookieJar()

例子一:获取Cookie,并保存到CookieJar()对象中

import urllib.request

import http.cookiejar

# 构建一个CookieJar对象实例来保存cookie

cookiejar = http.cookiejar.CookieJar()

# 使用HTTPCookieProcessor()来创建cookie处理器对象,参数为CookieJar()对象

handler=urllib.request.HTTPCookieProcessor(cookiejar)

# 通过 build_opener() 来构建opener

opener = urllib.request.build_opener(handler)

# 4. 以get方法访问页面,访问之后会自动保存cookie到cookiejar中

opener.open("http://www.baidu.com")

# 可以按标准格式将保存的Cookie打印出来

cookieStr = ""

for item in cookiejar:

cookieStr = cookieStr + item.name + "=" + item.value + ";"

# 舍去最后一位的分号

print(cookieStr[:-1])

运行的结果:

BAIDUID=AEC69A304375E8C526D3D97F063C5A92:FG=1;BIDUPSID=AEC69A304375E8C526D3D97F063C5A92;H_PS_PSSID=1427_26259_21113_20930;PSTM=1526536198;BDSVRTM=0;BD_HOME=0

我们使用以上方法将Cookie保存到cookiejar对象中,然后打印出了cookie中的值,也就是访问百度首页的Cookie值。

例子二:访问网站获得cookie,并把获得的cookie保存在cookie文件中

import urllib.request

import http.cookiejar

# 保存cookie的本地磁盘文件名

filename = 'cookie.txt'

# 声明一个MozillaCookieJar(有save实现)对象实例来保存cookie,之后写入文件

cookiejar = http.cookiejar.MozillaCookieJar(filename)

# 使用HTTPCookieProcessor()来创建cookie处理器对象,参数为CookieJar()对象

handler = urllib.request.HTTPCookieProcessor(cookiejar)

# 通过 build_opener() 来构建opener

opener = urllib.request.build_opener(handler)

# 创建一个请求,原理同urllib2的urlopen

response = opener.open("http://www.baidu.com")

# 保存cookie到本地文件

cookiejar.save()

运行结果:

例子三:从文件中获取cookies,做为请求的一部分去访问

import urllib.request

import http.cookiejar

# 创建MozillaCookieJar(有load实现)实例对象

cookiejar = http.cookiejar.MozillaCookieJar()

# 从文件中读取cookie内容到变量

cookiejar.load('cookie.txt')

# 使用HTTPCookieProcessor()来创建cookie处理器对象,参数为CookieJar()对象

handler = urllib.request.HTTPCookieProcessor(cookiejar)

# 通过 build_opener() 来构建opener

opener = urllib.request.build_opener(handler)

response = opener.open("http://www.baidu.com")

print(response.read().decode('utf-8'))

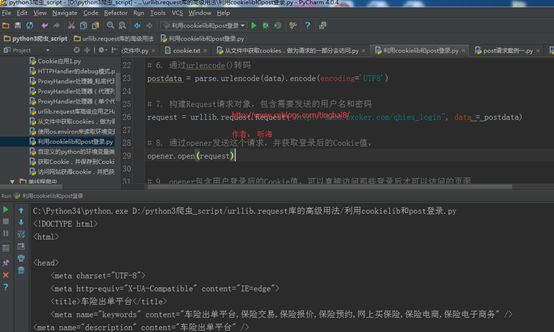

例子四:利用http.cookiejar和post登录网站(http://demo.bxcker.com)

from urllib import parse

import urllib.request

import http.cookiejar

# 1. 构建一个CookieJar对象实例来保存cookie

cookie = http.cookiejar.CookieJar()

# 2. 使用HTTPCookieProcessor()来创建cookie处理器对象,参数为CookieJar()对象

cookie_handler = urllib.request.HTTPCookieProcessor(cookie)

# 3. 通过 build_opener() 来构建opener

opener = urllib.request.build_opener(cookie_handler)

# 4. headers信息

headers ={

"Referer": "http://demo.bxcker.com/",

"Connection": "keep-alive",

"X-Requested-With": "XMLHttpRequest",

"User-Agent": "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.139 Safari/537.36",

"Content-Type": "application/x-www-form-urlencoded",

"Accept-Language": "zh-CN,zh;q=0.9",

}

# 5. 需要登录的账户和密码

data={"username":"demo100","password":"demo100"}

# 6. 通过urlencode()转码

postdata = parse.urlencode(data).encode(encoding='UTF8')

# 7. 构建Request请求对象,包含需要发送的用户名和密码

request = urllib.request.Request("http://demo.bxcker.com/qhiex_login", data = postdata)

# 8. 通过opener发送这个请求,并获取登录后的Cookie值,

opener.open(request)

# 9. opener包含用户登录后的Cookie值,可以直接访问那些登录后才可以访问的页面

response = opener.open("http://demo.bxcker.com/customer/index.shtml")

# 10. 打印响应内容

print(response.read().decode('utf-8'))

运行结果:

通过例子证明,通过这样实现跟“通过抓包工具获取Cookie,再通过获取到的Cookie去爬登录后的信息”相对简单实用。

模拟登录要注意几点:

- 登录一般都会先有一个HTTP GET,用于拉取一些信息及获得Cookie,然后再HTTP POST登录。

- HTTP POST登录的链接有可能是动态的,从GET返回的信息中获取。

- password 有些是明文发送,有些是加密后发送。有些网站甚至采用动态加密的,同时包括了很多其他数据的加密信息,只能通过查看JS源码获得加密算法,再去破解加密,非常困难。

- 大多数网站的登录整体流程是类似的,可能有些细节不一样,所以不能保证其他网站登录成功。