浙大团队发表 3D 视图合成新方法,效果远超 NeRF、NV

By 超神经

内容提要:只需几个不同视角的视频,就能把整个人体形象 360° 无死角地构建起来,不得不说,AI 的脑补能力越来越强大。这样的工具,今后将可能为影视业、体育节目呈现等带来新的突破。

关键词:人体新视图合成 动态 3D

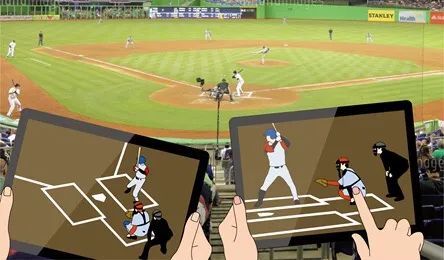

未来,我们的看电影、球赛以及演唱会等的方式,可能被「自由视角视频」(free-viewpoint video)彻底改变。

你可能不知道什么是「自由视角视频」,但你应该体验过 VR、AR 视频,或者玩过 3D 游戏,这些都属于自由视角视频的范畴,其特点便是:可以从任意角度观看,提供完全沉浸式的观感。

观众可以切换任意视角,不再局限于导播镜头

这种视频到底怎么才能拍出来?一般来说,传统的方法是,需要好多台摄像机从不同角度一起拍,然后把所有角度的视频合成在一起。

比如这样,在各个角度布满摄像头获取多个角度的画面

最终合成为自由视角视频

但是这种方式依赖于多个摄像机,不仅成本昂贵,还受限于拍摄场地的环境。

还有一种方式,可以摆脱这些限制,只需输入少量角度拍摄的人体镜头,便可合成 360° 的人体 3D 新视图。这便是来自浙江大学的研究人员,最近发表的最新成果。

12 月底,该团队在 arxiv 上发表了新论文《Neural Body: Implicit Neural Representations with Structured Latent Codes for Novel View Synthesis of Dynamic Humans》,提出一种新的人体表示 Neural Body,用稀疏多视角视频进行动态 3D 人体新视图的合成。经过实验验证,该方法优于此前的其它方法。

Neural Body:用于动态人像新视图合成的结构化潜码隐式神经表征

论文地址:https://arxiv.org/pdf/2012.15838.pdf

值得一提的是,该论文背后的七位作者,均来就读或毕业于浙江大学,并来自浙江大学计算机辅助设计与图形学国家重点实验室。其中,Hujun Bao(鲍虎军)、Xiaowei Zhou(周晓巍)均为该实验室教授,Yinghao Xu(徐英豪) 与 Qianqian Wang 本科毕业后,分别于港中文与康奈尔大学攻读博士学位。

素材不多,也能生成优质 3D 视图

目前,无论是影视节目,或是体育赛事,我们所看到的都是来自单个摄像头所拍摄的画面。如果能够得到「自由视角视频」,想看哪里看哪里,那一定会是上帝视角一般的体验。

事实上,AI 近几年也在研究这个问题,并诞生了诸如 NeRF、Neural Volumes (简称 NV)等视图合成方案。

不过,目前已有的研究表明,在密集的输入视图条件下,学习三维场景的隐式神经表示可以获得很好的视图合成质量。然而,如果视图是高度稀疏的,表示学习将是不适定的。

NeRF(左一)NV (中)与新方法效果对比

前两者均出现失真、变形等问题

因此,为了解决这个不适定问题,来自浙大、港中文和康奈尔大学的研究团队,提出在视频帧上整合观察结果的关键思想。

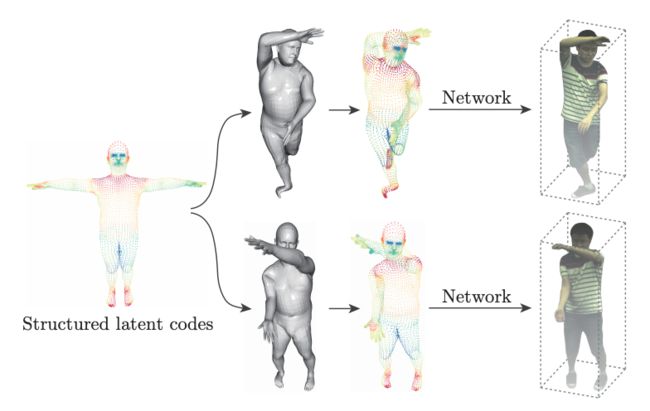

团队的最新研究成果中,提出了 Neural Body。这是一种新的人体表示,它假设在不同帧上学习到的神经表示共享,锚定在一个可变形网格上的相同的潜码集,以便跨帧的观察可以自然地集成。可变形网格也为网络提供了几何指导,以更有效地学习 3D 表示。

Neural Body 的基本思想

研究人员在一个新收集的多视图数据集上进行了实验,结果表明,该方法在视图合成质量方面,与之前的方法相比,具有很大的优势。

团队在 demo 演示中,展示了其方法从做出各种动作的人物的单目视频中,重建移动的人物的能力。

从 4 个角度的视频图像中,得到自由视角视频结果

这一方法大大降低了自由视角视频合成的成本,至少,省下了摄像机的成本,因此也具有更广泛的适用性。

得到 Neural Body,分五步走

一、结构化的潜码

为了控制潜码的空间位置与人体姿态,团队将这些潜码锚定到一个可变形人体模型(SMPL)。SMPL 是一个基于皮肤顶点的模型,它被定义为形状参数、姿势参数和相对于 SMPL 坐标系的刚体变换函数。

潜码与神经网络,一起用于表示人的局部几何和外观。将这些代码锚定在一个可变形的模型上,能够表示一个动态的人。通过动态人的表示,团队建立了一个潜在变量模型,将同一组潜码映射到不同帧的密度和颜色的隐式域中,自然地整合了观察结果。

二、代码扩散

由于结构化的潜码在三维空间中比较稀疏,直接对潜码进行插值会导致大多数三维点的向量为零。为了解决这个问题,团队将表面上定义的潜码扩散到附近的三维空间。

由于代码的扩散不应该受到人在世界坐标系中的位置和方向的影响,他们将代码的位置转换为 SMPL 坐标系。

代码扩散还将结构化潜码的全局和局部信息集合起来,有助于学习隐式域。

三、密度和颜色回归

图(b)概述了三维空间中任意点的密度和颜色的回归

研究团队发现,时间变化因素会影响人体的外观,如二次照明和自阴影。受自动解码器的启发,团队为每个视频帧分配了一个潜在的嵌入框架 t,以编码时间变化的因素。

四、体绘制

在给定的视点下,团队利用经典的体绘制(volume rendering,也称立体渲染)技术,将 Neural Body 渲染成二维图像。

然后,基于 SMPL 模型估计场景边界,接着,Neural Body 会预测这些点的体积密度和颜色。

在体绘制的基础上,通过对渲染图像和观测图像的比较,对模型进行了优化。

五、训练

与基于帧的重建方法相比,该方法利用视频中的所有图像来优化模型,并拥有更多的信息来恢复 3D 结构。

此外,团队采用 Adam 优化器来训练 Neural Body。训练在四个 2080 Ti GPU 上进行。对于一个共 300 帧的四视图视频,训练通常需要大约 14 小时。

经过以上五个步骤,Neural Body 得以实现基于少量视图的自由视角视频合成,而且与其他方法对比,效果明显优于前者。

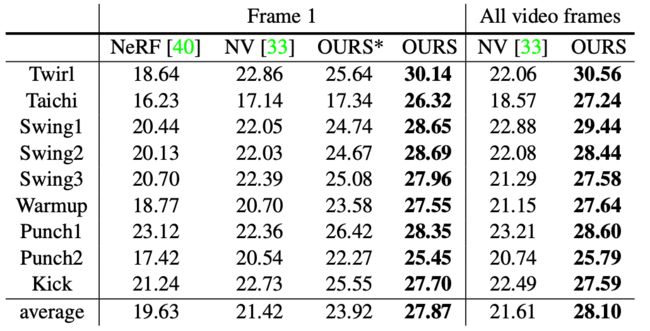

三种方法输出结果的 PSNR(峰值信噪比)对比

数值越大,表明输出图像质量越好

注:「OURS*」 和「OURS」分别代表只在一帧视频和在四帧视频训练的结果)

AI 的脑补技术,让 3D 效果的实现越来越简便,而它的应用也不止是影视业与体育赛事直播领域,对于游戏开发者、健身指导、3D 广告提供商等来说,都是能够大大提升工作效率与效果的工具。

未来的影院、赛场,可能人手一部 iPad,

想看哪里点哪里?

项目主页:

https://zju3dv.github.io/neuralbody/

—— 完 ——

扫描二维码,加入讨论群

获得更多优质数据集

了解人工智能落地应用

关注顶会&论文

回复「读者」了解详情

更多精彩内容(点击图片阅读)

![]()