- 使用Python和OpenCV实现图像像素压缩与解压

东方佑

量子变法pythonopencv开发语言

在本文中,我们将探讨如何使用Python和OpenCV库来实现一种简单的图像像素压缩算法。我们将详细讨论代码的工作原理,并提供一个具体的示例来演示该过程。1.引言随着数字媒体的普及,图像处理成为了一个重要的领域。无论是为了减少存储空间还是加快网络传输速度,图像压缩技术都扮演着至关重要的角色。这里,我们提出了一种基于像素重复模式的简单压缩算法,它适用于具有大量连续相同像素值的图像。2.技术栈介绍2.

- 【Python系列】Python 解释器的站点配置

Kwan的解忧杂货铺@新空间代码工作室

s1Pythonpython开发语言

欢迎来到我的博客,很高兴能够在这里和您见面!希望您在这里可以感受到一份轻松愉快的氛围,不仅可以获得有趣的内容和知识,也可以畅所欲言、分享您的想法和见解。推荐:kwan的首页,持续学习,不断总结,共同进步,活到老学到老导航檀越剑指大厂系列:全面总结java核心技术点,如集合,jvm,并发编程redis,kafka,Spring,微服务,Netty等常用开发工具系列:罗列常用的开发工具,如IDEA,M

- 利用Beautiful Soup和Pandas进行网页数据抓取与清洗处理实战

傻啦嘿哟

pandas

目录一、准备工作二、抓取网页数据三、数据清洗四、数据处理五、保存数据六、完整代码示例七、总结在数据分析和机器学习的项目中,数据的获取、清洗和处理是非常关键的步骤。今天,我们将通过一个实战案例,演示如何利用Python中的BeautifulSoup库进行网页数据抓取,并使用Pandas库进行数据清洗和处理。这个案例不仅适合初学者,也能帮助有一定经验的朋友快速掌握这两个强大的工具。一、准备工作在开始之

- python做一个注册界面_python如何做一个登录注册界面

weixin_39824033

python做一个注册界面

python做一个登录注册界面的方法:首先初始化一个window界面,并使用画布实现欢迎的logo;然后用代码实现登录和注册按钮;接着并进行登录判断代码;最后完成注册界面即可。【相关学习推荐:python视频教程】python做一个登录注册界面的方法:一、登录界面1、首先初始化一个window界面window=tk.Tk()window.title('WelcometoMofanPython')w

- python读取zip包内文件_Python模块学习:zipfile zip文件操作

weixin_40001634

python读取zip包内文件

最近在写一个网络客户端下载程序,用于下载服务器上的数据。有些数据(如文本,office文档)如果直接传输的话,将会增加通信的数据量,使下载时间变长。服务器在传输这些数据之前先对其进行压缩,客户端接收到数据之后进行解压,这样可以减小网通传输数据的通信量,缩短下载的时间,从而增加客户体验。以前用C#做类似应用程序的时候,我会用SharpZipLib这个开源组件,现在用Python做类似的工作,只要使用

- python制作登陆窗口_python登陆界面

weixin_39758494

python制作登陆窗口

广告关闭腾讯云11.11云上盛惠,精选热门产品助力上云,云服务器首年88元起,买的越多返的越多,最高返5000元!print(账号密码错误!请重试。)returnfalsebutton(master,text=登陆,width=10,command=test).grid(row=3,column=0,sticky=w,padx=10,pady=5)button(master,text=退出,wid

- 如何使用零配置的Sphinx生成Python文档?

潮易

sphinx全文检索搜索引擎

如何使用零配置的Sphinx生成Python文档?在Python编程中,编写文档是非常重要的。一个好的文档可以帮助其他开发者理解和使用你的代码。Sphinx是一个用于生成Python项目的文档的静态网页生成器,它支持多种文档格式,包括ReStructuredText和Markdown。以下是使用零配置的方式来使用Sphinx生成Python文档的详细步骤:1.首先,确保你已经安装了Sphinx。打

- 如何订阅&q;/扫描&q;主题、修改消息并发布到新主题?

潮易

python开发语言

如何订阅&q;/扫描&q;主题、修改消息并发布到新主题?这个问题涉及到Python编程中的MQTT(MessageQueuingTelemetryTransport)库的使用,该库允许我们创建客户端订阅和发布消息到MQTT服务器。以下是一个简单的步骤:1.安装MQTT库:可以使用pip安装`paho-mqtt`库。```pythonpipinstallpaho-mqtt```2.创建一个MQTT客

- Python-tkinter自制登录界面(含注册)

GCHEK

python开发语言

简单的用户登录、注册界面importtkinterastkimporttimeimportsubprocessimportsysimportosimporttkinter.messageboxwindow=tk.Tk()window.title('GCHEK')window.geometry('400x300')#设置储存用户信息的容器,这里用的txt。ifnotos.path.exists('U

- Python爬虫requests(详细)

dme.

Python爬虫零基础入门爬虫python

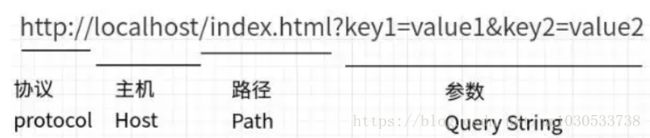

本文来学爬虫使用requests模块的常见操作。1.URL参数无论是在发送GET/POST请求时,网址URL都可能会携带参数,例如:http://www.5xclass.cn?age=19&name=dengres=requests.get(url="https://www.5xclass.cn?age=19&name=deng")res=requests.get(url="https://www

- 使用python计算等比数列求和的方法

HAMYHF

windows

在python中,计算Sum=m+mm+mmm+mmmm+.....+mmmmm.....,输入两个数m,n。m的位数累加到n的值,列出算式并计算出结果:#为了打印出算式,并计算出结果,将m,mm这些放入到列表中#定义列表中的m初始值为0,用Ele来代表m,mm....Ele=0#定义总和为0Sum=0#定义一个空列表List=[]#输入两个值n=int(input("inputadigit:")

- Python+Playwright常用元素定位方法

HAMYHF

python功能测试

CSSselector选择器在CSS中,定位元素主要通过选择器完成,以下是几种常见的CSS选择器定位方法:标签选择器(element):直接使用HTML元素名称来定位,例如p会选择所有段落元素。属性选择器(attribute):选择所有具有指定属性的元素,无论该属性的值是什么。例如,[title]会选择所有包含title属性的元素。选择具有指定属性,并且该属性值完全等于给定值的元素。例如,[typ

- Python中的 redis keyspace 通知_python 操作redis psubscribe(‘__keyspace@0__ ‘)

2301_82243733

程序员python学习面试

最后Python崛起并且风靡,因为优点多、应用领域广、被大牛们认可。学习Python门槛很低,但它的晋级路线很多,通过它你能进入机器学习、数据挖掘、大数据,CS等更加高级的领域。Python可以做网络应用,可以做科学计算,数据分析,可以做网络爬虫,可以做机器学习、自然语言处理、可以写游戏、可以做桌面应用…Python可以做的很多,你需要学好基础,再选择明确的方向。这里给大家分享一份全套的Pytho

- Python数据分析与可视化

程序媛小果

pythonpython数据分析开发语言

Python数据分析与可视化在数据驱动的商业世界中,数据分析和可视化成为了理解复杂数据集、做出明智决策的关键工具。Python,作为一种功能强大且易于学习的编程语言,提供了丰富的库和框架,使得数据分析和可视化变得简单高效。本文将探讨Python在数据分析和可视化中的应用,包括数据预处理、分析、以及如何通过可视化工具将数据洞察转化为可操作的策略。1.数据分析的重要性数据分析是提取数据中有用信息的过程

- 【Python 学习 / 7】模块与文件操作

卜及中

Python基础python学习数据库

文章目录前言一、导入模块1.导入整个模块2.导入模块中的特定函数3.给模块或函数起别名二、常用模块1.`math`模块2.`random`模块3.`os`模块4.`sys`模块三、文件处理1.打开文件2.读取文件3.写入文件4.关闭文件5.使用`with`语句管理文件四、日期时间1.`datetime`模块获取当前日期和时间创建日期和时间对象格式化日期和时间解析字符串为日期对象2.`time`模块

- 经销商管理系统架构设计方案(附 Java版本和Python版本源代码详解)

AI天才研究院

DeepSeekR1&大数据AI人工智能大模型AI大模型企业级应用开发实战AI大模型应用入门实战与进阶计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

经销商管理系统架构设计方案(Java实现源代码详解)关键词:经销商管理系统,Java,SpringBoot,MyBatis,MySQL,架构设计,源代码1.背景介绍随着市场竞争的日益激烈,企业对经销商的管理越来越重视。传统的经销商管理方式效率低下,信息滞后,难以适应现代企业的发展需求。为了提高经销商管理效率,降低运营成本,越来越多的企业开始采用信息化的手段来管理经销商,而经销商管理系统应运而生。经

- Python:数据从Excel表格链接到Word文档 更新Excel即可自动更新Word

一个花生米生花

pythonexcelword

要使用Python来创建或更新一个Word文档,并将数据从Excel表格链接到Word文档中,你可以使用python-docx库来操作Word文档和openpyxl或pandas库来读取Excel文件。不过,需要注意的是,python-docx库并不支持将外部文件链接到Word文档的功能。你可以在Word文档中插入Excel数据的快照,但它们不会自动更新。如果你想要在Word文档中插入Excel数

- 使用Odoo Shell卸载模块

odoo中国

odooodoo开源软件erp

使用OdooShell卸载模块我们在Odoo使用过程中,因为模块安装错误或者前端错误等导致odoo无法通过界面登录,这时候你可以使用OdooShell来卸载模块。OdooShell是一个交互式Pythonshell,允许你直接与Odoo数据库和模型进行交互。以下是使用OdooShell卸载模块的详细步骤:步骤1:启动OdooShell要启动OdooShell,你需要在终端中运行以下命令。确保你已经

- NumPy的基本使用

Mo思

编程学习numpypython开发语言pip

在Python的数据科学与数值计算领域,NumPy无疑是一颗耀眼的明星。作为Python中用于科学计算的基础库,NumPy提供了高效的多维数组对象以及处理这些数组的各种工具。本文将带您深入了解NumPy的基本使用,感受它的强大魅力。一、安装与导入在使用NumPy之前,首先要确保它已经安装在您的Python环境中。如果您使用的是Anaconda发行版,NumPy通常已经预装。若未安装,可以使用如下命

- FOKS-TROT: 一个高效、易用的全功能开源知识图谱生成工具

柳旖岭

FOKS-TROT:一个高效、易用的全功能开源知识图谱生成工具项目简介FOKS-TROT是一个基于Python的全功能开源知识图谱生成工具,旨在帮助研究人员和开发者快速构建具有丰富信息的知识图谱。该项目由hkx3upper在GitCode上开发并维护。通过FOKS-TROT,您可以轻松地将各种数据源(如文本文件、数据库、API)转换为结构化的知识图谱,并对其进行可视化分析和机器学习任务。此外,该工

- python实现word文档合并 v2.0

task138

python自动化python自动化运维开发

目录前言要求运行效果脚本下载链接前言之前发表了一个小工具,python用于合并word文档以完成特定的工作任务,现在领导给出了新需求,适当的调整了一下word文档的合并情况。同时,各位同事反馈说,环境部署太难了,脚本的使用成本比较高,难度大,所以我这次把脚本打包成一个EXE可执行文件,直接双击即可使用。要求由于脚本的具体逻辑发生了变化,因此,exe文件的同级目录下,一定要存在一个txt文件,否则无

- 2025年全国CTF夺旗赛-从零基础入门到竞赛,看这一篇就稳了!

白帽安全-黑客4148

安全web安全网络网络安全CTF

目录一、CTF简介二、CTF竞赛模式三、CTF各大题型简介四、CTF学习路线4.1、初期1、html+css+js(2-3天)2、apache+php(4-5天)3、mysql(2-3天)4、python(2-3天)5、burpsuite(1-2天)4.2、中期1、SQL注入(7-8天)2、文件上传(7-8天)3、其他漏洞(14-15天)4.3、后期五、CTF学习资源5.1、CTF赛题复现平台5.

- 2025年全国CTF夺旗赛-从零基础入门到竞赛,看这一篇就稳了!

白帽安全-黑客4148

网络安全web安全linux密码学CTF

目录一、CTF简介二、CTF竞赛模式三、CTF各大题型简介四、CTF学习路线4.1、初期1、html+css+js(2-3天)2、apache+php(4-5天)3、mysql(2-3天)4、python(2-3天)5、burpsuite(1-2天)4.2、中期1、SQL注入(7-8天)2、文件上传(7-8天)3、其他漏洞(14-15天)4.3、后期五、CTF学习资源5.1、CTF赛题复现平台5.

- 基于python深度学习遥感影像地物分类与目标识别、分割实践技术应用

xiao5kou4chang6kai4

深度学习遥感勘测python深度学习分类

专题一:深度学习发展与机器学习深度学习的历史发展过程机器学习,深度学习等任务的基本处理流程梯度下降算法讲解不同初始化,学习率对梯度下降算法的实例分析从机器学习到深度学习算法专题二深度卷积网络、卷积神经网络、卷积运算的基本原理池化操作,全连接层,以及分类器的作用BP反向传播算法的理解一个简单CNN模型代码理解特征图,卷积核可视化分析专题三TensorFlow与keras介绍与入门TensorFlow

- python 快速实现链接转 word 文档

嘿嘿潶黑黑

pythonword

python快速实现链接转word文档演示代码展示最后演示代码展示fromnewspaperimportArticlefromdocximportDocumentfromdocx.sharedimportPt,RGBColorfromdocx.enum.styleimportWD_STYLE_TYPEfromdocx.oxml.nsimportqn#tkinterGUIimporttkintera

- Python入门笔记

「已注销」

计算机

文章目录第0周课程导学第1周Python基本语法元素保留字数据类型语句与函数输入函数第2周Python基本图形绘制turtle库绝对坐标海龟坐标turtle角度坐标体系RGB色彩体系画笔控制函数运动控制函数方向控制函数循环语句第3周基本数据类型整型浮点数科学计数法复数类型数值运算操作符二元操作符有对应的增强赋值操作符数值运算函数字符串类型的表示字符串切片字符串类型及操作字符串类型格式化time库时

- pythonxml模块高级用法_Python minidom模块用法示例【DOM写入和解析XML】

Lucy-露西娅

pythonxml模块高级用法

本文实例讲述了Pythonminidom模块用法。分享给大家供大家参考,具体如下:一、DOM写XML文件#-*-coding:utf-8-*-#!python3#导入minidomfromxml.domimportminidom#1.创建DOM树对象dom=minidom.Document()#2.创建根节点。每次都要用DOM对象来创建任何节点。root_node=dom.createElemen

- React 渲染 Flash 接口数据

ox0080

#北漂+滴滴出行VIP激励Webreact.js前端前端框架

1.后端Python代码使用Flask创建多个接口,每个接口返回不同的数据,并使用自定义装饰器来绑定路由。代码:#app.pyfromflaskimportFlask,jsonifyapp=Flask(__name__)defapi_route(route,methods=['GET']):"""自定义装饰器,用于将函数与HTTP路由绑定"""defdecorator(func):app.rout

- LQB---基础练习---十六进制转八进制

「已注销」

#LQBLQB

试题基础练习十六进制转八进制资源限制内存限制:512.0MBC/C++时间限制:1.0sJava时间限制:3.0sPython时间限制:5.0s问题描述给定n个十六进制正整数,输出它们对应的八进制数。输入格式输入的第一行为一个正整数n(1<=n<=10)。接下来n行,每行一个由09、大写字母AF组成的字符串,表示要转换的十六进制正整数,每个十六进制数长度不超过100000。输出格式输出n行,每行为

- 【2025年】全国CTF夺旗赛-从零基础入门到竞赛,看这一篇就稳了!

网安詹姆斯

web安全CTF网络安全大赛pythonlinux

【2025年】全国CTF夺旗赛-从零基础入门到竞赛,看这一篇就稳了!基于入门网络安全/黑客打造的:黑客&网络安全入门&进阶学习资源包目录一、CTF简介二、CTF竞赛模式三、CTF各大题型简介四、CTF学习路线4.1、初期1、html+css+js(2-3天)2、apache+php(4-5天)3、mysql(2-3天)4、python(2-3天)5、burpsuite(1-2天)4.2、中期1、S

- Spring4.1新特性——综述

jinnianshilongnian

spring 4.1

目录

Spring4.1新特性——综述

Spring4.1新特性——Spring核心部分及其他

Spring4.1新特性——Spring缓存框架增强

Spring4.1新特性——异步调用和事件机制的异常处理

Spring4.1新特性——数据库集成测试脚本初始化

Spring4.1新特性——Spring MVC增强

Spring4.1新特性——页面自动化测试框架Spring MVC T

- Schema与数据类型优化

annan211

数据结构mysql

目前商城的数据库设计真是一塌糊涂,表堆叠让人不忍直视,无脑的架构师,说了也不听。

在数据库设计之初,就应该仔细揣摩可能会有哪些查询,有没有更复杂的查询,而不是仅仅突出

很表面的业务需求,这样做会让你的数据库性能成倍提高,当然,丑陋的架构师是不会这样去考虑问题的。

选择优化的数据类型

1 更小的通常更好

更小的数据类型通常更快,因为他们占用更少的磁盘、内存和cpu缓存,

- 第一节 HTML概要学习

chenke

htmlWebcss

第一节 HTML概要学习

1. 什么是HTML

HTML是英文Hyper Text Mark-up Language(超文本标记语言)的缩写,它规定了自己的语法规则,用来表示比“文本”更丰富的意义,比如图片,表格,链接等。浏览器(IE,FireFox等)软件知道HTML语言的语法,可以用来查看HTML文档。目前互联网上的绝大部分网页都是使用HTML编写的。

打开记事本 输入一下内

- MyEclipse里部分习惯的更改

Array_06

eclipse

继续补充中----------------------

1.更改自己合适快捷键windows-->prefences-->java-->editor-->Content Assist-->

Activation triggers for java的右侧“.”就可以改变常用的快捷键

选中 Text

- 近一个月的面试总结

cugfy

面试

本文是在学习中的总结,欢迎转载但请注明出处:http://blog.csdn.net/pistolove/article/details/46753275

前言

打算换个工作,近一个月面试了不少的公司,下面将一些面试经验和思考分享给大家。另外校招也快要开始了,为在校的学生提供一些经验供参考,希望都能找到满意的工作。

- HTML5一个小迷宫游戏

357029540

html5

通过《HTML5游戏开发》摘抄了一个小迷宫游戏,感觉还不错,可以画画,写字,把摘抄的代码放上来分享下,喜欢的同学可以拿来玩玩!

<html>

<head>

<title>创建运行迷宫</title>

<script type="text/javascript"

- 10步教你上传githib数据

张亚雄

git

官方的教学还有其他博客里教的都是给懂的人说得,对已我们这样对我大菜鸟只能这么来锻炼,下面先不玩什么深奥的,先暂时用着10步干净利索。等玩顺溜了再用其他的方法。

操作过程(查看本目录下有哪些文件NO.1)ls

(跳转到子目录NO.2)cd+空格+目录

(继续NO.3)ls

(匹配到子目录NO.4)cd+ 目录首写字母+tab键+(首写字母“直到你所用文件根就不再按TAB键了”)

(查看文件

- MongoDB常用操作命令大全

adminjun

mongodb操作命令

成功启动MongoDB后,再打开一个命令行窗口输入mongo,就可以进行数据库的一些操作。输入help可以看到基本操作命令,只是MongoDB没有创建数据库的命令,但有类似的命令 如:如果你想创建一个“myTest”的数据库,先运行use myTest命令,之后就做一些操作(如:db.createCollection('user')),这样就可以创建一个名叫“myTest”的数据库。

一

- bat调用jar包并传入多个参数

aijuans

下面的主程序是通过eclipse写的:

1.在Main函数接收bat文件传递的参数(String[] args)

如: String ip =args[0]; String user=args[1]; &nbs

- Java中对类的主动引用和被动引用

ayaoxinchao

java主动引用对类的引用被动引用类初始化

在Java代码中,有些类看上去初始化了,但其实没有。例如定义一定长度某一类型的数组,看上去数组中所有的元素已经被初始化,实际上一个都没有。对于类的初始化,虚拟机规范严格规定了只有对该类进行主动引用时,才会触发。而除此之外的所有引用方式称之为对类的被动引用,不会触发类的初始化。虚拟机规范严格地规定了有且仅有四种情况是对类的主动引用,即必须立即对类进行初始化。四种情况如下:1.遇到ne

- 导出数据库 提示 outfile disabled

BigBird2012

mysql

在windows控制台下,登陆mysql,备份数据库:

mysql>mysqldump -u root -p test test > D:\test.sql

使用命令 mysqldump 格式如下: mysqldump -u root -p *** DBNAME > E:\\test.sql。

注意:执行该命令的时候不要进入mysql的控制台再使用,这样会报

- Javascript 中的 && 和 ||

bijian1013

JavaScript&&||

准备两个对象用于下面的讨论

var alice = {

name: "alice",

toString: function () {

return this.name;

}

}

var smith = {

name: "smith",

- [Zookeeper学习笔记之四]Zookeeper Client Library会话重建

bit1129

zookeeper

为了说明问题,先来看个简单的示例代码:

package com.tom.zookeeper.book;

import com.tom.Host;

import org.apache.zookeeper.WatchedEvent;

import org.apache.zookeeper.ZooKeeper;

import org.apache.zookeeper.Wat

- 【Scala十一】Scala核心五:case模式匹配

bit1129

scala

package spark.examples.scala.grammars.caseclasses

object CaseClass_Test00 {

def simpleMatch(arg: Any) = arg match {

case v: Int => "This is an Int"

case v: (Int, String)

- 运维的一些面试题

yuxianhua

linux

1、Linux挂载Winodws共享文件夹

mount -t cifs //1.1.1.254/ok /var/tmp/share/ -o username=administrator,password=yourpass

或

mount -t cifs -o username=xxx,password=xxxx //1.1.1.1/a /win

- Java lang包-Boolean

BrokenDreams

boolean

Boolean类是Java中基本类型boolean的包装类。这个类比较简单,直接看源代码吧。

public final class Boolean implements java.io.Serializable,

- 读《研磨设计模式》-代码笔记-命令模式-Command

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

import java.util.ArrayList;

import java.util.Collection;

import java.util.List;

/**

* GOF 在《设计模式》一书中阐述命令模式的意图:“将一个请求封装

- matlab下GPU编程笔记

cherishLC

matlab

不多说,直接上代码

gpuDevice % 查看系统中的gpu,,其中的DeviceSupported会给出matlab支持的GPU个数。

g=gpuDevice(1); %会清空 GPU 1中的所有数据,,将GPU1 设为当前GPU

reset(g) %也可以清空GPU中数据。

a=1;

a=gpuArray(a); %将a从CPU移到GPU中

onGP

- SVN安装过程

crabdave

SVN

SVN安装过程

subversion-1.6.12

./configure --prefix=/usr/local/subversion --with-apxs=/usr/local/apache2/bin/apxs --with-apr=/usr/local/apr --with-apr-util=/usr/local/apr --with-openssl=/

- sql 行列转换

daizj

sql行列转换行转列列转行

行转列的思想是通过case when 来实现

列转行的思想是通过union all 来实现

下面具体例子:

假设有张学生成绩表(tb)如下:

Name Subject Result

张三 语文 74

张三 数学 83

张三 物理 93

李四 语文 74

李四 数学 84

李四 物理 94

*/

/*

想变成

姓名 &

- MySQL--主从配置

dcj3sjt126com

mysql

linux下的mysql主从配置: 说明:由于MySQL不同版本之间的(二进制日志)binlog格式可能会不一样,因此最好的搭配组合是Master的MySQL版本和Slave的版本相同或者更低, Master的版本肯定不能高于Slave版本。(版本向下兼容)

mysql1 : 192.168.100.1 //master mysq

- 关于yii 数据库添加新字段之后model类的修改

dcj3sjt126com

Model

rules:

array('新字段','safe','on'=>'search')

1、array('新字段', 'safe')//这个如果是要用户输入的话,要加一下,

2、array('新字段', 'numerical'),//如果是数字的话

3、array('新字段', 'length', 'max'=>100),//如果是文本

1、2、3适当的最少要加一条,新字段才会被

- sublime text3 中文乱码解决

dyy_gusi

Sublime Text

sublime text3中文乱码解决

原因:缺少转换为UTF-8的插件

目的:安装ConvertToUTF8插件包

第一步:安装能自动安装插件的插件,百度“Codecs33”,然后按照步骤可以得到以下一段代码:

import urllib.request,os,hashlib; h = 'eb2297e1a458f27d836c04bb0cbaf282' + 'd0e7a30980927

- 概念了解:CGI,FastCGI,PHP-CGI与PHP-FPM

geeksun

PHP

CGI

CGI全称是“公共网关接口”(Common Gateway Interface),HTTP服务器与你的或其它机器上的程序进行“交谈”的一种工具,其程序须运行在网络服务器上。

CGI可以用任何一种语言编写,只要这种语言具有标准输入、输出和环境变量。如php,perl,tcl等。 FastCGI

FastCGI像是一个常驻(long-live)型的CGI,它可以一直执行着,只要激活后,不

- Git push 报错 "error: failed to push some refs to " 解决

hongtoushizi

git

Git push 报错 "error: failed to push some refs to " .

此问题出现的原因是:由于远程仓库中代码版本与本地不一致冲突导致的。

由于我在第一次git pull --rebase 代码后,准备push的时候,有别人往线上又提交了代码。所以出现此问题。

解决方案:

1: git pull

2:

- 第四章 Lua模块开发

jinnianshilongnian

nginxlua

在实际开发中,不可能把所有代码写到一个大而全的lua文件中,需要进行分模块开发;而且模块化是高性能Lua应用的关键。使用require第一次导入模块后,所有Nginx 进程全局共享模块的数据和代码,每个Worker进程需要时会得到此模块的一个副本(Copy-On-Write),即模块可以认为是每Worker进程共享而不是每Nginx Server共享;另外注意之前我们使用init_by_lua中初

- java.lang.reflect.Proxy

liyonghui160com

1.简介

Proxy 提供用于创建动态代理类和实例的静态方法

(1)动态代理类的属性

代理类是公共的、最终的,而不是抽象的

未指定代理类的非限定名称。但是,以字符串 "$Proxy" 开头的类名空间应该为代理类保留

代理类扩展 java.lang.reflect.Proxy

代理类会按同一顺序准确地实现其创建时指定的接口

- Java中getResourceAsStream的用法

pda158

java

1.Java中的getResourceAsStream有以下几种: 1. Class.getResourceAsStream(String path) : path 不以’/'开头时默认是从此类所在的包下取资源,以’/'开头则是从ClassPath根下获取。其只是通过path构造一个绝对路径,最终还是由ClassLoader获取资源。 2. Class.getClassLoader.get

- spring 包官方下载地址(非maven)

sinnk

spring

SPRING官方网站改版后,建议都是通过 Maven和Gradle下载,对不使用Maven和Gradle开发项目的,下载就非常麻烦,下给出Spring Framework jar官方直接下载路径:

http://repo.springsource.org/libs-release-local/org/springframework/spring/

s

- Oracle学习笔记(7) 开发PLSQL子程序和包

vipbooks

oraclesql编程

哈哈,清明节放假回去了一下,真是太好了,回家的感觉真好啊!现在又开始出差之旅了,又好久没有来了,今天继续Oracle的学习!

这是第七章的学习笔记,学习完第六章的动态SQL之后,开始要学习子程序和包的使用了……,希望大家能多给俺一些支持啊!

编程时使用的工具是PLSQL