基础知识卷积神经网络

卷积神经网络:卷积核

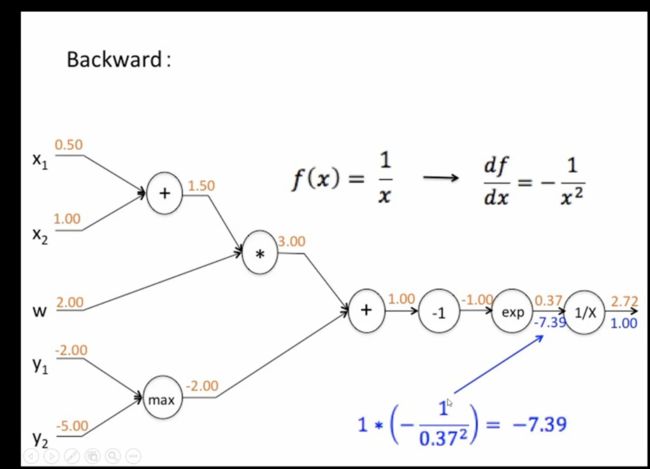

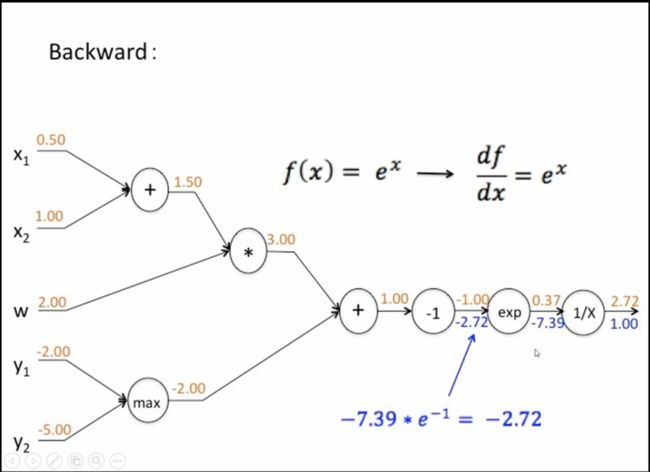

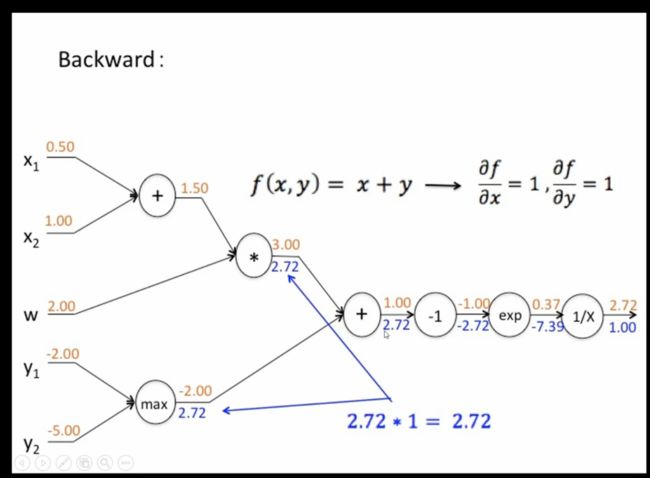

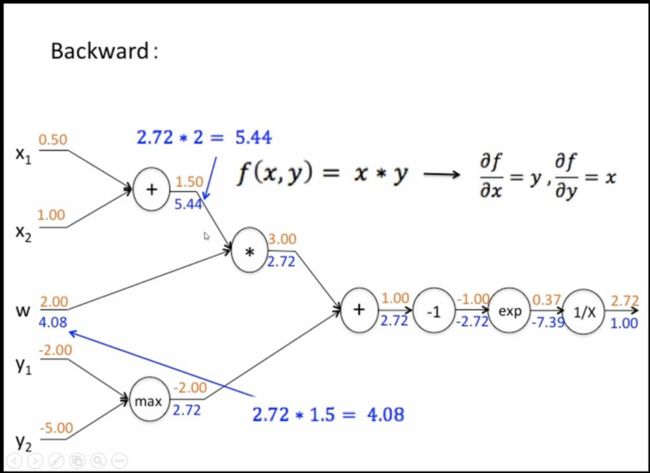

链式反向梯度传导

传导的过程就是导数系数传导的过程。就是前一个导数的结果和当前求导的乘积

卷积层:卷积神经的基本结构,由多个卷积核组成,每个卷积核同输入数据卷积运算形成新的特征图。

这个就说这个卷积层(输入)有多少卷积核运算(5),就会形成同等数量的特征图(输出)(5)。

卷积核:

同属如数据进行的二维或者1or2维算子

大小用户定义。当比较小时,获得更多的细节。大的时候,忽略细节

卷积核矩阵值:卷积神经网络的参数

卷积核初始值随机生成,通过反向反向传播更新。初始值一样不好,趋势非常的类似,缺少变化性。

卷积核组合方式:卷积层--特征图。

一次卷积核运算: 如果卷积层为(100*100)--3*3 (因为从2*2开始运算,99*99停止)卷积核(如果为5*5,开始3*3,结束为98*98,特征图为(96*96))--(98*98)的特征图

综上所述,特征图的大小为:卷基层-卷积核+1

一个卷积核输出为1个数因为当卷积运算相加 例如一次卷积运算: 当100*100*m 卷基层--卷积核(3*3*m)--中间值(1*1*m)--m层相加合并--最后一个输出(结果为二位矩阵),最后就为 98*98的二维矩阵图(厚度为1)

当有多个卷积核,就会产生多个特征图,注意:卷积核的大小可以不同

卷积层:卷积核的大小:

1一般选择奇数(有中心center)

2大小自己选

4覆盖范围:一般全部覆盖,也可以覆盖特定的区域(局域特定区别 例如人脸),

卷基层: 步长: 对输入特征图的扫描间隔:

卷积核3*3

7*7--步长为1--输出5*5

7*7--步长为2--输出3*3

边界扩充:在卷积计算的过程,为了准许边界上的数据也能作为中心参与卷积运算,将边界假装延伸

扩充目的: 确保卷积后的特征图尺度一致

确定方法: 卷积核的宽度2i+1,添加pad宽度为i。(步长为1)

卷积核的数目: 64,128,256. GPU并行更加高效

卷积网络参数计算与传统相比: 参数少了,计算量大了。因为需要计算每个卷积核和每个区域,然后还需要合并。但是参数少了。

卷积层--卷积网络:

正向传播

m:代表层数, i,j 代表具体位置

t代表的第几个卷积核(0 到N)

最后一个公式代表: 用第t个卷积核,从第一个到第m层,从区域i-1,j-1 到 i+1,j+1(因为卷积核为3*3)卷积运算然后相加,等到1*1*m,在相加,等到1*1

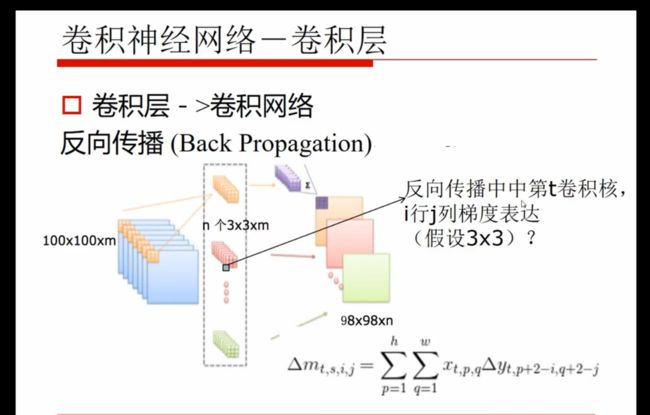

卷基层--卷积网络: 反向传播

n个卷积核,叠加的关系

i,j 对特征图中i-1,j-1 到i+1,j+1 (卷积核为3*3)中这个区域有影响。2i-p,2j-q因为i,j对应的p,q的对应关系。例如i,j,当在卷积核的中心(2,2)(假设下标开始于(1,1)而不是(0,0))时,特征图位置为(i,j),当在卷积核的位置为(1,1)时,特征图对应的位置为 i+1,j+1,当在卷积核的位置为(3,3)时,特征图对应的位置为 i-1,j-1。所以对应公式为2*i-p,2j-q.

yt代表特征图

对卷积核参数的反向求导:

坐标的对应关系,影响相应的整个yt特征图。

卷积神经网络--功能层

非线性激励(ReLu):卷积的线性运算,增加非线性描述功能

降维:特征图稀疏,减少运算量,保持精度poling(max,ave)--每张特征图单独降维)

归一化:特征的scale保持一致--提高精度(批量归一化)--特殊数scale不一致--加快训练,提高精度、、、邻近归一化(分区域归一化)

区域分割:不同区域进行独立学习--独立对某些区域单独学习--学习多套参数,更强的特征描述能力

区域融合:对分开的区域合并,方便信息的融合--不同的卷积核,然后进行融合--级联(拼一起)--运算融合(+-*/,max,conv,ResNet)--RestNet:数据经过神经网络和不经过神经网络相加--信息融合,信息结合和加成,特征更有效

增维:增加图片生成或者探测任务中空间信息