论文阅读:Local-Global Video-Text Interactions for Temporal Grounding

时序定位的局部-全局视频-文字交互

Abstract

摘要

本文针对文本到视频的时域定位问题,旨在识别与文本查询语义相关的视频时间间隔。我们使用一种新的基于回归的模型来解决这个问题,该模型学习为文本查询中的语义短语提取一组中级特征,这些特征对应于查询中描述的重要语义实体(参与者、对象和动作等),并且从多个层次反映查询的语言特征和视频的视觉特征之间的双模态交互。

该方法在双模态交互中,利用从局部到全局的上下文信息,有效的预测了目标时间间隔。通过深度的消融研究,我们发现,在视频和文本交互中结合局部和全局上下文对准确的定位至关重要。我们的实验表明,该方法在xx数据集上的性能远远优于目前的技术水平,在Recall@tIoU=0.5米处,分别为7.44%和4.61%

Introduction

介绍

研究背景

随着网络上的视频数量爆炸性增长,对视频内容的理解并且分析视频(内容分类及探究)变得日益重要。此外,随着基于大规模数据集上深度学习取得的最新进展,对于视频内容理解的研究也开始朝向多模态问题发展(视频问答、视频字幕),包括文字、语言和声音。

解决的问题

本文解决了文字到视频的时域定位问题,旨在定位视频中与文本查询中表达式对应的的时间间隔。

我们的主要想法是从文本查询中提取多个语义短语,并使用语言学与视觉特征的局部与全局交互将他们与视频对齐。我们将语义短语定义为可能描述了一个语义实体的单词序列,如演员、物体、动作、地点等等。

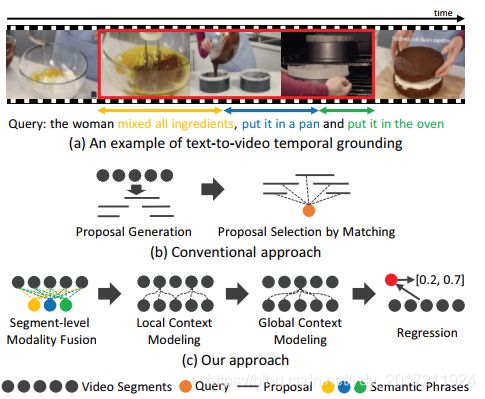

图表1a)展示了一个时域定位的例子:包含多个语义的文本查询对应于演员(一个女人)和动作(混合了所有的原料,将它放在一个平底锅,将它放进烤箱)。这个例子表明了,一个文本查询可以通过从查询中识别相关的语义短语并适当的将它们与对应的视频片段对齐,来有效的定位到视频上。

a)一个例子,目标时间间隔包含了多个与文本查询中语义短语相关的部分

b) scan-and-localize框架,通过将独立建议和查询中的整个语义进行比较,来定位目标时间间隔(现有方法)

c)我们的方法,使用视频片段和查询中识别的语义短语间的三个层次上的双模态交互,来回归目标时间间隔

现有方法的问题

然而,在时域定位的问题上,从未探索过如何利用文本查询中的这种语义短语。

1

大多数现有的方法[1,4,5,8,9,20,32,37]通常 scan-and-localize框架中解决这个问题,简而言之,将查询与所有时间间隔的候选建议进行对比,并选择最高匹配,如图表一b)。在匹配中,他们依靠查询的独立全局特征而不是短语级别的细粒度特征,因此丢失了本地化中的重要细节。

2

最近的研究[35]将该任务定义为通过回归的注意力定位,并试图通过注意力方案从查询中提取语义特征。然而,没有全面理解语境的情况下,这种方法仍局限于识别最具辨识性的语义短语。

我们提出的方法

我们提出如图一所示新颖的基于回归的方法来解决时域定位问题,执行局部-全局的视频-文字交互,对语义短语和视频片段进行深入的关系建模。

与现有的方法相反,我们首先使用序列查询注意力,提取语言学特征查询中的语义短语。

接着我们执行三个层次的视频-文本交互,来有效的将语义短语特征和片段级视觉特征进行匹配:

1)视频片段和语义短语特征进行片段级融合,突出与每个语义短语相关的片段

2)局部上下文建模,这有助于将短语与可变长度的时间区域对齐

3)全局上下文建模,捕捉短语间的连接

最后我们使用时间注意力池化来聚合融合的片段级特征,并使用聚合特征回归时间间隔

主要贡献

我们我们引入了一个顺序查询注意模块,从文本查询中提取多个不同的语义短语表示,用于后续的视频-文本交互

我们提出了一种有效的局部-全局视频-文本交互算法,在多个层次上对视频片段和语义短语之间的关系进行建模,从而通过回归增强最终定位。

我们进行了大量的实验来验证我们的方法的有效性,并表明它在这两方面都比目前的技术水平要好很多,charadessta和ActivityNet标题数据集。

相关工作

2.1 时序行为检测

最近的时间动作检测方法通常依赖于图像领域的最先进的目标检测和分割技术,可以分为以下三组:

首先,一些方法使用帧-级密集预测,根据置信值对帧进行修建并对相邻帧进行分组,来确定时间间隔。

其次,基于建议的技术[27,31,36,38]提取所有的动作提议并细化其边界以进行动作检测

第三,存在一些基于单次检测(如SSD[21])的快速推断方法[18,34]。

与仅限于定位单个动作实例的动作检测任务不同,文本对视频的时间基础需要定位更复杂的间隔,根据句子查询中的描述,这将涉及两个以上的动作。

2.2 Text-to-Video时域定位

从用于text-to-video时域定位的两个数据集DiDeMo Charades-STA发布以来,各种算法[1,8,9,20,37)中已经使用了scan-and-localize框架,基于滑动窗口扫描整个视频获得候选片段,并最终选择与输入文本查询最匹配的剪辑。

方法一

由于滑动窗口方案耗时且常常包含冗余的候选剪辑,因此提出了更有效、更高效的方法[4,5,32]作为替代方案:

提出了一种基于lstm的单流网络[4]来进行帧对字的交互,并提出了基于视频片段生成的方法[5,32]来减少冗余候选剪辑的数量。

尽管这些方法成功的提高了处理时间,他们仍需要观察整个视频,因此,引入了增强学习来观察一部分帧或几个剪辑

方法二

另一方面,无提议算法[10,25,35]也被提出。受最近在基于文本的机器理解方面的进展启发,Ghosh等人[10]提出直接识别与起始和结束位置对应的视频段索引,Opazo等人[25]通过采用查询引导的动态过滤器改进了该方法。Yuan等人[35]提出了一种基于共同注意的位置回归算法,该算法学习注意在ground-truth时间间隔内聚焦于视频片段

方法三

ABLR[35]与我们的算法最相似,因为它将任务定义为基于注意力的位置回归。然而,我们的方法不同于ABLR在以下两个方面。首先,abr只关注查询中最具判别性的语义短语来获取视觉信息,而我们考虑多个语义短语来进行更全面的估计。其次,ABLR依赖于视频和文本输入之间的粗交互,通常无法捕捉视频片段和查询词之间的细粒度关联。

相比之下,我们采用了更有效的多层次视频-文本交互来模拟语义短语和视频片段之间的关联。

3 提出的方法

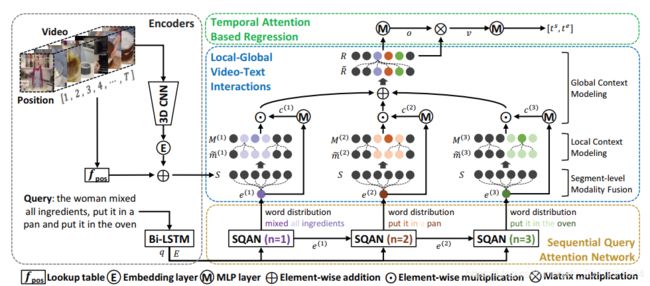

图2。我们算法的总体架构。给定一个视频和一个文本查询,我们对它们进行编码,以获得片段级视觉特征、单词级和句子级文本特征(章节3.2)。我们使用序列从查询中提取一组语义短语特征查询注意网络(SQAN)(章节3.3)。然后,根据提取的短语特征,通过局部-全局视频-文本交互获得语义感知的片段特征(章节3.4)。最后,我们利用时间注意直接从总结的视频特征中预测时间间隔(章节3.5)。我们使用回归损失和两个额外的注意相关损失来训练模型(第3.6节)

3.1 算法总览

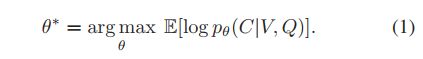

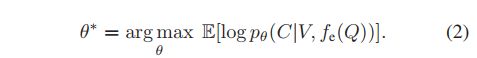

给定一个未修剪的视频V,一个文本查询Q和V内目标区域C的时间间隔,现有的方法通常学习由θ参数化的模型,以最大化以下期望对数似然:

注意,在上面的目标函数中,文本查询Q经常涉及到多个语义短语,如图1(a),除了全局关系外,还需要对查询与视频之间的更精细的关系进行建模,以实现时间定位。

为了实现这一想法,我们引入了一个可微模块fe,将查询表示为一组语义短语,并结合局部-全局视频-文本交互,以深入理解视频中的短语,这导致了一个新的目标函数:

图表2说明了所提方法的总体架构。

我们首先计算片段级视觉特征及其嵌入的时间戳,然后在查询的基础上推导出单词级和句子级特征。

其次,顺序查询注意网络(Sequential Query Attention Network,SQAN)通过顺序关注词级特征从查询中提取多个语义短语特征。

然后,通过多层视频-文本交互获取语义感知的片段特征;通过分段级模态融合和局部上下文建模来突出每个语义短语对应的片段特征,通过全局上下文建模来估计短语之间的关系。

最后,使用临时参与的语义感知段特征预测时间间隔。

3.2 编码器

查询编码

对于有L个单词的文本查询,我们使用一个两层的双向LSTM来获取单词和句子级别的表示。

将双向LSTM应用于嵌入的词特征。通过公式

![]()

将两个方向的隐藏状态串联起来,得到第l位的单词级特征。

而句子级别的特征q是通过连接前向和后向lstm中的最后隐藏状态来提供的。

d表示特征维数

![]()

视频编码

一个未裁剪的视频被分成一个固定长度的片段序列(例如,16帧),其中两个相邻的片段相互重叠一半的长度。

我们在对T个片段进行均匀采样后,使用3D CNN模块fv(·)从单个片段中提取特征,

然后将特征输入到嵌入层,

再通过ReLU函数将其维度与查询特征进行匹配。

形式上,用

![]()

表示一个矩阵,在列上存储了T个采样过的片段特征。如果输入视频较短,且片段数小于T,则用零向量填充缺失部分

我们按照==[6]==的方法,将每个片段的时间位置嵌入到相应的片段特征向量中,以提高实际的精度。

这个过程可以得到如下的视频表示公式:

![]()

![]()

![]()

Wseg表示可学习的段特征嵌入矩阵

fpos为由嵌入矩阵Wpos和和时间戳[1, . . . , T ]定义的查找表

注意dv是由fv(·)提供的特征的尺寸

由于我们将给定的任务表述为位置回归问题,位置编码是在后续过程中识别不同时间位置语义的关键步骤。

3.3 顺序查询注意力网络(SQAN)

(2)中表示为fe(·)的SQAN在识别描述语义实体的语义短语方面起着关键作用,例如,演员,对象和动作,这些都应该在视频中观察到,以实现精确定位。

由于语义短语没有groundtruth,我们以端到端的方式学习它们的表示。

为此,我们采用了一种注意机制,假设语义短语由查询中的单词序列定义,如图1,这些语义短语可以彼此独立提取。然而,请注意,由于我们的目标是获得不同的短语,我们通过前面的序列条件来提取它们,如[13,33]。

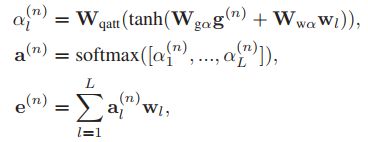

给出L个词级特征的向量E以及一个句子级别的特征q,

![]()

![]()

我们提取了N个语义短语特征

![]()

在每一步n中,通过将线性变换的句子级特征 与前面的语义短语特征e(n−1)∈Rd 连接起来的向量 嵌入 得到一个引导向量g(n)∈Rd

![]()

![]()

为可学习的嵌入矩阵。

请注意,我们在每一步使用不同的嵌入矩阵W(n) q,以便更容易地处理查询的不同方面。

![]()

然后,通过对词级特征上的注意权重向量a(n)∈RL进行估计

并计算词级特征的加权总和,得到当前的语义短语特征e(n),如下:

αl(n)为第l个词在第n步的置信度值

![]()

为可学习嵌入矩阵的查询注意层

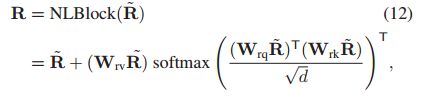

3.4 局部-全局的视频-文本交互

考虑到语义短语的特征,我们在三个层次上进行视频文本交互,以实现两个目标:

1)个体语义短语理解和

2)语义短语之间的关系建模。

单独语义短语理解

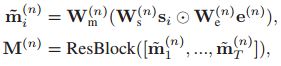

每个语义短语特征在两个层次上与单独的片段特征交互:片段级模态融合和局部上下文建模。

在片段级模态融合中,我们鼓励突出与语义短语特征相关的词段特征,抑制不相关的词段特征。然而,分段级交互不足以正确地理解长期语义实体,因为每个分段都只有16帧的有限视野。因此,我们引入了局部上下文建模,考虑了相邻的独立片段。

考虑到这一点,我们使用Hadamard乘积进行类似==[14]==的片段级模态融合,同时基于残差块建模本地上下文。残差模块(ResBlock)由两个时间卷积层构成。注意,我们在ResBlock中使用了大带宽的内核(例如,15)来覆盖长距离语义实体。整个过程总结如下

![]()

为用于分段级融合可学习的嵌入矩阵

![]()

表示段级融合后的第i个双模态段特征

![]()

表示第n个语义短语特征e(n)的语义专用段特征。

语义短语之间的关系建模

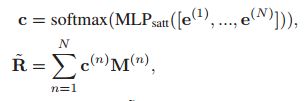

在得到N个具体语义的段特征后,{M(1),…, M(N)},分别考虑语义短语之间的上下文关系和时间关系。

例如,在图1(a)中,在语义短语“把它放在平底锅里”中理解“它”,需要从另一个短语“混合所有成分”的上下文来理解。由于这种关系可以在时间间隔较大的语义短语之间定义,我们通过观察所有其他部分来进行全局上下文建模。

为此,我们首先聚合N个特定于语义短语的段特征{M(1), …, M(N)}。采用注意力池化,根据相应的语义短语特征计算权重

其中MLPsatt表示多层感知器(MLP),其隐含层为d/2维,

c∈RN是N个语义特定的片段特征的权向量。

~R是通过注意力池化得到的聚合特征

然后,我们使用非本地块==[30]==(NLBlock),广泛用于捕获全局上下文

R是使用提出的局部-全局视频-文本交互的最终语义感知片段特征。

![]()

可学习的嵌入矩阵在NLBlock中

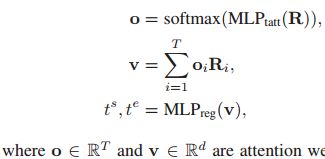

3.5 基于时间注意的回归

一旦获得语义感知的区段特征,我们在使用时间注意机制突出重要区段特征的同时对信息进行总结,最后使用MLP预测时间间隔(ts, te)如下:

分别为片段的关注权值和总结视频特征的关注权值。注意,MLPtatt和MLPreg分别有d2维和d维隐藏层。

3.6 training

我们使用三个损失项训练网络:

1)位置回归损失Lreg

2)时间注意力引导损失Ltag

3)显著的查询注意力损失Ldqa

整体loss为L = Lreg + Ltag + Ldqa.

位置回归损失

==[35]==回归损失定义为归一化的标注时间区间(tˆs, tˆe)∈[0,1]与我们的预测(ts, te)之间光滑L1距离的和,如下

lreg = smoothL1(tˆs−ts) + smoothL1(tˆe−te),

|x| < 1 smoothL1(x)被定义为0.5x^2

否则定义为|x| -0.5

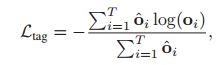

时间注意力引导损失

由于我们直接从时间注意特征回归时间位置,时间注意的质量是至关重要的。因此,我们采用==[35]==中提出的时间注意引导损失

其中,如果第i段位于标注的时间间隔内,oˆi设置为1,否则设置为0。注意引导损失使得模型在与文本查询相关的片段中获得更高的注意权值

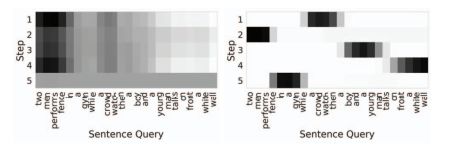

显著的查询注意力损失

虽然SQAN的设计目的是捕捉查询中的不同语义短语,但我们观察到,不同步骤中的查询注意权重通常与图3所示相似。

图3:没有突出查询注意力损失的查询注意力权重可视化(左),与突出查询注意力损失的(右)。SQAN成功地提取出了对应于不同步骤的参与者和动作的语义短语。

因此,我们采用==[19]==中引入的正则化术语,在不同的步骤中强制查询注意权值不同:

![]()

![]()

A为跨越N个步骤的连接的查询注意权重,||·||F表示矩阵的Frobenius范数。

通过使两个不同步骤的查询注意力权重不相关,这种损失鼓励注意力分布有更少的重叠

注意,λ∈[0,1]控制查询注意分布之间的重叠程度;当λ接近1时,注意权重被学习为one-hot向量。图3清楚地表明,正则化术语鼓励模型在查询注意步骤中关注不同的语义短语。

实验

4.1 数据集

Charades-STA

该数据集由[8]从Charades 数据集中采集,用于评估文本-视频时域定位,分别由训练集和测试集中的12408个时间间隔和3720个文本查询对组成。视频的平均长度为30秒,文本查询的最大长度设置为10秒。

ActivityNet Captions

这个数据集最初是为密集视频字幕而构建的,由20k平均长度120秒的YouTube视频组成。分为10,024、4,926和5,044个视频,分别用于训练、验证和测试。视频平均包含3.65个时间区间和句子描述,其中句子描述的平均长度为13.48个单词。按照前面的方法,我们报告我们的算法在验证集(由val 1和val 2表示)上的性能,因为测试分割的注释不公开可用

4.2 指标

跟随==【8】==我们采用两个指标进行性能比较:

1)时域交集不同时间阈值的Recall值(R@tIoU),来测量 标注值大于阈值的tIoU的预测百分比,

2)平均tIoU (mIoU)。我们使用三个tIoU阈值,{0.3,0.5,0.7}。

4.3 应用细节

为了用3D CNN模块在Charades-STA和ActivityNetCaptions数据集上提取分割特征,我们分别使用I3D[3] 2和C3D[28] 3网络,在一个训练步骤中固定它们的参数。我们从每个视频中均匀抽样T(= 128)段。

对于查询编码,我们保持小写转换和标记化后的所有单词标记;Charades-STA和ActivityNetCaptions数据集的词汇量分别为1140和11125。

对于ActivityNetCaptions数据集,我们截断所有最多有25个单词的文本查询。对于顺序查询注意网络(SQAN),我们提取了3个和5个语义短语,Charades-STA和ActivityNetCaptions数据集的λ分别设为0.3和0.2。在所有的实验中,我们使用Adam[15]学习模型,以100个视频查询对和固定的学习速率0.0004。特征维度d设置为512。

4.4 与其他方法比较

我们将我们的算法与最近的几种方法进行了比较,这些方法分为两组:

扫描-定位方法包括MCN [1], CTRL [8], SAP [5], ACL [9],acn [20], MLVI [32], TGN [4], MAN [37], TripNet [11],SMRL [29], RWM [12]

proposal-free算法如ABLR[35]、ExCL[10]、PfTML-GA [25]

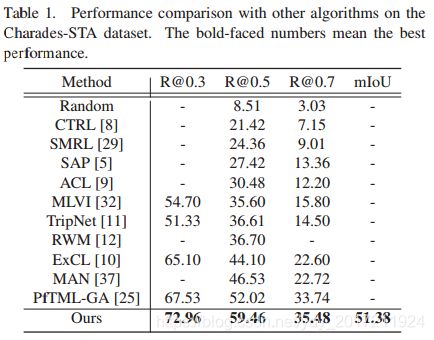

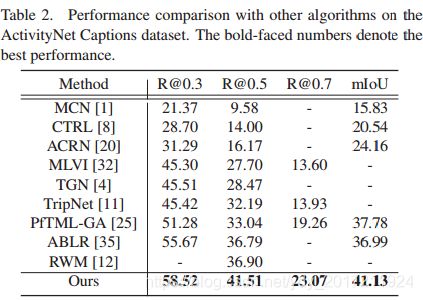

表1和表2分别总结了CharadesSTA和ActivityNet标题数据集上的结果,其中我们的算法优于所有竞争方法。值得注意的是,就[email protected]度量而言,所提议的技术分别比最先进的性能高出7.44%和4.61%。

Charades-STA数据集上与其他算法的性能比较。加粗的数字表示性能最好

ActivityNetCaptions数据集上与其他算法的性能比较。黑体数字表示最好的表现。

4.5 深入分析

为了更好地理解我们的算法,我们分析了各个组件的贡献。

4.5.1 模型简化测试

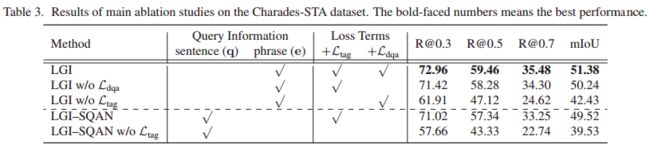

首先研究了顺序查询注意网络(SQAN)和LOSS项对CharadesSTA数据集的影响。

在这个实验中,我们训练5变种模型:

1)LGI:我们的完整模型,执行局部-全局的视频-文字交互,基于SQAN提取的语义表达特征功能,且学习使用所有loss项

2)LGI w / o Ldqa: LGI学习没有突出查询注意Ldqa(不加Ldqa

3)LGI w / o Ltag: LGI学习没有时间注意力引导Ltag,(不加Ltag

4)LGI-SQAN:一个本地化文本查询的模型,使用了sentencelevel特性q而没有SQAN,(不加SQAN

5) LGI-SQAN没有Ltag

请注意,在补充材料中描述了LGI-SQAN的架构。

表3:Charades-STA数据集模型简化研究结果。黑体字表示性能最好。

不同模块的具体作用

表3总结了我们观察到的以下结果。首先,从查询中提取语义短语特征(LGI)比单纯依赖句子级表示(LGI -SQAN)更有效地实现精确定位。其次,使用Ldqa对查询的显著性注意权重进行正则化,通过捕获不同的语义短语,提高了性能。第三,时间注意力引导损失Ltag通过使模型在目标时间间隔内聚焦于段特征来提高定位精度。最后,注意到LGI-SQAN的性能已经超过了[email protected]上最先进的方法(即52.02% vs.57.34%),这表明了所提出的局部-全局视频文本交互在建模视频片段和查询之间的关系方面的优越性。

参数调节 N和λ

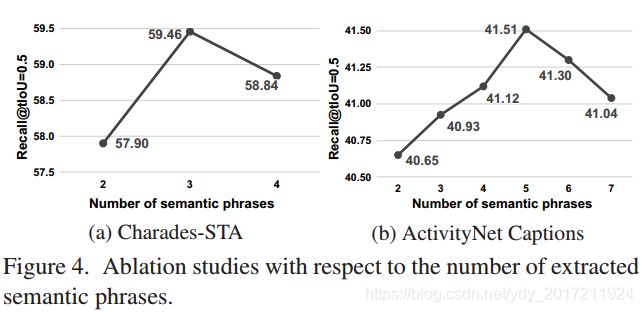

图4:关于提取的语义短语的数量的Ablation studies

我们还在两个数据集上分析了SQAN中两个超参数的影响,sqa - ldqa中的语义短语数(N)和控制值(λ)。图4展示了在SQAN中语义短语数量的结果,在这些结果中,性能一直增加到一定数量然后减少(3和5分别用于Charades-STA和ActivityNetCaptions数据集),这是因为较大的N使模型捕捉更短的短语,不能描述正确的语义。

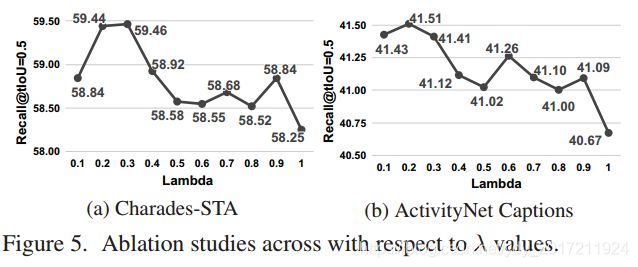

如图5所示,控制值λ为0.2和0.3通常性能良好,而更高的λ通过使模型集中在一个或两个单词作为短语,性能较差。

4.5.2 局部-全局视频-文本交互分析

我们对Charades-STA数据集上的局部-全局交互进行深入分析。为了做这个实验,我们使用了

LGI - sqan(代替LGI)作为我们的基础算法,以节省训练时间。

局部和全局上下文建模的影响

我们通过改变残差块(ResBlock)中的内核大小(k)和非本地块(NLBlock)中的块数量(b)来研究局部和全局上下文建模的影响。

对于局部上下文建模,除了ResBlock外,我们还采用了一个额外的模块,称为masked非局部块(Masked NL);掩码将注意力区域限制为一个局部范围,在NLBlock中以单个段为中心的固定窗口大小w。

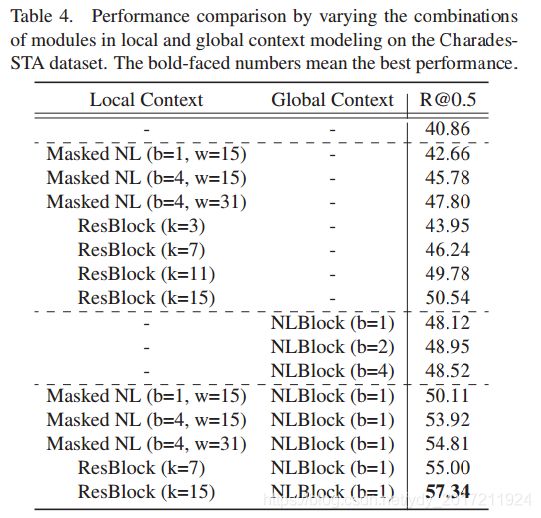

表4总结了结果,说明了以下几点。

首先,仅使用分段级模态融合而不使用上下文建模的模型的性能远远没有达到最先进的性能

其次,结合局部或全局上下文建模可以增强语义短语与视频的对齐,从而提高性能

第三,在局部上下文建模中,更大的局部视图范围进一步提高了性能,根据我们的观察,ResBlock比masked NL更有效

最后,合并局部和全局上下文建模可以获得16.48%的最佳性能增益

注意,尽管全局上下文建模本身具有局部上下文建模的能力,但通过增加nlblock的数量来对局部上下文建模是很困难的;masked NL和NLBlock的组合性能优于堆叠的NLBlock,显示了显式本地上下文建模的重要性

表4:通过在CharadesSTA数据集上改变局部和全局上下文建模中的模块组合进行性能比较。加粗的数字表示性能最好。

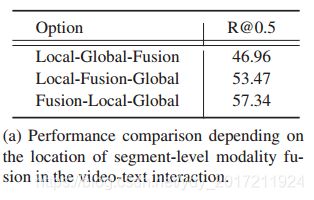

何时执行段级模态融合

表5(a)给出了三种不同选择的模态融合阶段的结果。这一结果表明,早期融合更有利于语义感知的联合视频文本的理解,并导致更好的准确性。

a)视频-文本交互中基于片段级模态融合位置的性能比较。

c)位置嵌入对视频编码的影响。

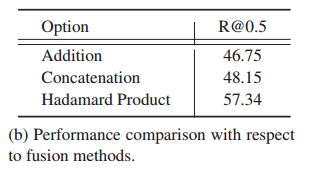

模态融合方法

b)融合方法的性能比较。

我们比较了不同的融合操作——加法、连接和点乘。对于连接,我们通过增加一个嵌入层来匹配其他方法的输出特征维数。从表5(b)可以看出,Hadamard积的性能最好,而其他两种方法的性能要差得多。我们推测部分由于Hadamard积作为一个门控操作,而不是结合两种形式,从而帮助模型区分语义短语相关和不相关的片段。

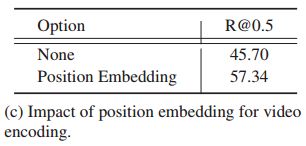

位置嵌入影响

表5©展示了位置嵌入在不同时间位置识别语义实体的有效性,提高了时序定位的准确性。

4.5.3 定性结果

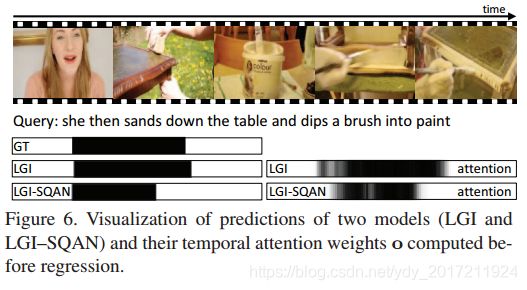

图6显示了LGI和LGI - sqan的预测和时间注意力权重o。我们的完整模型LGI通过语义短语层次的查询理解,提供了比LGI - sqan更准确的定位,使得视频-文本交互更加有效。在我们的补充资料中介绍了更多可视化时间注意权重、查询注意权重a和预测的例子。

两个模型(LGI和LGI-SQAN)预测的可视化,和回归前计算的时间注意权重o。

5 结论

我们提出了一种新的局部-全局视频-文本交互算法,通过成分语义短语提取来实现文本-视频的时序定位。所提出的多层交互方案通过建模局部和全局上下文,有效地捕获了语义短语和视频片段之间的关系。我们的算法在charadessta和ActivityNetCaptions数据集上都达到了最先进的性能。